카메라 각도 제어 및 조향 토크 피드백을 이용한 자율주행 모빌리티의 운영자 중심 관제 시스템 개발

Copyright Ⓒ 2024 KSAE / 227-06

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper presents an operator-centered teleoperated driving(ToD) system for autonomous mobility with camera angle control and steering torque feedback. The teleoperation system is needed to secure the safety and convenience of autonomous mobility. For reasonable teleoperation of autonomous mobility, the operator’s control inputs for path and velocity tracking are essential, considering communication delay and limited environment information. The ToD system based on the secured network was constructed with scale autonomous mobility, and the camera angle control and steering torque feedback algorithms were developed for expansion and improving the operating view and reality of the ToD system. The future path point was designed based on geometric analysis of the vehicle planar plane to derive the camera angle, which was used as the desired camera angle for the expansion of the operating view. The torque feedback algorithm was designed using the steering wheel angle rate and yaw rate to improve the ToD system reality.

Keywords:

Autonomous mobility, Tele-operated driving, Camera angle control, Torque feedback, Robot operating system, Mobile network키워드:

자율주행 모빌리티, 원격 관제 주행, 카메라 각도 제어, 토크 피드백, 로봇 운영 체제, 이동 통신망1. 서 론

완전 자율주행 기술은 기존의 모빌리티 시스템과 비교하여 안전하고 편리한 이동을 기대할 수 있게 한다. 이에 맞춰 산⋅학⋅연 각계에서 자율주행 모빌리티 기술에 대한 높은 관심을 가지고 연구개발이 활발하게 이뤄지고 있다. 연구 분야 중 자율주행 모빌리티의 원격 관제 기술은 자율주행 Fail-safety 관점에서 시스템 고장에 우회 대응 조작을 가능하게 하는 기술이며, 모빌리티 외 이용자 편의 관점에서 V2N(Vehicle to Network) 응용성이 있는 자율주행 기술 연구 분야이다. 자율주행 모빌리티의 원격 관제(Tele-operated driving) 유형은 총 4가지로 구분될 수 있다. 원격 운영자가 운전에 개입하지 않는 유형 0에서, 개입 정도에 따라 원격 운영자가 운전 조작에 모두 개입하는 유형 3까지로 나뉜다.1) 본 논문의 원격 관제 기술은 Tod 유형 3을 고려하여 개발되었다.

자율주행 자동차의 원격 관제 기술 개발을 위해서는 자율주행 플랫폼과 관련된 하드웨어와 플랫폼 제어 및 관제를 위한 소프트웨어 구성 기술 개발이 필요하다. 또한 관제를 위한 통신 방법과 보안에 대한 고려가 필요하기 때문에 관련 연구 개발이 활발히 이뤄지고 있다. 주형진 등은 ROS(Robot Operating System)를 이용하여 Pure pursuit controller가 적용된 자율주행 플랫폼을 구성하였다.2) Megalingam 등3)은 ROS기반 원격조종 로봇을 개발하였지만 SSH(Secure Shell)를 이용하였기 때문에 기초적인 단방향 통신만 구현되는 한계점을 보여주었다. Hajjaj과 Sahari4)는 ROS를 이용하여 원격 통신 구성 방법을 제시하였다. 하지만 Port forwarding 방법만 이용하기 때문에 보안에 비교적 취약한 한계점이 있는 것을 확인하였다.

모빌리티를 직접 조작하는 상황과 대비하여 원격으로 제어하는 관제 방법은 모니터 내 한정된 시야 범위 등 제한된 정보를 이용하여 제어가 수행된다. 또한 원격 운영자가 모빌리티의 동적 거동을 피드백 받기 어렵다. 이러한 원격 관제의 직접 조작하는 느낌인 현실감에 대한 한계점을 극복하기 위해 운영자에게 현실감을 제공하는 연구들이 수행되고 있다. 김준원5)은 무인 차량 원격 운영자에게 차량의 주행 정보 제공을 위한 관제측 조향휠의 조향 반력 제어 방법을 제안하였다. 이상영 등6)은 좁은 시야 범위를 해소하기 위해 다중 카메라가 적용되는 AVM(Around View Monitoring)을 활용하여 주차 시 환경 정보 제공 방법론을 제안하였다. AVM을 이용하면 넓은 시야를 확보할 수 있지만, 왜곡이 발생할 경우 일반 주행에는 부정적 영향을 줄 수 있다.

본 연구를 통해 자율주행 모빌리티 플랫폼의 하드웨어와 관제를 위한 소프트웨어, 그리고 LTE통신을 이용하는 ToD 시스템을 구성하고 자율주행 모빌리티 관제 시스템의 현실감 향상을 위한 알고리즘이 개발되었다. 모빌리티가 미래에 도달할 지점을 카메라가 비춰줄 수 있도록 차량 운전자의 시선 전략이 반영된 목표하는 선회 궤적 기반 능동형 카메라 헤딩 각도 제어 알고리즘이 개발되었다. 추가적으로 모빌리티의 요 각속도 크기에 비례하는 조향 휠 토크 제어 알고리즘이 개발되었다.

개발된 ToD 시스템과 알고리즘은 Scale vehicle을 이용해 평가되었다. 제안하는 알고리즘이 탑재되지 않은 동일한 원격 관제 모빌리티를 대조군으로 평가가 이루어졌다. 제안하는 원격 관제 알고리즘을 통해 운전자의 조작 노력 경감 및 주행 속도 증가, 차량 제어 편차 감소를 확인할 수 있었다.

2장에서는 운영자 중심 원격 관제 시스템의 전반적인 구성과 하드웨어, 소프트웨어 그리고 통신망 구성에 대해 기술한다. 3장에서는 제안하는 운영자 목표 선회 궤적 기반 카메라 헤딩 각도 제어 알고리즘과 조향 휠 토크 피드백 알고리즘에 대해 기술한다. 4장에서는 성능평가 결과를 보여준다. 마지막 5장에서는 결론과 한계점 분석 및 향후 계획에 대해 기술한다.

2. 운영자 중심 관제 시스템 개발

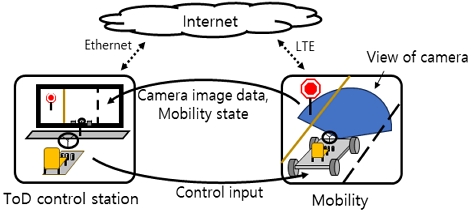

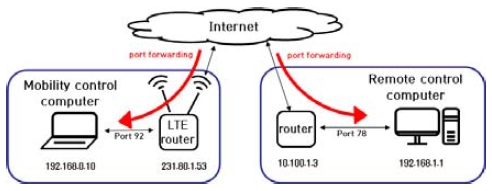

본 논문에서 제안하는 ToD 시스템은 인터넷망을 이용하여 관제센터와 모빌리티 간 제어 및 센서 입출력 데이터를 통신한다. 모빌리티는 LTE 라우터를 이용하여 인터넷에 접속하며, Fig. 1은 원격 관제 시스템의 개념을 보여준다. 관제 센터에서 카메라 이미지 데이터 및 조향 휠 토크 제어량을 수신받고, 카메라 각도 및 액츄에이터 제어 입력을 모빌리티로 송신한다.

2.1 관제 시스템 구축을 위한 하드웨어 구성

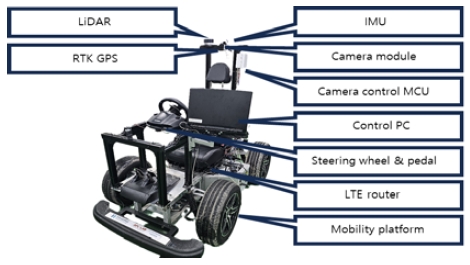

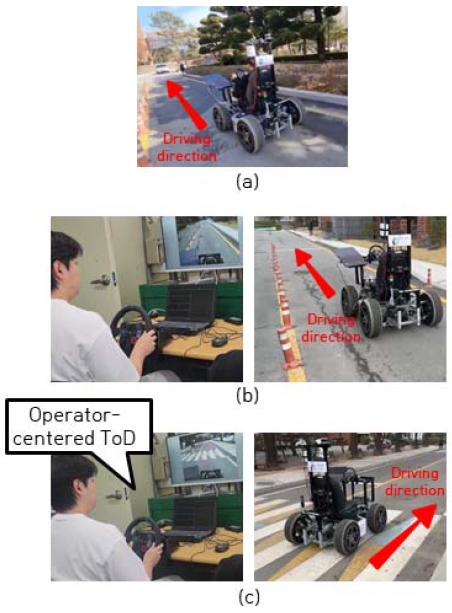

본 절에서는 관제 시스템 구성을 위해 이용된 모빌리티와 운영자 중심 관제 알고리즘 구성을 위한 카메라 모듈 및 관제센터 환경구성 내용을 확인할 수 있다. Fig. 2에서 확인할 수 있는 Scale vehicle 플랫폼인 ERP42 모델을 중심으로 운전자 탑승 및 직접 조작이 가능할 수 있고, 자율주행 제어 및 원격 관제 주행이 가능하도록 전반적 시스템이 구성되었다.

모빌리티의 위치 및 자세 추정 등 자체 정보 및 주변 환경 정보를 인지하기 위해 사용된 센서는 RTK-GPS 수신기, IMU, LiDAR, 카메라이고, 각각 MRP-2000, VN-100, VLP-16, Lifecam Studio가 사용되었다. 원격 관제를 위해 통신 관점의 LTE 이동 통신망 단말기(CNR-L600)와 운영자 중심 시스템 구성을 위한 카메라 각도 제어용 서보모터(FR0115M)가 각각 사용되었다.

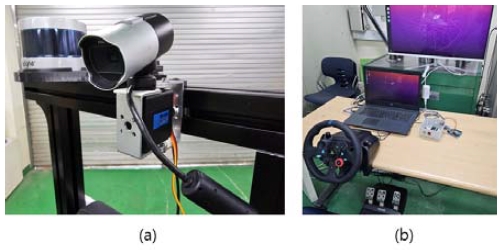

다음 Fig. 3의 (a)는 실시간 관제가 이루어질 때 전방 주행 이미지 데이터를 획득하기 위해 사용된 카메라와 카메라 각도 제어를 위한 서보 모터를 보여준다. (b)의 경우 구성된 관제센터 구성을 보여준다. 카메라에서 획득된 전방 주행 이미지 데이터는 관제센터로 전송되며 모니터에 출력되어 운영자가 원격 관제를 수행한다. 탑승 운전자와 원격 운전자의 조향휠 및 페달 조작을 위해 G29 모델이 모빌리티와 원격 관제센터에 각각 동일한 모델이 적용되었다.

2.2 관제 시스템 구축을 위한 통신 및 소프트웨어

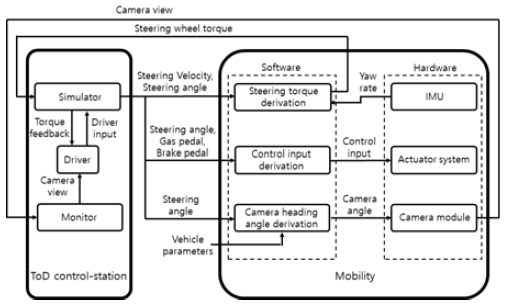

Fig. 4는 ROS를 통해 구성된 운영 중심 관제 시스템의 전반적 알고리즘 개략도를 보여준다.

각각의 하드웨어와 알고리즘 간 통신은 ROS를 기반으로 구현하였다. ROS는 하드웨어 및 알고리즘 간 데이터 통신을 노드와 메시지 형태로 구현할 수 있는 Meta-OS다.8) ROS를 통해 구성한 모빌리티의 전반적 알고리즘 개략도는 Fig. 4에서 확인할 수 있다.

본 연구에서는 원격 관제의 실시간성을 확보하기 위하여 오픈소스 컴퓨터 비전(OpenCV)의 라이브러리 함수를 활용하였다. 이미지 송출 시 OpenCV의 IMWRITE_ PNG_COMPRESSION 파라미터상 10에 해당하는 수치로 압축 전송하였다. 또, 해상도를 320 x 240으로 하향하여 송수신 데이터 크기를 조절하였다. 압축률과 해상도는 해당 시스템의 목표에 적합한 성능이 나올 수 있도록 시행착오법을 통해 도출하였다.

본 연구에서는 관제센터와 모빌리티의 통신을 위하여 Ubuntu의 오픈소스 Virtual Private Network(VPN) 프로토콜인 OpenVPN을 이용했다. VPN 서버를 통한 통신시 공공망 외부에 데이터가 드러나지 않기에 원격 관제 모빌리티에 적합한 통신 환경이다. 이를 위해 양측의 라우터와 같은 게이트웨이에서 서로 통신할 포트를 정한 뒤, 외부에서 해당 포트로 접근하면 접속할 수 있도록 포트 포워딩(Port forwarding)을 구성하였다. Fig. 5는 모빌리티 제어 컴퓨터와 관제 서버 컴퓨터가 서로 통신하는 예시를 나타낸다.

3. 카메라 각도 제어 및 조향 토크 피드백

3.1 선회 궤적 기반 카메라 헤딩 각도 제어

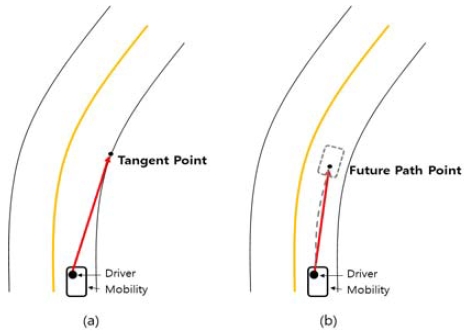

본 연구에서 제안하는 카메라 헤딩 각도 제어는 제한적 정보를 이용하는 원격 관제 상태에서 운영자 의도가 반영된 확장 영상 정보를 제공하기 위한 것이다. 운전자 조향 휠과 카메라 헤딩 각도 관계 도출을 위해 운전자의 시선 행동과 관련한 기존 연구를 조사했다. 운전자가 주시하는 주요한 지점은 도로와의 접선점과 미래 경로점이라는 분석 결과를 확인하였다.7) Okafuji와 Fukao9)는 목적함수를 이용해서 접선점과 미래 경로점 모두를 고려한 운전자 주시점 예측 방법을제시하였으며, 운전자 전방 주시 특성이 접선점과 미래 경로점에 집중되는 경향을 바탕으로 연구되었다. 접선점은 운전자 시선과 선회 곡선이 접하는 지점, 미래 경로점은 차량이 도달할 지점을 뜻한다. 접선점과 미래 경로점은 Fig. 6에서 확인할 수 있다.

Tuhkanen 등10)은 운전자가 도달하고자 하는 지점을 바라보고, 그 지점을 향해 조향하는 경향을 확인하였다. Wilkie 등11)은 운전자가 접선점을 바라볼 때보다, 미래 경로점을 바라볼 때 더 안정적인 제어가 수행됨을 확인했다. 운전자가 모니터를 이용하는 주행 환경이어도 운전자의 시점이 실차 주행과 경향이 유사함을 확인할 수 있다.12) 따라서 원격지 운영자가 조향 휠 입력 인가시, 카메라 헤딩 각도 제어를 통해 모빌리티가 미래에 도달할 지점인 미래 경로점 영상을 제공해 줄 경우 안정적인 원격 관제 성능을 기대할 수 있다. 또한, 실 차량 운전자들의 선회시 미래 경로점 주시 특성7)에 기반하기 때문에 상대적 이질감 감소를 기대할 수 있다.

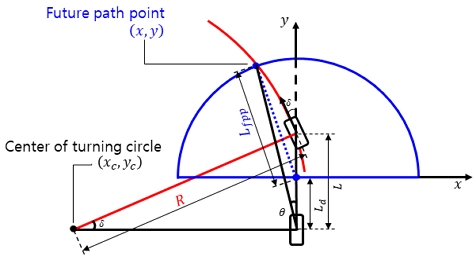

카메라 헤딩 각도 결정을 위해 애커만 스티어 기반 모빌리티의 선회 궤적과 미래 경로점 간 기하학적 관계는 다음 Fig. 7에서 확인할 수 있다.

전륜 축 중심이 미래 주행할 궤적과 미래 경로점 주시거리 반원간 교점을 기반으로 카메라 헤딩 각도 제어 입력이 도출되었다. 전륜 조향각 δ 대비 운전자 조향각 δsw의 모션비 Ns를 통해 식 (1)과 같은 운전자 조향 휠 각도 기반 전륜 조향각 계산이 가능하다.

| (1) |

전륜 기준 선회 반경 R은 축거 L과 전륜 조향각 간의 관계식 식 (2)와 같이 도출될 수 있다.

| (2) |

모빌리티의 전륜 기준 선회 궤적의 함수는 식 (3)과 같다. 이때, xc,yc는 각각 선회 중심점의 좌표이다. 운전자로부터 미래 경로점까지의 거리 Lfpp 만큼 떨어진 점의 궤적인 원의 방정식은 식 (4)와 같다.

| (3a) |

where,

| (3b) |

| (4) |

식 (5)는 식 (3a)와 (4)에서 기술된 두 원의 교점을 지나는 직선의 방정식이며, 교점은 카메라 헤딩 각도 결정을 위해 사용되었다.

| (5) |

식 (4)와 (5)를 연립한 방정식은 식 (6)과 같다.

| (6a) |

where,

| (6b) |

최종적으로 식 (6)의 두 근 α,β를 이용하여 모빌리티의 후륜 축에 위치한 카메라의 헤딩 각도 θ를 식 다음 식 (7)과 같이 도출할 수 있다.

| (7a) |

where,

| (7b) |

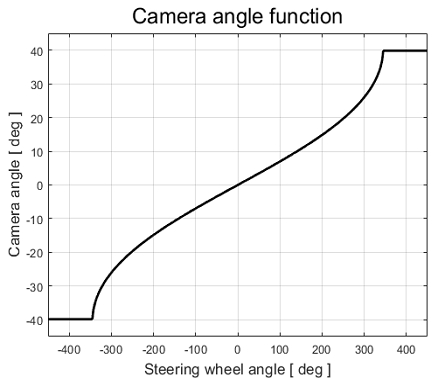

후륜 축 중심에서 미래 경로점까지의 거리 Lfpp는 기존의 연구9)에서 수행된 운전자 시점 추적 실험 결과를 참고하여 설정하였다. 해당 연구에서는 개인차가 있지만 운전자로부터 약 0 ~ 2 m 거리의 미래 경로점을 주시하는 결과가 도출되었다. 본 연구에서는 전방 주시 거리에 상수값인 2 m를 적용하여 조향 휠 입력에 따른 카메라 헤딩 각도 함수를 도출하였다. Fig. 8에서 각도 함수의 개형을 확인할 수 있다.

3.2 조향 휠 토크 피드백 알고리즘

조향 휠 토크 피드백 알고리즘은 자율주행 모빌리티 관제 시스템의 현실감 향상 및 모빌리티의 동적 거동 피드백을 위해 조향 휠의 토크를 제어한다. 제안하는 알고리즘은 마찰감과 함께 모빌리티의 현재 요 각속도를 기준으로 조향감을 원격 운영자에게 제공한다. 운영자 조향 휠의 반대 회전 방향으로 k1 크기의 토크 및 요 각속도와 비례 상수 k2의 곱을 더한 값이 조향 토크 크기를 결정하도록 설계되었다. 다음 식 (8)은 조향 휠 토크 피드백 계산식을 나타낸다.

| (8) |

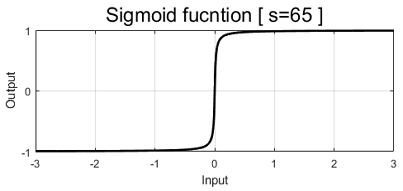

본 연구에서는 운영자 조향 휠 회전 방향을 판단하는 이산형 부호 함수에 의한 채터링 현상을 완화하기 위해 식 (9)와 같이 Sigmoid 함수를 적용하였다.

| (9) |

Sigmoid 함수의 원점 부근 기울기를 나타내는 계수 s는 실험적 시행 착오법을 통해 결정되었으며, 구체적 개형은 다음 Fig. 9에서 확인할 수 있다.

4. 성능평가

제안하는 관제 알고리즘은 2장에서 확인될 수 있는 하드웨어와 소프트웨어를 이용해 성능을 평가하였다. Table 1은 모빌리티 파라미터를 보여주고, Table 2는 알고리즘 설계에 이용된 파라미터를 보여준다.

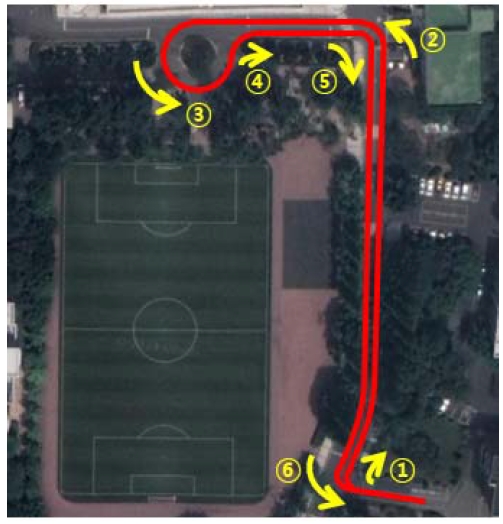

평가를 위해 선정된 실험경로는 한경국립대학교 안성캠퍼스의 교내 도로에서 교차로와 선회 구간이 조합된 시나리오 경로가 반영되었다. Fig. 10은 실험경로와 주행순서를 위성 지도상에서 표현한 것이다.

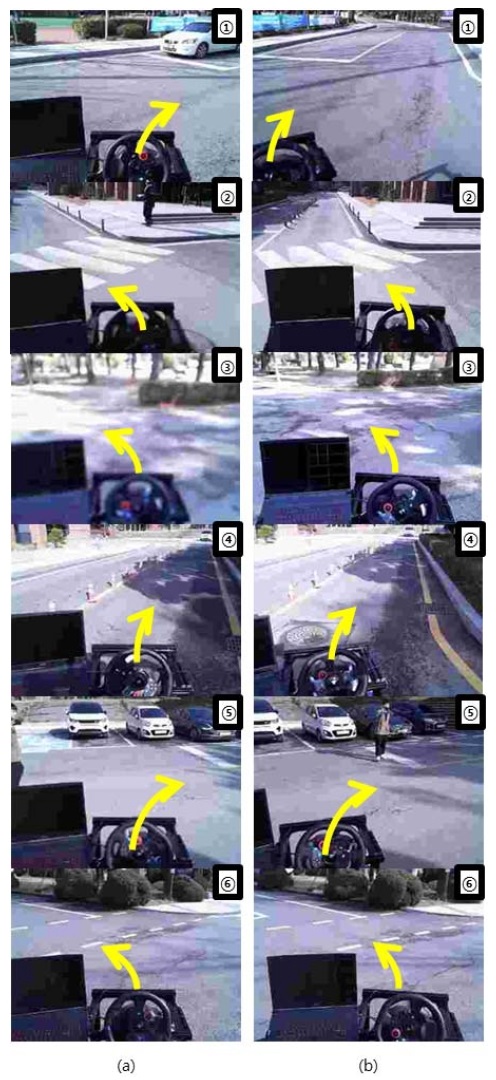

성능평가는 실험자가 직접 모빌리티에 탑승하여 실험경로를 주행하는 시나리오(Manual driving, MD)와 일반적인 원격 관제 주행 시나리오(ToD) 및 제안하는 알고리즘이 적용된 원격 관제 주행 시나리오(OC-ToD)로 구성되었다. Fig. 11은 ToD 시나리오 및 OC-ToD 시나리오 기반 평가를 수행하며 모빌리티에 장착된 카메라에서 전송한 정보를 이전 Fig. 10의 주행 순서에 따라 나열한 사진이다.

카메라 헤딩 각도 제어 미적용 및 적용시 원격 운영자에게 전송되는 이미지를 시각적으로 비교할 수 있다. Fig. 11(a)는 카메라 헤딩 각도 제어가 적용되지 않은 시나리오(ToD) 평가 수행 시 관제 센터로 송출된 이미지 데이터다. Fig. 11(b)는 운영자 중심 원격 관제 알고리즘이 적용된 시나리오(OC-ToD) 평가 수행 시 관제 센터로 송출된 이미지 데이터다. Fig. 12에서는 제안된 세 가지 성능평가 시나리오 수행 내용을 확인할 수 있다.

4.1 Driver-1 주행 결과 데이터

성능평가 결과 분석 및 비교를 위해 운전자 조향입력, 요 각속도, 모빌리티의 속도가 이용되었고, 이를 통해 선회 시 운전자가 인가하는 조향 노력의 양, 주행 안정성, 이질감 관점에서 분석이 수행되었다.

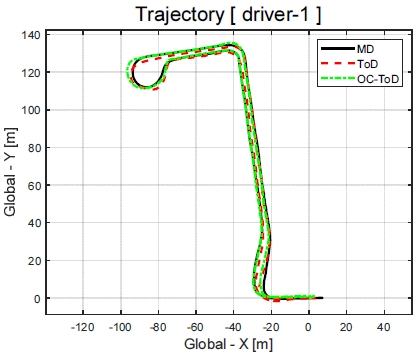

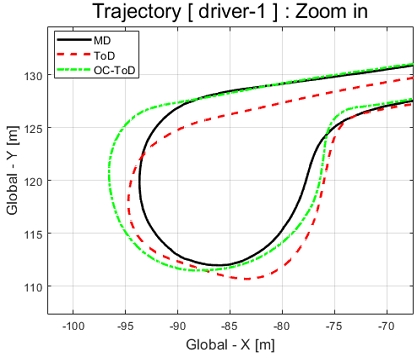

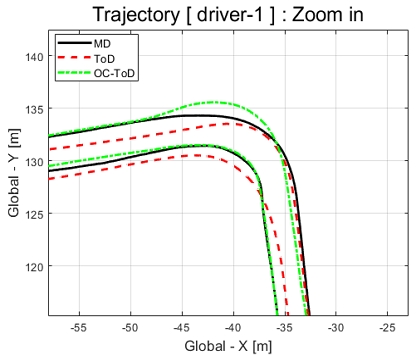

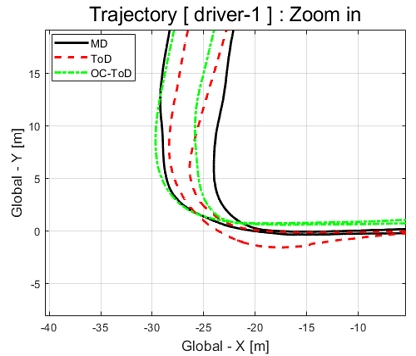

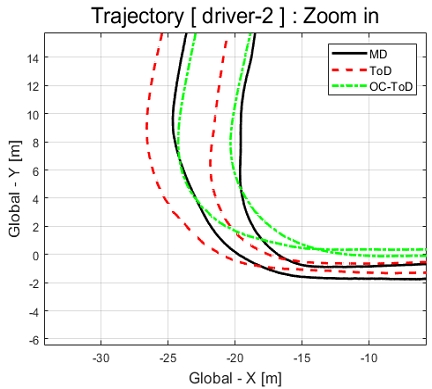

Fig. 13에서 ToD 주행 시나리오와 본 논문에서 제안하는 운영자 중심 원격 관제 시스템 기반 수행된 시나리오(OC-ToD)간 취득된 주행 궤적을 직접주행 시나리오(MD)의 궤적과 비교할 수 있다. Figs. 14 ~ 16은 주요 선회 구간 궤적을 확대한 그림이다.

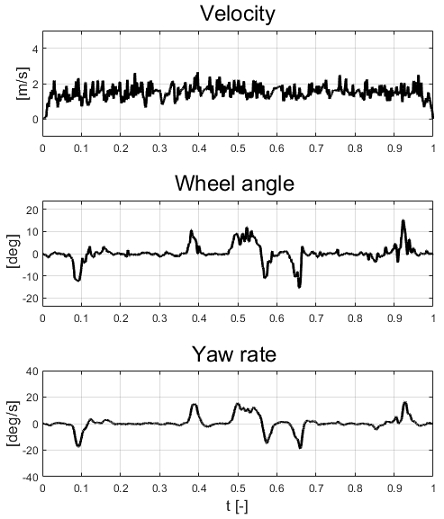

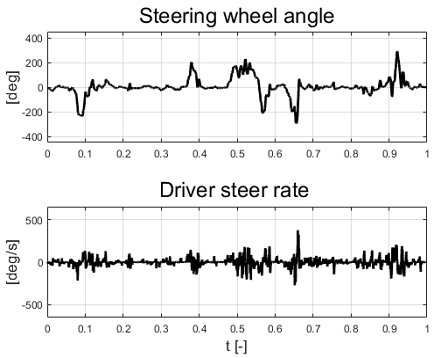

Fig. 17, Fig. 18은 MD 시나리오 기반 평가 과정에서 취득된 모빌리티의 상태량과 운전자의 입력을 나타낸다. 성능평가 시나리오 간 합리적인 비교 평가를 위하여 취득된 데이터를 시간에 대해 0에서 1로 정규화하여 시각화하였다. Fig. 17은 모빌리티의 상태량을 보여주며, 속도와 전륜 조향각, 요 각속도를 보여준다. 비교적 일정한 주행 속도를 유지하고 편차가 상대적 작은 결과를 확인할 수 있다. 이는 주행 현실감과 관련하여 해석될 수 있으며 ToD와 OC-ToD 시나리오의 결과와 비교평가 되었다. Fig. 18은 직접 주행시 운영자가 모빌리티에 인가한 조향 휠 입력과 조향 휠 입력의 변화율을 보여준다.

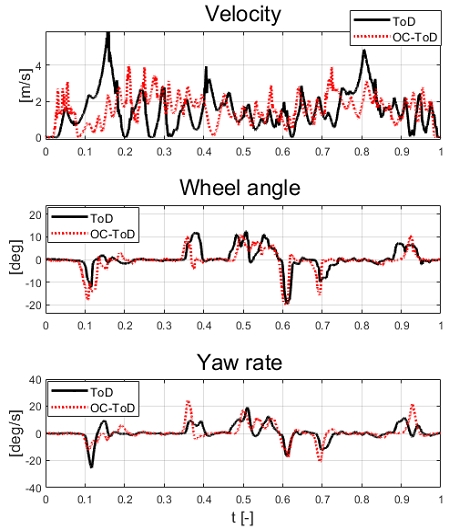

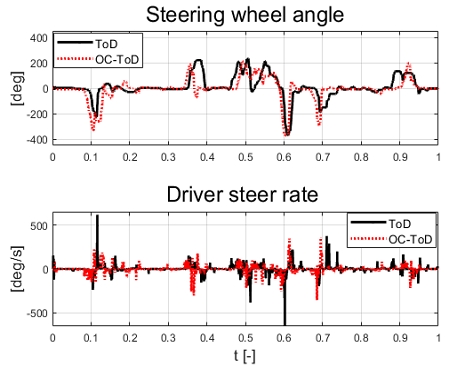

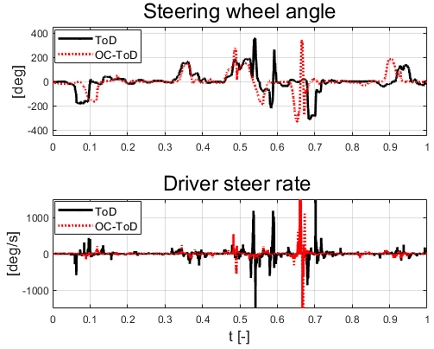

Fig. 19, Fig. 20는 ToD 시나리오와 OC-ToD 시나리오에서 취득된 모빌리티의 상태량과 운영자의 조향 휠 입력을 비교하여 보여준다. Table 3에서 세 시나리오에서 취득된 데이터들의 평균, 표준편차 등 정량적 수치를 확인할 수 있다.

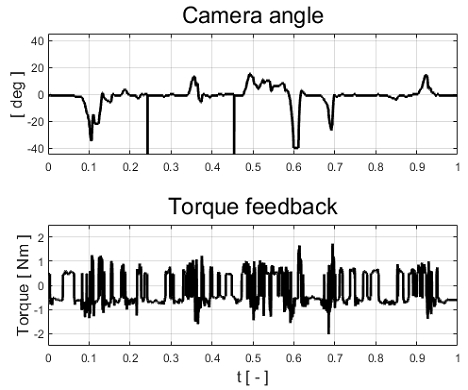

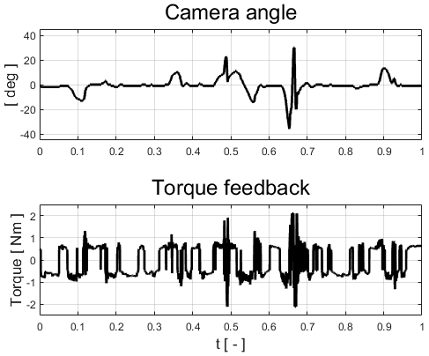

Fig. 17과 Fig. 19의 비교를 통해 제안하는 운영자 중심 원격 관제 알고리즘 적용시 평균 주행 속도가 증가한 반면 편차는 줄어든 결과를 확인할 수 있었다. 이는 제안하는 알고리즘이 원격 주행 현실감 향상에 긍정적 영향을 준 것으로 해석될 수 있다. 요 각속도 비교를 통해 향상된 주행 속도와 함께 요 각속도의 크기와 편차 모두 증가된 것을 확인할 수 있다. Fig. 18과 Fig. 20의 조향 각속도 비교를 통해 OC-ToD 시나리오에서 조작 변화를 나타내는 최고 조향 각속도 크기가 감소한 것을 확인할 수 있다. 이는 주변 환경 인지의 확대와 요 각속도 기반 토크 피드백으로 인하여 운영자에게 조작 노력 경감 및 조작 안정성을 향상시킬 수 있다고 볼 수 있다. 또한 MD 시나리오의 평균 주행 속도와 비교할 경우 상대적 높은 평균 주행 속도를 확인할 수 있다. Fig. 21은 OC-ToD 시나리오에서 운영자 중심 원격 관제를 위해 인가된 카메라 헤딩 각도 제어 입력 및 조향 휠 토크 피드백 제어 입력을 보여준다.

4.2 Driver-2 주행결과

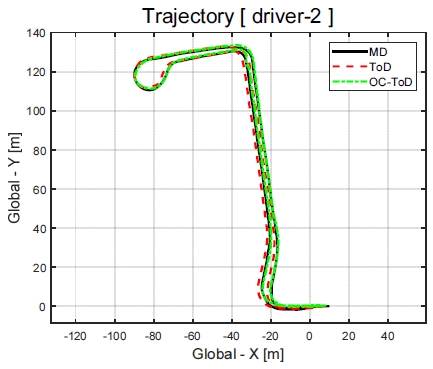

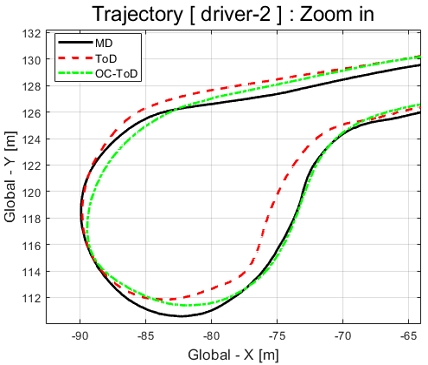

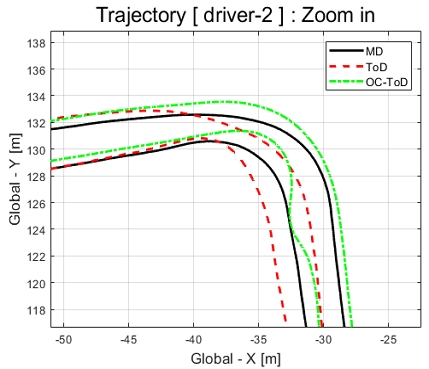

Fig. 22에서는 운전자-2의 ToD 주행 시나리오와 본 논문에서 제안하는 운영자 중심 원격 관제 시스템을 이용해 평가된 시나리오(OC-ToD)에서 취득된 주행 궤적을 직접주행 시나리오(MD) 궤적과 비교할 수 있다. Figs. 23 ~ 25는 주요 선회 구간 궤적을 확대한 그림이다.

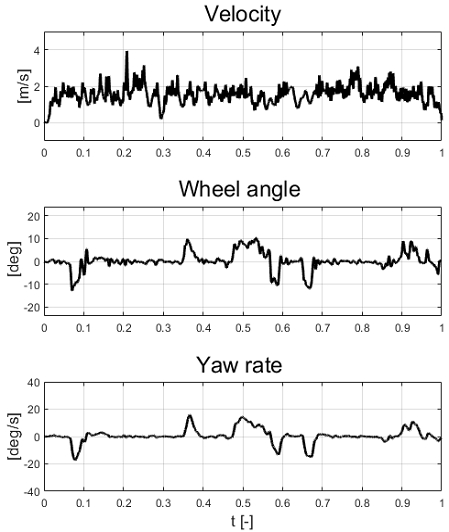

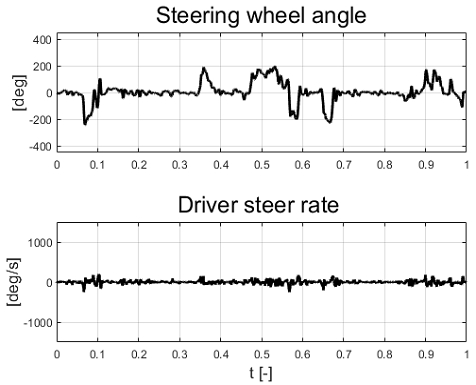

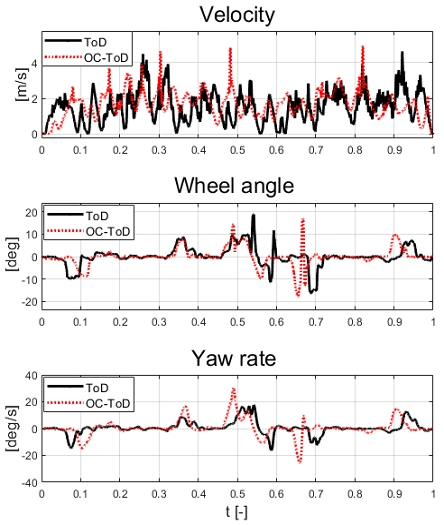

운전자-1의 성능평가와 같이 시나리오 간 합리적인 비교 평가를 위하여 취득된 데이터를 시간에 대해 0에서 1로 정규화하여 시각화하였다. Fig. 26, Fig. 27은 MD 시나리오에서 취득된 모빌리티의 상태량과 운전자의 입력을 나타낸다. Fig. 26은 모빌리티의 상태량을 보여주며, 속도와 전륜 조향각, 요 각속도를 보여준다. 비교적 일정한 속도를 유지하고, ToD 대비 편차가 작은 결과를 확인할 수 있다. Fig. 27은 직접 주행 시 운영자가 모빌리티에 인가한 조향 휠 입력과 조향 휠 입력의 변화율을 보여준다. Table 4에서 세 시나리오에서 취득된 데이터의 정량적 수치를 확인할 수 있다. Fig. 28, Fig. 29는 ToD 시나리오와 OC-ToD 시나리오에서 취득된 모빌리티의 상태량과 운영자의 조향 휠 입력을 비교하여 보여준다. Fig. 30은 제안하는 알고리즘의 제어입력을 나타낸다.

운전자-2의 OC-ToD 시나리오 수행시 170초 근방(가로축 0.6~0.7 사이)에서 불규칙적인 통신 지연이 발생하였기 때문에 Table 4의 OC-ToD 데이터는 170초까지의 데이터를 분석한 결과이다.

Fig. 26과 Fig. 28의 비교를 통해 운영자 중심 원격 관제 알고리즘 적용시 평균 주행 속도가 증가한 반면 편차는 줄어들었다. 요 각속도 비교를 통해 향상된 주행 속도로 모빌리티의 요 각속도 크기와 편차가 증가한 결과를 확인할 수 있다. Fig. 27과 Fig. 29의 조향 각속도 비교를 통해 운영자 중심 원격 관제 시스템 시나리오에서의 조향 휠 입력 변화율인 조향 각속도의 최대 크기가 ToD 대비 작은 것을 확인할 수 있다.

전반적인 평가 결과 분석을 통해 ToD 시나리오 대비 OC-ToD 시나리오에서 평균 속도, 요 각속도 크기의 증가 및 조향 각속도 편차 감소를 확인할 수 있었다. 이를 통해 본 논문에서 제안하는 운영자 중심 원격 관제 알고리즘의 현실감 증대, 원격 조작성 향상 및 운영자의 조작 노력 경감 효과를 확인하였다. 조향 휠 토크 피드백 알고리즘의 경우 기존 연구에서 확인되는 조향 및 타이어 동역학 기반 알고리즘이 아닌 원격 관제를 위해 실험적으로 도출된 방법론이 적용되었다.

5. 결 론

본 논문에서는 자율주행 모빌리티 플랫폼을 포함한 ToD 시스템 개발 및 운영자 중심 원격 관제 알고리즘을 제안하였다. 원격 관제 주행 기술은 모빌리티를 직접 조작하는 경우에 비해 주변 환경 인지의 한계와 모빌리티의 운동 상태를 체감할 수 없는 한계점이 존재한다. 관제 시스템의 현실감 향상을 위한 조향 휠 토크 피드백 알고리즘 및 능동형 카메라 헤딩 각도 제어 알고리즘을 개발하였다. 모빌리티의 동적 상태 체감을 위해 조향 휠 토크 피드백 함수에 요 각속도가 이용됐으며, 운영자의 목표 궤적이 카메라 각도에 반영되기 위해 미래 도달점 개념이 적용되었다. 개발된 ToD 시스템과 제안하는 알고리즘의 성능평가를 위하여 Scale vehicle을 이용해 실험자 두 명의 교내 도로 주행 데이터가 취득되었다. 성능평가는 총 세 가지의 시나리오에서 수행되었으며, 직접주행, 일반적인 ToD 시스템 기반 원격 주행, 제안하는 운영자 중심 원격 관제 시스템 기반 주행 총 세 가지 시나리오가 적용되었다. 성능평가 결과 운영자가 일반적 ToD 시스템을 통해 주행하는 시나리오 대비 제안하는 운영자 중심 원격 관제 시스템 기반 주행된 시나리오에서 제어 입력 및 모빌리티 상태량 분석을 통해 운영자의 조작 노력 경감과 원격 조작성이 향상된 것을 간접적으로 확인할 수 있었다. 한계점으로는 종 방향 현실감 부족으로, MD 대비 ToD 주행 결과에서 속도의 편차가 비교적 큰 값을 보이는 것을 확인할 수 있었다. 향후 종 방향 운동에 대한 현실감 향상 방법 고도화를 계획하고 있다. 또한, 조향 및 타이어 동역학 기반13) 토크 피드백 알고리즘 고도화를 계획하고 있다. 추가적으로, 평가 과정에서 통신 지연 문제가 발생할 수 있음을 확인하였다. 통신 지연 문제에 대응할 수 있는 운영자 제어 입력 기반 경로 계획 및 예견 제어 방법론14)으로 고도화를 계획하고 있다.

Nomenclature

| δ : | wheel angle, rad |

| δsw : | steering wheel angle, rad |

| Ns : | motion ratio of steering system, - |

| L : | distance between front axle and rear axle, m |

| Ld : | distance between driver seat and rear axle, m |

| R : | radius of turn, m |

| Lfpp : | distance between driver and future path point, m |

| θ : | camera heading angle control input, rad |

| : | yaw rate, rad/s |

| T : | torque feedback control input, Nm |

Acknowledgments

본 연구는 2022년도 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원(NRF-2022R1F1A1075167)을 받아 수행되었음.

References

-

S. Kim, “Network Requirement in Teleoperation of Autonomous Vehicle,” Transactions of KSAE, Vol.31, No.4, pp.239-246, 2023.

[https://doi.org/10.7467/KSAE.2023.31.4.239]

-

H. Joo and K. Lee, “Changes in Path Tracking Performance of Autonomous Vehicle According to Design Feedback Gain and Look-ahead Distance of Pure-pursuit Algorithm,” Transactions of KSAE, Vol.29, No.9, pp.839-846, 2021.

[https://doi.org/10.7467/KSAE.2021.29.9.839]

-

R. K. Megalingam, S. Tantravahi, H. S. S. K. Tammana, N. Thokala, H. S. R. Puram and N. Samudrala, “Robot Operating System Integrated Robot Control through Secure Shell (SSH),” 2019 3rd International Conference on Recent Developments in Control, Automation &Power Engineering (RDCAPE), pp.569-573, 2019.

[https://doi.org/10.1109/RDCAPE47089.2019.8979113]

-

S. S. H. Hajjaj and K. Sahari, “Establishing Remote Networks for ROS Applications via Port Forwarding: A Detailed Tutorial,” International Journal of Advanced Robotic Systems, Vol.14, Paper No.172988141770335, 2017.

[https://doi.org/10.1177/1729881417703355]

- J. Kim, “Steering-Wheel Force Feedback Control Study for Unmanned Ground Vehicle,” Journal of Military Robotics Society, Vol.1, No.1, pp.28-33, 2022.

-

S. Lee, J. Lee and S. Kee, “Teleoperated Valet Parking System Using AVM Camera,” Transactions of KSAE, Vol.31, No.6, pp.395-401, 2023.

[https://doi.org/10.7467/KSAE.2023.31.6.395]

-

O. Lappi, E. Lehtonen, J. Pekkanen and T. Itkonen, “Beyond the Tangent Point: Gaze Targets in Naturalistic Driving,” Journal of Vision, Vol.13, No.13, p.11, 2013.

[https://doi.org/10.1167/13.13.11]

- Y. Pyo, H. Cho, R. Jung and T. Lim, ROS Robot Programming, 1st Edn., Rubypaper, Bucheon, 2017.

-

Y. Okafuji and T. Fukao, “Theoretical Interpretation of Drivers’ Gaze Strategy Influenced by Optical Flow,” Scientific Reports, Vol.11, Paper No.2389, 2021.

[https://doi.org/10.1038/s41598-021-82062-1]

-

S. Tuhkanen, J. Pekkanen, P. Rinkkala, C. Mole, R. M. Wilkie and O. Lappi, “Humans Use Predictive Gaze Strategies to Target Waypoints for Steering,” Scientific Reports, Vol.9, No.1, Paper No.8344, 2019.

[https://doi.org/10.1038/s41598-019-44723-0]

-

R. M. Wilkie, G. K. Kountouriotis, N. Merat and J. P. Wann, “Using Vision to Control Locomotion: Looking Where You Want to Go,” Experimental Brain Research, Vol.204, 2010.

[https://doi.org/10.1007/s00221-010-2321-4]

- B. Song, J. Lim, S. Lee and J. Park, “A Study on the Analysis of Driver’s Visual Behavior Characteristics According to the Type of Curve Radius,” Journal of the Korean Society of Safety, Vol.27, No.2, pp.117-126, 2012.

- J. Kwon, J. Lee, S. Lee, S. Jung and J. Choi, “MDPS Steering Feel Performance Prediction Using Virtual Development Environment,” KSAE Spring Conference Proceedings, pp.246-253, 2020.

-

J. Prakash, M. Vignati, E. Sabbioni and F. Cheli, “Vehicle Teleoperation: Successive Reference-Pose Tracking to Improve Path Tracking and to Reduce Time-Delay Induced Instability,” 2022 IEEE Vehicle Power and Propulsion Conference (VPPC), pp.1-8, 2022.

[https://doi.org/10.1109/VPPC55846.2022.10003367]