전기차 자율 충전을 위한 AVM 영상 기반 무선충전패드 검출

Copyright Ⓒ 2023 KSAE / 214-08

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

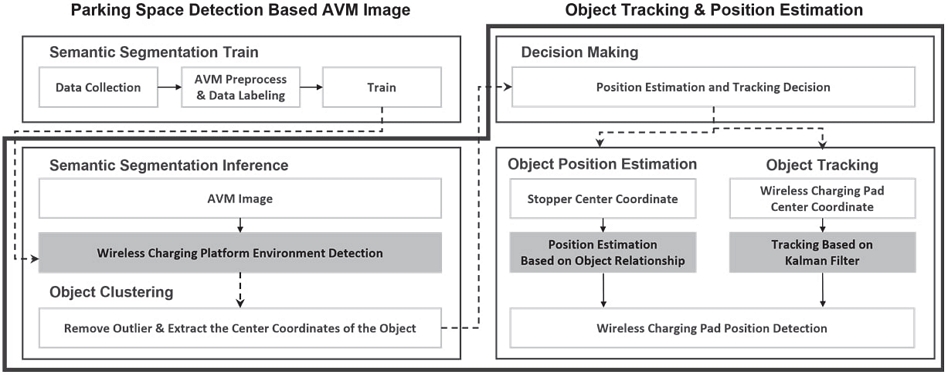

This paper proposes a method of recognizing a wireless charging platform environment based on an AVM image to determine a charging situation and detect the center coordinates of a wireless charging pad. With this technology, it is expected that true unmanned autonomous driving will be possible when a system by which electric vehicle-based, self-driving cars can repeat self-charging and driving is completed. An AVM image was created through calibration, and a learning dataset was generated based on the AVM image acquired from the wireless charging platform. A recognition algorithm for the wireless charging platform environment was implemented using the HRNet model, and a linear Kalman filter-based object tracking and a relationship-based object position coordinate estimation algorithm were implemented. The performance of each algorithm was evaluated using its own dataset, 3D PointCloud Map, and localization techniques. The performance evaluation of the relationship-based object estimation algorithm yielded an average error of 0.07 m.

Keywords:

AVM, Calibration, Semantic segmentation, Object tracking, Kalman filter키워드:

어라운드 뷰 모니터링, 캘리브레이션, 의미론적 분할, 객체 추적, 칼만 필터1. 서 론

전기차는 자율주행 분야에서 신속한 차량 제어, 자율주행 시스템 설계 및 적용을 위한 수단으로 이용되며, 많은 연구자들이 전기차를 기반으로 자율주행 기술 연구를 진행하고 있다. 최근 몇 년간 무선충전패드를 활용한 무선 충전 플랫폼이 공개되면서, 전기차 기반 자율주행 차량이 자율 충전 및 주행을 반복하는 구조가 완성된다면 진정한 의미의 무인 자율주행이 가능할 것으로 기대되고 있다.

자율 충전 기술을 구현하기 위해서는 무선 충전 플랫폼 환경을 인식하는 기술이 필요하며, 이는 주차 공간, 주차 라인, 무선충전패드 등으로 구성된 주차 환경을 인식하는 것으로 접근할 수 있다. 주차 환경 인식 방법으로는 센서 퓨전1,2)을 이용한 방식과, 카메라 센서를 이용한 방식이 있다. 센서 퓨전을 이용한 기존 연구로는 카메라 센서를 통해 주차 공간을 감지하고, 초음파 센서로 빈 공간을 식별하는 연구가 있다. 초음파 센서는 충돌 위험이 존재하는 객체 감지에 효과적이지만 주차장 환경에 따라 정확도가 감소할 수 있으며, 주차 공간 바닥에 위치한 무선충전패드를 식별하지 못한다는 한계점이 존재한다. 카메라 센서를 이용한 기존 연구에는 특징점, Object detection, QR 코드 등이 이용된다.

Nicholas3)는 주차장 상단에 고정된 CCTV 카메라로 취득한 영상에서 히스토그램과 특징점을 추출하여 빈 주차 공간을 탐색하였다. 특징점 기반 주차 공간 탐색은 영상 속 장면의 조명, 차량의 위치 등 환경 변화에 강인하여 빈 주차 공간을 비교적 쉽고 정확하게 탐색 가능하지만, 다양한 객체를 식별할 수 없어 주차 환경 인식에 적합하지 않았다. Jupiyandi 등4)과 Carrasco 등5)은 YOLO 기반 주차 공간 탐색 기법을 구현하였다. 딥러닝 기반 영상처리의 발전으로 인해 Object detection을 이용한 다중 객체 검출 정확도가 향상되었지만, 객체의 형태와 위치를 Bounding box로 표현하기 때문에 객체 고유의 경계가 고려되지 않았고, 카메라가 주차장 상단에 고정되어 있기 때문에 작은 객체의 경우 학습이 어렵다는 한계가 존재하였다. Ma 등6)은 차량 앞부분에 부착된 카메라와 QR 코드를 활용하여 주차 공간을 탐지하고, 다른 차량에 의해 QR 코드가 가려진 경우에는 Template matching을 통해 QR 코드를 복원하는 기술을 구현하였다. 하지만 QR 코드 인프라가 구축되지 않으면 활용하기 어렵고, 전방을 제외한 사각지대가 고려되지 않아 충돌 위험성이 존재한다는 한계가 존재하였다. 최근에는 사각지대를 없애고, 충돌 위험을 최소화하기 위해 차량의 전방위 환경 탐지가 가능한 AVM7,8) 영상을 이용하여 주차 환경을 인식하는 연구9-11)가 진행되고 있다.

무선 충전 플랫폼 환경 인식 후, 전기차의 충전 효율성을 극대화하려면 무선충전패드의 정확한 위치를 검출하기 위한 객체 추적 및 추정 알고리즘이 필요하다. 객체 추적과 관련된 기존 연구에는 Optical flow12,13)와 칼만 필터14,15) 등이 이용된다. Optical flow는 연속된 두 영상으로부터 추출한 Motion vector를 기반으로 객체의 방향과 속도를 파악하는 동작 패턴으로 전체 픽셀을 탐색할 경우 높은 정확도를 기록하였지만, 연산량이 커 실시간 처리가 불가능하였으며 가속도를 고려하지 않아 감속 또는 가속 상황에서 불안정한 모습을 보였다. 반면 칼만 필터는 사용자가 직접 설계한 시스템 모델을 통해 데이터의 불확실성을 제거하고, 측정값과 예측값을 기반으로 최적의 객체 상태를 추정하는 재귀 알고리즘으로, 직전 값을 다시 활용하기 때문에 효율적인 메모리 관리가 가능하다. Farag16)은 비선형 시스템의 실험 환경에서 EKF(Extended Kalman Filter)와 UKF(Unscented Kalman Filter) 기반 다중 객체 추적 기술을 구현하였다. 하지만 EKF는 특정 기준점 근처에서 비선형 시스템을 선형 근사화하기 때문에 기준점을 벗어나면 신뢰성이 떨어졌으며, UKF는 샘플링 기반 모델 근사화 전략을 통해 높은 성능을 기록하였지만 연산량이 커 실시간 처리가 어려웠다.

본 논문에서는 오창 C-track 자율주차 구역에 위치한 Fig. 1의 무선 충전 플랫폼 환경에서 AVM 영상을 기반으로 Semantic segmentation을 통해 무선 충전 플랫폼 환경을 인식하고, 객체 추적 및 추정 알고리즘을 통해 무선충전패드를 정확한 위치를 검출하여 전기차의 충전 효율성을 높이는 방법을 제안한다. AVM 영상에서 무선충전패드가 완전히 보이는 경우에는 선형 칼만 필터 기반 객체 추적을, 자차에 의해 무선충전패드가 가려진 경우에는 주변 물체와의 관계 기반 객체 추정을 통해 무선충전패드를 좌표를 검출한다.

2. AVM 영상 기반 무선 충전 플랫폼 환경 인식

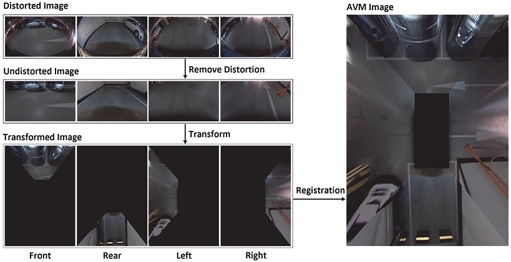

AVM 영상을 기반으로 무선 충전 플랫폼 환경을 인식하기 위해서는 실험 차량의 전방, 후방, 우측방, 좌측방에 부착된 4개의 190°광각 카메라를 이용하여 캘리브레이션하는 AVM 전처리 과정이 필요하다. 본 논문에서는 무선 충전 플랫폼 환경에서의 객체 인식 성능을 보장하기 위해 Semantic segmentation을 통해 객체의 형태를 픽셀 단위로 구분하여 인식하였으며, 무선 충전 플랫폼 환경에서 취득한 AVM 영상을 직접 Labeling하여 학습 데이터셋을 생성하였다.

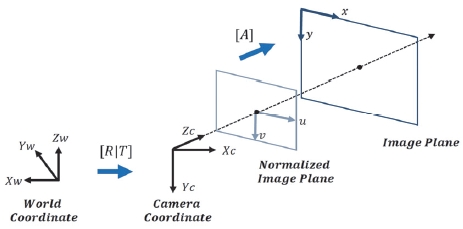

2.1 AVM 전처리

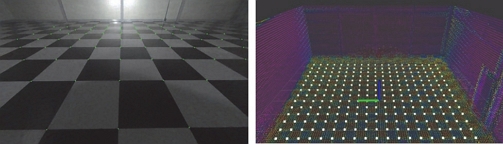

AVM 영상을 생성하기 위해서 4개의 190°광각 카메라를 이용하여 캘리브레이션을 진행하였으며, 이를 위해 Fig. 3과 같이 각 카메라의 좌표계를 변환해주었다. 먼저 각 카메라의 왜곡을 제거하기 위해 Fisheye 카메라 모델18)을 활용하여 내부 파라미터와 왜곡 계수를 계산하였으며, 좌표계를 변환하여 조감도 영상을 생성하기 위해 공차 보정실에서 취득한 2D 특징점과 3D 특징점을 매칭하여 외부 파라미터를 계산하였다. 최종 AVM 영상은 각 카메라의 조감도 영상을 정합하여 생성하였다.

2.2 무선 충전 플랫폼 환경 인식

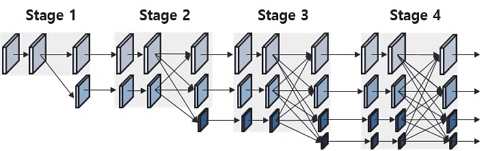

본 논문에서는 무선 충전 플랫폼 환경 인식을 위해 고상도 특징맵을 유지하여 좋은 성능을 기록하는 HRNet19-21) 모델을 이용하였다. 총 4개의 Stage로 구성된 HRNet은 각 Stage를 거치면서 점점 더 작은 해상도의 특징맵을 생성하며, 이전에 생성된 고해상도 특징맵들은 새 Stage에서 생성된 저해상도 특징맵과 병렬적으로 합성곱을 수행하면서 학습 과정동안 다양한 해상도의 특징을 반복적으로 수행한다. 하지만 복잡한 구조로 인해 실시간성 확보가 어려웠기 때문에 본 논문에서는 Fig. 6과 같이 다양한 해상도의 특징맵을 학습할 수 있도록 Stage 수는 유지하면서, Block 수를 줄여 연산량을 줄였다. 이후 AVM 학습 데이터셋을 활용하여 HRNet 기반의 무선 충전 플랫폼 환경 인식 모델을 생성하였다.

무선 충전 플랫폼 환경을 인식한 후에는 무선충전패드의 좌표를 검출하기 위해서 Mean shift를 기반으로 특정 객체를 군집화하여 이상치를 제거하고, 중심 좌표를 계산하였다. Mean shift란 식 (1)의 커널 밀도 추정을 통해 객체 군집화를 수행하는 비모수 방법론 모델로, 데이터의 분포를 정확하게 분석하기 위해서는 대역폭 h를 최적으로 설정하는 것이 중요하기 때문에, 프레임마다 최적의 대역폭 계산 후 군집화를 진행하였다.

| (1) |

- Where KDE : kernel function, h : bandwidth

3. 무선충전패드 검출

본 연구에서는 무선 충전 플랫폼 인식 결과와, 무선충전패드 및 스토퍼 군집화 결과를 기반으로 자차의 무선 충전 상황을 판단하였다. 자차가 충전 예정이거나 충전 중이라고 판단한 경우 자차와 제일 가까이에 위치한 스토퍼 두 개의 정보를 이용하여 가려진 무선충전패드의 위치 좌표를 추정하였으며, 그 외의 경우에는 AVM 영상 속 무선충전패드의 중심 좌표를 추적하였다.

3.1 칼만 필터 기반 객체 추적

본 연구에서는 객체 추적의 실시간성을 보장하기 위해 선형 칼만 필터를 이용하였다. 칼만 필터의 성능은 실제 시스템과의 유사도와 비례하기 때문에, 본 논문에서는 비선형 시스템의 실험 환경과 최대한 유사하게끔 가속, 감속 상황을 고려하여 식 (2) ~ (8)과 같이 시스템 모델을 설계하였다. 식 (2)의 상태 변수 중 실제로 입력받는 값은 2.2절에서 계산한 무선충전패드 위치 좌표 px와 py이며, vx, vy, ax, ay는 순간 속도 공식과 순간 가속도 공식을 이용하여 계산하였다.

| (2) |

| (3) |

| (4) |

| (5) |

| (6) |

| (7) |

| (8) |

최종 추정 단계에 사용되는 식 (9)의 행렬 H를 단위행렬로 가정하면 식 (10)으로 표현할 수 있다. 이를 통해 칼만 필터에서는 칼만 이득 K가 가중치로 이용되며, K가 증가하면 센서 측정값의 신뢰도가 높아지고, 감소하면 칼만 필터 시스템 예측값의 신뢰도가 높아지는 것을 알 수 있다. 또한 식 (11)과 식 (12)를 통해 시스템 잡음 Q는 K와 비례하고, 센서 잡음 R은 K와 반비례함을 확인할 수 있다. 즉 R과 Q를 통해 K를 조절 할 수 있으며, 이는 사용자가 실험을 통해 K를 변경해가며 실험 환경과 유사한 칼만 필터 시스템 모델을 설계할 수 있음을 뜻한다.

| (9) |

| (10) |

| (11) |

| (12) |

본 논문에서는 시스템 모델 행렬 A만으로는 이전 상태 가속도와 현재 상태 가속도의 상관관계를 정확하게 표현하기 어려웠기 때문에 식 (7), (8)과 같이 가속도가 일정하다고 예측하도록 설계한 후, 행렬 Q의 가속도 잡음을 높게 설정하여 가속도의 예측값 반영 비율을 낮추고, 측정값을 신뢰하도록 설계하였다. 이후 상태변수 예측과 추정을 반복하며 무선충전패드의 중심 좌표를 추적하였다.

3.2 관계 기반 객체 위치 좌표 추정

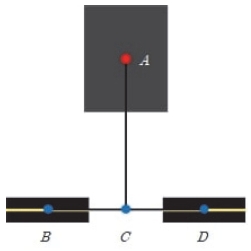

본 논문에서는 Fig. 7과 같이 무선충전패드의 중심 좌표 A를 기준으로, 주차 영역 속 스토퍼들의 각 중심 좌표를 이은 직선 에 수선의 발을 내리면 두 스토퍼의 중심점 C를 지나도록 무선 충전 플랫폼 환경을 모델링 하였으며, 이 관계를 기반으로 무선충전패드의 위치 좌표를 추정하였다.

직선 는 식 (13)으로 간단하게 표현 할 수 있다. 이때 이와 수직 관계인 직선 를 식 (14)로 모델링할 경우, 가 x축과 가까워질수록 의 기울기 이 급격하게 증가하여 무선충전패드의 중심 좌표 A의 정확한 추정이 불가능하였다. 따라서 본 연구에서는 식 (14)의 x, y 좌표계를 변환한 후, y 값을 이동시켜가며 완만한 기울기를 통해 무선충전패드의 중심 좌표를 정밀하게 추정하였으며, 최종적으로는 식 (15)와 같이 직선 를 모델링하였다.

| (13) |

| (14) |

| (15) |

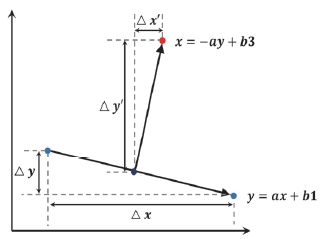

Fig. 8은 본 연구에서 사용한 위치 추정 방법이다. 식 (16)의 ∆y′는 Fig. 7의 모델링을 통해 미리 계산해 둔 직선 와 직선 의 비율을 통해 구할 수 있으며, 식 (17)과 식 (18)을 통해 두 스토퍼의 중심좌표로부터 무선충전패드의 중심 좌표를 추정하였다.

| (16) |

| (17) |

| (18) |

4. 실험 환경

제안하는 AVM 영상 기반 무선 충전 플랫폼 환경 인식 및 객체 추적, 객체 추정 알고리즘을 서로 다른 3종류의 자체 데이터셋을 이용하여 성능을 평가하였다. 자체 데이터셋은 무선 충전 플랫폼에서 취득하였으며 각 알고리즘의 실험 환경 및 특성에 맞추어 구성하였다.

4.1 무선 충전 플랫폼 환경 인식 모델 학습 방법

본 논문에서 제안한 무선 충전 플랫폼 환경 인식 모델 학습을 위해 생성한 자체 데이터셋의 구성은 Table 1과 같다. 무선 충전 플랫폼에서 취득한 500 x 700 해상도의 AVM 영상과, Labeling tool,22) Data Augmentation을 통해 총 8개의 객체로 구성된 600장의 자체 데이터셋을 생성하였으며, 무선충전패드가 포함된 무선 충전 시나리오, 무선 충전 패드가 포함되지 않은 주행 시나리오 등 다양한 시나리오를 포함하였다. 학습은 540장의 학습 데이터와, 60장의 검증 데이터로 나누어서 진행하였다. 모델 성능 평가용 테스트 데이터셋을 추가로 생성하기에는 Labeling 시간이 많이 소요되었기 때문에 검증 데이터를 이용하여 계산한 Mean IoU 성능 지표 결과와 학습에 사용되지 않은 영상의 원본과 추론 결과를 비교하여 모델의 성능을 확인하였다. 모델 학습 환경은 Table 2와 같다.

4.2 객체 추적 알고리즘 성능 평가 방법

회전 상황에서의 객체 추적 알고리즘 성능 평가를 위해 Table 3과 같이 구성된 우회전, 좌회전 시나리오의 AVM 영상 데이터셋을 취득하였으며, GT는 각 AVM 영상 데이터에서 무선 충전패드를 Labeling 한 후 중심 좌표를 계산하여 확보하였다. 이후 본 논문에서 제안한 무선 충전 플랫폼 환경 인식 모델을 이용하여 무선충전패드의 중심 좌표를 추출하고, 해당 좌표를 추적해가며 GT 값과 비교하였다. 성능 평가 지표로는 Error와 RMSE를 활용하였으며, Table 4의 환경에서 성능 평가를 진행하였다.

| (19) |

| (20) |

4.3 객체 추정 알고리즘 성능 평가 방법

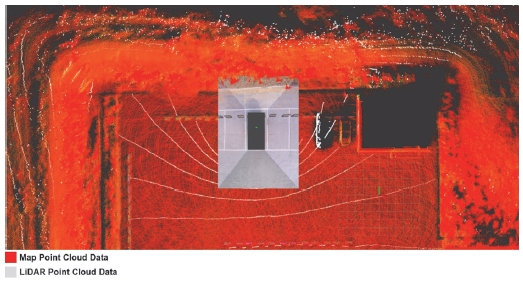

다양한 상황에서의 객체 추정 알고리즘 성능 평가를 위해 Table 5로 구성된 전진, 후진, 좌회전, 우회전 시나리오의 자체 데이터셋을 취득하였으며, GT는 무선 충전 플랫폼에서 취득한 Map data 속 고정된 무선충전패드의 네 꼭짓점을 검출한 후, 해당 점들의 중심 좌표로 설정하였다. 이후 Error와 RMSE를 기반으로 각 AVM 영상에서 추정한 무선충전패드의 중심 좌표를 2D 영상 좌표계에서 3D map 좌표계로 변환한 결괏값과 GT 값을 비교하였으며, Table 4의 환경에서 성능 평가를 진행하였다. Fig. 9는 AVM 영상 및 LiDAR data를 3D map 좌표계로 변환 후 시각화한 결과이다. 무선 충전 플랫폼 Map은 빨간색 Point cloud data로, 실험 차량에서 획득한 LiDAR data를 무선 충전 플랫폼 Map 좌표계로 변환한 결과는 흰색 Point cloud data로 표현하였다.

5. 실험 결과

5.1 무선 충전 플랫폼 환경 인식 모델 학습 결과

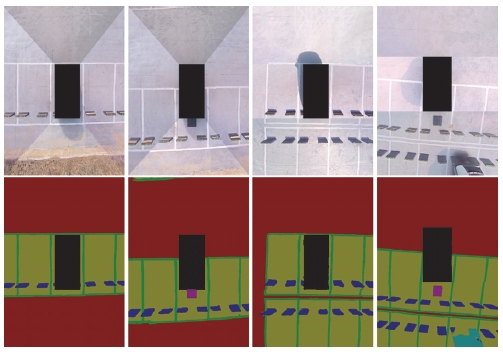

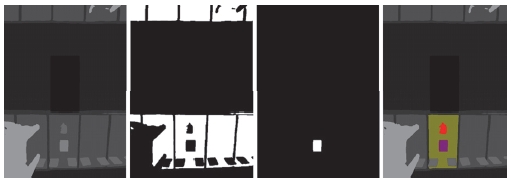

Table 6은 자체 제작한 검증 데이터를 이용하여 계산한 각 객체의 성능 평가 지표 결과로, 차선을 제외한 모든 객체가 0.8 이상의 IoU를 기록하였으며, Mean IoU는 0.8962를 기록하였다. Fig. 10은 학습에 사용되지 않은 영상을 추론한 결과로, 첫 번째 줄이 입력 영상이며 두 번째 줄이 추론 영상이다. 추론 영상 속 자차에 해당하는 검은색은 배경, 빨간색은 자유 공간, 연두색은 주차 공간, 초록색은 차선이며, 보라색과 남색은 각각 무선충전패드와 스토퍼를 의미한다. GT 영상이 존재하지는 않지만, 입력 영상과 추론 영상을 비교해 보면 주차 공간 속 무선충전패드, 이와 형상 및 크기가 유사한 스토퍼와 차량 등을 비롯하여 학습된 Class의 객체가 정확하게 추론된 것을 확인할 수 있다. 본 논문에서 제안한 Semantic segmentation 모델은 추후 Cityscapes 또는 KITTI benchmark 등 검증된 대용량 데이터셋을 이용하여 학습한 후, 실험을 통해 성능을 검증할 예정이다.

5.2 객체 추적 알고리즘 성능 평가 결과

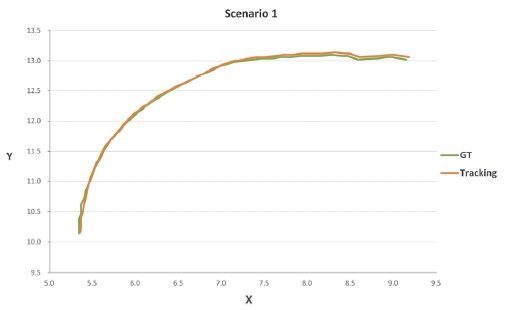

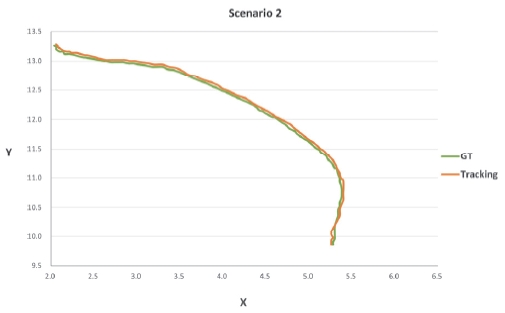

객체 추적 알고리즘 성능 평가 결과는 Table 7과 같으며, 각 성능 평가 지표는 픽셀 단위를 m로 바꾸어 표기하였다. 두 시나리오의 Avg error와 RMSE 모두 약 0.04 m를 기록하였으며, Fig. 11과 Fig. 12를 통해 각 시나리오의 GT와 추적 결과를 확인한 결과 궤도가 거의 일치하는 것을 확인하였다.

5.3 객체 추정 알고리즘 성능 평가 결과

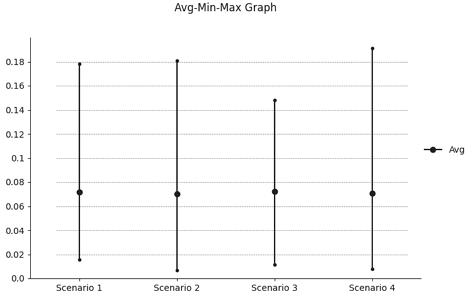

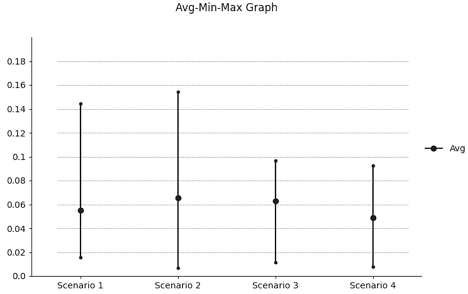

객체 추정 알고리즘 성능 평가 결과는 Table 8과 같으며, 각 성능 평가 지표는 픽셀 단위를 m로 바꾸어 표기하였다. 4개의 시나리오 모두 Avg error 0.07 m를 기록하였으며, 차량이 스토퍼 바로 앞에 위치할 때 오차가 크게 증가하는 현상을 보였다. 따라서 각 시나리오에서 차량과 스토퍼가 가까워지는 마지막 프레임 5장을 제거한 후 성능 평가를 다시 진행한 결과 Table 9와 같이 Max error 값이 감소하는 것을 확인하였고, 이를 통해 객체 추정 알고리즘 수정이 필요함을 확인하였다. Table 8과 Table 9의 Error 지표는 Fig. 13과 Fig. 14와 같이 Avg-Min-Max 그래프로 시각화하여 결과를 확인하였다.

자기 공명 방식의 WiTricity 무선충전패드는 15 ~ 20 cm 이내의 거리에서 90 %의 효율로 무선 충전을 지원한다.23) 따라서 본 논문에서 활용한 WiTricity 무선 충전 플랫폼 환경에서 90 % 이상의 효율로 전기차의 무선 충전을 지원하기 위해서는 위치 오차가 20 cm 이내여야 한다. 실험을 통한 객체 추적 및 추정 알고리즘 성능 평가 결과 두 알고리즘 모두 위치 오차 20 cm 이하를 기록하였으며, 이를 통해 제안하는 방식이 90 % 이상의 효율로 무선 충전 지원이 가능함을 확인하였다.

5.4 추가 실험

주차 공간에 무선충전패드와 비슷한 크기의 학습되지 않은 객체가 존재하는 경우를 고려하여, 무선 충전 플랫폼 환경 인식 결과를 기반으로 장애물 존재 여부를 판단하는 알고리즘을 이용해서 추가 실험을 진행하였다. 해당 실험에는 무선 충전 플랫폼 환경 AVM 영상 위에 학습되지 않은 임의의 객체를 합성한 AR 영상을 활용하였다. 먼저 본 논문에서 제안한 Semantic segmentation 모델을 이용하여 AR 영상 속 각 픽셀의 클래스를 추론한 후, 추론 결과를 기반으로 Parking space, Wireless charging pad 클래스의 Binary mask를 생성하였다. 이때 특정 클래스에 해당하는 픽셀은 흰색으로, 나머지 클래스의 픽셀은 검은색으로 표시하였다. Fig. 15의 1번 이미지는 추론 결과 영상이며, 2, 3번 이미지는 각각 Parking space 및 Wireless charging pad 클래스의 Binary mask이다. 이후 Parking space binary mask에서 Contour를 추출하여 여러 개의 Parking space를 개별 객체로 분리한 후, 무선충전패드의 중심 좌표를 포함하는 Parking space를 ROI로 선정하였으며, ROI에 해당하는 픽셀의 클래스가 Parking space 또는 Wireless charging pad가 아닐 때 장애물이 존재한다고 판단하였다. Fig. 15의 4번 이미지는 AVM 영상 속 ROI를 연두색 Point로, 무선충전패드를 보라색 Point로, 장애물로 판단된 객체를 빨간색 Point로 시각화한 결과이다. 해당 알고리즘은 본 논문에서 제안하는 AVM 영상 기반 무선충전패드 검출에 사용되지 않았지만, 추가 실험을 통해 무선 충전패드가 위치한 주차 공간 속 장애물 존재 여부를 판단할 수 있음을 확인하였다. 추후 해당 알고리즘을 추가하여 AVM 영상 기반 무선충전패드 검출 방식을 보완할 계획이다.

6. 결 론

본 논문에서는 AVM 영상을 기반으로 무선 충전 플랫폼 환경을 인식하고, 무선충전패드의 중심 좌표를 검출하는 알고리즘을 제안하였다. 무선 충전 플랫폼에서 취득한 AVM 영상을 기반으로 학습 데이터셋을 생성하였으며, HRNet 구조를 이용한 Semantic segmentation 알고리즘을 이용하여 객체의 형태를 픽셀 단위로 구분하는 무선 충전 플랫폼 환경 인식 기술을 구현하였다. 또한 무선 충전 플랫폼 환경 인식 결과를 기반으로 자차의 무선 충전 여부를 판단하였으며, 선형 칼만 필터 기반 객체 추적 알고리즘과 관계 기반 객체 추정 알고리즘을 이용하여 무선충전패드의 중심 좌표를 검출하였다. 각 알고리즘은 자체 데이터셋과, 3D PointCloud map, localization 기법 등을 통해 성능을 검증하였다. 추가로, 무선 충전 플랫폼 환경 인식 결과를 기반으로 ROI에 해당하는 주차 공간 속 장애물 존재 여부를 판단하는 실험을 진행하여 무선 충전패드 검출 방식 보완 방안을 제시하였다.

무선 충전 플랫폼은 야외에 위치하였기 때문에 날씨, 계절, 시간대에 의해 인식 성능이 좌우되었다. 본 연구에서는 무선 충전 플랫폼 환경 인식 결과가 객체 추적 및 추정 알고리즘의 성능에 큰 영향을 미치기 때문에, 학습되지 않은 환경에서 실험을 진행할 경우에는 전체적인 성능이 떨어지는 것을 확인하였다. 따라서 더욱 강인한 인식 알고리즘을 구현하기 위해 다양한 환경의 추가 데이터셋을 취득함과 동시에, 모델의 성능을 개선하는 방향으로 추후 연구를 진행할 예정이다. 또한 객체 추정 알고리즘의 경우 스토퍼와 자차의 거리가 가까워지거나, 지면이 울퉁불퉁하여 차량의 Roll, Pitch 변화가 심해지는 순간 AVM 영상의 외부 보정이 틀어져 오차가 커지는 것을 확인하였다. 따라서 이를 해결하기 위해 카메라의 Roll, Pitch 값을 보상해준다면 AVM 영상의 오차가 줄어들 것으로 예측된다.

Nomenclature

| AVM : | around view monitoring |

| xk : | state variable vector |

| zk : | measured value vector |

| A : | system matrix |

| H : | output matrix |

| Q : | system noise covariance matrix |

| R : | measurement noise covariance matrix |

| K : | kalman gain |

| P : | error covariance matrix |

| Δt : | time difference between kth and k-1th frame |

| a : | inclination between two stoppers |

| b1 : | intercept 1 of the estimation equation |

| b2 : | intercept 2 of the estimation equation |

| b3 : | intercept 3 of the estimation equation |

| Δx, Δy : | distance difference between stoppers |

| Δx′ , Δy′ : | distance difference between stopper and pad |

| RMSE : | root mean squared error |

Subscripts

| subscript ‘k’ : | kth time stamp |

| subscript ‘estimate’ : | estimated wireless pad coordinate |

| subscript ‘stopper’ : | stopper center coordinate |

| superscript ‘-’ : | predicted value |

| superscript ‘^’ : | estimated value |

| superscript ‘T’ : | transposed value |

Acknowledgments

이 논문은 2022년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구임(No.2022-0-00199, 커넥티드 자율주행을 위한 5G-NR-V2X 성능 검증). 이 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2022R1 A5A8026986).

References

-

J. K. Suhr and H. G. Jung, “Sensor Fusion-Based Vacant Parking Slot Detection and Tracking,” IEEE Transactions on Intelligent Transportation Systems, Vol.15, No.1, pp.21-36, 2013.

[https://doi.org/10.1109/TITS.2013.2272100]

-

J. K. Suhr and H. G. Jung, “Automatic Parking Space Detection and Tracking for Underground and Indoor Environments,” IEEE Transactions on Industrial Electronics, Vol.63, No.9, pp.5687-5698, 2016.

[https://doi.org/10.1109/TIE.2016.2558480]

- N. True, “Vacant Parking Space Detection in Static Images,” University of California, San Diego, Vol.17, pp.659-662, 2007.

-

S. Jupiyandi, F. R. Saniputra, Y. Pratama, M. R. Dharmawan and I. Cholissodin, “Pengembangan Deteksi Citra Mobil untuk Mengetahui Jumlah Tempat Parkir Menggunakan CUDA dan Modified YOLO,” Jurnal Teknologi Informasi dan Ilmu Komputer, Vol.6, No.4, pp.413-419, 2019.

[https://doi.org/10.25126/jtiik.2019641275]

-

D. P. Carrasco, H. A. Rashwan, M. Á. García and D. Puig, “T-YOLO: Tiny Vehicle Detection based on YOLO and Multi-scale Convolutional Neural Networks,” IEEE Access, Vol.11, pp.22430-22440, 2021.

[https://doi.org/10.1109/ACCESS.2021.3137638]

-

S. Ma, W. Fang, H. Jiang, M. Han and C. Li, “Parking Space Recognition Method based on Parking Space Feature Construction in the Scene of Autonomous Valet Parking,” Applied Sciences, Vol.11, No.6, Paper No.2759, 2021.

[https://doi.org/10.3390/app11062759]

-

J. Kannala and S. S. Brandt, “A Generic Camera Model and Calibration Method for Conventional, Wide-angle, and Fish-eye Lenses,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.28, No.8, pp.1335-1340, 2006.

[https://doi.org/10.1109/TPAMI.2006.153]

- J. K. Lee, Y. K. Baik, H. Cho and S. Yoo, “Online Extrinsic Camera Calibration for Temporally Consistent IPM Using Lane Boundary Observations with a Lane Width Prior,” arXiv Preprint arXiv:2008.03722, , 2020.

-

D. Lee and S. -C. Kee, “Real-time Implementation of the Parking Line Departure Warning System Using Partitioned Vehicle Region Images,” Transactions of KSAE, Vol.27, No.7, pp.553-560, 2019.

[https://doi.org/10.7467/KSAE.2019.27.7.553]

-

J. Kim, D. Lee, B. Yu and S. -C. Kee, “A Study on the Parking Point Searching for Wireless Charging of Electric Vehicles,” Transactions of KSAE, Vol.28, No.7, pp.483-489, 2020.

[https://doi.org/10.7467/KSAE.2020.28.7.483]

-

S. W. Lee, D. K. Lee and S. C. Kee, “Deep-learning-based Parking Area and Collision Risk Area Detection Using AVM in Autonomous Parking Situation,” Sensors, Vol.22, No.5, Paper No.1986, 2022.

[https://doi.org/10.3390/s22051986]

-

K. Kale, S. Pawar and P. Dhulekar, “Moving Object Tracking Using Optical Flow and Motion Vector Estimation,” 4th International Conference on Reliability, Infocom Technologies and Optimization (ICRITO)(Trends and Future Directions), pp.1-6, 2015.

[https://doi.org/10.1109/ICRITO.2015.7359323]

-

B. Du, S. Cai and C. Wu, “Object tracking in Satellite Videos based on a Multiframe Optical Flow Tracker,” IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, Vol.12, No.8, pp.3043-3055, 2019.

[https://doi.org/10.1109/JSTARS.2019.2917703]

-

R. E. Kalman, “A New Approach to Linear Filtering and Prediction Problems,” Vol.82, No.1, pp.35-45, 1960.

[https://doi.org/10.1115/1.3662552]

- N. True, “Vacant Parking Space Detection in Static Images,” University of California, San Diego, Vol.17, pp.659-662, 2007.

-

W. Farag, “Kalman-filter-based Sensor Fusion Applied to Road-objects Detection and Tracking for Autonomous Vehicles,” Proceedings of the Institution of Mechanical Engineers, Part I: Journal of Systems and Control Engineering, Vol.235, No.7, pp.1125-1138, 2021.

[https://doi.org/10.1177/0959651820975523]

- WiTriCity, Wireless Charger Platform, November 2022, https://witricity.com

- OpenCV, Computer Vision Open Source, November 2022, https://docs.opencv.org/3.4/db/d58/group__calib3d__fisheye.html

- K. Sun, Y. Zhao, B. Jiang, T. Cheng, B. Xiao, D. Liu, Y. Mu, X. Wang, W. Liu, Y. Mu, X. Yang, W. Liu and J. Wang, “High-resolution Representations for Labeling Pixels and Regions,” arXiv Preprint arXiv:1904.04514, , 2019.

-

Y. Yuan, X. Chen and J. Wang, “Object-contextual Representations for Semantic Segmentation,” Computer Vision–ECCV 2020: 16th European Conference, Part VI 16, pp.173-190, 2020.

[https://doi.org/10.1007/978-3-030-58539-6_11]

-

J. Wang, K. Sun, T. Cheng, B. Jiang, C. Deng, Y. Zhao, D. Liu, Y. Mu, M. Tan, X. Wang, W. Liu and B. Xiao, “Deep High-resolution Representation Learning for Visual Recognition,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.43, No.10, pp.3349-3364, 2020.

[https://doi.org/10.1109/TPAMI.2020.2983686]

- Labelme, Labeling Tool, https://github.com/wkentaro/labelme, , 2022.

- Park, C. B., Lee, B. S. and Lee, S. G. “Analysis of the Development Trend of High-capacity Wireless Power Transmission Technology for Railway Vehicles,” KoreaScience, Vol.63, No.9, pp.35-42, 2014.