CNN-ViT 통합 모듈을 이용한 Two-Branch 백본 기반 깊이 완성 연구

Copyright Ⓒ 2024 KSAE / 224-08

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

A part of this paper was presented at the KSAE 2023 Fall Conference and Exhibition

Abstract

Depth estimation on surrounding environments is one of the key components in autonomous driving applications, such as object detection and SLAM. To predict the depth of scene accurately, depth completion combines information from a sparse LiDAR depth map and a camera image. In this paper, we proposed a two-branch architecture based on CNN and a Vision transformer to fuse different modalities from heterogeneous sensors. To fuse two modalities, the proposed model consists of two branch modules: a coarse-branch and a fine-branch. Using the sparse depth map and an image, the coarse-branch module generates a coarse depth map that focused on color information. The fine-branch module estimates a final dense depth map focused on depth information through the color-dominant depth map and the sparse depth map. Experiments on the NYUv2 dataset demonstrated that the proposed method outperformed previous models.

Keywords:

Depth completion, Deep learning, Multi-modal learning, Vision transformer, Residual connection키워드:

깊이 완성, 딥러닝, 멀티모달 러닝, 비전 트랜스포머, 잔차 연결1. 서 론

최근 자율주행 기술이 고도화됨에 따라, 정확한 환경 인식을 위해 다양한 센서를 기반으로 한 인지 연구들이 진행중이다. 특히 카메라와 라이다(LiDAR) 센서는 주변 환경을 인식하고, 깊이 정보를 추출하는데 주로 활용되고 있다. 카메라 센서의 경우 물체의 색상과 질감을 포함한 고밀도의 풍부한 정보를 제공하는 장점이 있지만, 정확한 거리 정보를 추정하는데 한계가 존재한다. 반면 라이다 센서는 레이저 신호를 기반으로 거리를 측정하여, 매우 정확한 깊이 정보를 제공하는 특성을 가지고 있다. 그러나 라이다 원시 데이터(Raw data) 내 유효한 깊이 정보가 채워져 있는 픽셀 정보는 매우 희소(Sparse)하며, 객체 경계 주변에 노이즈가 많이 발생하는 단점이 있다. 각 센서들이 가진 문제점들을 해결하기 위한 대안으로 센서 퓨전(Sensor fusion) 기술이 도입되었다. 이는 Table 1과 같은 상호보완적인 특성을 활용하여, 카메라와 라이다가 가진 단점들을 극복할 수 있다는 이점이 존재한다. 특히 센서 퓨전 기반 인식 기술 중, 라이다의 희소한 깊이 지도와 RGB 이미지를 융합하여, 정확하고 고밀도의 깊이 지도를 생성하는 깊이 완성(Depth completion) 기술이 활발히 연구되고 있다. 이는 한 장면(Scene) 내 구조적 깊이를 추정함으로써 자율주행, 증강현실, 3D 재구성과 같은 다양한 3D 비전 응용 작업에 도움을 줄 수 있다.

최근 딥러닝의 발전에 따라 CNN(Convolutional Neural Network)을 활용한 깊이 완성 기법들이 좋은 성능을 보여주었다. 대부분의 초기 방법들은 CNN을 기반으로 한 Single-branch 모델 구조를 사용하였다. 그러나 이러한 구조는 깊이 완성을 수행하는데 크게 2가지의 문제점이 존재한다.

첫 번째로, 깊이 완성 성능 향상의 한계이다. 깊이 완성 작업의 특성 상 양식(Modality)이 다른 라이다와 카메라 데이터들을 융합하는 방법에 따라 성능이 결정되기 때문에, 단순히 두 데이터를 결합(Concat)하여 사용하는 Single-branch 방식은 성능 개선에 한계가 존재한다. 이러한 문제점을 해결하고, 두 데이터를 효과적으로 활용하기 위해 Two-branch 구조를 기반으로 한 모델이 제안되었다. Two-branch 기반 모델은 RGB 이미지와 희소한 깊이 지도를 각각 다른 구조를 가진 네트워크를 통해 특징을 추출하여, 두 특징을 융합하는데 중점을 둔 방식이다. 예를 들어 PENet1)은 색상과 깊이 정보에 대해 다른 네트워크를 사용하여 각각의 깊이 완성 지도와 신뢰성 지도를 추정하고, 이후 신뢰성 지도를 기반으로 가중 합을 통해 최종 깊이를 완성하게 된다. FusionNet2) 또한 지역적(Local)인 특징과 전역적(Global)인 특징 정보를 각각 추출하기 위해 Two-branch로 구성된다. DeepLiDAR3) 모델도 색상과 법선 벡터(Surface normal) 브랜치로 나누어, 네트워크 내 다중 융합 방식을 적용하여 깊이 완성을 수행하였다. 이와 같이 Two-branch 기반 특징 학습을 통해, 두 센서 데이터들을 적응적으로 활용함으로써, 깊이 완성 성능을 향상할 수 있다는 것이 입증되었다.

두 번째 문제로는, 일반적인 CNN 기반 깊이 완성 모델은 이미지의 전역적인 장거리 관계를 모델링하기 어렵다는 점이다. CNN 기반 모델들은 고정된 커널(Kernel)을 이용하여 인접한 픽셀 간의 관계를 파악하기 때문에, 전역적인 공간에서의 특징 추출에 한계가 있다. 최근 이 문제점을 해결하기 위해 전체 이미지에 걸친 정보 관계를 잘 파악하는 비전 트랜스포머(Vision transformer)를 깊이 완성 분야에 적용하기 시작하였다. GuideFormer4) 모델은 비전 트랜스포머를 깊이 완성 분야에 처음으로 도입하여 성능 향상의 가능성을 보여주었다. 그러나 비전 트랜스포머의 구조적 특성으로 인해, 이미지 패치(Patch)를 벡터로 투영하는 과정에서 지역적인 특징 손실이 발생하는 문제가 있었다. 이 한계를 보완하고자, CompletionFormer5) 모델이 제안되었다. 이는 CNN 기반의 지역적 특징과, 비전 트랜스포머 기반의 전역적 특징을 조합하여 JCAT(Joint Convolutional Attention and Transformer) 블록으로 통합함으로써, 모든 공간에 대한 특징 추출을 수행한다. 최근 이와 같은 방식으로 CNN과 비전 트랜스포머를 결합한 모듈을 사용하여 깊이 완성을 수행함으로써, 깊이 완성 벤치마크에서 우수한 성과를 거두고 있다.

위에서 언급된 두 가지 문제점을 동시에 해결하기 위해, 본 논문에서는 두 해결책을 적용한 네트워크를 설계한다. 최근 트랜스포머를 활용하여 우수한 성능을 보인 CompletionFormer 백본(Backbone)을 베이스 모델로 채택하여, Two-branch 구조 기반 모델을 제안한다. 기존의 Single-branch로 구성된 베이스 모델은 RGB 이미지와 깊이 지도를 단순히 결합하여, 두 센서 데이터들을 완전히 활용할 수 없다는 단점이 존재하였다. 두 센서를 제대로 활용하지 못하기 때문에, 정확한 깊이 완성 지도를 생성하기 어렵다는 한계 또한 분명하였다. 이를 극복하고자, 재설계된 제안 모델은 색상에 집중하여 특징을 학습하는 Coarse-branch와, 깊이에 집중하여 특징을 학습하는 Fine-branch로 구성된 Two-branch 백본으로 이루어진다. 제안 모델은 각 브랜치에서 도출된 깊이 지도를 융합하여, 양식이 다른 두 데이터들을 완전히 이용할 수 있도록 한다. 또한 학습 과정에서 특징이 손실되지 않도록 JCAT 블록 내 계층 간 잔차 연결을 추가해줌으로써, 모델의 성능을 안정적으로 개선되도록 한다. NYUv2 데이터셋에 대한 실험 결과는 본 논문에서 설계한 네트워크가 기존 모델들의 성능을 능가한다는 것을 보여준다.

2. 방법론

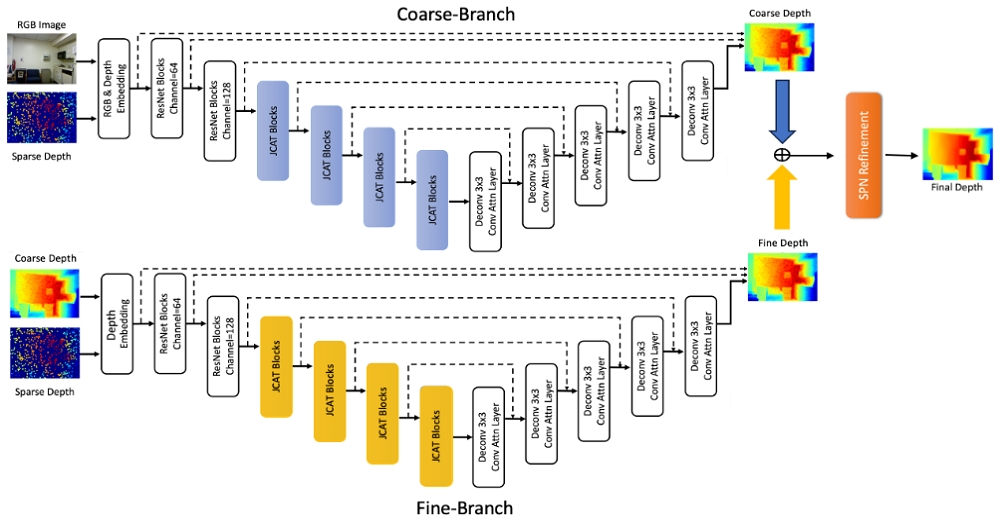

본 장에서는 제안하는 깊이 완성 기법에 대하여 소개하고자 한다. Fig. 1과 같이 본 논문에서 제안하는 모델은 기존 Single-branch 모델의 단점을 보완한 Two-branch 구조로 구성되어 있다. 이는 카메라의 RGB 정보를 중점적으로 학습하는 Coarse-branch, 라이다의 깊이 정보를 중점적으로 학습하는 Fine-branch로 이루어진다. 서로 상호보완적인 센서 정보들을 중심으로 각각 학습한 이후, 융합하는 본 모델을 통해 깊이 완성 성능을 효과적으로 향상시킬 수 있다.

2.1 Two-branch Backbone

Two-branch 구조의 모델은 각각의 브랜치에서 RGB 이미지와 희소한 깊이 지도 정보를 잘 학습할 수 있도록 Coarse-branch와 Fine-branch로 이루어진다. 기존 모델의 Single-branch 구조는 희소 깊이 지도에서 객체 경계에 생기는 노이즈들을 줄일 수 없다는 문제점이 존재하였다. 이러한 문제점을 해결하고자 본 논문에서는 두 브랜치에서 각각의 데이터 특성을 중심으로 학습을 진행한 후, 도출된 깊이 지도들을 융합하도록 모델을 설계한다. 제안한 구조를 통해 RGB 이미지와 희소 깊이 지도의 특성을 완전히 이용하고, 서로의 장점들을 살려 정교한 특징 학습이 가능하도록 한다.

먼저 Coarse-branch는 RGB 이미지와 희소한 깊이 지도를 입력으로 받아, 색상을 중심으로 깊이 지도를 생성한다. 이는 색상 정보와 질감을 중점적으로 보기 때문에, 객체 경계 주변의 깊이를 효과적으로 학습할 수 있다는 장점이 존재한다. 더불어 고밀도의 이미지 내 구조 정보에 집중하므로 작은 물체에 대한 깊이 또한 효과적으로 추출해낼 수 있다. 본 브랜치에서 사용된 백본은 CompletionFormer의 Joint Convolutional Attention and Transformer(JCAT) 모듈을 기반으로 설계된다. JCAT 모듈은 CNN과 비전 트랜스포머 네트워크가 병렬로 조합하여 구성되며, 각 네트워크마다 특징을 추출한 후, 이러한 특징들을 더해준다. CNN과 비전 트랜스포머를 한 모듈 내 통합함으로써, 이미지 내의 지역적 및 전역적인 특징을 효과적으로 추출할 수 있도록 설계하였다. 또한 JCAT 블록을 백본으로 사용하기 때문에, 네트워크의 수용 영역(Receptive field)을 전역적으로 확장할 수 있도록 하였다. 본 논문에서 사용된 인코더-디코더 네트워크는 5단계로 구성되어, 서로 다른 스케일의 특징들 간 영향을 받을 수 있도록 한다.

Fine-branch에서는 Coarse-branch의 결과인 Coarse depth map과 희소 깊이 지도를 입력으로 받아, 깊이를 중심으로 깊이 지도를 예측하는 것을 목표로 한다. 이전 브랜치에서 생성된 깊이 지도를 가이드 삼아 더 정교하게 학습함으로써 기존보다 향상된 성능을 얻을 수 있다. 또한 본 브랜치에서는 깊이를 중점으로 학습된 깊이 지도를 기반으로 하여, 기존 모델보다 깊이 정제 과정을 한번 더 거치기 때문에 훨씬 강력한 깊이 완성을 수행한다. 구체적인 과정은 이전 브랜치와 동일하게 두 입력 정보를 결합하여 임베딩한 후 다음 네트워크에 넘겨준다. 인코더-디코더 네트워크는 Coarse-branch와 동일하게 JCAT 모듈을 기반으로 5단계로 설계하였다. 마지막 디코더의 결과로 도출된 Fine depth map와 앞선 Coarse-branch 브랜치의 Coarse depth map과 융합한다. 목적이 다른 각 브랜치들을 통해 도출된 깊이 지도들은 서로 상보적인 특징을 가지고 있다. PE-Net을 통해 Late-Fusion 방식이 상호 보완적인 두 특징을 효과적으로 표현할 수 있음에 영감을 받아, 각 센서에서 중점적으로 학습된 Coarse depth map과 Fine depth map을 Late-Fusion 방식으로 결합하였다. Two-branch에 거쳐 긴 과정 동안 깊이 정보 특징들을 학습하면서, 예측된 깊이 지도의 픽셀에 누락 값이 발생하는 문제점을 확인하였다. 이러한 누락 값을 채워 넣기 위해, 유효한 깊이 값들을 공간적으로 전파시켜 깊이를 정제하는 Spatial Propagation Network(SPN)이 사용되었다. 앞서 융합된 깊이 지도와 희소 깊이 지도의 신뢰성 값을(Confidence) 기반으로, 픽셀 간의 관련성(Affinity)을 계산한다. 그 후, 유효한 깊이 값들을 누락된 픽셀에게 전파함으로써 깊이를 정제한다. 본 모델은 베이스 모델과 동일하게 본 논문에서도 깊이 정제 모듈인 Non-Local Spatial Propagation Network(NLSPN)6) 모델을 후처리 과정에 사용한다. NLSPN은 관계성이 더 큰 픽셀에 집중한 형태의 변형 커널을 이용하여, 효과적으로 유효한 깊이를 전파할 수 있도록 한다.

2.2 Residual Connection

ResNet7)에 처음 도입된 잔차 연결(Residual connection)은 입력 데이터에 모델이 예측한 특징을 추가해주는 방법이다. 이를 기반으로 네트워크의 가중치 소실 문제를 해결하며, 효과적인 성능 개선을 입증하였다. 본 모델에서도 성능 개선을 위해 JCAT 블록 내 잔차 연결을 추가하여, Two-branch의 긴 학습 과정 중에도 특징 정보가 손실 되지 않도록 설계되었다. 이를 통해 입력의 특징을 완전히 무시하지 않고, 잔차 연결을 통해 모델이 풍부한 정보를 활용하여 학습할 수 있다.

2.3 Loss Function

본 논문에서 제안한 모델을 학습하기 위해 L2 손실함수를 사용하여 학습을 진행한다.

| (1) |

각 브랜치 별 손실을 계산하기 위한 수식 (1)에서 은 모델이 예측한 깊이 지도를 의미하며, Dgt는 학습을 위한 실제(Ground truth) 깊이 지도, ⊙은 요소별(Element-wise) 곱을 의미한다. 또한 1( )은 판별자(Indicator)를 의미하는데, 실제 값의 깊이 지도에도 유효하지 않는 픽셀이 포함되어 있기 때문에, 유효한 픽셀만 고려하도록 손실함수를 구성하였다.

| (2) |

또한 전체 손실을 나타내는 수식 (2)와 같이 Coarse-branch와 Fine-branch의 손실 값을 더하여 전체 모델 학습에 반영해주도록 하였다. 커널의 크기, 학습률, 배치와 같은 하이퍼파라미터 λ는 실험적으로 설정되었다.

3. 실 험

3.1 데이터셋

제안 모델을 검증하기 위해 본 논문에서는 NYUv28) 데이터셋을 사용하였다. NYUv2 데이터셋은 마이크로소프트 Kinect 카메라를 기반으로 실내 장면에서 촬영한 464개의 RGB이미지와 깊이 이미지로 구성된다. 이전의 깊이 완성 모델들의 실험 환경과 유사하게 본 연구에서는 균일하게 샘플링된 50,000개의 이미지에 대해 학습을 진행한다. 이후 평가를 위해 654개의 레이블이 지정된 테스트셋을 기반으로 모델을 테스트한다. 학습 및 테스트 셋 모두에서 640 × 480 크기의 원본 프레임을 이중 선형 보간(Bilinear interpolation)을 이용하여 절반만 다운 샘플링(Down-sampled) 한 후, 304 × 228 크기로 가운데를 잘라(Center-crop) 사용한다.

3.2 평가 지표

NYUv2 데이터셋을 기반으로 깊이 완성 모델을 평가하기 위해 다음과 같은 두 가지 표준 지표를 사용한다.

- Root mean squared error (RMSE)

| (3) |

- Mean absolute relative error (REL)

| (4) |

식 (3)의 RMSE는 실제 값과 예측한 깊이 지도를 픽셀 별로 깊이 값을 비교하여 mm단위로 오차를 측정하므로, 깊이 정확도와 직접적인 상관 관계가 있다. 이에 따라 KITTI 깊이 완성 벤치마크에서도 RMSE 지표를 기준으로 모델의 성능 순위를 매긴다. 본 논문에서도 일반적으로 많이 사용하는 두 평가 지표를 이용하여 모델의 성능을 평가한다.

3.3 실험 결과

본 논문에서는 NYUv2 데이터셋에서 제안 모델을 평가하였다. 제안 모델은 종단간(End-to-end)으로 학습이 진행되며, 테스트셋을 기반으로 다른 모델들과 성능을 비교하였다. Table 2는 NYUv2 데이터셋에서 제안 모델과 다른 깊이 완성 모델들과의 정량적 비교를 나열한다. 본 연구에서 제안한 모델은 REL 평가 지표를 기준으로 다른 모든 모델을 능가하는 성능을 보여준다. 더불어 벤치마크의 주 평가 지표인 RMSE 또한 SOTA 모델과 동일한 결과를 나타낸다. 특히 Table 3과 같이 기존의 베이스 모델인 CompletionFormer와 비교했을 때, RMSE 기준 17 mm, REL 기준 5.4 mm 이 개선됨을 확인할 수 있다. 즉 모든 평가 기준에서 전반적으로 더 향상된 성능을 보여주며 제안한 Two-branch 백본의 우수함을 입증한다.

Table 4는 베이스 모델부터 제안한 모델까지의 네트워크 구성에 따른 성능 차이를 보여준다. Single-branch로만 구성된 모델은 CompletionFormer이며, 여기에 부가적으로 잔차 연결을 추가하여 성능 평가를 진행하였다. 단순히 잔차 연결을 백본 내에 추가함으로써, 기존 모델보다 9 mm의 성능을 개선할 수 있었다. 또한 본 논문에서 제안한 Two-branch 백본은 기존 모델들 대비 각각 15 mm, 6 mm의 성능 향상을 달성했으며, 잔차 연결을 추가했을 시 더욱 정교한 깊이 완성이 가능하다.

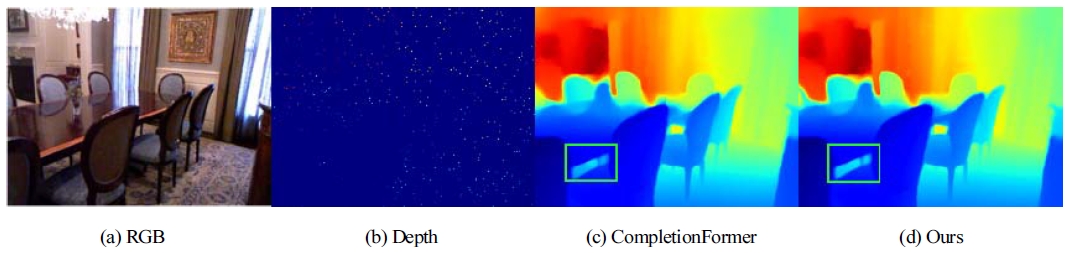

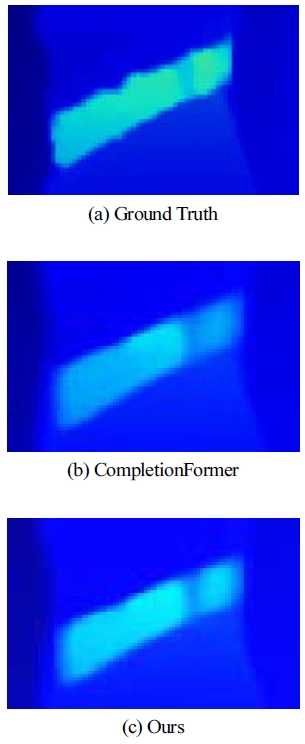

Fig. 2는 NYUv2 데이터셋의 RGB 이미지(a)와 희소한 깊이 지도(b)를 입력으로 받아 깊이 완성을 수행한 결과를 나타낸다. 결과 이미지는 깊이 정도를 수치화하여, 거리가 멀수록 빨간색, 가까울수록 파란색으로 시각화된다. 본 논문에서 제안한 기법과 비교하기 위해, 기준 모델인 CompletionFormer를 선정 하였다. 구체적인 차이를 확인하기 위해 Fig. 3과 같이 결과 이미지 내 연두색 직사각형 부분을 똑같은 배율로 확대하여, 정답 값을 기준으로 정성적 비교를 진행한다. 베이스 모델인 CompletionFormer(b)의 경우 실제 값(a)보다 객체 주변에서 픽셀들이 뭉개지는 것을 볼 수 있다. 반면 제안 모델(c)은 기존 베이스 모델 대비 훨씬 픽셀들이 선명하며, 객체 주변에서도 노이즈들이 비교적 줄어든 것을 확인할 수 있다. 본 연구에서 제안한 Two-branch 기반 백본을 통해, 카메라와 라이다 각각의 특성을 완전히 활용함으로써 정성, 정량적인 결과에서 모두 향상된 성능을 입증한다.

4. 결 론

본 연구에서는 기존의 CompletionFormer 모델을 Two-branch 구조로 변경하여 효과적으로 깊이 완성을 수행하는 새로운 모델을 제안한다. Single-branch로 구성된 기존 모델은 양식이 다른 두 센서 간 데이터들이 융합되는데 한계가 존재하였다. 이 문제점을 해결하기 위해 제안한 모델은 먼저 RGB이미지와 희소한 깊이 지도를 입력으로 받아 Coarse한 깊이 정보를 가진 깊이 지도를 추출한다. 이후 Coarse한 깊이 지도와 이전에 입력으로 제공한 희소 깊이 지도를 두 번째 브랜치로 전달하여, 더 정밀하고 안정적으로 깊이 완성을 수행한다. 이러한 모델 구조를 통해 양식이 다른 두 센서 데이터들이 효과적으로 융합할 수 있다. 더불어 베이스 모델에서 제안한 JCAT 블록 내 잔차 연결을 추가하여, Two-branch의 긴 학습 과정 중에도 특징 정보가 손실 되지 않도록 설계되었다. 결과적으로 본 논문에서 제안한 모델은 기존에 비해 모든 평가 지표에서 전반적으로 성능이 향상되었으며, SOTA 모델인 BEV@DC와 비교하여 동등하거나 더 나은 성능을 보여준다. 다만 본 연구의 한계로는 비전 트랜스포머를 기반으로 한 모델 구조이기 때문에, 많은 메모리와 연산량을 필요로 한다는 점이다. 베이스 모델 대비 깊이 완성 성능을 향상시켰지만, 추론 속도는 기존의 10 fps 대비 6f ps로 저하되었다. 향후 연구 방향으로는 개선된 성능은 유지하면서, 더 빠른 추론 속도를 달성할 수 있는 효율적인 깊이 완성 모델을 개발하고자 한다.14)

Acknowledgments

이 논문은 전남대학교 학술연구비(과제번호: 2023-0487) 지원에 의하여 연구되었음. 본 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(RS-2022-00166693). 본 연구는 과학기술정보통신부 및 정보통신기획평가원의 인공지능융합혁신인재양성사업 연구 결과로 수행되었음(IITP-2023-RS-2023-00256629).

References

- M. Hu, S. Wang, B. Li, S. Ning, L. Fan, and X. Gong, “PENet: Towards Precise and Efficient Image Guided Depth Completion,” ICRA, 2018.

-

W. V. Gansbeke, D. Neven, B. D. Brabandere, and L. V. Gool, “Sparse and Noisy Lidar Completion with RGB Guidance and Uncertainty,” MAV, 2019.

[https://doi.org/10.23919/MVA.2019.8757939]

-

J. Qiu, Z. Cui, Y. Zhang, X. Zhang, S. Liu, B. Zeng, and M. Pollefeys, “DeepLiDAR: Deep Surface Normal Guided Depth Prediction for Outdoor Scene from Sparse Lidar Data and Single Color Image,” CVPR, 2019.

[https://doi.org/10.1109/CVPR.2019.00343]

-

K. Rho, J. Ha, and Y. Kim, “GuideFormer: Transformers for Image Guided Depth Completion,” CVPR, 2022.

[https://doi.org/10.1109/CVPR52688.2022.00615]

-

H. Zhang, X. Guo, M. Poggi, Z. Zhu, and M. Mattoccia, “CompletionFormer: Depth Completion with Convolutions and Vision Transformers,” CVPR, 2023.

[https://doi.org/10.1109/CVPR52729.2023.01777]

-

J. Park, K. Joo, Z. Hu, C. Liu, and I. Kweon, “Non-Local Spatial Propagation Network for Depth Completion,” ECCV, 2020.

[https://doi.org/10.1007/978-3-030-58601-0_8]

- K. He, X. Zhang, S. Ren, and J. Sun, “Identity Mappings in Deep Residual Networks,” ECCV, 2016.

-

N. Silberman, D. Hoiem, P. Kohli, and R. Fergus, “Indoor Segmentation and Support Inference from RGBD Images,” ECCV, 2012.

[https://doi.org/10.1007/978-3-642-33715-4_54]

-

X. Cheng, P. Wang, C. Guan, and R. Yang, “CSPN++: Learning Context and Resource Aware Convolutional Spatial Propagation Networks for Depth Completion,” AAAI, 2020.

[https://doi.org/10.1609/aaai.v34i07.6635]

-

S. Imran, X. Liu, and D. Morris, “Depth Completion with Twin Surface Extrapolation at Occlusion Boundaries,” CVPR, 2021.

[https://doi.org/10.1109/CVPR46437.2021.00261]

-

Z. Yan, K. Wang, X. Li, Z. Zhang, B. Xu, J. Li, and J. Yang, “RigNet: Repetitive Image Guided Network for Depth Completion,” ECCV, 2022.

[https://doi.org/10.1007/978-3-031-19812-0_13]

-

Y. Lin, T. Cheng, Q. Zhong, W. Zhou, and H. Yang, “Dynamic Spatial Propagation Network for Depth Completion,” AAAI, 2022.

[https://doi.org/10.1609/aaai.v36i2.20055]

-

W. Zhou, X. Yan, X. Liao, Y. Lin, Y. Huang, J. Zhao, G. Cui, and S. Li, “Bev@dc: Bird’s Eye View Assisted Training for Depth Completion,” CVPR, 2023.

[https://doi.org/10.1109/CVPR52729.2023.00891]

- S. Kim and C. Kim, “TB-CompletionFormer : Improved Depth Completion Based on Two-branch Backbone,” KSAE Fall Conference Proceedings, pp.1571-1577, 2023.