카메라 및 레이더 데이터의 딥러닝 융합 기법의 객체 검출 성능 향상 연구

Copyright Ⓒ 2024 KSAE / 224-04

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Autonomous vehicles utilize various sensors, such as cameras, radars, and LiDAR, to guarantee precise and reliable perception in diverse environments. However, fulfilling all the perception tasks with a single sensor led to active research in sensor fusion to identify the strengths and weaknesses of each sensor in analyzing the comprehensive environment. This paper investigated the fusion of the camera’s visual information and radar distance data to achieve more accurate and efficient environmental perception while driving. The study focused on the fusion method in terms of both data and speed, effectively combining radar detection points with the camera image plane to generate feature maps. An efficient approach was proposed, leveraging the characteristics of the YOLOv5 network for selective grid detection, and its effectiveness was explored. To evaluate the performance of the proposed method, YOLOv5-based detection models were trained and validated with RGB images from cameras and fused images with radar data. Furthermore, the impact of the selective grid detection method on processing speed was assessed by comparing the average processing speed per validation dataset. Experimental results confirmed both the effectiveness and efficiency of the proposed approach in facilitating object detection.

Keywords:

Autonomous vehicle, Recognition, Sensor fusion, Object detection, Deep Learning키워드:

자율주행차, 인식, 센서 융합, 객체 검출, 딥러닝1. 서 론

자율주행 기술은 현재 많은 관심과 기대를 받으면서 지속적으로 발전하고 있는 분야이다. 자율주행 차량은 안전하고 효율적인 주행을 수행하기 위해 다양한 기술과 시스템을 필요로 하며, 특히 센서를 통해 주변 환경을 정확히 인식하고 객체를 식별하는 인식 시스템은 핵심적인 역할을 수행한다. 자율주행 차량에 장착된 여러 센서들을 이용하여 주행 환경에서의 물체 탐지, 차선 인식, 장애물 회피 등 여러 인식 과제를 수행한다. 그러나 단일 센서만으로는 모든 인식 요구 사항을 완벽히 충족시키기에는 한계가 존재한다. 따라서 각 센서들의 장단점을 통합하고 상호보완하여 더욱 정확하고 신뢰할 수 있는 주행 환경 인식을 구현하는 것이 현대 자율주행의 필수적인 과제이다.1)

자율주행 차량의 주요 센서로는 라이다, 카메라, 레이더, GPS, IMU 등이 있으며, 이들을 목적에 맞게 조합하여 융합을 수행할 수 있다. 주로 사용되는 센서 조합은 카메라-라이다, 카메라-레이더, 그리고 카메라-라이다-레이더가 있다. 최근 카메라, 라이다, 레이더 세 가지 센서를 모두 동시에 활용하는 센서 융합에 관한 연구가 떠오르고 있으나, 이 중 가장 일반적으로 사용되어 온 것은 카메라와 레이더의 조합이다.2) 카메라와 레이더는 서로의 장단점이 상호 보완적이며 라이다에 비해 상대적으로 비용이 경제적이다. 이 때문에 이미 ADAS(Advanced Driver Assistance System) 등에 널리 쓰이고 있다. 카메라는 고해상도 이미지를 통해 세밀한 시각 정보를 제공하고, 객체의 시각적 특징을 인식하는 데 탁월하다. 그러나 기후와 빛에 취약하며, 거리 정보의 신뢰도가 제한적이라는 한계가 있다. 반면 레이더는 정보의 해상도가 상대적으로 낮아 객체 식별 성능이 약하나, 장거리에서의 객체 탐지와 속도 측정에 강점을 가지며, 날씨와 조도 조건에 영향을 받지 않는 안정적인 성능을 제공한다. 따라서 카메라와 레이더의 융합을 통해 시각 정보와 거리 및 속도 정보를 결합하고 다양한 환경에서 더욱 높은 신뢰성을 가진 환경 인식을 기대할 수 있다.

자율주행 차량은 도로상의 여러 객체를 실시간으로 인식하고 대응해야 하므로 처리 속도는 인식 시스템에 있어 중요한 요소이다. 그러나 처리속도와 함께 정확도를 높이는 것 역시 매우 중요하다. 따라서 이 두 가지 측면을 균형 있게 고려하는 것이 자율주행 차량의 인식 시스템 최적화에 있어 중요한 과제이다. 따라서 본 논문은 카메라와 레이더의 융합을 통해 자율주행 차량의 주행 안정성과 객체 인식 능력을 향상시키는 것을 목표로 한다. 또한 두 센서의 비용적인 이점을 활용하기 위해 하드웨어 자원이 제한된 상황에서 효율적인 환경 인식을 구현 방법을 제안하고자 한다. 본 연구는 레이더의 원시(Raw) 데이터를 카메라 이미지 평면에 투영하여 새로운 채널 형태로 융합한 데이터를 생성한 후, 이를 YOLOv5 기반 네트워크에 입력하여 객체 검출을 수행하는 알고리즘을 제안한다. 해당 네트워크는 2D 평면에서 객체 검출을 수행하고, 생성된 특징 맵을 통해 객체 검출을 실시간으로 수행한다. 이를 이용하여 주행 환경에서의 객체 감지와 분류를 정확하게 수행하는 동시에 처리 속도를 향상시키는 방법을 제시한다.

2. 관련 연구

2.1 센서 융합

센서 융합은 다양한 센서들로부터 수집된 정보를 효과적으로 결합하여 더 정확하고 신뢰할 수 있는 상황 인식을 달성하는 것을 목표로 한다. 여러 센서의 강점을 활용하고 단점을 보완함으로써 환경에 대한 더욱 포괄적인 이해를 제공하며, 전체 시스템의 신뢰성을 향상시킬 수 있다.3) 칼만 필터(Kalman filter) 등의 필터 기반 융합 기법이 주로 연구되어 왔으나, 최근 딥러닝을 활용하여 센서 융합 문제를 해결하는 연구가 주목받고 있다. 먼저 이미지 평면에 투영된 레이더 감지 포인트를 기점으로 기대되는 최대 높이와 너비를 고려한 ROI 창을 생성하고, 해당 영역 내에서 객체 분류를 진행하는 방법이 제안되었다.4) 또한 이미지 평면에 레이더 감지 포인트를 3 m 높이의 수직선으로 투영하는 방법과 카메라와 레이더 두 데이터를 입력받아 처리하는 네트워크 CRF-Net이 제안되었다.5) 2D 평면을 넘어 3D 공간에서 센서 데이터를 융합하는 시도도 있었다. 카메라로 감지한 결과를 기반으로 객체 주변에 3D 공간의 ROI 개념인 ‘ROI frustum’을 생성하여 레이더 포인트와 매핑(Mapping)하는 방법이 제안되었고,6) 또한 객체의 3D 월드 좌표를 극좌표로 변환하여 데이터의 차원을 낮추고, 트랜스포머 모델을 사용하여 카메라와 레이더의 공간 및 문맥 정보를 보완하는 방법도 제안되었다.

센서 융합의 방법은 이종의 데이터가 융합되는 지점에 따라 크게 세 가지로 분류할 수 있다. 각 센서의 원시 데이터를 병합하여 하나의 통합된 특징을 추출하거나 모델에 입력으로 제공하는 초기 융합(Early fusion), 각 센서에서 얻은 결과를 독립적으로 처리 후 최종 단계에서 융합하는 후기 융합(Late fusion), 그리고 각 센서에서 추출한 특징을 특징 공간 단계에서 융합하는 중기 융합(Intermediate fusion, Hybrid fusion)이 있다. 후기 융합과 중기 융합은 연산량이 많아 고성능 프로세서가 필요하지만, 초기 융합은 데이터 처리와 저장에 드는 비용을 절감할 수 있다. 또한 초기 융합은 센서 데이터를 보존하면서 더 풍부한 특징을 얻을 수 있다. 그러나 초기에 데이터를 결합하는 방식은 데이터 융합의 난이도가 높다는 것은 가장 어려운 부분 중 하나이다.7) 본 논문은 딥러닝을 활용하여 초기 융합의 센서 간 데이터 일치 문제에 접근하고자 한다.

2.2 1단계 검출기(One-Stage Detector)

딥러닝 기반 객체 검출 기법은 특징 추출과 객체 위치 예측을 두 단계로 나눠서 수행하는 2단계 검출기(Two-stage detector)와 두 작업을 동시에 수행하는 1단계 검출기(One-stage detector)로 나뉜다. 대표적인 2단계 검출기로는 R-CNN(Region-based Convolutional Neural Network),8) Faster R-CNN9) 등이 있다. 이들은 두 단계의 신경망을 사용하여 상대적으로 정확한 객체 검출을 제공하나 구현이 복잡하여 높은 계산 비용을 가지며 처리 속도가 상대적으로 느리다. 반면 SSD,10) YOLO11)과 같은 1단계 검출기는 하나의 신경망을 사용하기 때문에 구현이 비교적 간단하고 높은 처리 속도를 가지지만 정확도가 상대적으로 낮을 수 있다.

3. 카메라 및 레이더 데이터 융합 알고리즘

본 논문에서는 카메라와 레이더의 데이터를 효과적으로 융합하기 위해 레이더 감지 포인트를 카메라 이미지 평면에 투영하는 방법을 사용하였다. 레이더 포인트를 특정 형태를 가진 2차원 평면의 특징으로 변환한 뒤 이미지와 같은 사이즈의 특징맵 채널로 만들어 RGB 이미지의 새로운 채널로 결합하는 방식이다.

3.1 네트워크

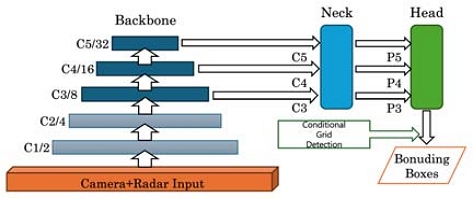

본 논문에서 제안하는 객체 검출 네트워크는 탁월한 실시간성과 성능으로 잘 알려진 YOLOv5 모델을 기반으로 한다. 기존의 네트워크의 입력부와 출력부의 구조를 목적에 맞게 수정하였다. 이미지만 입력받도록 되어 있는 모델의 입력부를 카메라 이미지와 레이더 데이터가 융합된 4채널 데이터를 입력받도록 하고, 모델의 검출부에 입력되는 그리드 셀을 제한하도록 했다. Fig. 1은 YOLOv5 네트워크의 구조를 나타낸 그림이다.

3.2 타원형 레이더 특징맵

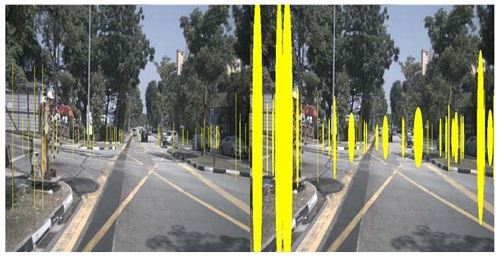

레이더 감지 포인트를 이미지 평면에 투영하여 실제 높이 3 m의 수직선 특징으로 변환한 레이더 특징맵을 생성하고, 이를 카메라 RGB 이미지에 추가 채널로 융합하는 방법의 선행 연구6)의 융합 기법은 수직 방향의 불확실성을 보완하기 위해 고안되었다. 이때 이미지 내 객체가 있는 곳에 위치한 레이더 특징맵 데이터는 네트워크가 데이터를 처리하는 과정에서 해당 영역을 활성화하는 가중치 역할을 할 것으로 예상된다. 그러나 레이더의 감지 포인트는 보통 하나의 점으로 객체를 관측하기 때문에 이미지 크기에 비해 밀도가 낮다는 특징을 가진다. 이러한 레이더 감지 포인트로부터 생성된 너비가 1픽셀인 수직선 역시 이미지 내 객체가 존재하는 면적에 비해 희박할 수 있으며, 이는 이미지 내 객체가 존재하는 영역을 모두 포함하기 어렵다. 특히 수평 방향, 즉 너비 및 면적에 관련된 포괄적인 정보를 보완할 필요성이 있다.

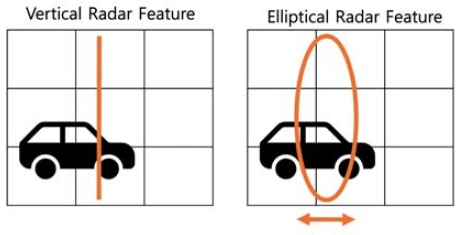

본 논문은 레이더 감지 포인트를 최하단 꼭짓점으로 하는 세로로 긴 형태의 타원 모양 특징으로 변환하는 방법을 제안한다. 각 타원 특징은 레이더의 깊이 정보로 채워져 있으며, 가능한 객체 존재 영역을 최대한 포함하도록 위치한다. 수직선 특징과 타원 특징의 형태를 비교하기 위해 각 형태의 레이더 특징맵을 Fig. 2에 시각화하였다. Fig. 2의 왼쪽 (a) 이미지는 수직선 형태, 오른쪽 (b) 이미지는 타원 형태의 레이더 특징을 나타낸 이미지이다. Fig. 3은 검출할 물체가 있는 영역을 가로 방향으로 포함하는 정도의 차이를 비교하기 위한 예시를 그림으로 나타낸 것이다.

(a) Vertical line radar feature from prior research(left), (b) Elliptical radar feature from proposed approach(right)

타원 형태의 레이더 특징이 수평 방향의 불확실성을 보완하면서 레이더의 감지 정보를 더 활용하기 위해 레이더가 제공하는 RCS(Radar Cross Section) 값을 이용하였다. RCS는 레이더 반사 단면적을 뜻하며 일반적으로 RCS 값이 클수록 레이더에게 목표 객체가 뚜렷하게 나타나므로 레이더 감지 범위의 증가로 이어진다. 이를 객체의 전반적인 면적에 대한 가중치로써 활용하여 레이더 감지 포인트로부터 특징맵을 생성할 때 RCS 값이 클수록 타원의 너비를 넓게 생성하도록 하였다. 그러나 RCS 값만으로는 객체의 크기에 대한 완전한 정보를 제공하지 못할 수 있다. 거리에 따라 레이더 신호의 반사량이 변하므로 RCS 값으로는 크기를 정확하게 판단할 수 없다.13) 가까운 객체일수록 더 많은 레이더 신호를 반사하고, 멀리 있는 객체는 적게 반사하기 때문이다. 이러한 이유로 타원의 폭을 결정할 때는 거리 정보도 함께 반영하여 RCS 값과 거리에 따라 적절한 타원을 형성하도록 조절하였다. 타원의 폭은 RCS 값과 비례하며, 거리와 반비례한다.

Fig. 2의 오른쪽 그림 (b)에서 멀리 있는 객체를 감지한 레이더 포인트로부터 생성된 타원들은 각기 다른 폭을 가지고 있다. 특히 차량 객체가 존재하는 영역에서는 타원 특징의 폭이 상대적으로 넓게 나타나는 것을 확인할 수 있다. 이렇게 객체의 크기와 거리 정보를 고려한 특징맵이 생성되며, 이를 통해 레이더의 감지 결과를 더욱 정확하게 표현할 수 있게 된다.

3.3 조건부 그리드 셀 검출

카메라와 레이더 데이터가 4채널 배열의 형태로 통합된 입력 데이터는 YOLOv5 기반 네트워크의 입력으로 전달된다. 객체 검출 네트워크는 기본적으로 YOLOv5의 모델 구조를 사용하되, 목적에 맞게 입력부와 검출부를 필요에 맞게 조정하였다. 기존 이미지만 입력받아 처리하는 입력부를 카메라와 레이더 데이터 모두를 입력받도록 하고, 조건에 해당하는 그리드 셀에서 검출을 수행하도록 검출부를 수정하였다.

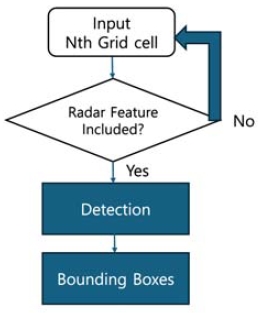

YOLOv5 모델은 입력 이미지를 가로 N개, 세로 N개의 그리드(Grid)로 분할한 뒤 각 그리드 셀(Grid cell)에서 앵커(Anchor)를 이용한 객체 검출을 수행하는 특징을 가지고 있다. 본 논문에서는 이러한 특징을 이용하여 검출 단계에서 입력되는 그리드 셀을 제한함으로써 계산 비용을 절감하는 방법을 고안하였다.

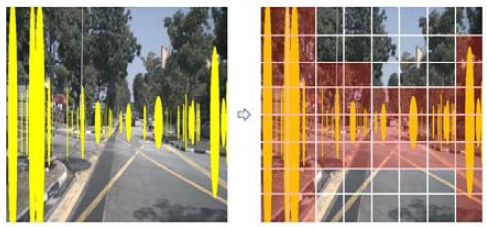

Fig. 4에 레이더 감지 포인트로부터 검출이 수행될 그리드 셀을 선택하는 방식을 시각적으로 나타내었다. 방식은 다음과 같다. 분할된 그리드 중 타원 특징 영역이 포함된 그리드 셀 및 그와 이웃한 그리드를 선택한다. 이때 선택되지 않은 영역은 도로 외 영역 또는 공중으로, 객체가 존재할 가능성이 낮은 위치에 해당한다. 네트워크는 이렇게 선택된 그리드 셀에 할당된 앵커를 이용하여 검출을 수행한다. 이로 인해 계산 비용을 절감함으로써 전반적인 객체 검출의 효율을 높일 수 있다. 해당 알고리즘은 Fig. 5에 블록 다이어그램으로 표현되었다.

4. 실 험

4.1 데이터셋

객체 검출 네트워크 학습에는 자율주행 연구를 위한 대규모 공개 데이터셋 중 하나인 Nuscenes 데이터셋14)의 v1.0-trainval이 사용되었다. 라이다, 레이더, 카메라 외에도 IMU, GPS 센서를 포함하여 다양한 센서 양식과 다양한 객체 카테고리에 대한 정교한 주석(Annotation)을 제공한다. Nuscenes는 ‘샘플(Sample)’ 단위로 데이터가 형성되어 있고, 한 샘플에는 차량 주변 360도 범위의 환경을 동기화된 라이다 1개, 레이더 5개, 그리고 카메라 6개가 인식하는 데이터가 포함되어 있다. 학습과 검증에 사용된 샘플은 각각 20,480개와 6,839개이다.

Nuscenes에서 제공하는 주석은 3D 경계 상자를 포함한 객체 속도, 가시성, 객체 상태 등의 정보를 제공한다. 본 논문에서 사용하는 네트워크는 2D 객체 검출을 수행하기 때문에 Nuscenes 데이터셋의 3D 경계 상자 주석(Center_x, Center_y, Center_z, Width, Length, Height)을 2D 경계 상자(Min_x, Min_y, Max_x, Max_y)로 변환하여 활용하였다. 데이터셋이 제공하는 카메라의 내부 및 외부 매개변수, 객체의 3D 위치와 회전 등의 정보를 기반으로 객체의 3D 경계 상자 꼭짓점을 2D 이미지 평면에 투영하고, 이를 이용하여 2D 경계 상자를 생성했다. 투영 과정은 객체의 크기와 비율을 보존하면서 2D 이미지 평면에 객체를 표현하므로, 객체 인식 알고리즘이 크기 및 비율 변화에 더 강인하게 대응할 수 있다.

4.2 실험 방법

제안하는 알고리즘의 성능 평가를 위해 동일한 샘플을 세 가지의 입력 데이터 형태로 학습 데이터셋과 검증 데이터셋을 구성하여 성능 평가를 진행했다. RGB 이미지로만 구성한 데이터셋(RGB only), 기존 연구6)의 레이더 수직선 특징맵으로 변환한 데이터셋(Vertical), 그리고 제안하는 방법의 타원 특징맵으로 변환한 데이터셋(Ellipse)으로 세 가지 데이터셋을 구성하였고, 각각 학습과 검증을 수행했다.

Table 1은 학습이 수행된 소프트웨어 환경을 정리한 것이다. Linux Ubuntu 18.04 LTS 기반으로 연구가 진행되었고, CUDA는 11.3 버전을 사용하였다. 딥러닝 프레임워크는 CUDA 버전에 맞추어 PyTorch 1.12.1 버전을 사용하였으며 Anaconda의 Python 3.9를 기반으로 개발되었다.

4.3 결과 및 고찰

성능 평가 지표는 객체 검출 모델의 성능을 평가하는 지표중 하나인 mAP(mean Average Precision, 평균 정밀도)를 사용했다. 그중에서도 IoU(Intersection over Union)의 임계값이 50 %일 때의 평균 정밀도인 mAP@50를 선택하였다. IoU는 두 개의 영역 또는 객체가 얼마나 겹쳐져 있는지를 나타내며 객체 검출에서 예측된 바운딩 박스와 실제 바운딩 박스 간의 겹침 정도를 측정하는 데 사용된다.

성능 평가를 위해 RGB only, Vertical, Ellipse 세 가지 데이터셋으로 각각 학습한 세 모델에 대해 동일한 검증 데이터셋으로 mAP@50을 계산하여 비교하였다. 또한 원거리 객체 검출 성능도 비교하였다. 거리가 40 m 이상인 객체의 경계상자만 남긴 검증 데이터셋에 대해 mAP@50을 계산하였다. 처리 속도는 검증 데이터셋의 ms 단위의 샘플당 추론 시간을 계산하였다. 단위는 세 가지 데이터셋의 mAP@50과 추론 시간을 표 4-3에 정리하였다. mAP와 처리 속도 실험 결과는 각각 Table 2, Table 3에 정리하였다.

Table 2에서 ‘Total’은 모든 검증 데이터셋을 의미하며, ‘Long Range’는 거리가 40 m 이상인 레이더 포인트의 데이터를 추린 데이터셋을 의미한다. ‘Total’데이터셋에서 모델이 학습한 세 가지 버전의 레이더 특징에 대한 mAP는 각각 0.301, 0.318, 0.324로 나타났으며, ‘Long Range’ 데이터셋에서는 각각 0.59, 0.633, 0.649의 mAP를 기록했다. 이 결과로부터 RGB 이미지만을 사용했을 때보다 레이더 특징이 융합될 때 mAP가 향상되었음을 알 수 있다.

또한 제안하는 레이더 특징의 데이터가 검출 성능 개선에 영향을 미쳤으며, 검출 효율성 면에서도 제안하는 검출 그리드 셀 제한 방식이 이미지 당 검출 시간을 단축시키는 것을 관찰하였다.

Table 3의 ‘General’은 일반적인 방법으로, ‘Proposed’는 본 논문에서 제안하는 조건부 그리드 셀 검출 방식으로 검출을 수행했음을 나타낸다. 각 레이더 특징 데이터셋 버전에 대해 ‘General’ 방식은 평균적으로 34.3 ms, 35.1 ms, 35.6 ms가 소요되었고, ‘Proposed’ 방식에 대해서는 32.7 ms, 34.2 ms, 33.8 ms가 소요되었다.

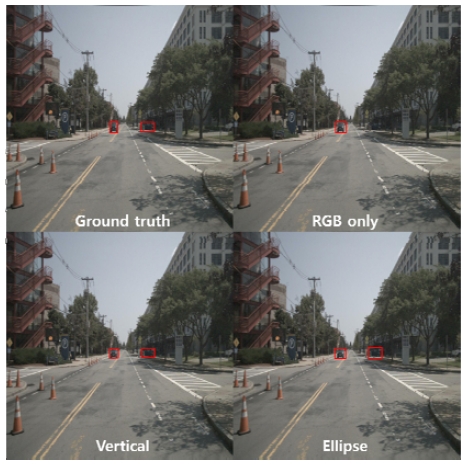

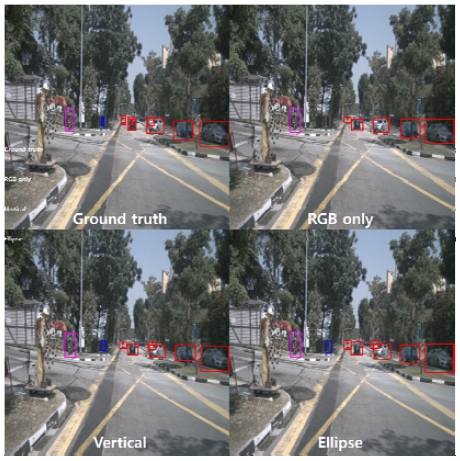

Fig. 6과 Fig. 7은 정답 데이터(Ground truth)와 비교군 데이터셋 세 가지의 객체 검출 결과에 대한 정성적인 평가 결과를 나타낸 이미지이다. 검출된 객체의 클래스는 경계 상자의 색으로 구분되었다. 빨간색은 차량(Vehicle.car), 파란색은 사람(Human), 그리고 분홍색은 자전거(Vehicle. bicycle)를 나타낸다.

실험 결과, RGB 이미지에 비해 RGB 이미지와 레이더 특징맵이 융합된 데이터로 학습된 모델이 멀리 있는 물체와 겹친 물체를 더 찾아내는 경향이 있었다. 그러나 해당 모델의 실질적인 사용을 위해 전반적인 검출 성능이 향상되어야 필요가 있다. 학습 데이터셋에 포함된 겹쳐진 물체들의 주석을 전반적인 성능 저하의 원인으로 추정하였다. 레이더 데이터 특성상 가려진 물체의 감지 포인트를 2D 이미지 평면에 투영할 때 이미지 상에서는 나타나지 않는 객체를 가리킬 수 있다. 이러한 겹쳐진 주석을 걸러낸 데이터로 학습 시 객체 특징을 추출할 때 미치는 영향에 대해 추가적인 연구가 필요할 것으로 보인다.

5. 결 론

본 논문에서는 자율주행 차량의 카메라 및 레이더 데이터 융합 기법을 통한 객체 검출의 성능 향상에 관한 연구를 진행하며 두 가지 융합 기법을 제안하였다. 레이더에서 감지한 객체 감지 정보를 카메라 이미지 평면에 투영하여 특징맵 생성 시 타원 형태의 레이더 특징을 생성하는 방법과 레이더 특징맵을 활용하여 검출을 수행할 그리드 셀을 제한하는 방법으로, 객체 검출의 정확성과 속도에 대한 개선을 시도하였다.

이 연구의 기여는 다음과 같다. 각 레이더 감지 포인트로부터 생성된 타원 형태의 레이더 특징은 수직선 형태의 특징에 비해 가로 방향, 즉 객체의 너비를 더 보완할 수 있다. 이때 레이더 감지 값인 RCS 값을 이용하여 타원 너비를 결정하며 레이더 특징의 효율성을 높였다. 또한 YOLOv5 네트워크의 특징을 활용하여 객체가 존재할 가능성이 높은 영역에서만 검출을 수행하도록 해서 객체 검출의 효율성을 증가시켰으며, 레이더 특징을 이용해 지역 제안을 하는 방식에 새로운 방법을 제안했다.

해당 방법의 실효성을 평가하기 위해 YOLOv5 기반의 객체 검출 네트워크를 학습 및 검증을 수행하여 성능 평가를 진행했다. 객체 검출 모델은 카메라 이미지 데이터셋, 비교 대상인 기존 연구의 카메라 이미지와 수직선 레이더 특징맵 데이터셋, 그리고 제안하는 방법인 카메라 이미지와 타원 레이더 특징맵 데이터셋으로 각각 학습 후 동일한 검증 데이터셋으로 mAP를 측정하였다. 실험 결과 제안하는 방법에서 멀리 떨어진 객체나 작은 객체에 대한 검출 성능이 향상되었다. 또한, 객체 검출 수행 그리드를 제한하는 방법은 처리 속도를 줄여 객체 검출의 효율성을 확보할 수 있었다. 이러한 결과들은 자율주행 차량의 환경 인식 및 객체 검출에 있어서 레이더 데이터 활용의 새로운 가능성을 제시한다.

Acknowledgments

본 논문은 산업통상자원부가 지원한 ‘자율주행기술개발혁신사업’의 지원을 받아 수행된 연구 결과입니다[과제명: Lv.4 자율주행시스템의 FailOperational 기술개발 / 과제번호: 20018055]. 또한, 본 연구는 국토교통부/국토교통과학기술진흥원의 지원으로 수행되었음(과제번호 RS-2021-KA160501).

References

- K. Chu, J. Han, M. Lee, D. Kim, K. Jo, D. Oh, E. Yoon, M. Gwak, K. Han, D. Lee, B. Choe, Y. Kim, K. Lee, K. Huh and M. Sunwoo, “Development of an Autonomous Vehicle: A1,” Transactions of KSAE, Vol.19, No.4, pp.146-154, 2011.

-

Z. Wang, Y. Wu and Q. Niu, “Multi-Sensor Fusion in Automated Driving: A Survey,” IEEE Access, Vol.8, pp.2847-2868, 2020.

[https://doi.org/10.1109/ACCESS.2019.2962554]

-

D. Yeong, G. Velasco-Hernandez, J. Barry and J. Walsh, “Sensor and Sensor Fusion Technology in Autonomous Vehicles: A Review,” Sensors, Vol.21, No.6, Paper No.2140, 2021.

[https://doi.org/10.3390/s21062140]

-

R. Hartley and A. Zisserman, “Multiple View Geometry in Computer Vision,” Cambridge University Press, 2003.

[https://doi.org/10.1017/CBO9780511811685]

-

F. Nobis, M. Geisslinger, M. Weber, J. Betz and M. Lenkamp, “A Deep Learning-Based Radar and Camera Sensor Fusion Architecture for Object Detection,” 2019 Sensor Data Fusion: Trends, Solutions, Applications (SDF), IEEE, 2019.

[https://doi.org/10.1109/SDF.2019.8916629]

-

R. Nabati and H. Qi, “CenterFusion: Center-Based Radar and Camera Fusion for 3D Object Detection,” Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, pp.1527-1536, 2021.

[https://doi.org/10.1109/WACV48630.2021.00157]

-

G. Hernandez-Penaloza, A. Belmonte-Hernandez, M. Quintana and F. Alvarez, “A Multi-Sensor Fusion Scheme to Increase Life Autonomy of Elderly People with Cognitive Problems,” IEEE Access, Vol.6, pp.12775-12789, 2018.

[https://doi.org/10.1109/ACCESS.2017.2735809]

-

R. Girshick, J. Donahue, T. Darrell and J. Malik, “Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.580-587, 2014.

[https://doi.org/10.1109/CVPR.2014.81]

- S. Ren, K. He, R. Girshick and J. Sun, “Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks,” Advances in Neural Information Processing Systems, Vol.28, 2015.

-

W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C. Y. Fu and A. C. Berg, “SSD: Single Shot Multibox Detector,” Computer Vision – ECCV 2016: 14th European Conference, Amsterdam, The Netherlands, October 11-14, 2016, Proceedings, Part I 14, Springer International Publishing, 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

J. Redmon, S. Divvala, R. Girshick and A. Farhadi, “You Only Look Once: Unified, Real-Time Object Detection,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.779-788, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

- GitHub, https://github.com/ultralytics/yolov5, , 2023.

- J. Lee, “An Application of Computer Vision and Laser Radar to Collision Warning System,” Transactions of KSAE, Vol.7, No.5, pp.258-267, 1999.

-

Z. Wang, Y. Wu and Q. Niu, “Multi-Sensor Fusion in Automated Driving: A Survey,” IEEE Access, Vol.8, pp.2847-2868, 2020.

[https://doi.org/10.1109/ACCESS.2019.2962554]