자율주행 시스템을 위한 시뮬레이션 기반 SOTIF 위험 분석 및 위험 평가 방법론

Copyright Ⓒ 2024 KSAE / 221-02

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Amid the rapid growth of autonomous driving technology, it is essential to conduct research on the safety elements of the mobility systems based on their automated capacities. This led to increased interest in developing processes that ensure the safety of autonomous vehicles, particularly the safety analysis and assessment from the perspective of the Safety of the Intended Functionality(SOTIF). This paper applies the System-Theoretic Process Analysis(STPA) method to the SOTIF risk analysis process in assessing the risks associated with a camera-based Adaptive Cruise Control(ACC) system. The STPA process was used in identifying risk scenarios, and the performance limitations of the perception sensors were implemented in the simulation tool. This set up appropriate criteria in assessing potential risks in the system within a simulated environment. Finally, based on the risk assessment of the scenarios, this paper discusses the system’s design objectives and improvement guidelines on risk avoidance.

Keywords:

Autonomous driving system, STPA, SOTIF, Hazard analysis & risk assessment, Performance limit, Take over time키워드:

자율주행 시스템, 시스템-이론적 프로세스 분석, 의도된 기능의 안전성, 위험 분석 및 평가, 성능 한계, 제어권 전환 시간1. 서 론

자율주행차 산업은 우리의 예측을 뛰어넘는 거대한 시장 규모로 성장하고 있다.1) 자율주행 관련 기술이 급속하게 성장함과 동시에 차량의 부품들이 전장화 되고 차량 전체를 소프트웨어로 제어하는 Software defined vehicle를 목표로 기술 발전이 이뤄지고 있다. 하지만 전기/전자 시스템의 복잡성은 예상치 못한 결함이나 사고로 이어지기도 하기 때문에 시스템의 안전성 및 신뢰성에 대한 검증은 점차 강조되고 있다.2-3) 현재 자동차 업계에서는 시스템의 안전성을 확보하기 위해 기능 국제 표준인 “ISO 26262 – Road Vehicle – Functional Safety”를 활용해 기능안전 분석을 수행하고 시스템의 내부 고장 및 컴포넌트의 결함으로 발생하는 위험을 식별하여 차량 안전성을 확보하고 있다.4) 하지만 인지센서의 데이터엔 예측 불가능한 무작위 외란들이 존재하고 자율주행 시스템에 발생하는 문제는 기존의 ISO 26262 기반 기능안전 분석만을 활용하여 해당 사고를 방지하는데 한계가 존재한다.5,6)

시스템의 성능한계로 발생하는 사고는 특정 운용 상황이나 조건에서 시스템이 안전하게 작동할 수 있도록 충분한 분석을 통해 설계되지 못했거나 고려하지 못한 변수들로 인해 발생한다. 이는 Safety of The Intended Functionality(SOTIF: ISO/PAS 21448) 관점에서의 문제인데 SOTIF란 의도된 기능에 대한 안전이라는 뜻으로 시스템의 성능/기능적 한계나 예측 가능한 사용자의 오용으로 인해 발생하는 위험을 식별하고 대응하기 위한 안전 표준이다. 따라서 빠른 속도로 성장하는 자율주행 기술 개발 속도에 맞춰 SOTIF 관점 안전 분석 및 평가를 통해 자율주행 차량의 안전을 확보하는 프로세스가 개발되어야 한다. 특히, 높은 안전 요구사항이 요구되고 시스템 제어 의존도가 높아지는 자율주행 Level 3 이상의 자율주행 시스템을 개발하기 위해서 SOTIF 관점 위험 분석 및 평가 연구는 필수적이다.

따라서 SOTIF 관련 안전을 확보하기 위한 연구는 증가하고 있는 추세이며 자율주행 Level 3 수준을 Target system으로 선정하고 대상 시스템의 성능을 평가하거나 및 위험원을 분석하는 연구가 진행되고 있다.7)

SOTIF 상황에서 시스템의 성능저하를 확인하고 SOTIF 관점 성능한계 상황에서 인지 알고리즘의 개선의 필요성을 확인한 연구는 다음과 같다. Peng 등8)은 mAP와 MCD method를 통해 Fog, Snow, Glare, Rain 상황에서 카메라 성능한계 시 인지성능의 불확실성을 평가하였다. 인지 알고리즘으로는 YOLOv3를 사용하였고 실험 결과 카메라 SOTIF 상황에서 불확실성이 증가하여 개선이 필요함을 확인하였다. 또한, 현존하는 오픈 데이터셋이 불충분한 인지 알고리즘 성능과 동적 운영환경에서 야기될 수 있는 SOTIF 성능한계를 포함하고 있지 않음을 지적하며 카메라 SOTIF 상황을 야기하는 Environment 요소와 Object 요소를 정의하고 이를 포함한 Long-Tail traffic scenario 데이터셋을 제시하였다. 이 후 You Only Look One(YOLO), Regions with Convolutional Neural Networks features(R-CNN)등의 2D object detection 모델들을 통해 SOTIF triggering 요소를 포함한 데이터 셋에서 검출 성능이 하락하는 것을 확인하였고 SOTIF 관점 위험을 방지하기 위한 데이터셋의 연구 필요성을 주장하였다.9)

또한, 시스템에 발생할 수 있는 기능안전 관점의 위험과 SOTIF 관점의 위험을 분석하여 위험원을 도출하거나 위험 시나리오를 도출한 연구는 다음과 같다. Xuezhus 등10)은 SOTIF 영역의 안전 분석을 위해 Systems-Theoretic Process Analysis(STPA) 안전 분석 기법의 Control structure를 활용한 시나리오를 생성하는 것을 제안하였으며, 자율주행 시스템 중 Adaptive Cruise Control(ACC)및 Object following과 같은 종, 횡방향 제어 기능에 대하여 안전분석을 진행하여 발생할 수 있는 위험을 도출하였다.

Khatun 등11)은 기능안전 관점과 성능한계의 관점에서의 복합적인 안전분석 기술을 고려한 확장 Hazard Analysis Risk Assessment(HARA)를 제안하였으며, 차선 변경 상황을 대상으로 안전분석을 진행하여 위험 시나리오를 도출하였다.

Lee 등12)은 한국 교통사고 통계분석과 자율주행 사고사례를 분석하여 기본(Logical) 시나리오와 테스트 시나리오를 도출하고, AEB 시스템을 기반으로 한 위험 시나리오 탐색 과정과 시나리오 탐색에 대한 평가지표를 제안하였다.

이원종과 기석철13)은 테스트베드용 VILS 시스템 제작 및 구성을 통해 SOTIF 관점 위험 검증을 위한 실차 시스템 기반 시뮬레이션 평가 환경을 구축하였지만 해당 환경을 사용하여 위험 분석이나 평가를 진행하지 않았다.

이처럼 대부분의 연구는 시스템의 성능 하락의 결과를 기반으로 기능안전과 SOTIF 관점의 연구 필요성을 주장하거나, 위험 시나리오를 도출했지만 테스트 환경에서 해당 위험 시나리오의 위험평가를 진행하여 검증하지 않았다. 이처럼 안전 분석 프로세스를 통해 도출한 시스템의 위험을 회피하기 위한 시스템 설계 요구사항이나 개선 가이드라인 도출 연구는 부족한 수준이다.

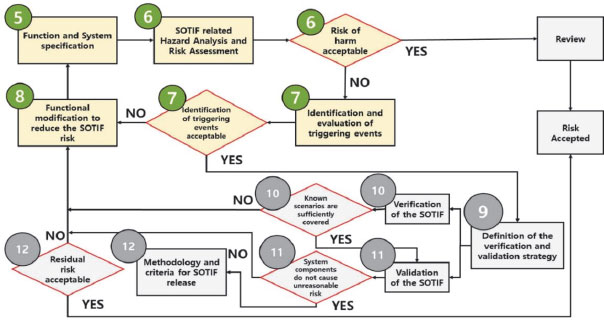

따라서 본 논문에서는 Fig. 1의 SOTIF 프로세스를 자율주행 차량에 적용할 수 있는 프로세스를 소개한다. 이 프로세스는 위험 분석부터 평가까지의 일련의 통합 절차를 포함하며 STPA 안전 분석 기법을 활용한 시나리오 도출 방법과 가상 시뮬레이션 기반 위험 평가 방법론을 제안한다. 또한, 도출된 위험을 회피하기 위한 시스템 설계사항을 정의하고 개선 가이드라인을 도출하는 프로세스를 제시한다.

2. STPA 기반 SOTIF 관점 위험 분석

과거부터 차량의 전장 시스템의 오작동으로 인해 발생할 수 있는 위험을 해결하고자 안전 수준을 충족하고 위험을 줄이기 위한 노력이 지속되어 왔다. 하지만 전통적 위험 분석 기법은 시스템 구성요소에 고장이 발생함을 전재로 위험을 식별하거나 소프트웨어 로직 간의 충돌로 인한 위험반영이 어렵다는 단점이 있다. 이러한 단점을 극복하기 위해 본 논문은 시스템이론에 기반한 최신 사고 분석 모델(STAMP) 기반 프로세스인 STPA를 기능 안전 분석에 적용한다. 따라서 본 장에서는 STPA 안전 분석 프로세스의 전체 과정을 각 단계별로 세분화하여 설명한다. 이는 자율주행 시스템의 예측 불가능성과 복잡성으로 인해 발생하는 위험을 평가하기 위해 매우 필수적인 과정이며 이러한 새로운 접근 방식을 제공하여 자율주행 자동차 시스템이 필요한 안전 수준을 충족하고 고장 위험을 줄이는 것을 목표로 한다.

2.1 STPA 안전 분석 프로세스

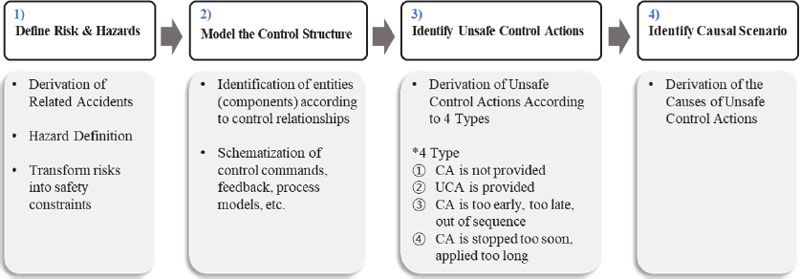

STPA는 복잡한 시스템에서 잠재적인 사고 및 위험을 식별하고 예방하기 위한 시스템 이론 기반 위험 분석 기법이다. STAMP 기법의 확장으로 만들어졌으며, 시스템의 구조, 동작 및 컴포넌트와 사람 간의 제어 명령을 바탕으로 안전을 분석한다. STPA 기반 위험 분석은 Fig. 2와 같이 4단계로 사고(Accident) 정의부터 위험(Hazard) 정의, Control Structure 모델링, Control Action(CA) 정의, Unsafe Control Action(UCA), Causal Scenario 도출 순서로 이루어진다.

STPA 분석을 시작하기 위해 분석 시스템의 작동 목적과 기능 범위를 정의한다. 일반적으로 ACC 시스템은 카메라와 레이더의 센서 퓨전을 통해 거리와 속도를 추정한다. 이때 레이더 센서로부터 거리 정보를 받지 못하거나 데이터 신뢰도가 떨어지는 경우 센서 퓨전 기술을 사용하여 카메라 센서를 사용하여 강건한 ACC 기능을 수행할 수 있다. 본 연구에서는 레이더 센서를 통해 데이터를 받을 수 없는 상황을 가정하고 카메라 센서로부터 수신되는 이미지 데이터를 사용하여 ACC 기능을 수행하는 상황을 고려였다.

STPA 1단계에선 시스템에 발생할 수 있는 사고를 정의한다. 사고 종류로는 차량 간 충돌, 운전자 부상, 재산손실, 임무 실패 등이 있고 이를 사용해 다양하게 정의할 수 있다. 본 논문에서는 자율주행 시스템의 고도화에 따라 증가하는 사용자의 탑승 안정감과 만족도 요구사항에 중점을 두고, 실제 충돌이 발생하지 않아도 운전자가 불편함을 느끼는 상황을 사고로 간주한다. 운전자의 불편함을 정량화 하기 위해 여러 자료들을 기반으로 차량의 총 가속도 합과 전방 차량과의 Time To Collision(TTC)의 임계값을 정의하고 이를 운전자가 불안함을 느끼는 평가 기준으로 선정하였다.

사고를 정의했다면 차량 레벨에서 사고를 발생시킬 수 있는 위험원을 정의한다. 본 논문에선 탑승한 운전자 관점에서 위험을 발생시킬 수 있는 잘못된 종방향 가속 및 감속명령을 위험원으로 선정하였다. 마지막으로 앞서 정의한 위험과 사고를 방지하기 위한 Safety Requirement (SR)을 도출한다. SR은 시스템이 지켜야 하는 제약 상태나 조건을 의미하며 식 (1) 같이 시스템과 시스템이 지켜야 하는 제약조건(Constraint)과 Hazard를 사용하여 정의된다.

| (1) |

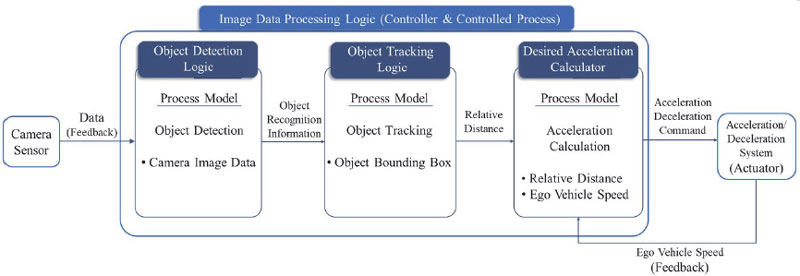

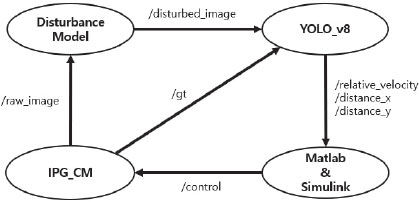

STPA 2단계는 시스템의 제어 아키텍처를 Control structure 형태로 모델링하는 단계다. Control structure는 분석 대상 시스템의 제어 흐름을 파악하고 관련 컴포넌트를 식별할 수 있는 제어 아키텍처이다. Fig. 3은 본 논문에서 분석 대상으로 정의한 시스템인 ACC 모델의 Control structure를 나타낸다. 이와 같은 Control structure는 안전 분석 대상 시스템의 전반적인 제어 흐름을 파악하여 시스템 전체의 CA를 정의하고 UCA를 정의하는 데 활용된다.

STPA 3단계에선 UCA를 정의한다. UCA는 제어 명령이 불안전하게 제공되거나 제공되는 과정에서 원치 않게 불안전한 상태로 전달되어 시스템의 위험 또는 사고를 유발할 수 있는 경우를 나타낸다. Control structure의 모든 제어 명령이 UCA 도출의 분석 대상이 될 수 있으며, 안전 분석의 범위에 따라 특정한 CA만을 고려할 수도 있다. UCA는 일반적으로 CA를 제공하는 Controller와 CA가 제공되는 형태인 Type과 CA가 제공되는 상황을 의미하는 Context를 조합하여 도출할 수 있다. 식 (2)를 사용해 UCA를 식별할 수 있고 UCA 예시는 Table 1과 같다.

| (2) |

STPA 4단계에선 UCA가 발생한 원인 시나리오(Causal scenario)를 도출하기 위해 도출한 UCA의 발생 원인(Causal factor)을 분석한다. 원인은 크게 두 가지로 나뉠 수 있는데, CA가 불안전하게 생성됐거나 CA이 정상적으로 제공됐지만 부적절하게 수행되어 UCA가 발생하는 경우가 있다. Causal factor는 Control structure를 참고하여 분석하며 크게 Controller 자체 존재 원인, 부적절한 피드백 및 잘못된 정보, Control path 문제, Controlled process 문제로 나눠서 도출하였다.

본 논문에서는 UCA003 “Object detection logic provided object recognition information, but the values were incorrect”에 대해 Causal scenario를 도출하며 예시는 Table 2와 같다.

3. 위험 평가를 위한 시뮬레이션 평가 환경 구축

본 장에선 STPA 기반 안전 분석 프로세스 결과물을 평가하기 위해 가상 시뮬레이션을 활용한 위험 평가 프로세스를 제안한다. 가상 시뮬레이션 환경을 설계하여 위험 평가를 진행한 이유는 카메라 센서에 발생할 수 있는 성능한계 상황을 현실에서 묘사하기 어렵고, 동일한 성능한계 시나리오에 대해 반복 테스트를 하기 어렵기 때문이다.

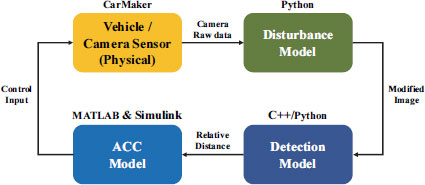

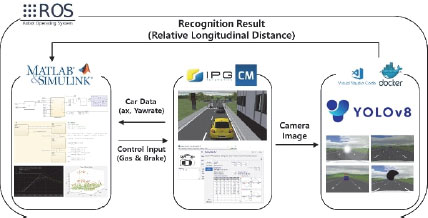

본 논문에선 앞서 STPA 안전분석 기법을 활용하여 도출한 CS004 “Object Recognition logic provided object recognition information with incorrect values due to camera sensor performance deterioration”를 SOTIF 성능한계 시나리오로 선정하였다. 또한, 성능한계 상황이 자율주행 시스템에 미치는 위험을 평가하기 위해 가상 카메라 모델을 사용해 시나리오의 위험을 평가한다. 카메라 센서에 발생할 수 있는 대표적인 성능 한계 상황은 이물질, 역광, 물방울 또는 안개로 인한 이미지가 흐려지는 현상이 있으며, 해당 성능한계 상황을 카메라 이미지 외란 모델을 구축하여 테스트하였다. 또한, 성능한계 상황에서 카메라 기반 ACC 모델을 장착한 차량을 분석하기 위해 아래 Fig. 4와 같이 자체적으로 인지 모델과 ACC 제어 시스템을 구현하고 해당 환경에서 차량의 움직임을 분석하였다.

3.1 ROS 기반 통합 시뮬레이션 환경

Robot Operating System(ROS)환경에서 MATLAB & Simulink와 Visual studio code 기반 데이터 처리 환경을 활용해 카메라 센서 데이터 기반 ACC 로직을 구성하였다. 본 논문에서 제안하는 시뮬레이션 기반 위험 평가 프로세스는 Fig. 5와 같이 3개의 환경이 통합되어 루프 구조로 작동한다. 시뮬레이션 가상 환경은 독일 IPG Automotive사의 CarMaker 시뮬레이션 프로그램을 사용했으며 선정된 시나리오를 CarMaker 가상 환경에 구축하여 시뮬레이션을 수행하였다. 객체 인지 및 성능한계 묘사를 위해 YOLOv8와 Python Open Source Computer Vision(OpenCV)를 사용하였다.

CarMaker에서 송신된 카메라 센서 데이터는 ROS 통신을 사용하여 YOLOv8 기반 Object recognition model로 전달되고 딥러닝 기반 객체 인식 및 거리 추정을 수행하고 해당 거리 추정 데이터는 MATLAB & Simulink로 다시 전달된다. 해당 거리 추정 데이터는 Sliding Mode Control(SMC)기반 종방향 제어기에 입력되어 요구 감가속도량을 계산하고 이를 차량 모델의 가속 페달과 브레이크 페달량으로 CarMaker에 송신하여 차량을 제어하는 구조다.

Fig. 6은 시스템의 노드와 토픽흐름을 보여준다. CarMaker 시뮬레이터를 가리키는 IPG_CM 노드에서 트래픽의 2D 바운딩 박스, 종 횡방향 상대거리 정보를 담고 있는 /gt 토픽과 전방 이미지 정보를 담고 있는 /raw_image 토픽을 발행한다. Disturbance Model 노드에서는 /raw_image 토픽을 구독해 이미지에 외란을 주입 후 외란이 주입 된 이미지를 /disturbed_image 토픽 형태로 발행한다. YOLO_v8 노드에서는 외란이 입혀진 이미지 토픽과 /gt 토픽을 구독하여 종, 횡방향 상대거리 및 상대속도를 각각 /distance_x, /distance_y, /rel_velocity 토픽형태로 만들어 발행한다. 이 토픽들은 MATLAB & Simulink 노드에서 구독해 제어기의 입력값으로 사용되고 종방향 제어값을 /control 토픽 형태로 IPG_CM 노드로 전송하여 차량을 제어한다.

3.2 YOLOv8 기반 객체 인식 모델

카메라 성능한계 평가를 위해 트래픽 객체 검출 및 상대거리를 추정할 수 있는 인지모델을 개발하였다.

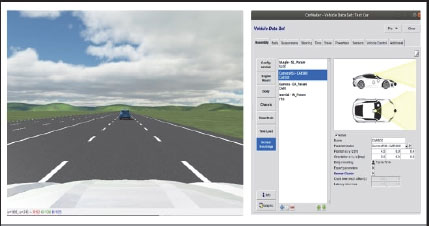

해당 인지 모델은 Fig. 7과 같이 CarMaker 내부 센서인 Camera Raw Signal Interface(RSI)로부터 RGB raw 데이터를 받아 Yolov8 모델을 통해 트래픽을 검출하도록 하였다. 이후 3차원 좌표와 2차원 이미지 좌표 간 호모그래피(Homography) 변환을 통해 검출된 트래픽의 종, 횡방향 상대 거리를 도출하였다. 개발된 인지모델은 60 km, 120 km 시나리오들 기준 평균 1.16 m의 상대거리 오차 성능을 보였다.

3.3 카메라 이미지 외란 모델

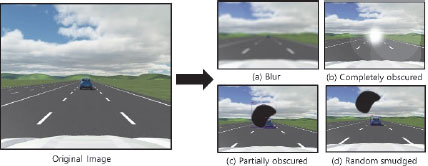

성능한계가 발생한 카메라 이미지 데이터를 묘사하기 위하여 외란 모델(Disturbance model)을 제작하였다. 묘사할 성능한계 상황을 결정하기 위해서 ISO34502 표준을 참고하였으며, 이에 의하면 대표적인 카메라 센서의 성능한계 상황이 발생 내용은 다양하다. ISO34502 표준을 참고하였을 때 성능한계 발생 결과는 객체가 전부 가려지거나, 일부가 가려지거나, 객체가 흐릿해지는 Blur effect가 발생하거나, RGB 센서의 고장으로 주변 환경과 객체를 구별하지 못하는 상황으로 구분된다.14) 본 논문에서는 전체 성능한계 상황 중 객체가 전부 가려지거나, 일부가 가려지거나, Blur effect가 발생한 상황을 고려했다.

Fig. 8은 Original image에 3가지 Disturbance model을 적용한 예시이다. 렌즈 표면에 습기가 차거나 안개 상황에서 주행 혹은 빠른 주행 시 관찰 대상이 흐릿하게 나타나는 성능 한계를 묘사하기 위하여 Fig. 8(a)와 같이 이미지 전체에 Blur effect를 적용하여 묘사하였다. 객체가 전부 가려지는 성능 한계는 Fig. 8(b)와 같이 빛이 카메라에 간섭을 일으켜 주행 중인 전방 물체가 전부 가려질 수 있도록 묘사했다. 그 외의 경우는 Fig. 8(c), (d)와 같이 오염물이 카메라 렌즈 표면에 랜덤 한 위치에 묻어서 객체가 일부 가려지거나 가려지지 않지만 랜덤 한 위치에 오염물이 묻어 객체로 인식되어 잘못된 상대거리를 출력하는 상황을 구현했다.

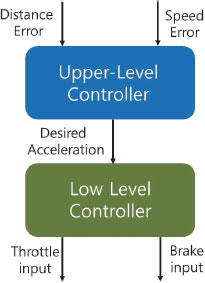

3.4 ACC Model

ACC는 전방 차량 추종 및 목표 속도 정속 주행, 자동 긴급 제동 장치(Autonomous emergency braking) 기능을 능동적으로 수행해야 한다. 따라서 Fig. 9와 같이 ACC는 상황 별 목표 가속도를 계산하는 상위제어기와 목표 가속도를 추정하기 위해 Engine throttle과 Brake input을 계산하는 하위 제어기로 구성된다.15)

상위 제어기는 카메라 센서를 통해 계측된 전방 차량과의 상대거리 정보를 사용하여 목표 가속도를 계산한다. 하지만 CarMaker 시뮬레이터의 차량은 목표 가속도 값을 입력 받아 제어되는 것이 아닌 Gas/Brake 페달 입력을 통해 제어된다. 따라서 하위 제어기는 계산된 목표 가속도를 추종하도록 Engine throttle과 Brake pressure 값을 계산하여 출력한다.16)

카메라 기반 종방향 제어 알고리즘은 운전자의 탑승감에 큰 영향을 주는 종방향 가속도를 생성하며, 변화하는 주행 환경에 실시간으로 대응하기 위해서는 제어 모델의 계산 복잡도를 줄이는 것이 중요하다. 본 연구에서는 횡방향 거동을 포함하지 않고 속도 유지 및 감속 상황만을 고려하는 간단한 선형 종방향 제어 모델을 적용한다. 종방향 가속도를 계산하기 위한 동역학 상태 공간 모델링은 식 (3)으로 표현된다.16)식 (3.1)은 상태변수로 위치, 속도, 가속도 성분을 의미하고, 식 (3.2)는 시스템 입력을 의미한다.

| (3.1) |

| (3.2) |

이때 는 상태변수로 각각 위치, 속도, 가속도 성분을 의미하고 ulong=adesire는 시스템 입력을 의미한다.

상위 전방 차량의 거리 정보를 받아 객체 인식 모델의 결과로 얻은 상대거리 값은 차량이 가속/감속하는 상황에서 진동과 같은 외란이 발생하여 측정 데이터의 신뢰성이 감소하는 문제가 있다. 따라서 시스템의 비선형성(Non-Linearity)과 차량 파라미터들의 불확실성(Uncertainty)에도 차량의 안정성을 확보할 수 있는 종 방향 제어를 수행하기 위해 강건 제어(Robust control)의 대표기법 중 하나인 SMC를 사용하여 Follow mode에서 목표 가속도를 출력하는 ACC 상위제어기를 설계하였다. SMC 제어는 시스템 상태 공간(State space)에서 시스템이 안정적인 동작을 할 수 있는 특정 면인 Sliding surface를 정의한다. 이후 상태 변수(State vector)들이 안정한 Sliding surface를 따라 원점으로 빠르게 수렴하도록 제어한다.17)

SMC 기반 종방향 제어기를 설계하기 위해 동역학(Dynamics) 관점 종 방향 차량 모델을 식 (4)와 같이 정의하였다.

| (4) |

사용되는 변수 Farto는 공기저항, Rx는 지면과 차량 사이의 구름 저항에 의한 힘을 나타낸 것이다. 는 자 차량의 종방향 가속도를 의미하며 종방향 상위 제어기의 출력 값인 목표 가속도 u로 정의한다. 전방에 차량이 있는 경우 안전거리를 유지하며 같은 속도로 따라가도록 설계하기 위해 추종 오차 e를 식 (5)와 같이 정의하였다.

| (5) |

는 전방 차량의 종방향 속도, 는 자 차량의 종방향 속도이며, xp-xe는 자차량과 전방차량과의 상대 거리, τtg는 전방 차량과 일정 거리를 유지하기 위한 Time gap 변수이다. Sliding surface는 식 (6)과 같다.

| (6) |

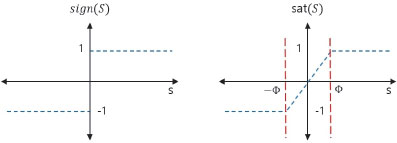

분석하고자 하는 차량의 시스템은 비선형 시스템으로 시스템이 Lyapunov 관점에서 Asymptotically stable 하기 위한 만족 조건과 SMC가 Sliding condition을 만족하기 위한 조건을 정의한다. 이때, Sign function을 사용하여 Sliding condition을 정의하는 경우 S=0 구간에서 불연속적이므로 제어 입력의 떨림(Chattering) 현상이 발생한다. 따라서 Sign function을 Fig. 10과 같이 Saturation function으로 대체한다. 따라서 모든 조건을 만족시키고 본 논문에서 사용하는 SMC 기반 종방향 상위 제어기의 출력 u는 식 (7)과 같이 정의되며 이는 목표 가속도 값이다.

| (7) |

식 (7)의 는 전방 차량의 종방향 가속도, 는 자 차량의 종방향 가속도이며 c와 ψ는 적당한 값의 상수로 제어기 성능을 향상시키기 위한 튜닝 파라미터이다.

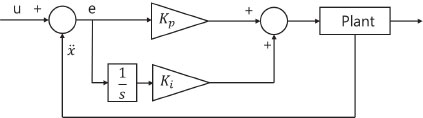

상위 제어기에서 계산된 목표 가속도 값과 자 차량의 가속도 오차는 피드백 제어 기반 하위 제어기에 입력되어 Engine torque 및 Brake pressure 값으로 변환되어 CarMaker 차량에 입력된다. 본 논문에서 사용한 피드백 제어기는 아래 Fig. 11과 같이 비례제어기와 적분제어기로 구성하였다. 비례제어기는 제어 목표값과 현재 값의 오차에 비례하는 출력을 만들어 오차를 감소시킨다.

제어 목표값은 상위 제어기를 통해 출력되고 있는 목표 가속도 값이며 현재 값은 자 차량의 가속도로 설정하였다. 하지만 비례제어만 사용하면 정상상태 오차(Steady state error)를 제거할 수 없다는 한계가 있다. 따라서 정상상태 오차를 제거하기 위해 적분 제어기를 함께 사용하였는데 적분 제어기는 제어기의 목표값과 현재 값의 차이를 적분한 값을 오차로 설정하고 적분 계수에 비례하는 제어기 출력값을 만든다. 이때 비례 제어기 상수값 Kp와 Ki는 튜닝 파라미터로 경험에 따라 시행착오를 통해 원활한 실험환경을 위해 최적화된 값으로 설정된 변수이다.

4. SOTIF 관점 위험 평가

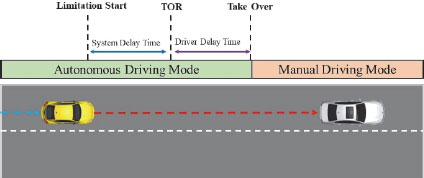

본 장에서는 “카메라 센서의 성능 한계로 인해 객체 인식 정보가 정상적으로 전달되지 않는 상황”을 도출된 Causal scenario의 대표적인 상황으로 선정하고, 시뮬레이션 환경을 활용하여 해당 상황의 SOTIF 관점 위험성을 Severity와 Controllability 관점에서 평가한다. 또한, 성능 한계가 발생한 상황에서 시스템의 Controllability를 산정하기 위해 차량의 최소 TTC가 위험 임계값에 도달하지 않고 제어권 전환이 성공적으로 이루어졌는지 평가한다.

본 논문에선 카메라 센서의 성능한계가 발생한 경우 운전자에게 제어권을 이양하여 위험을 회피할 수 있다고 가정하였다. 제어권 전환은 시스템이 요청하고 운전자가 승인하는 과정이 포함되어 있기에 위험을 회피하기 위해선 시스템 시간 예산 내에 제어권 전환이 수행되어야 한다. 따라서 ACC 시스템의 시간 예산을 도출하기 위해 성능 한계 발생 간격을 조절하여 시나리오를 평가했고 위험 시나리오가 도출되는 최소 성능 한계 발생 간격을 시스템 최대 시간 예산으로 정의하였다.

최종적으로 Fig. 12와 같이 시스템 시간 예산 내에 제어권 전환이 수행될 수 있는 경우 운전자 인지 & 반응 시간을 고려한 제어권 전환 요청 시간을 시스템 설계 목표로 제안하고, 시간 예산 내에 제어권 전환이 이뤄질 수 없는 경우 추가적인 Fail operation 기능 설계를 통한 결함 대응 시간의 확보 필요성을 시스템 개선 가이드라인으로 제시하고자 한다.

4.1 SOTIF 관점 위험 평가 개요

SOITF 관점 위험 평가는 시나리오별 충돌 시 상해도 정도를 의미하는 심각도(Severity, S)와 위험 사건에 운전자 노출 시 운전자의 상황 통제 가능성을 의미하는 제어 가능성(Controllability, C)를 지표로 사용해 평가한다. 시나리오가 위험하지 않다고 평가되는 경우는 일반적으로 제어 가능한 상황이거나 운전자에게 피해를 주지 않는 상황으로 S=0 또는 C=0을 만족하는 상황이다. SOTIF 위험 평가 프로세스에선 ISO 26262와 달리 ASIL 등급을 산정하지 않기 때문에 위험이 허용 가능한지(Acceptable) 또는 허용 불가능한지(Unacceptable) 평가하는 것에 중점을 두고 Severity와 Controllability를 부등호를 사용하여 평가한다.18) 따라서 위험 평가의 목적은 식별된 시나리오에 대해 Severity와 Controllability를 평가하였을 때 존재하는 위험을 분석하고 해당 위험이 허용할 수 있는 수준으로 낮추기 위해 시스템의 의도된 기능(Intended functionality)을 수정하기 위한 가이드라인을 제시하는 것이다.

SAE J2980 문서에서는 프랑스, 일본 및 미국에서 수집한 사고 데이터베이스를 활용하여 충돌 형태와 상대 충돌 속도에 따른 Severity 등급 산정 방법을 제시하고 있다.19) 해당 연구자료들을 토대로 본 논문에선 충돌 상대속도를 활용하여 Severity를 산정하였고 ISO26262와 달리 Severity의 세부 등급은 산정하지 않고 부등호를 사용해 위험도가 존재하는지(S>0) 평가하였다. 본 논문에서는 차량이 고속 주행 중(60 km/h, 120 km/h) 카메라 성능한계 발생 상황을 고려하고 있으며 SAE J2980 문서의 자료를 참고하였을 때 모든 시나리오는 충돌 가능성과 충돌 발생 시 상해 위험도가 존재한다고 판단하였고 S>0인 상황으로 평가하였다.

Controllability는 위험 상황 발생 시 운전자가 해당 위험을 회피하기 위해 제어를 시도하고, 성공적으로 위험을 회피할 확률을 기반으로 등급이 산정된다. 분석 대상 시스템이 ACC이기 때문에 운전자는 위험을 회피하기 위해 급격하게 핸들을 조작하여 회피 거동을 할 필요 없이 적절한 양의 브레이크를 작동하면 위험을 간단하게 회피할 수 있다. 따라서 운전자에게 충분한 시간을 두고 제어권 전환이 수행된다면 운전자 대부분은 해당 위험을 회피하기 위한 제어를 할 수 있다고 가정하고 운전자가 충분한 제어 시간을 확보한 상황을 C=0인 안전한 상황으로 평가하였고 그렇지 못한 경우 C>0인 위험 상황으로 평가하였다.

4.2 제어권 전환 시간 정의

자율주행 중 카메라 센서에 고장이 발생하거나 성능한계가 발생하는 경우 시스템은 정상 주행이 가능한지 평가한다. 정상 주행이 불가능할 경우 시스템은 운전자에게 시스템 고장을 알리고 제어권 전환이 안전하게 이뤄질 수 있도록 Fail operation 기능을 사용하여 차량을 제어한 후 운전자에게 제어권을 전환한다.20) 따라서 제어권 전환 시간(TOT, Take-Over Time)은 제어권 전환 요청(TOR, Take-Over Request)이 발행된 시점부터 운전자가 제어권을 인수받는 시점 까지를 의미 한다.

이때 TOT는 운전자의 인지 & 반응시간에 영향을 받는다. 인지 시간은 운전자의 연령대, 운전 자세, TOR 방식이나 주행 조건에 영향을 받아 결정되는데 알림 방식의 종류(시각적, 청각적 또는 진동)와 운전자의 반응 준비 상태(손과 발의 위치)가 TOT에 영향을 끼친다.21) 반응시간은 운전자가 반응하여 조향, 브레이크 명령을 인가하였을 때 시스템이 실제로 작동하기까지의 시간으로 운전자의 반응 속도와 시스템 작동 지연 시간이 영향을 준다.

운전자의 인지 & 반응시간을 결정하기 위하여 실제 운전자를 대상으로 한 많은 연구가 진행되었다. 대표적으로 장명순21)은 현재 한국 도로 설계에 사용되는 인지 반응 시간 2.5초는 비용-효율 측면에서 재고의 여지가 있으며 60 km/h이하일 땐 2초, 80 km/h시 1.8초, 100 km/h시 1.6초, 120 km/h이상일 경우 1.4초가 타당하다고 주장하였다. 최재성 등22)은 인지시간을 가속페달에서 발을 뗀 시간과 RPM이 감소하기 시작하는 시점의 차이로 계산하였고, 반응 시간은 가속페달에서 발을 뗀 시간과 브레이크를 밟기 시작한 시간의 차이로 계산하였다. 결과적으로 100, 120, 140 km/h에서 인지 반응 시간은 각각 1.76초, 1.56초, 1.44초로 고속 주행 상황에서 인지 반응시간이 감소함을 확인하였다. 일반적으로 제어권 전환요청에 따른 수행 완료 시간은 2.72초로 평가되고 있고 많은 연구들이 1초와 3초 사이가 적절한 제어권 전환 시간이라고 주장하고 있다.23)

본 논문에선 해당 연구자료를 참고하여 60 km/h과 120 km/h시나리오에서 각각 2초와 1.5초를 인지 반응시간으로 설정하였고 해당 운전자의 인지 & 반응 시간을 고려한 TOT를 도출하였다.

4.3 시나리오 위험 평가를 통한 Time budget 도출

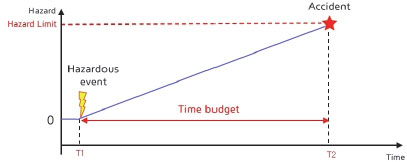

시스템 시간 예산(Time budget)은 특정 결함이나, 성능한계가 발생한 이후 사고가 발생하기 이전까지의 전체 시간을 의미한다. 이는 시스템의 Fail operation 기능의 장착 여부나 주행 상태, 환경에 영향을 받는다. 사고가 발생하지 않고 제어권 전환이 이뤄지기 위해서 Fig. 13과 같이 Hazard limit에 도달하기 이전에 시스템은 시간 예산 내에 제어권 전환을 요청하고 운전자는 제어권을 이양받아야 한다. 이때 위험이 발생한 시점부터 사고가 발생한 시간 까지를 시스템의 시간 예산으로 정의한다.

본 논문에선 평가 대상 시스템의 시간 예산을 도출하기 위해 성능한계 발생 간격에 변화를 주며 테스트하였고 위험 시나리오로 도출된 성능한계 발생 간격 조건 중 최솟값을 시스템의 시간 예산으로 설정하였다.

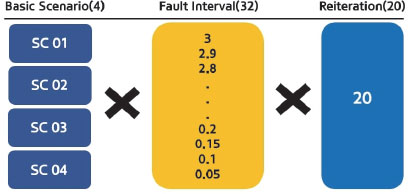

본 논문에선 60 km/h과 120 km/h에서 전방 차량과 같은 속도로 주행하는 중 각각 17초와 20초에 성능한계가 발생한 경우를 고려하였다. 또한, 같은 속도와 성능한계 발생 조건에서 전방 차량이 급감속 하는 경우를 고려하였다. 이때 전방 차량 감속도는 국토교통부 기준 급감속 수치에 해당하는 5 m/s2을 사용하였고, 아래 Table 3과 같이 Basic Scenario SC01~04를 정의하였다.24)

또한 성능한계 시나리오별 시간 예산을 도출하기 위해 Basic scenario에 Fault interval 조건 32개를 추가하여 최종 시나리오를 도출하고 데이터 신뢰성 확보를 위해 같은 시나리오를 20번씩 반복 테스트하였다. 전체 시나리오 도출과정은 Fig. 14와 같다.

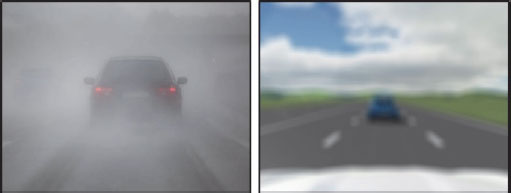

카메라 센서에 빛이 간섭하여 Fig. 15의 왼쪽과 같이 이미지 데이터에 성능한계를 발생한 경우를 고려하였고, Fig. 15의 오른쪽과 같이 성능한계를 모사하여 위험을 평가하였다.

Fig. 16은 전체 시나리오 중 일부 결과를 예시로 나타낸 것으로 17초부터 20초에 각각 2초 동안 성능한계가 발생했을 때 객체 인식 모델의 상대거리 추정값과 참값을 비교한 그래프로 가로축은 Step으로 MATLAB 내부 연산 횟수를 의미하며 세로축은 상대거리 추정값을 의미한다. Fig. 16의 시나리오 전부 빛이 카메라에 간섭을 일으켜 이미지에 성능한계가 발생한 경우 객체를 인식하지 못하고 상대거리 값을 0으로 출력하는 것을 확인할 수 있다.

Table 4는 전체 시나리오 중 일부 시나리오 4개에 대하여 위험 평가를 진행한 내용이다. S의 경우 차량의 충돌 발생 시 예상되는 상대 충돌 속도를 사용하여 평가를 진행하였고 C의 경우 측정된 최소 TTC를 사용하여 평가를 진행하였다. 정속 주행 시나리오(SC01, SC03)의 경우 예상 상대 충돌 속도가 기준치 이상으로 S>0로 평가되었지만 기록된 최소 TTC가 임계값보다 높았기 때문에 C=0인 안전한 시나리오로 평가되었다. 전방 차량 감속 시나리오(SC02, SC04)의 경우 예상 상대 충돌 속도가 기준치 이상으로 S>0로 평가되고 기록된 최소 TTC가 임계값 보다 낮았기 때문에 C>0인 위험 시나리오로 평가되었다.

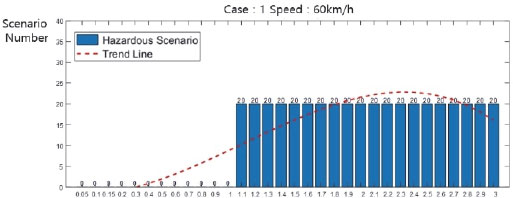

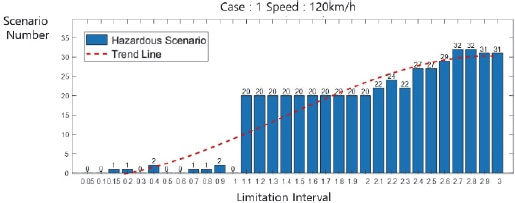

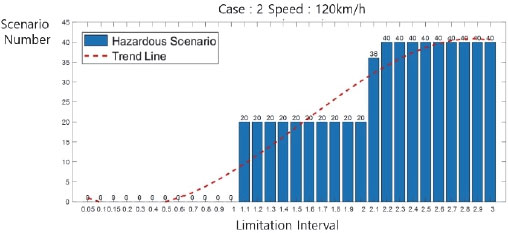

Fig. 17과 Fig. 18은 전체 빛 성능한계 시나리오에 대하여 위험 평가를 위와 같은 방식으로 진행하였을 때 도출된 위험 시나리오 도출 결과 그래프이다. 가로 좌표축은 성능한계 발생 간격을 나타내며 세로 좌표축은 해당 성능한계 발생 간격에서 도출된 위험 시나리오 개수를 의미한다.

위험 평가결과를 분석해 보면 60 km/h조건과 120 km/h조건에서 모두 성능한계 발생 시간이 1.0초를 초과하는 경우 위험 시나리오가 발생함을 확인할 수 있으므로 1.0초가 Time budget이다.

카메라 센서에 습기가 차거나 액체가 렌즈 표면에 묻어 Fig. 19의 왼쪽과 같이 이미지가 흐려지는 성능한계를 발생한 경우를 고려하였고, Fig. 19의 오른쪽과 같이 성능한계를 모사하여 위험을 평가하였다.

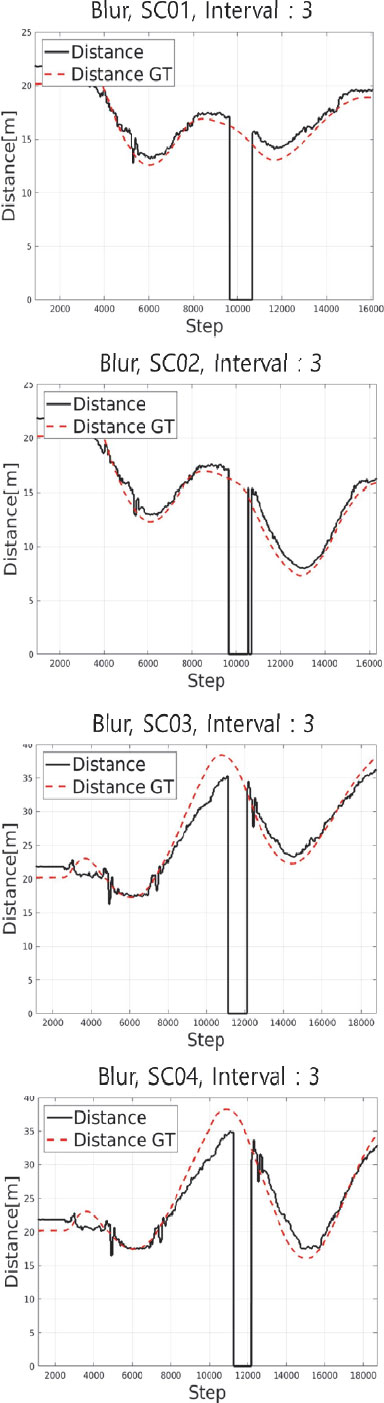

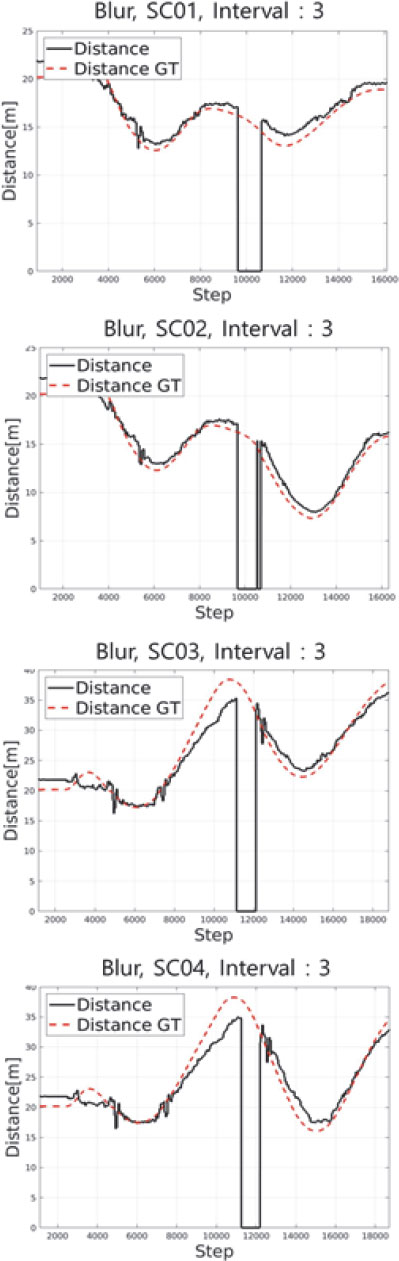

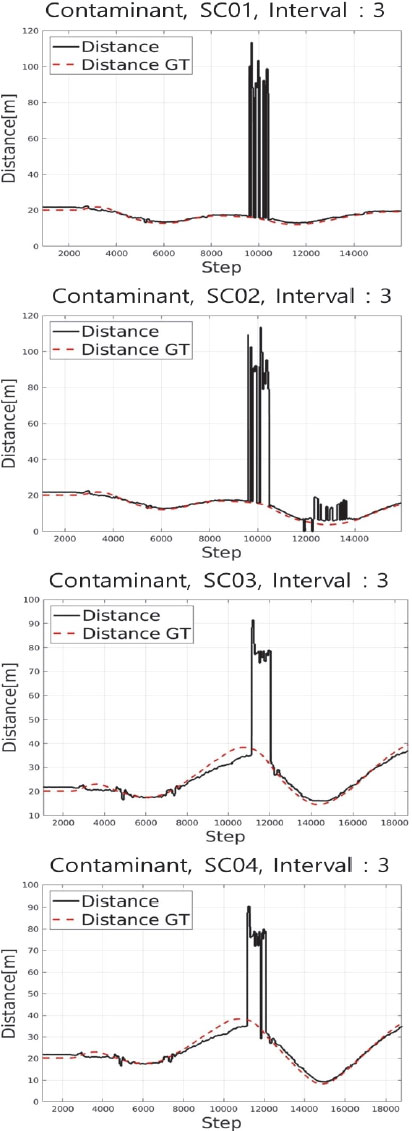

Fig. 20은 전체 시나리오 중 일부 결과를 예시로 나타낸 것으로 17초부터 20초에 각각 3초 동안 성능한계가 발생했을 때 객체 인식 모델의 상대거리 추정값과 참값을 비교한 그래프이다. Fig. 20의 시나리오 전부 카메라 이미지가 흐려지는 성능한계가 발생한 경우 객체를 인식하지 못하고 상대 거리값을 0으로 출력하는 것을 확인할 수 있다.

Fig. 21과 Fig. 22는 전체 흐려짐 성능한계시나리오에 대하여 Severity와 Controllability 위험 평가를 앞서 언급한 방식으로 진행하였을 때 도출된 위험 시나리오 도출 결과 그래프이다. 가로 좌표축은 성능한계 발생 간격을 나타내며 세로 좌표축은 해당 성능한계 발생 간격에서 도출된 위험 시나리오 개수를 의미한다.

위험 평가결과를 분석해 보면 60 km/h조건과 120 km/h조건에서 모두 성능한계 발생 시간이 1.0초를 초과하는 경우 위험 시나리오가 발생함을 확인할 수 있고 1.0초가 Time budget이다. 이미지 흐려짐 성능한계 시나리오 위험 평가결과는 빛의 간섭 성능한계 시나리오와 유사한 위험 평가결과를 나타낸다. 이미지가 흐려지는 경우 객체가 가려졌을 때처럼 상대거리 값을 0으로 출력하는 같은 성능한계 영향을 보이기 때문이다.

카메라 센서 표면에 오염물이 묻어 Fig. 23의 왼쪽과 같이 이미지가 오염되어 수신되는 성능한계를 고려하였고, Fig. 23의 오른쪽과 같이 카메라 렌즈에 이물질이 묻어 객체의 일부를 가리거나 오염물을 객체로 인식하는 성능한계 상황을 평가하고자 하였다. 따라서 오염물의 위치를 무작위 위치에 발생시키고 오염물 성능한계 발생 간격을 변경하며 평가하였다.

Fig. 24는 전체 시나리오 중 일부 결과를 예시로 나타낸 것으로 17초부터 20초에 각각 3초 동안 이미지 중앙에 오염물 성능한계가 발생했을 때 객체 인식 모델의 상대거리 추정값과 참값을 비교한 그래프이다. 이를 살펴보면 시나리오 카메라 이미지에 오염이 발생한 경우 객체의 일부가 가려져서 정확한 인지를 할 수 없거나 오염물 자체를 객체로 인식하는 경우 잘못된 상대거리 값을 출력함을 알 수 있다.

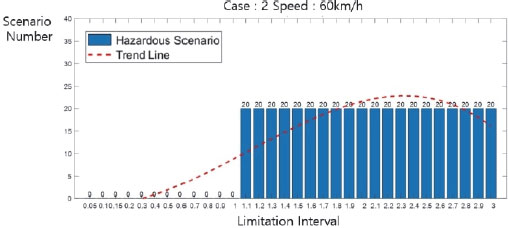

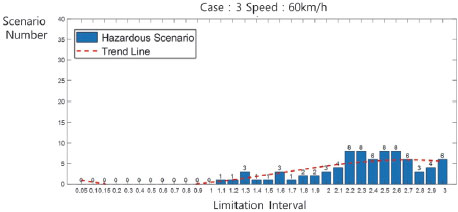

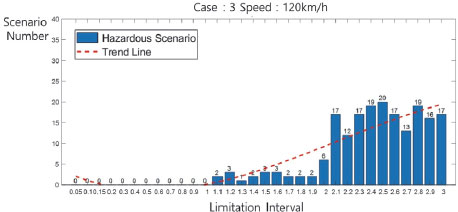

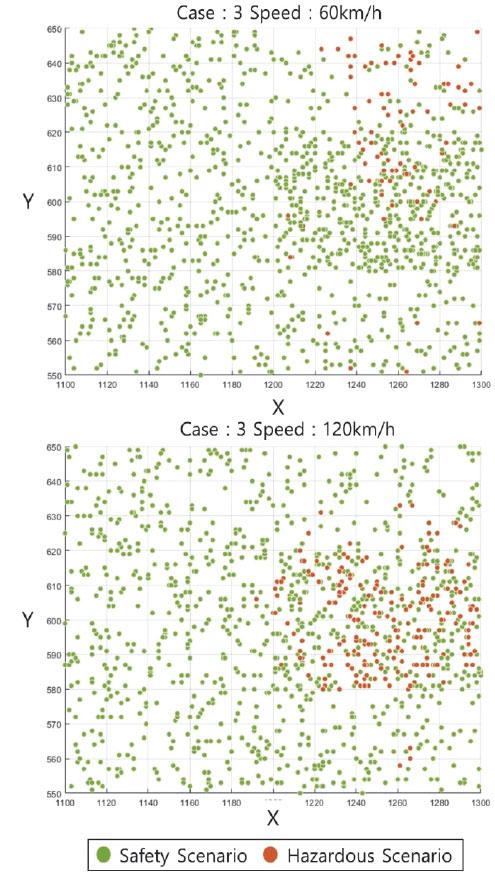

Fig. 25와 Fig. 26은 전체 오염물 성능한계 시나리오에 대하여 Severity와 Controllability 위험 평가를 앞서 언급한 방식으로 진행하였을 때 도출된 위험 시나리오 도출 결과 그래프이다. 가로 좌표축은 성능한계 발생 간격을 나타내며 세로 좌표축은 해당 성능한계 발생 간격에서 도출된 위험 시나리오 개수를 의미한다.

위험 평가결과를 분석해 보면 60 km/h조건과 120 km/h조건에서 성능한계 발생 시간이 각각 2초와 1.9초를 초과하는 경우 위험 시나리오가 발생함을 확인할 수 있고 Time budget은 각각 2초와 1.9초이다.

오염물 성능한계 시나리오는 다른 성능한계와 달리 위험 시나리오가 적게 도출되었는데 오염물의 위치 조건에 따라 객체 인지 성능에 영향을 끼치지 않는 시나리오가 존재하기 때문이다. Fig. 26은 오염물의 이미지상 위치에 따라 위험 시나리오로 도출된 경우 주황색 점으로 표시했을 때 전체 시나리오 위험 평가결과이다. Fig. 26을 보면 속도 별 위험 시나리오의 오염물 위치 조건과 개수에 차이가 있다.

이는 속도 조건에 따라 전방 차량과의 안전거리에 차이가 있고 이는 Fig. 28과 같이 카메라 이미지에 표현되는 객체의 크기에 영향을 미치기 때문이다. 따라서 120 km/h조건의 시나리오가 객체가 오염물에 간섭될 확률이 높았고 위험 시나리오가 더 많이 도출되었다.

4.4 제어권 전환 요청시간과 결함대응 시간도출

제어권 전환 시간(TOT)은 제어권 전환 요청(TOR)이 발행된 시점부터 운전자가 제어권을 이양 받은 순간까지 이다. 따라서 제어권 전환을 발행하기 위한 시간 TOR과 운전자가 이를 인지하고 제어권을 인수하는데 필요한 지연시간 TDelay을 사용해 제어권 전환 시간은 식 (8)과 같이 정의된다. 이때 주어진 시간 예산 내에 제어권 전환을 안전하게 수행하기 위해선 시스템 시간 예산이 제어권 전환 시간보다 커야 하고 이는 식 (9)로 정의할 수 있다.

본 논문에선 시나리오의 속도조건별 운전자의 지연시간을 고려하였을 때 시간 예산 안에 제어권 전환이 이뤄질 수 있는 제어권 전환 요청 시간(Take-over request time)을 도출하고자 한다. 만약 시간 예산안에 제어권 전환을 수행할 수 없어 사고를 회피할 수 없는 경우 시스템에 추가적인 Fail operation 기능 설계를 통해 식 (10)과 같이 시간 예산에 결함 대응 시간(Fail Operational Time, FOT)을 확보할 수 있다고 가정하였다. 따라서 식 (10)의 좌변과 같이 시간 예산에 결함 대응 시간을 추가하여 제어권 전환이 사고가 발생하지 않고 수행될 수 있도록 필요한 최소 결함 대응 시간을 도출하고자 한다.

| (8) |

| (9) |

| (10) |

위험 평가를 통해 성능한계별 도출된 시간 예산은 Table 5와 같다. 카메라 센서에 빛과 흐려짐에 의해 성능한계가 발생한 경우 사고가 발생하지 않기 위해 시스템은 120 km/h와 60 km/h 조건에서 1.0초 이내에 제어권 전환이 이뤄져야 하는데 이는 식 (9)에서 Time budget 값은 1 s 임을 의미한다. 이때 운전자의 인지 반응 지연 시간이 120 km/h와 60 km/h 조건에서 각각 2초와 1.5초임을 고려하면 주어진 시간예산 내에 제어권 전환이 수행될 수 없다. 따라서 제어권 전환이 성공적으로 수행되기 위하여 시스템에 추가적인 Fail operation 기능이 필요함을 알 수 있고 식 (10)을 활용하여 시스템에 요구되는 결함 대응 시간(FOT)을 설계 가이드라인으로 도출한다. 따라서 식 10의 부등식을 만족하기 위해 최소 FOT을 도출하면 60 km/h조건에선 FOT = 1초, 120 km/h조건에선 FOT = 0.5초가 요구된다.

위와 같은 방법으로 카메라에 오염물이 묻어 성능한계가 발생한 상황에서 시스템은 120 km/h와 60 km/h조건에서 각각 2초와 1.9초의 시간 예산 내에 제어권 전환이 이뤄져야 한다. 또한, 운전자의 인지 반응 지연 시간을 고려 했을 때 시간 예산 내에 제어권 전환이 수행될 수 있다. 따라서 위험을 회피하기 위한 TOR 발행 시간을 식 (8), (9)를 사용해 계산하면 60 km/h조건에선 성능한계 발생 시 즉시 TOR을 발행해야 하고 120 km/h조건에선 성능한계 발생 시 0.4초 안에 TOR을 발행할 경우 운전자의 제어 가능성을 확보할 수 있다. 이는 시스템이 0초와 0.4초 이내에 성능한계 상황을 파악하고 제어권 전환요청을 발행해야 함을 의미하는데, 설계상 어려움이 있으므로 해당 성능한계를 대비하기 위해 Fail operation 기능을 추가하여 시간 예산을 확보하는 것이 바람직하다.

결과적으로 각각의 성능한계 상황에서 ACC 시스템의 TOR과 FOT 도출 결과는 Table 6과 같다. 이때 Light과 Blur 성능한계의 경우 운전자의 인지 지연시간을 고려했을 때 제어권 전환이 Time budget 내에 수행 될 수 없기 제어권 전환은 실패(Fail)할 수밖에 없다. 따라서 추가적인 Fail operation 기능을 설계하여 FOT를 최소 요구사항 이상 확보하여야 함을 명시했다. Contaminant 성능한계의 경우 주어진 Time budget 내에 제어권 전환이 수행될 수 있지만 120 km/h조건의 경우 성능한계 발생 즉시 제어권 전환 요청을 하는 것이 어렵기 때문에 개선 필요(Need improvement)로 명시하였다.

5. 결 론

본 논문에서는 STPA 안전 분석 기법을 SOTIF 위험 분석 프로세스에 적용하였고 ACC 시스템의 위험을 분석하고 가상 환경을 사용하여 위험을 평가하였다.

STPA 안전 분석 기법을 활용하여 카메라 센서 기반 ACC 시스템에 발생할 수 있는 운전자 관점의 위험과 사고를 정의하였다. 카메라 센서 기반 ACC 시스템의 제어 구조를 Control structure을 이용해 식별하고 발생할 수 있는 UCA를 식별하고 UCA 발생원인을 분석해 Causal scenario를 도출하였다. 도출된 Causal scenario 중 카메라 센서에 성능한계가 발생하여 Object recognition logic이 올바른 카메라 이미지 데이터를 받지 못하는 상황을 위험 평가 대상으로 선정하였고 MATLAB & Simulink와 CarMaker 시뮬레이션 툴을 활용해 위험 평가 환경을 구축하였다. 성능한계 상황은 카메라가 빛에 영향을 받아 객체가 완전히 가려지거나, 외부 환경 요소로 인해 이미지가 흐려지거나 오염물이 카메라에 묻어 이미지 일부를 가린 상황을 고려하여 테스트를 진행하였다.

시나리오는 Severity와 Controllability를 사용해 평가되었고 위험 시나리오를 안전 시나리오로 개선하기 위해서 Controllability를 0으로 만드는 전략을 사용하였다. Controllability는 TTC 관점에서 평가되었고 운전자에게 적절한 시간에 제어권 인수가 이뤄진다면 TTC 시간 내에 적절한 제어를 할 수 있을 것으로 가정하였다. 따라서 TOR을 시스템 설계 목표로 도출하였고 Time budget 내에 제어권이 전환될 수 없는 상황인 경우 시스템 Time budget를 추가로 확보하기 위해 FOT를 추가적인 시스템 개선 가이드라인으로 제시하였다.

하지만 사용한 ACC 모델은 상용화된 차량에 장착된 ACC 모델과 성능상의 차이가 존재하기 때문에 시나리오 테스트 결과에 제한이 있다는 한계점이 있다. 또한, 카메라 이미지를 받아 성능한계를 발생시키고 객체 인식을 진행하고 제어하는 과정이 0.05초에 한 루프가 수행될 수 있도록 시스템을 설계했지만, 구현의 한계로 성능한계 발생 시 루프가 수행되는 시간이 지연되는 현상이 존재했다. 테스트한 시나리오 조건들도 발생할 수 있는 가장 심각한 상황을 고려하여 테스트를 진행하다 보니 성능한계가 비슷한 영향도를 보이고 있다는 한계점이 존재한다. 이는 보다 현실과 정합성이 높은 차량 시스템 모델과 경량화 된 로직을 사용하고 특정 시나리오에 대하여 심화된 조건에서 테스트를 진행한다면 보다 신뢰성 높은 데이터를 얻을 수 있을 것이다.

본 연구는 SOTIF 관점의 위험을 분석하고 평가하는 프로세스를 제안하였고 Level 3 이상 자율주행 시스템의 안전 분석 프레임워크로서 활용될 수 있을 것으로 기대하고 있다.

Acknowledgments

본 연구는 산업통상자원부의 자율주행 기술개발혁신사업으로 지원을 받아 수행된 연구결과임(20024814, 허브 연계형 Lv.4 상용차 자율주행 예측구동 제어 및 최적운행 기술개발 This research was supported by the Ministry of Trade, Industry and Energy(MOTIE), KOREA, through the Autonomous driving Development Innovation Program. (20024814, Development of Predictive Powertrain Control and Optimal Driving Technology for Hub Linked Lv. 4 Autonomous Driving of Commercial Vehicles).

References

- B. Y. Lee, “Domestic and International Trends and Prospects in Autonomous Vehicle Technology Development,” Information and Communications Magazine, Vol.33, No.4, pp.10-16, 2016.

- I. P. O. V. ZERO, Euro NCAP 2025 Roadmap, 2015.

-

S. Riedmaier, T. Ponn, D. Ludwig, B. Schick and F. Diermeyer, “Survey on Scenario-Based Safety Assessment of Automated Vehicles,” IEEE Access, Vol.8, pp.87456-87477, 2020.

[https://doi.org/10.1109/ACCESS.2020.2993730]

-

S. Riedmaier, T. Ponn, D. Ludwig, B. Schick and F. Diermeyer, “Survey on Scenario-Based Safety Assessment of Automated Vehicles,” IEEE Access, Vol.8, pp.87456-87477, 2020.

[https://doi.org/10.1109/ACCESS.2020.2993730]

- ISO 26262 vs. SOTIF (ISO/PAS 21448): What’s the Difference?, https://www.ptc.com/en/blogs/alm/iso-26262-vs-sotif-iso-pas-21448-whats-the-difference

-

X. Zhang, W. Shao, M. Zhou, Q. Tan and J. Li, “A Scene Comprehensive Safety Evaluation Method Based on Binocular Camera,” Robotics and Autonomous Systems, Vol.128, Paper No.103503, 2020.

[https://doi.org/10.1016/j.robot.2020.103503]

-

R. Mariani and K. Greb, “Recent Advances and Trends on Automotive Safety,” 2022 IEEE International Reliability Physics Symposium (IRPS), IEEE, 2022.

[https://doi.org/10.1109/IRPS48227.2022.9764484]

-

L. Peng, H. Wang and J. Li, “Uncertainty Evaluation of Object Detection Algorithms for Autonomous Vehicles,” Automotive Innovation, Vol.4, No.3, pp.241-252, 2021.

[https://doi.org/10.1007/s42154-021-00154-0]

-

L. Peng, J. Li, W. Shao and H. Wang, “PeSOTIF: A Challenging Visual Dataset for Perception SOTIF Problems in Long-Tail Traffic Scenarios,” 2022, arXiv:2211.03402, .

[https://doi.org/10.1109/IV55152.2023.10186651]

- Y. Xuezhu, D. Zhongju, J. Pimentel, R. Johansson, G. Gruska, X. Ruoyu and X. Fu, “Identifying Effective STPA Control Structures to Characterize SOTIF Areas 1, 2, 3, and 4 in Automated Vehicles,” 27th International Technical Conference on the Enhanced Safety of Vehicles (ESV) National Highway Traffic Safety Administration, Paper No. 23-0019, 2023.

-

M. Khatun, M. Glaß and R. Jung, “Scenario-Based Extended HARA Incorporating Functional Safety & SOTIF for Autonomous Driving,” ESREL-30th European Safety and Reliability Conference, 2020.

[https://doi.org/10.3850/978-981-14-8593-0_5225-cd]

-

J. M. Lee, U. I. Jung and B. S. Song, “Critical Scenario Generation for Collision Avoidance of Automated Vehicles Based on Traffic Accident Analysis and Machine Learning,” Transactions of KSAE, Vol.28, No.11, pp.817-826, 2020.

[https://doi.org/10.7467/KSAE.2020.28.11.817]

-

W. J. Lee and S. C. Kee, “Implementation of VILS System for Autonomous Driving Testbed Based on HD Map,” Transactions of KSAE, Vol.31, No.7, pp.503-511, 2023.

[https://doi.org/10.7467/KSAE.2023.31.7.503]

- International Organization for Standardization, “ISO 34502 - Road Vehicles - Test Scenarios for Automated Driving Systems Scenario Based Safety Evaluation Framework,” ISO 34502, International Organization for Standardization, 2022.

- J. H. Kim, Model Predictive Control Based ACC Controller Design to Avoid Abnormal Driving Vehicles, M. S. Dissertation, Hanyang University, Seoul, 2022.

- J. S. Kwak and K. S. Yi, “Development of Throttle and Brake Controller for Autonomous Vehicle Simulation Environment,” Journal of Auto-Vehicle Safety Association, Vol.14, No.1, pp.39-44, 2022.

- H. S. Roh, Development of the Longitudinal Control for Truck Platooning, M. S. Dissertation, Kookmin University, Seoul, 2020.

- J. Li, Y. Zhang, S. Zho, C. Chen and Z. Du, “A Research on SOTIF of LKA Based on STPA,” 2022 IEEE International Conference on Real-Time Computing and Robotics (RCAR), pp.396-400, 2022.

- SAE International, SAE J2980 Surface Vehicle Recommended Practice. SAE J2980, SAE International, 2018.

- J. Y. Hwang and Y. S. Son, “The Study on Camera Fail Operational Control for Autonomous Vehicle,” KSAE Spring Conference Proceedings, 2011.

- M. S. Jang, S. K. Lee, J. S. Kim, S. M. Hong and K. J. Lee, “The Chronological Evolution of Driver’s Perception Reaction Time,” Transportation Technology and Policy, Vol.8, No.6, pp.55-61, 2011.

-

J. S. Choi, S. W. Jeong, J. M. Kim, T. H. Kim and J. S. Shin, “A Study on Driver Perception-Reaction Time in High-Speed Driving Situations,” International Journal of Highway Engineering, Vol.19, No.1, pp.107-119, 2017.

[https://doi.org/10.7855/IJHE.2017.19.1.107]

-

B. Zhang, D. W. Joost, V. Silvia, H. Riender and M. Marieke, “Determinants of Take-Over Time from Automated Driving: A Meta-Analysis of 129 studies,” Transportation Research Part F: Traffic Psychology and Behaviour, Vol.64, pp.285-307, 2019.

[https://doi.org/10.1016/j.trf.2019.04.020]

- Republic of Korea: Ministry of Land Infrastructure and Transport, Rapid acceleration and other dangerous driving behaviors increase the likelihood of traffic accidents, https://molit.go.kr/atmo/USR/N0201/m_36515/dtl.jsp?lcmspage=74&id=95086729, , 2024.