UI 사례 분석 기반 부분자율주행 HMI 정보 제공 방법 특성 비교 연구

Copyright Ⓒ 2024 KSAE / 220-01

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

The objective of this study is to compare and analyze the method of delivery of user information in partially automated driving systems from the viewpoint of human-machine interaction(HMI). In this study, we analyzed the role of the driver in changing the level of automated driving and the factors in automated driving systems based on international standards. Then, we analyzed the differences in User Interface(UI) according to automated driving level from the perspective of function through precedent research studies and Original Equipment Manufacturer(OEM) use-case analysis. Consequently, we anticipate that the UI of level 4 automated vehicles, unlike other levels of partially automated vehicles, will be utilized for new purposes, such as boarding support. Likewise, the scope of external HMI is expected to increase.

Keywords:

Passenger, Automated vehicle, Information, Human-Machine interaction, User interface키워드:

탑승자, 자율주행 차량, 정보, 인간-기계 상호작용, 사용자 인터페이스1. 서 론

1.1 연구 배경

최근 자동차는 IT(Information Technology)기술과 접목한 스마트카로 진화하면서, 탑승자에게 제공되는 정보의 종류와 목적이 다양해지고 있다. 일례로 개인화(Personalization), 연결성(Connectivity), 사용성(Usability)이라는 키워드를 토대로 ‘사용자 맞춤형 서비스 제공’, ‘하나의 스마트폰 디바이스로 통제 가능한 차량 및 다른 스마트 디바이스’, ‘직관적이고 편안한 인터페이스를 통한 조작 부담의 저감’이라는 미래 자동차 디지털 콕핏 사용자의 니즈를 도출한 사례가 있다.1) 완성차 업체(Original Equipment Manufacturer, OEM)의 인포테인먼트 개발 동향 사례를 살펴보면, 메르세데스-벤츠의 차세대 인포테인먼트 시스템인 ‘MBUX(Mercedes-Benz User eXperience)’는 사용자의 습관과 취향을 학습해 목적지까지의 최적 주행 경로 및 스트리밍 음원의 추천 등 개인화된 서비스를 제공하여 시스템 사용자의 만족도를 높이고 있다.2)

미국자동차공학회(Society of Automotive Engineers, SAE)에서는 2014년도부터 SAE J3016 정의서를 통하여 자율주행 레벨의 구분을 위한 분류 체계 및 정의를 논의해왔다. SAE J3016에서는 자율주행 차량의 주행 자동화 단계를 동적운전작업(Dynamic Driving Task, DDT)의 자동화 정도에 따라 주행 자동화가 없는 레벨 0부터 완전히 자동화가 이루어진 레벨 5까지 총 여섯 단계로 나누었는데, 단계별로 자율주행시스템(Automated Driving System, ADS) 및 인간의 수행 역할이 변화하는 것을 확인할 수 있다. 이에 대한 자세한 내용은 2장에서 설명하였다.

자율주행이 고도화되면서 차량의 라이다, 레이더, 카메라와 같은 센서를 통해 데이터를 수집하여 운전자에게 다양하고 많은 정보를 제공할 수 있지만, 운전자의 집중력과 작업 부하를 고려한 적절한 수준의 정보 제공이 필요하다. 이와 관련하여, 백수진과 양지현3)은 자율주행 레벨 3 수준의 주행 환경에서 전용도로, 도심로 주행 환경에 필요한 정보의 양을 도출하는 시뮬레이터 실험을 수행하였다. 그 결과, 정보의 양에 따라 운전자가 상황을 인지하는 시간, GSR(Galvanic Skin Response) peak, 인지율이 달랐다. 이 결과는 모든 주행 환경과 주행 상황에서 많은 양의 정보가 운전자의 빠른 인지시간과 높은 상황 인지율로 이어지지 않았음을 시사한다.

이전부터 레벨 2-3 수준의 자율주행 차량에서 운전자와 차량의 상호작용을 다룬 연구는 다수 진행되었다. 이지원 등4)은 차량 인터페이스 가이드라인, OEM 매뉴얼 등 문헌 연구를 통해 자율주행 레벨 2-3 수준의 시각, 청각, 촉각 알림 초안을 제안하고, 시뮬레이터 기반 레벨 3 자율주행 상황에서 운전자에게 청각 또는 촉각 기반 제어권 알림 유형에 따른 제어권 전환 실험을 진행하였다. 그 결과, 청각 기반 제어권 전환 알림 중 이어콘(짧은 음악적 신호)을 제공하였을 때 다른 청각 알림 유형보다 제어권 전환 시간 면에서 유의미하게 빨랐다.

김영우 등5)은 30명의 참가자를 대상으로 자율주행 레벨 3 시뮬레이터 환경에서 동승자 대화, 영상 시청, 스마트폰 게임 및 음료 들기와 같은 비주행 과업의 인지 부하, 몰입도 및 제어권 이양 시간을 측정하는 실험을 수행하였다. 그 결과, 운전자가 수행하는 비주행 과업의 종류에 따라 운전자는 다른 수준의 인지 부하 및 몰입도를 보이는 것으로 나타났다.

SAE 기준 자율주행 레벨 3에서 인간 운전자는 이상 상황 발생 시 대처의 주체(Fallback-ready user)로써의 역할을 수행하기 때문에6) 그동안의 연구는 제어권 전환 상황을 인식시켜 차량의 제어권을 인간 운전자에게 이양하기 위한 알림 방법에 관하여 주로 수행되어왔다.

반면, 자율주행 레벨 4에서는 자율주행시스템이 모든 이상 상황의 대응을 수행하므로6) 이러한 수행 역할 변화를 고려한 새로운 탑승자 상호작용에 대한 연구는 아직 부족한 실정이다. 홍승혜와 최준호7)에 따르면 레벨 0~3 환경은 인지 부하에 따른 운전자의 퍼포먼스가 중요하지만, 레벨 4 환경에서는 시스템에 대한 운전자의 신뢰감 및 시스템 상호작용이 중요하고 하였다. 이처럼 자율주행 레벨 3과 레벨 4에서는 자율주행시스템과 인간의 수행 역할이 변화하게 되므로, 자율주행 차량의 탑승자에게 제공되는 정보의 내용과 정보 제공 방법이 달라질 수 있다. 예를 들어, 작동설계영역(Operational Design Domain, ODD) 이탈이라는 동일한 이상 상황에서 인간 운전자의 대처가 요구되는 레벨 3과 대비하여 운전자의 대처가 요구되지 않는 레벨 4에서는 덜 긴급한 정보를 탑승자에게 제공할 것으로 보인다.

따라서, 기존 레벨 3에서 차량 제어권 전환 중심의 자율주행시스템-사용자 간 상호작용이 아닌, 새로운 유형으로 전개될 것으로 예측되는 레벨 4 자율주행시스템의 상호작용에 관한 연구가 필요하다.

1.2 연구 목표

본 연구는 사용자 인터페이스(User Interface, UI) 사례 분석 기반의 부분 자율주행 차량 HMI(Human-Machine Interaction) 정보 제공 방법 특성 비교 연구로, 자율주행 레벨 변화에 따라 사용자에게 정보를 제공하기 위한 사용자 인터페이스의 특성 차이를 분석하는 것을 목표로 한다. 이를 위해 자율주행 레벨 3과 레벨 4에서의 자율주행시스템과 사용자의 수행 역할 변화를 비교하고, HMI 관점에서 사용자 정보 제공 방법을 분석하였다.

2장과 3장에서는 SAE J3016 표준을 기반으로 자율주행 레벨 3과 레벨 4의 특징을 비교하고, ISO/TR 4804 국제 표준을 기반으로 자율주행 레벨 3과 4 자율주행시스템의 설계 시 인적요인 측면의 고려사항을 분석하여 정리하였다.

4장에서는 OEM의 차량 매뉴얼, 기술자료, 보도자료 등을 기반으로 자율주행 레벨 변화(레벨 2~레벨 4)에 따른 UI 사례를 분석하였다.

5장에서는 레벨 4 자율주행 차량에서 활용 범위가 증대될 것으로 기대되는 외부 인터페이스(External Human-machine interface, e-HMI)의 선행연구 사례를 분석하였다.

6장에서는 자율주행 레벨에 따른 UI의 변화 양상을 정리하고, 자율주행 레벨 4 차량의 UI에서 예상되는 특징을 정리하였다.

본 연구의 결과는 자율주행 레벨 2, 3 대비 차별화된 레벨 4 탑승자 상호작용 평가 방법 개발을 위한 선행연구로서의 의의가 있을 것으로 기대된다.

2. HMI 관점의 SAE J3016 정의서 기반 자율주행 레벨 3&4 분석

SAE J3016은 미국자동차공학회에서 2014년 1월 최초로 제안한 자율주행 레벨 구분의 국제적 표준으로, 자율주행 단계의 분류 체계와 상세한 정의를 제공하고 있지만, ODD 내에서 ADS가 완전한 DDT를 수행하는 공통점이 있는 자율주행 레벨 3과 레벨 4의 차이를 이해하기 위해 구체적인 사례를 중심으로 분석이 필요하다.

따라서 본 연구에서는 2023년 2월 기준 최신 버전인 SAE J3016 2021년 4월 개정본(J3016_202104)6)을 기준으로 HMI 관점에서 차량의 주행 자동화 레벨 분류를 정리하고, 자율주행 레벨 3과 레벨 4를 구체적인 사례 중심으로 비교 분석하였다.

2.1 SAE J3016 기반 주행 자동화 레벨 분류

SAE J3016에서는 자율주행시스템에서 작동하고 있는 기능(Feature)의 DDT 자동화 정도에 따라서 주행 자동화가 없는 레벨 0부터 완전 자동화인 레벨 5까지 총 6개의 단계로 차량의 주행 자동화 단계를 구분하고 있다. 이때 DDT는 조향 및 가/감속에 의한 차량의 동작 제어 등과 같이 차량을 도로교통 상에서 작동시키기 위하여 요구되는 실시간의 조작적(Operational) 및 전술적(Tactical) 기능을 의미한다.6) J3016의 주행 자동화 단계 분류를 기준으로, 레벨 0부터 레벨 2는 운전자 보조 기능(Driver support features)에 해당한다.

레벨 0(No driving automation)는 DDT의 자동화가 이루어지지 않은 단계로, 운전자가 모든 DDT를 수행하여야 한다. 레벨 0 기능은 경고 및 순간적인 지원을 제공하며, 예시로는 Blind spot warning, Lane departure warning 등이 있다.

레벨 1(Driver assistance)은 차량의 횡방향 또는 종방향 중 하나의 제어만 가능하며, 완전한 사물과 이벤트의 감지 및 대응(Object & Event Detection and Response, OEDR)의 수행은 불가능한 단계이다. 레벨 1 기능의 예시로는 차량의 횡방향 제어를 위한 Lane centering이나 종방향 제어를 위한 Adaptive cruise control 등이 있다.

레벨 2(Partial driving automation)는 차량의 횡방향 및 종방향의 동작 제어가 모두 가능하나, 여전히 완전한 OEDR의 수행은 불가능한 단계이다. 레벨 2 기능의 예시로는 주행 차선 내에서 차량의 조향, 가속 및 제동이 가능한 Autopilot(Tesla), HDA(Hyundai) 등이 있다.

레벨 3부터 레벨 5는 자율주행 기능(Automated driving features)에 해당한다.

레벨 3(Conditional driving automation)에서는 한정된 ODD 내에서 완전한 DDT의 수행이 가능하나, 시스템 고장 등 이상 상황 발생에 따른 시스템의 대응(DDT fallback)이 불가능하여 인간 운전자의 개입이 요구되는 단계이다. 레벨 3 기능의 예시로는 제한된 ODD(예 : 고속도로)에서 차량의 주변을 모니터링하며 차량의 감/가속 및 조향 제어를 수행하는 Traffic jam chauffeur가 있다.

레벨 4(High driving automation)에서는 한정된 ODD 내에서 완전한 DDT 및 DDT fallback의 수행이 가능한 단계이다. 한정된 지역에서 인간 사용자의 개입 없이 운행이 가능한 무인 택시 서비스인 Waymo one 등에서 자율주행 레벨 4 수준의 주행 기능을 활용하고 있다.

레벨 5(Full driving automation)에서는 ODD의 제한 없이 완전한 DDT 및 DDT fallback의 수행이 가능한 단계이다. 레벨 4 기능이 제한된 ODD 내에서 수행되는 것과는 달리, 레벨 5 기능은 어떠한 ODD의 제한 없이 해당 기능을 수행할 수 있다는 점에서 차이가 있다.

위에서 분석한 내용을 바탕으로 주행 자동화 단계에 따른 자율주행시스템의 완전한 DDT 및 DDT fallback 수행 능력을 Table 1에 요약하여 나타내었다.

2.2 SAE J3016 기반 자율주행 레벨 3&4 비교

자율주행 레벨 3 대비 레벨 4의 가장 큰 차이점은 자율주행 중 시스템 또는 차량 자체의 고장이나, 시스템의 ODD를 벗어나는 등의 이상 상황 발생 시, 이에 대응하는 DDT fallback의 주체가 인간 사용자에서 자율주행시스템으로 변화하는 것이다.

자율주행 레벨 3에서 DDT fallback의 주체는 차량의 운전석에 탑승하고 있는 인간 운전자이다. 자율주행시스템 활성화 시에는 시스템에 대한 운전자의 감독이 필요하지 않다. 하지만 이상 상황 발생 후, 시스템의 개입 요청이 있는 경우에 인간 운전자가 차량의 제어권을 넘겨받아 이상 상황에 대응해야 할 의무가 있다.

반면, 자율주행 레벨 4에서 DDT fallback의 주체는 자율주행시스템이다. 자율주행시스템 활성 상태에서는 이상 상황이 발생하더라도 시스템이 자동으로 이에 대처하여 최소위험조건을 달성하게 되므로, 차량의 제어를 위한 인간의 개입이 필수적으로 요구되지 않는다.

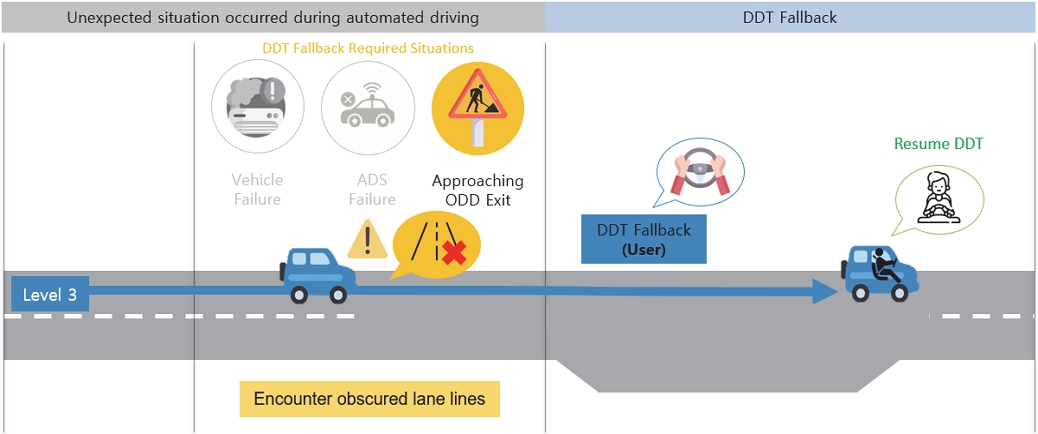

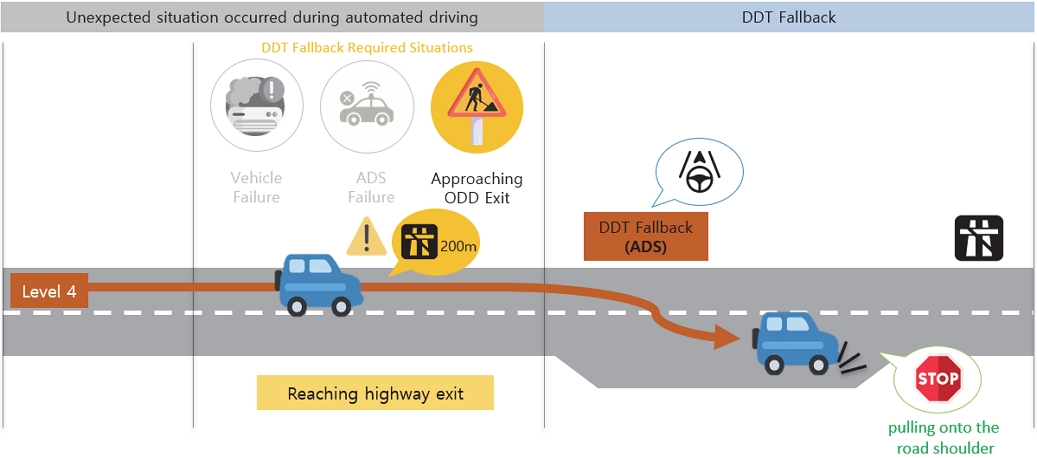

SAE J3016에서 제시하는 이상 상황 예시 중 레벨 3과 레벨 4 Highway 기능 ODD 이탈 사례에서 DDT fallback 수행 과정의 차이를 도식화하여 나타내면 Fig. 1 및 Fig. 2와 같다.

레벨 3 수준의 Highway 기능은 명확한(Clearly visible) 주행 차선이 있는 고속도로 내에서 자율주행시스템이 완전한 DDT를 수행한다.

레벨 3 Highway 기능이 활성화된 상태로 주행하는 중 차선이 갑자기 흐려져 해당 기능의 작동설계영역을 이탈하게 되는 경우에, DDT fallback의 주체인 인간 운전자는 차량의 제어권을 시스템으로부터 넘겨받아 남은 여정을 직접 운전하게 된다. 레벨 3 Highway 기능의 DDT fallback 수행 과정을 Fig. 1에 나타내었다.

레벨 4 수준의 Highway 기능은 한정된 작동설계영역(고속도로) 내에서 자율주행시스템이 완전한 DDT/DDT fallback 및 OEDR을 수행한다. Highway 기능이 활성화된 상태로 고속도로를 주행하던 중에 고속도로의 종료 지점에 도달하여 기능의 설계된 작동설계영역을 이탈하게 되는 경우, DDT fallback의 수행 주체는 자율주행시스템이다.

자율주행시스템은 인간 사용자의 개입이 없이 최소 위험 조건을 달성하기 위한 대응을 스스로 수행하게 된다(예 : 차량감속 후 갓길에 정차). 레벨 4 Highway 기능의 DDT fallback 수행 과정을 Fig. 2에 나타내었다.

3. ISO/TR 4804 기반 자율주행 레벨 3&4 인적요인(Human Factors) 분석

ISO/TR 4804는 레벨 3과 레벨 4 자율주행시스템의 안전성 및 보안성을 보장하기 위한 설계 및 검증 방법을 규정한 국제 표준이다. 본 연구에서는 ISO/TR 4804 2020년 12월 버전(ISO/TR 4804:2020)8)을 기준으로, 자율주행시스템의 인적요인(Human factors) 측면에 집중하여 관련 챕터인 2.2.2.14 Human-machine interaction, 2.2.2.15 User state determination, 2.2.2.16 Vehicle state, Appendix A development examples 챕터의 내용을 요약 정리하였다. 본 장의 분석 내용은 자율주행 레벨 4 탑승자 정보 제공 위치 및 정보 제공 방법 논의에 활용할 수 있다.

3.1 인간-기계 상호작용(Human-Machine Interaction)

HMI는 인간과 기계가 상호작용해 정보와 조작을 주고받을 수 있는 수단을 제공하는 것으로, 시스템이 인간 운전자를 대신하여 ODD 내에서 모든 DDT를 수행하는 레벨 3 이상 자율주행시스템의 안전한 작동을 위해 중요하게 고려되어야 할 요소이다. 이러한 HMI의 가장 중요한 목표는 실제 주행모드(자율주행, 수동주행)와 관련 책임 및 주행 작업에 대해 사용자가 올바르게 해석하고 구분하도록 하는 것이다. 자동화 수준에 따라 운전자의 주행 작업과 책임이 달라지기 때문에, 다른 수준의 자동화 기능이 장착된 차량에서 운전자는 주행모드와 책임의 혼란을 겪을 수 있기 때문이다. 따라서 HMI는 주행모드와 운전자 책임 전환 등을 명확하고 쉽게 이해할 수 있는 방법(예: 시각-청각 신호의 결합)으로 전달해야 한다.

미국 도로교통안전국(National Highway Traffic Safety Administration, NHTSA)이 2017년 발표한 지침에 따르면, HMI는 다양한 지표를 통해 운전자 및 탑승자에게 시스템 상태나 오작동 등을 알릴 수 있어야 하며, HMI의 사용성과 안정성에 대한 요구사항을 충족하기 위하여 사용자와의 커뮤니케이션 등을 고려하여야 한다. 따라서 HMI 및 인적요인은 자율주행시스템 개발의 중요한 부분이라고 할 수 있다.

3.2 사용자 상태 결정(User State Determination)

자율주행시스템 사용자의 상태 측정 및 감지를 위해 활용 가능한 기술로는 운전자 모니터링 카메라, 시트 포지션, 점등(Lighting) 요소, Hands-on 스티어링 휠 센서, 착석 센서, 스티어링 컬럼 토크 등이 있다. 이때 사용자의 상태 측정을 위해 설정된 센서는 신뢰성과 유효성 테스트가 이루어져야 하며, 테스트 수행 시에는 눈 모양, 안경 착용 여부 등의 다양한 사용자 샘플을 사용하여 센서 시스템의 한계를 극복해야 한다.

3.3 차량 상태(Vehicle State)

사용자에서 자율주행시스템으로 제어권이 전환되는 작업 중의 자율주행시스템은 운전자와 차량의 상태를 모니터링해야 한다. 모니터링되는 차량 상태로는 연료 등 에너지 저장장치의 상태 또는 배터리의 충전 상태, 타이어 공기압, 오일 온도 및 레벨, 도어 상태 등이 있다. 시스템은 모니터링한 차량 상태를 기반으로 제어권 전환이 필요하다고 판단되면 사용자에게 다시 차량의 제어권을 전환하기도 한다.

3.4 자율주행 레벨 3&4 기능 HMI 예시(Development Examples)

ISO/TR 4804에서 설명하는 자율주행 레벨 3&4 기능 HMI 예시는 다음과 같다. 레벨 3 기능인 Traffic Jam Pilot의 HMI는 차량의 운용자(Operator)인 차량 내의 사용자가 제어권 전환 요청에 대응할 수 있는지 표시해야 한다.(예: 눈을 뜨고 있는가 등) 레벨 4 기능인 Urban Pilot의 HMI는 차량 내 사용자 이외에도 차량 외부의 원격 운용자와 같은 새로운 Operator에 대한 고려가 추가적으로 필요하다.

레벨 3 Traffic Jam Pilot에서는 현재의 자율주행 단계를 사용자에게 명확하게 표시하고, 차량으로부터 제어권을 전환하려는 사용자의 의도적인 행동을 감지하는 등 HMI를 통해 사용자의 자유와 책임에 대하여 사용자와 지속적인 소통을 위한 목적으로 활용된다. 반면, 레벨 4 Urban Pilot에서는 즉각적인 차량의 정지를 위한 항법적 상호작용의 수단으로 활용되는 등 레벨 3과는 다른 목적으로 HMI가 활용된다.

4. 자율주행 레벨별 UI 사례 분석

본 장에서는 OEM의 공식 보도자료, 사용자 매뉴얼 및 관련 기술자료를 참고하여 자율주행 레벨별 기능의 관점에서 UI의 사용사례를 정리하였다. 이를 통해 자율주행 레벨 변화에 따른 사용자 인터페이스의 특징 차이를 분석하고자 한다.

4.1 자율주행 레벨 2 UI 사례 분석 : Tesla - Autosteer

자율주행 레벨 2 수준의 기능은 운전자 지원 기능(Driver support feature)으로 분류되며, 작동 시에 운전자의 감독하에서 사용되는 운전자 보조 기능에 해당한다. 사용자는 기능의 작동상태를 지속적으로 주시하면서 필요한 경우에는 직접 차량의 감/가속 또는 조향을 수행해야할 책임이 있다. 따라서, 자율주행 레벨 2 수준의 기능은 자율주행 기능(Automated driving feature)에 해당하지 않는다.

AutoPilot은 미국 Tesla 사의 Model S 차량에 적용된 자율주행 레벨 2 수준의 운전자 지원 기능이다. AutoPilot은 설정한 속도를 유지하면서 주행하는 Traffic-Aware Cruise Control, 인접한 차선으로의 이동 및 조향을 지원하는 Autosteer, 탐색한 경로를 기반 고속도로 진출로 및 인터체인지로 안내하는 Navigate on Autopilot, 공공도로에서 차량을 주차 공간으로 이동하는 것을 지원하는 Autopark를 하위 기능으로 지원하고 있다.9)

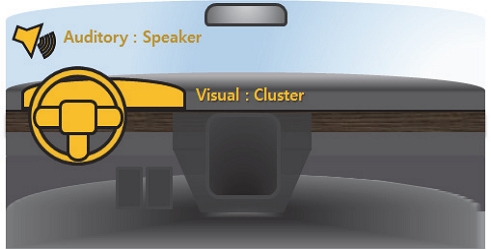

사용자가 차량의 방향 지시등을 작동하면 해당 방향 지시등이 가리키는 방향의 인접한 차선으로의 이동을 지원하는 레벨 2 기능인 Autosteer의 작동/활성화 시에는 사용자가 스티어링 휠을 항상 잡고 있어야 하는 등 기능의 작동 상태에 대한 사용자의 지속적인 모니터링이 필요하다. 따라서 Autosteer의 UI는 Fig. 3과 같이 사용자가 작동상태를 지속적으로 모니터링 할 수 있도록 클러스터 및 스피커를 활용하여 기능의 작동상태에 대한 정보를 제공하고 있다.

Autosteer 기능이 활성화되었을 때는 클러스터 상에 파란색 배경의 스티어링 휠 로고를, 비활성화 되었을 때는 회색 배경의 스티어링 휠 로고가 나타나 사용자는 Autosteer 기능의 활성화 상태를 알 수 있다.

일정 시간 동안 사용자가 스티어링 휠에 손을 올려놓는 것이 감지되지 않을 경우, 시스템은 클러스터 상에 “Apply slight turning force to steering yoke” 문구로 사용자가 스티어링 휠을 잡도록 경고한다. 경고 이후에도 사용자가 지속적으로 스티어링 휠을 잡지 않는 경우에는 Error 심벌 및 경고음과 함께 “Take over immediately” 문구가 표시되어 사용자에게 Autosteer 기능이 해제됨을 경고한다.

Autosteer UI의 타입과 위치, UI를 통해 사용자에게 제공되는 정보의 내용을 Table 2에 정리하여 나타내었다.

4.2 자율주행 레벨 3 UI 사례 분석 : Honda – Traffic Jam Pilot

자율주행 레벨 3 수준 이상의 기능부터는 자율주행 기능(Automated Driving Feature)으로 분류된다.

자율주행 레벨 3 기능이 작동할 때는 사용자가 기능의 작동상태를 주시할 의무가 존재하지 않으므로 레벨 2 기능과 같이 스티어링 휠을 지속적으로 잡고 있거나 전방을 주시하고 있어야 할 의무가 없다. 하지만, 작동한계상황 등 시스템이 요구할 시에는 사용자가 개입하여 대응하여야 할 책임이 여전히 존재한다.

일본 Honda 사의 준대형 세단인 Legend 차량에 탑재된 Traffic Jam Pilot 기능은 고속도로 정체 구간에서 30 km/h이하로 주행 시 활성화할 수 있다. 기능이 활성화되면, 시스템이 차량 주변을 스스로 모니터링하며 최대 50 km/h까지 가속, 제동, 조향을 제어하면서 주행하므로 사용자가 별도로 차량을 조작할 필요가 없다. 따라서 해당 기능이 활성화된 상태에서는 사용자가 스티어링 휠에서 손을 떼고 전방 상황 주시 의무에서 벗어나 시선을 자유롭게 둘 수 있으며, 영상시청 등의 실내 행위가 가능하다.10)

다만, 고속도로를 벗어나 톨게이트에 도달하거나, 기상상황이 악화되는 등(예 : 폭우) Traffic Jam Pilot의 ODD를 이탈하여 기능이 비활성화될 경우에는 사용자가 제어권 전환 알림에 따라 다시 개입하여 운전을 재개하여야 한다.

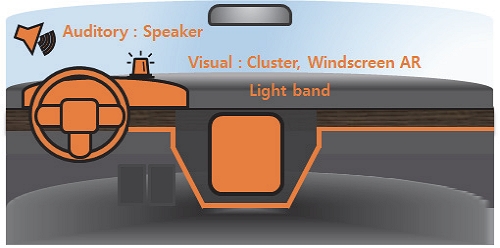

레벨 3 기능인 Traffic Jam Pilot의 차량 내부 UI는 Fig. 4와 같이 윈드실드의 Augmented Reality(AR) 디스플레이, 스티어링 휠/센터페시아/대시보드의 라이트밴드, 청각 경고음, 스티어링 휠 진동을 복합적으로 활용한다. 이를 통해 사용자에게 차량이 현재 자율주행 상태로 주행 중임을 알리거나, ODD 이탈 등에 따른 시스템의 차량 제어권 이양 요청을 인식시킨다.

Traffic Jam Pilot 기능이 작동 중일 때에는 파란색(Turquoise) UI를 적극적으로 사용한다. 스티어링 휠의 혼 커버 좌/우, 중앙 디스플레이 상단, 대시보드의 라이트밴드가 파란색(Turquoise)으로 변화하며 현재 해당 기능이 활성화되어 자율주행을 수행하고 있음을 사용자에게 알린다.

Traffic Jam Pilot 기능이 비활성화될 경우에는 빨간색의 UI를 통해 사용자가 차량의 제어권을 이양받아야 하는 상황임을 알린다.

클러스터 내부에 표시되는 스티어링 휠 조작 이미지와 스티어링 휠의 혼 커버 좌/우, 중앙 디스플레이 상단, 대시보드의 라이트밴드가 적색으로 변화한다. 여기에 동반하여 스티어링 휠이 진동하고, 안전벨트가 조여지면서 사용자에게 제어권 이양 필요 상황에 대한 정보를 운전자에게 적극적으로 전달한다.

또한, Traffic Jam Pilot이 작동하고 있을 때에는 Fig. 5와 같이 차량 외부 인터페이스인 전/후 범퍼의 파란색(Turquoise) 라이트밴드가 점등되어 차량이 현재 자율주행 모드로 주행하고 있음을 외부에 전달한다.

External user interface(light band) of level 3 Traffic Jam Pilot(redrawn based on Seo et al. 202311))

Traffic Jam Pilot UI의 타입과 위치, 사용자에게 제공되는 정보의 내용을 Table 3에 정리하여 나타내었다.

4.3 자율주행 레벨 4 UI 사례 분석 : Hyundai – IONIQ 5 Robotaxi

자율주행 레벨 4 이상의 기능은 레벨 3 기능과 달리, 자율주행시스템의 운영설계영역을 벗어나더라도 인간의 개입 없이 모든 이상 상황에 대응할 수 있도록 설계되어 있다. 따라서, 자율주행 레벨 4 기능은 차량의 운행 과정 동안 사용자가 별도로 차량의 조작에 개입할 필요가 없으며, 외부에서 원격으로 차량을 호출하는 등의 상황이 가능해짐에 따라 레벨 3에서는 해당하지 않았던 사용자 인터페이스가 새롭게 요구된다.

현대자동차그룹은 IONIQ 5 전기 차량을 기반으로 미국의 자율주행 기업인 앱티브(Aptiv) 사와의 합작법인인 Motional을 통해 개발한 레벨 4 자율주행 로보택시의 시범 운영 서비스를 현재 미국 라스베가스에서 진행하고 있다.12) 본 연구에서는 IONIQ 5 Robotaxi 서비스의 UI를 자율주행차의 사용자 여정 단계 분류13)를 참고해 ‘호출~탑승 전’, ‘탑승 후~출발’, ‘주행 중’, ‘도착~하차’ 단계로 분류하여 각 단계에서의 UI에 대한 분석을 진행하였다.

‘호출~탑승 전’ 단계는 사용자가 목적지까지 이동하기 위하여 차량을 호출하고, 호출한 차량에 탑승하기 이전까지의 단계이다. 로보택시의 외부에는 원거리에서도 사용자가 차량을 인식할 수 있도록 Fig. 6과 같이 루프돔 및 라이트밴드가 장착되어 있다.

각 도어의 창문 하단에 위치한 라이트밴드는 차량의 상태(탑승자 유무 등)에 따라 색상이 변화하는데, 이를 통해 사용자는 외부에서도 차량의 상태를 직관적으로 파악할 수 있다.

차량의 도어가 잠금상태일 때는 라이트밴드의 색상이 적색으로 표시되며, 사용자가 스마트폰을 통해 도어의 잠금을 해제하면 라이트밴드의 색상이 파란색(Turquoise)으로 변화한다.14) 또한, 운전석 전면 대시보드 상단에 차량의 외부 쪽을 바라보도록 설치된 디스플레이를 통해 차량을 호출한 사용자의 서비스 아이디를 표시하여 사용자가 다른 차량과 혼동하지 않고 차량에 탑승할 수 있도록 하였다.

‘탑승 후~출발’ 단계는 사용자가 차량에 탑승 후 목적지까지 주행을 시작하기 이전의 단계이다. 사용자는 후석에 설치된 개별 디스플레이를 통해서 주행하는 동안 필요한 정보(예상 도착 시간 등)를 제공받게 된다. 또한, 디스플레이 상에 ‘Start ride’ 버튼을 별도로 제공하여, 탑승 직후 사용자가 원하는 시점에 차량의 출발을 지시할 수 있도록 설계되었다.

‘주행 중’ 단계는 목적지까지 이동하는 단계이다. 사용자는 대시보드 중앙의 디스플레이를 통해 차량의 이동 경로를 실시간으로 확인할 수 있으며, 현재 차량의 위치 및 식별된 인근 차량 등 차량이 인지하고 있는 주변의 주행 상황을 전달받는다.

만약 사용자가 주행 중 안전벨트를 해제하거나, 공사 구간 출현으로 인해 기존 경로에서 차량이 우회하는 등의 돌발 상황이 발생할 경우, 디스플레이에 표시되는 팝업 메시지 및 경고 사운드를 통해 사용자에게 행동 지침과 차량의 대처 방법에 대한 정보를 전달한다.15)

Fig. 7에서는 IONIQ 5 Robotaxi 서비스 사용자가 ‘주행 중’ 단계에서 정보를 제공 받는 차량 인테리어 UI의 구성을 나타내었다. 해당 여정 단계에서 사용자 정보 제공은 중앙의 대형 디스플레이를 통한 시각 알림과 스피커를 통한 청각 알림을 통해 주로 이루어진다.

‘도착~하차’ 단계는 목적지에 도착 후 사용자가 차량에서 하차하기까지의 단계이다. 사용자는 목적지에 도착 후 하차 시 차량 내 조명과 차량 주변 조명을 통해 차량 주변의 상황을 파악할 수 있다.

만약 사용자가 차량 내에 두고 내리는 물건이 있는 경우에는 차량 외부 스피커를 통해 알림을 제공하도록 설계되었다.

Hyundai IONIQ 5 Robotaxi 서비스에서 사용하고 있는 UI의 타입과 위치, 사용자에게 제공되는 정보의 내용을 Table 4에 정리하여 나타내었다.

5. 자율주행 레벨 4 차량 외부 인터페이스(e-HMI) 선행연구 분석

자율주행 레벨 4에서는 차량 내에 운전자가 없는 무인 운용이 허용되므로6) 무인 차량을 사용자가 외부에서 호출하는 ‘로보라이드’ 형태의 서비스가 보편화될 것으로 보인다. 국내에서도 현재 특정 구역 내에서 사용자가 차량을 호출하고, 지정된 경로를 따라 목적지까지 이동하는 형태로 레벨 4의 시범 서비스가 이루어지고 있다.

기존의 인간 운전자는 길을 건너려는 보행자와 눈을 마주치거나 제스처를 취하는 등 주행 상황에서 의사 표현의 주체로서의 역할을 수행하였다.

하지만 레벨 4 차량의 무인 운용 시에는 이러한 의사 표현의 수행 주체가 사라지게 되므로 차량 외부의 사용자 또는 주변 도로 사용자와 소통하기 위한 대체적인 주체가 필요하다. 따라서 이러한 의사소통의 수행 주체로써 외부 인터페이스(e-HMI)의 활용 범위가 확대될 것으로 예상된다. 본 장에서는 자율주행 레벨 4 차량 e-HMI의 주요 선행연구 사례를 분석하여 정리하였다.

Haeuslschmid 등16)은 운전자, 승객 및 보행자를 위한 윈드실드(Wind-shield) 디스플레이를 통해 주차권 투영, 보행자를 위한 네비게이션으로의 활용을 제안하였다.

Colley 등17)은 휴대용 프로젝터를 사용한 시각 정보 제공 방법의 프로토타입을 제시하는 방법으로 외부 보행자 혹은 다른 차량에게 경고 혹은 정보를 제공하는 방법에 대해 제안하였다.

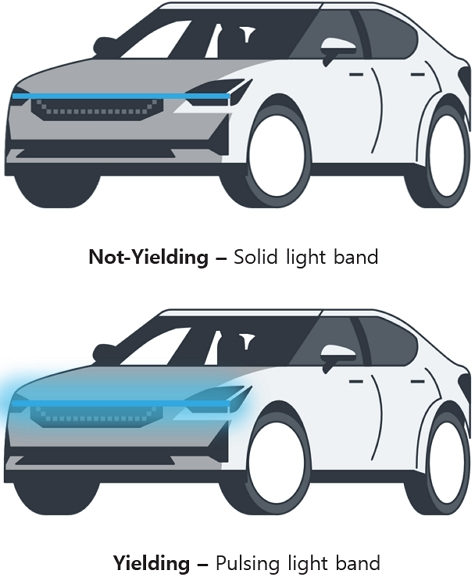

Dey 등18)은 Fig. 8과 같이 라이트밴드를 통해 자율주행 차량 외부의 보행자에게 정보를 제공하는 방법을 제안하였다. 횡단보도를 건너려는 보행자와 차량이 마주치는 상황에서 차량 전면부의 라이트밴드를 통해 보행자에게 양보 의도가 없음을 알릴 때는 정적인 라이트밴드를, 양보 의도가 있음을 알릴 때는 맥동하는 라이트밴드를 표시한다.

Providing information to external pedestrians using light band : yielding intent(redrawn based on Seo et al. 202311))

Bazilinskyy 등19)은 Fig. 9와 같이 자율주행 차량의 앞범퍼에 장착된 디스플레이를 통해 차량 외부의 보행자에게 정보를 제공하는 방법을 제안하였다. 차량이 보행자 쪽으로 다가가고 있을 때 보행자가 차량의 진행 방향 쪽으로 보행하지 않도록 외부 디스플레이로 보행자에게 회피할 방향을 제안한다.

레벨 4 e-HMI 선행연구 사례 분석 결과를 정리해보면, 라이트밴드 또는 앞범퍼 디스플레이 등을 활용하여 시각적인 정보 위주의 제공을 통해 외부 사용자 또는 주변도로 사용자와의 상호 작용이 이루어지는 방향으로 다수의 연구가 이루어지고 있는 것을 확인할 수 있었다.

이때 사용되는 UI의 색상으로는 공통적으로 Turquoise 또는 Cyan의 파란색 계통 색상을 채택하고 있는 것을 확인할 수 있었으며, 이는 4장에서 분석하였던 실제 레벨 4 시범 서비스인 IONIQ 5 Robotaxi 서비스의 사례에서도 확인할 수 있었다.

6. 결 론

본 연구에서 분석한 자율주행 레벨별 기능의 UI 차이를 비교하여 정리해보면 다음과 같다.

레벨 4 이하의 자율주행 레벨인 레벨 2 기능은 사용자의 기능 작동상태 모니터링, 레벨 3 기능은 사용자에게 제어권 이양 알림과 같이 시스템이 사용자에게 요청하려는 특정한 목적을 달성하기 위하여 UI가 사용되는 경향을 보이고 있었다.

반면, 차량의 운행 과정에서 사용자의 개입이 요구되지 않는 자율주행 레벨 4 기능에서는 탑승 지원, 분실물 알림 등 더욱 다양하고 새로운 목적으로 UI가 사용되는 경향을 보였다. 또한, 운행 과정 중에 주변과의 상호작용을 수행하는 주체가 인간에서 자율주행시스템으로 변화하며, 새로운 고려 대상인 외부 사용자와의 상호작용을 위한 다양한 방법론적인 선행 연구가 이루어지고 있음을 확인하였다. 그중에서도 특히 e-HMI의 활용 범위가 증대되어 사용자가 차량의 외부에 있더라도 외부 디스플레이, 라이트밴드, 스피커 등을 통해 차량 내부 사용자 뿐만 아니라 외부 사용자와도 적극적으로 소통하려는 양상을 보이는 것을 확인할 수 있었다. 이러한 점을 고려하였을 때, 향후 레벨 4 차량에서는 새로운 의사소통의 수단으로써 e-HMI가 본격적으로 채택될 것으로 보인다. 또한, 향후 자율주행 환경을 고려한 차량 경고등 또는 UI 색상 체계의 정리가 필요할 것으로 보인다.

본 연구의 의의는 기존에 운전자-차량 간 상호작용 관련 연구가 다수 진행되었던 자율주행 레벨 2-3 수준의 OEM 사례뿐만 아니라, 현재 시범적으로 운영이 이루어지고 있는 자율주행 레벨 4 서비스 사례를 기반으로 레벨 4 수준으로까지 연구 관점을 확장하여 사용자 인터페이스를 시각화하여 제시하고, 자율주행시스템으로부터 사용자에게 제공되는 정보의 제공 방법 및 위치에 대한 분석을 수행하였다는 점이다.

본 연구의 결과는 향후 자율주행 레벨 4 차량의 사용자 인터페이스 개발을 위한 HMI 기능 요구 사양 도출의 기초 연구 자료로 활용할 수 있을 것으로 기대한다. 추후 자율주행 레벨 4 HMI 기능의 다양한 사용자 정보 제공 상황 시나리오 도출 및 상세 Use case 설계에 대한 보완 연구를 진행할 예정이다.

Acknowledgments

본 연구는 산업통상자원부 자율주행기술개발혁신사업의 지원을 받아 수행된 연구임(20018101, T Car 기반 자율주행 인지예측지능제어 차량부품시스템 통합평가 기술개발). 이 논문은 BK21의 지원을 받아 수행된 연구임(5199990814084). 이 논문은 과학기술정보통신부의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2021R1A2C1005433). 이 논문은 2023년도 정부(산업통상자원부)의 재원으로 한국산업기술진흥원의 지원을 받아 수행된 연구임(P0017120, 2023년 산업혁신인재성장지원사업).

References

- H. Ryu and K. Kim, “Global Trends and Developments on Automotive UX/UI,” Proceedings of the Korea Information Processing Society Conference, pp.1145-1148, 2019.

- Mercedes-Benz, MBUX: The Mercedes-Benz User Experience, https://www.mercedes-benz.co.kr/passengercars/technology/mb-mbux.html, , 2023.

-

S. Baek and J. Yang, “Automated Driving System GUI Level Study From the User’s Perspective,” Transactions of KSAE, Vol.28, No.8, pp.563-570, 2020.

[https://doi.org/10.7467/KSAE.2020.28.8.563]

-

J. Lee, H. Yun, J. Kim, S. Baek, H. Han, S. M. FakhrHosseini, E. Vasey, O. Lee, M. Jeon and J. Yang, “Design of Single-Modal Take-Over Request in SAE Level 2 & 3 Automated Vehicle,” Transactions of KSAE, Vol.27, No.3, pp.171-183, 2019.

[https://doi.org/10.7467/KSAE.2019.27.3.171]

- Y. Kim, S. Yoon and Y. Ji, “The Effect of Cognitive Attributes of Non-Driving Related Tasks on the Takeover Performance,” Proceedings of HCI Korea 2019, pp.812-816, 2019.

- SAE On-Road Automated Vehicle Standards Committee, Taxonomy and Definitions for Terms Related to On-Road Motor Vehicle Automated Driving Systems, SAE Standard J3016, 2021.

-

S. Hong and J. Choi, “Effect of Multimodal Agent Interface on Trust and Safety in Autonomous Driving Environment - Focusing on the Context of Non-Driving Related Task and Take-Over Request,” Design Convergence Study, Vol.19, No.2, pp.3-21, 2020.

[https://doi.org/10.31678/SDC81.1]

- ISO/TR 4804:2020, Road vehicles — Safety and cybersecurity for automated driving systems — Design, verification and validation, https://www.iso.org/standard/80363.html, , 2020.

- Tesla, Model S Owner’s Manual 2021+, https://www.tesla.com, , 2022.

- Honda European Media Newsroom, Honda launches next generation Honda SENSING Elite safety system with Level 3 automated driving features, https://hondanews.eu/eu/et/corporate/media/pressreleases/329456/honda-launches-next-generation-honda-sensing-elite-safety-system-with-level-3-automated-driving-feat, , 2021.

- W. Seo, B. Choi, S. Hong and J. Yang, “A Study on the Method of Providing HMI Information for SAE Level 3&4 Automated Vehicle,” KSAE Spring Conference Proceedings, p.399, 2023.

- Hyundai Motor Group, Hyundai × Motional - Bringing IONIQ 5 robotaxis to the streets from 2023, https://www.hyundai.com/worldwide/en/brand-journal/mobility-solution/robotaxis, , 2021.

-

D. Lim and H. Hwangbo, “UX Design for Holistic User Journey of Future Robotaxi,” Proceedings of the AHFE 2021, pp.976-984, 2021.

[https://doi.org/10.1007/978-3-030-80091-8_116]

- Hyundai Motor Group, IONIQ 5-based Robotaxi – the Safe Bet for Getting around Las Vegas, https://www.hyundai.com/worldwide/en/brand-journal/mobility-solution/ioniq5robotaxi, , 2022.

- Hyundai Motor Group, Inspired by Humans: Introducing the IONIQ 5-based Robotaxi, https://www.hyundai.com/worldwide/en/brand-journal/mobility-solution/ioniq-5-based-robotaxi, , 2022.

-

R. Haeuslschmid, B. Pfleging and F. Alt, “A Design Space to Support the Development of Windshield Applications for the Car,” Proceedings of the 2016 CHI Conference on Human Factors in Computing Systems, pp.5076-5091, 2016.

[https://doi.org/10.1145/2858036.2858336]

-

A. Colley, J. Häkkilä, M. T. Forsman, B. Pfleging and F. Alt, “Car Exterior Surface Displays: Exploration in a Real-World Context,” Proceedings of the 7th Acm International Symposium on Pervasive Displays, pp.1-8, 2018.

[https://doi.org/10.1145/3205873.3205880]

-

D. Dey, A. Habibovic, M. Berger, D. Bansal, R. H. Cuijpers, and M. Martens, “Investigating the Need for Explicit Communication of Non-Yielding Intent through a Slow-Pulsing Light Band(SPLB) eHMI in AV-Pedestrian Interaction,” Proceedings of the 14th International Conference on Automotive User Interfaces and Interactive Vehicular Applications, pp.307-318, 2022.

[https://doi.org/10.1145/3543174.3546086]

-

P. Bazilinskyy, L. Kooijman, D. Dodou, K. Mallant, Roosens, M. Middelweerd and J. de Winter, “Get out of the Way! Examining eHMIs in Critical Driver-Pedestrian Encounters in a Coupled Simulator,” Proceedings of the 14th International Conference on Automotive User Interfaces and Interactive Vehicular Applications, pp.360-371, 2022.

[https://doi.org/10.1145/3543174.3546849]