실도로 주행 데이터를 이용한 도로 인프라 센서 기반 차선 변경 거동 검출 네트워크 연구

Copyright Ⓒ 2022 KSAE / 203-07

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

In this paper, a classification algorithm of lane change maneuver based on roadside sensors on highway is proposed. Data augmentation using field operational test data is also considered for scalability. The maneuver classification is composed of semantic maps and convolution neural network(CNN). The semantic map aims to represent a bird’s eye view of both vehicle and road geometry, and the corresponding trajectory of the vehicle. The CNN is used to classify a lane change maneuver of multiple vehicles. While good performance of maneuver classification is shown with respect to a well-known dataset called highD, it is still necessary to consider scalability. Thus, the data augmentation is suggested to build a semantic map based on field operational test data. Despite different sensor characteristics of two datasets, it is demonstrated how the performance of CNN-based maneuver classification is improved in terms of scalability is demonstrated.

Keywords:

Lane change, Maneuver classification, Roadside sensor, Data augmentation, Scalability키워드:

차선 변경, 거동 검출, 인프라 센서, 데이터 증강, 확장성1. 서 론

미래의 자동차는 도로 인프라 및 차량 간 통신으로 연결되는 커넥티드(Connected) 자율주행자동차로 진화할 것으로 예상되고 있다.1) 현재 개발하고 있는 대부분의 자율주행자동차는 차량 내 환경센서를 통하여 주변 객체(차량, 보행자, 차선 등)를 인지하고, 차량 거동(Maneuver)을 검출하고, 주행 궤적을 계획하는 등 다양한 주제에 대한 연구가 활발하게 진행되고 있다. 하지만, 주어진 센서의 측정 범위, 주변 차량 및 건물에 의해 가려지는 상황(Blockage)에 의한 인지 성능 저하 등 현재 센서 기술의 한계가 존재한다.2) 이러한 인지관점의 한계점을 극복하기 위해서 도로 상의 장착된 센서(라이다, 레이더, 카메라 등), 소위 도로 인프라 센서(Roadside sensor)를 사용한 차량 검출 및 추적(Detection and tracking), 보행자 검출, 보행자의 횡단 의도(Intention) 예측, 차량의 주행 궤적 예측(Path prediction)과 같은 연구가 활발히 진행되고 있다.3-6)

그 중 차선 변경(Lane change) 거동을 검출하는 연구는 차량 내 센서를 기반으로 끼어들기(Cut-in) 거동을 검출하는 문제가 대부분이며 도로 인프라 센서를 이용한 연구는 상대적으로 찾아보기 어렵다. 차량 내 센서를 기반으로 끼어들기 또는 차선변경 거동을 검출하는 방법론은 크게 Model-based, Generative, Discriminative, Neural network 기반 접근방법으로 구분할 수 있으며 본 논문에서는 딥러닝 네트워크(Neural network)을 기반으로 하는 방법론을 중심으로 살펴보고자 한다.7) 딥러닝 기반 연구는 다시 Multi-layer perceptron(MLP), Recurrent neural network(RNN), Convolution neural network(CNN)이 대표적으로 사용되고 있다. 예를 들어서, MLP을 사용하여 차선 변경 궤적을 예측하는 방법과 차선 변경에 대한 확률을 판단하는 알고리즘이 제안되었다.8,9) RNN의 경우 시계열의 정보를 사용하여 차량의 의도 혹은 궤적을 예측하는 연구,10,11) CNN은 이미지를 사용하여 차량의 거동 검출 및 예측 연구에 적용되고 있다.12)

도로 인프라 센서를 기반으로 한 연구는 거동 검출보다는 주로 궤적 예측에 대한 연구가 주를 이루고 있다. 예를 들어서 시계열의 조감도(Bird’s eye view, BEV) 이미지를 사용한 CNN 기반 궤적 예측, CNN과 Long-short term memory(LSTM) 기반 궤적 예측, LSTM 기반 단일 차량에 대한 차선 변경 예측 등이 있다.6,13,14) 물론 딥러닝이 아닌 기구학적 관계를 이용하여 차선 변경의 유무를 검출하는 연구가 존재하지만 딥러닝을 기반으로 차선 변경 거동 검출을 진행한 연구는 거의 찾아보기 힘들다.15,16)

차량 거동을 검출하는 딥러닝 네트워크를 개발하기 위해서는 데이터셋 구축이 선행되어야 한다. 일반적으로 특정 지역에 도로 인프라 센서를 설치하여 데이터셋을 획득되고 공개하고 있지만 네트워크의 성능 향상 및 강인성 제고를 위해서는 데이터의 다양성 확대(Scalability)가 필요로 하며 궁극적으로 도로 인프라 센서의 설치 지역의 확대가 필요해진다. 또 다른 접근 방법으로는 학습 데이터를 가상으로 증강(Data augmentation)하는 기술이 연구되고 있다. 예를 들어서, 도로 인프라 센서로 탑재된 라이다 센서 기반 차량 검출 알고리즘을 위한 학습 데이터 내 차량의 위치 분포가 편향되지 않도록 라이다 포인트 클라우드와 라벨링 된 차량 정보를 회전(Rotation)하거나 무작위 이동(Random translation) 기술을 적용하여 성능 향상을 시켰다.17) 또 다른 방법으로 실제 센서로 획득한 데이터 중 배경을 제외하고 주변 객체들을 제거한 후 가상의 동적 객체(차량, 보행자 등)를 랜덤하게 배치하여 데이터를 증강시키는 기술도 있다.18)

본 연구에서는 도로 인프라 센서를 기반으로 한 공개데이터셋을 이용하여 다중 차량에 대한 차선 변경 거동 검출을 위한 데이터셋을 구성한다. 다음으로 CNN을 적용하여 차선 변경 거동 검출을 위한 가능성을 확인한다. 마지막으로 제한된 데이터셋을 도로 환경을 고려할 수 있는 데이터셋으로 확대할 수 있는 데이터 증강 방법을 제안하고자 한다. 실도로 주행데이터를 도로 인프라 센서를 기반으로 획득한 데이터로 모사하는 데이터 증강 방법을 이용하기에 두 데이터셋 간의 불확실성이나 센서 특성이 다를 수 있는 한계점을 미리 언급하고자 한다. 따라서 본 연구에서는 CNN기반 차선 변경 거동 검출 알고리즘의 강인성과 확장성을 확인해보자 한다. 즉, 도로 형상의 변화와 주변 차량의 움직임의 다양성이 확장되는 데이터셋에 대해서 딥러닝 기반 차선 변경 거동 검출 알고리즘의 성능에 미치는 영향을 살펴보고자 한다.

2. 차선 변경 거동 검출

2.1 차선 변경의 정의 및 라벨링

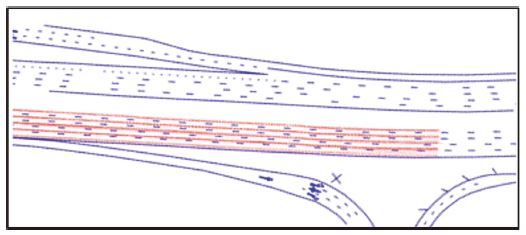

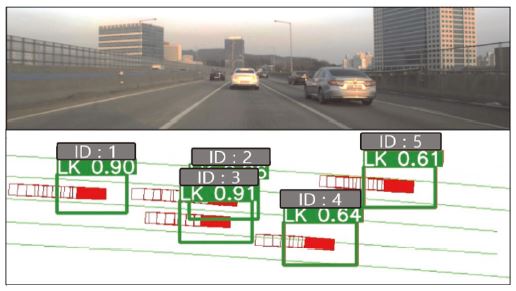

도로 인프라 센서를 사용하여 고속도로 주행 시 차선 변경 거동 검출 연구를 위한 대표적인 공개 데이터셋으로 독일의 highD, 미국의 NGSIM US Route 101(US-101) 데이터가 널리 알려져 있다.7) Table 1에서 두 데이터셋을 비교하고 있으며 highD의 경우 드론을 사용하여 서로 다른 60개 지점의 도로에 대하여 16.5시간 동안의 시계열 데이터로 이루어져 있다.19) 400 ~ 420 m 정도 길이의 직선 도로를 측정범위로 정하고 각 차량 별 ID, 종방향 위치(x), 횡방향 위치(y), 종방향 속도(υx), 횡방향 속도(υy), 차량의 길이와 폭(Width, height), 차량이 위치하는 차선 ID, 차선의 횡방향 위치 등의 정보를 포함하고 있다. Fig. 1은 highD 데이터셋의 특정 시간에 다섯 대 차량에 대한 차량 별 ID와 해당 차량의 길이와 폭을 반영하여 사각형의 형태로 도로 이미지 상에 투영하여 보여주고 있다.

미국 교통부에서 US-101 근방의 고층 빌딩의 카메라들을 동기화 하여 획득된 데이터를 활용하여 만든 NGSIM US-101 또한 highD와 동일하게 시계열 데이터를 제공하고 있다.20) 교통류 분석을 위해 생성된 데이터셋으로 Fig. 2와 같이 500 ~ 640 m 길이의 차선에 대하여 위 highD 데이터셋에서 언급된 정보뿐만 아니라 도로 정보(shp 파일 형태)를 제공하여 차선에 대한 정보를 확인할 수 있다. 본 논문에서는 우선 Table 1 내 주행 거리(Driven distance)가 큰 highD 데이터셋을 선정하여 차선 변경 거동에 대해서 라벨링을 진행하였다.

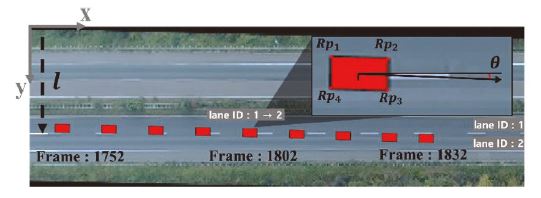

네트워크 학습 및 평가를 위한 라벨링을 위해서는 차선 변경의 정의가 필요하며 차선과의 횡방향 위치만 기준으로 차선 변경의 시작과 끝을 정의할 수 있지만21,22) 헤딩각(Heading angle) 정보도 추가적으로 사용하여 차선 변경이 시작되는 시점과 종료 시점을 좀 더 정확하게 정의하고자 한다.23) 예를 들어서, Fig. 1 내 차량 ID 1번의 경우 과거 시계열 데이터를 살펴보면 Fig. 3에서 보는 바와 같이 1차선에서 2차선으로 차선 변경이 이루어졌음을 알 수 있고 이에 해당하는 정보를 highD에서는 차선(Lane) ID로 명기되어 있어서 차선 ID의 변경 여부를 이용하여 차선 변경 여부를 확인할 수 있다. 즉, Fig. 3의 경우 차량 ID 1번이 1,802 frame에 Lane ID가 1번에서 2번으로 변경되며 이를 기준으로 차선변경이 있음을 선정할 수 있다.

다음으로 차선 변경의 시작 시점과 종료시점을 정의하고자 하며 우선 헤딩각을 주어진 좌표축 정의에 따라 속도 벡터를 사용하여 다음과 같이 헤딩각(θ)을 추정하였다.24)

| (1) |

여기서 vx와 vy는 종⋅횡방향 속도를 각각 뜻한다. 이렇게 추정된 헤딩각을 이용하여 식 (2)와 같이 회전된 차량에 해당하는 사각형의 4 꼭짓점을 계산할 수 있다(Fig. 3의 우측 상단 그림 참조).

| (2) |

여기서 R은 회전 행렬, pi는 차량에 해당하는 사각형의 4개 꼭짓점 좌표를 뜻한다. 마지막으로 차선변경 시점을 기준으로 특정 차선의 횡방향 값(Fig. 3의 l참조)과 사각형의 꼭짓점이 처음으로 교차하는 시점부터 마지막에 교차하는 시점을 차선변경의 처음과 종료 시점으로 정의한다. Fig. 3의 경우 1,752 frame과 1,832 frame을 차선 변경 구간으로 추출하여 라벨링을 진행하였다.

2.2 차선변경 검출을 위한 학습데이터셋

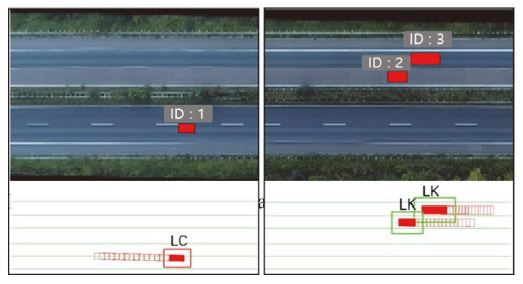

차선변경 검출을 위한 알고리즘은 크게 관심영역(Region of interest, ROI)에 따라 상면도(Bird`s eye view)형태로 차량과 도로 형상을 표시하는 Semantic map과 CNN을 기반으로 차선변경의 거동 구분(Maneuver classification)으로 구성되어 있다. 관심영역 설정과 Semantic map의 구성은 알고리즘 및 학습과 밀접한 관계를 가지고 있다. 우선 ROI의 설정은 차량과 도로를 형상화하는 Semantic map의 해상도(Resolution)를 결정한다. highD 데이터의 경우 도로 종방향 길이(400 ~ 420 m) 모두 포함하도록 이미지를 생성할 경우 차량에 해당하는 사각형의 픽셀 사이즈가 너무 작아져 거동 구분 성능에 영향이 있다.25) 따라서 문헌의 방법을 참고하여 횡방향을 40 m로 선정하고 종방향의 경우 80 m로 분할하였다.26,27)

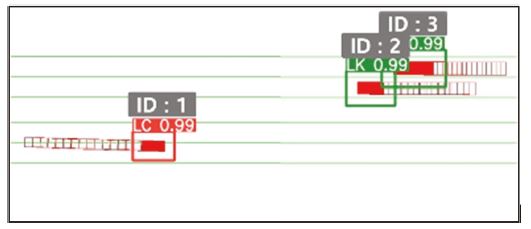

다음으로 네트워크의 입력으로 사용되는 Semantic map의 경우 RGB채널을 이용하여 구성하였다. ROI 설정 비율에 맞춰 입력 이미지의 크기를 400×800 픽셀로 구성하여 해상도를 0.1(m/pixel)로 설정하였다. Fig. 4의 하단 그림과 같이 분할된 ROI 내에 차량에 해당하는 크기의 사각형(빨간색 또는 R채널)으로 표시한다. 도로 형상의 경우 녹색선(G채널)으로 표시하며 차량의 과거 주행 궤적을 포함시키기 위하여 현재부터 이전 15 frame까지 해당하는 차량 궤적(그림 내 빨간색 사각형 실선 참조)을 추가한다. 또한, 각 차량 ID마다 거동(Maneuver) 라벨링에 해당하는 차선 유지(Lane-keeping, LK)와 차선 변경(Lane change, LC)으로 구분하여 명기되어 있음을 알 수 있다. 최종적으로 Table 1과 같이 주어진 highD 데이터셋 중 학습데이터로 Fig. 4의 좌측 그림과 같이 전체 도로 중 0 ~ 80 m에 해당하는 영역을 선정하였으며 해당 영역에서 총 2,609번의 차선 변경이 발생하였다. 위에서 정의된 차선 변경의 시작과 종료 시점을 고려하여 총 131,846 frame의 데이터를 추출하였으며 학습데이터로는 그 중 50 %에 해당하는 65,923장의 Semantic map을 선정하였다.

2.3 CNN기반 차선변경 거동 검출 및 검증

차선 변경 거동 검출 알고리즘은 우선 위에서 언급한 바와 같이 여러 장의 Semantic map을 생성하고 이를 사용하여 CNN 기반 차선 변경 거동 구분(Maneuver classification)을 수행하게 된다. CNN으로 YOLOv5s을 사용하였으며 YOLOv5는 기존 YOLO의 백본인 DarkNet에서 CSP-DarkNet으로 변경되었으며 정확도 및 검출 속도가 향상된 모델로 알려져 있다.28) YOLOv5에는 YOLOv5s, YOLOv5m, YOLOv5l, YOLOv5x으로 구분되어 있으며 이는 필터 크기, 특징 추출 모듈의 차이가 있다.29) 이 중 실시간 속도가 가장 빠르고 성능이 상대적으로 높은 YOLOv5s을 선정하였다.

위에서 선정된 학습 데이터에 대해서 Ubuntu 18.04, nvidia RTX A6000를 기반으로 약 25시간 동안 100 epoch의 학습을 진행하였다. Table 2의 (a)는 학습데이터를 제외한 50 %의 Validation 데이터셋에 대한 평가 결과이며 차선 유지에 대한 정확도는 99 %, 차선 변경에 대한 정확도는 98 %이다.

평가 데이터셋의 경우 60개의 도로 중 첫번째 도로의 400 m를 5개의 80 m 영역으로 분할하여 총 19,445장의 Semantic map을 생성하였다. Table 2의 (b)에는 평가 데이터셋에 대한 결과이며 학습 결과와 비해 차선 유지의 경우 2 %, 차선 변경의 경우 1 % 성능이 하락한 것을 볼 수 있다.

Fig. 5에서는 80 m로 분할된 영역 중 차량 ID 1번에 대하여 차선 변경을 검출한 모습을 볼 수 있으며 2번, 3번 차량에 대해서도 차선 유지를 검출한 모습을 확인할 수 있다.

3. 도로 인프라 센서 데이터 증강

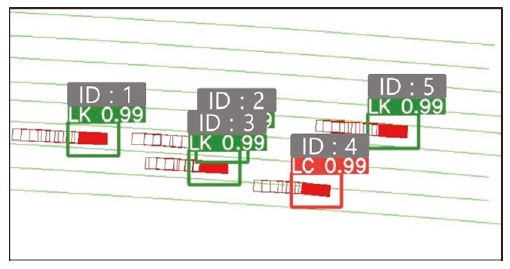

Fig. 1이나 Fig. 5에서 보는 바와 같이 highD 데이터셋 60개 지점의 서로 다른 도로에서 획득한 데이터를 포함하고 있음에도 불구하고 거의 직선에 가까운 도로 환경만을 고려하고 있다. 따라서, Fig. 6에서 보는 바와 같이 2장에서 학습된 차선변경 거동 판단 알고리즘이 곡선 구간에서 오판단하는 경우가 발생할 수 있다. Fig. 6의 데이터는 도로 인프라 센서를 이용하여 측정한 데이터가 아니고 실도로 주행 테스트(Field operational test, FOT)를 통해서 획득된 데이터 일부를 Semantic map으로 구성한 것이다. 즉, 차량 ID 1번이 환경 센서가 장착된 자차량에 해당하고 주변 차량의 인지결과를 지도에 투영을 해서 보여주고 있다. 이러한 데이터를 차선변경 검출 네트워크에 주입했을 경우 차량 ID 4번의 차선 변경(LC)을 차선 유지(LK)로 오판단하고 있다. 이러한 성능저하 원인 중 하나로 학습 단계에서 곡선로에 대한 데이터가 충분히 추가되어 있지 않기 때문이라는 추론이 가능하다. 본 절에서는 CNN기반 차선변경 거동 알고리즘의 확장성을 확인하기 위하여 다양한 도로 형태나 차량의 움직임을 포함하고 있는 실도로 주행 데이터를 도로 인프라 센서기반 데이터셋으로 증강(Augmentation)하는 방법에 대해서 소개를 하고자 한다.

3.1 다중 차량 생성

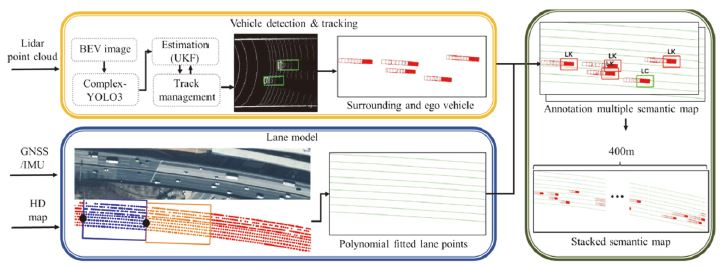

Fig. 7에서 보는 바와 같이 라이다(Lidar), GNSS/IMU가 탑재된 실차를 이용하여 실 도로 주행 데이터를 획득하고 라이다 센서 기반 차량 검출 및 추적 알고리즘을 사용하여 주변 차량들에 대한 정보를 생성한다. 병렬적으로 정밀도로지도(HD map 또는 Fig. 2의 shp 파일 참고)와 차량의 GNSS/IMU 데이터를 활용하여 현재 위치에 해당하는 차선 정보를 점(Point)형태로 추출한다. 그 후, ROI 내의 자차, 주변 차량, 차선의 점 정보를 도로 기준 좌표계로 좌표 변환하여 차선 정보(Lane model)를 생성한다. 마지막으로 주변 차량과 차선 정보를 이용하여 Semantic map을 생성하고 이를 합성(Stacked semantic map)하여 400 m 도로가 포함된 이미지로 생성한다.

다중 차량을 생성하기 위해 Fig. 7의 라이다 기반 차량 검출(Vehicle detection)은 라이다 정보를 2차원 이미지로 표현하여 접근하는 딥러닝 기법 중 하나인 Complex-YOLOv3를 선정하였다. 본 알고리즘의 작동 원리는 3차원의 포인트 클라우드를 RGB 채널의 이미지로 처리한 후 백본인 YOLOv3을 이용하여 차량을 검출한다.26) 네트워크 학습은 공개 데이터셋인 PandaSet과 실도로 주행 데이터를 혼합하여 Fine tuning 방법을 이용하여 학습 및 성능 평가를 진행하였다.30,31)

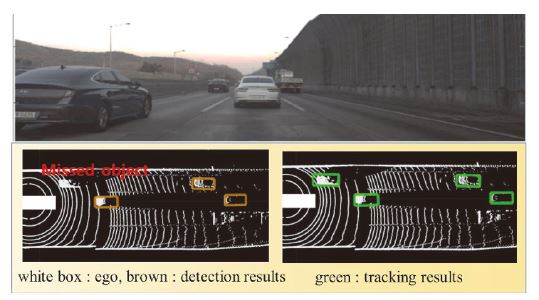

다음으로 차량 검출 결과에 물체 추적(Tracking) 기법을 적용하였으며 이를 통하여 차량의 위치, 속도 및 방향각을 비선형 모델을 이용하여 추정함으로써 검출 결과를 보정 및 안정화하였다. 추적 기법으로는 비선형 모델인 Unscented Kalman filter를 이용하여 상태 값과 공분산에 대해 예측을 하고 입력으로 들어오는 측정치를 기반으로 상태 값과 공분산을 보정한다.32) 이 때 표적 관리(Track management)를 이용하여 표적의 생성, 유지 및 삭제를 관리한다. 예를 들어서, Fig. 8에서는 차량 추적(Vehicle tracking) 알고리즘을 이용하여 좌측 하단 그림과 같이 전방 좌측의 미검출(Missed detection) 차량을 인식(Fig. 8 우측 하단 그림 참조)하여 결과가 안정화 되고 있음을 보여주고 있다.

3.2 도로 및 차선 정보 생성

다중 차량이 주행하는 도로 정보, 즉 정밀지도를 획득하기 위하여 국토지리정보원에서 제공하는 정밀도로지도(shp 파일)를 사용하였다.33) Fig. 7 하단 과정은 Fig. 2와 같이 shp 파일을 통해 차선 정보를 추출하였으며 빨간, 파란, 주황색 점들과 같이 차선에 대한 정보를 점(Point)형태로 GPS 좌표와 함께 제공을 하며 데이터 획득 차량(즉, 자차량)의 GNSS/IMU에서 획득된 위치를 사용하여 차량 주변의 차선 점(Point)정보를 추출할 수 있다. Fig. 7의 하단 그림에서 검은색 포인트가 자차의 출발점이 되며 이를 기준으로 ROI(80×40 m)를 설정함을 보여주며(그림 내 파란색 박스 참조) 더 나아가 ROI내 차선 점 정보를 2차 다항식으로 곡선 피팅(Curve fitting)하여 차선 정보를 표출하고 있다.34) 또한 GNSS/IMU의 경우 칼만필터를 이용하여 위치가 보정이 된 값을 사용하였으며 주어진 ROI를 벗어나는 경우 새로운 ROI를 설정할 수 있다(Fig. 7의 하단 그림 중 주황색 박스 참조).

3.3 증강 데이터셋 생성 및 라벨링

생성된 주변 차량과 차선 정보를 이용하여 Fig. 7 우측 상단과 같이 Semantic map을 생성하고 라벨링을 진행하였다. 이 때 획득한 14분의 주행 데이터에 대하여 9,010장의 이미지를 생성을 하였다. 다음은 Fig. 7 우측 하단 그림과 같이 400 m의 도로에서 차량들의 거동을 검출할 수 있도록 ROI로 구분하여 생성된 이미지를 확인할 수 있다. 또한 분할하여 생성된 이미지는 Fig. 7의 우측 하단 그림과 같이 병합하여 400 m 크기의 Stacked semantic map 또한 생성 가능하다.

본 논문에서 총 생성된 데이터의 경우 Table 3과 같이 highD 데이터셋 85,368장은 학습 데이터셋과 평가 데이터 셋을 각각 77 %, 23 %로 구성이 되어있으며, 증강 데이터 9,010장은 학습 데이터셋 50 % 평가데이터 50 %로 구성하였다.

Table 4에서는 highD 데이터셋으로 학습한 알고리즘을 highD 데이터셋과 증강 데이터에 대하여 평가한 결과를 볼 수 있으며 증강 데이터에서의 평균 정확도가 대략 22 % 하락하였기에 곡률이 반영된 증강 데이터에 대한 유효성을 확인할 수 있다.

4. 평가 결과

YOLOv5s 학습에는 Table 5와 같이 단계별로 데이터셋을 구성하여 학습 및 평가를 진행하였다. 첫번째로 65,923장의 highD 데이터로 알고리즘을 학습시킨 파라미터(Table 5의 Number 1), 두번째로 highD 데이터셋으로 학습된 알고리즘에 Fine-tuning을 통하여 추가적으로 4,505장의 증강 데이터셋을 학습한 파라미터(Table 5의 Number 2), 세번째로 동일하게 Fine-tuning으로 진행하되 문헌을 참고하여 증강 데이터셋과 같은 비율로 highD 데이터를 혼합하여 Fine-tuning 진행한31) 파라미터(Table 5의 Number 3)의 성능 비교하였다.

Experimental results according to different test set. Aug indicates augmented data, highD indicates highD dataset

3개의 파라미터에 대한 비교에 사용되는 평가 지표로는 딥러닝 기반 분류에 보편적으로 사용되는 평균 정확도(Accuracy)와 F1 score 그리고 차선 변경 정확도를 사용하였다. 실제 주행 상황에서는 차선 변경 보다는 차선 유지를 하는 상황이 많기 때문에 라벨의 불균형이 발생하며 이에 따라 F1 score과 차선 변경 정확도를 사용하여 성능을 비교하였다.35)

highD 데이터셋에서의 평가는 highD 데이터셋만 학습한 첫번째 파라미터(Number 1)가 highD와 특성이 다른 증강 데이터를 추가 학습한 두번째 파라미터(Number 2)보다 성능이 높을 것으로 예상할 수 있다. Table 5의 평균 정확도인 Aaυg를 보면 두번째 파라미터가 첫번째 파라미터보다 0.3 % 높지만, F1 score인 F1aυg는 11 %, 차선 변경 정확도인 Alc는 31 %로 첫번째 파라미터가 높기에 첫번째 파라미터의 성능이 높다고 판단할 수 있다. highD 데이터와 증강데이터를 모두 사용하여 Fine-tuning을 진행한 세번째 파라미터(Number 3)의 경우 Fine-tuning에 highD 데이터가 포함되어 있기에 두번째 파라미터 대비 F1 score과 차선 변경 정확도인 Alc가 모두 높은 것을 확인할 수 있다.

증강 데이터셋 평가 결과의 경우 증강 데이터를 Fine-tuning에 포함한 두번째와 세번째 파라미터가 다양한 도로 형상 데이터에 대하여 학습하지 않은 첫번째 파라미터보다 높은 성능을 나타낼 것을 예상할 수 있다. 두번째, 세번째 파라미터 모두 평균 정확도와 F1 score 그리고 차선 변경 정확도가 97 %가 넘는 수치임을 확인할 수 있으며 첫번째 파라미터는 평균 정확도 F1 score 그리고 차선 변경 정확도가 highD 데이터셋의 평가 결과 대비 대략 20 % 하락한 것을 볼 수 있다. highD와 증강 데이터를 모두 Fine-tuning한 파라미터는 highD 데이터셋과 증강 데이터셋에서 모든 평가 지표가 96 %가 넘는 성능을 나타낸다. Fig. 9는 증강 데이터에 대한 세번째 알고리즘의 검출 결과로서 Fig. 6에서 오판단되는 4번 차량 대한 차선 변경이 오판단 없이 진행된 모습을 볼 수 있다.

5. 결 론

본 연구에서는 도로 인프라 센서 기반 차선 변경 거동 검출 모델과 실도로 주행 데이터 기반 인프라 센서 관점에서의 데이터 증강 방법론에 대하여 살펴보았다. 공개 데이터 셋인 highD를 사용하여 Semantic map을 구성하고 CNN 기반 알고리즘을 사용하여 차선 변경 거동 검출 모델의 가능성을 확인하였다. 또한 실도로 주행데이터를 이용한 데이터 증강 기법을 통하여 다양한 도로 형상이 포함된 데이터를 생성하였으며 해당 데이터에 대한 학습 및 평가를 통해 알고리즘의 확장성을 확인하고 도로 형상 변화에 대한 강인성을 증가하였다. 향후에는 LSTM과 같은 궤적 예측 알고리즘을 통한 Semantic map 고도화 및 실도로 주행 데이터의 확대를 통하여 고속도로뿐만이 아닌 교차로, 합류로 등의 더 많은 도로 형태에 대한 확장성 및 강인성을 확인 및 개선 하고자 한다.

Acknowledgments

본 연구는 국토교통부/국토교통과학기술진흥원의 지원으로 수행되었음(과제번호 RS-2022-00142565).

References

-

N. Lu, N. Cheng, N. Zhang, X. Shen and J. W. Mark, “Connected Vehicles: Solutions and Challenges,” IEEE Internet Things, Vol.1, No.4, pp.289-299, 2014.

[https://doi.org/10.1109/JIOT.2014.2327587]

-

M. Tsukada, T. Oi, M. Kitazawa and H. Esaki, “Networked Roadside Perception Units for Autonomous Driving,” Sensors, Vol.20, No.18, Paper No.5320, 2020.

[https://doi.org/10.3390/s20185320]

-

Y. Cui, H. Xu, J. Wu, Y. Sun and J. Zhao, “Automatic Vehicle Tracking with Roadside LiDAR Data for the Connected-Vehicles System,” IEEE Intelligent Systems, Vol.34, No.3, pp.44-51, 2019.

[https://doi.org/10.1109/MIS.2019.2918115]

-

R. Ojala, J. V. Ainen, J. Hanhirova, V. Hirvisalo and K. Tammi, “Novel Convolutional Neural Network-based Roadside Unit for Accurate Pedestrian Localization,” IEEE Transactions on Intelligent Transportation Systems, Vol.21, No.9, pp.3756-3765, 2020.

[https://doi.org/10.1109/TITS.2019.2932802]

-

J. Zhao, Y. Li, H. Xu and H. Liu, “Probabilistic Prediction of Pedestrian Crossing Intention Using Roadside LiDAR Data,” IEEE Access, Vol.7, pp. 93781-93790, 2019.

[https://doi.org/10.1109/ACCESS.2019.2927889]

-

R. Izquierdo, A. Quintanar, I. Parra, D. Fernández-Llorca and M. A. Sotelo, “Vehicle Trajectory Prediction in Crowded Highway Scenarios Using Bird Eye View Representations and CNNs,” IEEE 23rd International Conference on Intelligent Transportation Systems, pp.1-6, 2020.

[https://doi.org/10.1109/ITSC45102.2020.9294732]

-

R. Song and B. Li, “Surrounding Vehicles’ Lane Change Maneuver Prediction and Detection for Intelligent Vehicles: A Comprehensive Review,” IEEE Transactions on Intelligent Transportation Systems, Vol.23, No.7, pp.1-17, 2021.

[https://doi.org/10.1109/TITS.2021.3076164]

-

R. S. Tomar, S. Verma and G. S. Tomar, “Prediction of Lane Change Trajectories through Neural Network,” International Conference on Computational Intelligence and Communication Networks, pp.249-253, 2010.

[https://doi.org/10.1109/CICN.2010.59]

-

S. Yoon and D. Kum, “The Multilayer Perceptron Approach to Lateral Motion Prediction of Surrounding Vehicles for Autonomous Vehicles,” IEEE Intelligent Vehicles Symposium, pp.1307-1312, 2016.

[https://doi.org/10.1109/IVS.2016.7535559]

- S. Su, K. Muelling, J. Dolan, P. Palanisamy and P. Mudalige, “Learning Vehicle Surrounding-aware Lane-changing Behavior from Observed Trajectories,” IEEE Intelligent Vehicles Symposium, pp.1412-1417, 2018.

-

N. Deo and M. M. Trivedi, “Multi-Modal Trajectory Prediction of Surrounding Vehicles with Maneuver Based LSTMs,” IEEE Intelligent Vehicles Symposium, pp.1179-1184, 2018.

[https://doi.org/10.1109/IVS.2018.8500493]

-

D. Lee, Y. P. Kwon, S. McMains and J. K. Hedrick, “Convolution Neural Network-based Lane Change Intention Prediction of Surrounding Vehicles for ACC,” IEEE 20th International Conference on Intelligent Transportation Systems, pp.1-6, 2017.

[https://doi.org/10.1109/ITSC.2017.8317874]

- Z. S. Nejad, H. Heravi, A. R. Jounghani, A. Shahrezaie and A. Ebrahimi, “Vehicle Trajectory Prediction in Top-View Image Sequences Based on Deep Learning Method,” arXiv preprint arXiv:2102.01749, , 2021.

-

V. Mahajan, C. Katrakazas and C. Antoniou, “Prediction of Lane-Changing Maneuvers with Automatic Labeling and Deep Learning,” Transportation Research Record, Vol.2674, No.7, pp.336-347, 2020.

[https://doi.org/10.1177/0361198120922210]

-

Y. Cui, J. Wu, H. Xu and A. Wang, “Lane Change Identification and Prediction with Road-Side LiDAR Data,” Optics & Laser Technology, Vol.123, 2020.

[https://doi.org/10.1016/j.optlastec.2019.105934]

-

L. Du, W. Chen, J. Ji, Z. Pei, B. Tong and H. Zheng, “A Novel Intelligent Approach to Lane-Change Behavior Prediction for Intelligent and Connected Vehicles,” Computational Intelligence and Neuroscience, Vol.2022, 2022.

[https://doi.org/10.1155/2022/9516218]

-

S. Zhou, H. Xu, G. Zhang, T. Ma and Y. Yang, “Leveraging Deep Convolutional Neural Networks Pre-Trained on Autonomous Driving Data for Vehicle Detection From Roadside LiDAR Data,” IEEE Transactions on Intelligent Transportation Systems, 2022.

[https://doi.org/10.1109/TITS.2022.3183889]

-

J. Fang, D. Zhou, F. Yan, T. Zhao, F. Zhang, Y. Ma and R. Yang, “Augmented Lidar Simulator for Autonomous Driving,” IEEE Robotics and Automation Letters, Vol.5, No.2, pp.1931-1938, 2020.

[https://doi.org/10.1109/LRA.2020.2969927]

-

R. Krajewski, J. Bock, L. Kloeker and L. Eckstein, “The highD Dataset: A Drone Dataset of Naturalistic Vehicle Trajectories on German Highways for Validation of Highly Automated Driving Systems,” 21st International Conference on Intelligent Transportation Systems, pp.2118-2125, 2018.

[https://doi.org/10.1109/ITSC.2018.8569552]

- J. Colyar and J. Halkias, NGSIM, US Highway 101 Dataset, https://www.fhwa.dot.gov/publications/research/operations/07030/030,2022.

- J. D. Chovan, L. Tijerina, G. Alexander and D. L. Hendricks, “Examination of Lane Changes Crashed and Potential IVHS Countermeasures. Final Report,” Report DOT-VNTSC-NHTSA-93-2, NHYSA. U.S. Department of Transportation, 1994.

-

T. Toledo and D. Zohar, “Modeling Duration of Lane Changes,” Transportation Research Record. pp.71-78, 2007.

[https://doi.org/10.3141/1999-08]

- R. D. Worrall and A. G. R. Bullen, “An Empirical Analysis of Lane Changing on Multi-Lane Highways,”Highway Research Board, Vol.303, pp.30-43, 1970.

-

W. Liu, R. Duan and F Zhu, “A Robust Cascaded Strategy of In-Motion Alignment for Inertial Navigation Systems,” International Journal of Distributed Sensor Networks, Vol.13, No.9, 2017.

[https://doi.org/10.1177/1550147717732919]

- V. Etten and Adam, “You Only Look Twice: Rapid Multi-Scale Object Detection in Satellite Imagery,” ArXiv, Vol.1805, No.09512, 2018.

-

M. Simony, S. Milz, K. Amende and H. Gross, “Complex-Yolo: An Euler-Region-Proposal for Real-time 3D Object Detection on Point Clouds,” IEEE International Conference on Computer Vision and Pattern Recognition, pp.197-209, 2018.

[https://doi.org/10.1007/978-3-030-11009-3_11]

-

B. Yan, P. Fan, X. Lei, Z. Liu and F. Yang, “A Real-Time Apple Targets Detection Method for Picking Robot Based on Improved YOLOv5.” Remote Sensing, Vol.13, pp.16-19, 2021.

[https://doi.org/10.3390/rs13091619]

-

D. Xudong, S. Yan and C. Duan, “A Lightweight Vehicles Detection Network Model Based on YOLOv5,” Engineering Applications of Artificial Intelligence, 2022.

[https://doi.org/10.1016/j.engappai.2022.104914]

-

Z. Chen, L. Cao and Q. Wang, “YOLOv5-Based Vehicle Detection Method for High-Resolution UAV Images.” Mobile Information Systems, 2022.

[https://doi.org/10.1155/2022/1828848]

- Pandaset, Introducing PandaSet by Hesai and Scale AI, https://pandaset.org, /, 2022.

-

Y. B. Kim, T. H. Lee and B. S. Song, “Training and Performance Analysis of Vehicle Detection Neural Networks to Field Test and Simulation Datasets of Multi-channel Lidar,” Transactions of the KSAE, Vol.29, No.12, pp.1123-1132, 2021.

[https://doi.org/10.7467/KSAE.2021.29.12.1123]

-

S. J. Julier and J. K. Uhlmann, “Unscented Filtering and Nonlinear Estimation,” Proceedings of the IEEE, Vol.92, No.3, pp.401-422, 2004.

[https://doi.org/10.1109/JPROC.2003.823141]

- National Geographic Information Institute, https://www.ngii.go.kr/kor/main.do, /, 2022.

-

H. Akima, “A New Method of Interpolation and Smooth Curve Fitting Based on Local Procedures,” Journal of the ACM, Vol.17, No.4, 1970.

[https://doi.org/10.1145/321607.321609]

-

M. Krüger, A. S. Novo, T. Nattermann, M. Mohamed and T. Bertram, “Reducing Noise in Label Annotation: A Lane Change Prediction Case Study,” IFAC-PapersOnLine, Vol.52, No.8, pp.221-226, 2019.

[https://doi.org/10.1016/j.ifacol.2019.08.074]