자율주행 기술 동향 및 발전 방향: AI를 중심으로

Copyright Ⓒ 2022 KSAE / 203-06

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Autonomous driving is not a new concept, and relevant technology has been developed for a long time. However, in recent years, autonomous driving technology has been leaping forward, fueled by the advance of AI-based technologies. In particular, the essential components of autonomous driving, such as perception, prediction, and planning, deliver entirely different performances from those of the pre-AI era. In this study, the trends and development of autonomous driving technology will be analyzed by decomposing it into element technologies ranging from perception, prediction, and planning, focusing on AI-based research. For the perception part, LiDAR and camera-based research and sensor fusion technologies will be examined. For the prediction part, we will look into various prediction paradigms such as interaction-aware and map-based prediction. The planning part will cover maneuver decisions, motion planning, and reinforcement learning-based methods.

Keywords:

Autonomous vehicle, Architecture, Artificial intelligence, Decision and planning, Perception, Prediction키워드:

자율주행 자동차, 아키텍처, 인공지능, 판단 및 경로생성, 인지, 예측1. 서 론

인공지능 기술은 무한한 가능성과 빠른 발전을 통해 다양한 산업에 적용되어 두각을 나타내고 있다. 대표적인 산업으로 자율주행 자동차를 빼놓을 수 없다. 자율주행 자동차는 다양한 센서를 기반으로 인지, 예측, 판단 및 경로생성 등의 알고리즘을 활용하여 운전자를 대체하고자 하는 인공지능 알고리즘의 집약체라고 할 수 있다.

자동차 분야에서 기존의 규칙 기반의 기술을 인공지능 기술로 대체함으로써 주행 도중 발생할 수 있는 무수히 많은 상황에 대한 적절한 대처가 가능해지고 있다. 자율주행 자동차를 위한 인공지능 기술은 특정 기술에 한정되지 않고 인지, 예측, 판단의 모든 분야에서 활용되고 있으며 자율주행 기술의 성능을 비약적으로 발전시키고 있다. 특히 딥러닝을 활용한 자율주행 기술들이 많이 개발되고 있으며, 일례로 미국의 테슬라에서는 Tesla AI Day를 통해 테슬라 자동차에 적용중인 다양한 딥러닝 기술 및 아키텍처를 공개하였다. 이에 따라 딥러닝에 필수적인 주행 데이터셋 또한 지속적으로 수집 및 공개되고 있다. nuScenes에서는 인지 및 예측 알고리즘 개발을 위한 다중 센서 기반 주행 데이터셋을 공개하여 많은 연구진이 사용중이며, 경로 계획 및 판단을 위한 데이터셋 또한 공개할 예정이다.1,2) 뿐만 아니라 Waymo, Lyft, Argoverse 등 다양한 데이터셋이 수집되고 공개되어있다.3-5) 이와 같이 다양한 학습데이터의 공개로 인지, 예측, 판단에 걸쳐 활발한 연구가 진행되고 있다.

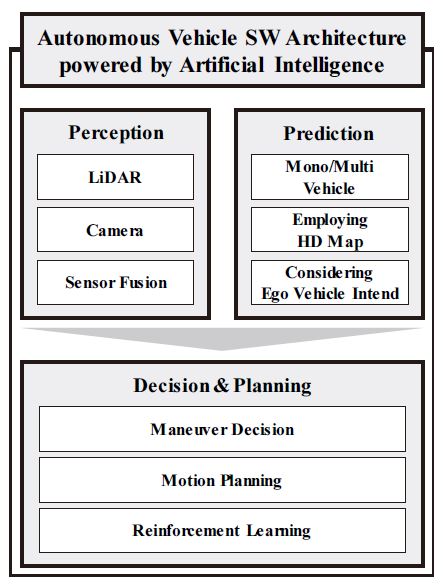

인공지능 기술은 Fig. 1과 같이 인지, 예측, 판단 및 계획 부분에 다양하게 활용되고 있다. 인지 기술은 다양한 차량 주행 환경에서 차량 주변 동적, 정적 객체의 3차원 위치 정보를 취득하기 위해 활용된다. 특히, 인공지능의 발달로 인해 복잡한 환경에서도 뛰어난 객체 검출 성능을 보이고 있으며, 보다 먼 거리의 객체를 환경 변화에 강인하게 검출하기 위한 방법들이 개발되고 있다.

예측 기술은 특히 다수의 자동차 간에 발생하는 이해충돌, 고정밀 지도 정보를 활용한 정밀 예측, 자차량과 주변차량 사이에 발생하는 상호작용 등을 고려하기 위한 인공지능 기술이 개발되고 있다. 이를 통해서 기존의 규칙 기반 접근법에서는 해결할 수 없는 미래에 대한 불확실성, 사람 운전자들 사이의 상호작용 등 고차원적이고 복잡한 문제 해결을 도모하고 있다. 또한 객체뿐만 아니라 도로 환경을 고려하기 위한 딥러닝 아키텍쳐가 개발되고 있으며 이를 통해 자동차 주행환경에 특화되어 고성능, 고신뢰도의 미래 경로 예측 기술이 소개되고 있다.

판단 및 계획 기술의 경우 일반적인 규칙 기반 상황으로 해결할 수 없는 복잡한 상황에 대한 대응에 활용되고 있다. 주행 데이터를 학습하여 활용하기 때문에 사람과 비슷한 거동을 하고 조화롭고 강건하게 활용되는 것들을 볼 수 있다. 하지만 양질의 데이터를 확보해야하는 문제점들이 제기되었으며, 최근에는 강화학습 기반 알고리즘을 통하여 데이터 없이 학습하고 다양한 상황에 대응 가능한 알고리즘이 많이 활용되고 있다.

이 연구에서는 인공지능 알고리즘이 자율주행 자동차 기술에 어떻게 적용되고 있는지를 확인하고 해당 알고리즘이 어느 정도의 성능과 안전성을 가지고 있는지에 대하여 알아본다. 또한 앞으로의 자율주행 기술의 향상을 위하여 보완해야 하는 기술을 확인한다.

2. 인공지능 기반 자율주행 인지 알고리즘

자율주행 기술 중 인지 알고리즘은 자율주행차량 주변의 정적, 동적 객체를 검출하여 주행 경로 상의 장애물을 인식하는 역할을 수행한다. 인지 알고리즘의 성능은 이후 수행되는 미래 예측 및 경로 생성 알고리즘에 크게 영향을 미치게 된다. 따라서 다양한 환경에서 강인하고 정확하게 주변 객체의 위치를 검출하는 것이 매우 중요하다.

2.1 인공지능 인지 알고리즘 동향

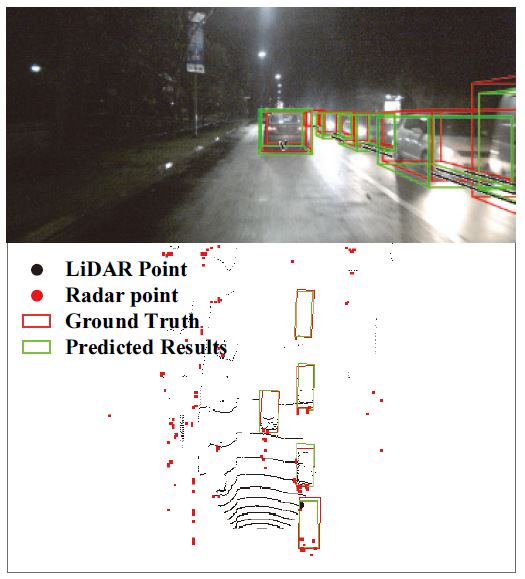

자율주행 환경에서 차량 주변의 장애물을 검출하기 위해 널리 사용되는 센서로는 카메라, 라이다, 레이다 등이 있으며, 각 센서는 동작 원리에 따라 서로 다른 특성을 가지고 있다. 위 센서 중 라이다와 카메라 센서는 인공지능을 이용한 인지 알고리즘에 가장 널리 사용되며, Fig. 2와 같이 단일 센서가 가지는 한계를 극복하기 위한 센서 융합 기반의 인지 방법도 함께 연구되고 있다.

라이다 센서는 다이오드에서 발사된 레이저가 물체에 반사되어 돌아오는 시간을 측정하여 거리를 측정하는 원리를 이용하여 100 m 내외의 먼 위치까지의 거리를 cm의 오차 내에서 정밀하게 측정한다. 특히, 이러한 다이오드를 여러 층으로 쌓아 360도 회전하며 거리를 측정하면 3차원 포인트 클라우드 데이터를 취득할 수 있다. 하지만 이렇게 취득된 3차원 점군 데이터는 점의 분포가 매우 희소하고 순서가 없는 비정형 데이터이기 때문에 영상처리에 널리 사용되는 컨볼루션 뉴럴 네트워크(CNN)을 사용하기에 부적절하므로 이를 해결하기 위한 방법들이 고안되었다.

먼저, 복셀(Voxel) 기반 방법은 비정형의 점군 데이터를 이미지와 같이 정형화된 데이터로 만들기 위해 3차원 공간을 복셀이라 불리는 3차원 격자로 나누어 복셀 내에 점군을 할당한다.6-8) 이후 이미지와 유사한 형태의 복셀에서 3D 혹은 2D 컨볼루션 연산을 통해 조감도(Bird’s eye view, BEV) 좌표계에서 객체를 검출한다.6) 이 때, 희소한 포인트 데이터를 효율적으로 다루기 위해 3D 컨볼루션이 아닌 Sparse 2D 컨볼루션을 이용하거나, 복셀이 아닌 필러(Pillar) 형태의 격자를 이용하는 방법이 소개되었다.7,8)

반면, 연속적인 점군 데이터를 복셀화 하는 과정에서 데이터가 이산화 되며, 점군 사이의 기하학적인 데이터가 소실되는 단점을 개선하기 위해 포인트넷(PointNet)을 이용하는 방법이 제안되었다.9-11) 비정형의 점군 데이터를 복셀화 없이 처리하기 위해 제안된 포인트넷은 점군 데이터의 순열 변화에 불변한 특성을 가지기 때문에 점군 데이터를 직접 입력받을 수 있다. 포인트 기반 방법은 입력 포인트에서 최단점 샘플링을 통해 포인트를 샘플링한 뒤, 샘플 포인트에서 일정 거리만큼 떨어진 주변 포인트들을 그룹화 한 뒤 다중 레이어 퍼셉트론(MLP)를 이용하여 피처를 추출한 뒤 추출된 피처에서 객체를 검출한다.10) 이 때, 샘플 포인트의 개수가 증가함에 따라 연산량이 선형적으로 증가하는 것을 보완하기 위해 물리적인 거리가 아닌 피처 사이의 거리를 이용해 특징이 풍부한 피처를 가진 포인트를 효율적으로 샘플링 하는 방법이 제안되었다.11)

최근 빠른 속도 및 효율성을 갖는 복셀 기반 방법과 기하학적 정보를 효율적으로 추출할 수 있는 포인트 기반 방법의 장점을 결합한 포인트-복셀 기반의 방법 또한 제안되어 높은 객체 검출 성능을 달성하였다.12)

카메라 센서는 직접 레이저를 발사하여 정밀하게 거리를 측정하는 라이다 센서와는 달리 외부 광원에서 반사된 빛의 강도를 측정하여 데이터를 취득한다. 이렇게 취득된 이미지 데이터는 풍부한 시각적, 의미론적 정보를 제공하지만 거리 정보는 제공하지 않기 때문에 객체의 3차원 위치를 검출하는 것은 매우 어려운 문제로 알려져 있다.

최근 인공지능의 발전으로 인해 거리 정보가 소실된 RGB 이미지에서 거리 정보를 예측하는 거리 추정 연구가 활발하게 이루어지고 있다.13) 이에 따라 거리 추정 네트워크를 통해 예측된 뎁스 맵을 입력으로 받아 객체의 3차원 위치 정보를 검출하는 뎁스 맵 기반 방법이 제안되었다. Wang 등14)에서는 카메라 내부 행렬을 이용하여 뎁스 맵의 거리 정보를 3차원 공간으로 역투영시키고, 역투영되어 얻어진 점군 데이터에서 라이다 기반 객체 검출 알고리즘을 사용하여 객체를 검출하는 방법을 제안하였다. Ma 등15)에서는 뎁스 맵을 역투영시키지 않고 이미지 형태로 입력 받는 2D 컨볼루션 뉴럴 네트워크 기반의 기술이 사용되었다. 하지만 뎁스 맵 기반 방법은 거리 추정 네트워크와 객체 검출 네트워크가 순차적으로 동작해야 하기 때문에 동작 속도가 느려 빠른 알고리즘 속도가 요구되는 자율주행 환경에서 사용하기 어려우며, 객체 검출 성능이 거리 추정 성능에 제한되는 단점이 있다.

한편 별도의 거리 추정 네트워크 없이 RGB 이미지를 직접 입력 받아 객체 검출 네트워크와 거리 추정 네트워크를 동시에 학습, 추정하는 이미지 기반 방법 또한 개발되었다. Wang 등16)에서는 2D 객체 검출 네트워크에 객체까지의 거리를 예측하는 서브 네트워크를 추가하여 이미지만을 이용하여 객체 검출이 가능함을 보였고, Park 등17)에서는 위 네트워크가 거리 정보를 더 잘 예측할 수 있도록 많은 데이터를 이용하여 사전학습 한다면 3D 객체 검출을 위한 거리 추정 성능을 크게 향상시킬 수 있음을 보였다.

최근 영상처리 분야에서 트랜스포머 계열의 네트워크가 각광받으면서, 이미지 기반 3D 객체 검출 네트워크에서도 트랜스포머를 활용하려는 시도가 활발히 연구되고 있다. Li 등18)에서는 이미지에서 추출한 피처를 트랜스포머를 이용해 조감도 좌표계로 역투영하여 객체를 검출하는 연구가 진행되었다.

자율주행차량에서 일반적으로 사용되는 라이다, 카메라는 단일 센서로 사용하였을 때 명확한 단점이 존재한다. 라이다 센서는 포인트의 밀도가 거리의 제곱에 반비례하여 감소하므로 검출하려는 객체의 거리가 멀어질수록 포인트가 희소해지고, 객체의 종류를 구별할 수 있는 능력이 부족해진다. 반면, 카메라는 광원이 부족하거나(야간) 시계가 한정적인 상황(눈, 비, 안개 등)에서는 강인하게 동작하기 어려우며, 이미지는 거리 정보를 제공하지 않기 때문에 주변 객체의 거리 측정 성능이 한정적이다. 따라서 이러한 상보적인 특성을 보완하기 위한 센서 융합 기반의 객체 검출 알고리즘이 제안되었다.

초기 카메라-라이다 센서 융합 연구는 주로 라이다 데이터가 매우 넓은 영역에 걸쳐 분포하므로 이미지를 이용하여 라이다 데이터의 관심 영역을 한정시키는 연구가 진행되었다.19) 하지만 라이다 기반 객체 검출 방법이 점차 효율적으로 동작할 수 있도록 개선되고 난 뒤에는 라이다의 부족한 객체 구분 능력을 이미지를 이용해 개선하려는 시도로 발전되었다. Vora 등20)에서는 입력 이미지에서 물체의 종류를 구분하는 의미론적 영상 분할 네트워크를 활용하여 라이다 점군에서 추출된 피처를 보완해주는 방법을 개발하였다. Yin 등21)에서는 라이다 포인트가 거리에 따라 희소해지는 점을 보완하기 위해 이미지를 이용해 라이다 포인트를 보간한 뒤 객체를 검출하는 방법을 제안하였다.

2.2 도전 및 발전 방향

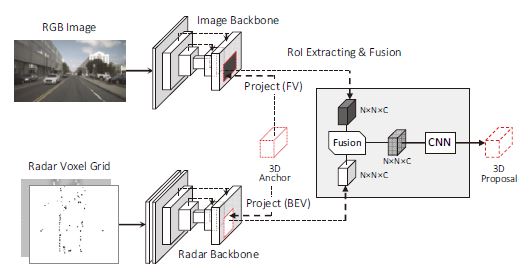

다양한 환경에서 강인하게 객체를 검출하기 위해 다양한 자율주행 인지 알고리즘이 연구되고 있지만 고성능의 객체 검출 시스템을 위해 대다수의 연구가 고가의 라이다 센서를 이용하는 한계가 있다. 따라서 자율주행 기술의 가격, 고장 허용 기능 등을 위해 Fig. 3과 같이 저가의 카메라, 레이더를 이용한 인지 알고리즘 개발이 요구될 것으로 보인다.22) 또한 인공지능 기반 인지 알고리즘을 학습시키기 위해서는 사람이 직접 정답 데이터를 만드는 과정이 요구되는데, 다양한 센서 구성, 주행 환경 등에서 인지 알고리즘이 강인하게 동작할 수 있도록 비지도학습, 능동학습 등의 학습 방법에 대한 연구도 필요하다.

3. 인공지능 기반 자율주행 예측 알고리즘

자율주행 자동차의 주행에 있어서 정확한 미래 주행 상황에 대한 예측은 차량 안전성 및 주행 효율성 측면에서 매우 중요한 역할을 한다. 하지만 수없이 다양한 도로 환경 및 주행 조건에서 발생하는 미래에 대한 불확실성을 충분히 고려한 예측 기술 개발은 어려움이 있다. 따라서 데이터 기반의 인공지능을 활용하여 고도화된 미래 예측 기술이 도입되고 있으며 이에 따라서 양질의 주행 데이터에 대한 중요성도 부각되고 있다.

3.1 인공지능 예측 알고리즘 동향

자율주행을 위한 미래 예측에 있어서 인공지능 기술은 다양한 주행 데이터 셋의 공개와 함께 다양하고 활발하게 개발되어 왔으며 단일차량 예측부터 지도 정보 및 상호작용을 고려한 다차량 예측, 자율주행 자동차의 미래 경로 계획이 고려된 예측 등 주변 환경과의 상호작용이 고려된 예측 기술이 많이 개발되어 왔다. Fig. 4는 도로 형태를 고려하여 차량의 경로를 예측한 결과를 나타낸다.

인공지능의 발전과 함께 자율주행 자동차 주변에 존재하는 자동차의 미래 경로를 예측하는 기술이 활발하게 개발되었다. 초창기에는 비교적 단순한 네트워크를 활용해서 단일 주변 차량에 대한 미래 경로 혹은 주행 의도를 예측하는 기술이 개발되었다.

Lee 등23)에서는 주변 차량의 차선 변경 의도를 예측하기 위해 컨볼루션 뉴럴 네트워크(CNN) 기반의 인공지능 기술이 사용되었다. 이를 통하여 주변 차량의 차선 변경 방향과 감가속에 대한 분류를 학습하여 자차량의 어댑티브 크루즈 컨트롤(ACC) 기능에 활용하기 위해 도입되었다. 이와 비슷하게 Yoon 등24)에서 또한 주변 차량의 미래 경로를 뉴럴 네트워크를 활용하여 예측한 후에 자율주행 자동차의 종방향 움직임을 제어하는 방법론이 개발되었다.

하지만 인공지능 기술 개발이 가속화되고 다수의 주행 데이터가 공개됨에 따라서 단일 차량에 대한 예측뿐만 아니라 고정밀 지도를 활용한 예측 기술, 차량 간 상호작용이 고려된 다차량 예측 기술을 위한 인공지능 기법이 소개되었다.

자율주행 자동차 주변에 존재하는 다수의 차량들에 대한 미래 경로를 예측하는데 있어서 차량 간 상호작용에 대한 고려는 필수적이다. 따라서 CNN, GNN등과 같이 차량과 차량사이의 공간적 특성을 추출할 수 있는 인공지능 기술을 활용한 기술이 개발되었다. 또한 시계열의 과거 경로를 인코딩 하기 위한 순환 신경망(RNN)계열의 인코더가 주로 사용되었다.

Jeon 등25)과 Deo와 Trivedi26)에서는 주변 차량들의 위치를 이미지화한 다채널 점유 그리드 맵을 형성한 후 CNN기반의 네트워크를 활용하여 차량 간 상호작용에 대한 특성을 추출하였으며 시계열의 과거 경로에 대해 장단기 메모리 네트워크(LSTM)를 적용하였다. 반면, Jeon 등27)에서는 주변 차량들의 상태정보 및 상대적 상태정보를 활용하여 그래프를 구성하였으며 GNN기반의 인공지능 기술을 통해 다차량에 대한 동시적 미래 예측 기술을 개발하였다.

하지만 이러한 방법론은 과거에 발생한 차량 간 상호작용만 고려되었기 때문에 예측된 미래에 발생하는 차량 간의 이해 충돌 관계에 대한 분석이 불가능 하다. 또한 자율주행 차량의 미래 경로는 미리 취득할 수 있는 정보이기 때문에 이를 충분히 고려한 미래 예측 기술이 요구된다.

기존의 다른 무인 이동체와 다르게 자율주행 자동차는 도로환경에서 주행한다는 특징이 있다. 도로에는 주변 차량의 미래를 예측하는데 있어서 매우 중요한 정보가 포함되어 있기 때문에 이러한 정보를 활용하는 미래 경로 예측 기술이 개발되었다. 또한 이러한 추세에 따라서 도로환경에 대한 고정밀 지도가 구축되고 있으며 이를 활용하는 방법에 대한 고찰 또한 이루어지고 있다.

일례로 Djuric 등28)과 같이 고정밀 지도를 이미지화하여 활용하는 방법이 연구되었다. 이러한 방법은 고정밀 지도를 이미지처럼 처리하여 CNN을 활용한 네트워크를 활용하여 인코딩한다. 이를 통해서 복잡한 도로 환경을 한 장의 이미지에 포함할 수 있다는 장점이 있다. 하지만 이러한 접근법은 입력 데이터의 크기가 매우 커지고 불필요한 정보가 과도하게 포함되게 된다는 단점이 있다.

반면에 고정밀 지도를 벡터화하여 표현한 후 그래프 뉴럴 네트워크(GNN)을 활용하는 기술도 개발되었다.29) 이러한 고정밀 지도에 대한 벡터화 기법은 표현 방식이 복잡하지만 광역의 지도를 표현하는 데에 있어서 효율적이고 각각의 정보가 정확한 수치적 정보를 포함할 수 있다는 장점이 있다.

주변 차량의 미래 거동 및 경로를 예측하는 데에 있어서 자율주행 차량의 경로 계획은 매우 큰 영향을 미친다. 일례로, 자율주행 자동차가 차선 유지만 할 경우에는 옆 차선의 차량의 거동에도 변화가 없지만 만약 자율주행 자동차가 차선 변경을 시도할 경우 옆차선의 차량의 거동에 변화가 생긴다. 따라서 이러한 자율주행 자동차의 경로 계획과 주변차량의 미래 경로 사이의 상관관계를 통해 예측 성능을 향상시키고자 하는 연구가 진행되었다.

Kim 등30)에서는 어탠션 메커니즘을 기반으로 하여 차량 간 상호작용에 대해 분석하였으며 재귀 구조를 활용하여 미래에 대한 초기 예측 결과를 활용해 최종 예측 결과를 추출하여 미래에서의 상호 의존도를 고려하였다. 반면 Song 등31)과 Tolstaya 등32)에서는 사전에 알 수 있는 자율주행 차량의 미래 경로를 활용한 예측을 진행하였다. Song 등31)에서는 주변 차량의 미래 경로를 예측하는데 있어서 자율주행 자동차의 미래 경로를 활용하는 기술이 개발되었다. 개발된 기술을 두 종류의 데이터셋에서 평가를 진행하였으며 기존 기술들보다 향상된 예측 성능을 확인 할 수 있었다. 추가적으로 Tolstaya 등32)에서는 가우시안 분포를 통하여 주변 차량의 미래 위치를 확률적으로 접근하였으며 가우시안 분포의 파라미터를 추정하는데 있어서 자율주행 차량의 미래 경로를 활용하는 방법을 도입하였다.

이러한 인공지능 기술은 계획된 자율주행 자동차의 미래 경로를 활용하여 주변 차량의 미래 경로를 예측하고 있다. 하지만 궁극적으로는 안전하고 효율적인 주행을 위해서는 예측과 계획이 병렬적으로 융합되어야 한다. 즉, 현재 상태에서 자율주행 자동차가 이동할 수 있는 다수의 미래 경로 후보군에 대해서 각기 다른 미래 주행 상황을 예측하고 이를 통합적으로 평가하여 최적의 경로를 생성하는 접근법이 요구되고 있다.

3.2 도전 및 발전 방향

미래 경로를 예측하는 데에 있어서 주변 환경 및 주변 객체들과의 상호작용을 고려하기 위한 다양한 접근법이 연구되고 있지만 자율주행 시스템을 위한 예측 기술이 아닌 단순히 예측 성능 향상을 위한 연구에 집중되고 있다. 데이터 셋에는 미래에 대한 다양한 경우의 수가 전혀 포함되지 못하며 직진하는 시나리오가 매우 많이 존재하여 다양한 시나리오에 대한 학습이 불가능하다. 즉, 주어진 데이터 셋에 국한된 연구가 진행되고 있으며 데이터 셋에 자연적으로 존재하는 한계점에 대한 고찰이 이루어지지 못하고 있다. 이러한 양상은 실제 수많은 불확실성 속에서 주행하는 자율주행 자동차를 개발하는데 있어서 큰 걸림돌로써 작용하게 된다. 따라서 단순히 주어진 데이터 셋에 의존하는 기술이 아닌 다양한 미래 불 확실성을 고려하여 실제 자율주행 자동차에 적용할 수 있는 기술적 접근이 필요로 하다.

4. 인공지능 기반 자율주행 판단 및 계획 알고리즘

인지와 예측만큼 많은 연구가 진행되고 있는 것은 아니지만, 판단 부분에서도 다양한 인공지능 알고리즘들이 사용되고 있다. ADAS를 포함한 기존의 자동차의 판단 알고리즘에는 대부분 규칙기반 알고리즘이 시나리오별로 구분되어 활용되었다. 하지만 자율주행 기술의 고도화로 대응 시나리오가 복잡해져 감에 따라 일부 인공지능 기술들이 연구되고 있다.

4.1 인공지능 판단 및 계획 알고리즘 동향

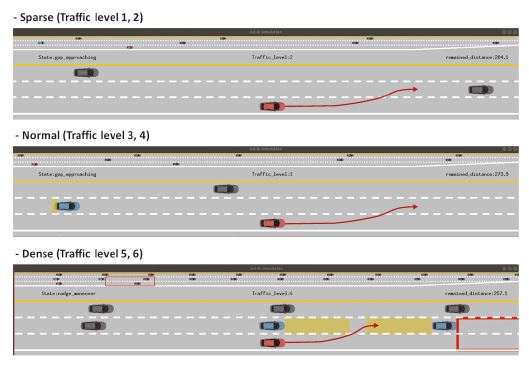

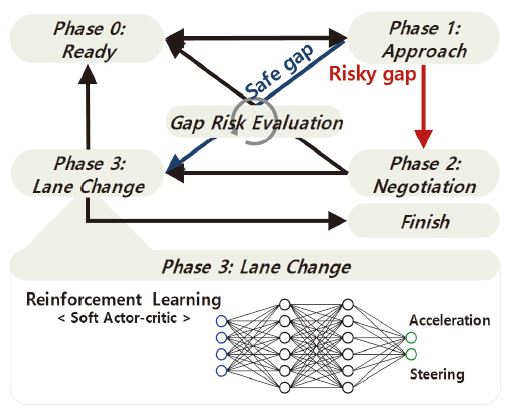

움직임을 결정하는 알고리즘들은 대부분 규칙 기반으로 주어진 시나리오대로 분류되고 정해진 주행 전략에 따라 주행해왔다. 하지만 주행 알고리즘의 고도화로 인하여 차선변경, 충돌회피 등 더 많은 임무가 차량에 주어지며, 자율주행 시스템이 마주하게 되는 다양한 상황을 모두 시나리오로 표현하고 분류하는 것이 불가능해졌다. 따라서 인간의 주행을 모사하기 위하여 주행 데이터를 기반으로 학습한 인공지능 알고리즘들이 연구되었지만 다차량 상황을 모델링 하는 것이 매우 어려웠고, 모든 상황을 고려하여 데이터를 구축하고 학습하는 것은 매우 어려웠다. 최근에는 이와 같은 문제를 해결하기 위하여 모델이 필요 없는 강화학습 알고리즘이 연구되고 있다. Fig. 5는 시뮬레이터를 활용하여 강화학습 기반으로 차선을 변경하는 알고리즘 개발 환경을 나타낸다.

주행 판단을 위해서는 주변의 상황을 먼저 인식 하는 것이 중요하다. 기존의 상황 인식 알고리즘은 전방의 타겟 차량만을 대상으로 하였지만, 복잡한 거동에 전방위 환경 재구축이 중요해졌다. 주변 차량의 인지 및 예측 결과를 기반으로 자차량을 중심으로 하는 장애물지도 또는 위험도 지도를 생성한다.

Schreiber 등33)에서는 주행 전체 환경 구축을 위하여 OGM(Occupancy grid map)을 생성한다. RNN을 사용하여 차량을 추출하고 예측 결과를 기반으로 자율 주행을 위한 주변 환경을 재구성한다. 이를 통하여 주변 환경을 통합적으로 분석이 가능하다. Okamoto 등34)은 예측 결과를 기반으로 위험도 분석을 진행하였으며 전방위에 대한 위험도 지도를 생성한다. Li 등35)은 CNN 알고리즘을 사용하여 차량의 주행 정보를 학습하고, 학습 정보를 기반으로 인간과 비슷한 주행 결정을 내리는 방법을 사용한다. 이를 통하여 자율주행 자동차가 일반 차량들과 혼합되어 주행하는 환경에서 효율적이고 강건하게 주행하는 것을 볼 수 있었다.

인공지능 기반으로 경로와 속도 등 움직임 계획이 가능하다. 인공지능 알고리즘을 이용할 경우 사람과 비슷한 특성을 나타낼 수 있다는 장점이 있다. Wang 등36)은 Fuzzy neural network(FNN)를 기반으로 자율주행 차량의 속도를 계획하였다. 수동 운전 데이터를 기반으로 Fuzzy 알고리즘 기반의 속도 계획을 진행하였으며, 운전자와 비슷한 주행 특성을 가지면서도 승차감과 안정성을 보장할 수 있는 속도를 생성할 수 있었다. Rehder 등37)은 CNN을 기반으로 시뮬레이터와 실제 데이터를 기반으로 사람의 경로생성 방식을 학습하였고, 복잡한 교통 시나리오에서 사람과 비슷한 경로를 생성하는 것을 볼 수 있었다. Chai 등38)에서는 DNN을 사용하여 자동 주차를 위한 알고리즘을 제안하였다. 학습 결과를 통하여 최적의 주차 경로 계획을 진행할 수 있었다.

강화학습 기반의 알고리즘은 주로 상황 판단과 경로생성을 통합하여 진행하였다. 따라서 충돌회피 및 차선변경 알고리즘의 성능을 높이기 위하여 많이 활용되고 있다. 학습기반 판단 알고리즘을 설계하기 위하여 양질의 데이터가 필수적이었다면, 데이터 구축의 단점을 보완하고 데이터가 없이 학습이 가능한 강화학습 기반의 알고리즘이 제시되었다.

초기에는 DQN과 같은 가치 기반(Value-based) 강화학습 알고리즘이 차선변경 연구에 많이 연구되었다. Hoel 등39)에서는 DQN을 이용하여 차선 변경 알고리즘을 설계하여 제안하였다. 하지만 DQN 기반의 알고리즘들은 알고리즘의 특징으로 인하여 이산적인 결과값을 배출하고, 승차감이 연관 되어있는 자동차에서는 적용이 어렵다.

이후 승차감을 향상시키기 위한 연속적인 제어입력에 대한 요구와 함께 Actor-critic과 같은 정책 기반(Policy-based) 강화학습 알고리즘이 연구되었다. Al-Qizwini 등40)의 경우 차선 변경 경로 생성을 위하여 Deep deterministic policy gradient(DDPG) 방법을 사용하였으며, Hart 등41)의 경우 복잡한 상황에서의 성능을 보장하기 위하여 Soft-actor-critic(SAC) 방법을 통하여 차선 변경 알고리즘을 생성하였다. You 등42)은 RL과 Deep Inverse RL을 사용하여 안전한 경로 생성 방법을 학습하였고, 추월 알고리즘 및 전방 차량 속도 추종 알고리즘을 설계하였다. Hwang 등43)은 Fig. 6과 같이 Rule-base 의사결정기와 RL을 함께 융합하여 하이브리드 알고리즘을 사용하였다.

하지만 강화학습 알고리즘의 경우 모든 것을 학습에 맡기기 때문에 교통 법규 등의 적용이 어렵고, 주행 성향이나 안전성을 임의로 결정할 수 없다. 또한 법규나 규칙이 다른 구간의 경우 별도의 학습을 진행해야 하며, 학습 결과를 확인할 수 없어 안전성이 보장할 수 없다는 단점이 있다.

4.2 도전 및 발전 방향

많은 판단 알고리즘들이 연구되고 있지만, 완전자율주행 자동차의 상용화 지연과 불완전한 안전성 보장 등의 문제로 상용화 차량에 탑재는 지연되고 있다. 학습을 기반으로 하는 인공지능 알고리즘을 사용하여 성능을 최대화 하면서도 자동차의 필수 요건인 안전성을 보장할 수 있는 접근이 필요하다. 강화학습 알고리즘의 경우 주로 시뮬레이션을 통하여 학습을 진행하기 때문에 실제 자동차에 적용 시 센서 노이즈에 민감하게 반응하는 등 실제 적용까지는 아직 더 많은 연구가 필요하다. 인공지능 알고리즘이라고 하여 결정 내용이 완전히 블랙박스가 아닌, 학습 결과에 따른 예상 거동을 어느 정도 예측하고 설명할 수 있는 인공지능 알고리즘의 연구가 진행되어야 자율주행 자동차에 적용되어 좋은 성능을 낼 수 있을 것으로 보인다.

다만 자동차의 컴퓨팅 파워가 급속도로 향상되고 있으며, 시뮬레이션 환경 또한 실제의 모습과 비슷하게 발전하고 있다. 이를 기반으로 다양한 인공지능 알고리즘들의 적용이 가속화될 수 있을 것으로 기대한다.

5. 인공지능 알고리즘 사용을 위한 자율주행 소프트웨어 아키텍처

인지, 예측, 판단 및 계획 등 자율주행 자동차의 전반적인 알고리즘에 대하여 인공지능 알고리즘이 미치는 영향에 대하여 알아보았다. 이 장에서는 이와 같은 알고리즘들을 통합하는 소프트웨어 아키텍처의 동향에 대하여 알아본다.

5.1 자율주행 소프트웨어 아키텍처 동향

자율주행 소프트웨어 플랫폼으로는 Apollo, Autoware 등의 오픈 플랫폼이 대표적이며 NVIDIA 및 테슬라 등 기업들에서도 활발하게 개발이 진행중이다. 대부분의 경우 인지, 예측, 판단의 기술들을 독립적으로 구현하고 각 모듈들의 입출력을 유기적으로 연결하여 전체적인 SW 아키텍처를 구성하고 있다.

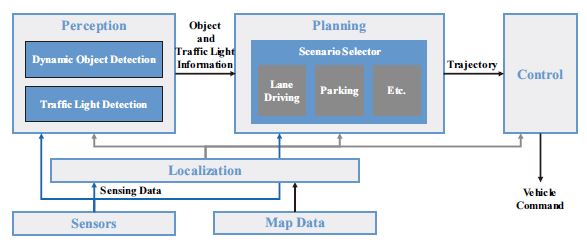

Autoware는 2015년 일본의 나고야대학에서 처음 개발하여 공개한 자율주행 SW 플랫폼으로 인지, 판단, 제어 등의 자율주행 기술을 통합하기 위해 ROS(Robot operating system)를 활용한다.44) Autoware는 Fig. 7과 같이 위치 추정(Localization), 주변 환경 인지(Perception), 경로 계획(Planning), 제어(Control)의 네 단계로 구성되어 있으며, 기본적으로 LiDAR와 HDmap을 활용하며 카메라와 레이더 등 여러 센서에 대한 모델도 함께 지원한다. 지도 정보와 센서로부터 들어오는 정보를 입력으로 하여 자차량의 위치를 추정하고 주변 동적객체 및 신호등 검출을 수행하며 추정된 위치, 검출된 객체 정보를 활용하여 미션과 시나리오에 맞게 경로 계획을 수행한다. 최종적으로 계획된 경로를 추종하기 위한 제어기 모듈을 포함하고 있다. 2021년 Autware.Auto를 공개하였으며, v1.0에서는 자동 발렛 파킹(Autonomous valet parking, AVP), v2.0에서는 화물 운송(Cargo delivery) 기능을 공개하였다.

Apollo는 중국의 Baidu사에서 개발 및 공개한 자율주행 소프트웨어 플랫폼으로 제한된 도로에서의 자율주행을 지원하는 Apollo 1.0부터 도심 자율주행을 지원하는 Apollo 6.0까지 지속적으로 업데이트되고 있다.45) Apollo는 위치추정, 인지, 예측, 경로 계획, 제어에 이르는 각 요소 기술들을 모듈화 하여 개발하고 이를 CyberRT 기반 미들웨어를 기반으로 통합하여 전체 SW 아키텍처를 구성하고 있다. Apollo의 위치 추정 모듈은 GPS를 기반으로 하며 RTK(Real time kinematic)을 활용한 방법과 GPS, IMU 그리고 LiDAR를 활용한 다중 센서 방법을 제공하고 있으며, 인지 모듈에서는 라이다, 카메라 그리고 레이더의 센서를 모두 사용할 수 있고 딥러닝 기반의 모델을 활용하여 3차원 객체, 차선, 신호등을 검출하고 추적한다. 예측 단계에서는 검출된 객체의 미래 경로를 미리 예측하고 이를 통해 주변 차량의 중요도를 판단하며 경로 계획 단계에서는 일반 주행, 신호등, 정지 신호 등의 시나리오별 경로를 생성하여 제어에 활용한다. 그 밖에도 NVIDIA 드라이브웍스 등에서도 독자적인 SW 아키텍처를 보유 및 개발하고 있다.

6. 결 론

자율주행 자동차 분야의 인지, 예측, 판단 및 계획 분야에 적용되어 연구되고 있는 다양한 인공지능 기술에 대하여 분류하고 분석해보았다. 상용화를 위해서는 안전성 확보 등의 보완점은 필요해 보이지만, 다양한 환경에서 좋은 성능을 나타내는 것은 확실해 보인다. 자율주행 자동차의 안전성과 성능 향상을 위하여 인공지능 기술을 활용한 다양한 시도와 연구가 지속적으로 진행되어야 할 것으로 판단된다.

이를 위하여 국내에서도 국내 주행상황에 특화된 데이터 확보가 필수적이며, 단순히 많은 양의 데이터보다는 다양한 환경을 포함하는 양질의 데이터 확보가 필요하다. 현재 각 알고리즘 별로 인공지능 기술들이 사용되고 있지만, 자율주행 자동차 시스템 통합 관점에서 각 알고리즘의 성능과 특성을 고려하고 장단점을 보완할 수 있는 아키텍처 구성에 대한 연구가 필요하다.

Acknowledgments

이 논문은 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원 및 한국연구재단의 지원을 받아 수행된 연구임(No.2021-0-00951, No.2021R1C1C1004154).

References

-

H. Caesar, V. Bankiti, A. H. Lang, S. Vora, V. E. Liong, Q. Xu, A. Krishnan, Y. Pan, G. Baldan and O. Beijbom, “Nuscenes: A Multimodal Dataset for Autonomous Driving,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.11621-11631, 2020.

[https://doi.org/10.1109/CVPR42600.2020.01164]

-

P. Sun, H. Kretzschmar, X. Dotiwalla, A. Chouard, V. Patnaik, P. Tsui, J. Guo, Y. Zhou, Y. Chai, B. Caine, V. Vasudevan, W. Han, J. Ngiam, H. Zhao, A. Timofeev, S. Ettinger, M. Krivokon, A. Gao, A. Joshi, Y. Zhang, J. Shlens, Z. Chen and D. Anguelov, “Scalability in Perception for Autonomous Driving: Waymo Open Dataset,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.2446-2454, 2020.

[https://doi.org/10.1109/CVPR42600.2020.00252]

-

S. Ettinger, S. Cheng, B. Caine, C. Liu, H. Zhao, S. Pradhan, Y, Chai, B. Sapp, C. R. Qi, Y. Zhou, Z. Yang, A. Chouard, P. Sun, J. Ngiam, V. Vasudevan, A. McCauley, J. Shlens and D. Anguelov, “Large Scale Interactive Motion Forecasting for Autonomous Driving: The Waymo Open Motion Dataset,” IEEE/CVF International Conference on Computer Vision, pp.9710-9719, 2021.

[https://doi.org/10.1109/ICCV48922.2021.00957]

- J. Houston, G. Zuidhof, L. Bergamini, Y. Ye, L. Chen, A. Jain, S. Omari, V. Iglovikov and Peter Ondruska, “One Thousand and One Hours: Self-driving Motion Prediction Dataset,” arXiv preprint arXiv:2006.14480, , 2020.

-

M. Chang, J. Lambert, P. Sangkloy, J. Singh, S. Bak, A. Hartnett, D. Wang, P. Carr, S. Lucey, D. Ramanan and J. Hays, “Argoverse: 3D Tracking and Forecasting with Rich Maps,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.8748-8757, 2019.

[https://doi.org/10.1109/CVPR.2019.00895]

-

Y. Zhou and O. Tuzel, “Voxelnet: End-to-end Learning for Point Cloud Based 3D Object Detection,” IEEE Conference on Computer Vision and Pattern Recognition, pp.4490-4499, 2018.

[https://doi.org/10.1109/CVPR.2018.00472]

-

Y. Yan, Y. Mao and B. Li, “Second: Sparsely Embedded Convolutional Detection,” Sensors, Vol.18, No.10, pp.3337-3354, 2018.

[https://doi.org/10.3390/s18103337]

-

A. H. Lang, S. Vora, H. Caesar, L. Zhou, J. Yang and O. Beijbom, “Pointpillars: Fast Encoders For Object Detection From Point Clouds,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.12697-12705, 2019.

[https://doi.org/10.1109/CVPR.2019.01298]

- C. R. Qi, H. Su, K. Mo and L. J. Guibas, “Pointnet: Deep Learning on Point Sets for 3D Classification and Segmentation,” IEEE Conference on Computer Vision and Pattern Recognition, pp.652-660, 2017.

-

S. Shi, X. Wang and H. Li, “PointRCNN: 3D Object Proposal Generation and Detection from Point Cloud,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.770-779, 2019.

[https://doi.org/10.1109/CVPR.2019.00086]

-

Z. Yang, Y. Sun, S. Liu and J. Jia, “3DSSD: Point-based 3D Single Stage Object Detector,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.11040-11048, 2020.

[https://doi.org/10.1109/CVPR42600.2020.01105]

-

S. Shi, C. Guo, L. Jiang, Z. Wang, J. Shi, X. Wang and H. Li, “PV-RCNN: Point-Voxel Feature Set Abstraction for 3D Object Detection,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.10529-10538, 2020.

[https://doi.org/10.1109/CVPR42600.2020.01054]

- H. Fu, M. Gong, C. Wang, K. Batmanghelich and D. Tao, “Deep Ordinal Regression Network for Monocular Depth Estimation,” IEEE Conference on Computer Vision and Pattern Recognition, pp.2002-2011, 2018.

-

Y. Wang, W. L. Chao, D. Garg, B. Hariharan, M. Campbell and K. Q. Weinberger, “Pseudo-LiDAR from Visual Depth Estimation: Bridging the Gap in 3D Object Detection for Autonomous Driving,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.8445-8453, 2019.

[https://doi.org/10.1109/CVPR.2019.00864]

-

X. Ma, S. Liu, Z. Xia, H. Zhang, X. Zeng and W. Ouyang, “Rethinking Pseudo-LiDAR Representation,” European Conference on Computer Vision, pp.311-327, 2020.

[https://doi.org/10.1007/978-3-030-58601-0_19]

-

T. Wang, X. Zhu, J. Pang and D. Lin, “FCOS3D: Fully Convolutional One-Stage Monocular 3D Object Detection,” IEEE/CVF International Conference on Computer Vision Workshop, pp.913-922, 2021.

[https://doi.org/10.1109/ICCVW54120.2021.00107]

-

D. Park, R. Ambrus, V. Guizilini, J. Li and A. Gaidon, “Is Pseudo-Lidar Needed for Monocular 3D Object Detection?,” IEEE/CVF International Conference on Computer Vision, pp.3142-3152, 2021.

[https://doi.org/10.1109/ICCV48922.2021.00313]

- Z. Li, W. Wang, H. Li, E. Xie, C. Sima, T. Lu, Q. Yu and J. Dai, “BEVFormer: Learning Bird’s-Eye-View Representation from Multi-Camera Images via Spatiotemporal Transformers,” arXiv preprint arXiv:2203.17270, , 2022.

- C. R. Qi, W. Liu, C. Wu, H. Su and L. J. Guibas, “Frustum Pointnets for 3D Object Detection from RGB-D Data,” IEEE Conference on Computer Vision and Pattern Recognition, pp.918-927, 2018.

-

S. Vora, A. H. Lang, B. Helou and O. Beijbom, “Pointpainting: Sequential Fusion for 3D Object Detection,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.4604-4612, 2020.

[https://doi.org/10.1109/CVPR42600.2020.00466]

- T. Yin, X. Zhou and P. Krähenbühl, “Multimodal Virtual Point 3D Detection,” Advances in Neural Information Processing Systems, Vol.34, pp.16494-16507, 2021.

-

Y. Kim, D. Kum and J. W. Choi, “GRIF Net : Gated Region of Interest Fusion Network for Robust 3D Object Detection from Radar Point Cloud and Monocular Image,” IEEE International Conference on Intelligent Robots and Systems, pp.10857-10864, 2020.

[https://doi.org/10.1109/IROS45743.2020.9341177]

-

D. Lee, Y. Kwon, S. McMains and J. Hedrick, “Convolution Neural Network-based Lane Change Intention Prediction of Surrounding Vehicles for ACC,” IEEE International Conference on Intelligent Transportation Systems, pp.1-6, 2017.

[https://doi.org/10.1109/ITSC.2017.8317874]

-

S. Yoon, H. Jeon and D. Kum, “Predictive Cruise Control Using Radial Basis Function Network-Based Vehicle Motion Prediction and Chance Constrained Model Predictive Control,” IEEE Transactions on Intelligent Transportation Systems, Vol.20, No.10, pp.3832-3843, 2019.

[https://doi.org/10.1109/TITS.2019.2928217]

-

H. Jeon, D. Kum and W. Jeong, “Traffic Scene Prediction via Deep Learning: Introduction of Multi-Channel Occupancy Grid Map as a Scene Representation,” IEEE Intelligent Vehicles Symposium, pp.1496-1501, 2018.

[https://doi.org/10.1109/IVS.2018.8500567]

-

N. Deo and M. M. Trivedi, “Convolutional Social Pooling for Vehicle Trajectory Prediction,” IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, pp.1486-1476, 2018.

[https://doi.org/10.1109/CVPRW.2018.00196]

-

H. Jeon, J. Choi and D. Kum, “Scale-net: Scalable Vehicle Trajectory Prediction Network under Random Number of Interacting Vehicles via Edge-enhanced Graph Convolutional Neural Network,” IEEE International Conference on Intelligent Robots and Systems, pp.2095-2102, 2020.

[https://doi.org/10.1109/IROS45743.2020.9341288]

- N. Djuric, V. Radosavljevic, H. Cui, T. Nguyen, F. Chou, T. Lin, N. Singh and J. Schneider, “Uncertainty-aware Short-term Motion Prediction of Traffic Actors for Autonomous Driving,” IEEE Winter Conference on Applications of Computer Vision, pp.2084-2093, 2018.

-

J. Gao, C. Sun, H. Zhao, Y. Shen, D. Anguelov, C. Li and C. Schmid, “VectorNet: Encoding HD Maps and Agent Dynamics from Vectorized Representation,” IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.11525-11533, 2020.

[https://doi.org/10.1109/CVPR42600.2020.01154]

-

S. Kim, D. Kum and J. Choi, “RECUP Net: RECUrsive Prediction Network for Surrounding Vehicle Trajectory Prediction with Future Trajectory Feedback,” IEEE International Conference on Intelligent Transportation Systems, pp.1-6, 2020.

[https://doi.org/10.1109/ITSC45102.2020.9294381]

-

H. Song, W. Ding, Y. Chen, S. Shen, M. Y. Wang and Q. Chen, “PiP: Planning-Informed Trajectory Prediction for Autonomous Driving,” European Conference on Computer Vision, pp.598-614, 2020.

[https://doi.org/10.1007/978-3-030-58589-1_36]

-

E. Tolstaya, R. Mahjourian, C. Downey, B. Vadarajan, B. Sapp and D. Anguelov, “Identifying Driver Interactions via Conditional Behavior Prediction,” IEEE International Conference on Robotics and Automation, pp.3473-3479, 2021.

[https://doi.org/10.1109/ICRA48506.2021.9561967]

-

M. Schreiber, V. Belagiannis, C. Gläser and K. Dietmayer, “Dynamic Occupancy Grid Mapping with Recurrent Neural Networks,” IEEE International Conference on Robotics and Automation (ICRA), pp.6717-6724, 2021.

[https://doi.org/10.1109/ICRA48506.2021.9561375]

-

K. Okamoto, K. Berntorp and S. Di Cairano, “Driver Intention-based Vehicle Threat Assessment Using Random Forests and Particle Filtering,” IFAC-PapersOnLine, Vol.50, No.1, pp.13860-13865, 2017.

[https://doi.org/10.1016/j.ifacol.2017.08.2231]

-

L. Li, K. Ota and M. Dong, “Humanlike Driving: Empirical Decision-Making System for Autonomous Vehicles,” IEEE Transactions on Vehicular Technology, Vol.67, No.8, pp.6814-6823, 2018.

[https://doi.org/10.1109/TVT.2018.2822762]

-

M. Wang, J. Chen, Z. Deng and Y. Xiang, “Velocity Planning Method Base on Fuzzy Neural Network for Autonomous Vehicle,” IEEE Access, Vol.9, pp.19111-19126, 2021.

[https://doi.org/10.1109/ACCESS.2021.3054124]

- E. Rehder, J. Quehl and C. Stiller, “Driving Like a Human: Imitation Learning for Path Planning Using Convolutional Neural Networks,” International Conference on Robotics and Automation Workshops, pp.1-5, 2017.

-

R. Chai, A. Tsourdos, A. Savvaris, S. Chai, Y. Xia and C. L. P. Chen, “Design and Implementation of Deep Neural Network-Based Control for Automatic Parking Maneuver Process,” IEEE Transactions on Neural Networks and Learning System, Vol.33, No.4, pp.1400-1413, 2022.

[https://doi.org/10.1109/TNNLS.2020.3042120]

- C. -J. Hoel, K. Wolff and L. Laine, “Automated Speed and Lane Change Decision Making Using Deep Reinforcement Learning,” IEEE International Conference on Intelligent Transportation Systems (ITSC), pp.2148-2155, 2018.

-

M. Al-Qizwini, O. Bulan, X. Qi, Y. Mengistu, S. Mahesh, J. Hwang and D. Clifford, “A Lightweight Simulation Framework for Learning Control Policies for Autonomous Vehicles in Real-World Traffic Condition,” IEEE Sensors Journal, Vol.21, No.14, pp.15762-15774, 2021.

[https://doi.org/10.1109/JSEN.2020.3036532]

-

P. Hart, L. Rychly and A. Knoll, “Lane-Merging Using Policy-based Reinforcement Learning and Post-Optimization,” IEEE Intelligent Transportation Systems Conference(ITSC), pp.3176-3181, 2019.

[https://doi.org/10.1109/ITSC.2019.8917002]

-

C. X. You, J. B. Lu, D. Filev and P. Tsiotras, “Advanced Planning for Autonomous Vehicles Using Reinforcement Learning and Deep Inverse Reinforcement Learning,” Robotics and Autonomous Systems, Vol.114, pp.1-18, 2019.

[https://doi.org/10.1016/j.robot.2019.01.003]

-

S. Hwang, K. Lee, H. Jeon and D. Kum, “Autonomous Vehicle Cut-In Algorithm for Lane-Merging Scenarios via Policy-Based Reinforcement Learning Nested Within Finite State Machine,” IEEE Transactions on Intelligent Transportation Systems(TITS), 2022.

[https://doi.org/10.1109/TITS.2022.3153848]

- Autoware Foundation(2021), Autoware URL: https://gitlab.com/autowarefoundation/autoware.auto, , 2021.

- Baidu Apollo team(2017), Apollo: Open Source Autonomous Driving, URL: https://github.com/ApolloAuto/apollo, , 2017.