딥러닝 기반의 객체 검출 및 거리 추정을 위한 카메라 센서 구현에 관한 연구

Copyright Ⓒ 2022 KSAE / 201-06

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Autonomous Emergency Braking(AEB), one of the core technologies of Advanced Driver Assistance System (ADAS), provides drivers convenience and is effective for safety driving. As the number of AEB-equipped vehicles increases, it is expected that requests for analyzing traffic accidents involving AEB-equipped vehicles will rise. In this study, a deep learning-based camera sensor was developed to implement the function of the AEB in Prescan for reconstruction and analysis of traffic accidents related to AEB. The deep learning algorithm, YOLO(You Only Look Once), was used to detect a front vehicle and to obtain the coordinates of the bounding box. The intrinsic parameters of the camera were calculated through camera calibration. The relative distance to the front vehicle was estimated using the coordinates of the bounding box and the calibrated camera parameter. The intrinsic parameters were compared within the standard error range to find the most similar value to the relative distance measured by the idealized sensor. Based on the results, the optimal parameter was obtained and a more accurate relative distance could be estimated using these values.

Keywords:

ADAS(Advanced Driver Assistance System), AEB(Autonomous Emergency Braking), Deep learning, YOLO(You Only Look Once), Camera calibration, Prescan키워드:

첨단 운전자 보조 시스템, 긴급 제동 장치, 딥러닝, 딥러닝 객체 검출 알고리즘, 카메라 캘리브레이션, ADAS 시뮬레이션 프로그램1. 서 론

최근 안전에 대한 중요성이 대두되면서 전 세계적으로 자동차 제조사들이 안전과 편의를 도모하기 위해 첨단 운전자 보조 시스템(ADAS, Advanced Driver Assistance System)을 장착한 차량을 출시하고 있다. ADAS의 대표적인 기능으로 긴급 제동 장치(AEB, Autonomous Emergency Braking)가 있으며, 교통사고와 가장 밀접한 관계가 있는 기능이다. AEB는 카메라 센서와 레이더 센서를 활용하여 주행 상황에서 전방 차량 또는 보행자 등과의 충돌 위험을 운전자에게 경고하고, 차량의 제동 시스템을 제어하는 주행 안전 시스템이다. AEB는 2022년도부터 초소형차를 제외한 모든 차량에 의무적으로 장착하도록 하는 법규가 시행될 예정이며, 이에 따라 ADAS 장착 차량의 AEB와 관련된 사고 분석 수요가 증가 될 것으로 예상된다. ADAS 장착 차량의 교통사고는 ADAS 센서 및 알고리즘에 대한 특성이 반영된 과학적인 사고 재현 및 분석 기법이 필요하다. 그에 따라 국립과학수사연구원에서는 ADAS 장착 차량의 AEB 관련 교통사고 재현 및 분석을 위한 AEB 시뮬레이션 감정 기법을 개발하고 있으며, 이를 위해서는 딥러닝(Deep learning) 기반의 카메라 센서를 개발할 필요가 있다.1)

단안 카메라로부터 얻은 이미지를 바탕으로 객체와의 거리를 추정하기 위한 연구는 국⋅내외에서 활발하게 진행되고 있다. 박근남 등2)은 카메라 센서를 통해 인공 표식이 부착된 전방 차량과의 거리를 계산하고 GPS 데이터를 활용하여 전방 차량과의 거리의 정확성을 높였다. 하지만, 인공 표식을 활용하여 거리를 계산하기 때문에 인공 표식이 부착되지 않은 차량과의 거리는 계산할 수 없다. 김현석 등3)은 딥러닝 기반의 카메라 센서로 전방 차량을 검출하고, 검출된 전방 차량의 공간 위치 정보(x, y, w, h)와 라이다 센서로 취득한 실제 거리 정보의 관계를 이용하여 수식을 세워 이를 통해 전방 차량과의 거리를 추정하였다. 그러나, 라이더 센서로 측정된 실제 거리 정보를 사용하여 거리 추정 수식을 세우기 때문에 카메라 센서만으로 거리를 추정하기 어렵다. Eigen 등4)은 영상의 깊이 데이터를 사용하여 다중 스케일 심층 신경망을 학습하고 이를 통해 깊이(Depth)를 추정하였다. Godard 등5)은 Convolution Neural Network(CNN)를 통해 오른쪽 이미지와 왼쪽 이미지의 시차(Disparity)를 구하여 깊이를 추정하였으며, 또한 Zhou 등6)은 Image sequence를 통해 객체의 움직임을 추정하고 깊이에 관하여 학습하는 연구를 진행하였다. 깊이 추정에 관한 선행 연구는 입력 이미지 내에서 모든 객체의 깊이를 추정하지만, 특정 객체의 깊이를 추정하기 위해서 이미지 내에서 특정 객체의 위치를 찾는 후처리가 필요하다.

이러한 선행 연구들과 같이 본 연구에서는 차량 시뮬레이션 환경에서 AEB의 기능 구현을 위해 딥러닝 모델로 전방 차량을 실시간으로 감지하고, 카메라 캘리브레이션을 통해 거리를 추정하는 카메라 센서를 구현하고자 하고자 하였다.

2. 컴퓨터 비전의 이론적 배경

2.1 딥러닝 기반의 객체 검출

최근 딥러닝이 컴퓨터 비전에 접목되면서 각종 산업에서 괄목할 만한 성과를 나타내고 있다. 딥러닝 기반 컴퓨터 비전의 대표적인 응용 분야로 객체 검출(Object detection)이 있다. CNN을 사용하여 입력 영상에서 특정 객체의 위치를 탐색(Localization)하고, 특정 객체의 종류를 인식(Recognition)하는 것이 딥러닝 기반의 객체 검출이다.

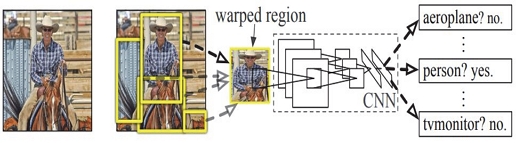

객체 검출의 방법에 따라 Two-Stage detector와 Single-Stage detector로 분류할 수 있다.7) Two-Stage detector는 순차적으로 Regional proposal, Classification, Regression 단계를 수행한다. Regional proposal 단계에서 Selective search, Regional proposal network와 같은 알고리즘 및 네트워크를 통해 입력 영상에 객체가 있을 만한 영역(RoI, Region of Interest)을 파악한다. 객체가 있을 만한 영역에서 CNN을 사용하여 객체를 Classification하고 객체가 있을 만한 영역을 경계박스(Bounding box)로 표현하기 위해서 Regression를 수행한다. 이러한 Two-Stage detector는 각 단계를 순차적으로 진행하기 때문에 느리지만 정확하다. 대표적인 모델로 Fig. 1에 나타낸 바와 같이 R-CNN(Region with Convolution Neural Network Feature) 계열이 있다.8)

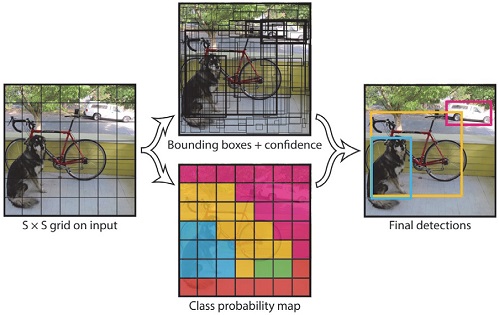

Single-Stage detector는 입력 영상에서 객체가 있을 만한 영역을 먼저 추출하지 않고, CNN에서 객체가 있을 만한 영역의 경계박스를 예측하여, 경계박스 내에 객체를 분류한다. Two-Stage detector보다 정확도는 낮지만, 속도가 빠르다. Single-Stage detector의 대표적인 모델로 Fig. 2와 같이 YOLO(You Only Look Once)계열9)이 있고, SSD(Single Shot Multi Box Detector)계열10)이 있다.

2.2 카메라 캘리브레이션

이미지나 영상의 정보를 활용하기 위해서는 카메라 캘리브레이션(Camera calibration)이 필수적인 과정이다. 카메라 캘리브레이션은 3차원 공간 좌표와 2차원 이미지 좌표로 변환 관계를 설명하기 위해 카메라의 외부 변수(Extrinsic parameter)와 내부 변수(Intrinsic parameter)를 계산하는 과정이다.11,12) 아래 식 (1)에서 s는 척도인자(Scale factor)이며, 2차원 이미지 좌표와 3차원의 공간 좌표는 동차 좌표계로 표현하였다. [R|t]는 카메라의 외부 변수로 카메라의 상대적인 위치를 나타낸다. [R|t]는 이동 변수(Translation parameter)와 회전 변수(Rotation parameter)로 구성되고, 강체 변환(Rigid transformation)을 통해 3차원 공간 좌표가 카메라 좌표로 변환된다. A는 카메라 내부 변수로 왜도 계수(Skew coefficient), 초점거리(Focal length), 주점(Principal point)으로 구성되고, 사영 변환(Projective transformation)을 통해 카메라 좌표가 2차원 이미지 좌표로 변환된다.

| (1) |

3. 모델 학습 및 평가

3.1 YOLOv2 전이학습

CNN을 학습시키기 위해서는 수 만장의 이미지와 많은 시간이 소요된다. 따라서 효율적인 모델 학습을 위해 대규모 학습 데이터로 사전에 학습된 모델을 재사용하는 전이학습(Transfer learning)을 이용한다.13) 따라서 CNN의 대표적인 네트워크 모델인 ResNet-50(Residual network)을 사전 학습된 모델로 이용하여 YOLOv2를 학습시킨다.14) YOLO(You Only Look Once)는 입력 이미지를 Grid cell로 나누고, 각 Grid cell의 경계박스와 경계박스의 Confidence score, Class probability를 하나의 회귀문제로 계산하여 실시간으로 객체 검출이 가능하다.

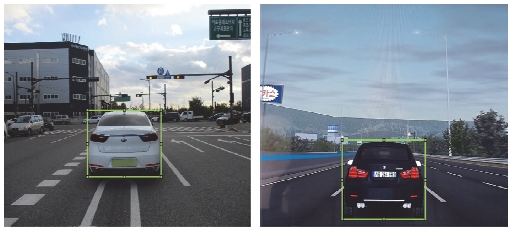

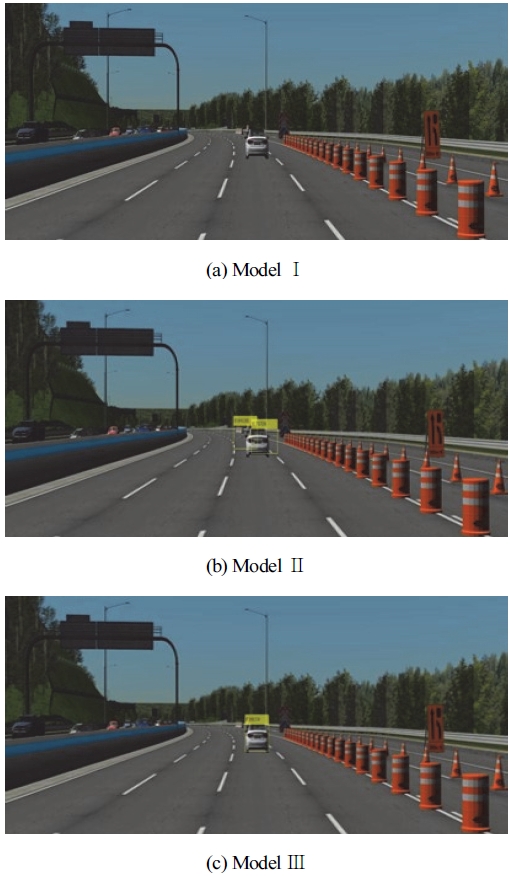

본 연구는 차량 시뮬레이션 환경에 적합한 모델 개발을 위해 실제 차량의 후면 이미지(Real vehicle image)와 시뮬레이션 차량의 후면 이미지(Simulation vehicle image)를 학습 데이터로 사용하였으며, MATLAB 2021a15)의 Image labeler app를 이용하여 Fig. 3과 같이 준비된 학습 데이터에 경계박스를 설정하고, 경계박스의 공간 위치 정보를 취득하였다. 실제 차량의 후면 이미지 693장, 시뮬레이션 차량의 후면 이미지 296장을 각각 학습에 사용하였고, 실제 차량의 후면 이미지와 시뮬레이션 차량의 후면 이미지를 합해 총 989장으로 학습시켰다. 실제 차량의 후면 이미지로 학습시킨 모델을 ModelⅠ로 정하고, 시뮬레이션 차량의 후면 이미지로 학습시킨 모델은 Model Ⅱ, 모든 데이터로 학습시킨 모델을 Model Ⅲ로 정하였으며, Table 1에 데이터에 따른 학습 데이터와 검증 데이터의 개수를 정리하였다.

모델 학습 및 성능 평가를 위해 사용한 PC 환경은 다음과 같다. CPU는 Intel(R) Core(TM) i9-10980XE이며, GPU는 NVIDIA GeForce RTX 2080 SUPER, 플랫폼은 MATLAB 2021a를 이용하였다. 모델별 Total loss와 Training time을 Table 2에 각각 정리하였다.

3.2 모델 평가

AP(Average Precision, 평균정밀도)는 객체 검출 분야의 검증 및 평가 지표로 정밀도(Precision)와 재현율(Recall)을 종합한 수치이다.16) 정밀도는 모든 검출 결과 중에서 옳게 검출한 비율을 의미하며, 재현율은 실제 옳은 결과 중에서 옳게 검출된 비율을 의미한다. 모델 평가를 위한 데이터로 실제 차량의 후면 이미지와 시뮬레이션 차량의 후면 이미지 248장을 사용하여 AP를 측정하였다. 또한, FPS(Frame Per Second)를 측정하여 객체가 실시간으로 얼마나 잘 검출되는지를 확인하였다. 이때, FPS는 평가 데이터 전체에 대한 평균 FPS를 나타낸 값이다. Table 3과 같이 각 Model의 AP와 FPS를 비교한 결과, 모든 Model에서 실시간 검출이 가능하며, Model Ⅲ, Model Ⅰ그리고 Model Ⅱ의 순서대로 AP가 높았다. 이를 통해 AP 및 평균 FPS에서 3개의 모델 중 Model Ⅲ가 가장 우수함을 알 수 있다.

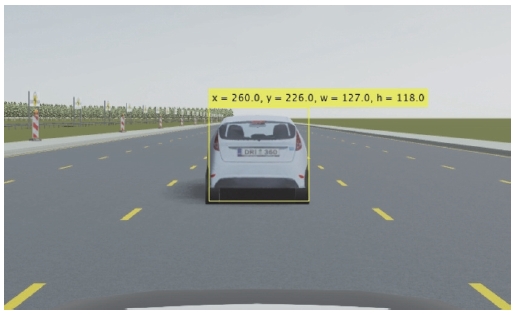

또한, 차량 시뮬레이션 환경의 이미지를 사용하여 육안으로 모델별 차량 검출 여부를 확인하였다. 그 결과 Fig. 4에 나타낸 바와 같이 ModelⅠ은 아예 검출하지 못하였고, Model Ⅱ는 제대로 검출하지 못하였지만, Model Ⅲ는 가장 정확하게 검출하였다. 따라서 세 모델 중 상대적으로 정확한 객체 검출이 가능한 Model Ⅲ를 선정하였다.

4. 최적 거리 추정

4.1 거리 추정을 위한 카메라 캘리브레이션

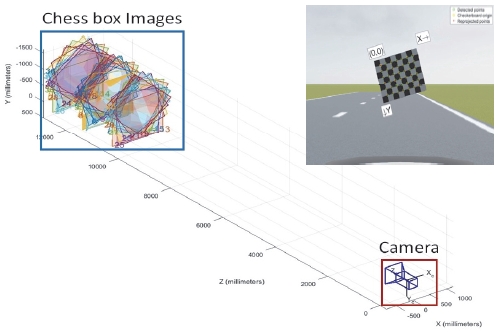

Prescan에서 제공하는 가상 카메라 센서의 외부 변수와 내부 변수를 계산하여 3차원 공간 좌표와 2차원 좌표의 변환 관계를 설명하기 위해 대표적인 카메라 캘리브레이션 기법을 사용하였다. 카메라 캘리브레이션의 대표적인 방법은 체커보드의 코너(Corner) 및 엣지(Edge)를 인식하고 특징점 간의 위치 관계를 파악하여 카메라의 외부 변수와 내부 변수를 계산하는 방법이다. 체커보드는 Prescan의 Chessplane Box를 활용하여, 0.25 m의 격자 크기를 갖는 Chessplane Box의 이미지 34장과 MATLAB 2021a의 Camera calibration app를 이용하여 Fig. 5와 같이 카메라 캘리브레이션을 하였다.

이때, 카메라 센서의 외부 변수는 계산 값이 아닌 카메라 센서의 위치 정보를 활용하였다. 카메라의 위치 정보에는 높이(Height), 롤(Roll), 피치(Pitch), 요(Yaw)가 있으며, 높이는 1.32 m이고, 롤, 피치, 요는 모두 0 deg로 설정하였다.

카메라 캘리브레이션 결과로 내부 변수는 다음과 같이 계산되었다. 초점거리(fx, fy)는 각각 875.920과 876.049이며, 표준 오차는 각각 ±155.366과 ±155.482이다. 또한, 주점(cx, cy)은 각각 305.142와 244.648이고, 표준 오차는 각각 ±9.244와 ±17.177이며, 왜도 계수(Skew coefficient)는 0이다. 표준 오차를 포함하여 초점거리와 주점을 Table 4에 다시 정리하여 나타내었다.

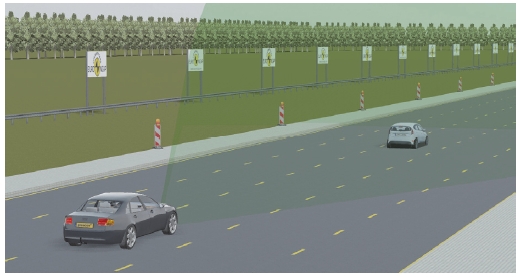

Prescan의 Air(Actor Information Receiver) Sensor는 Idealized sensor로서 객체의 거리(Range, m), 방위각(Azimuth, θ), 고도각(Elevation, ϕ) 및 속도(Velocity, m/s) 등의 정보를 제공한다. Fig. 6에 나타낸 바와 같이 VUT(Vehicle Under Test)가 편도 5차로 직선도로를 50 km/h로 주행하는 상황에서 VUT에 장착된 Air sensor를 이용하여 100 % 오버랩 상태의 정차되어있는 전방 차량과의 상대 거리를 50 m 지점부터 충돌 직전까지 측정하였다. Fig. 7과 같이 카메라 센서를 통해 차량을 검출하여 경계박스의 공간 위치 정보를 추출하였다.

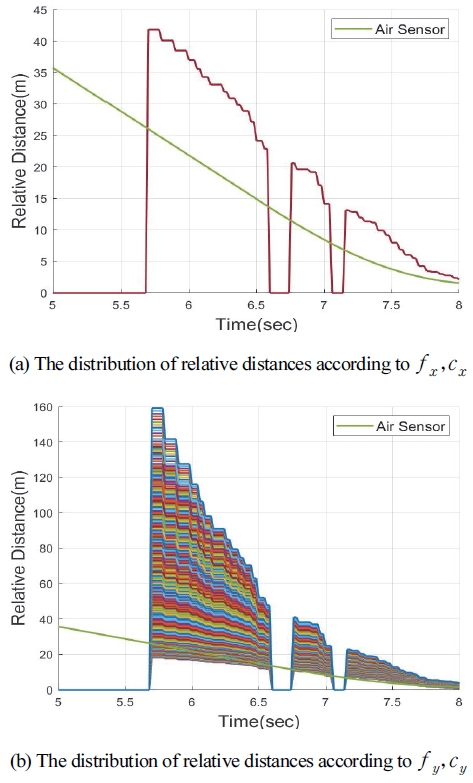

경계박스의 공간 위치 정보와 카메라의 외부, 내부 변수를 식 (1)에 적용함으로써 2차원 좌표를 3차원 좌표로 변환하여 전방 차량과의 상대 거리를 추정하였다. 모델에서 객체를 검출하고, 검출된 객체의 경계박스를 사용하여 거리를 추정하므로 모델이 객체를 검출하지 못할 때는 전방 차량과의 상대 거리는 0 m로 표현된다. Air sensor와 가장 유사한 상대 거리를 찾기 위해서 카메라 캘리브레이션 결과의 표준 오차 범위 내에서 초점거리와 주점의 값에 따른 상대 거리를 비교하였다. Fig. 8과 같이 초점거리(fx)와 주점(cx)에 따른 상대 거리의 변화는 없었지만, 초점거리(fy)와 주점(cy)에 따라 상대 거리가 변화하였고, 카메라 캘리브레이션 결과의 표준 오차 범위 내에서 추정된 거리의 분포가 상당히 넓은 것을 확인하였다.

4.2 내부 변수의 최적값 추정

Prescan의 Air sensor와 가장 유사한 상대 거리를 추정할 수 있는 카메라의 내부 변수를 찾고자 카메라 캘리브레이션 결과의 표준 오차 범위 내에서 정수 단위로 비교하였다. 그 결과, Air sensor와 가장 유사한 상대 거리를 추정할 수 있는 초점거리(fx, fy)는 875.920과 876.016으로, 주점(cx, cy)은 305.142와 234.648로 설정한 경우이며 Table 5에 다시 정리하여 나타내었다.

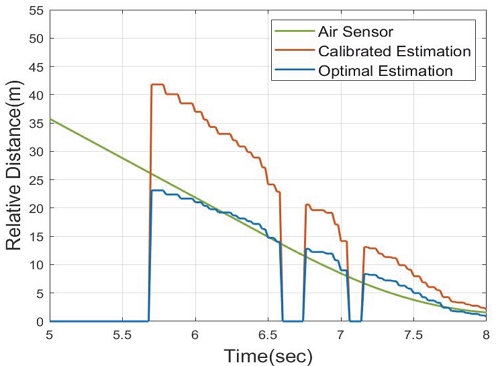

카메라 캘리브레이션으로 계산된 내부 변수와 최적의 내부 변수에 의해 각각 검출된 전방 차량과의 상대 거리를 Fig. 9와 같이 비교하였다. 카메라 캘리브레이션으로 계산된 내부 변수로 추정한 상대 거리는 Air sensor로 측정된 상대 거리와 매우 큰 편차를 보이나, 최적의 내부 변수를 활용하여 추정한 상대 거리는 Air sensor로 측정된 상대 거리와 매우 유사한 것을 확인하였다.

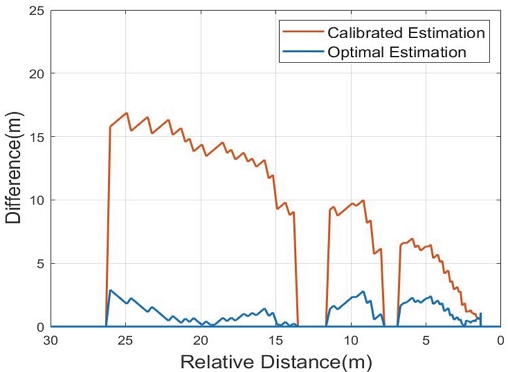

Air Sensor로 측정된 상대 거리와 카메라 센서에 대해 추정된 상대 거리 간의 편차를 계산하여 Fig. 10에 나타내었다. 그 결과, 카메라 캘리브레이션의 내부 변수로 추정한 상대 거리의 최대편차는 약 17 m이고, 최적의 내부 변수로 추정한 상대 거리의 최대편차는 약 3 m로 오차가 상대적으로 현저히 적게 나타나는 것을 알 수 있었다.

5. 결 론

본 연구에서는 ADAS 장착 차량에 대한 교통사고 분석 및 사고 재현 시뮬레이션에 적용할 목적으로 딥러닝 모델(YOLOv2)을 활용하여 실시간으로 객체를 검출하고, 카메라 캘리브레이션을 통해 정확한 거리를 추정하는 카메라 센서를 구현하고자 하였으며, 아래와 같은 결론을 도출하였다.

- 1) Prescan과 같은 차량 시뮬레이션 환경에서 가상의 카메라 센서 모델 개발 시에는 객체 검출 모델 개발을 위한 데이터로 실제 차량과 시뮬레이션 차량의 이미지를 함께 학습하는 것이 적합하다.

- 2) 카메라 캘리브레이션으로 카메라의 내부 변수를 계산하여 단순 적용하면 Idealized sensor인 Air sensor와 비교 시 상대 거리의 편차가 매우 크게 나타나는 것을 알 수 있었다.

- 3) 반면 카메라 내부 변수의 표준 오차 범위 내에서 최적의 내부 변수를 찾아 활용할 경우, Air sensor에서 측정된 상대 거리와 매우 유사하게 나타나며, 단순히 카메라 캘리브레이션 결과를 적용하는 경우보다 편차 또한 상대적으로 크게 감소함을 알 수 있었다.

이러한 결론들을 바탕으로 차량 시뮬레이션 환경에서 AEB의 기능 구현을 위한 카메라 센서를 개발하였으며, 전방 차량을 검출하고 전방 차량과의 정확한 상대 거리를 추정할 수 있었다. 향후, 객체 추적 알고리즘을 이용하여 현재 모델을 보강하고, 카메라 센서와 레이더 센서 간의 센서 융합(Sensor fusion)을 적용함으로써 좀 더 정확한 상대 거리를 추정하는 연구를 진행하고자 한다.

Acknowledgments

이 논문은 행정안전부 주관 국립과학수사연구원 중장기과학수사감정기법연구개발(R&D)사업의 지원을 받아 수행한 연구임(NFS2022TAA01).

References

-

J. H. Kim, H. S. Han, S .H. Kim, J. H. Choi, J. J. Kim and H. S. Park, “A Study on the AEB Operation Simulation Using PreScan Based on the Vehicle Test,” Transactions of KSAE, Vol.30, No.3, pp.249-257, 2022.

[https://doi.org/10.7467/KSAE.2022.30.3.249]

-

G. H. Park and S. C. Kee, “Forward Vehicle Following Using Artificial Landmark Tracking of Image Sequences,” Transactions of KSAE, Vol.28, No.2, pp.133-142, 2020.

[https://doi.org/10.7467/KSAE.2020.28.2.133]

-

H. S. Kim, M. G. Park, W. I Son, H. D. Choi and S. K. Park, “Deep Learning based Object Detection and Distance Estimation Using Mono Camera,” Journal of Korean Institute of Intelligent Systems, Vol.28, pp.201-209, 2018.

[https://doi.org/10.5391/JKIIS.2018.28.3.201]

- D. Eigen, C. Puhrsch and R. Fergus, “Depth Map Prediction from a Single Image Using a Multi-scale Deep Network,” Advances in Neural Information Processing Systems 27, 2014.

-

C. Godard, O. Mac Aodha, M. Firman and G. J. Brostow, “Digging into Self-supervised Monocular Depth Estimation,” Proceedings of the IEEE/CVF International Conference on Computer Vision, pp.3828-3838, 2019.

[https://doi.org/10.1109/ICCV.2019.00393]

-

T. Zhou, M. Brown, N. Snavely and D. G. Lowe, “Unsupervised Learning of Depth and Ego-motion from Video,” IEEE Conference on Computer Vision and Pattern Recognition, pp.1851-1858, 2017.

[https://doi.org/10.1109/CVPR.2017.700]

- Z. Zou, Z. Shi, Y. Guo and J. Ye, “Object Detection in 20 Years: A Survey,” arXiv:1905.05055, , 2019.

-

R. Girshick, J. Donahue, T. Darrell and J. Malik, “Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation,” IEEE Conference on Computer Vision and Pattern Recognition, pp.345-360, 2014.

[https://doi.org/10.1109/CVPR.2014.81]

-

J. Redmon, S. Divvala, R. Girshick and A. Farhadi, “You Only Look Once: Unified, Real-time Object Detection,” IEEE Conference on Computer Vision and Pattern Recognition, pp.779-788, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C. Y. Fu and A. C. Breg, “SSD: Single Shot MultiBox Detector,” European Conference on Computer Vision, Spring, Cham, pp.21-37, 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

- Z. Zhang, “A Flexible New Technique for Camera Calibration,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.22, pp.358-368, 2015.

-

C. H. Park and D. W. Lee “Calibrating a Depth Camera Based on Deep Learning of a 2D Planar Surface,” Transactions of KSAE, Vol.27, No.7, pp.521-527, 2019.

[https://doi.org/10.7467/KSAE.2019.27.7.521]

-

M. Oquab, L. Bottou, I. Laptev and J. Sivic, “Learning and Transferring Mid-level Image Representations Using Convolutional Neural Networks,” IEEE Conference on Computer Vision and Pattern Recognition, pp.1717-1724, 2014.

[https://doi.org/10.1109/CVPR.2014.222]

- K. He, X. Zhang, S. Ren and J. Sun, “Deep Residual Learning for Image Recognition,” IEEE Conference on Computer Vision and Pattern Recognition, pp.770-778, 2016.

- Mathworks, Inc, Matlab, Toolbox, Symbolic Math, 1993.

-

R. Padilla, S. L. Netto and E. A. B. Silva, “A Survey on Performance Metrics for Object Detection Algorithms,” IEEE Conference on Systems, Signals and Image Processing, pp.237-242, 2020.

[https://doi.org/10.1109/IWSSIP48289.2020.9145130]