CNN 기반 차량 밑면 중심점 검출을 통한 차량 위치 추정 정확도 개선

Copyright Ⓒ 2022 KSAE / 200-08

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper proposes a method to improve vehicle position accuracy by detecting its bottom face center(BFC) based on a convolutional neural network. The proposed method is implemented by simply adding only the heads for BFC detection after maintaining the architecture of the existing vehicle detector. The BFC is calculated based on the feature map obtained from the vehicle detector. In order for the network to detect the BFC, the origin and distance function must be defined. In this paper, eight combinations of two methods for the origin, and four methods for the distance function were compared and evaluated. The performance of the proposed method is quantitatively evaluated by using Euclidean distance error and normalized Euclidean distance error. The result of this study revealed that the proposed method shows a 94.6 % improvement in vehicle position accuracy, compared to the previous method.

Keywords:

Vehicle position estimation, Bottom face center, Deep neural network, Vehicle-to-infrastructure communication, Surveillance camera키워드:

차량 위치 추정, 밑면 중심점, 딥뉴럴네트워크, V2I 통신, 감시 카메라1. 서 론

운전자 보조 시스템(Driver Assistance Systems, DAS)은 운전자의 편의성을 높여주는 동시에 주행 부담을 덜어주는 기술로, 이를 위해서 주변 차량의 위치를 파악하는 것은 반드시 필요하다. 하지만 교차로와 같은 복잡한 상황에서 자차에 탑재된 센서만으로 이를 수행하는 것은 제한적이다.1) 이러한 문제점을 해결하기 위해, 최근 인프라가 차량을 검출하여 V2X 기술을 통해 이를 제공하는 접근법이 개발되고 있다.2) 검출 차량의 정보가 제공되는 방식은 정밀지도 상에 차량과 같은 동적 물체(Dynamic object)의 위치를 표시하는LDM(Local Dynamic Map) 방법 등이 주로 사용된다.3) 인프라가 차량을 검출하는 방법에는 Loop을 활용하는 방법22,23)과 라이다(Lidar)를 활용하는 방법,14-16) 카메라를 사용하는 방법4-11,17-21) 등이 있다. Loop은 설치 비용이 비싸고 라이다는 센서의 가격이 비싸기 때문에 카메라를 사용하는 방법이 선호된다.

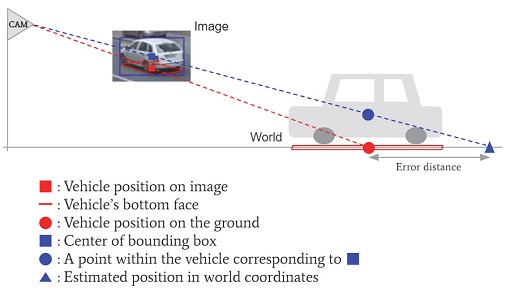

도로에 설치된 감시 카메라 영상에서 차량을 검출하고 위치를 파악하는 방법에는 경계 상자(Bounding box)의 중심24,25)을 검출하는 방법과 밑면 중심점을 검출하는 방법이 있다. 경계 상자의 중심을 검출하는 방법은 차량 검출 결과를 직접 사용하기 때문에 차량 위치 검출이 용이하지만, Fig. 1과 같이 오차 거리를 포함한 위치를 검출하게 된다.26) Fig. 1은 차량과 카메라 사이의 기하학적 관계에 의해 발생하는 오류를 나타낸다. 카메라로부터 획득한 영상(Image)에 표시된 파란색 사각형은 검출된 차량 경계 상자의 중심을 나타내고 빨간색 사각형은 차량 밑면의 중심을 표시한 것이다. 실세계에서 차량 위치는 빨간색 원으로 표시된 것처럼 지면 위의 한 점에 해당하며, 이는 밑면 중심점에 대응하는 실세계 좌표와 동일하다. 하지만 경계 상자 중심에 대응하는 실세계 좌표는 파란색 원으로 표시된 것처럼 지면에서 일정 높이 이상 떨어진 차량 내의 어느 한 지점과 카메라의 중심을 지나는 직선 위의 한 점이 된다. 경계 상자 중심을 차량 위치로 검출하는 경우 이 직선이 지면과 만나는 지점, 즉, Fig. 1의 파란색 세모가 차량 위치로 검출된다. 이는 그림에서 표시된 것처럼 오차거리를 포함한 위치이다. 경계 상자 중심을 보정할 수 있다면 정확한 차량 위치를 계산할 수 있지만, 차량의 위치에 따라 높이와 거리 사이 관계가 일정하지 않아 경계 상자 중심을 보정하는 것은 불가능하다. 따라서 차량의 정확한 위치를 파악하기 위해서는 밑면 중심점을 검출할 필요가 있다.

밑면 중심점 검출 방법은 기하학적 방법을 활용하는 방법과 딥뉴럴네트워크(Deep Neural Network, DNN)를 이용하는 방법으로 나눌 수 있다. 기하학적 방법을 활용하는 방법은 제약사항이 많다는 단점이 있다. Dubská 등6)는 차량의 윤곽선 정보가 획득된다는 전제 하에 3개의 소실점을 계산9) 하고 각 소실점으로부터 차량의 윤곽선에 접하는 선을 구함으로써 3차원 경계 상자를 생성하였다. Zhang과 Zhang4)은 Mask R-CNN으로 차량의 윤곽선 정보를 획득하고, 차선 정보를 활용하여 소실점을 계산한다. 이들로부터 Dubská 등6)과 같이 각 접선의 교점을 구해 3차원 경계 상자를 생성한다. 이렇게 차량의 에지 방향으로 소실점을 추정하는 것은 모든 차량이 일정한 방향으로 이동하는 것을 전제한다. 따라서 교차로와 같이 차량 방향이 다양하게 나타나는 경우에는 적용이 제한된다. 딥뉴럴네트워크를 활용하는 방법은 딥뉴럴네트워크를 통해 3차원 경계 상자 생성에 필요한 파라미터를 추정하는 방법,7,17-20) 3차원 경계 상자의 꼭지점을 키포인트로 검출하는 방법,10) 소실점을 검출하는 방법11) 등이 있다. Mousavian 등17)과 Gählert 등18)은 3차원 경계 상자의 자세(Pose)와 크기(Dimension) 정보를, Fang 등19)은 차량의 Viewpoint와 밑면 중심점이 영상으로 투영된 위치를 딥뉴럴네트워크로 알아내어 2차원 정보와 결합함으로써 3차원 경계 상자를 획득한다. Yang 등21)은 각각 2차원 경계 상자와 3차원 경계 상자 생성을 위한 파라미터를 추정하는 서브네트워크와 키포인트를 검출하는 서브네트워크가 조합되어 3차원 경계 상자를 생성한다. 이러한 접근법들은 네트워크 구조의 복잡도가 높아지고 수행시간을 증가시킨다.

본 논문은 기존 차량 검출용 딥러닝 아키텍처를 최대한 유지하면서 밑면 중심점 추정 헤드(Head)만을 추가함으로써 차량의 위치를 정확하게 추정하는 방법을 제안한다. 제안 방법을 사용하면 차량 검출기를 그대로 사용하면서, 추가적으로 밑면 중심점을 추정하는 것이 가능하다. 또한 차량의 진행 방향과 거리, 도로의 방향이 다양한 교차로 상황에서도 제안 방법이 적용 가능함을 실험적으로 확인하였다.

2. 제안 방법

제안 방법은 기존의 차량 검출기에 밑면 중심점을 검출하는 헤드(Head)를 추가함으로써 단순하게 구현된다. 본 논문에서는 다양한 물체 검출에 널리 사용되고 있는 Yolo v313)를 재학습하여 차량 검출기로 사용하였다. 추가된 밑면 중심점 검출 헤드는 완전 컨볼루션 계층(Fully convolutional layer)으로 이루어진다.

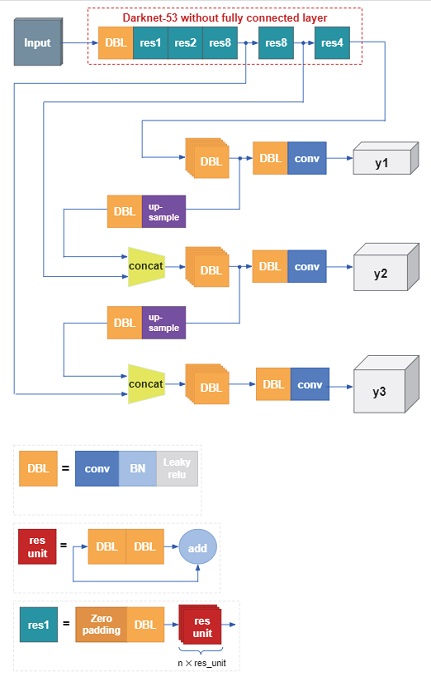

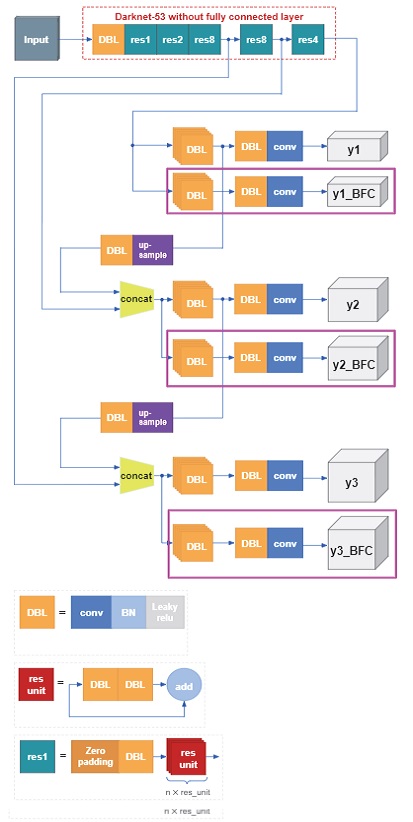

2.1 Yolo v3

본 논문에서 사용한 Yolo v3는 Yolo12)의 세번째 버전으로 Fig. 2와 같이 Darknet-53을 백본(Backbone)으로 사용하고 Feature pyramid network을 넥(Neck)으로 사용하여 서로 다른 크기의 Feature map 3개를 생성한 후 이에 헤드를 붙여 물체를 검출한다. 높은 해상도의 Feature map에서는 작은 물체를 검출하고 낮은 해상도의 Feature map에서는 큰 물체를 검출하는 방식으로 동작한다. Yolo v3는 Yolo와 같이 물체 검출을 회귀 문제로 접근하였다. 우선 입력 영상을 SⅹS 그리드 셀로 나누고 각 셀마다 후보 경계 상자를 여러 개 생성한다. 이 때 Yolo와 달리 Yolo v3에서는 서로 다른 3개의 스 케일에서 경계 상자를 생성한다. 출력되는 정보에는 경계 상자의 위치와 크기, 물체의 존재 여부, 클래스가 포함된다.

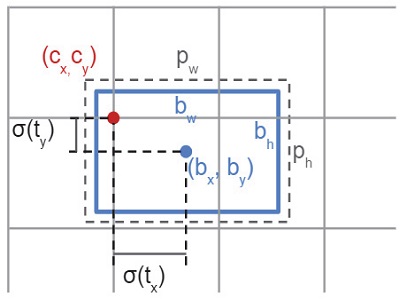

경계 상자의 위치와 크기 정보는 네트워크 출력(tx, ty, tw, th)으로부터 식 (1)과 같이 계산된다.

| (1) |

식 (1)의 bx, by, bw, bh는 각각 경계 상자의 위치와 크기를 나타낸다. Fig. 3과 같이 (bx, by)는 경계 상자의 중심점에 해당하고, (bw, bh)는 경계 상자의 너비와 높이에 해당한다. 경계 상자의 위치는 경계 상자의 중심점이 위치하고 있는 셀의 원점(cx, cy)에 경계 상자 중심까지의 거리 (σ(tx), σ(ty))를 더함으로써 표현된다. 여기서 σ는 시그모이드 함수이다. 경계 상자의 크기(bw, bh)는 anchor box의 크기(pw, ph)에 대한 비율(etw, eth)로 나타낸다. Fig. 3은 경계 상자 위치 표현 시 셀의 좌상단을 기준으로 한 경우이다.

Representation for the position and size of a bounding box. The blue rectangle is a bounding box where bw and bh are its width and height, respectively, and the black dotted rectangle indicates an anchor box whose width and height are pw and ph, respectively. The center of the bounding box is represented the blue dot (bx, by). The red dot (cx, cy) is an origin of a cell including the center of the bounding box

2.2 제안 시스템 구조

본 논문에서 제안하는 시스템은 차량 검출기로 사용되는 Fig. 2의 Yolo v3 구조에 Fig. 4와 같이 밑면 중심점 검출을 위한 헤드를 추가하여 구성된다. 밑면 중심점 검출은 추가된 헤드를 통해 각 스케일 별로 이루어진다. 추가된 헤드는 Fig. 4에서 자홍색 사각형으로 표시된 부분으로, 생성된 Feature map은 밑면 중심점을 뜻하는 약자인 BFC(Bottom Face Center)로 표시하였다.

Architecture of the proposed system. Three heads were added to Yolo v3 to detect the center of the bottom face. The added heads are highlighted with magenta squares

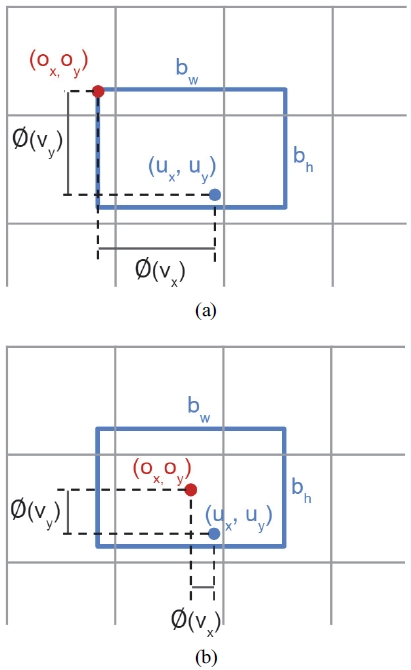

경계 상자의 위치 표현 방법과 같이 밑면 중심점 또한 원점과 원점으로부터 떨어진 거리로 표현할 수 있다. 본 논문에서는 밑면 중심점 좌표 표현을 위한 원점을 경계 상자를 기준으로 하여 설정하였다. 이를 위해 네트워크 학습 과정에서는 경계 상자 Ground Truth(GT)가 사용되고, 추론 과정에서는 검출된 경계 상자 정보를 사용하게 된다. 추정된 밑면 중심점 좌표(ux, uy)가 각 좌표축을 따라 원점(ox, oy)으로부터 떨어진 거리를 함수 ∅(vx)와 ∅(vy)로 표현한다면, 식 (2)와 같이 표현된다.

| (2) |

이때, vx와 vy는 네트워크의 출력이다. 본 논문에서는 (ox, oy)를 설정하는 두 가지 방식과 함수 ∅를 설정하는 네 가지 방식을 실험을 통해 비교 평가하였다.

네트워크 학습 시, 차량 검출기 부분은 고정된 상태로 두고(Freeze) 추가된 헤드만 학습시켰다. 이때 Loss는 식 (3)과 같이 MSE(Mean Squared Error)를 사용하였다.

| (3) |

여기서 L은 손실값, n은 데이터 수, xi, yi와 ux,i, uy,i는 각각 i번째 데이터의 GT와 예측된 밑면 중심점 좌표이다.

3. 실 험

본 논문에서 제안하는 방법은 앞서 설명된 바와 같이, 차량 검출기 부분은 고정된 상태에서 추가된 헤드에 대해서만 학습이 진행되므로 차량 검출 Average Precision(AP)은 유지된다.

3.1 데이터 세트

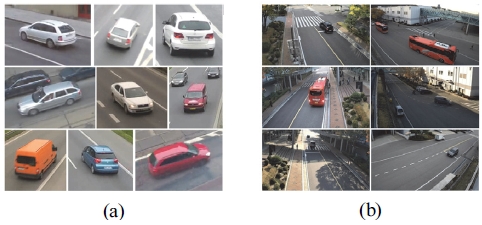

제안된 시스템의 학습과 평가에는 공용 데이터 세트인 BoxCars116k9)와 서로 다른 장소에 설치된 감시카메라로부터 직접 획득한 데이터 세트를 함께 사용하였다.

BoxCars116k 데이터 세트는 총 116,000여장의 영상에 대한 카메라 정보, 2차원 경계 상자 정보와 3차원 경계 상자 정보 등을 포함한다. Fig. 5(a)에서 보이는 바와 같이, 해당 데이터 세트에 포함된 각 영상은 차량을 중심으로 여백이 포함된 패치 영상 형태이다. 영상 한 장당 차량 한 대가 등장하며 3차원 경계 상자 8개 꼭지점의 영상 좌표가 포함되어 있다. 해당 데이터 세트는 차량과 경계 상자가 어긋나는 등 부정확한 경우가 있어, 정확한 정보가 포함된 데이터를 선별하여 학습과 평가에 사용하였다.

자체 획득 데이터 세트는 Fig. 5(b)와 같이 도로에 설치된 감시 카메라로부터 획득한 영상이다. 데이터 획득 장소는 일반 도로가 아닌 회사 또는 공장 부지 내에 있는 도로로서 차량 통행량이 많지 않다. 하지만 승용차 이외에도 버스, 트럭과 같은 특수 차량이 자주 등장한다는 특징이 있다. 해당 데이터 세트는 다양한 장소와 시간대에서 획득되었다. 학습과 평가에 사용된 각 데이터의 수는 Table 1과 같다.

3.2 네트워크 학습 방법

본 실험에서는 제안된 시스템의 밑면 중심점 계산 방법을 다양하게 설정하여 서로 다른 방법으로 학습 후 비교 평가하였다. 총 8 가지 방법으로 정의된 밑 면 중심점 계산 방법은 셀의 원점을 정의하는 방법 2종류와 셀 원점과 밑면 중심점 사이의 거리를 정의하는 방법 4종류의 조합으로 이루어진다. 학습률은 실험적으로 정해진 값을 사용하였고, 코사인 어닐링(Cosine annealing)을 기반으로 점점 감쇄되는 형태로 변화시켰다.

밑면 중심점 검출을 위한 네트워크 학습을 위해서는 네트워크에서 생성된 Feature map으로부터 밑면 중심점의 좌표 값을 출력하기 위한 원점을 정의하는 것이 우선되어야 한다. 본 논문에서는 Fig. 6(a)와 (b)의 빨간색 점들과 같이 경계 상자의 좌측 상단과 경계 상자의 중심을 원점으로 설정하는 2가지 방법을 비교하였다. Fig. 6의 (ox, oy)는 정의된 원점의 좌표, (ux, uy)는 밑면 중심점 좌표를 의미한다. 이 두 점 사이의 거리는 영상의 좌표축인 x축과 y축을 따라 각각 함수 ∅(vx)와 ∅(vy)로 정의된다. 여기서 vx와 vy는 네트워크의 출력이다. 본 논문에서는 위치 차이를 나타낼 수 있는 다양한 방법 중 다음과 같은 4가지 방법을 비교하였다.

Description of the vehicle bottom face center. Red and blue circles indicate origins and bottom face centers, respectively. (a) Shows the case where the top left of the bounding box is used as the origin, (b) Shows the case where the center of the bounding box is used as the origin

- 1) 함수의 입력 값에 대한 항등 함수로 정의

| (4) |

- 2) 함수의 입력 값에 대한 대수적 표현으로 정의

| (5) |

- 3) 함수의 입력 값이 경계 상자의 크기에 대한 비율로 위치 차이를 표현하도록 정의

| (6) |

이때, bw, bh는 식 (1)에서 정의한 경계상자의 폭과 높이를 의미한다.

- 4) Sigmoid 함수가 적용된 입력 값이 경계 상자의 크기에 대한 비율로 위치 차이를 표현하도록 정의

| (7) |

3.3 성능 평가

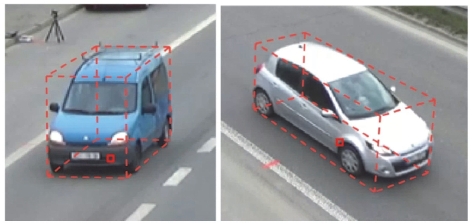

성능 평가에 사용되는 차량 위치는 Fig. 7의 빨간색 사각형과 같이 차량이 지면에서 차지하는 사각형 영역의 중심점으로 정의된다. 이 위치는 차량의 3차원 경계 상자가 Fig. 7의 빨간색 점선과 같이 생성되면 그 중 밑면의 중심에 해당한다.

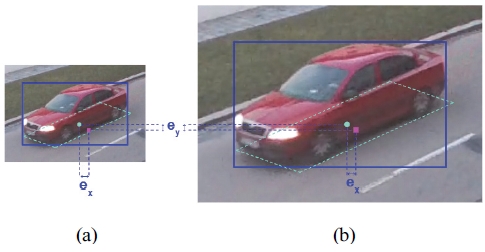

성능 평가에는 두 가지 기준이 사용된다. 첫번째 평가 기준은 영상 상에서 GT 차량 위치와 검출된 차량 위치 사이의 평균 유클리드 거리로 계산되는 위치 오차이다.

| (8) |

여기서 xi와 yi는 차량 위치에 대한 GT, 과 은 예측된 차량 위치이고, n은 전체 데이터의 수이다.

영상에서 차량의 크기는 차종 또는 카메라로부터의 거리에 따라 다양하게 나타난다. 식 (8)을 사용하는 경우, 촬영된 물체의 영상 내 크기와 관계없이 오차가 계산된다. Fig. 8은 이러한 예를 보여준다. 이 그림에서 (a)는 원거리 차량이 영상에 작게 촬영된 경우이고, (b)는 근거리 차량이 영상에 크게 촬영된 경우이다. 두 상황에서 계산된 위치 오차 ex와 ey는 동일하지만, 픽셀 단위의 위치 오차를 미터 단위로 변경하게 되면 (a)의 위치 오차가 (b)보다 크게 될 것이다. 이와 같은 한계를 극복하기 위하여 본 논문에서 사용한 두번째 성능 평가 기준은 식 (9)와 같이 오차거리를 물체의 크기로 정규화 하는 방법이다.

| (9) |

Limitation of the simple Euclidean distance. (a) Shows the case where the distant vehicle is captured with a small pixel size, and (b) Shows the case where the close vehicle is captured with a large pixel size. Cyan circles and magenta squares indicate true and estimated bottom face centers, respectively

여기서 ex, ey는 각각 좌표 축을 따라 발생한 오차이며 W와 H는 경계 상자의 너비와 높이이다. 오차 거리 ex, ey를 각각 경계 상자의 너비와 높이로 나누어 계산된 오차 enorm은 1 × 1 픽셀로 정규화 된 경계 상 자에서 발생한 오차 크기를 의미한다. 따라서 정규화 된 오차는 영상에 촬영된 물체의 크기를 반영한 기준이 된다. 위의 식 (9)를 기반으로 한 정규화 된 오차 거리 계산식은 다음과 같다.

| (10) |

식 (10)에서 xi와 yi는 차량 위치 GT, 과 은 예측된 차량 위치, n은 전체 데이터 수이다.

제안된 시스템을 두 기준으로 평가한 결과는 Table 2에서 볼 수 있다. 좌측 두 열은 이전에 정의한 좌표 표현을 위한 두가지 원점 정의 방법과 네가지 거리 함수 정의 방법을 의미한다. 그리고 첫번째 기준인 정규화 되지 않은 오차 거리 결과는 세번째 열에, 정규화 된 오차 거리 결과는 마지막 열에 나타난다. 총 8 조합에 대한 실험 결과 설명을 용이하게 하기 위해, Table 2의 첫번째 행부터 순차적으로 조합 1, 조합 2, 조합 3과 같이 칭하겠다.

Table 2에서 확인할 수 있듯이, 정규화 되지 않은 오차가 평가 기준인 경우 우수한 성능을 보인 상위 세 조합은 조합 7, 조합 5 그리고 조합 4 이다. 반면, 정규화 오차가 평가 기준인 결과에서는 조합 5, 조합 4, 조합 7 순서로 성능이 우수하게 나타난다.

정규화 없이 오차가 계산된 첫번째 평가 기준의 경우, 가장 작은 오차를 보인 방법은 조합 7로 경계 상자의 중심을 원점으로 설정한 뒤 검출된 좌표까지의 거리 함수를 세번째 정의인 경계 상자 크기에 대한 비율로 표현한 방법이다. 이 경우 평균 1.4122 픽셀의 오차거리로 가장 좋은 성능을 보였다. 하지만 오차를 정규화 한 두번째 평가 기준을 적용한 결과에서는 원점을 경계 상자의 중심으로 동일하게 설정하지만 거리 함수를 항등 함수로 정의한 조합 5에서 가장 좋은 성능을 보였다. 좌표 표현을 위한 원점과 거리 함수 정의 방법의 조합에 따라 정규화 없이 오차를 계산할 경우 가장 우수한 경우와 가장 저조한 경우의 성능 차이가 최대 26.6 % 발생했다. 정규화 된 오차를 계산할 경우는 최대 25.0 %의 성능 차이를 보였다.

Table 3은 경계 상자의 중심점을 차량 위치로 사용하는 기존 방법24,25)과 가장 우수한 성능을 보인 제안 방법(조합5)의 정규화 된 위치 추정 오차를 비교한 것이다. 기존 방법의 경우 정규화 된 오차 거리가 평균 0.2753 픽셀인데 반해 제안 방법의 경우 0.0149 픽셀로 약 94.6 % 개선되었다.

제안 방법과 기존 방법에 의한 차량 위치 검출 결과는 Fig. 9와 같다. 그림에서 초록색 십자 표시는 제안 방법, 파란색 사각형은 기존 방법(경계 상자 중심), 마지막으로 빨간색 사각형은 GT의 차량 위치를 나타낸다. Fig. 9로부터 제안 방법은 다양한 차종, 서로 다른 차량 크기와 방향, 포즈에서도 밑면 중심점 위치 검출에 성공함을 알 수 있다. Table 4는 차량 포즈 변화에 따른 검출 성능을 비교한 것이다. 차량 진행 방향을 좌측, 정면, 우측 세 경우로 나누고 각 상황 별로 정규화된 오차를 계산한 것이다. 이는 3차원 경계 상자 GT가 제공되는 BoxCars116k 데이터의 결과이다. Table 4에서 알 수 있듯이, 제안 방법은 차량이 정면을 바라보는 경우 가장 큰 오차를 보이며 다른 두 경우에는 비슷한 수준의 오차를 보인다. 이와 달리 기존 방법은 차량 포즈와 관계없이 유사한 오차 수준을 가진다. 이는 차량이 정면에 가까울수록 영상에서 차량 밑면이 잘 보이지 않기 때문에 제안 방법은 차량 포즈에 영향을 받음을 의미한다. 반면 기존 방법은 차량 검출 결과를 사용하므로 차량 포즈에 크게 영향을 받지 않게 된다.

Detection results of the proposed and existing method. Blue and red squares indicate the vehicle positions detected by the existing method and ground truth, respectively. Green crosses indicate the vehicle positions detected by the proposed method

Fig. 9에서 제안 시스템의 출력과 GT는 매우 인접한 데 반해, 기존 방법의 출력은 GT와 상당히 떨어져 있음을 확인할 수 있다. 더욱이, 기존 방법의 출력과 GT 사이 관계가 일정하지 않음을 확인할 수 있는데, 이는 일률적인 보정이 불가능함을 의미한다.

본 논문에서는 학습 데이터 세트에서 구해지는 밑면 중심점의 평균을 모든 차량의 밑면 중심점으로 가정하는 방법의 성능을 추가로 비교 평가하였다. 밑면 중심점은 데이터 세트 별로 계산되었으며, 경계 상자의 종/횡방향 상대 좌표를 0에서 1 사이 값으로 표현하였다. 평균 밑면 중심점을 이용한 성능 평가 결과, 정규화된 오차는 0.0528로 경계 상자 중심을 그대로 사용했던 기존 방법보다 개선된 결과를 획득하였다. 하지만 여전히 제안 방법의 오차인 0.0149에 비해 부족한 결과를 보였다.

Table 2에서 평가 기준에 따라 성능 순위가 변화한 것처럼 밑면 중심점 검출 평가 결과 또한 평가 기준에 따라 다른 양상을 보인다. Fig. 10에서 (a)는 검출 결과 중 정규화 오차가 큰 영상의 예시이고, (b)는 정규화 되지 않은 오차가 큰 예시 영상이다. 정규화 된 오차에서 큰 값을 보이는 경우는 대부분 영상에 나타나는 차량의 크기가 작은 경우이다. 이에 반해 정규화 되지 않은 오차에서 큰 값이 나타나는 경우는 대부분 영상 속 차량의 크기가 큰 경우이다. 이는 앞서 설명된 오차 정규화의 필요성을 잘 보여준다. 제안 시스템은 조감도 상의 차량 위치를 사용하는 응용 분야를 가정했는데, 그러한 관점에서는 영상 상의 위치 오차보다는 실세계에서의 밑면 중심점 오차가 더 중요하다. 다만, 실세계 거리 오차를 직접적으로 측정할 방법의 확보가 곤란할 때, 차량의 크기에 대한 상대적 비율을 사용하면 비슷한 효과를 거둘 수 있을 것으로 예상된다.

Detection results with large errors. Blue and red squares indicate the vehicle positions detected by the existing method and GT, respectively. Green crosses indicate the vehicle positions detected by the proposed method. (a) Cases with large average normalized errors, (b) Cases with large average errors

4. 결 론

본 논문은 감시 카메라로 촬영한 영상에서 차량 위치 검출의 정밀도를 개선하기 위해 딥뉴럴네트워크를 기반으로 차량 밑면 중심점을 검출하는 방법을 제안한다. 기존에 사용되던 경계 상자의 중심점을 차량 위치로 사용하는 방법은 계산이 단순하지만 실세계 좌표계로 변환 시 위치 오차를 발생시킨다는 한계가 있다. 제안 방법은 기존 차량 검출용 딥러닝 아키텍처에 차량 밑면 중심 검출 헤드를 추가함으로써 차량 위치 검출의 정밀도를 개선하였다. 제안 방법은 기존 차량 검출기를 그대로 사용하고 추가된 헤드 부분만을 학습시키기 때문에, 차량 검출 성능을 유지할 수 있고 학습의 난이도를 낮출 수 있다. 밑면 중심점 좌표는 기준이 되는 원점과 두 점 사이의 거리 함수를 다양하게 정의하고 이를 조합하여 비교하였다. 실험 결과 경계 상자의 중심을 원점으로 하고 거리 함수를 항등 함수로 정의하였을 때 가장 우수한 정규화 오차를 획득하였으며, 기존 방법 대비 약 94.6 % 개선된 위치 추정 결과를 보였다.

Acknowledgments

A part of this paper was presented at the KSAE 2021 Spring Conference

본 연구는 국토교통부 국토교통기술사업화지원사업의 연구개발비지원(22TBIP-C161428-02)에 의해 수행되었습니다.

References

-

G. N. Bifulco, B. Caiazzo, A. Coppola and S. Santini, “Intersection Crossing in Mixed Traffic Flow Environment Leveraging V2X Information,” 2019 IEEE International Conference on Connected Vehicles and Expo, pp.1-6, 2019.

[https://doi.org/10.1109/ICCVE45908.2019.8965228]

- S. M. Wi, K. Choi, H. G. Jung, J. K. Suhr and D. Kim, “Optimization of YOLOv3 for Real-Time Embedded Systems,” KSAE Spring Conference Proceedings, pp.965-971, 2021.

-

S. Lefèvre, D. Vasquez and C. Laugier, “A Survey on Motion Prediction and Risk Assessment for Intelligent Vehicles,” ROBOMECH Journal, 2014.

[https://doi.org/10.1186/s40648-014-0001-z]

-

B. Zhang and J. Zhang, “A Traffic Surveillance System for Obtaining Comprehensive Information of the Passing Vehicles Based on Instance Segmentation,” IEEE Transactions on Intelligent Transportation Systems, Vol.22, No.11, pp.7040-7055, 2021.

[https://doi.org/10.1109/TITS.2020.3001154]

-

R. Zeng, Z. Ge, S. Denman, S. Sridharan and C. Fookes, “Geometry-constrained Car Recognition Using a 3D Perspective Network,” 34th AAAI Conference on Artificial Intelligence, pp.1161-1168, 2020.

[https://doi.org/10.1609/aaai.v34i01.5468]

-

M. Dubská, A. Herout and J. Sochor, “Automatic Camera Calibration for Traffic Understanding,” Proceedings of the British Machine Vision Conference, BMVA Press, 2014.

[https://doi.org/10.5244/C.28.42]

-

V. Kocur and M. Ftáčnik, “Detection of 3D Bounding Boxes of Vehicles using Perspective Transformation for Accurate Speed Measurement,” Machine Vision and Applications, Vol.31, p.62, 2020.

[https://doi.org/10.1007/s00138-020-01117-x]

-

H. Bradler, A. Kretz and R. Mester, “Urban Traffic Surveillance(UTS): A Fully Probabilistic 3D Tracking Approach based on 2D Detections,” 2021 IEEE Intelligent Vehicles Symposium(IV), pp.1198-1205, 2021.

[https://doi.org/10.1109/IV48863.2021.9575140]

-

M. Dubská, A. Herout, R. Juránek and J. Sochor, “Fully Automatic Roadside Camera Calibration for Traffic Surveillance,” IEEE Transactions on Intelligent Transportation Systems, Vol.16, No.3, pp.1162-1171, 2015.

[https://doi.org/10.1109/TITS.2014.2352854]

-

X. Ren, X. Wang and P. Wang, “Vehicle Positioning Method of Roadside Monocular Camera,” 2020 IEEE MTT-S International Wireless Symposium, pp.1-3, 2020.

[https://doi.org/10.1109/IWS49314.2020.9360114]

-

J. Sochor, J. Špaňhel and A. Herout, “BoxCars: Improving Fine-Grained Recognition of Vehicles using 3D Bounding Boxes in Traffic Surveillance,” IEEE Transactions on Intelligent Transportation Systems, Vol.20, No.1, pp.97-108, 2018.

[https://doi.org/10.1109/TITS.2018.2799228]

-

J. Redmon, S. Divvala, R. Girshick and A. Farhadi, “You Only Look Once: Unified, Real-Time Object Detection,” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.779-788, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

- J. Redmon and A. Farhadi, “Yolov3: An Incremental Improvement,” arXiv preprint arXiv:1804.02767, , 2018.

-

T. Yin, X. Zhou and P. Krähenbühl, “Center-based 3D Object Detection and Tracking,” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.11784-11793, 2021.

[https://doi.org/10.1109/CVPR46437.2021.01161]

-

H. Zhang, H. Ji, A. Zheng, J. N. Hwang and R. H. Hwang, “Monocular 3D Localization of Vehicles in Road Scenes,” 2021 IEEE/CVF International Conference on Computer Vision Workshops, pp.2855-2864, 2021.

[https://doi.org/10.1109/ICCVW54120.2021.00320]

-

X. Chen, H. Ma, J. Wan, B. Li and T. Xia, “Multi-view 3D Object Detection Network for Autonomous Driving,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.1907-1915, 2017.

[https://doi.org/10.1109/CVPR.2017.691]

-

A. Mousavian, D. Anguelov, J. Flynn and J. Košecká, “3D Bounding Box Estimation using Deep Learning and Geometry,” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.7074-7082, 2017.

[https://doi.org/10.1109/CVPR.2017.597]

-

N. Gählert, J. J. Wan, N. Jourdan, J. Finkbeiner, U. Franke and J. Denzler, “Single-shot 3D Detection of Vehicles from Monocular Rgb Images Via Geometrically Constrained Keypoints in Real-time,” In 2020 IEEE Intelligent Vehicles Symposium(IV), pp.437-444, 2020.

[https://doi.org/10.1109/IV47402.2020.9304847]

- J. Fang, L. Zhou and G. Liu, “3D Bounding Box Estimation for Autonomous Vehicles by Cascaded Geometric Constraints and Depurated 2D Detections using 3D Results,” arXiv preprint arXiv:1909.01867, , 2019.

- B. Li, W. Ouyang, L. Sheng, X. Zeng and X. Wang, “Gs3d: An Efficient 3D Object Detection Framework for Autonomous Driving,” In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp.1019-1028, 2019.

-

W. Yang, Z. Li, C. Wang and J. Li, “A Multi-task Faster R-CNN Method for 3D Vehicle Detection Based on a Single Image,” Applied Soft Computing, Vol.95, Paper No.106533, 2020.

[https://doi.org/10.1016/j.asoc.2020.106533]

-

D. Guilbert, S. S. Ieng, C. Le Bastard and Y. Wang, “Robust Blind Deconvolution Process for Vehicle Reidentification by an Inductive Loop Detector,” IEEE Sensors Journal, Vol.14, No.12, pp.4315-4322, 2014.

[https://doi.org/10.1109/JSEN.2014.2345755]

-

P. Burnos, J. Gajda, Z. Marszalek, P. Piwowar, R. Sroka, M. Stencel and T. Żegleń, “Road Traffic Parameters Measuring System with Variable Structure,” Metrology and Measurement Systems, Vol.18, pp.659-666, 2011.

[https://doi.org/10.2478/v10178-011-0062-8]

-

C. Wang and A. Musaev, “Preliminary Research on Vehicle Speed Detection using Traffic Cameras,” 2019 IEEE International Conference on Big Data (Big Data), pp.3820-3823, 2019.

[https://doi.org/10.1109/BigData47090.2019.9006233]

-

P. Giannakeris, V. Kaltsa, K. Avgerinakis, A. Briassouli, S. Vrochidis and I. Kompatsiaris, “Speed Estimation and Abnormality Detection from Surveillance Cameras,” In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, pp.93-99, 2018.

[https://doi.org/10.1109/CVPRW.2018.00020]

- G. Kim, H. G. Jung and J. K. Suhr, “Improvement of Vehicle Position Estimation using Deep Learning-based Vehicle Underside Center Estimation,” KSAE Spring Conference Proceedings, pp.931-932, 2021.