도심 자율주행을 위한 LiDAR 기반 실시간 객체 거동 예측

Copyright Ⓒ 2022 KSAE / 200-07

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

There are many cut-in/out and other unexpected situations in the urban setting, so the ability to predict the behavior of nearby objects and to perform algorithms in real time has become important. This is because it is possible to prepare an appropriate real-time response strategy through judgment and control according to the object’s behavior. Therefore, in this paper, two methods for securing real-time stability of self-driving vehicles in the city center are proposed. First, an object tracking method is proposed by using a behavior model-based Kalman filter for location tracking, and a Kalman filter for predicting object speed and behavior. Second, a method for predicting and updating the position of an object at a period of up to 40 hertz by supplementing a lidar sensor with a low period by using the posture data of the vehicle is proposed. This method can be cross-validated through simulation and by using the KITTI benchmark.

Keywords:

LiDAR, Object tracking, Kalman filter, Velocity estimation, Behavior prediction키워드:

라이다, 객체 추적, 칼만 필터, 속도 예측, 거동 예측1. 서 론

인지는 주변 환경, 차선 등 자율주행 자동차에 필요한 각종 데이터를 수집하는 단계로서, 정확한 판단과 제어가 이루어지기 위한 가장 기본적이며 중요한 기술로 인식되고 있다. 자율 주행에서 인지1-3)기능을 위해 사용되는 센서는 카메라, 레이더, 라이다, GPS, IMU 등이 있는데, 이 센서들 가운데 주로 객체를 인지할 때 자주 사용되는 센서로는 카메라와 라이다가 있다.

레벨4 이상의 자율주행 차량을 구현하려면 주변 환경 정보를 인식하는 센서의 성능 뿐만 아니라, 여러 센서가 지닌 장 단점을 파악하고, 서로 보완할 수 있는 센서들을 결합하여 안정성과 신뢰성을 확보하여야 한다. 추가적으로 검출 알고리즘 뿐만 아니라 다음 거동을 예측하는 추적 알고리즘 또한 중요하게 대두되고 있다. 또한 통신 등과 같은 차량 외부의 인프라를 활용하는 차량 통신(V2X), 고정밀 지도(HDMAP)4) 등을 통해 센서와 관련된 현실적인 한계를 극복하는 기술이 필요하다.

추적과 관련된 접근법으로는 칼만 필터18-20)와 딥러닝21) 등이 많이 사용된다. 최근 딥러닝 기법의 발달로 추적에서도 딥러닝을 사용하곤 있지만, 아직 더 많은 검증이 이루어져야 한다. 칼만 필터 기반 추적은 인지 중에 발생 되는 잡음을 처리하고, 객체의 위치를 예측하고, 측정할 수 있는 알고리즘으로, 매우 간단함에도 불구하고, 효과적이고 실용적인 객체 추적 알고리즘이다.

객체 추적하는 기존 연구로는 카메라를 이용한 딥러닝 기반 추적 연구11-13)가 있다. 이는 이미지에서의 물체 인식 성능의 빠른 발전으로 인해, 다중 객체 추적 연구 또한 딥러닝을 이용하여, 물체 추적의 정확성이 향상되었다. 하지만, 이미지이기 때문에, 정확한 다중 객체의 실체 위치 예측과는 종 방향 오차가 컸으며, 실시간 처리에 적합하지 않는 모습을 보였다.

추가적으로, 객체의 거동을 실시간으로 추적에 용이한 대표적인 센서인 레이더를 통해 영역별 칼만필터를 적용하여 객체를 추적하였지만, 회전 상황이나, 다중 객체를 인지하는 데에는 불안정한 모습을 보였다.

센서의 한계를 보완하기 위해 최근 라이다 센서의 위치 정보를 이용한 다중 객체 추적 연구14-17)도 이어지고 있다.

Dewan 등5)에서는 라이다 센서를 이용한 UKF(Unscented Kalman Filter) 기반 다중 객체 추적 기법을 구현하였지만, 자율 주행과 같이 실시간으로 관찰 위치가 변화되는 상황 등에 대한 고려가 되지 않고, 객체의 속도를 일정하다고 가정한다는 한계점이 존재한다.

Zhang 등6)은 객체 추적 시 기준이 되는 점이 바뀌었을 때 또한 강인한 객체 인식 및 추적에 관한 연구를 하였으며, 실제 자율주행 차량을 이용하여, 도심 환경에서 실시간 처리에 응용하였다. 하지만, 객체의 절대 속도와 상대 속도와 같은 거동을 예측하는 것은 고려가 되지 않았다.

Abdul Fachman7)에서는 라이다를 이용하여 다중 객체의 추적은 하였으나, 객체의 거동을 추적하기 보다는 객체의 거동 속도를 나누어 단순히, 정적 객체인지, 동적 객체인지에만 국한하여 사용하였다.

객체의 거동을 예측 추적함으로써, 그에 따른 차량의 판단과 제어로 알맞은 대응 전략을 마련할 수 있기 때문에 중요성이 늘어나고 있다.

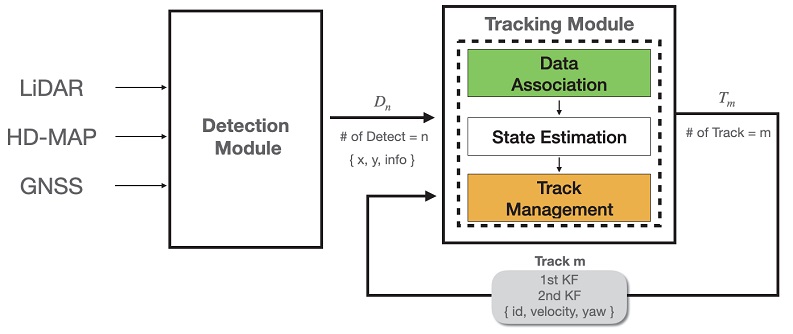

따라서 본 연구는 Fig. 1과 같이 도심 자율 주행 차량 환경에서 LiDAR, GNSS 및 고정밀 지도를 이용한 주변 객체 인식 데이터를 기반으로 객체 거동 예측을 위한 칼만 필터를 추가하여 추적하는 방식을 제안한다.

2. 객체 추적을 위한 객체 인지

객체 추적을 위해서는 센서를 통해 객체가 인지된 정보를 필요로 한다. 특히 Cut-in/out과 같은 돌발 상황이 많이 발생하는 도심 환경에서는 객체 인지 성능이 보장되어야 하기 때문에, 딥러닝과 그리드 기반 객체 인지를 통해 객체를 인지하고자 한다.

Fig. 1에서의 Detection module(인지 모듈)에서 사용하는 센서는 LiDAR, GNSS와 HD-MAP을 사용한다. 주변 환경을 인지하는 LiDAR 센서를 통해 Pointcloud를 얻게 된다. 이를 통해 딥러닝 인지 네트워크와 제안하는 그리드 기반 인지 알고리즘을 적용하여 객체를 검출하게 된다. GNSS 센서는 검출된 객체의 지역 중심 좌표와 GNSS를 통해 전역 중심 좌표를 구할 때 사용한다. 마지막으로 HD-MAP은 그리드 기반 인지 알고리즘을 적용할 때, 유효한 도로 영역을 검출하기 위해 사용된다.

2.1 오픈 플랫폼의 딥러닝 기반 라이다 객체 인지

오픈 플랫폼이란 오픈 표준을 기반으로 하는 소프트웨어 시스템을 의미한다. 이 소프트웨어 시스템은 외부 사용자가 소스 코드를 추가 수정하지 않아도, 원래의 프로그래머가 의도한 함수를 사용할 수 있으며, 이를 기반으로 새로운 기능을 추가 구현할 수 있게 만든 시스템이다. 그래서 본 연구에서는 자율 주행 오픈 플랫폼인 Baidu 사의 Apollo 플랫폼의 객체 인지 알고리즘을 사용하게 되었다.

Apollo는 오픈 소스 자율 주행 구현을 위한 플랫폼으로써, 클라우드 데이터 서비스, 소프트웨어, 차량 및 하드웨어 플랫폼을 포함하는 서비스 솔루션을 제공하고 있다. 그중 본 연구에서는 LiDAR 기반 객체 인지 모듈을 이용한다. Apollo에서는 테스트를 위한 Velodyne 64채널 LiDAR로 학습된 모델을 제공하지만 네트워크 학습을 위한 Loss function이나 과정을 제공하지 않기 때문에 따로 학습은 진행하지 않고 사용하였다.

2.2 실시간 그리드 맵 객체 인지

2.1절에서 언급한 딥러닝 기반 객체 인지 알고리즘의 불확실성을 제거하고, 정확성과 실시간성을 보장하기 위해 다음과 같은 방법을 사용하였다.

먼저 도로 영역이 아닌 곳에 존재하는 불필요한 데이터를 제거한다. 때문에 본 연구에서는 고 정밀 지도(HD-Map)을 사용하여 라이다 전처리를 진행하였다. 앞서 Fig. 1의 시스템 구성도의 인지 모듈의 ROI filter 작업을 의미한다.

고정밀 지도는 차선, 표지판 등을 사전에 제작한 전자 지도로, 센서 인지가 어렵거나, 성능 향상 등 센서 인지의 한계성을 극복하는 방법으로써 사용될 수 있다. 고정밀 지도는 UTM 좌표계를 기반으로 국토 교통부에서 제작 및 배포하였으며, 도로 영역과 비 도로 영역을 구분하기 위해 라벨링 규칙을 포함하였다.

본 연구에서는 도로 영역 뿐만 아니라, 주행 경로가 아닌 도로 영역도 제거하였으며, Segmentation 기법을 이용하여 ROI(Region of Interest) filter를 진행하였다.

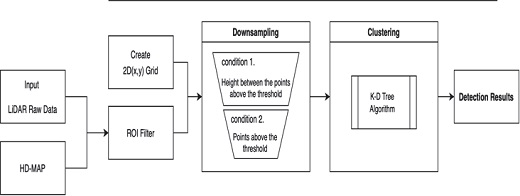

Fig. 2는 그리드 맵 객체 인지 알고리즘의 구성도로서, 객체의 특징은 지면과의 높이 차이가 크다는 특성과, LiDAR 데이터의 z축 정보를 이용하여 객체를 인지한다. 추적부 관심 영역 지정 이 후 2D(x, y) 그리드를 만들어. LiDAR 데이터를 3D(x, y, z) 좌표를 2D(x, y)로 투영시킨다. 그 뒤, 그리드 내부 샘플링 과정에서 그리드 내에서 포인트들이 일정 개수 이상이며, 일정 높이 차이 이상일 때 하나의 2D(x, y) 포인트로 다운샘플링한다. 이를 통해 지면과 같이 높이 차이가 나지 않는 영역들이 제거 된다. 마지막으로 물체 후보군을 검출하기 위해 Pcl library9)의 k-d tree 알고리즘을 적용한 클러스터링 작업 이후 추적부에 전달이 된다.

3. 다중 필터 기반 객체 추적

추적 모듈의 입력은 인지 모듈의 출력으로서 예측 주기 갱신을 위해 GNSS 센서를 추가 사용하게 된다. 이를 통해 기존 라이다 센서의 주기인 10 Hz 보다 빠른 주기로 출력됨으로 써, 실시간성을 보장한다.

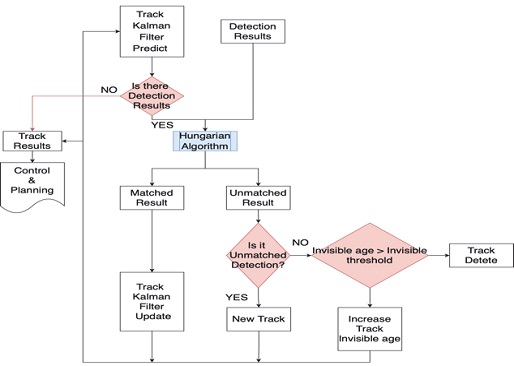

추적 모듈은 칼만 필터를 이용한 추적 기법을 사용한다. 칼만 필터는 과거에 수행한 측정값을 바탕으로 현재의 상태 변수의 결합 분포를 추정하는 것으로 칼만 필터를 사용함으로써, 객체 인지 시 발생하는 잡음을 처리하는데 도움을 준다. 또한 객체 추적은 물체가 순간적으로 사라지거나 나타나지 않는 선형적 특징을 가지고 있기 때문에 칼만 필터를 이용해 객체 추적에 많이 사용되고 있다.10) Fig. 3과 같이 다중 객체에 대한 추적 관리 시스템을 구성하여 추적기를 생성, 갱신, 삭제를 관리하였다.

3.1 위치 추정을 위한 선형 칼만필터 기반 객체 추적

칼만 필터에서 추정 값 도출할 때 가장 중요한 변수는 칼만 이득(K)이다. 하지만 이 칼만 이득 값은 사용자가 직접 정하는 변수가 아니라, 수식에 의해서 계산된 값이다. 하지만 식 (1)을 보면 칼만 이득에 영향을 주는 사용자 변수 Q, R이 존재하는 것을 알 수 있다.

| (1) |

| (2) |

- Where Kk : Kalman Gain; Pk: error covariance value, (n x n) matrix

이 때 Q는 시스템 잡음, R은 센서 잡음을 의미하게 된다. Q는 식 (2)를 통해 K와 비례 관계인 것을 알 수 있고, 식 (1)을 통해 R은 K와 반비례 관계인 것을 알 수 있다. 즉, Q 가 크게 되면 칼만 이득이 증가하게 되고, 칼만 필터는 시스템에 잡음이 많은 것으로 알고 추정하는 값에 대한 비중을 줄이고 센서 값을 더 신뢰하게 된다. 또한 R이 크게 되면 칼만 이득은 줄어들고, 칼만 필터는 센서에 잡음이 많기 때문에 센서의 값보다 추정하는 값을 신뢰하게 된다.

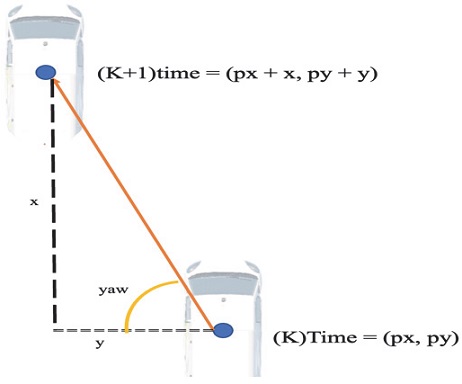

이러한 칼만 필터의 특징을 이용하여, 본 연구에서는 객체를 놓치지 않고 추적하기 위해 첫 번째 칼만 필터를 센서 값을 추종하게끔 식 (3)~(7)과 같이 모델링 하였다. 또한 Fig. 4를 통해 차량 시스템에 대한 모델링을 진행하였다. 차량을 기준으로 전방은 +x축을 나타내고, 왼쪽 횡 방향은 +y축을 나타낸다.

| (3) |

| (4) |

| (5) |

| (6) |

| (7) |

- Where px, py, vx, vy: scalar

첫번째 선형 칼만 필터를 통해 객체의 위치를 추정하게 된다. 하지만, 센서 값을 추종하게끔 모델링하였기 때문에, 센서의 잡음 또한 포함되어 있다. 즉, 객체 거동을 알 수 있는 객체의 속력 및 진행 방향이 잡음의 영향을 받기 때문에, 선형 칼만 필터를 추가하여 객체의 거동 추정을 하는 방법을 3.2절에서 설명한다.

3.2 거동 추정을 위한 선형 칼만필터 기반 객체 추적

첫 번째 칼만 필터와 헝가리안 알고리즘을 통해 객체를 놓치지 않고 추적을 하게 되면 객체의 움직임을 알 수 있는 객체 궤적(Trajectory)을 얻을 수 있게 된다. 이 궤적을 n초간 누적시켜 객체의 거동을 예측하는 두 번째 칼만 필터에 적용한다. 두 번째 칼만 필터는 첫 번째 칼만 필터와 다르게 센서 값보다 추정 값을 추종하게끔 식 (8)~(14)와 같이 모델링 하였다. 또한 값을 누적시켜 거동을 예측한 이유는 비선형 칼만 필터인 EKF에서 미분 선형화 과정을 거치게 되는 부분에서 인용하게 된 방법이다.

일반적인 실제 물리 시스템은 대부분 비선형으로 이루어졌기 때문에 일반적인 칼만 필터만으로는 명확한 한계가 있다. 이를 보완한 칼만 필터 EKF,20) Particle Filter19) 등이 있다. EKF(Extended Kalman Filter)는 비선형 칼만 필터로서 선형 칼만 필터와 구조는 동일하나, 예측 단계에서 비선형 시스템 모델을 1차 테일러 시리즈 선형화 과정을 거친 확률 변수로 근사화 하여 예측을 하게 된다. 즉, 매 순간마다 미분을 통해 선형으로 변형시켜 선형 칼만 필터처럼 작용한다고 하여 선형화 칼만 필터라고도 불린다.

하지만 선형화 과정은 계산 량을 증가시키고, 비선형 정도가 큰 경우, 평균과 분산에 큰 불확실성이 포함되어 필터 계산 값이 발산되어지는 단점이 있다. 이러한 이유로 2차 선형 칼만 필터를 통해 값을 누적시켜 선형화 하는 방법을 제시한다.

| (8) |

| (9) |

| (10) |

| (11) |

| (12) |

| (13) |

| (14) |

- Where px, py, vx, vy, yaw, yawd: scalar

두 번째 칼만 필터를 통해 얻은 추정 값 x, y, yaw 값을 이용하여 객체의 속력 및 진행 방향을 구하게 된다.

또한 신뢰성 있는 추적을 위해 헝가리안 알고리즘에서 필요한 비용 계산 시 본 연구에서는 GNN기반으로 유클리드 거리로 비용을 계산함과 더불어, 기존에 추적된 추적기에 신뢰도를 의미하는 파라미터를 추가하여 더 작은 비용을 가질 수 있도록 보완하였다.

3.3 차량 자세 모델을 통한 예측 갱신

제안한 알고리즘은 고속 환경과, 다양한 커브 상황이 있는 도심에서, 라이다 센서의 처리 시간은 10 hz로 다소 느리다는 단점을 가지고 있다.

이를 보완하기 위해, Fig. 3의 Kalman filter predict에서는 기존 추적된 물체들에 한하여, 차량의 자세 데이터와 앞 서 제안한 객체의 거동을 기반으로 객체의 위치를 예측 갱신 알고리즘을 연구하였다.

추가적으로 식 (15)~(20)과 같이 CTRV(Constant Turn Rate and Velocity) 모션 모델 기반으로 예측 갱신을 진행하였다.

| (15) |

| (16) |

| (17) |

| (18) |

| (19) |

| (20) |

4. 실험 환경

제안하는 두가지 방식을 KITTI benchmark22)와, 시뮬레이션, 실 차를 통해 검증하였다.

4.1 KITTI Datasets

본 연구에서 제안한 추적기의 성능을 평가하기 위하여 KITTI 추적 데이터셋을 이용하여 성능을 평가하고자 한다. KITTI의 추적 데이터 셋은 추적 정보를 나타내는 Tracklets을 제공하여, 이를 통해 Ground Truth로 지정하여 평가할 수 있다. 학습을 위한 데이터 셋도 있었지만 제안한 추적기는 학습을 필요로 하지 않기 때문에 사용하지 않았다.

본 성능 평가에서는 6개의 다른 주행 시나리오로 구성된 데이터 셋 종류를 선택하였다. 주행 시나리오는 6개로 2, 6, 7, 12, 14, 17를 지정하였다.

Table 1은 각 데이터 셋에서 구성되어져 있는 객체의 종류 Car, Pedestrian, Cyclist의 객체 수를 표현한 표이다. 마지막 행의 Sum은 ground truth 전체 합을 의미하며, 각 열의 S는 Scenario를 의미한다. 즉 S2는 Scenario 2번을 의미한다.

각 시나리오를 고른 이유는 객체 구성에 따라 다양한 상황을 평가하기 위해서 선택하였는데, S2와 S14는 각 객체 종류가 모두 분포되어 있고, S6는 오로지 Car로만 이루어져 있는 것을 Table 1을 통해 볼 수 있다.

4.2 Simulation 성능평가 방법

차량 거동 예측 실험을 위해 MORAI23)라는 시뮬레이터를 사용하였다. MORAI 시뮬레이터를 사용한 이유로는 Fig. 5와 같이 실 차 주행 환경과 가장 비슷하게 구현이 되어 있으며, 이외에도 실험할 수 있는 센서, 차량 모델 등이 구성되어 있어서 사용하였다.

Fig. 5는 왼쪽 그림이 실제 환경이며, 오른쪽 그림이 시뮬레이터 속 동일 장소를 보인 그림이다.

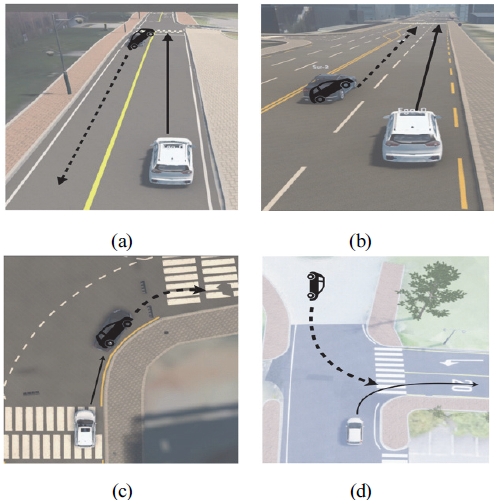

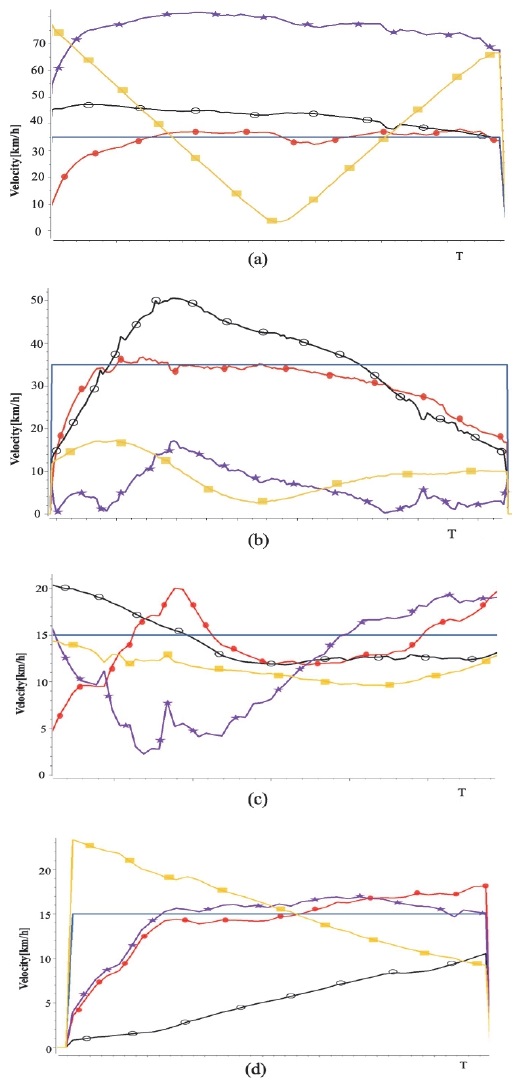

실험은 Fig. 6과 같이 4가지로 구성하였고, 실험 차량 1대와 타겟 차량 1대를 이용한 실험이며, 타겟 차량은 등속 운동을 한다. Fig. 6에서 하얀색 차량이 실험 차량이며, 검은색 차량이 타겟 차량이며, 등속 운동을 한다.

Introduction of the experimental scenario. Ego vehicle (white car), Target vehicle(black car), If all experiment vehicles move in a straight direction, but are in different directions(a), and are in same directions(b); If all experiment vehicles are in curved situation, they are in same direction(c), in a different direction(d)

실험 내용으로는 타겟 차량을 놓치지 않고 추적하는 지 여부와, 타겟 차량의 거동을 예측하는 전역 속도와 상대 속도를 알아보는 실험이며, Ground truth 데이터로는 시뮬레이터에서 나오는 타겟 차량의 전역 속도를 이용한다.

시나리오 A는 내 차량 속도가 50 km/h이고, 타겟 차량이 30 km/h로 진행 방향이 서로 다른 경우이며, 시나리오 B는 A와 속도는 같으나 진행 방향이 다른 경우이다. 시나리오 C는 모든 차량이 15 km/h로 코너를 진입할 때이다. 마지막으로 시나리오 D는 시나리오 C와 속도는 같으나 진행 방향이 다른 경우이다.

4.3 실 차 성능 평가 방법

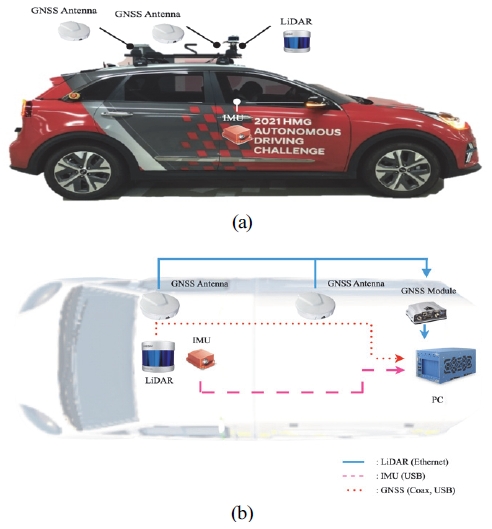

본 연구는 현대자동차 자율주행 챌린지에서 제공하는 대회 차량으로 DB를 취득하여 진행하였다. Fig. 7과 같이 차량을 구성, 본 연구에서 필요한 센서 및 전장 설비를 보유하고 있다. 본 연구에서 사용된 센서는 총 LiDAR 1대, GNSS 1대로 본 연구에서는 이 센서들 이외에는 사용하지 않았으며, 추가적으로 고정밀 지도를 활용하여 연구를 진행하였다.

알고리즘을 처리한 Computing platform은 산업용 PC으로 intel Xeon과 RTX 3080의 제원을 갖는다. 모든 알고리즘은 Linux 기반의 Ubuntu 18.04 환경에서 처리되었으며, 추가적으로 ROS8) 환경을 구축하여 사용하였다.

또한 본 연구에서 사용한 Lidar 센서는 Hesai사의 Pandar 40 m 모델이다. 이 라이다 센서의 특징으로는 40개의 채널을 가지고 있으며 검출 범위는 -100~100 m를 검출할 수 있도록 센서를 부착하였다.

실 차에서는 전체 시스템의 임베디드 연산 시간 처리 성능을 평가하였다.

5. 실험 결과

5.1 KITTI 추적기 성능 평가

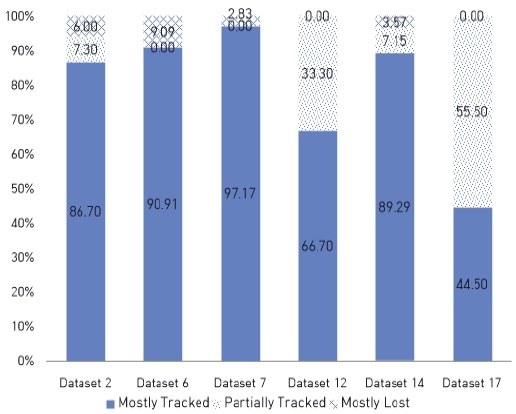

추적기의 성능을 나타내는 여러 평가 지표들이 있는데, 모든 프레임에 대하여 False Positive(FP)와 False Negative(FN)을 평가할 수 있고, 추적기의 추적 객체를 잃는 것을 의미하는(Fragmentation)와 ID가 바뀌는 현상을 정량화(IDSW, ID Switch)하는 것으로 설명할 수 있다. 또한 다중 객체에 대한 정확성에 대해서는 Multiple Object Tracking Accuracy(MOTA)와 Multiple Object Tracking Precision(MOTP)로도 표현할 수 있다. 마지막으로는 GT를 얼마나 잘 추적하였는지를 평가하는 지표는 3가지로 표현되는데, GT의 80 % 이상을 추적하면 Mostly Tracked(MT), 20 %이하를 추적하게 되면 Mostly Lost(ML), 부분 추적하게 되면 Partially Tracked(PT)로 표현 할 수 있다.

이런 평가지표를 바탕으로 추적기의 성능은 Table 2로 나타내었다.

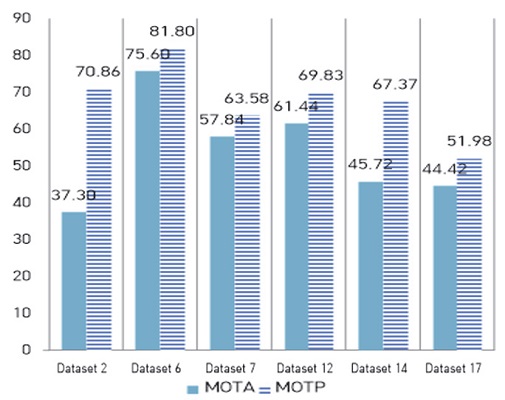

Table 2에서는 전체 데이터 셋에 대한 전반적인 성능을 평가해보았으며, Fig. 8, Fig. 9는 데이터 셋 별 추적기의 성능을 비교 분석해본 결과이다. Fig. 8은 MOTP, MOTA의 성능을 기록한 그래프로서, MOTP의 성능이 MOTA의 성능보다 높은 점수를 기록하였다. MOTA의 값이 상대적으로 낮은 이유는 거동 추적을 위해 센서 값보다 추정 값을 더 신뢰하기 때문에 여기서 정확성이 낮아졌다고 예상할 수 있다.

추적기의 성능은 차량으로만 구성된 6번 데이터 셋의 경우 전반적인 성능평가 지표가 높은 수준을 보이고 있다. 하지만 보행자와 이륜차로 이루어진 17번 데이터 셋의 경우 성능 지표가 평균보다 아래를 기록하고 있다. 또한 Fig. 9를 보면 알 수 있듯이, 모든 객체 추적에 대해서 ML(Mostly Lost)는 수치가 낮게 기록되었다. 이를 통해 본 논문의 객체 추적기는 객체를 놓치지 않고 지속적으로 추적한다는 것을 알 수 있다.

5.2 Simulation 거동 예측 실험

Fig. 10에서 원형 선이 타겟 객체의 절대 속도를 예측한 그래프이며, 가로 일직선이 타겟 속도의 절대 속도 GT 값을 나타낸다. 또한 빈 원형 선은 내 차량의 속도를 나타냈으며, 별 무늬 선은 타겟 객체의 상대 속도를 예측한 그래프 이다. 마지막으로 사각형 선은 인지된 객체와 내 차량 간의 거리를 나타낸다. 거리를 나타낸 이유는 연속성을 통해, 객체 추적이 끊임없이 추적되고 있다는 것을 알려준다. Fig. 10의 (c) 시나리오의 결과를 제외하고 대부분의 타겟 객체의 절대 속도를 추적기가 잘 추적하는 것을 볼 수 있다. 하지만 (c) 시나리오의 경우, 상대속도가 급격하게 변화함에 따라 절대속도 추정이 불안정한 모습을 관찰할 수 있었다.

Simulation result graph by experimental scenario, full circle line is absolute speed, rectangle line is distance between target vehicle and ego vehicle, empty circle line is ego vehicle velocity, star line is relative velocity and line is target vehicle’s GT velocity

사용한 알고리즘의 거동 추적 결과를 정량적인 결과를 위해 EKF를 사용한 거동 추적 결과 오차를 비교하여 Table 3에 나타내었다.

객체의 속도 오차를 검증하는 방법은 추정된 속도와 GT 값의 차이에 대한 평균(E), 표준 편차(σ), 최대 오차 속도(Max), 표준 오차(RMSE, Root Mean Squares Error)로 나타내고자 한다. 이는 숫자가 낮을 수록 오차가 낮음을 의미한다.

Table 3을 통해 오차를 비교해 보았을 때, EKF를 통해 선형화 작업을 하지 않아도 성능이 비교 우위에 있는 것을 알 수 있다. 하지만 시나리오 C처럼 상대 속도 즉 라이다 좌표계에서 구한 속도가 오차가 크게 생긴다면 이후 속도를 추정하는데도 오차가 크게 누적되는 것을 볼 수 있었다. 변화량이 큰 값을 제거할 수 있는 필터 등을 추가 구현한다면 더 강인한 추적기가 될 수 있을 것이라고 예상할 수 있다.

5.3 임베디드 구현 결과

실 차 실험에서는 전체 프로세스 처리 시간을 측정하였다. 도심과 같은 실제 실 차량에서 이루어지는 실험에서는 단순히 하나의 모듈만 처리하는 것이 아니라, 통합 인지 모듈 이외에도 제어, 판단 모듈이 다 같이 동작하기 때문에 이를 고려하여 실시간성을 검증하는 실험을 진행하였다.

Table 4를 통해 인지 모듈은 네트워크를 처리하기 때문에 일정 시간이 평균적으로 소요되는 것을 알 수 있었으며, 추적 모듈은 처리하는 시간이 매우 빠르지만, 다중 객체 인지로 인해 추적해야 할 객체의 개수가 일정 이상일 경우 처리하는 시간이 증가하는 것을 알 수 있다.

6. 결 론

본 논문은 LiDAR 센서를 이용하여 객체 인지 및 추적을 통한 객체의 거동을 예측하는 인지 모듈을 제안하였다. 딥러닝 기반 인지에서 학습하는 방법이 아닌 비지도 학습인 그리드 맵 기반 인지 추가를 통해 인지 성능의 향상을 이끌어 냈다. 또한, 비선형 칼만 필터인 EKF의 미분식 선형화를 하지 않고도, 2개의 칼만 필터를 이용하여 하나는 객체 추적에 사용하며, 두 번째 칼만필터를 적용하여 속도를 추정하는 빠르고 신뢰성이 있는 추적 방법을 KITTI, 시뮬레이션, 실 차 실험을 통해 검증하였다. 본 연구를 통해 현대 자율 주행 챌린지에서 운전자의 개입과 충돌 없이 4 km의 상암 자율 주행 테스트베드를 완주하여 2등이라는 성과를 이뤘다.

아쉬운 점은 거리가 먼 물체에 대해 속도 오차가 큰 점이다. 이를 보완하기 위해 향후 목표로는 레이더와의 센서 퓨전을 수행하게 된다면 레이다를 통해 종방향의 강인함을 통해, 객체의 거동 연구를 진행하고자 한다. 또한, 지금의 추적기는 GNN 비용 기반의 매칭 방법을 사용하고 있는데, 이는 추적 속도에 대한 제한 조건을 가지고 있을 수 밖에 없다. 이를 해결하기 위해, 객체 별 추정 속도에 따른 제한 조건을 다르게 가지게 된다면, ID Switch 같은 현상이 더욱 줄어들 것으로 예측된다. 또한 객체 추적기에서 사용하는 max_age 관련해서도, 신뢰성 정보를 바탕으로 하게 된다면, 추적에 더욱 강인한 결과가 도출 될 수 있을 것이라고 판단된다.

Subscripts

| superscript ‘‑’ (a‑) : | predict value |

| subscript ‘k’ (ak) : | kth value |

| dt : | difference between kth time and (k-1)th time |

| xk : | state variable, (n x 1) column vector |

| zk : | measure value, (m x 1) column vector |

| A : | system matrix, (n x n) matrix |

| H : | output matrix, (m x n) matrix |

| Q : | system noise covariance matrix, (n x n) diagonal matrix |

| R : | measurement noise covariance matrix, (m x m) diagonal matrix |

Acknowledgments

본 연구는 과학기술정보통신부 및 정보통신기획평가원의 지역지능화혁신인재양성(Grand ICT 연구센터) 사업의 연구결과로 수행되었음(IITP-2022-2020-0-01462).

본 연구는 산업통상자원부와 한국산업기술진흥원의 국가혁신클러스터사업(P0015335-자율주행용 컴퓨팅 모듈 및 자율주행 셔틀 안전성 보장 기술개발)의 지원을 받아 수행된 연구결과임.

References

-

J. Seo, S. Oh and Y. Kim, “A Study of Curved Lane Detection Based on Dual Sensor Monitoring of LiDAR and Camera,” Transactions of KSAE, Vol.29, No.2, pp.197-204, 2021.

[https://doi.org/10.7467/KSAE.2021.29.2.197]

-

D. Kang, M. Kim, H. Sun and J. Kim, “Feature Mapping with Machine Learning Based Object Classification,” Transactions of KSAE, Vol.28, No.6, pp.419-425, 2020.

[https://doi.org/10.7467/KSAE.2020.28.6.419]

-

J. Kim, D. Lee, B. Yu and S. Kee, “A Study on the Parking Point Searching for Wireless Charging of Electric Vehicles,” Transactions of KSAE, Vol.28, No.7, pp.483-489, 2020.

[https://doi.org/10.7467/KSAE.2020.28.7.483]

-

J. Redmon and A. Farhadi, “YOLO9000: Better, Faster, Stronger,” Conference on Computer Vision and Pattern Recognition(CVPR), 2017.

[https://doi.org/10.1109/CVPR.2017.690]

-

A. Dewan, T. Caselitz, G. D. Tipaldi and W. Burgard, “Motion-based Detection and Tracking in 3D LiDAR Scans,” IEEE International Conference on Robotics and Automation(ICRA), 2016.

[https://doi.org/10.1109/ICRA.2016.7487649]

- Y. Zhang, X. Sun, H. Xu and E. Yao, “Tracking Multi-Vehicles With Reference Points Switches at the Intersection Using a Roadside LiDAR Sensor,” IEEE International Conference on Robotics and Automation (ICRA), 1987.

- A. S. Abdul Fachman, 3D Lidar Multi Object Tracking for Autonomous Driving Multi Target Detection and Tracking under Urban Road Uncertainties, M. S. Thesis, Delft University of Technology, Delft, 2017.

- ROS. Open Source Robotics Foundation 2016, June 15, Retrieved from http://wiki.ros.org/rviz

- R. Rusu, Uniform Sampling - PCL API Documentation - Point Cloud Library, April 2017. Retrieved from http://docs.pointclouds.org/

-

X. Weng, J. Wang, D. Held and K. Kitani, “3D Multi-Object Tracking: A Baseline and New Evaluation Metrics,” 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems(IROS), October 25-29, 2020.

[https://doi.org/10.1109/IROS45743.2020.9341164]

-

G. Ciaparrone, F. Luque, S. Tabik, L.Troiano, R. Tagliaferri and F. Herrera, “Deep Learning In Video Multi-Object Tracking: A Survey,” arXiv:1907.12740v4, [cs.CV] 19 Nov 2019.

[https://doi.org/10.1016/j.neucom.2019.11.023]

- M. Miah, Justine Pepin, N. Saunier and G. Bilodeau “An Empirical Analysis of Visual Features for Multiple Object Tracking in Urban Scenes,” arrXiv:2010.07881v1, , 2020.

-

Y. Wang, B. Wang, X. Wang, Y. Tan, J. Qi and J. Gong, “A Fusion of Dynamic Occupancy Grid Mapping and Multi-object Tracking Based on Lidar and Camera Sensors,” 2020 3rd International Conference on Unmanned Systems (ICUS), pp.107-112, 2020.

[https://doi.org/10.1109/ICUS50048.2020.9274841]

-

J. Choi, S. Ulbrich, B. Lichte and M. Maurer, “Multi-Target Tracking using a 3D-Lidar Sensor for Autonomous Vehicles,” Proceedings of the 16th International IEEE Annual Conference on Intelligent Transportation Systems, 2013.

[https://doi.org/10.1109/ITSC.2013.6728343]

-

M. Thuy and F. Puente Leon, “Non-Linear, Shape Independent Object Tracking based on 2D Lidar Data,” IEEE, 2009.

[https://doi.org/10.1109/IVS.2009.5164334]

-

K. Cho, S. Baeg and S. Park, “Real-time 3D Multiple Occluded Object Detection and Tracking,” IEEE ISR, 2013.

[https://doi.org/10.1109/ISR.2013.6695718]

-

M. Simon, S. Milz, K. Amende and H. M. Gross, “Complex - YOLO: Real-time 3D Object Detection on Point Clouds,” arXiv:1803.06199, , 2018.

[https://doi.org/10.1109/CVPRW.2019.00158]

-

R. E. Kalman, “A New Approach to Linear Filtering and Prediction Problems,” Vol.82, No.1, pp.35-45, 1960.

[https://doi.org/10.1115/1.3662552]

-

F. Gustafsson, “Particle Filter Theory and Practice with Positioning Applications,” IEEE Aerospace and Electronic Systems Magazine, Vol.25, No.7, pp.53-82, 2010.

[https://doi.org/10.1109/MAES.2010.5546308]

-

N. Yang, S. Lin, H. Huang and L. Zhou, “An Adaptive Extended Kalman Filter for Structural Damage Identification,” Journal of Structural Control and Health Monitoring, Vol.13, No.4, pp.849-867, July 2006.

[https://doi.org/10.1002/stc.84]

-

P. Tokmakov, J. Li, W. Burgard, and A. Gaidon, “Learning to Track with Object Permanence,” arXiv preprint arXiv:2103.14258, , 2021.

[https://doi.org/10.1109/ICCV48922.2021.01068]

-

A. Geiger, P. Lenz, C. Stiller and R. Urtasun, “Vision Meets Robotics: The KITTI Dataset,” IJRR, Vol.32, No.11, 2013.

[https://doi.org/10.1177/0278364913491297]

- MORAI, Autonomous vehicle Simulation Program, March 2020, Retrieved from https://www.morai.ai