라이다 및 카메라 듀얼 센서 모니터링 기반의 곡선 차선인식 알고리즘 연구

Copyright Ⓒ 2021 KSAE / 183-12

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

The accurate detection of road markings is a pre-requisite for safe advanced driver-assistance systems(ADAS). LiDAR-based lane detection has some advantages over camera-based detection in terms of robustness in various weather conditions, such as rain, and at night. However, LiDAR has a much lower resolution that may not detect enough lane markings and can give false markings depending on the reflectivity of lanes and surroundings. Therefore, this paper proposes a method to improve the LiDAR-based lane detection with the supplement of a camera. If the LiDAR-detected lane does not pass the proposed validation logic, the algorithm determines the use of a camera-based lane detection or estimates the upcoming lane from the previous data. The proposed algorithm is evaluated by using the KITTI road lane data set consisting of 851 frames. The proposed algorithm showed about 22 % accuracy improvement compared to the lane detection using LiDAR alone.

Keywords:

Lane detection, LiDAR, Camera, Curved lane키워드:

차선검출, 라이다, 카메라, 곡선차선1. 서 론

ADAS(Advanced Driver Assistance System)는 기존의 안전벨트, 에어백 등과 같은 수동적인 자동차 안전기술에서 한 단계 더 발전하여 여러 센서를 통해 위험을 미리 감지하여 운전자가 적절하게 대응할 수 있게 해주는 능동형 자동차 안전기술로써, 최근 자율주행 연구가 활발해짐에 따라 이에 관련된 연구 또한 활발히 진행되고 있다.1,2) ADAS를 구성하는 여러 시스템 중, 차선 이탈시 경고를 하는 LDWS(Lane Departure Warning System), 차로의 유지를 보조해주는 LKAS(Lane Keeping Assist System), 앞차와의 거리를 스스로 유지하며 주행을 할 수 있게 해주는 ACC(Adaptive Cruise Control) 등과 같은 여러 기능들의 구현을 위해서는 정확한 차선의 검출이 아주 중요한 부분으로 자리매김하고 있다.3)

기존의 차선인식 연구들은 주로 카메라 기반의 시각정보에 의존하고 있지만 차선 인식률 향상에 한계점을 가지고 있다. 특히 차선의 색과 비슷한 물체가 인식될 경우, 강한 햇빛 혹은 그림자가 있는 환경 등에서는 차선 인식률이 현저히 떨어지는 문제가 발생한다.

카메라 기반 차선인식의 한계점을 해결하기 위해 최근에는 LiDAR 센서를 활용하는 차선인식 연구가 추진되어왔다.4-6) LiDAR는 레이저 펄스파를 보낸 후 물체에 닿아 반사되어 돌아오는 시간으로 물체의 3차원 위치를 측정하며, 반사강도를 동시에 측정할 수 있다. LiDAR의 반사강도는 도로 차선에서 높은 값이 측정되지만 이에 반하여 도로의 표면은 차선에 비해 레이저 펄스가 더 많이 산란이 되어 더 낮은 반사강도 값을 가지게 되므로 이를 이용하여 차선과 도로 표면을 구분할 수 있다. 또한 LiDAR는 카메라에 비해 빛의 세기변화에 덜 민감하기 때문에 햇빛의 세기변화에 민감한 카메라의 단점을 보완해줄 수 있다.6,7)

차선 검출의 관점에서 LiDAR가 여러 장점을 가지고 있지만, 카메라에 비하여 낮은 해상도와,7) 급격한 날씨변화에 취약한 특성을 나타낸다.8) 따라서 최근에는 LiDAR의 3차원 정보와 카메라 이미지를 딥러닝 기반 알고리즘으로 융합하여 차선을 검출하는 연구9,10)가 발표가 되었으나 실시간 인식에 한계점을 가지고 있다.

이에 따라 본 연구에서는 LiDAR 기반의 차선인식 정확도를 개선하기 위해 카메라 정보도 같이 사용하나, 계산량을 최소화하기 위해 딥러닝 기반의 융합이 아닌 LiDAR와 카메라 듀얼 센서 모니터링 기반의 차선인식 기법을 제안한다.

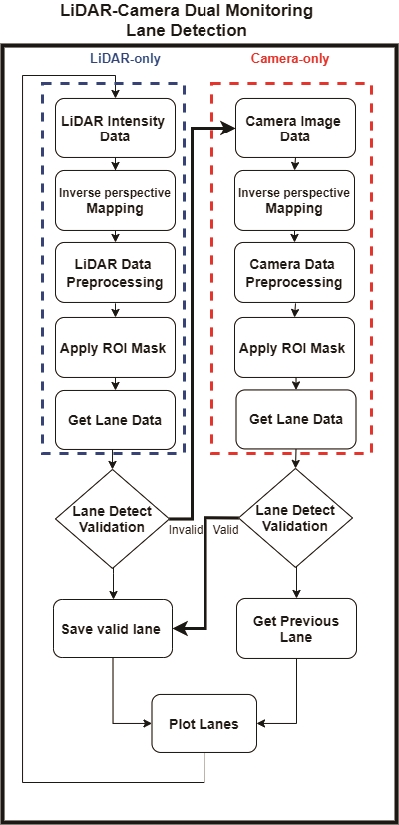

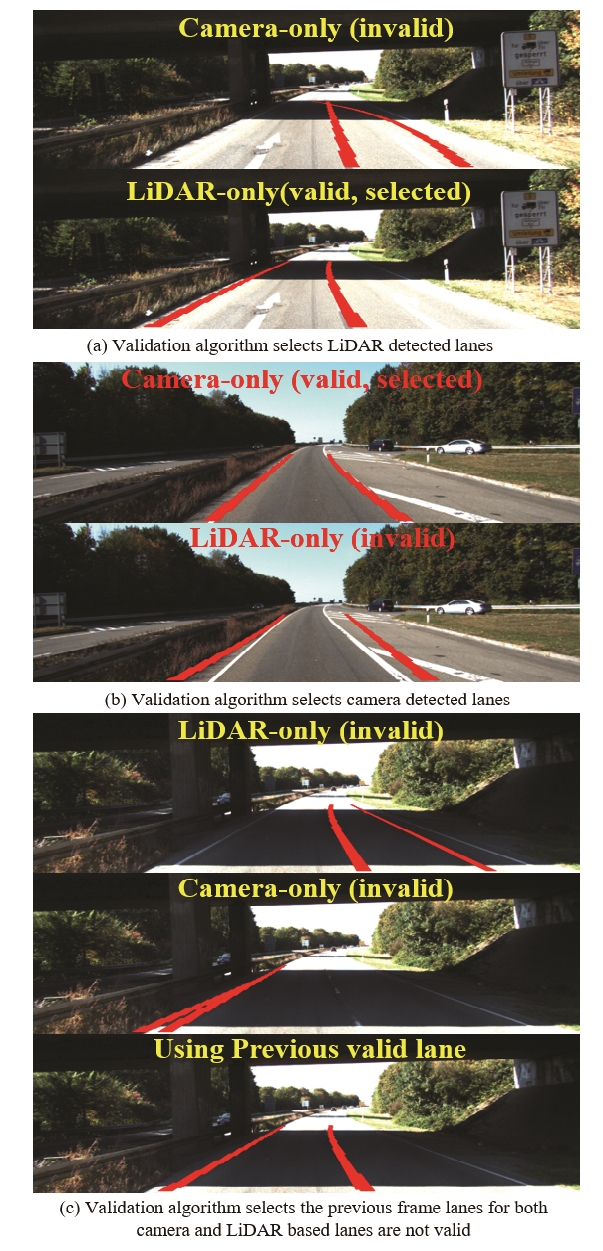

본 연구에서 제안하는 기법은 LiDAR 기반의 차선인식 기법으로 검출된 차선의 유효성 검사를 수행한 후 인식 실패시에는 백그라운드 프로세스에서 처리되는 카메라 기반의 차선검출로 대체하거나 이전 프레임의 데이터로 차선을 예측하는 듀얼 센서 모니터링 기법으로, 단일 LiDAR 기반의 차선인식률을 보다 개선할 수 있는 장점이 있다. 개선된 성능을 검증하기 위하여 KiTTI road detection set11)를 이용하였으며, Fig. 1의 LiDAR-only, Fig. 1의 Camera-only, 제안한 알고리즘, 총 세 개의 방법으로 구분하여 차선인식률 결과를 비교평가 하였다.

2. Related Research

기존의 카메라 기반의 차선 검출 연구는 차선의 기하학적 특징을 기반으로 차선을 검출하고 차선 곡선모델을 피팅(Fitting)하는 방법을 주로 사용하였다.12) 대표적인 차선기하학적 특징기반의 차선검출은 Adaptive threshold 기법을 이용한 방법13)으로, 해당 연구13)에서는 Adative threshold를 통해 차선에 해당하는 부분의 픽셀값과 Edge에 관한 정보를 얻은 후, 후보군을 생성하여 차선에 해당하는 Edge만을 걸러내어 직선차선을 검출하였다. Ozgunalp는 차선의 소실점 추정 기법을 사용하여 도로위의 차선을 검출하는 방법14)을 제안하였다. 해당 연구14)에서는 소실점 추적을 통하여 차선의 위치판단을 함과 동시에 차선에 대한 Edge map상에서 Noise를 제거함으로써 SNR(Signal to noise ratio) 추정치를 향상시켜 차선 후보군을 가려내는 데 사용하였다. Collado는 카메라의 왜곡을 보정하기 위하여 Inverse Perspective Mapping (IPM)을 사용하였고, Hough transform 방법을 이용하여 차선을 검출한 후 픽셀 이미지에 Fourier transform을 적용하여 차선의 유형을 나누는 방법15)을 제안하였다. Huang는 차선 추적과 차선 검출에 대한 강건성(Robustness)을 최적화하는 데 장점을 가지고 있는 Kalman filter를 적용하는 기법16)을 제안하였다. 해당 연구16)에서는 IPM을 적용하여 Top view영상을 얻은 뒤 가우시안 컨볼루션과 Binarization 과정을 통해 차선에 대한 정보를 얻은 후, 픽셀 값 분포에 대한 히스토그램을 생성하여 Extreme point를 기준으로 차선을 그린 뒤, Kalman filter를 적용하여 차선 추적이 가능하게 하였다. 차선의 기하학적 특징을 이용한 차선검출 방법들에 이어 곡선 차선 검출을 위해 다양한 차선 모델들을 사용한 연구들도 있다. 가장 전통적인 방법으로는 Wang이 제안한 Spline 모델을 활용한 차선 모델 검출 기법17)이 있다. Wang은 또한 Spline 모델과 CHEVP를 활용하여 Control point를 이동시키는 방법을 사용하는 B-snake model18)을 제안하여 기존의 Spline model과 비교하였을 때 더 개선된 성능을 나타내었다. Aly는 outlier 제거에 용이한 RANSAC19)과 IPM, Second-derivative Gaussian map을 활용하여 곡선의 차선 모델을 구하는 방법20)을 사용하였다.

머신러닝 기법이 많은 주목을 받은 이후로는 이후로 여러 연구에서 카메라기반의 머신러닝 혹은 딥러닝 기반의 차선인식 방법을 제안하였다. 그중 Convolution Neural Network(CNN)을 이용한 차선검출 기법21)은 기존의 전통적인 차선인식 방법과 비교하였을 때 훨씬 좋은 검출률을 보였다. 또 다른 CNN을 활용한 차선검출 연구22)에서는 CNN을 통해 노이즈 제거와 선명한 모서리 이미지를 얻은 후, RANSAC 기법을 통해 Edge 이미지에 대한 모델의 Parameter를 추출하여 차선을 피팅하는 방법을 사용하였다.

기존의 차선 검출 연구는 카메라 기반의 방법을 많이 사용하였지만 LiDAR 기반의 차선 검출 연구 또한 진행되어왔다. 6채널의 DENSO LiDAR를 이용한 연구4)에서는 LiDAR를 사용하여 반사강도 데이터를 취득하였다. 위 연구4)에서는 획득한 반사강도의 평균치와 거리정보를 이용하여 특징점을 필터링 하는데 사용하였고, Random transform 기법을 이용하여 차선에 해당하는 데이터를 취득하였다. DENSO LiDAR를 이용한 또 다른 차선검출 연구에서는 LiDAR에서 멀리 떨어져 있는 차선 데이터들을 얻기 위하여 LiDAR의 거리정보를 함께 사용하는 기법6)을 제안하였다. LiDAR를 이용한 또 다른 차선검출 연구5)에서는 64채널의 3차원 LiDAR를 사용하여 차량 운전이 가능한 지역만을 추출해 ROI(Region of Interest)로 설정하여 이를 통해 계산의 효율성을 높였고, FIR 필터와 Kalman filter를 적용하여 차선의 특징점을 추정하는 기법을 사용하였다.

카메라와 LiDAR를 모두 이용한 기존의 차선검출 연구23)에서는 카메라의 RGB 이미지와 LiDAR의 반사강도 데이터를 각각 얻어 ‘Voting Scheme’라는 과정을 통해 도로 위에 있는 차선에 대하여 더 높은 가중치를 주어 효과적으로 차선을 검출하는 방법을 제안하였고, 다른 연구24)에서는 3개의 AVM 카메라와 2대의 LiDAR를 사용하여 높은 퀄리티의 반사강도 데이터를 얻는 방법을 제안하였다. 해당 연구24)에서는 맵 매칭 기반의 Localization 알고리즘이 좋은 성능을 낼 수 있도록 하는데 차선 데이터를 이용하였다.

최근에는 딥러닝으로 LiDAR 및 카메라 정보를 융합하여 차선인식을 개선하는 연구가 발표되고 있다. Xiaodong은 LiDAR의 데이터와 칼라 이미지를 사용하여 도로표면에 대한 데이터만을 분리시킨 후 CNN을 적용하여 이미지 패치를 생성한 후 차선인 부분과 차선이 아닌 부분으로 분류하는 방법9)을 제안하였다. 해당 연구에서는 그림자가 있거나 다른 차량들로부터의 산란현상 등 가혹한 조건에서 좋은 성능을 내는데에 집중하였다. 또 다른 연구에서는 자동으로 차선을 찾아주는 End-to-end 방식의 DNN을 제안하였다.25) 해당 연구25)에서는 Pre-processing 과정을 거친 Input 이미지에 Convolution network를 중첩시켜 차선의 위치와 이미지의 Baseline을 검출하였다.

카메라 기반의 차선검출에 관한 연구들은 최근 머신러닝 및 딥러닝 기술이 등장하며 차선의 검출률에 많은 향상을 보였지만 입력영상의 조도, 그림자, 날씨 환경에 많은 영향을 받기 때문에 단일 카메라만으로는 정확한 차선 검출에 어려움이 있다.7) LiDAR를 이용한 차선검출의 경우 카메라에 비해 그림자, 조도의 영향을 덜 받는다는 장점이 있지만 날씨 변화에 의한 영향과 카메라에 비해 해상도가 낮다는 점에서 여전히 정확한 차선 검출에 어려움을 가지고 있다.8) 이러한 문제들을 해결하기 위하여 카메라와 LiDAR를 모두 사용하는 차선검출 연구에서 두 센서의 융합을 통하여 차선검출의 성능향상에 대한 연구가 진행되었지만, 혹독한 기상상태, 빛 반사가 심한 경우, 복잡한 도심에서는 차선인식률이 떨어지고, 여러 센서를 사용하면서 소요되는 계산량이 많다는 문제 등 여전히 해결되어야 하는 문제들이 남아있다.

따라서 본 연구에서는 기존의 LiDAR와 카메라를 함께 사용하는 차선검출 연구들의 한계점을 해결하기 위한 방법으로 LiDAR와 카메라 듀얼센서 모니터링 기반의 차선검출 알고리즘을 제안한다.

3. Lane Detection

본 연구에서 제안하는 LiDAR와 카메라 듀얼 센서 모니터링 기반의 차선인식 기법은 반사강도를 활용한 단일 LiDAR 기반으로 차선을 인식하는 기법으로, 도로 환경에 따라 차선 인식의 정확도가 낮아지면 해당 부분을 카메라 기반의 차선인식 결과로 대체하는 검출 정확도를 개선하는 방법을 사용한다. 만약, 두 센서 모두 차선 유효성 검사에 불합격이 되는 경우에는 이전 프레임의 데이터를 활용하여 차선을 예측한다. 따라서 본 연구에서는 LiDAR와 카메라 듀얼센서를 사용할 때와 각각 센서에서 차선검출을 수행하였을 때를 비교하여 더 높은 차선인식률을 달성하는 것을 목표로 한다. 또한 본 연구에서 제시하는 알고리즘의 계산량을 측정하여 알고리즘의 실시간 적용 가능성을 검토해보고자 한다. 전체적인 과정은 Figs. 1, 2에 제시하였다.

3.1 LiDAR Data Projection

3차원 정보를 가지고 있는 LiDAR와 카메라를 함께 사용하기 위해서는 3D LiDAR 포인트들을 카메라의 2D 평면에 Mapping 시키는 과정이 필수적이다. LiDAR 데이터의 Format이 x = (x, y, z, 1)T라고 한다면, 이에 대응되는 카메라 데이터의 형식은 y =(u, v, 1)T라고 할 수 있고, 식 (1)과 같이 표현될 수 있다.

| (1) |

위 식 (1)에서 Matrix 는 카메라 렌즈에 의한 왜곡 보정을 위한 변환행렬로, LiDAR와 카메라의 동기화에 사용된다. Matrix 는 mapping되는 카메라의 회전 행렬이고, 는 LiDAR의 회전 행렬과 카메라로의 변환 행렬을 포함하는 행렬이다. 해당 행렬들의 모든 요소에 대한 값은 KiTTi dataset11)에서 제공하는 값들을 사용하여 실험을 진행하였다.

2D로 변환된 LiDAR 데이터들의 값은 각각의 픽셀위치에 해당하는 x, y값과 해당 픽셀에 대한 반사강도 값으로 변환된다. 반사강도 값은 0부터 1의 값 사이에 분포하며 도로 표면에 비하여 차선에서 더 높은 값을 가진다. 본 연구에서는 도로표면에서의 반사강도 값은 대부분 0.4를 넘지 않는 반면 차선위에서의 반사강도 값은 0.5∼0.6 사이의 값을 가진다는 점을 근거로 하여 차선을 구분해주는 임계값 0.4로 설정하였다.

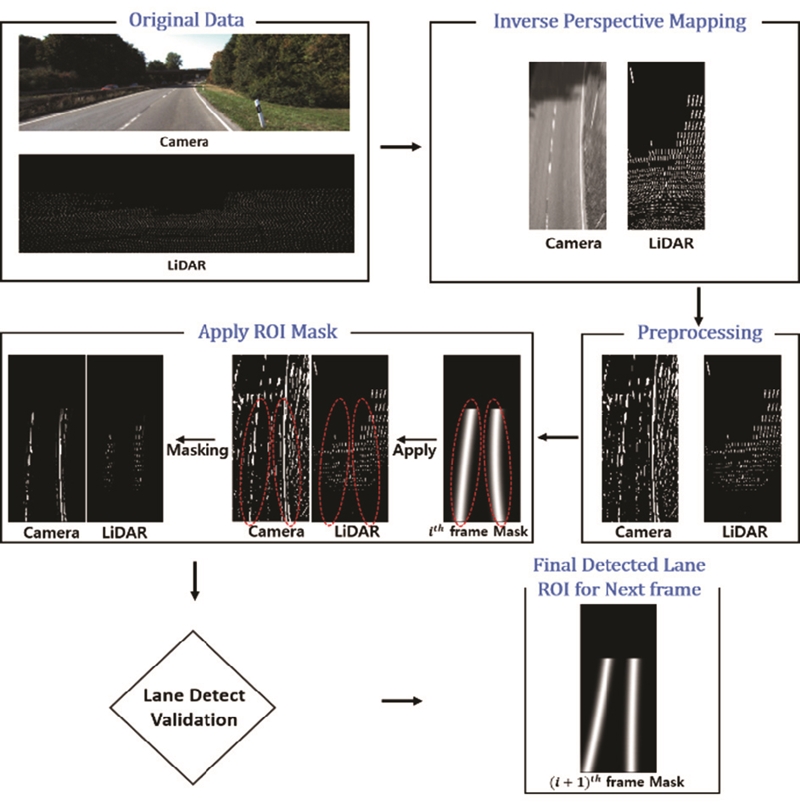

3.2 Inverse Perspective Mapping & Pre-processing

LiDAR Data의 Projection 이후에는 역투영 변환 기법이 사용되었다. 역투영 변환(Inverse perspective mapping)에서는 카메라의 왜곡을 보정하여 불필요한 배경들을 제거하고 원하는 영역만 볼 수 있도록 하는 과정이 이어진다. 역투영 변환의 변환행렬은 OpenCV 오픈소스 라이브러리의 함수를 사용하여 계산하였다. 아래 수식2)은 역투영 변환 과정에 대한 식이고, 수식3)에는 역투영 변환 과정에 사용된 행렬 M을 나타내었다.

역투형 변환된 이미지를 다시 원래 영역으로 가져오기 위해서는 역투영 변환의 역변환 과정이 필요하다. 역투영 변환의 역변환 과정은 역투영 변환된 이미지 영역에 역투영 변환과정에 사용된 행렬의 역행렬 M-1을 변환행렬로 하여 곱셈 연산을 적용하여 원래 이미지 영역으로 변화시켰다. 수식4)에 역투영 변환과정에 사용된 행렬의 역행렬을 나타내었다.

| (2) |

| (3) |

| (4) |

이후의 전처리 과정으로는 Adaptive threshold를 적용하여 다른 객체들에 의한 노이즈를 제거하였다. 이 과정을 통해 1차적으로 차선을 도로표면에서부터 분리시킨 후, 침식, 팽창연산, 가우시안 필터 등의 필터들을 적용하여 불필요한 노이즈를 추가적으로 제거하였다.

3.3 Apply ROI Mask

이미지의 전처리 과정이 끝난 후, 마스크를 적용함으로써 현재 프레임에 존재하는 도로 표면의 노이즈들을 제거한다. 현재 프레임에 적용할 ROI 마스크는 이전 프레임에서 유효하다고 판단한 차선에 수식5)의 가우시안 분포를 적용하여 구하였다. 이러한 방식을 사용함으로써, 이미지 영역에서 차선과 멀리 위치해 있는 값들을 제거할 수 있다. 이 ROI 마스크는 노이즈를 제거할 수 있을 뿐만 아니라 각각의 프레임에서 검출한 차선들의 경향성을 반영하고 있어 이후에 차선의 유효성 검사에도 사용된다.

| (5) |

3.4 Lane Fitting

ROI 마스크를 적용한 후, 노이즈가 제거된 이진 영상으로부터 차선의 방정식을 얻는 과정이 이어진다. 첫 번째로 왼쪽에 해당하는 차선과 오른쪽에 해당하는 차선으로 차선데이터를 군집화하는 과정이 수행된 후 두 번째 두 그룹으로 군집화된 데이터들에 대하여 각각 RANSAC19) 기법을 이용하여 차선의 분포에 대한 식을 얻는다.

첫 번째 과정에 해당하는 데이터의 군집화의 방법으로는 K-means 군집화 기법과 DBSCAN 군집화 기법이 대표적이다. DBSCAN은 K-means 기법과 비교하였을 때 연산과정의 속도 측면에서 더 느리다는 점, 군집안의 요소들의 거리에 대한 값과 한 군집에 포함되어야 하는 최소 포인트들의 개수에 대한 두 개의 Hyper parameter 값이 있어 K-means 군집화 방식에 비해 고려해야 할 사항에 많다는 점을 고려하였을 때, K개의 고정된 군집으로 더 빠르게 군집화할 수 있는 K-means 방식을 사용하여 군집화를 진행하였다.

K-means를 이용한 데이터 군집화가 완료되면, RANSAC 기법을 통해 차선의 방정식에 대한 파라미터를 얻는다. 본 연구에서는 Noisy한 환경에서도 적절한 차선의 방정식의 파라미터들을 얻기 위하여 2차 다항식으로 차선의 형태를 가정한 후 Outlier를 제거하며 최적의 파라미터를 찾는 모델링 기법인 RANSAC를 사용하여 최적의 파라미터를 선정한 후 이를 기반으로 차선에 대한 방정식을 도출하였다.

3.5 Validation Algorithm

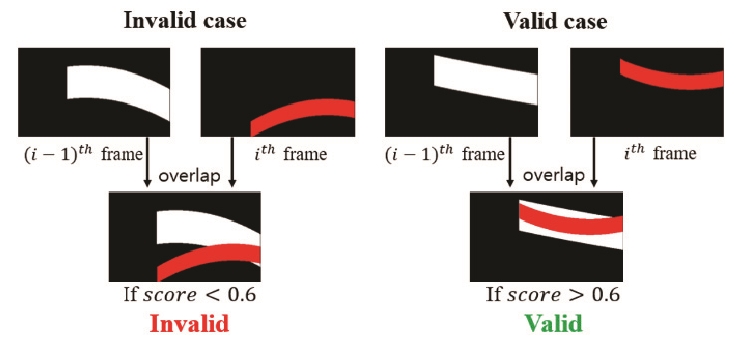

차선 유효성 검사 알고리즘의 첫 번째 방법은 Score를 이용하는 방법이다. Score는 현재 프레임에서 검출한 차선과 이전 프레임에서 검출한 차선을 비교하여 계산된다. 자세한 계산 방법은 수식6)에 나타나 있다.

| (6) |

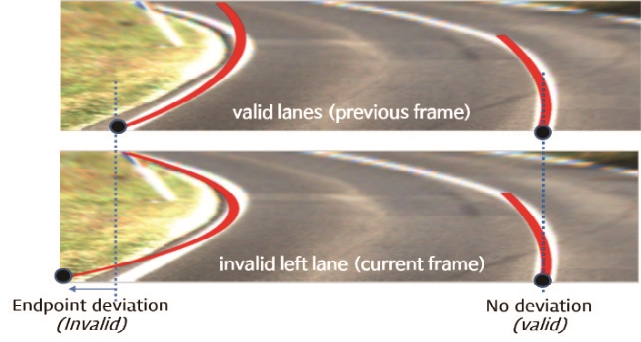

유효성 검사 알고리즘에서는 차선이 정상적으로 검출될 경우, 인접한 두 프레임 사이에서의 차선의 모양과 위치는 크게 변하지 않는다는 사실을 이용하여 Score의 값이 0.6 이상이면 차선의 위치와 모양이 크게 변하지 않았다고 판단하여 유효성 검사를 통과하는 것으로 정의하였다. 만약 Score의 값이 0.6 이하면 현재 프레임의 차선은 외부 환경변화에 의해 잘못된 차선을 검출하였다고 판단하여 유효성 검사를 통과하지 못한 것으로 인식된다. 즉, Fig. 3의 빨간색 선이 하얀색 선과 겹치는 부분의 비율이 0.6 이상이면 올바르게 검출한 차선으로 판단한다고 할 수 있다.

두 번째 유효성 검사는 RANSAC을 통해 구한 차선의 방정식의 파라미터를 이용하는 방법이다. 아래 수식7)은 검출한 차선을 2차 방정식으로 근사한 결과다.

| (7) |

수식7)의 파라미터 ‘c’는 차선의 끝점에 해당하는 정보를 담고 있다. 따라서 현재 프레임에서 검출한 차선과 이전 프레임에서 검출한 차선의 방정식의 ‘c’값을 비교하여 일정값 이상 차이가 나면 검출한 차선을 유효하지 않은 차선으로 판단한다.

3.5.1의 Score를 이용한 유효성 검사 알고리즘과 3.5.2의 차선의 방정식의 파라미터를 이용한 차선검출 알고리즘은 LiDAR를 통해 획득한 차선 데이터에 먼저 적용되어 유효한 차선인지 판단한다. 만약 두 가지 방법 모두 유효한 차선으로 판단하면 LiDAR를 통해 획득한 차선의 데이터를 현재 프레임의 차선 데이터로 사용한다. 만약 LiDAR를 통하여 획득한 차선에서 Invalid하다고 판단되면, Camera를 통해 획득한 차선의 데이터에 유효성 알고리즘을 다시 적용한 후, 두 가지 유효성검사 알고리즘에서 모두 유효하다고 판단하면 Camera를 통해 얻은 차선의 데이터를 현재 프레임의 차선으로 사용한다. 만약 Camera를 이용하여 획득한 차선 데이터에서도 Invalid 하다고 판단된다면 앞서 설명한 바와 같이 이전 프레임에서 저장한 차선의 데이터를 현재 프레임의 차선 데이터로 대체한다.

유효성 검사를 통해 유효한 차선으로 판단된 데이터들은 현재 프레임에서 올바르게 인식된 차선으로 정해진다. 그러므로 다음 프레임에서 사용할 ROI Mask를 현재 프레임에서 검출한 차선을 기준으로 생성하는 과정이 이어진다. ROI Mask는 현재 프레임에서 검출한 차선을 기준으로 하여 가우시안 분포를 적용하여 생성된다.

4. Experiment

본 연구의 실험은 Intel core i7-8750 2.2 GHz CPU와 Microsoft Visual Studio 2017 환경에서 수행하였다. 본 연구에서 제안한 알고리즘인 LiDAR-only, Camera-only, LiDAR-Camera의 성능 평가를 위해 KITTI raw dataset11)의 851장의 Frame을 사용하였다. MATLAB의 Ground Truth Labeler를 통해 수동으로 취득한 Ground truth 데이터는 본 연구에서 제안한 알고리즘들의 차선인식률 검증을 위해 사용하였다. Fig. 5는 Ground Truth Labeler를 통해 생성된 Ground truth 데이터들의 예를 나타내었다.

차선 검출률 측정비교는 카메라만 사용한 경우(Fig. 1의 Camera-only process), LiDAR만 사용한 경우(Fig. 1의 LiDAR-only process), 본 논문에서 제시한 Algorithm(Fig. 1의 Proposed algorithm)을 사용한 세 개의 경우에 대하여 각각 851개의 Frame을 적용하여 이루어졌다. 구체적인 차선 검출률 측정 방법은 Ground truth area 생성, 중심선(Center lane) 생성, Center lane과 Ground truth area와 비교, 총 3단계로 나누어진다. 첫 번째 과정인 Ground truth area 생성에서는 Annotation을 통해 생성한 Lane을 중심으로 x축 방향 ±10 offest을 주어 Ground truth area를 생성한다. 두 번째 과정인 중심선 생성에서는 센서들로부터 검출된 차선으로부터 x축 방향의 중심점들을 Interpolation 하여 중심선(Center lane)을 추출한다. 세 번째 과정인 중심선과 Ground truth area 비교에서는 중심선이 Ground truth area안에 모두 포함되는지 확인하여 Ground truth area안에 차선이 모두 포함되면 올바로 검출한 것으로 정의하였고, 한 개의 Pixel이라도 포함되지 않으면 검출에 실패한 것으로 정의하였다.

본 연구에서는 KiTTI road detection set11) 중 빛의 반사가 심하거나(Fig. 6(a)) 많은 그림자가 존재하는(Fig. 6(c)) 등 차선 검출에 있어서 가혹한 환경에 있는 Data set을 선정하여 성능 검증을 수행하였다. Table 1의 에 실험결과와 같이 카메라 기반(Fig. 1 Camera-only) 방법으로는 74.56 %의 차선 검출률을 보였고, LiDAR 기반(Fig. 1 LiDAR-only)으로는 69.06 %의 차선검출률 결과가 나왔다.

Comparison of lane detection accuracy among LiDAR-only, camera-only and the proposed algorithm(Camera, LiDAR and previous valid lane)

반면 본 연구에서 제안된 알고리즘의 차선검출률은 91.48 %의 상대적인 높은 성능이 검증되었다. 제안한 알고리즘은 Fig. 6에서와 같이 카메라가 차선인식에 실패했을 시(Fig. 6(a)), LiDAR에서 검출된 유효한 차선을 선택하며, LiDAR의 차선이 검증단계에서 통과가 되지 않으면(Fig. 6(b)) 유효한 카메라의 차선 검출 결과를 사용하여 강인한 차선 검출이 가능하다. 또한, Fig. 6(c)와 같이 LiDAR와 카메라가 모두 차선인식에 실패할 경우, 이전 프레임의 유효 차선을 사용함으로써 차선 검출의 오차를 최소화할 수 있다.

실험결과에서 명시하는 바와 같이 제안하는 차선 Dual monitoring 알고리즘은 각각의 단일센서를 통해 차선을 검출했을 때보다 많게는 22.42 % 차선검출률 향상이 가능함이 검증되었다.

5. 결 론

본 연구에서는 단일 LiDAR 혹은 카메라 기반의 차선검출 정확도를 향상하고 계산량을 최소화하기 위해 딥러닝 기반의 융합이 아닌 LiDAR와 카메라 듀얼센서 모니터링 기반의 차선인식 알고리즘을 새롭게 제안하였다. 제안한 듀얼 센서 모니터링 차선인식 알고리즘은 단일 LiDAR 기반의 차선 인식 기법에 기반하지만 도로 환경에 따라 차선 인식의 정확도가 낮아져 자체 개발한 검출 유효성 검사에 따라 카메라 기반의 차선인식 결과로 대체하여 검출 정확도를 개선하는 방법이다.

KITTI road detection dataset으로 실험을 수행한 결과 제안하는 알고리즘이 각각의 단일센서를 통해 차선을 검출했을 때 보다 많게는 22.42 % 차선검출률 향상됨을 검증하였고, 약 10 fps의 연산 속도를 보여주었다.

고성능 차선 검출이 검토되었지만 성능 향상을 위해 다음과 같은 부분에서 추가 연구가 필요하다. 첫째로는 본 알고리즘이 이전 프레임의 데이터에 높은 의존성을 가지고 있으며 연속으로 카메라와 LiDAR 모두 차선 검출에 실패하는 경우에 차선 검출 신뢰성이 하락하는 문제가 존재한다. 실험 Dataset에서는 LiDAR와 카메라가 모두 차선을 검출하지 못한 경우가 드물었으나 가혹한 환경에 대한 차선 검출성능을 향상시켜야 할 필요성이 있다.

또한 주어진 실험환경 내에서 약 10 fps의 연산속도를 보여주었으나 실시간 적용을 위해 딥러닝 센서 융합기반의 차선 방법보다 더 높은 연산 속도가 가능하도록 개선할 필요성이 있다.

Acknowledgments

본 연구는 한동대학교 교내연구지원사업 제 201901900001 호에 의한 것임. 프로그래밍에 도움을 준 황재욱 및 강수빈 학생에게 감사드립니다.

References

-

H. Jang, W. Son, T. Ahn, Y. Lee and K. Park, “A Study on Methods for Constructing Deep Learning Training Datasets for Object Classification Using Virtual 3D Lidar Sensor,” Transactions of KSAE, Vol.28, No.6, pp.427-437, 2020.

[https://doi.org/10.7467/KSAE.2020.28.6.427]

-

H. –S. Shin, M. –J. Kim and J. –H. Kim, “Path Generation and Tracking Algorithm of Auto Valet Parking System Development,” Transactions of KSAE, Vol.28, No.6, pp.389-399, 2020.

[https://doi.org/10.7467/KSAE.2020.28.6.389]

-

A. B. Hillel, R. Lerner, D. Levi and G. Raz, “Recent Progress in Road and Lane Detection: a Survey,” Machine Vision and Applications, Vol.25, pp.727-725, 2014.

[https://doi.org/10.1007/s00138-011-0404-2]

- K. Takagi, K. Morikawa, T. Ogawa and M. Saburi, “Road Environment Recognition Using On-vehicle LIDAR,” IEEE Intelligent Vehicles Symposium, pp.120-125, 2006.

- T. Li and D. Zhidong, “A New 3D LIDAR-Based Lane Markings Recognition Approach,” IEEE International Conference on Robotics and Biomimetics, pp.2197-2202, 2013.

-

P. Lindner, E. Richter, G. Wanielik, K. Takagi and A. Isogai, “Multichannel Lidar Processing for Lane Detection and Estimation,” 12th International IEEE Conference on Intelligent Transportation Systems, pp.1-6, 2009.

[https://doi.org/10.1109/ITSC.2009.5309704]

-

J. Kocić, N. Jovičić and V. Drndarević, “Sensors and Sensor Fusion in Autonomous Vehicles,” 26th Telecommunications Forum(TELFOR), pp.420-425, 2018.

[https://doi.org/10.1109/TELFOR.2018.8612054]

-

M. Kutila, P. Pyykönen, W. Ritter, O. Sawade and B. Schäufele, “Automotive LIDAR Sensor Development Scenarios for Harsh Weather Conditions,” IEEE 19th International Conference on Intelligent Transportation Systems, pp.265-270, 2016.

[https://doi.org/10.1109/ITSC.2016.7795565]

- X. Gu, A. Zang, X. Huang, A. Tokuta and X. Chen, “Fusion of Color Images and LiDAR Data for Lane Classification,” Proceedings of the 23rd SIGSPATIAL International Conference on Advances in Geographic Information Systems, Article No.69, 2015.

-

G. Cui, J. Wang and J. Li, “Robust Multilane Detection and Tracking in Urban Scenarios Based on LIDAR and Mono-vision,” IET Image Process, pp.269-279, 2014.

[https://doi.org/10.1049/iet-ipr.2013.0371]

-

A. Geiger, P. Lenz, C. Stiller and R. Urtasun, “Vision Meets Robotics: The KITTI Dataset,” The International Journal of Robotics Research, Vol.32, No.11, pp.1231-1237. 2013.

[https://doi.org/10.1177/0278364913491297]

-

Y. Xing, C. Lv, L. Chen, H. Wang, H. Wang, D. Cao, E. Velenis and F. -Y. Wang, “Advances in Vision-based Lane Detection: Algorithms, Integration, Assessment, and Perspectives on ACP-Based Parallel Vision,” IEEE/CAA Journal of Automatica Sinica, Vol.5, No.3, pp.645-661, 2018.

[https://doi.org/10.1109/JAS.2018.7511063]

-

U. Suddamalla, S. Kundu, S. Farkade and A. Das, “A Novel Algorithm of Lane Detection Addressing Varied Scenarios of Curved and Dashed Lanemarks,” International Conference on Image Processing Theory, Tools and Applications (IPTA), pp.87-92, 2015.

[https://doi.org/10.1109/IPTA.2015.7367103]

-

U. Ozgunalp, R. Fan, X. Ai and N. Dahnoun, “Multiple Lane Detection Algorithm Based on Novel Dense Vanishing Point Estimation,” IEEE Transactions on Intelligent Transportation Systems, Vol.18, No.3, pp.621-632, 2017.

[https://doi.org/10.1109/TITS.2016.2586187]

-

J. M. Collado, C. Hilario, A. de la Escalera and J. M. Armingol, “Adaptative Road Lanes Detection and Classification,” Advanced Concepts for Intelligent Vision Systems, pp.1151-1162, 2006.

[https://doi.org/10.1007/11864349_105]

-

Y. Huang, Y. Li, X. Hu and W. Ci, “Lane Detection Based on Inverse Perspective Transformation and Kalman Filter,” KSII Transactions of Internet and Information Systems, Vol.12, No.2, pp.643-661, 2018.

[https://doi.org/10.3837/tiis.2018.02.006]

-

Y. Wang, D. G. Shen and E. K. Teoh, “Lane Detection Using Spline Model,” Pattern Recognition Letters, Vol.21, No.8, pp.677-689, 2000.

[https://doi.org/10.1016/S0167-8655(00)00021-0]

-

Y. Wang, E. K. Teoh and D. G. Shen, “Lane Detection and Tracking Using B-Snake,” Image and Vision Computing, Vol.22, No.4, pp.269-280, 2004.

[https://doi.org/10.1016/j.imavis.2003.10.003]

-

M. A. Fischler and R. C. Bolles, “Random Sample Consensus: A Paradigm for Model Fitting with Applications to Image Analysis and Automated Cartography,” Communications of the ACM, Vol.24, No.6, pp.381-395, 1981.

[https://doi.org/10.1145/358669.358692]

-

M. Aly, “Real Time Detection of Lane Markers in Urban Streets,” IEEE Intelligent Vehicles Symposium, pp.7-12, 2008.

[https://doi.org/10.1109/IVS.2008.4621152]

-

J. Li, X. Mei, D. Prokhorov and D. C. Tao, “Deep Neural Network for Structural Prediction and Lane 10) Detection in Traffic Scene,” IEEE Transactions on Neural Networks and Learning Systems, Vol.28, No.3, pp.690-703, 2017.

[https://doi.org/10.1109/TNNLS.2016.2522428]

-

J. Kim, J. Kim, G. J. Jang and M. Lee, “Fast Learning Method for Convolutional Neural Networks Using Extreme Learning Machine and Its Application to Lane Detection,” Neural Networks, Vol.87, pp.109-121, 2017.

[https://doi.org/10.1016/j.neunet.2016.12.002]

- K. Takagi, K. Morikawa, T. Ogawa and M. Saburi, “Road Environment Recognition Using On-vehicle LIDAR,” IEEE Intelligent Vehicles Symposium, pp.120-125, 2006.

-

H. Lee, S. Kim, S. Park, Y. Jeong, H. Lee and K. Yi, “AVM/Lidar Sensor Based Lane Marking Detection Method for Automated Driving on Complex Urban Roads,” IEEE Intelligent Vehicles Symposium(IV), pp.1434-1439, 2017.

[https://doi.org/10.1109/IVS.2017.7995911]

-

A. Gurghian, T. Koduri, S. V. Bailur, K. J. Carey and V. N. Murali, “DeepLanes: End-To-End Lane Position Estimation Using Deep Neural Networks,” CVPR Workshops, pp.38-45, 2016.

[https://doi.org/10.1109/CVPRW.2016.12]