전기차 무선 충전을 위한 주차위치 탐색에 관한 연구

Copyright Ⓒ 2020 KSAE / 176-05

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Presented in this paper is a method of searching the parking space for an electric vehicle, and of tracking a wireless charging spot accurately from the bird’s-eye-view image provided by the AVM(around view monitoring) system, by fusing four fish-eye cameras already mounted on produced vehicles. In addition, how to get parameters and combine four fish-eye cameras for AVM images throughout camera calibration is introduced. The proposed detection method finds parking spaces based on vision using image segmentation. Assembling enormous datasets can be a very daunting and time-consuming task due to the manual effort of collecting and labeling data. To solve this problem, this paper used data augmentation, a data space solution to the problem of limited data. The proposed tracking method is robust against problems like dim lighting, background, and reflections on road surfaces.

Keywords:

Around view monitoring system, Camera calibration, Data augmentation, Parking slot detection, Bird’s eye view image키워드:

어라운드 뷰 모니터링 시스템, 카메라 캘리브레이션, 데이터 확장, 주차공간 탐색, 조감도 영상1. 서 론

자율 주행의 기술이 향상됨에 따라 운전자에게 편의 기능을 제공하는 ADAS(Advanced Driver Assistance System)와 함께 일부 구간에서 자율 주행이 가능한 자율 주행 서비스가 제공되고 있다. 최근에는 단순히 기술을 향상시키는 기술 연구보다는 환경과 편의성에 초점을 맞추어 전기자동차를 이용한 연구가 진행되고 있다.

전기자동차를 이용한 자율 주행 배송 서비스를 구현하기 위해서는 무선 충전이 가능한 주차공간에 자동 주차 기능을 개발해야 한다. 특히, 전기차의 무선 충전 효율을 높이기 위해서는 정확한 주차 위치를 검출해야 한다.1) 자동 주차 시스템은 빈 주차 공간을 인식하는 것으로 시작되지만, 주차장은 다양한 장애물과 조명이 존재하는 통제되지 않은 환경이기 때문에 이러한 시스템이 사용 가능한 위치를 올바르게 인식하기가 어렵다. 현재 흔하게 사용되는 인식 방법으로 초음파센서와 후방카메라를 이용한 방법이 있다. 초음파센서는 장애물이나 기둥이 감지되면 소리로써 그 정보를 알려주지만 부정확한 범위 데이터로 인해 사용 가능한 주차공간을 탐지하지 못하기도 한다. 후방카메라는 후방의 영상을 제공함으로써 주차에 필요한 많은 정보를 제공하지만 사각지대가 존재하기 때문에 전, 후, 좌, 우를 모두 확인할 수 있는 AVM 시스템이 필수적이다. AVM 시스템은 전, 후, 좌, 우의 최소 4대의 카메라의 영상을 합성하여 조감도 영상을 제공하는 시스템이다.2,3)

자동 주차를 위해서는 인지, 판단, 제어가 모두 필요하지만, 본 논문에서는 카메라만을 이용한 주차공간 탐색 및 목표 위치 설정에 중점을 두었다. 주차공간을 탐색하는 방법은 크게 2가지로 나눌 수 있는데 주차 영역을 탐색하는 방법과 특징점과 표식 등을 이용한 방법이 있다.

공간을 탐색하는 방법은 현재 많은 양산차량에도 사용이 되고 있다. 라이더,4) 레이더,5) 초음파센서6)와 같은 거리를 알 수 있는 센서를 사용해서 주차공간을 탐색한다. 이러한 센서는 주차공간을 탐색할 수는 있으나 배송 서비스를 위한 무선 충전 구역을 식별하기에는 어려움이 있다.

특징점, 표식을 인식하는 방법은 주차장에 설치되어 있는 CCTV와 같은 고정 카메라,7,8) 드론9)을 이용한 이동 카메라 차량에 부착된 광각 카메라를 사용하는 방법이 있다. 차량 외에 다른 위치에 설치되어 있는 카메라로 주차공간을 탐색하는 방법은 인프라가 갖춰지지 않으면 사용할 수 없기 때문에 차량에 부착되어 있는 카메라를 사용하여 주차공간을 탐색하는 것이 효율적이다. 주차공간을 찾기 위한 카메라로는 주로 광각 카메라가 사용된다. 이 광각 카메라로 취득된 데이터는 기하학적 변환을 거쳐 조감도 영상으로 변환이 되는데 이때, 주차장은 여러 개의 직선으로 표시가 된다. 이 직선을 찾기 위해 기존에는 허프변환, 특징 맵(Feature map)10-12)을 이용한 방법, 코너라인 및 패턴 매칭 기술13-15) 등 사용되었다. 하지만, 희미한 조명, 배경 및 노면의 반사 등으로 인해 오류가 자주 발생한다. 그래서 최근에는 기계학습16,17)을 이용한 방법을 사용함으로써 주차 영역 인식의 정확도를 높이고 있다.

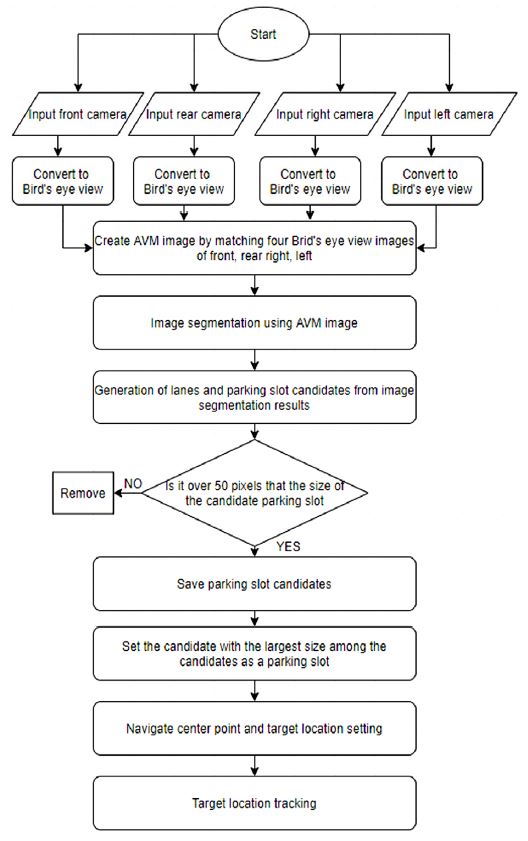

본 논문에서는 이미 탑재된 4개의 어안 카메라 센서를 융합하여 AVM 영상을 만드는 방법과 AVM 영상에서 전기 자동차의 주차공간을 탐색하고 무선 충전 지점을 정확하게 추적하는 방법을 제안한다. 또한 카메라 보정을 통한 고유한 매개변수를 얻는 방법과 4개의 카메라 영상을 결합하는 방법을 제안했다. 주차 영역 감지는 크게 3단계로 나뉜다. 첫째, 전, 후, 좌, 우 4개의 어안 카메라를 입력으로 AVM 영상을 만든다. AVM 영상을 만들 때 기하학적 연산으로 인하여 컴퓨터 자원을 많이 사용하게 되는데 Look Up Table을 이용하여 연산속도를 최대화할 수 있다. 둘째, AVM 영상을 입력으로 이미지 분할의 딥러닝 모델을 이용하여 주차선과 주차 영역을 인지한다. 카메라 영상은 조명과 빛반사에 취약한 문제점이 있지만, 학습을 시키는 과정에서 데이터 확장을 통해 희미한 조명, 배경, 노면의 빛반사 등과 같은 문제에 강하며 실외 또는 실내 주차장에 관계없이 인식 가능하게 하였다. 마지막으로 인식된 주차 영역의 중심점을 탐색하여 차량이 최종적으로 이동할 위치를 나타낸다. 목표 위치는 차량이 움직이는 동안 AVM 영상 내에서 지속적으로 추적된다. 제안된 방법은 사전에 미리 생성한 GT(Ground Truth)데이터를 사용하여 결과를 검증하였다.

2. AVM 영상 제작

2.1 카메라 구성

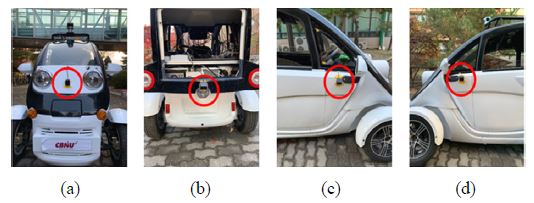

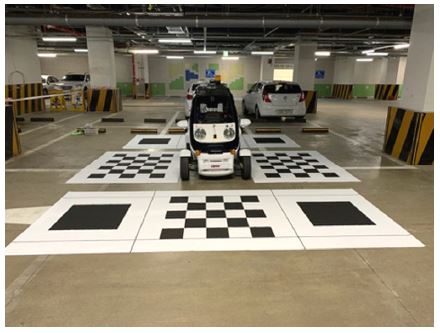

1920*1080의 해상도와 190도의 화각을 가지고 있는 세코닉스사18)의 카메라가 전, 후, 좌, 우 총 4대가 차량에 부착되어 있다. 서로 다른 4대의 카메라영상은 카메라 캘리브레이션19)과 기하학적 변환을 통해 AVM 영상으로 만들어 진다. Fig. 2는 실제 실험에 사용된 차량의 카메라가 설치된 위치를 나타낸 것이다.

2.2 카메라 캘리브레이션

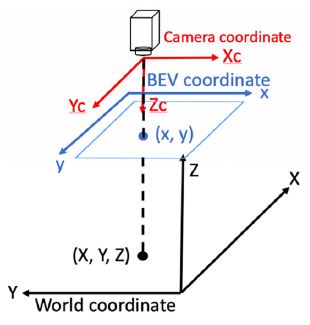

우리가 실제로 보는 세상은 3차원이다. 하지만 이것을 카메라 영상에 담으면 2차원의 이미지로 변하게 되는데 영상을 변환 당시의 카메라의 위치 및 방향에 의해 3차원의 점들이 이미지상에서 어디에 맺히게 되는지 결정된다. 실제 이미지는 사용된 렌즈, 렌즈와 이미지 사이의 거리, 렌즈와 이미지 센서가 이루는 각 등 카메라 내부의 기구적인 부분에 의해서 크게 영향을 받는다. 따라서, 영상 간의 기하학적인 변환이나 3차원 점들의 투영 위치를 구하고 3차원의 월드 좌표를 복원할 때는 이러한 내부 요인을 제거해야 정확한 계산이 가능해진다. 이러한 내부 요인의 파라미터 값을 구하는 과정을 카메라 캘리브레이션이라고 부른다. 이 파라미터는 크게 내부 파라미터와 외부 파라미터로 나뉜다. Fig. 3은 조감도 영상으로 변환하기 위한 좌표계의 관계를 나타낸 것이다.

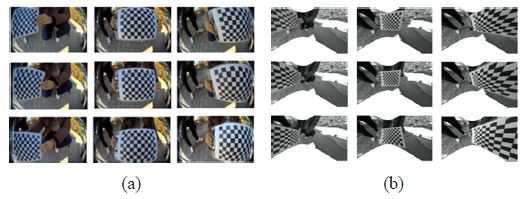

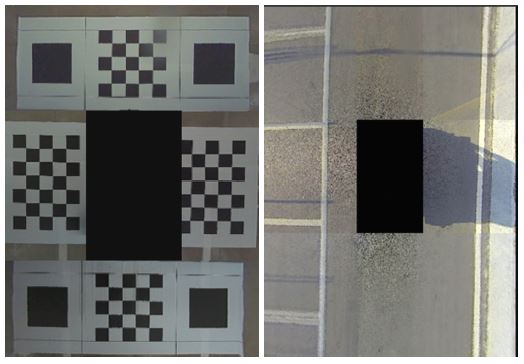

내부 파라미터는 초점거리, 주점거리, 비대칭 계수가 존재하는데 초점거리는 렌즈와 이미지센서의 거리를 말하고 주점거리는 카메라 렌즈의 중심을 말한다. 비대칭 계수는 이미지 센서의 셀 배열이 기울어진 정도를 나타낸다. 화각이 넒은 카메라를 사용하면 넓은 범위를 볼 수 있지만 상대적으로 영상의 왜곡이 심해지는 문제가 있으며 이는 영상의 중심에서부터 영상의 끝으로 갈수록 심해진다. 그렇기 때문에 Fig. 4와 같이 영상의 끝부분에 체커보드를 배치하여 내부 파라미터를 구한다.20) 내부 파라미터는 Table 1과 같고 왜곡 계수는 Table 2와 같다.

카메라의 외부 파라미터는 카메라 좌표계와 월드 좌표계 사이의 변환 관계를 설명하는 파라미터로서 두 좌표계 사이의 회전과 평행이동 변환으로 표현된다. Fig. 6은 본 연구에서 입력영상으로 사용하기 위한 조감도 영상으로 4개의 어안 카메라 입력 영상의 좌표계를 변환하고 1개의 조감도 영상으로 정합하여 생성하였다. 좌표계 변환식은 식 (1)과 같다.

| (1) |

차량에 설치되어 있는 각 카메라들은 모두 설치되어 있는 높이, 위치, 각도가 다르다. 그래서 입력 영상을 조감도 영상으로 변환할 때 전, 후, 좌, 우 4개의 입력영상에서 보이는 체커보드의 사각형이 정사각형이 되며 그 크기가 모두 같아질 수 있는 회전 변환, 이동 변환, 크기 변환의 값을 조정하여 조감도 영상으로 변환한다. 전, 후, 좌, 우의 조감도영상을 정합할 때 겹치는 영역이 발생하는데 겹치는 영역은 해당 영역의 RGB 값을 반반씩 사용하여 AVM 영상을 만들었다.

3. 주차 영역 탐색

주차 영역 탐색은 주차선과 주차 영역을 가장 잘 찾고 분류를 할 수 있는 알고리즘 중 하나인 이미지 분할(Image segmentation)의 딥러닝 모델 중 하나인 ESPNet을21) 활용하여 연구를 진행하였다. ESPNet은 이미지 분할 모델 중 속도와 성능이 모두 우수하기 때문에 실시간성을 요구하는 실차에서 적용가능하다. 그리고 모델의 중간 부분에서 어떤 특징을 기반으로 학습을 진행했는지 확인하기가 비교적 간편하다. 또한 데이터 확장(Data augmentation)22)을 통해 모델의 성능을 높이고 정확한 주차 위치를 탐색하였다.

3.1 The Data Set & Labeling

제안된 방법으로 만들어진 AVM 영상을 입력으로 하여 400개의 데이터 세트를 구성하였다. 더 큰 데이터 세트가 더 나은 딥러닝 모델로 이어진다는 것이 일반적으로 인정되는 개념이다. 하지만 데이터를 수집하고 레이블을 지정하는 수동 작업으로 인해 엄청난 양의 데이터 세트를 라벨링 하는 것은 매우 어려운 작업이며 많은 시간을 소비할 수 있다. 이 문제를 해결하기 위해서 본 논문에서는 제한된 데이터 문제에 대한 데이터 공간 솔루션인 데이터 확장을 제안한다. 480*400 픽셀 크기의 400개 AVM 영상을 각 0, 90, 180, 270도 회전시켜 1600개의 데이터 세트를 훈련시켰으며, 기하학적 변환, 색상 지터(랜덤 컬러 조작) 및 임의의 원근법 조작을 훈련시켰다. 제안된 검출 방법은 희미한 조명, 배경, 노면의 반사 등과 같은 문제에 강력하며 실외 또는 실내 주차장에 관계없이 주차선과 주차공간을 인식할 수 있다. 사용된 데이터는 주차선, 무선 충전 주차장, 배경으로 총 3개의 영역으로 나누어 학습을 진행하였다. 400개의 데이터 세트에는 실내, 실외, 주차장을 포함한 경우, 포함하지 않은 경우 등 다양한 시나리오가 포함되었다.

3.2 주차위치 탐색

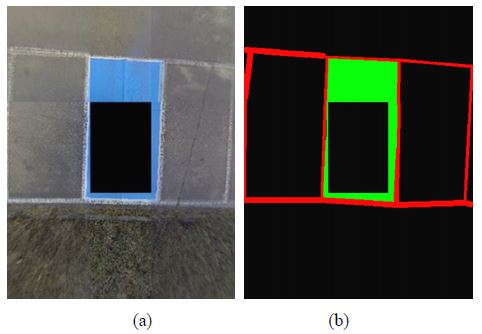

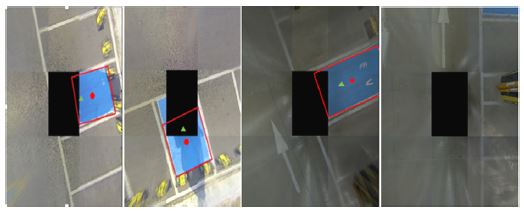

전기차 무선 충전을 위해서는 주차장 내 무선충전 패드와 차량에 부착되어 있는 충전 패드가 겹쳐야 한다. 본 연구에서는 무선충전 패드가 주차 영역 중심에 매립되어 있다고 가정하고 주차공간의 중심점을 주차위치로 설정하였다. 이미지 분할로 나온 결과물 중 크기가 50 픽셀 미만의 주차공간 후보는 긍정 오류(False positive)의 확률이 높으므로 제거를 하였다. 50 픽셀 이상의 주차공간 후보 중 크기가 가장 큰 후보를 주차 영역으로 지정하고 지정된 주차영역을 모두 포함할 수 있는 최소 크기의 사각형을 생성하였다. 주차 위치는 AVM 영상 내에서 생성된 사각형의 크기가 실제 주차공간 크기의 90 % 이상이 됐을 때 설정하며, 그때 생성된 사각형의 중심점으로 지정하였다. Fig. 8(a)는 이미지 분할의 최종 결과물을 나타낸 것이고 Fig. 8(b)의 초록색 원은 무선 충전이 가능한 공간의 중심점 즉, 차량이 이동해야 할 최종 목적지인 주차위치를 나타낸 것이다.

4. 실험 결과

본 논문에서는 제안한 주차 영역 인식의 성능 평가를 위해 실제로 양산에 적용된 AVM 카메라를 장착한 실 차량으로 충북대학교에서 데이터를 취득했다. 평가에 사용된 영상은 총 400개로 학습에 사용되지 않은 실내 영상 200개, 실외 영상 200개로 구성되어 있다. 실험 환경은 CPU : Intel(R) Core(TM) i7-7700HQ CPU@2.8GHz, GPU : NVIDIA GeForce GTX 1060, Memory : DDR4 16GB, OS : Linux ubuntu 16.04에서 진행되었다. 이미지 분할은 mIoU (Mean Intersection over Union)에23) 대한 지표로 성능 평가를 하였다. 이미지 분할 실험 결과는 Table 3과 같다.

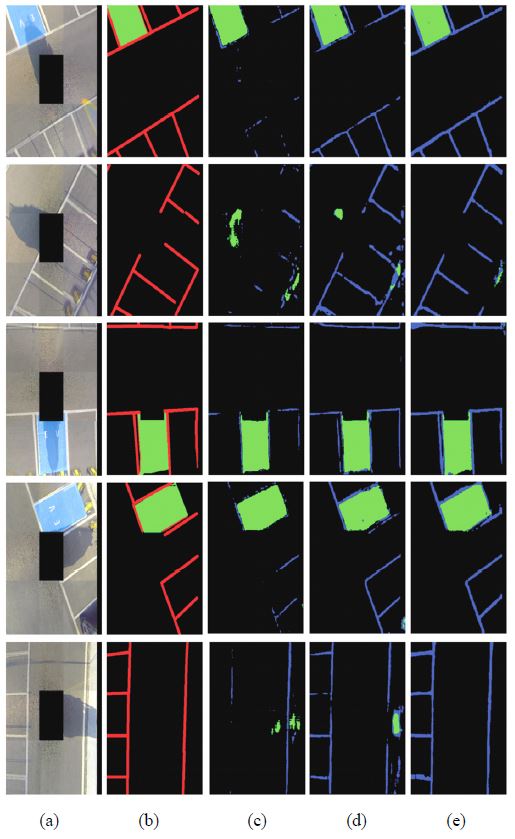

Fig. 9는 Table 3의 결과 영상을 나타낸 것이다. 400개의 AVM 영상을 학습시켰을 때는 mIoU가 0.566이 나왔으며, 영상 회전을 통해 1600개로 학습량을 늘렸을 때는 mIoU가 0.681, 기하학적 변환, 색상 지터(랜덤 컬러 조작) 및 임의의 원근법 조작을 학습 하였을 때는 mIoU가 0.811로 400개의 영상만 학습시켰을 때 보다 43.28 %의 성능이 향상되었다. 또한, 그림자를 주차공간으로 인식하는 긍정 오류가 많이 감소하였다.

(a) Input images (b) GT images (c) Results of training 400 images (d) Results of training 1600 images (e) Results of training 1600 images + data augmentation

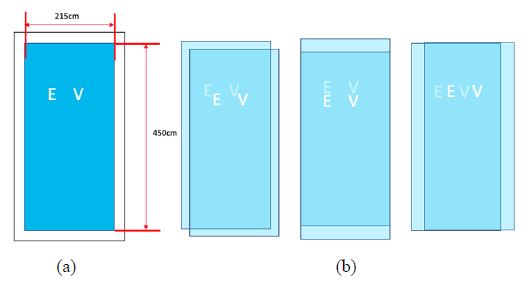

Fig. 10(a)는 실험에 사용된 주차장 크기를 나타낸 것이고 Fig. 10(b)는 실제 주차 영역과 인식된 주차 영역이 겹치는 경우를 나타낸 것이다. 실제 주차 영역의 중심점과 인식된 박스의 중심점 사이의 유클리드 거리가 20 cm 이하일 경우 차량이 실제 주차장에 주차를 하여 무선 충전을 할 수 있고 충전 효율이 82 % 이상이기 때문에24) 이를 기준으로 IoU를 계산해 보면 최소 0.741의 값이 나와야 한다는 것을 알 수 있다. 즉, 영상 분할을 통해 82 % 이상의 효율로 전기차를 무선충전하기 위해서는 IoU가 0.741이 나와야 한다. 본 연구에서는 mIoU가 0.811이 나와 위의 조건을 만족한다. 속도는 평균 FPS(Frame Per Second)가 15이상 나오며 주차 상황이라는 특성상 차량의 운행 속도가 10 km/h 이하로 운행되기 때문에 실제 차량에 적용이 가능하다.

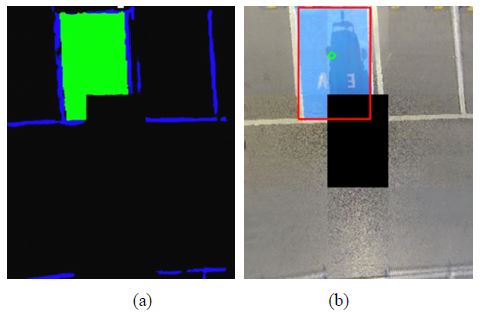

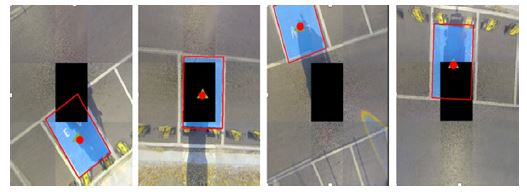

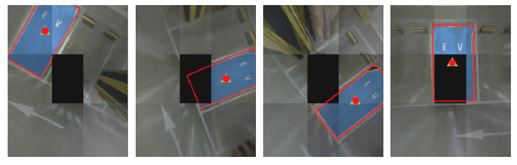

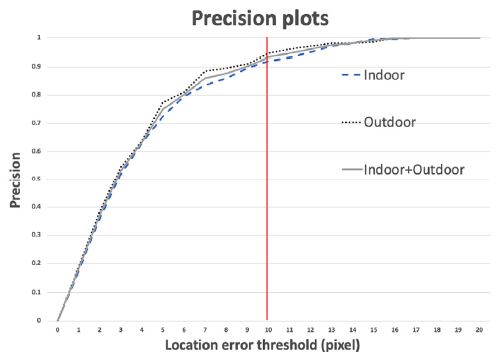

Fig. 11과 Fig. 12는 실내와 실외주차장에서의 무선 충전이 가능한 영역의 중심점을 인식한 결과를 나타낸 것이고 실제 주차 영역의 중심점과 제안된 방법으로 검출된 주차 위치의 오차를 유클리드 거리(Euclidean distance)로 나타내었다. Fig. 13은 유클리드 거리에 따른 정확도(Precision)를 표현한 것이다. 본 연구에서 AVM영상의 한 픽셀당 실제 거리가 약 2 cm에 해당한다. 실제 주차 영역의 중심점과 인식한 결과의 중심점 사이의 유클리드 거리가 10픽셀 이하일 경우 주차 위치를 올바르게 찾은 것으로 간주하였다. 평가에 사용된 영상 400개 중 374개의 영상에서 중심점을 올바르게 찾아 93.5 %의 정확도를 보였다. 실외에서는 주차공간이 존재하는 200개의 AVM 영상 중 189개의 주차공간 중심점을 정확하게 찾아 94.5 %의 정확도를 보였고 실내에서는 주차공간이 존재하는 200개의 AVM 영상 중 185개의 주차공간 중심점을 정확하게 찾아 92.5 %의 정확도를 보였다.

Fig. 14는 주차 위치의 오검출 예시를 나타낸 것이다.삼각형은 실제 주차공간의 중심점을 나타낸 것이고 원은 제안된 방법으로 인식된 중심점을 나타낸 것이다. 현재 차량이 주차공간과양 옆의 차선을 함께 가릴 때 실제 주차가 가능한 공간이지만 주차 위치를 제대로 설정하지 못하는 오류가 종종 발생하였다. 하지만 실제 시스템에서는 차량이 주차공간을 가리기 전에 목표 위치를 설정하고 저장하여 정확한 위치에 주차를 하는 것이 가능하다.

5. 결 론

본 논문은 이미 탑재된 4개의 어안 카메라를 융합하여 AVM 영상을 만들고 제한된 데이터 세트를 활용해 높은 성능의 무선 충전 영역을 탐색하고 중심점을 추적하는 방법을 제안했다. 현재 차량이 주차공간을 많이 가린 경우 실제 주차가 가능한 공간이지만 주차공간을 제대로 인식하지 못하는 상황이 종종 발생하였다. 이러한 문제를 해결하기 위해서 현재 딥러닝 모델에 추적 알고리즘과 주차장 위치를 예측해 주는 알고리즘 연구가 필요하다. 본 논문에서는 무선충전 패드가 주차 영역 중심에 매립되어 있다고 가정하고 실험을 진행하였지만 향후 인프라가 갖춰지면 실제 무선 충전이 가능한 자동주차 시스템을 개발할 계획이다.

Acknowledgments

본 연구는 산업통산자원부 산업기술혁신사업(10082585, 자율 주행이 가능한 딥러닝 기반 개방형 EV 차량 플랫폼 기술개발)에 의해 수행되었음.

References

- BMW, https://www.youtube.com/watch?v=GlrcPrzuPMM, , 2019.

-

B. Leibe, N. Cornelis, K. Cornelis and L. Van Gool, “Dynamic 3D Scene Analysis from a Moving Vehicle,” 2007 IEEE Conference on Computer Vision and Pattern Recognition, Minneapolis, pp.1-8, 2007.

[https://doi.org/10.1109/CVPR.2007.383146]

-

D. K. Lee and S. C. Kee, “Real-time Implementation of the Parking Line Departure Warning System Using Partitioned Vehicle Region Images,” Transactions of KSAE, Vol.27, No.7, pp.553-560, 2019.

[https://doi.org/10.7467/KSAE.2019.27.7.553]

-

J. Lee, J. Jo and T. Park, “Segmentation of Vehicles and Roads by a Low-Channel Lidar,” IEEE Transactions on Intelligent Transportation Systems, Vol.20, No.11, pp.4251-4256, 2019.

[https://doi.org/10.1109/TITS.2019.2903529]

-

R. Prophet, M. Hoffmann, M. Vossiek, G. Li and C. Sturm, “Parking Space Detection from a Radar Based Target List,” 2017 IEEE MTT-S International Conference on Microwaves for Intelligent Mobility (ICMIM), Nagoya, pp.91-94, 2017.

[https://doi.org/10.1109/ICMIM.2017.7918864]

- T. Wu, P. Tsai, N. Hu and J. Chen, “Research and Implementation of Auto Parking System Based on Ultrasonic Sensors,” 2016 International Conference on Advanced Materials for Science and Engineering( ICAMSE), Tainan, pp.643-645, 2016.

-

J. Nyambal and R. Klein, “Automated Parking Space Detection Using Convolutional Neural Networks,” 2017 Pattern Recognition Association of South Africa and Robotics and Mechatronics(PRASA-RobMech), Bloemfontein, pp.1-6, 2017.

[https://doi.org/10.1109/RoboMech.2017.8261114]

-

R. Rajalekshmi, B. Radhakrishnan and L. P. Suresh, “Intelligent Parking Space Detection and Number Plate Extraction,” 2017 International Conference on Circuit, Power and Computing Technologies(ICCPCT), Kollam, pp.1-6, 2017.

[https://doi.org/10.1109/ICCPCT.2017.8074327]

-

C. Peng, J. Hsieh, S. Leu and C. Chuang, “Drone-Based Vacant Parking Space Detection,” 2018 32nd International Conference on Advanced Information Networking and Applications Workshops(WAINA), Krakow, pp.618-622, 2018.

[https://doi.org/10.1109/WAINA.2018.00155]

-

S. J. Han and J. D. Choi, “Parking Space Recognition for Autonomous Valet Parking Using Height and Salient-Line Probability Maps,” Etri Journal, Vol.37, No.6, pp.1220-1230, 2015.

[https://doi.org/10.4218/etrij.15.0114.0112]

-

M. Lee, S. Kim, W. Lim and M. Sunwoo, “Probabilistic Occupancy Filter for Parking Slot Marker Detection in an Autonomous Parking System Using AVM,” IEEE Transactions on Intelligent Transportation Systems, Vol.20, No.6, pp.2389-2394, 2019.

[https://doi.org/10.1109/TITS.2018.2855183]

-

J. S. Lee and S. C. Kee, “Empty Parking Space Detection Method Using Around View Monitoring System,” International Journal of Control, Robotics and Systems, Vol.23, No.6, pp.455-461, 2017.

[https://doi.org/10.5302/J.ICROS.2017.17.0043]

-

J. K. Suhr and H. G. Jung, “Automatic Parking Space Detection and Tracking for Underground and Indoor Environments,” IEEE Transactions on Industrial Electronics, Vol.63, No.9, pp.5687-5698, 2016.

[https://doi.org/10.1109/TIE.2016.2558480]

- L. Li, L. Zhang, X. Li, X. Liu, Y. Shen and L. Xiong, “Vision-based Parking-slot Detection: A Benchmark and a Learning-based Approach,” 2017 IEEE International Conference on Multimedia and Expo(ICME), Hong Kong, pp.649-654, 2017.

-

D. S. Bolme, J. R. Beveridge, B. A. Draper and Y. M. Lui, “Visual Object Tracking Using Adaptive Correlation Filters,” 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, San Francisco, CA, pp.2544-2550, 2010.

[https://doi.org/10.1109/CVPR.2010.5539960]

-

Q. Li, C. Lin and Y. Zhao, “Geometric Features-Based Parking Slot Detection,” Sensors, Vol.18, No.9, pp.2821-2836, 2018.

[https://doi.org/10.3390/s18092821]

-

L. Zhang, J. Huang, X. Li and L. Xiong, “Vision-Based Parking-Slot Detection: A DCNN-Based Approach and a Large-Scale Benchmark Dataset,” IEEE Transactions on Image Processing, Vol.27, No.11, pp.5350-5364, 2018.

[https://doi.org/10.1109/TIP.2018.2857407]

- SEKONIX, http://sekolab.com/products/camera, , 2019.

-

C. H. Park and D. W. Lee, “Cailbrating a Depth Camera Based on Deep Learning of a 2D Planar Surface,” Transactions of KSAE, Vol.27, No.7, pp.521-527, 2019.

[https://doi.org/10.7467/KSAE.2019.27.7.521]

- D. Lee, https://darkpgmr.tistory.com/32, , 2019.

-

S. Mehta, M. Rastegari, A. Caspi, L. Shapiro and H. Hajishirzi, “ESPNet: Efficient Spatial Pyramid of Dilated Convolutions for Semantic Segmentation,” The European Conference on Computer Vision (ECCV), pp.552-568, 2018.

[https://doi.org/10.1007/978-3-030-01249-6_34]

-

C. Shorten and T. M. Khoshgoftaar, “A Survey on Image Data Augmentation for Deep Learning,” Journal of Big Data, Vol.6, Article Number 60, 2019.

[https://doi.org/10.1186/s40537-019-0197-0]

- Py Image Search, www.pyimagesearch.com/2016/11/07/intersection-over-union-iou-for-object-detection, , 2020.

- M. G. Park, V. T. Nguyen, S. D. Yu, S. W. Yim and K. J. Park, “Efficiency Measurements for 6.6kW WPT System According to the X and Y Offsets,” The Korean Institude of Electrical Engineers Summer Conference Proceedings, pp.9-10, 2016.