대상 추종을 위한 파티클 필터 기반 단안 카메라의 능동형 움직임 제어 알고리즘 개발 및 평가

Copyright Ⓒ 2020 KSAE / 171-05

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper proposes an active motion control algorithm of a single-camera based on a particle filter for object tracking. In other studies, a camera is one of the most used sensors for object recognition and tracking. Nevertheless, the fixed single-camera has its drawback: there is a limitation that if the object is out of the field of view of the fixed camera, the performance of recognition and tracking can be degraded. In this paper, a particle filter was used to track the target object by using RGB information from the camera, and the Lyapunov method was applied to control the stepper motor. The performance evaluation results showed that the camera module could track the desired point based on the control algorithm proposed in this study. The key contribution of this study is to design and evaluate the robust object tracking control by showing the same effect as expanding the field of view of the camera.

Keywords:

Particle filter, Lyapunov direct method, Stepper motor, Object tracking, Single camera키워드:

파티클 필터, 리아프노프 직접법, 스텝 모터, 대상 추종, 단안 카메라1. 서 론

최근 영상 처리 및 데이터 처리 기술, 그리고 인공지능 기반의 학습 기술이 발전함에 따라 카메라를 사용한 연구가 활발히 이루어지고 있다. 카메라는 공간, 가격 측면에서도 합리적으로 이용할 수 있는 기기이기 때문에 많은 연구에서 주요 비전 센서로써 사용되고 있다. 김민구 등1)은 카메라로 취득된 영상의 히스토그램을 분석하여 주차가 가능한 공간을 찾아내는 알고리즘을 제안하였고, Diaz-Cabrera 등2)은 단안 카메라를 사용하여 실시간성을 가진 강건한 교통 신호 감지 및 신호등과의 거리 추정 알고리즘을 제안하였다. 박정홍 등3)은 단안 카메라를 기반으로 한 근거리 선박 자동 탐지 알고리즘을 제안하고 평가하였다. Hane 등4)은 어안렌즈가 장착된 카메라와 휠 주행 거리계를 이용한 실시간 물체 탐지 알고리즘을 제안하였다. 이재설 등5)은 전방 광각 카메라를 이용한 차량 검출 및 추적에 관한 시스템을 구성하고 평가하였으며, 최경택 등6)은 단안 카메라를 활용하여 정밀 측위 시 고속도로 시설물에 대한 랜드 마크의 적합성을 평가하였다.

카메라는 물체의 탐지나 검출 뿐만 아니라 영상 내에서의 대상 물체 추종도 가능하다. 민희선 등7)은 카메라와 파티클 필터를 이용한 스텝 모터를 기반으로 한 대상 추종 제어 알고리즘을 제안하였다. Schedgger 등8)은 딥러닝과 다중 타겟 추적을 위한 프와송 다중 - 베르누이 혼합(Poisson Multi - Bernoulli Mixture, PMBM) 필터 기반의 2차원 단안 카메라 이미지를 이용한 3차원에서의 다중 물체 추종 알고리즘을 제안하였다. Chen 등9)은 영상 정보를 학습 데이터로 사용하는 심층 합성곱 신경망(Deep convolutional neural network)을 이용한 영상 내부에서의 물체 추종 방법을 제안하였다. Zhou 등10)은 확장 칼만 파티클 필터와 최소제곱 서포트 벡터 회귀 모형을 융합한 물체 추종 제어 알고리즘을 제안하고 평가하였다. 기존에 진행된 연구들을 살펴보면 모두 카메라가 고정된 상태에서 제안된 알고리즘이다. 하지만 카메라가 고정된 상태에서 영상데이터를 취득할 경우, 카메라의 시야각을 벗어난 대상 물체는 추종할 수 없다는 한계점이 존재한다. 이러한 한계점을 보완하기 위해 이광무 등11)은 상하좌우로 회전 및 이미지 확대가 가능한 PTZ(Pan-Tilt-Zoom) 카메라를 사용하여 취득한 영상에 차영상 기법을 적용한 파티클 필터를 사용하여 추적 대상을 찾아내고 해당 대상이 영상 내에서 알맞은 크기로 화면 중앙에 위치하도록 카메라의 속도를 제어하는 알고리즘을 제안하였다. 또한 이종영 등12)은 열감지 센서로 사람의 움직임을 감지하여 최적의 위치로 이동하고 대상을 추종하는 CCTV 시스템을, 라주혁 등13)은 영상 내에서 목표로 하는 RGB 값과 동일한 값을 가지는 x, y 위치를 저장하고 해당 위치들의 중심점을 찾아 카메라가 특정 색상을 추종하도록 하는 알고리즘을 제안하였다. 그러나 열감지 센서는 사람뿐만 아니라 일정 온도 이상의 물체 또한 감지한다는 한계점이, 목표 RGB 값을 지정하고 해당 값과 일치하는 위치들의 중심점을 찾는 방법은 명암이 가해졌을 때 영상 내 RGB 값에 변화가 생기기 때문에 색상의 특징을 추출하거나 명암 변화를 고려하는 알고리즘 없이는 대상 물체를 강건하게 추종하기 어렵다는 한계점이 존재한다. 이러한 한계점을 극복하기 위해 본 논문에서는 확률기반의 파티클 필터를 사용하여 단안 카메라가 목표 색상과 유사한 특정 범위 내 RGB 값을 가지는 대상을 추종하게 함으로써 명암 변화에 대해 강건한 성능을 보이는 알고리즘을 구성하였다.

이광무 등이 제안한 알고리즘도 본 논문과 동일하게 파티클 필터를 사용하지만, 본 논문에서 RGB 정보만을 사용하는 것과는 달리 HSV(색상 채도 명도, Hue Satuation Value) 공간과 Edge 이미지를 사용하여 이전 이미지와의 오차가 극심한 부분을 추종 대상이라고 판단한다. 또한 위 논문은 움직이는 물체의 추적에 초점을 맞추고 있으나, 본 논문은 향후 자율주행 대차 시스템14)에서 사용되는 레이저 스캐너 알고리즘과의 융합을 위해 대상 물체의 군집점 도출 및 추종에 중점을 두고 있다. 본 논문에서 제안하는 알고리즘은 RGB 정보를 사용하는 파티클 필터를 기반으로 군집점을 도출하여 영상 내에서 추종 대상의 색 위치를 추정하고, 추종 대상이 카메라의 시야각을 벗어나지 않고 영상의 중심에 위치하게끔 카메라의 횡방향 회전을 능동적으로 제어한다. 회전 제어를 위한 구동기는 스텝 모터가 사용되었으며 리아프노프 기법 기반 제어 입력이 도출되었다.

본 논문은 다음과 같이 구성되었다. 2장에서는 파티클 필터 기반의 물체 추종 알고리즘과 리아프노프 직접법 기반 제어 알고리즘으로 구성된 대상 추종 제어 알고리즘을 기술하였다. 3장에서는 실험을 위해 구성된 하드웨어를 이용하여 능동형 카메라 제어 알고리즘의 성능을 평가하였고, 논문의 전체적인 내용과 향후 계획을 4장에서 정리하였다.

2. 대상 추종 제어 알고리즘

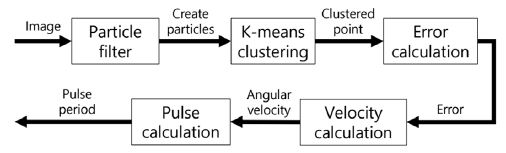

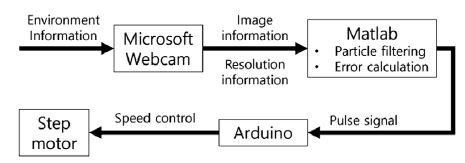

본 연구에서 사용되는 알고리즘의 모델 개략도를 Fig. 1로 표현하였다. 마이크로소프트 웹캠으로부터 영상 정보를 취득하며, 취득된 영상은 매트랩 환경에서 파티클 필터를 거치게 된다. 파티클 필터를 거쳐 추종 대상 색상에 모인 파티클의 위치를 분리형 군집화(K-means clustering)하여 도출된 군집점(Clustered point)과 이미지 중심점 사이의 오차를 리아프노프 직접법의 변수로 사용해 카메라와 대상 물체 사이의 각도 θ를 도출하였다. 스텝모터는 스텝 당 각도 정보가 정해져 있으므로 θ를 0으로 만들기 위한 펄스의 개수를 계산하여 인가함으로써 카메라의 회전 속도를 제어하였다.

2.1 파티클 필터 기반 물체 추종 알고리즘

본 논문은 영상 내 물체의 위치를 파악하기 위해 색상을 기반으로 한 파티클 필터를 이용하였다. 파티클 필터 기반의 물체 추종 알고리즘은 파티클 생성, 파티클 갱신, 가능도 계산, 파티클 재표본 추출(Resampling)의 과정으로 진행된다. 파티클 생성 단계에서는 영상 내부의 위치와 평균이 0이고 분산이 1인 정규분포의 속도를 가지는 파티클을 무작위로 생성한다. 파티클 갱신 과정은 수식 (1)과 같다.

| (1) |

x와 y는 파티클의 위치를, 와 는 해당 파티클이 가지고 있는 속도를 나타낸다. 이전시간 k-1에서의 상태변수 와 위치, 속도의 표준편차 σpos,σvec과 외란 을 곱한 값을 더하여 현재시간 k에서의 상태변수를 예측한다.

현재 상태를 예측한 후 가능도(Likelihood) 계산을 통해 사후확률(Posterior probability)을 계산한다. 파티클 위치의 RGB 값을 각각 r, g, b로 정의하며, 목표로 하는 RGB 값을 각각 Tr, Tg, Tb로 정의한다. 목표 RGB값과 파티클이 위치한 픽셀의 RGB값의 유클리드 노름을 구해 상대거리 d를 구한다.

| (2) |

식 (2)에서 구한 d를 사용하여 로그 가능도를 계산한다.

| (3) |

파티클의 재표본 추출(Resampling) 과정에서는 다항 재표본 추출(Multinomial resampling)기법을 사용하였다. Llog에서 Llog의 최댓값을 빼줌으로써 모두 음수값이 되게 하고, 해당 값을 자연상수 e의 지수로 삼아 L의 최댓값이 1이 되도록 한다.

| (4) |

정규화한 L의 누적합을 가중치 w로 사용하고, 가중치가 낮은 파티클을 가중치가 높은 파티클로 대체한다.

| (5) |

재표본 추출을 진행한 후 파티클 생성 과정을 제외한 일련의 과정을 반복하여 영상 내 파티클을 목표 색상과 유사한 지점으로 이동시킨다.

2.2 리아프노프 직접법 기반 제어 알고리즘

본 논문에서는 리아프노프 직접법을 기반으로 한 스텝 모터의 속도 제어 알고리즘을 구성하기 위해 비용함수를 식 (6)과 같이 설계하였다.

| (6) |

식 (6)을 미분하여 식 (7)을 얻을 수 있으며, 리아프노프 안정성을 만족하기 위해 를 식 (8)과 같이 설계하였다.

| (7) |

| (8) |

식 (7)과 식 (8)을 연립하여 식 (9)를 얻고 를 스텝모터의 회전 속도 K라고 정의한다. 식 (9)를 K에 관한 식으로 정리하면 식 (10)과 같다.

| (9) |

| (10) |

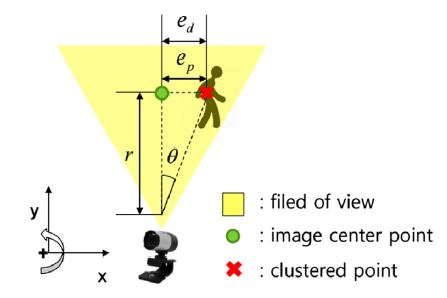

Fig. 2는 카메라와 대상 사이의 각도 θ 계산의 개념도이다. 파티클 필터를 이용하여 영상 내에서 추종 대상의 군집점을 잡고, 영상의 중심점과 군집점의 영상 내 횡방향 거리 오차 ep를 구한다. ep에 비례상수 m을 곱해줌으로써 실제 거리 오차 ed로 변환할 수 있고 ed가 0이라고 가정할 때, ed는 호의 길이 공식에 의해 rθ로 나타낼 수 있다. 위 식을 정리함으로써 제어하고자 하는 값 θ를 식(11)과 같이 도출할 수 있다.

| (11) |

식 (10)에 식 (11)을 대입하면 스텝 모터의 속도 K는 식 (12)와 같이 표현할 수 있다.

| (12) |

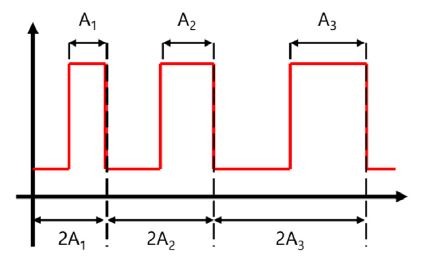

사각 펄스 한 주기가 2A의 시간으로 구성되어 있을 때 K는 식 (13)과 같이 표현할 수 있다.

| (13) |

ω는 스텝 모터의 스텝 당 각도를 나타내며, 본 논문에서 사용된 스텝 모터의 사양에 의하면 한 스텝당 0.72 deg를 회전하므로 식 (13)에 대입하면 식 (14)와 같이 정리할 수 있다.

| (14) |

본 논문에서 제안하는 알고리즘은 속도 제어를 위해 펄스의 반주기 A가 가변적으로 적용될 수 있도록 설계되었다. 오차가 줄어들수록 속도가 감소하여 A가 증가하는 상황을 Fig. 3으로 표현하였다.

3. 성능 평가

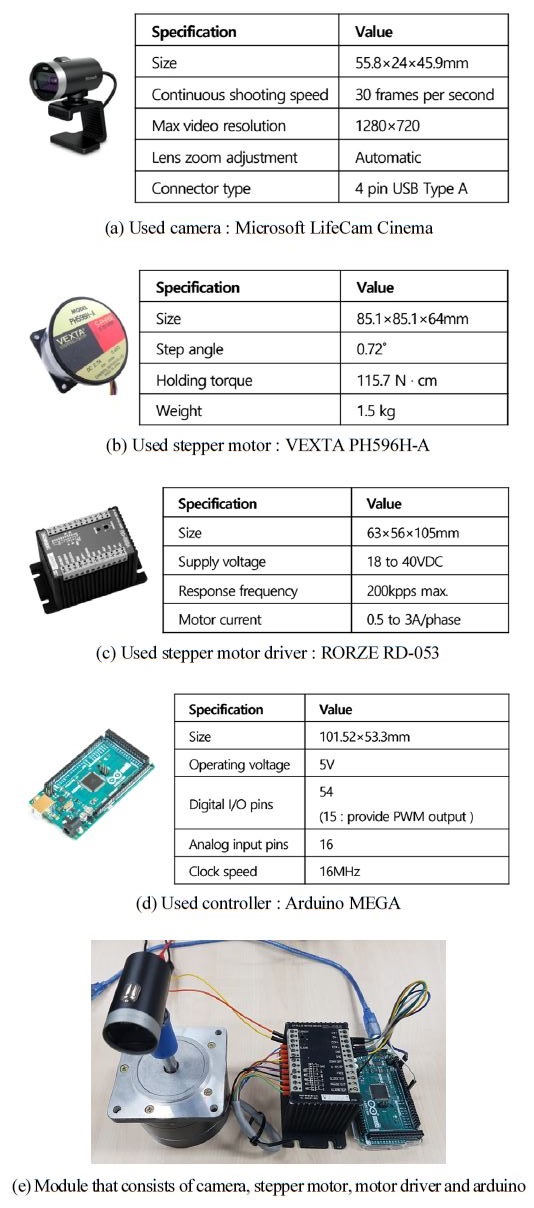

제안하는 알고리즘의 성능 평가를 위해 카메라와 스텝 모터를 결합한 모듈을 제작하였다. 영상 정보를 취득하기 위한 카메라는 마이크로소프트社의 라이프캠 시네마 카메라를 이용하였고 카메라의 회전을 위한 스텝 모터는 벡스타社의 PH596H-A 모델을 이용하였다. 스텝 모터와 아두이노 간의 연결을 위한 스텝 모터 드라이버는 로체社의 RD-053을 이용하였다. 제어기는 아두이노社의 아두이노 메가 2560을 사용하였다.

성능 평가를 위한 알고리즘은 Fig. 5와 같이 구성하였으며, 두 가지 Case를 지정하여 각각 140프레임 동안 진행하였다. σrgb,σvec은 각각 25, 5로, γ는 5로 설정하였다. m은 2.3~3.2 m의 범위에서 실험을 통해 얻은 4를 사용하였으며, r은 3.2를 적용하였다. 모터가 움직이지 않는 중립 지역(Dead zone)은 이미지 중심점의 x 픽셀값인 640픽셀에서 ±50픽셀의 범위로 설정하였다. 추종 대상의 색상은 [0, 0, 255]의 RGB 값을 가지는 파란색으로 정의하였다.

3.1 카메라의 시야각 안에서 한 방향으로 이동하는 경우 (case-1)

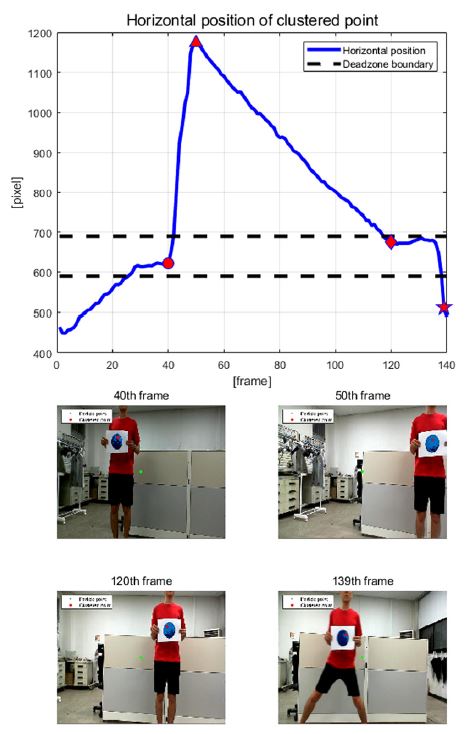

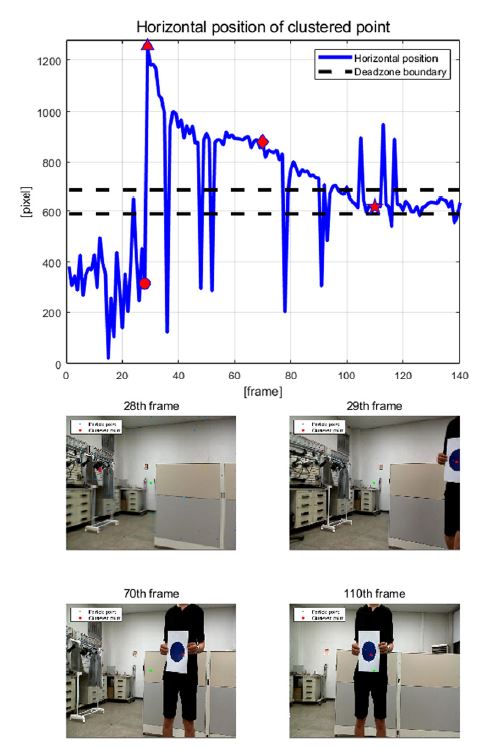

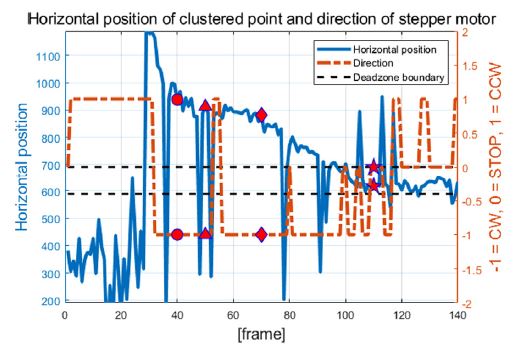

Case-1은 Fig. 7과 같이 추종 대상이 카메라의 시야각 안에서 한 방향으로 이동하는 경우이다. σpos는 25로 설정하였다. 40/50/120/139번째 프레임일 때의 데이터를 각각 ●/▲/◆/★의 기호로 표현하였으며, Fig. 6에서 해당 프레임에서 군집점의 횡방향 위치와 중립 지역, 그리고 해당 상황의 장면을 확인할 수 있다.

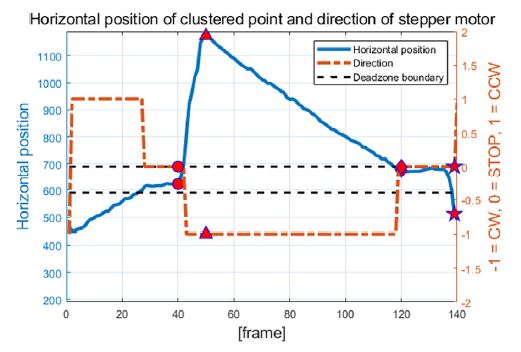

Fig. 7을 통해 대상이 있는 것으로 추정되는 군집점의 횡방향 위치가 590픽셀 미만에 있을 경우는 스텝 모터가 반시계방향(Counter - Clock Wise, CCW)으로 회전, 690픽셀 이상에 있을 경우는 시계방향(Clock Wise, CW)으로 회전하며 중립 지역에 위치할 경우는 정지함을 확인할 수 있다.

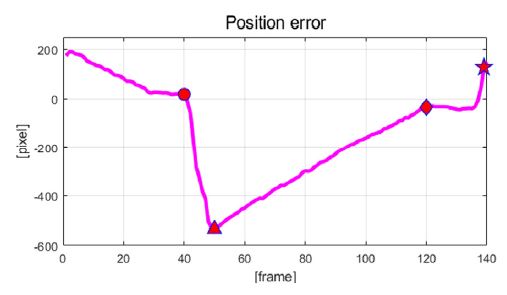

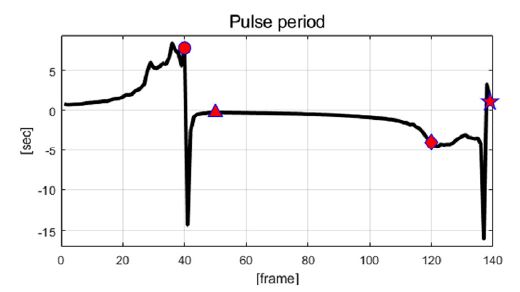

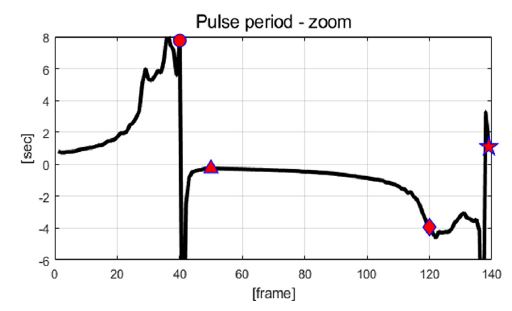

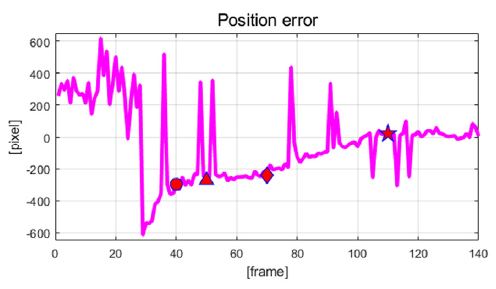

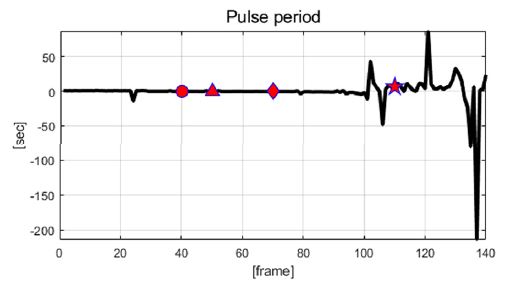

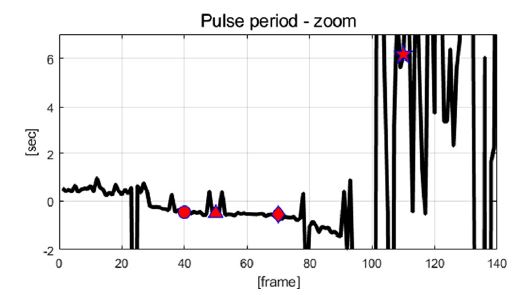

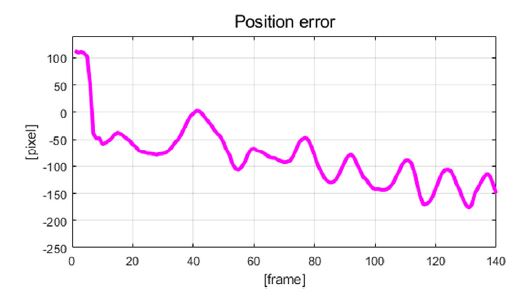

Fig. 8은 이미지 중심점과 군집점 사이의 오차를 보여주며 Fig. 9는 펄스의 주기를 보여준다. Fig. 10은 Fig. 9를 확대한 그래프이다. Fig. 8에서 오차가 음수인 경우는 군집점이 이미지 중심점의 우측에 위치함을 의미한다. 펄스의 주기가 급변하는 현상은 추종 대상이 이동함으로써 군집점 또한 이동하여 이미지 중심점을 지나칠 경우, ep가 급격하게 줄어들어 스텝 모터의 속도가 거의 0에 근접하기 때문에 발생하나 알고리즘의 성능에는 영향을 주지 않는다. 오차가 증가할 때 펄스의 주기는 감소하여 더 빠른 속도로 오차를 0으로 수렴시키는 성능을 확인할 수 있다.

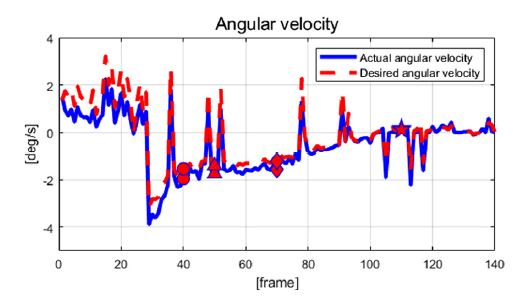

Fig. 11은 알고리즘으로 도출된 목표 각속도와 스텝 모터가 회전한 실제 각속도를 보여준다. 실제 각속도는 매트랩에서 제공하는 Tic-toc 명령어로 알고리즘의 실행 시간을 구하여 실행 시간으로 각도 θ를 나누는 방법을 이용하였다. 계산 시간은 컴퓨터의 성능과 소프트웨어 실행 상태에 따라 달라지므로 실제로 적용된 각속도가 목표로 하는 각속도와 완벽하게 일치하지는 않지만 근사한 값을 보임을 확인할 수 있다.

3.2 카메라의 시야각 밖에서 진입하는 경우 (case-2)

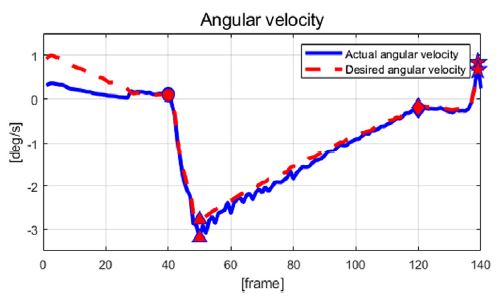

Case-2는 추종 대상이 카메라 시야각 밖에서 진입하는 경우이며, σpos는 1,000으로 설정하였다. Case-1과 마찬가지로 28/29/70/110번째 프레임일 때의 데이터를 각각 ●/▲/◆/★의 기호로 표현하였으며, Fig. 12에서 해당 프레임에서 군집점의 횡방향 위치와 중립 지역, 그리고 해당 상황의 사진을 각각 확인할 수 있다. 28 프레임에서 대상 물체가 위치한 곳이 아닌 지점에 존재하던 군집점이 29 프레임에서 목표 색상을 가진 대상 물체의 출현과 함께 해당 물체로 이동하는 것을 확인할 수 있다. 70 프레임에서 대상이 움직임에 따라 군집점과 실제 중심점의 위치 오차가 있지만 추종 및 제어와 함께 110 프레임에서 줄어든 것을 확인할 수 있었다.

Fig. 13에서 대상 물체의 위치와 회전 방향을 확인할 수 있다. Case-1과 달리 일부 프레임에서 군집점의 위치가 급변하는 부분이 존재하는데, 이는 σpos를 1,000으로 설정하여 파티클의 산포 범위를 늘렸기 때문이다. 산포 범위가 늘어나 위치가 급격히 변화한 파티클이 생성되면 군집점의 위치 또한 급변하기에 일부 프레임에서 이러한 현상을 확인할 수 있다. 하지만 Fig. 14에서 오차의 급격한 변화가 발생하더라도 오차를 줄여가는 경향성을 확인할 수 있다. Fig. 15, Fig. 16에서는 오차가 감소하면 주기가 늘어나고 속도가 감소함으로써 안정성을 유지하려는 것을 확인할 수 있다. Fig. 17에서 실제 각속도가 목표 각속도와 큰 차이가 없는 것을 확인할 수 있다.

3.3 시야각 안에서 대상 물체가 빠르게 한 방향으로 이동하는 경우

카메라의 시야각 안에서 대상 물체가 빠르게 한 방향으로 이동하는 경우, Fig. 18과 같이 오차가 0으로 수렴하려는 성향은 보이나 대상 물체가 오차가 수렴하는 속도보다 빠르게 움직이므로 오차가 점점 발산함을 확인할 수 있다. 이는 리아프노프 직접법의 한계로써 오차를 0으로 수렴시킬 수는 있지만, 연산 시간에 제한을 두지 않기에 발생하는 문제이다. 이러한 한계점을 보완하기 위해 향후 적응형 제어 이론 적용을 통한 제어 알고리즘의 고도화를 계획하고 있다.

4. 결 론

본 논문에서는 파티클 필터를 기반으로 한 단일 카메라의 능동형 움직임 제어 알고리즘을 제안하고 평가하였다. 파티클 필터를 이용하여 물체의 위치를 판단하였고, 카메라의 속도를 제어하기 위해 리아프노프 직접법 기반의 제어 알고리즘을 사용하였다. 성능 평가는 마이크로소프트 웹캠, 스텝 모터, 스텝 모터 드라이버와 아두이노로 구성된 모듈과 매트랩 환경에서 구성된 제어 알고리즘을 통해 이루어졌다. 성능 평가 결과 본 논문에서 제안한 알고리즘이 영상의 중심과 군집점 사이의 오차를 감소시키며 대상을 잘 추종하는 것을 확인할 수 있었다. 하지만 연산 시간에 제한이 없는 리아프노프 직접법의 한계와 더불어 스텝 모터의 속도가 빠르지 않아 중립 구역에 위치하기까지 시간이 많이 소요된다는 한계점이 존재한다. 또한 RGB 색상을 기반으로 추종 대상을 판단하기 때문에 대상 물체와 유사한 색상을 가진 타 객체가 주변에 존재할 경우 추종 대상을 혼동할 수 있다는 한계점이 존재한다. 본 논문에서 제시된 한계점들을 보완하기 위해 향후 인공지능을 기반으로 한 군집점 주변 이미지의 실시간 학습 혹은 단일 레이저 스캐너(Light Detection And Ranging, LiDAR)와의 융합을 통하여 색상에 영향을 받지 않고 강건하게 대상을 추종하고 구분하는 알고리즘으로 고도화할 계획에 있다. 또한 스텝 모터의 속도 제어 성능의 향상을 위해 현재 사용하고 있는 아두이노를 산업용 아두이노로 대체할 계획에 있다. 본 논문에서 제안하는 알고리즘은 추후 공장 등의 자동화 설비에서 작업자들의 안전을 위한 안전 모듈 및 자율주행 대차 시스템과 같은 대상 추종 시스템의 능동형 인지 모듈로 사용될 수 있을 것으로 예상하며, 향후 적용이 고려되는 장소 및 대상에 적합하게 고도화할 계획에 있다.

Nomenclature

| θe : | angle error in local coordinate, deg |

| ep : | pixel error, pixel |

| ed : | actual error, m |

| γ : | control gain, - |

| r : | distance between object and camera, cm |

| m : | transmutation constant, m/pixel |

| σrgb : | standard derivation of RGB value, - |

| σpos : | standard derivation of position value, - |

| σvec : | standard derivation of vector value, - |

Subscripts

| E : | error |

| P : | pixel |

| D : | distance |

| RGB : | rgb color |

| POS : | position |

| VEC : | vector |

Acknowledgments

A part of this paper was presented at the KSAE 2019 Spring Conference

References

- M. G. Kim, S. Y. Lee and J. H. Kim, “Efficient Parking Detection System Using Image Histogram of Non-Movable Monocular Camera,” KSAE Spring Conference Proceedings, pp.683-686, 2018.

-

M. Diaz-Cabrera, P. Cerri and P. Medici, “Robust Real-time Traffic Light Detection and Distance Estimation Using a Single Camera,” Expert Systems with Applications, Vol.42, No.8, pp.3911-3923, 2015.

[https://doi.org/10.1016/j.eswa.2014.12.037]

-

J. H. Park, J. W. Han, J. W. Kim, N. S. Son and S. Y. Kim, “Automatic Detection of Nearby Ships using Monocular Vision for Autonomous Navigation of USVs,” Journal of Institute of Control, Robotics and Systems, Vol.23, No.6, pp.416-423, 2017.

[https://doi.org/10.5302/J.ICROS.2017.17.0042]

-

C. Hane, T. Sattler and M. Pollefeys, “Obstacle Detection for Self-Driving Cars Using Only Monocular Cameras and wheel Odometry,” IEEE/RSJ International Workshop on Intelligent Robots and Systems, pp.5101-5108, 2015.

[https://doi.org/10.1109/IROS.2015.7354095]

-

J. S. Lee, K. T. Choi, T. H. Park and S. C. Kee, “A Study on the Vehicle Detection and Tracking Using Forward Wide Angle Camera,” Transactions of KSAE, Vol.26, No.3, pp.368-377, 2018.

[https://doi.org/10.7467/KSAE.2018.26.3.368]

-

K. T. Choi, J. K Suhr and H. G. Jung, “Landmark Suitability Evaluation of Road Facilities in Highway for Monocular Camera-based Precise Vehicle Localization System,” Transactions of KSAE, Vol.27, No.4, pp.273-290, 2019.

[https://doi.org/10.7467/KSAE.2019.27.4.273]

- H. S. Min, T. J. Song, H. W. Lee and K. S. Oh, “Development of a Camera based Object Tracking Control Algorithm Using Particle Filter,” KSAE Spring Conference Proceedings, pp.628-629, 2019.

-

S. Scheidegger, J. Benjaminsson, E. Rosenberg, A. Krishnan and K. Granstrom, “Mono-Camera 3D Multi-Object Tracking Using Deep Learning Detectrions and PMBM Filtering,” IEEE Intelligent Vehicles Symposium, pp.433-440, 2018.

[https://doi.org/10.1109/IVS.2018.8500454]

-

Y. Chen, X. Yang, B. Zhong, S. Pan, D. Chen and H. Zhang, “CNNTracker : Online Discriminative Object Tracking via Deep Convolutional Neural Network,” Applied Soft Computing, Vol.38, pp.1088-1098, 2016.

[https://doi.org/10.1016/j.asoc.2015.06.048]

-

Z. Zhou, D. Wu and Z. Zhu, “Object Tracking based on Kalman Particle Filter with LSSVR,” Optik, Vol.127, No.2, pp.613-619, 2016.

[https://doi.org/10.1016/j.ijleo.2015.10.038]

- K. M. Yi and J. Y. Choi, “Robust Object Tracking using PTZ Camera,” Proceedings of IEIE Conference, pp.154-157, 2010.

- J. Y, Lee, M. J. Kim, D. B. Kim, J. H. Park and J. W. Park, “Motion-Tracking Automatic Movable CCTV System,” Proceedings of KIIT Conference, pp.347-348, 2019.

- J. H. Ra, J. S. Yoon, Y. J. Ahn, S. W. Yang and M. J. Chung, “CCTV System Having the Automatic Tracking Function,” Proceedings of the KSME Fall Annual Meeting, pp.3553-3555, 2015.

-

T. J. Song, H. W. Lee and K. S. Oh, “Laser-scanner-based Object State Estimation and Tracking Control Algorithms of Autonomous Truck Using Single-wheel Driving Module,” Microsystem Technology, 2019.

[https://doi.org/10.1007/s00542-019-04539-4]