환경 센서 기반 고정 객체 이동 객체 구분 알고리즘 개발

Copyright Ⓒ 2019 KSAE / 166-04

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Research on the level 4 autonomous vehicle has been actively studied in various organizations. An accurate recognition of nearby objects is essential for autonomous navigation because it requires prediction of path or movement of nearby vehicles and objects. In the conventional method, there is a considerable amount of error because only the relative speed information between the vehicle and the object is used, and the error is larger in motion situations, such as the autonomous driving situation including the turning state of the vehicle. In this study, we propose a new method to classify the moving information of the object, whether it is a fixed object or a moving object.

Keywords:

Autonomous vehicle, ADAS, LIDAR, Clustering, Classification, Stationary target, Moving target키워드:

자율 주행 자동차, 첨단 운전자 보조 시스템, 라이다, 군집화, 분류, 고정 물체, 이동 물체1. 서 론

자율 주행 자동차란 운전자 또는 승객의 조작 없이 스스로 운행이 가능한 자동차를 말하며, 현재 Tesla, 현대차, Audi, Google, NVIDIA 등 여러 기업, 연구소 및 학계에서 개발 중으로 급부상하고 있다. 자율 주행 자동차는 첨단 운전자 보조 시스템인 ADAS(Advanced Driver Assistant System) 기술을 기반으로 개발되고 있다. ADAS란 차량운행 시 탑재된 각종 센서들을 통해 주변의 위험상황을 감지하여 운전자에게 경고하거나 운전자가 위험상황에 대처할 수 있도록 도와주는 첨단 운전자 지원 시스템이다.1-3) 자율 주행 자동차는 주변 상황과 정보를 빠르고 정확하게 파악하는 인식단계, 인식단계의 정보를 바탕으로 주행 환경과 목표지점에 적합한 주행 전략을 결정하는 판단 단계, 인식과 판단을 통해 직접적으로 주행을 하는 제어 단계로 구성된다. 특히 자율 주행 자동차의 눈 역할을 하는 인식단계에서는 RADAR, LIDAR, 카메라 와 같은 센서들을 사용하여 주변 상황의 정보를 검출한다. 자율주행 차량 및 DAS 기능에서 보행자와 차량과 같은 객체 정보들을 정확히 판별하는 것은 매우 중요하다.4-6)

그 중 LIDAR(Light detection and ranging)는 빛의 반사를 이용하여 객체까지의 거리를 측정하는 장비이며 최근 많이 적용되고 있다. 그러나 LIDAR 센서는 차량과 보행자등의 필요한 객체정보들을 검출함과 동시에 불필요한 정보들도 획득하게 되므로 그대로 사용할 수 없다. 이는 빛을 반사하는 모든 물체에 대한 정보를 돌려주기 때문이다. 지표면에 대한 정보 등이나 주변에 정형화되지 않은 나무 같은 물체에 대한 정보도 획득된다. 이에 LIDAR Point Cloud 정보들을 군집화하고 추적하는 과정은 필수 요소 기술이 된다.7,8)

본 논문에서는 LIDAR 정보 처리를 통해 객체를 검출하고 궁극적으로는 객체의 속성을 파악하는 새로운 방법을 제시하고 실차 시험을 통해 검증하는데 있다. 위험 판단을 위한 기본적인 군집화, Tracking 알고리즘 및 노이즈 제거에 대해 소개한다. 본 연구의 핵심인 관심 있는 객체 중에서 고정 객체 및 이동 객체를 구분하는 방법을 중점적으로 논한다. 고정 객체 및 이동 객체의 구분은 위험 판단 알고리즘에 적용하여 정확도를 향상시키는데 적용될 수 있으며 또한 운전 가능 영역(Drivable Space) 선정을 통한 최소한의 안전성 확보에도 적용될 수 있다. 객체들에 추적에 있어서도 고정물체를 제외하고 추적하기 때문에 객체의 수도 줄어 연산량을 줄 일수도 있다.

기존 연구에 대한 소개는 거의 존재하지 않고 있으며 일부 양산 차량에 적용된 SCC(Smart Cruise Control) 알고리즘을 위해 고정 물체 및 이동 물체를 구분하고자 하는 알고리즘의 소개가 기술 문서상에 소개되어 있다.9) 이 기술 문서에서는 고정 및 이동 객체를 구별하기 위해 자기 차량과 상대 객체간의 상대속도 차이를 이용하여 객체를 구분하였기에 상당한 오차가 존재하였다. RADAR의 경우 2.5 kph 이하의 속도로 움직이는 객체는 고정 물체로 간주하였다. 또 하나의 문제는 기존의 상대속도 기반 방식들은 차량의 종 방향 주행 관점에서의 구분법으로 선회 등 차량의 동적 환경에서는 오차가 더 크게 작용하거나 적용하기 어려운 상황이다.

본 논문에서는 자기 차량과 상대 차량 간 연산이 아닌 여러 개의 객체 정보를 사용한 연산을 적용함으로써, 자율주행 시스템에서 요구하는 정확한 객체 구분을 위해 기존 방식의 한계를 극복하고자 하였다. 이를 통해 선회 등의 다양한 주행 환경에서 고정 객체 이동 객체를 구분하여 자율주행 차량에서 제어 대상 객체 검출 알고리즘, 충돌 위험 판단 대상 객체 검출 및 주행 가능 영역 알고리즘 등에 적용 가능한 새로운 알고리즘을 제안 한다.

본 논문의 구성은 다음과 같다. 2장에서는 객체 군집화에 대해 소개하고 3장에서는 특징점 추출 방법, 4장에서는 LIDAR 데이터 노이즈 제거 방법, 5장에서는 Object tracking에 대해 소개하며, 6장에서는 고정 객체 및 이동 객체 판단에 대한 알고리즘 및 시험 결과에 대해 논한다. 7장에서는 결론으로 마무리한다.

2. 객체 군집화

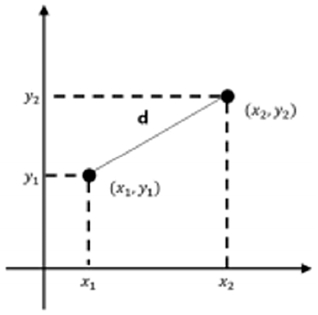

LIDAR 센서는 객체에 반사되는 빛의 정보를 받아 위치 정보를 보내주고 좌표로 표기할 수 있으며, 각각의 객체는 점의 집합으로 나타난다. 객체 분류를 할 때, 객체가 서로 떨어져 있는 특성을 이용하여, 점과 점사이의 거리가 일정 임계치가 넘어가면 서로 다른 객체로 보도록 설계하였다. 일정 임계치는 객체의 거리가 멀어질수록 크게 설정하여 센서의 특성을 반영하였다. 점과 점사이의 저리공식은 식 (1)로 정의한다.

| (1) |

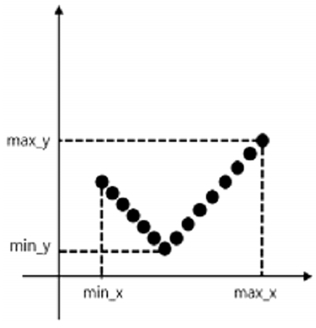

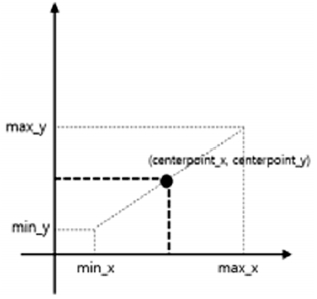

LIDAR 데이터의 점과 점사이의 거리를 의미하며, (x1,y1), (x2,y2)는 비교할 각각의 점들을 의미한다. 점과 점 사의의 거리가 일정 임계치 안의 데이터들을 하나의 군집화된 객체로 분류하고 이들에게 각각의 고유한 ID가 부여하게 된다. 군집화된 객체 내 점들 중 가장 작은 값을 갖는 min(x,y)와 가장 큰 값을 갖는 max(x,y)를 구해 객체의 중심점인 centerpoint_x, centerpoint_y를 만든다. Fig. 2와 Fig. 3은 중심점 centerpoint_x와 centerpoint_y를 구하는 과정을 그림으로 설명한 것이며, 각각 식 (2), 식 (3)으로 정의한다.

| (2) |

| (3) |

3. 특징점 추출

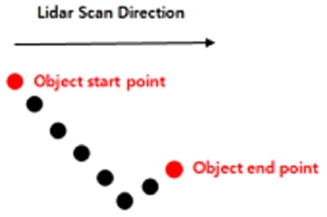

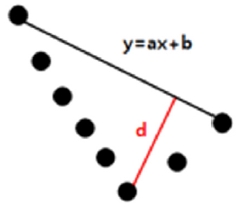

특징점은 정형화된 객체 내에 모서리와 같이 그 객체의 특징을 나타내 줄 수 있는 부분들을 추출하여 다른 인식이나 판단에서 적용하는 점 데이터들이다. 특징점 연산은 Fig. 4처럼 LIDAR의 고정된 스캔 방향을 이용해 시작점과 끝점을 구하고 직선의 방정식을 세운다.10)

Fig. 5와 같이 직선 방정식을 구한 뒤 객체내의 각각의 점들에 대해 수선의 발을 내리고, 가장 긴 d를 가진 점을 찾는다.

위 과정을 통해 구해진 모서리 등이 객체의 특징점이 되고 이는 향후 고정 객체와 이동 객체를 분류하는 알고리즘에서 각 객체의 거리 정보 연산에 적용할 수 있다.

4. LIDAR 데이터 노이즈 제거

객체의 군집화를 수행하더라도 불필요한 객체의 데이터들도 포함하고 있다. 이전에서도 기술하였지만, Object Classification은 LIDAR 좌표에서 객체들이 갖는 특징인 점의 밀도와 규칙성의 차이를 이용해 객체의 종류를 분류하는 알고리즘을 적용하였다. 점의 밀도와 규칙성은 LIDAR 좌표에 군집화 된 객체 내의 점과 점사이의 거리의 평균값 및 분산을 통해 알 수 있다. LIDAR로부터 인식하고 싶은 객체로는 정형화되었다고 판단할 수 있는 보행자, 차량, 건물의 경우는 점과 점 사이의 거리가 조밀하고 규칙적이다. 그러나 정형화되지 않은 가로수 나무와 같은 객체는 객체 검출 대상이 아니면서도 차량이나 보행자 검출에 방해를 주고 있다. 나뭇잎이나 나무 가지로 인해 LIDAR 데이터 점과 점 사이의 거리가 일정하지 않는 불규칙적인 특징이 있다. 따라서 본 논문에서는 LIDAR 데이터의 점과 점 사이 거리의 정보를 통해 인식 불필요한 비정형화된 객체를 걸러내는 과정을 제안한다. Fig. 6처럼 LIDAR가 동일한 각도로 객체를 인식했을 때, 군집화된 각 객체의 다른 특성을 이용하여 비정형화된 객체를 분류할 수 있고 이를 제거함으로서 객체 검출이나 위험 판단 알고리즘 개발에서 오류를 줄일 수 있다.

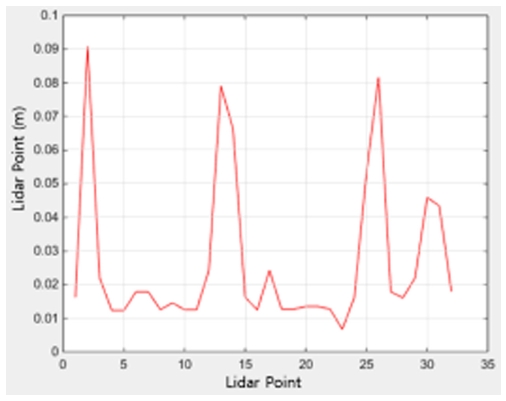

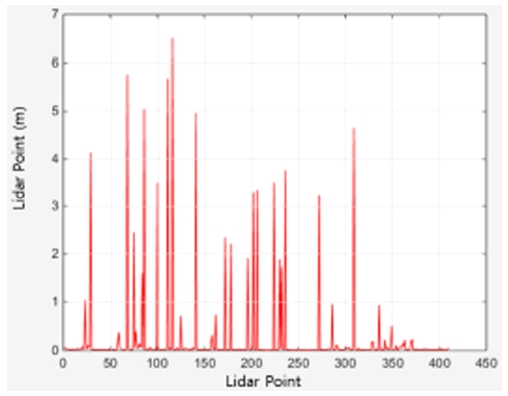

Fig. 7, Fig. 8 각각 LIDAR Point Cloud 데이터를 기반으로 사람과 나무 상단 부분의 점과 점 사이의 거리를 나타낸 그래프다. 나무 객체의 점과 점 사이의 거리가 전체적으로 사람 객체에 비해 높은 수치를 가진다.

Fig. 7은 사람 객체내의 점과 점사이의 거리 값들을 그래프로 나타낸 것이며, 최대 거리 값이 0.09 m로 비교적 낮은 수치를 띄고 있다. 반면 Fig. 8은 나무 객체 내의 점과 점사이의 거리 값들을 그래프로 나타낸 것이며, 최대 거리 값이 6.5m로 비교적 높은 수치를 띄고 있다. 점간의 거리 값이 크면 점의 분포가 불규칙적일 확률이 높다. Table 1은 두 객체 간 평균과 표준편차를 표로 비교 분석한 결과이다. 나무 객체의 평균과 표준편차가 사람 객체에 비해 높은 수치를 가지고 있음을 알 수 있다.

매 LIDAR 데이터 입력 후 군집화를 통해 객체들이 생성된 후에 각 객체 등에 대해 객체들이 갖는 특징인 점의 밀도와 규칙성의 차이를 이용해 비정형화된 객체를 제거함으로써 차량 관점에서 위험 객체인 차량과 보행자를 검출에 용이하게 적용할 수 있다.

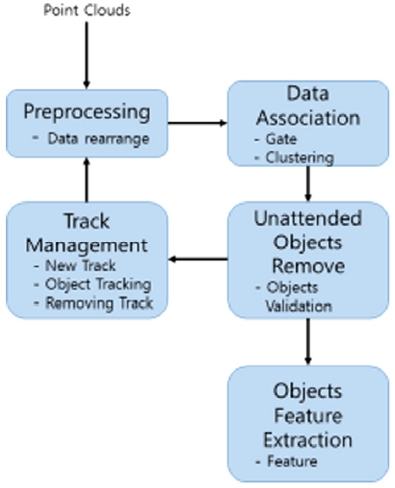

5. Object Tracking

객체 추적은 유지, 소멸, 생성 단계를 거치면서 객체 정보를 유지시키고, 새로운 정보를 갱신시키는 과정이다. 소멸이나 생성 단계의 군집화된 객체들은 소멸 카운터나 생성 카운터를 적용하여 객체 검출 오류를 최소화하였다.

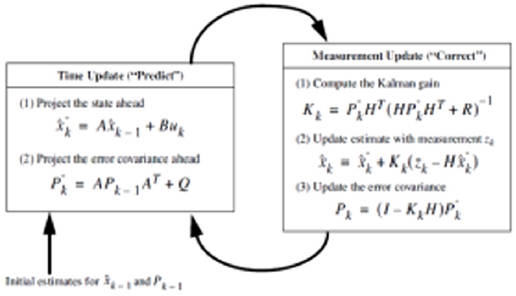

Object tracking 과정은 비 정화된 객체를 제외하고 객체의 좌표 정보 및 Kalman Filter를 이용하여 객체를 추적하고 경로를 예측한다.

칼만 필터 모델은 Constant Velocity 모델을 적용하였으며 여기에 적용되는 행렬들은 LIDAR 특성을 고려하여 아래와 같은 값들을 적용하였다.

여기서, x는 상태 백터, z는 관측 백터, Φ는 시스템 모델 행렬, Q는 공정 잡음 공분산 행렬, H는 관측 행렬, R은 측정 노이즈 공분산 행렬, σ는 각각 표준 편차를 나타낸다.

| (4) |

6. 고정 객체 및 이동 객체 판단

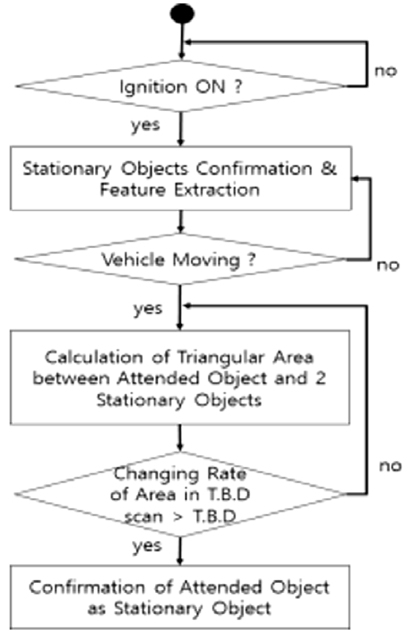

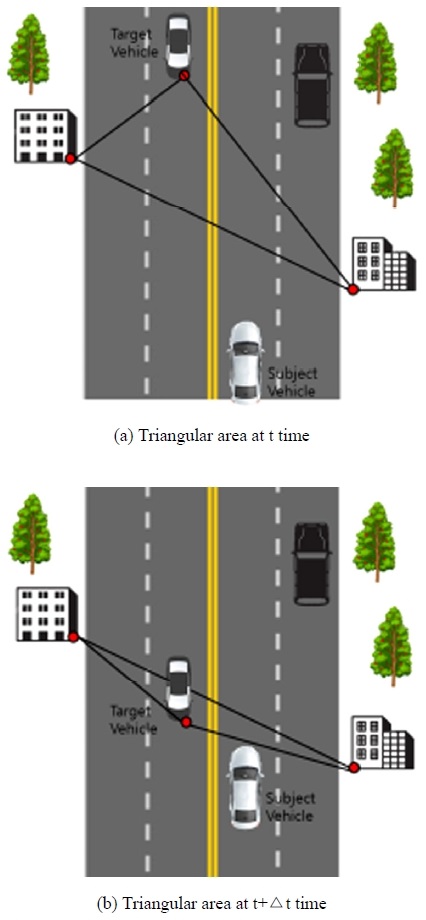

고정 물체 및 이동 물체의 구분 알고리즘의 개념은 고정 물체 사이의 간격은 항상 일정하다는 점을 이용하는 것이다. 그리고 만약 이동 물체가 있다면 이 이동물체와 고정 물체 사이의 간격은 시간에 따라 변하기 마련이라는 것이다. 따라서 관심 있는 객체의 이동 여부를 알고자할 때는 확실히 고정 객체인 2개를 선정하고 이들 사이의 거리 변화를 계측하면 될 것이다. 본 논문에서는 새로운 방법으로 확실한 고정 물체 2개와 관심 있는 객체를 이용하여 삼각형을 구성하고 면적의 변화를 관찰하여 면적 변화가 감지되면 이동 물체고 검출하는 것이다. 아래 그림 Fig. 11은 알고리즘의 순서도를 나타낸 것이다.

확실한 2개 이상의 고정 객체 선정이 우선 중요하다. 차량은 처음 시동 후 정차 상태를 일정 시간 유지한다는 점을 이용한다. 이 때 동일한 알고리즘 적용되고 또한 자기 차량이 정지되어 있기 때문에 고정 객체와의 상대거리가 불변하게 되는 점을 이용하여 상대거리 값의 변화를 추가적으로 관찰하여 고정 객체를 확실하게 감지하는 단계를 수행 수행한다. 또 차량이 운행 중 정차 중일 때에도 동일한 알고리즘을 수행하여 고정 객체에 대한 객체 분류(Object classification)를 오차를 최소화하면서 알고리즘을 수행하는 것이다.

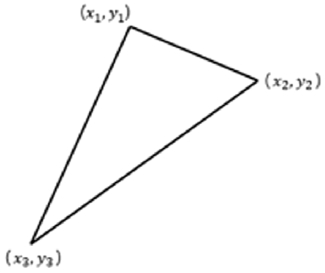

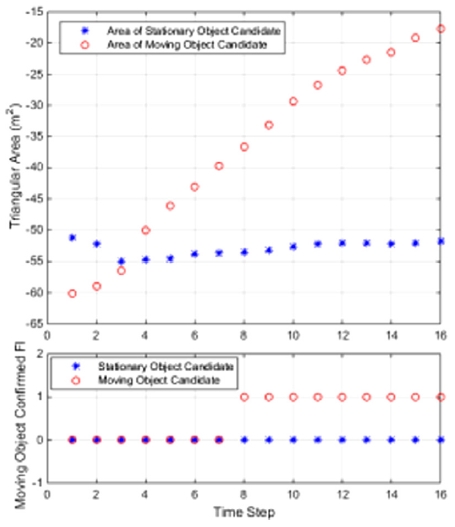

Object Classification과 Object tracking 과정을 거친 확정된 고정 객체 2개는 임의의 객체 하나와 삼각형을 만들며 그 면적을 구한다. 일정 시간동안 삼각형의 면적의 변화가 임계값 이상이면 이동 객체, 삼각형의 면적이 임계값 미만이면 고정 객체로 판단한다. Fig. 12는 임의의 세 점으로 그린 삼각형이며, 임의의 세 점을 이용한 삼각형 면적의 공식은 식 (4)와 같다.

| (5) |

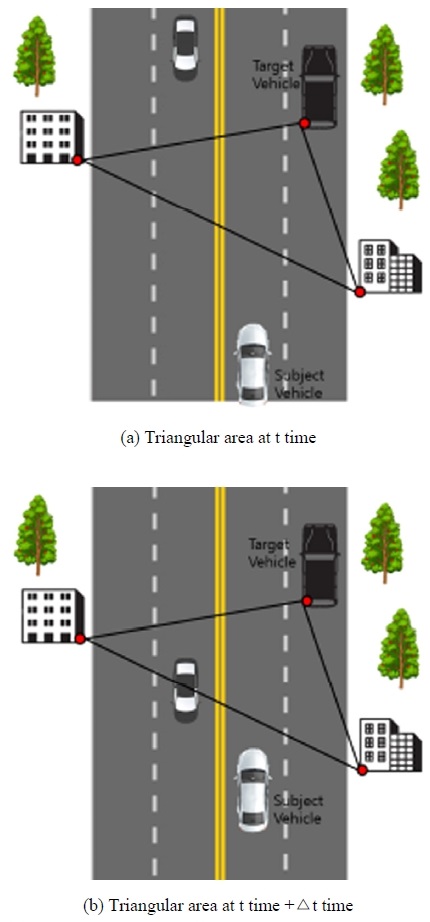

Fig. 13의 (a),(b)는 고정 객체들의 시간에 변화에 따른 삼각형 면적의 변화를 보여주는 개념 그림이다. 확실한 고정 객체 2개와 이동 여부 판단을 원하는 객체로 삼각형을 구성하였고 면적 변화가 없으므로 고정 객체로 판단할 수 있다.

Fig. 14의 (a),(b)는 고정 객체 2개와 이동 객체간의 삼각형 면적의 변화를 보여주는 개념 그림으로 일정 시간 경과 후 면적 변화가 존재하므로 이동 객체로 판단할 수 있다.

Fig. 15는 본 연구의 알고리즘을 증명할 시스템 구성을 나타낸 것이다. 승용차량으로 선정하였으며 지붕에 16채널 LIDAR 센서 2개를 장착하였다.

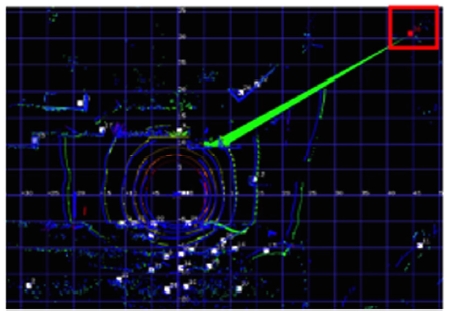

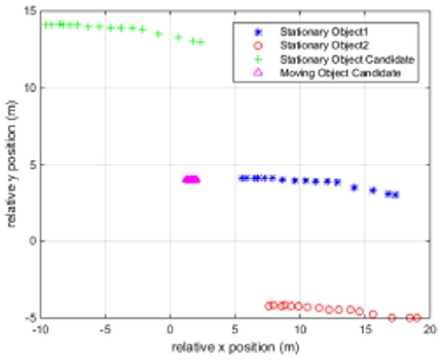

Fig. 16은 차량에 탑재된 LIDAR로 고정 객체를 검출한 결과를 보여주고 있다. LIDAR 정보를 Bird Eye view로 보여주고 있으며 좌표축으로 (0,0)이 차량의 위치를 나타내고 있다. 고정 객체 3개를 이용한 삼각형이 녹색으로 표시되도록 구성하였다.

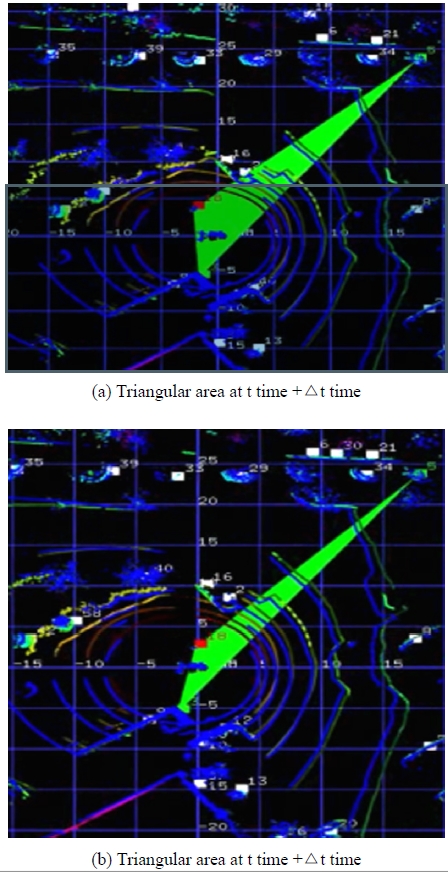

다음 그림 Fig. 17은 확실한 2개의 고정 객체와 이동 중인 객체를 이용한 삼각형 면적에 대한 변화를 보여주는 시험 결과이다. 빨간색으로 표시된 객체가 이동 중인 보행자이다. 그림 (a)에서 일정 시간 경과 후에는 그림 (b)로 이동하게 되어 고정 객체 2개와의 삼각형 면적의 변화를 눈으로도 쉽게 확인할 수 있다.

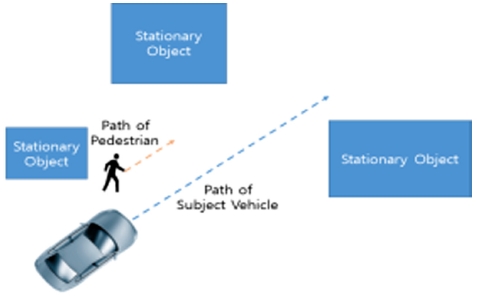

Fig. 18은 실차 시험 기반 시험 시나리오를 나타낸 것이다.

시험 환경은 확실한 고정 객체 2개를 확보한 상태에서 두 개의 객체에 대한 이동 속성 정보를 분류하는 것이다.

Fig. 19, Fig. 20은 시험 결과를 보여주는 그래프이다. Fig. 19는 시나리오에 따른 객체 특징점을 추출하여 상대 위치로 나타낸 것이다. 고정 객체는 차량의 이동에 따라서 이동 궤적이 동일한 형태로 생성되고 있다. 또한 보행자의 이동 객체는 차량과의 상대 속도에 해당하는 만큼 궤적으로 나타나고 있다. Fig. 20은 속성 정보 파악을 위한 객체의 삼각형 면적을 나타낸 것으로 고정 객체와 이동 객체에서의 면적 변화를 파악할 수 있으면 일정시간동안 면적 변화가 한계치를 넘게 되면 확실한 이동 객체로 선정됨을 보여주고 있다.

7. 결 론

- 1) LIDAR 센서의 Point cloud 데이터를 객체로 분류하고 객체의 이동 속성 정보 획득에 이용하기 위해 각 객체의 특징점을 추출하는 기법 알고리즘을 개발 구현하였다.

- 2) 불필요한 객체에 대한 제거를 위해 차량이나 보행자 등 정형화되지 않은 객체들에 대한 판별법을 소개하고 구현하여 객체의 추적과정 즉 생성, 유지, 소멸의 단계를 위한 객체를 선별하여 연산 속도 향상에 기여할 수 있었다.

- 3) 객체의 이동 속성은 매우 중요한 것으로 고정 객체 2개를 이용한 삼각형 면적 기법의 알고리즘을 적용하고 실차 시험을 통해 구현 검증하였다. 또한 차량의 선회 등 동적 움직임이 있다고 하더라도 정확도를 유지할 수 있다는 장점이 있다.

- 4) 알고리즘 평가에 있어서 대상 객체가 자율주행 차량 앞쪽에 존재하는 경우에는 거의 100 %의 성능으로 구분을 완료하였으나 대상 객체 차량이 자율주행 차량 뒤쪽으로 이동하는 상황 하에서는 특징점의 변동으로 인해 오류가 다수 발생하였다. 이에 대한 개선 알고리즘 개발이 필요하다고 판단된다. 또한 고정 물체 및 이동 물체를 구분하기 위해서는 일정 시간 동안 면적 변화를 관측해야 하는 한계점이 존재한다.

본 연구를 통해 자율주행 차량에서 필요로 하는 객체의 이동 속성 정보를 파악하기 위한 새로운 방법을 제시하고 성능을 실차를 통해 검증하였다.

본 연구의 한계점으로는 검출된 고정 객체 수가 2개보다 작은 경우 본 알고리즘을 적용할 수 없다. 따라서 연석 등과 같은 다른 객체들에 대한 정보 및 타 센서 정보를 융합하는 방법들에 대한 연구가 필요하다고 판단된다. 또한 실제 적용에 있어서 임계치는 성능에 아주 중요한 요소이다. 본 연구에서는 고정 임계치를 적용하였으나 다양한 환경에서의 강건성 확보를 위해서는 추가적인 연구가 필요하다고 판단된다.

향후 실도로 환경에서의 주변 차량 및 객체 등으로 인한 부정확성 등을 개선하여 알고리즘의 강건성 확보를 위한 연구를 계속해 나갈 것이다.

Nomenclature

| min : | minimum distance, m |

| centerpoint : | center distance of object, m |

| S : | triangular area, m2 |

| P : | position, m |

| V : | velocity, m/s |

Subscripts

| x,y : | relative point of object, m,m |

Acknowledgments

본 연구는 국토교통부 도심도로 자율협력주행 안전・인프라 연구 사업의 연구비지원(과제번호 19PQOW-B152473-01)에 의해 수행되었습니다. 이 논문은 2018년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업임(No. 2018R1D1A1B07048143). 이 논문은 2018년도 정부(산업통상자원부)의 재원으로 한국산업기술평가관리원의 지원을 받아 수행된 연구임 (No.K_G012000307001, NCAP 대응을 위한 후방 자동제동시스템 Rear Automatic Braking System 개발). 또한 2018년 한국교통대학교 지원을 받아 수행하였음.

References

-

H. Yun, S. Kim, J. Lee, and J. Yang, “Analysis of Cause of Disengagement Based on U.S. California DMV Autonomous Driving Disengagement Report”, Transactions of KSAE, 26(4), p464-475, (2018).

[https://doi.org/10.7467/ksae.2018.26.4.464]

-

M. Park, and J. Son, “Reference Test Scenarios for Assessing the Safety of Take-over in a Conditionally Autonomous Vehicle”, Transactions of KSAE, 27(4), p309-317, (2019).

[https://doi.org/10.7467/ksae.2019.27.4.309]

-

J. Lee, H. Yun, J. Kim, S. Baek, H. Han, S. Maryam FakhrHosseini, E. Vasey, O. Lee, M. Jeon, and J. Yang, “Design of Single-modal Take-over Request in SAE Level 2 & 3 Automated Vehicle”, Transactions of KSAE, 27(3), p171-183, (2019).

[https://doi.org/10.7467/ksae.2019.27.3.171]

-

M. Lee, H. J. Han, C. Jang, and M. Sunwoo, “Information Fusion of Cameras and Laser Radars for Perception Systems of Autonomous Vehicles”, Journal of Korean Institute of Intelligent Systems, 23(1), p35-45, (2013).

[https://doi.org/10.5391/jkiis.2013.23.1.35]

-

C. Park, and S. Kee, “Implementation of Autonomous Driving System in the Intersection Area Equipped with Traffic Lights”, Transactions of KSAE, 27(5), p379-387, (2019).

[https://doi.org/10.7467/ksae.2019.27.5.379]

-

E. Hyun, Y. Jin, B. Kim, and J. Lee, “Development of Human Detection Algorithm for Automotive Radar”, Transactions of KSAE, 25(1), p92-102, (2017).

[https://doi.org/10.7467/ksae.2017.25.1.092]

- W. Jeong, and M. Park, “Object Classification and Object Feature Point Extraction Using LIDAR”, KSAE Spring Conference Proceedings, p877-881, (2018).

- W. Jeong, S. Moon, J. Lee, and M. Park, “Object Tracking and Drivable Space Detection Using Lidar”, KSAE Daegu・Kyeongbuk Branch Conference Proceedings, p37, (2018).

- Delphi, Technical Document Product Definition Document for Electronically Scanned Radar, (2009).

- W. Jeong, M. Park, and S. Kim, “Method of Discrimination of Stationary Target and Moving Target for Improving Perception Algorithm”, KSAE Fall Conference Proceedings, p796-801, (2018).