신호등이 설치된 교차로 구역에서의 자율주행 시스템 구현

Copyright Ⓒ 2019 KSAE / 162-06

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

In this paper, we studied an autonomous vehicle driving system at an intersection equipped with traffic lights. We proposed deep learning based traffic light recognition algorithm, crossing/stop decision algorithm, path generation, and path following method. In addition, we implemented the proposed systems into a real vehicle environment. The main contribution of this paper is a crossing/stop decision algorithm to determine whether a test vehicle will pass through an intersection or stop in accordance with the recognized traffic light condition. This algorithm was designed based on vehicle speed and the distance between the position of the stop line and the vehicle. Ioniq PHEV, a vehicle equipped with sensors for autonomous driving, was used in order to evaluate the performance of the proposed system. The test vehicle drove through the intersection at the proving ground located in Ochang Campus, Chungbuk National University. The experimental results showed that the test vehicle successfully passed through the intersection in accordance with the traffic light status with a maximum speed of 30 kph on a straight course and a maximum speed of 10 kph on a 90° corner course.

Keywords:

Autonomous driving, Traffic light recognition, A intersection driving, Coordinates map, CNN(Convolutional Neural Network)키워드:

자율주행, 신호등인식, 교차로 주행, 좌표지도, 콘볼루션 신경망1. 서 론

최근 4차 산업혁명이 진행됨에 따라 자율주행시스템에 대한 연구가 활발히 진행되고 있다. 자율주행시스템은 드론, 공장로봇 등 다양한 산업분야에 적용이 가능하지만, 차량자율주행시스템은 사람들의 편의, 안전, 경제성 등 사회적으로 다양한 이점을 가져올 수 있다. 도로교통공단 TAAS(교통사고분석시스템)1)의 경찰 DB 관련 교통사고 현황에 따르면 17년도 1년간 교차로구역에서의 교통사고 횟수는 102,354건이다. 해당 건수는 전체 교통사고 횟수 216,335건의 47.3 %를 차지하는 큰 비중이다. 따라서 차량운행의 안전성이 보장되는 교차로 차량자율주행시스템이 구현된다면 교통사고의 비중을 크게 낮출 수 있을 것이다.

차량자율주행시스템은 실제 차량 운전자의 운전 방식을 모방하여 구성된다. 운전자의 인지 역할을 하여 차량 주변의 사물을 구별하는 능력은 지능형 센서가 담당하며 대표적으로 레이더와 라이다, 카메라, 초음파 센서가 있다. 운전자의 주행 조작은 조향, 제동, 현가장치를 전자 제어 하는 방식으로 대체되며 운전자의 판단을 담당하는 두뇌는 고성능 컴퓨팅 시스템으로 대체된다.

자율주행 조작과 판단을 담당하는 하드웨어 시스템은 이미 보통 운전자의 능력을 대체할 만한 성능을 보유하였다. 하지만 자율주행 인지 센서는 감지 방식의 물리적인 한계와 열악한 주행 환경에서 오감지 문제 등으로 인해 운전자의 인지 능력에 미치지 못하고 있다. 레이더 센서는 정교한 종방향 거리 측정이 가능하나 횡방향 거리 측정과 물체를 구분하는 능력이 부족하다.2) 라이다 센서는 주간, 야간 상황 모두 사용이 가능하다는 장점이 있지만 낮은 해상도와 양산 신뢰성 검증이 부족하다는 문제가 있다.3) 카메라는 주행 상황에 대해 많은 정보 취득이 가능하지만 조명변화, 날씨 변화 등에 의해 화질 저하가 심각하게 발생한다.4)

본 연구에서 제안하는 신호등 인식 기반의 교차로 자율주행시스템은 차량의 전방에 설치된 단안 카메라를 이용하였다. 따라서, 카메라의 화질 저하 환경에서도 동작할 수 있는 신호등 인식 알고리즘 개발이 요구된다.

신호등 인식 알고리즘은 크게 비학습 기반 알고리즘과 학습기반 알고리즘으로 나뉜다. 비학습 기반 알고리즘은 신호등의 HSV나 YCbCr과 같은 색상 데이터를 기반으로 신호등을 인식한다.5) 해당 방식은 차량이 신호등을 바라볼 때 하늘에 위치한다는 점과 시간, 날씨에 따른 하늘의 색상 변화에 민감하게 반응한다. 따라서 본 논문에선 환경에 강인한 학습기반 알고리즘에 일반 환경 영상 DB와 열악한 환경에서 취득한 영상 DB까지 포함된 학습데이터를 통한 학습으로 다양한 환경에서 강인한 인식이 가능하도록 구현하였다. 또한 차량자율주행시스템 특성상 알고리즘은 실시간 처리가 가능한 모델을 요구하며 자세한 내용은 ‘2. 신호등 인식 알고리즘’에서 상세히 설명한다.

차량 위치인식은 단순 GPS를 이용한 방법과 3D Lidar와 IMU6)를 이용한 방법, 초음파를 이용한 방법,7) 추측항법을 이용한 방법8) 등 다양한 방안이 존재한다. 3D Lidar, IMU, 초음파를 이용한 방법 들은 GPS의 비용문제나 환경제약에 대한 문제를 해결하기 위한 방안으로, GPS와 함께 사용한다면 더욱 높은 성능을 보장한다. 추측항법의 경우 타 방식보다 신뢰도가 떨어지지만 실시간성이 보장된다. 본 연구는 개활 지역에서 차량자율주행시스템을 구현한다. 따라서 환경제약에 구애받지 않는 GPS와 GPS의 실시간성 보정을 위한 추측항법을 사용하여 시스템을 구성하였으며 세부 내용은 ‘3. 차량 위치 인식’에서 상세히 설명한다. 한편 차량 주행 경로 생성도 해당 GPS방식을 이용하여 구현되며 ‘4. 좌표지도를 이용한 주행경로 생성’에서 상세히 설명한다.

차량 경로 추종은 생성된 주행경로를 토대로 차량에 설비된 임베디드 제어모듈에 종방향, 횡방향 제어값이 입력되며 구현된다. 종방향, 횡방향 제어기는 PID, Pure pursuit, Kinematic control, LQR with FF, Previe control9) 등 다양한 방안이 존재한다. 알고리즘 각각은 고속상황, 저속상황 등 안정적으로 구동되는 환경이 존재한다. 본 논문은 교차로의 특성을 고려하여 저속과 코너 상황에 강인한 알고리즘을 사용하였으며 자세한 내용은 ‘5. 차량제어시스템구성 및 경로추종’에서 상세히 다룬다.

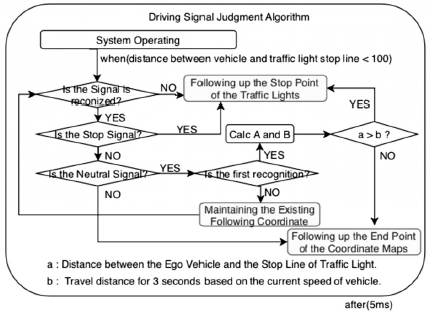

차량 주행 신호 판단은 신호등 인식의 인식 결과에 따라 차량의 주행, 정지를 판단한다. 운전자의 판단이 들어가는 주황색 신호에 대해 차량의 속력, 차량 정지선과의 거리를 이용해 알고리즘을 구현하였으며 ‘6. 주행 신호 판단 알고리즘’에서 상세히 설명한다.

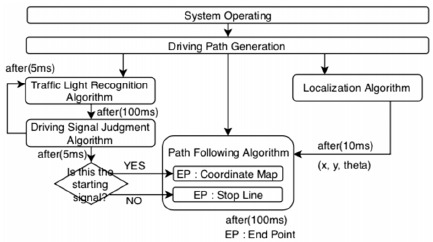

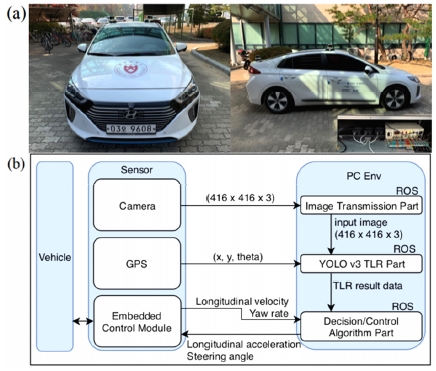

본 논문에서 제안하는 교차로 자율주행 시스템 은 Fig. 1에 설명하였다. 시스템 작동 후 차량의 주행 경로를 생성하고 재귀적으로 반복되어 실행되는 위치인식파트, 경로추종파트, 신호인식 및 판단 파트가 동시에 실시간성을 갖춘 상태로 실행되며 각각의 파트는 차량 주행을 위한 변수들을 공유한다. 신호인식 알고리즘에서는 신호등 검출을 위한 전처리 기법과 누적 확률기반 인식률 개선을 제안하였고, 실제 차량 제어 시스템을 구현하여 실차기반 교차로 환경에서 한 대의 Laptop PC로 시스템 통합 구현하는 방법을 제시하였다.

2. 신호등 인식 알고리즘

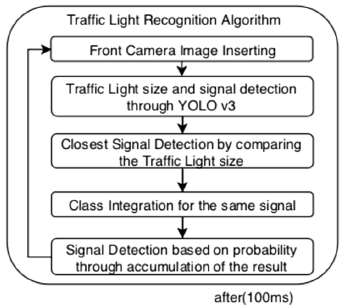

본 논문에서 신호등 인식 알고리즘 시스템은 Fig. 2와 같다. 전방카메라로부터 이미지 입력, CNN모델을 이용한 신호 정보 추출, 크기 비교를 통한 최근접 신호등 검출, 동일 신호에 대한 클래스 통합을 거쳐 최종 누적확률기반 신호 정보 추출을 통해 최종 신호를 인식한다.10)

2.1 신호등 인식용 카메라 캘리브레이션

카메라 센서는 차량 전방의 윈드실드 부근에 부착된다. 교차로 진입구간부터 교차로 통과 구간까지의 신호등 영역이 카메라의 시야(FoV, Field of View)에 포함되도록 카메라 외부 파라미터에 대한 캘리브레이션을 실험적으로 실시한다. 또한 차량의 교차로 진입 속도를 고려할 때, 교차로 전방 85 m 부근에서 신호등 검출이 수행되어야 하므로 25.36°의 협각 렌즈를 사용하여 원거리 검출 해상도를 확보하였다. 카메라와 렌즈의 상세스펙은 Table 1과 같다.

2.2 학습 기반 인지 알고리즘

차량자율주행시스템에서 신호등 인식은 날씨와 조명 변화 환경에서도 매우 높은 인식 성능과 신뢰성이 요구된다. 특히, 역광 상황에서 신호등이 영상에서 사라지는 펜텀현상이 일어나기도 하며 대낮의 파란 하늘과 저녁 노을 배경에서 신호등의 색상 정보가 급격하게 변화하게 된다. 따라서 이러한 열악한 환경에 대응해서도 강인한 알고리즘 개발이 요구된다. 한편, 자율주행 차량 제어를 위해서는 고속처리가 가능한 알고리즘도 동시에 요구된다. 최근 소개된 YOLO v311)는 자동차 주행환경과 같이 외부 조명 변화와 복잡한 배경이 있는 상황에서 강인한 인식률과 실시간성이 보장된다는 특징이 있어서 신호등 인식 모델로 채택하였다.

2.3 학습 데이터 구성

신호등 인식을 위한 학습 데이터는 일반 물체인식용으로 개발된 YOLO v3 모델을 신호등 인식 및 신호상태 판별의 역할까지 가능하도록 구성하였다. 본 논문에서 제안하는 YOLO v3 모델은 신호등과 함께, 신호등의 주행, 중립, 정지 신호를 판별한다.

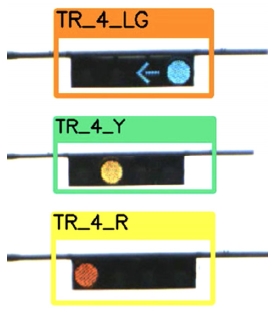

학습에 사용된 이미지는 차량을 통해 3구, 4구 신호등이 존재하는 교차로 구간의 실 도로에서 촬영된 신호등 데이터를 사용하였다. 촬영은 맑은 날, 흐린 날, 우천 환경에서 촬영하였다. 실험에 사용된 신호등 이미지의 구성 및 개수는 Table 2와 같다.12)

학습은 동일한 신호체계에 대해 최대한 다양한 클래스로 나누어 진행된다. 학습 시, GT(Ground Truth)의 ROI (Region of Interest)는 신호등 외형에서 가로 1.2배, 새로 1.5배의 가중치를 준 데이터를 사용한다.

2.4 학습 이미지 데이터 확장

딥러닝의 기본 전제는 학습 데이터에 따라 신경망의 웨이트들을 학습시켜 원하는 결과를 도출해 내는 것이다. 따라서 딥러닝을 이용한 학습은 다양한 환경의 학습 데이터를 요구한다. 만일 학습 데이터의 환경이 한정적이라면, 해당 딥러닝 모델은 학습된 환경에만 국한되어 신뢰성 있는 결과를 도출할 것 이다.

학습기반의 알고리즘인 YOLO v3는 전용 프레임 툴인 Darknet13)을 사용해 구현하였다. 해당 프레임은 YOLO v3 입력 데이터의 종류를 보강시켜주는 데이터 증강(Data Augmentation)14) 기법을 제공한다. 데이터 증강은 입력된 학습 이미지의 색조, 채도, 노출 등을 수정하여 새로운 이미지를 만들어낸다.

본 연구에서 학습에 사용된 데이터 증강 기법은 신호등에서 최적화하여 구성하였다. 신호등 인식의 특징은 신호 판별 시 위치정보를 사용할 수 있는 점 이다. 따라서 본 논문에선 Darknet에서 제공하는 모든 데이터 증강 기법을 사용하되 좌우 대칭 기법인 플립 옵션은 사용하지 않고 학습을 진행하였다.

2.5 신호 검출, 인식 데이터 처리 과정

YOLO v3 알고리즘을 통해 신호등의 위치정보와 신호정보가 출력된다. 위치정보는 신호등의 가로길이, 세로길이로 카메라를 기반으로 한 이미지의 위치정보를 담고 있다. 일반적으로 교차로 진입 차량이 1개의 신호등을 지나가는 동안에 여러 장의 입력 영상에서 서로 다른 박스 크기의 신호등이 검출된다. 다중으로 검출된 신호등 중 신호 판단 기준으로써 검출해야 하는 신호등은 차량 전방에서 최근접한 신호등이므로 YOLO v3 알고리즘으로부터 전송받은 이미지에서 검출된 신호등의 크기를 비교하여 가장 큰 신호등을 최종 검출 신호등으로 판단하였다.

신호정보는 총 7개의 신호로 구성된다. 이는 신호등의 구의개수와 신호로 나눈 결과로 최종적으로 4개의 신호로 간소화할 수 있다. 가령 3구의 빨강 신호는 4구의 빨강 신호와 동일한 신호로 판단하여도 무관하다.

학습기반의 신호등 인식은 인식률이 높은 편이지만 완벽하다고는 할 수 없다. 따라서 검출된 결과를 누적시키고, 누적된 결과에서 가장 높은 확률을 갖는 신호를 최종 인식 신호로 판단하여 인식률을 높인다. 하지만 누적되는 신호의 데이터가 많을수록 실시간성이 떨어진다는 단점이 있기에 시스템의 성능에 따라 적절한 누적값을 요구한다.

본 논문에서는 최근접 신호등 검출, 클래스 통합, 누적확률기반 신호 정보 추출을 통해 최종 신호를 검출하였다(Fig. 3).

3. 차량 위치 인식

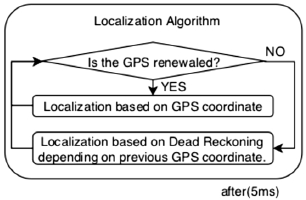

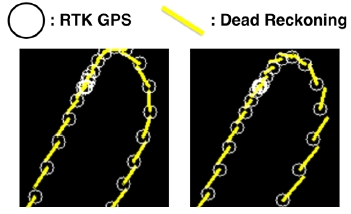

본 논문에서 차량 위치인식 시스템은 Fig. 4와 같다. RTK방식의 GPS로 수신받은 차량 위치 정보에 추측항법을 더하여 구현된다.

GPS센서는 차량에 부착되어 (x, y, theta)의 정보를 수신 받는다. 하지만 최대 10 m의 오차를 갖기 때문에 RTK라는 반송파 해독방식을 사용하여 1 ~ 10 cm의 오차를 갖도록 구현된다. 해당 오차는 차량 위치인식에 사용이 가능한 범위이다. 하지만 수신 빈도가 1 ~ 5 Hz이기에 차량에서의 실시간성을 보장할 수 없다. 따라서 추측항법(Dead Reckoning)을 사용하여 GPS 수신 구간 사이의 차량위치를 추정한다. 추측항법은 RTK GPS보다 정확도는 떨어지지만 실시간성이 보장되는 휠 엔코더, 자이로스코프 등을 사용하여 구현되기 때문에 차량에서 요구하는 실시간성을 보장할 수 있다.

차량 위치 인식은 NED(North East Down)좌표계를 사용하였고 충북대학교 오창 자율주행 성능시험장(Fig. 11)의 입구를 기준으로 차량의 위치를 (x, y)로 나타내었다.

3.1 RTK GPS를 이용한 차량 위치 인식

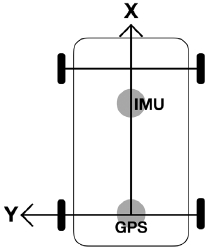

RTK GPS는 GPS센서 2대를 이용하여 구현하였다. 각각 기준국(Base)과 이동국(Rover)라 불린다. 기준국은 고정된 위치에 부착되며 GPS 수신 정보의 오차를 누적시키고 최종적으로 계산된 오차를 이동국으로 송신해준다. 이동국은 차량의 후륜축 중심의 상단 루프(Fig. 5)에 부착되며 기준국으로부터 수신받은 오차정보를 이용하여 오차범위 1 ~ 10 cm의 수신정보를 구현한다.15,16)

GPS센서의 수신빈도, 기준국, 이동국 등의 환경 설정은 소프트웨어 u-center를 사용하였으며 본 실험에서 RTK GPS의 수신빈도는 5 Hz로 사용하였다.

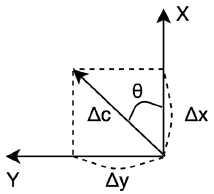

3.2 추측항법을 이용한 차량 위치 인식

추측항법은 차량자율주행을 위해 설치된 임베디드 제어모듈에서 출력되는 각속도와 차량의 전진방향 속도를 이용하였다. 각속도와 차량의 전진방향 속도를 출력하는 센서는 Fig. 5의 IMU 위치에 부착되었다. 추측항법을 통한 차량위치구현은 아래 (1), (2), (3)을 통해 구현되며 수식은 Fig. 6에 표기된 수식을 따른다.

| (1) |

| (2) |

| (3) |

Method how to calculate vehicle location. The arrow mean heading of vehicle. θ mean a angle between x-axis of NED Coordinate System and heading of vehicle. Δx mean a small moving distance to x-axis of NED Coordinate System. Δy mean a small moving distance to y-axis of NED Coordinate System

Fig. 7은 RTK GPS와 추측항법을 사용해 차량을 주행하며 위치를 출력한 이미지다. 흰 원은 RTK GPS를 수신받은 차량의 위치, 흰색점으로 이루어진 선은 추측항법을 이용한 차량의 위치를 의미한다. RTK GPS의 수신빈도는 추측항법의 구현을 확인하기 위하여 1 Hz로 사용하였다. 좌측 그림은 각속도를 반영한 그림이고 우측 그림은 각속도를 반영하지 않은 그림이다.

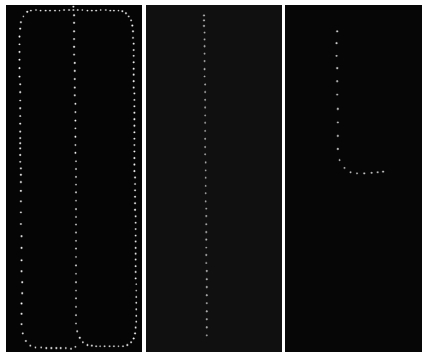

4. 좌표지도를 이용한 주행 경로 생성

주행 경로는 사전에 제작한 좌표지도를 통해 생성된다. 좌표지도는 차량이 추종해야하는 처음부터 끝까지의 경로가 점으로 구성되어 있다. 각각의 점은 차량 제어를 위한 7가지 정보를 저장하고 있으며 해당 정보는 다음과 같다.

- 1) 점의 주소 2) 위도

- 3) 위도 4) 차량의 추종 속력

- 5) 신호등 정지점의 위도

- 6) 신호등 정지점의 경도

- 7) 신호등 정지점의 주소

점은 Fig. 5의 GPS 부착지점을 기준으로 생성되며 차량에 부착된 RTK GPS를 사용한다. 이 때 RTK GPS의 수신빈도는 1 Hz이며 차량의 속도는 약 10 kph로 점 사이 간격을 약 3 m로 구성한다. 생성된 점은 Fig. 8과 같다.

5. 차량제어시스템 구성 및 경로추종

본 논문은 실차를 기반으로 시스템을 구현하였다. 실험에 사용된 차량은 Fig. 9의 (a)와 같으며 카메라 및 차량제어용 임베디드 제어모듈이 장착되어있는 아이오닉 플러그인 하이브리드 차량을 사용하였다. 차량제어시스템은 Fig. 9의 (b)와 같다.

임베디드 제어모듈은 차량의 종방향 가속도, 횡방향 조향각이 입력된다. 본 논문에서 차량 종방향 제어는 PD제어기17)를 구현하여 사용하였으며 차량 횡방향 제어는 Stanford University가 DARPA에서 사용한 Stanley Steering Control18) 제어법을 사용하였다.

본 논문에서 종방향 PD제어기는 부드러운 속도상승과 정지를 할 수 있도록 제어기 이득값(Gain)을 실험적으로 설정하였다. 또한 정상상태의 오차는 크게 중요하지 않으므로 PID 제어기의 I 성분은 사용하지 않았다. 횡방향 제어기는 저속, 코너 상황이 많은 교차로 상황에 장점을 갖는 Stanley Steering Control 방식을 사용하였다. 연구에 사용한 스탠리 계수는 아래와 같으며 차량 속력 0 ~ 30 kph 구간에서 실험적으로 구하였다.

| (4) |

| (5) |

수식은 Stanley Steering Control의 기본 방정식이다. k는 조향 계수로 최대값 2와 최소값 0.001을 범위로 한다. 는 차량의 조향각이며 ν는 차량 종방향 속력을 의미한다.

6. 주행 신호 판단 알고리즘

주행 신호 판단 알고리즘은 인식된 신호에 따라 차량의 주행, 정지 행동을 판단하는 알고리즘으로 전체적인 시스템 구성은 Fig. 10과 같다.

주행 신호 판단 알고리즘은 인식된 신호, 차량의 속력, 차량과 정지선 사이의 거리를 기반으로 구현된다. 인식된 신호는 최종적으로 주행, 중립, 정지의 3가지 상태로 출력되며 각각 신호등 인식의 결과가 초록색, 주황색, 빨강색 일 때를 의미한다.

중립 신호에 대해서는 차량의 속력과 신호등 정지선 사이의 거리를 통해 주행, 정지 신호로 결정된다. 차량이 신호등을 처음으로 인식했을 때의 속력을 기준으로 계산된 3초 동안의 이동거리가 신호등을 처음으로 인식했을 때의 차량과 신호등 정지선의 거리보다 멀다면 주행 신호로 판단하지만 가깝다면 정지 신호로 판단한다.

주행 신호일 경우 기존 좌표지도의 종방향 타겟 속도를 따른다. 하지만 정지신호일 경우 신호등 정지선 좌표를 추종하며 종방향 타겟 속도는 신호등 정지선 좌표에서의 속도를 0으로 설정하여 선형적으로 감소시킨다.

7. 실험 방법 및 결과

본 논문은 충북대학교 오창 자율주행 성능시험장(Fig. 11(a))의 신호등이 설치된 교차로(Fig. 11(b))의 장애물이 없는 환경에서 실험되었다.

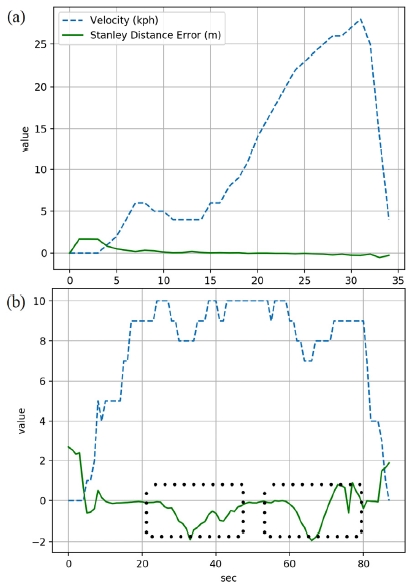

직선구간 기준 최대 30 kph, 코너구간 기준 최대 10 kph로 차량자율주행시스템을 구현하였다. 최종적으로 구현된 시스템의 성능은 Table 3, Fig. 12 및 Table 4와 같다.

The result of the TLR. The confusion matrix is used for the performance evaluation, and it is defined as one sequence from the distance of 85 m to the moment when the vehicle passes through the traffic lights12)

The result of vehicle path following according to vehicle's velocity. (a) means straight course. and (b) means corner course. At (b) course, The two dotted boxes means corner section

Table 3은 신호등 인식 알고리즘에 대한 성능평가이다. 차량이 주행하는 상황에서 차량과 신호등과의 거리 85 m 지점에서부터 교차로를 통과하는 시점까지의 인식 결과 1 Sequence로 정의하며 해당 결과를 혼동행렬로 나타낸 결과이다. Fig. 12는 차량 제어에 대한 성능평가이며 차량이 경로를 따라 주행할 때, 차량과 추종경로 사이의 오차를 출력한 그래프이다. Table 4는 Table 3의 신호등 인식 알고리즘과 Fig. 12의 차량 제어 알고리즘을 기반으로 구현된 모든 시스템을 통합하여 교차로 상황에서 차량자율주행시스템구현의 성공/실패에 대한 실험 결과이다. Table 4의 차량 제어에 대해서는 직선구간 최대 30 kph, 코너구간 최대 10 kph에서 안정적으로 주행이 가능했다.20)

8. 결 론

본 논문은 차량자율주행을 위한 센서, 제어모듈이 장착된 실 차량을 이용해 신호등이 설비된 교차로 상황에서 차량자율주행시스템을 구현하였다. 본 연구는 신호등 인식, 신호에 따른 차량 행동 판단, 차량 제어로 3가지 분야에 대해 이루어졌다.

연구에 대한 결과는 충북대학교 오창 자율주행 성능시험장의 환경 하에 성공적으로 구현되었다.

신호등 인식 및 신호 판단에 대해서는 주황색 신호에 대한 차량의 행동을 주로 연구하였고 차량의 속도, 차량과 정지선의 거리에 따라서 ‘6. 주행 신호 판단 알고리즘’ 을 구성하였다. 본 연구에서 고정된 변수는 주황색 신호의 유지시간이며 이는 교차로의 형태, 교통량 등에 따라 다르다. 따라서 강인한 주행 신호 판단 알고리즘 구현을 위해서는 V2X와 같은 추가적인 기능을 통해 해당 신호등의 주황색 신호 유지시간을 받은 후, 정확한 차량제어신호를 구현해야한다.

차량 제어에 대해서는 차량위치인식과 종방향, 횡방향 제어에 대해 실험하였다. 차량위치인식의 경우 RTK GPS 및 추측항법을 이용하여 ‘3. 차량 위치 인식’ 을 구성하였다. 하지만 본 연구에 사용된 GPS는 헤딩에 대한 정보에 최대오차로 5°가 발생하여 횡방향 제어에 불안전성이 발생할 수 있다. 따라서 칼만필터와 같은 기법을 통해 센서의 한계를 보완해야 한다. 또한 GPS를 이용한 위치 인식 시스템은 전파통신이 불안정한 고층 빌딩 사이에서는 위치에 대한 정보를 신뢰하기 어렵다. 또한 추측항법의 경우도 GPS 대비 신뢰도가 낮기 때문에 GPS의 보완 알고리즘으로 사용되는데, 더 진보된 추측항법 알고리즘을 통해 시스템을 구현한다면 기존보다 성능이 향상된 시스템을 구현할 수 있다. 차량의 종방향, 횡방향 제어에 대해서는 각각 PD제어기와 Stanley Steering Control을 이용하여 ‘5. 실차를 이용한 차량제어 및 경로추종’ 을 구성하였다. 본 연구에서 종방향 속도 제어의 PD제어기는 저속의 상황에 맞추어 구현된 결과이다. 따라서 고속의 상황에서 정지 및 주행 성능에 대해서는 신뢰할 수 없다. 하지만 실제 도로에서는 주행 상황에 따라 차량이 주행하는 속도는 다양하게 분포되며 정확한 제어를 통해 차량의 추돌 방지 및 탑승자의 편안한 승차감을 구현해야한다. 본 연구에서 사용된 횡방향 제어기인 Stanley Steering Control 또한 저속상황에 맞추어 구현되었다. 더욱 안정적인 제어를 위해서는 현재 사용 중인 알고리즘 외에 Pure pursuit, Kinematic control, LQR with FF, Previe control 등 도로의 다양한 환경에 따라 각각의 장점을 갖는 알고리즘들을 조건에 맞춰 사용하거나 Model Predictive Control19)와 같은 더욱 진보된 알고리즘을 통해 구현할 수 있다.

최종적으로 본 연구를 통한 결론은 아래와 같이 요약될 수 있다.

- 1) 좌표지도, GNSS RTK, 카메라, 차량 내부센서를 기반으로 도심 교차로 자율주행 시스템을 구현할 수 있다.

- 2) 기존의 인지, 제어 알고리즘과 주행 신호 판단 알고리즘을 통해 실 차량을 이용한 교차로 주행 시스템 구현이 가능함을 실험적으로 검증하였다.

- 3) 정확하고 정밀한 차량 제어를 위해선 본 논문에 사용된 위치인식/제어 알고리즘보다 진보된 방식이 요구된다.

- 4) 신호등의 주황색 신호 유지시간 및 잔여시간과 현재 차량의 속도, 차량과 신호 정지선 사이의 거리를 알 수 있다면 안전한 주행 신호 판단 알고리즘을 구현할 수 있다.

Acknowledgments

A Part of this paper was presented at the KSAE 2018 Fall Conference and Exhibition

이 논문은 2019년도 정부(과학기술정보통신부)의 재원으로 정보통신기술진흥센터의 지원을 받아 수행된 연구임(No. R7117-19-0164, 차량 통신 기반의 광역 주행환경인지 및 협조 주행기술 개발).

References

- Road Traffic Authority, Traffic Accident Detailed Statistics, http://bitly.kr/d54R (2018).

-

G. Reina, D. Johnson, and J. Underwood, “Radar Sensing for Intelligent Vehicles in Urban Environments”, MDPI Sensors Journal, 15(6), p14661-14678, (2015).

[https://doi.org/10.3390/s150614661]

- D. J. Lim, Obstacle tracking and Vehicle Recognition Based on Lidar and Vision Sensor Fusion, M. S. Thesis, Ajou University, Suwon, (2014).

-

P. G. Jo, and J. W. Lee, “Traffic Light Detection Using Morphometric Characteristics and Location Information in Consecutive Images”, Journal of Institute of Control, Robotics and Systems, 21(12), p1122-1129, (2015).

[https://doi.org/10.5302/j.icros.2015.15.0133]

- T. H. Jung, and J. H. Kim, “Traffic Light Recognition based on HSV/YCbCr Color Model and Morphological Feature”, KSAE Fall Conference Proceedings, p547-551, (2017).

- S. W. Heo, and T. H. Park, “Localization of Autonomous Vehicle Using 3D LIDAR and IMU”, KSAE Fall Conference Proceedings, p850, (2016).

- S. Y. Kim, J. -M. Lee, D. H. Lee, and M. H. Lee, “Unmanned Navigation of Vehicle Using the Ultrasonic Satellite System”, Journal of Institute of Control Robotics and Systems, 13(9), p875-882, (2007).

- H. J. Jung, D. H. Lee, S. K. Kim, C. S. Kim, and K. S. Huh, “Development of Vehicle Position Estimator using Dead Reckoning Algorithm”, KSAE Annual Conference Proceedings, p1255-1257, (2012).

- J. M. Snider, Automatic Steering Methods for Autonomous Automobile Path Tracking, Robotics Institute Carnegie Mellon University, Pittsburgh, CMU-RI-TR-09-08, (2009).

- C. H. Jang, S. J. Cho, S. W. Jeong, J. K. Suhr, and H. G. Jung, “Traffic Light Recognition Exploiting Map and Localization at Every Stage”, Expert Systems With Applications, 88, p290-304, (2017).

- J. Redmon, and A. Farhadi, YOLOv3:An Incremental Improvement, Computer Vision and Pattern Recognition, (2018).

- C. H. Park, and S. -C. Kee, “A Study on the Traffic Light Recognition Based On Deep Learning for Urban Autonomous Driving”, KSAE Spring Conference Proceeding, p811-812, (2018).

- J. Redmon, YOLO v3 Darknet Frame, https://pjreddie.com (2018).

- J. Salamon, and J. P. Bello, “Deep Convolutional Neural Networks and Data Augmentation for Environmental Sound Classification”, IEEE Signal Processing Letters, 23(3), p279-283, (2016).

- H. J. Woo, S. K. Jung, B. G. Cho, and J. H. Kim, “Research of Navigation Algorithm for Unmanned Gound Vehicle based on Real Time Kinematic (RTK)-GPS”, KSAE Spring Conference Proceedings, p972-976, (2009).

- R. B. Langley, RTK GPS, GPS WORLD, September 1998, INNOVATION p70-76, (1998).

-

J. -I. Bae, “An Adaptive Cruise Control Systems for Inteligent Vehicles in Accordance with Vehicles Distance”, The Transactions of The Korean Institute of Electrical Engineers, 62(8), p1157-1162, (2013).

[https://doi.org/10.5370/kiee.2013.62.8.1157]

- S. Thrun, M. Montemerlo, S. Strohband, and G. Bradski, “Pamela MahoneyStanley: The Robot that Won the DARPA Grand Challenge”, Journal of Field Robotics, 23(9), p661-692, (2006).

-

J. -Y. Lee, and K. -S. Yi, “MPC based Steering Control using a Probabilistic Prediction of Surrounding Vehicles for Automated Driving”, Journal of Institute of Control, Robotics and Systems, 21(3), p199-209, (2015).

[https://doi.org/10.5302/j.icros.2015.14.9012]

- C. H. Park, and S. -C. Kee, “A Intersection Driving System Implementation Based on Sensor and Coordinates Maps for Urban Autonomous Driving”, KSAE Fall Conference Proceedings, p722-728, (2018).