보행자 보호를 위한 단안 카메라 기반 측면 정규 영상에서의 위험 지역 검출 방법

Copyright Ⓒ 2019 KSAE / 160-10

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper proposes a method for the detection of critical areas using a monocular camera. In addition to a frontal camera, existing methods have used an additional sensor, such as a laser scanner or stereo camera, in order to detect critical areas. However, this complex system architecture reduces utilization realistically and increases the prices. To overcome these limitations, this paper uses a side-rectilinear image generated from a frontal image, in which the shape distortion of the side of vehicle has been removed. In order to reduce the computational cost, the proposed method omits the verification steps of the tires and vehicles from the general part-based vehicle detection process. Additionally, a single tire-based vehicle candidate generation method is introduced in order to increase the detection rate of the critical areas. Experimental results confirm that the proposed method can successfully detect the critical areas with a performance similar to that of the existing method.

Keywords:

Active pedestrian protection system, Critical area detection, Monocular camera, Side-rectilinear image, Part-based vehicle detection키워드:

능동적 보행자 보호 시스템, 위험 지역 검출, 단안 카메라, 측면 정규 영상, 부품 기반 차량 검출1. 서 론

최근 능동적 보행자 보호 시스템1)의 실시간성과 오작동(False alarm)의 최소화를 위해 차량의 전방 카메라에서 취득된 영상 전체에서 보행자를 탐색하는 기존의 방법 대신 제한된 영역에서만 보행자를 탐색하는 새로운 접근방법이 제시되었다. 그 중, Broggi 등2)은 사고 발생 가능성이 매우 높은 상황을 고려하여 위험도가 높은 위험지역을 먼저 검출하고 그 영역에서만 보행자를 검출하는 방법을 제안하였다. 보행자가 갑자기 나타날 수 있는 위험지역을 검출하기 위해서 레이저 스캐너(Laser scanner)를 사용하였고, 전방 카메라를 이용하여 검출된 위험지역 내에서 보행자 검출을 수행하였다. 이러한 이종 센서의 결합은 시스템의 구조를 다소 복잡하게 한다. 또한 레이저 스캐너는 고가이며 센서 장착 시 차량 외관을 심하게 변형시켜야한다는 단점이 있다.3) 이를 해결하기 위한 방안으로 이전에 우리는 스테레오 카메라를 이용하여 위험 지역을 검출하는 방법4,5)을 제안했었다. 이 방법은 스테레오 매칭을 실시한 후 UV-disparity를 사용하여 도로면과 장애물의 경계를 추정하고 Disparity map에서 추정된 도로면으로부터 일정 높이의 선에서 깊이 변화량을 측정하여 깊이 변화량의 국소 최대치(Local maxima)와 국소 최소치(Local minima)가 있는 위치를 위험지역 후보로 검출한다. 이 방법은 위험지역 검출 시 정확한 성능을 보여줬지만, 스테레오 비전은 까다로운 카메라 Calibration 과정과 Disparity map을 얻기 위해 비교적 많은 연산량이 요구되는 스테레오 매칭 과정을 필요로 한다는 단점을 갖는다.

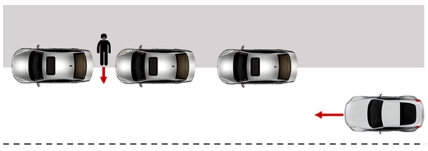

본 논문에서는 이러한 점을 보완하기 위해 차량에 탑재된 단안 전방 카메라만을 사용하여 위험지역을 찾아내는 방법을 제안하고자 한다. Fig. 1은 본 논문에서 고려하는 위험 상황을 보여준다. 그림은 차도를 횡단하려는 보행자가 주정차된 차량에 가려져 있다가 갑자기 도로로 나와서 운전자와 보행자가 서로를 인식하지 못하여 주행하는 차량과 보행자가 충돌할 수 있는 상황을 설명한다. 이와 같은 상황은 차대 보행자 사고의 대부분을 차지하며 보행자에게는 매우 치명적이다. 이러한 사고를 미연에 방지하기 위해 반드시 검출해야 할 위험영역은 바로 주정차 차량 앞 혹은 주정차된 차량들 사이의 영역이 된다. 다시 말해, 본 논문에서는 유럽의 신차안전도평가(Euro NCAP)6)에서 보행자 AEB(AEB VRU, Autonomous Emergency Braking Vulnerable Road User) 테스트 프로토콜에서 제시된 길가 쪽에서 갑작스럽게 나타나는 보행자에 대해 초점을 맞추고자 한다. 운전자 쪽에서 나타나는 보행자는 주로 도로 건너편에서 나타나기 때문에 비록 장애물에 가려져 있다 하더라도 운전자와 보행자가 서로를 인식할 수 있는 거리가 확보된다. 따라서 위험도가 더 높은 길가 쪽 보행자에 초점을 맞추었다.

단안 카메라를 사용하여 자차 우측 도로변에 주정차된 차량 사이의 위험지역을 검출하기 위해서는 주정차 차량의 위치를 먼저 파악해야 한다. 그러나 단일 영상 자체에서는 종방향 거리에 따라 주정차된 차량의 형태 변화(Perspective distortion)가 크게 발생하기 때문에 차량 검출이 용이하지 않다. 이러한 문제는 이전에 사각지대(Blind spot) 검출 연구7,8)에서 측면 정규 영상을 활용함으로써 해결된 바 있다. 마찬가지로 본 논문에서도 측면 정규 영상을 도입한다. 측면 정규 영상은 자차의 우측에 설정된 관심영역을 중심으로 생성되고, 관심 영역 내 주정차된 차량은 부품 기반 차량 검출 방법(Part-based vehicle detection method)을 통해 검출된다. 마지막으로 검출된 차량의 위치를 근거로 위험지역 후보 영역이 설정된다. 본 논문에서는 위험지역의 검출률을 높이고 연산량을 최소화하기 위하여 일반적인 부품 기반 차량 검출 방법을 간소화한 새로운 방법을 제안한다. 제안된 위험지역 검출 방법을 KITTI vision Benchmark Suit의 Raw data9)에 적용하여 위험지역이 단일 영상에서도 효과적으로 검출됨을 확인하였다.

2. 측면 정규 영상 생성

측면 정규 영상은 전방 카메라에서 획득한 영상을 차량 종축과 수직한 광축을 가지는 가상 카메라로 투영하여 생성된다.8) 따라서 상대 차량의 측면은 가상 카메라로부터 일정한 거리에 있는 평면이 되기 때문에 측면 정규 영상에 원근 왜곡(Perspective distortion)이 없는 외형과 비교적 일정한 크기로 투영된다.

전방 카메라에서 획득한 영상에서의 한 점 pr은 다음의 식 (1)에 의해 측면 정규 영상에서의 한 점 pc로 변환된다.

| (1) |

Kc와 Rc는 전방 카메라의 내부 파라미터(Intrinsic parameter)와 외부 파라미터(Extrinsic parameter)의 회전행렬(Rotation matrix)이 되고, Kr와 Rr은 가상 카메라의 내부 파라미터와 회전행렬이 된다. Rr에서 롤(Roll), 피치(Pitch), 요(Yaw) 수치는 0°, 0°, ±90°가 되고, 차의 방향을 0°라고 할 때, 회전 각도가 ±90°가 되면 가상 카메라의 광축은 차의 종축에 수직이 된다. 측면 정규 영상은 자차를 기준으로 우측과 좌측의 영상을 생성할 수 있는데, 본 논문에서는 관심 영역이 우측에만 포함되므로 Yaw 값을 90°로 설정한다.

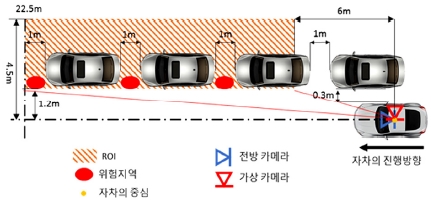

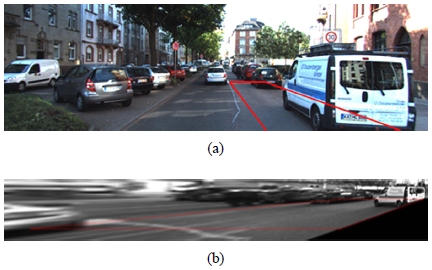

측면 정규 영상을 생성하기 위해서는 관심영역(Region of Interest, ROI)을 먼저 설정해야한다. 본 논문에서 설정하는 관심영역은 Fig. 2에서 사선패턴이 있는 영역이다. 자차 중심으로부터 종방향으로는 6 m~22.5 m이고, 우측 횡방향으로는 1.2 m~4.5 m 범위를 갖는다. 종방향으로 6 m부터 시작되는 이유는 전방 카메라의 높이와 화각에 의해서 자차 중심으로부터 6 m이내의 영역은 카메라 영상에 나타나지 않기 때문이다. 그리고 최대 종방향 거리가 22.5 m인 이유는 차의 길이를 5 m로 간주하고, 전방 20 m까지로 관심영역을 설정하였기 때문이다. 주정차 차량이 많은 골목길 상을 주행하는 상황을 가정하기 때문에, 최대 속도를 30 km/h로 가정하였다. 이러한 최대 속도에서 보행자 충돌 위험이 나타날 수 있는 최소 거리는 전방 20 m로 볼 수 있다.10) Fig. 3(a)는 전방 카메라 영상이고, Fig. 3(b)는 식 (1)에 의해서 생성된 측면 정규 영상을 보여준다. 각 그림에서 실선으로 이루어진 영역은 Fig. 2의 조감도에서 설명된 관심영역을 표시한 것이다.

3. 부품 기반 차량 검출 방법

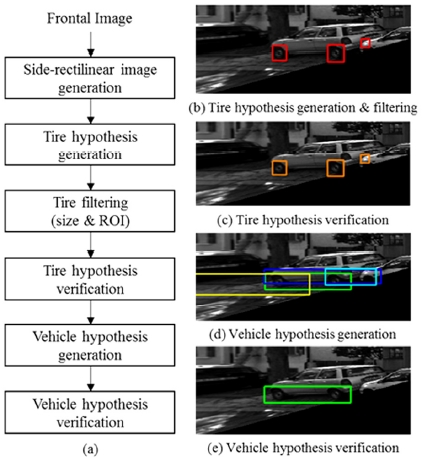

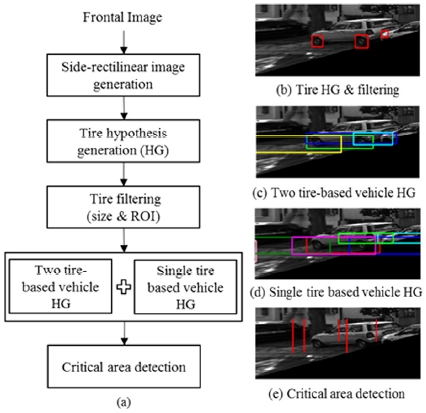

차량 측면의 외형은 차종에 따라 달라질 수 있으나 모든 차는 비슷한 형태의 타이어를 갖고 있다. 이러한 점 때문에 영상을 이용한 차량 검출은 일반적으로 부품 기반 검출 방법을 적용한다. 본 논문에서도 부품 기반 방법을 통해 차량 검출을 수행한다. Fig. 4(a)는 일반적인 부품 기반 차량 검출 방법의 흐름도를 보여주고, Fig. 4(b)~(e)는 각 단계별 결과의 예를 보여준다.

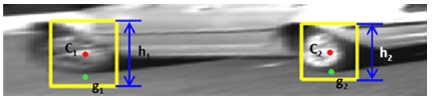

첫 단계로 타이어 후보 생성한다. 이 단계에서는 Viola-Jones 방법11)을 이용하여 타이어 후보를 검출한다. 다음 단계로 검출된 타이어의 위치와 크기를 이용하여 타이어 후보 필터링을 수행한다. 우선 검출된 타이어의 지면점이 관심영역 내에 존재하는지 여부를 판단하고, 측면 정규 영상 상 위치에 따른 타이어의 크기가 타당한지를 판단하여 타이어로서 정확도가 비교적 높은 후보만 남긴다. 다음 단계로는 HOG-SVM(Histogram of Oriented Gradients-Support Vector Machine)12,13)으로 타이어를 검증한다. 차량 후보 생성 단계에서는 검증된 타이어들 간의 기하학적 관계를 이용한다. 검증된 타이어로부터 Fig. 5에서와 같이 타이어의 중심과 크기, 조감도 상에서의 지면점을 구한다. 그리고 아래와 같이 차량 후보로 판단할 수 있는 세 가지 기하학적 관계를 계산한다.

- 1) 두 타이어 중심점 c1과 c2사이의 각도

- 2) 두 타이어 지면점 g1과 g2사이의 물리적 거리

- 3) 두 타이어 크기 h1과 h2의 비

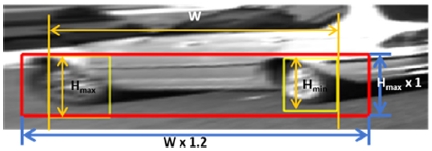

여기서 계산된 값들은 학습 데이터의 Ground-truth(GT)로부터 통계적으로 얻어진 범위 내에 존재해야만 차량 후보를 생성할 수 있다. 조건에 부합하는 두 타이어에 의해서 만들어지는 차량 영역은 Fig. 6에서 볼 수 있다. 가로길이는 전륜과 후륜 사이이의 거리(w)에 1.2배가 되며, 세로길이는 두 타이어의 크기 중 큰 타이어의 크기로 결정된다. 세로길이를 타이어의 크기와 같게 한 이유는 차량의 측면 외형 변화를 최소화하기 위해서이다. 차량의 하반부는 상반부보다 차종에 따른 외형의 차이가 크지 않아 차를 검증하는데 매우 적합하다. 마지막 단계로 생성된 차량 후보들은 다시 HOG-SVM에 의해 검증된다.

4. 위험 지역 검출 방법

본 논문에서는 관심영역 내 차량을 우선적으로 검출한 뒤 검출된 차량의 앞쪽 일부 영역 또는 검출된 차량 사이 영역을 위험 지역으로 설정한다. 3절에서의 차량 검출 방법은 정확도(Precision)는 비교적 높지만 미검출되는 차량이 많이 발생된다. 보행자 보호 관점에서는 보행자가 나타날 수 있는 위험지역이 오검출되더라도 실제 위험지역은 가능한 많이 정검출하는 것이 더 실용성이 높다. 따라서 연산량이 비교적 많고 정검출된 후보를 제거할 소지가 많은 후보 검증 단계를 생략하고, 검출된 타이어 후보를 기반으로 차량 후보를 검출하는 단순화된 구조를 제안한다. 이러한 구조는 계산의 복잡도를 낮추고 속도를 향상시키며, 검증 단계에서 미검출된 차량 후보도 그대로 사용하여 가능한 모든 위험지역이 검출되게 할 수 있다. 제안된 방법의 흐름도는 Fig. 7(a)와 같으며, 각 단계별 결과의 예는 Fig. 7(b)~(e)에서 보여준다. 일반적인 부품 기반 차량 검출 방법과의 차이점은 타이어 및 차량의 후보 검증 단계가 없고, 차량 후보 검출 단계에서 단일 타이어 기반 차량 후보 생성 방법이 추가되었다는 점이다. 두 타이어 기반 차량 후보 검출 방법은 한 차량을 이루는 두 타이어 간의 기하하적 관계로부터 차량 후보를 선택하는 방법이기 때문에 한 타이어만 검출된 경우 그 타이어가 속한 차량은 절대로 검출될 수 없다. 이러한 점을 보완하기 위해 한 타이어만 검출되더라도 차량 후보를 생성할 수 있는 방법을 제안하였다.

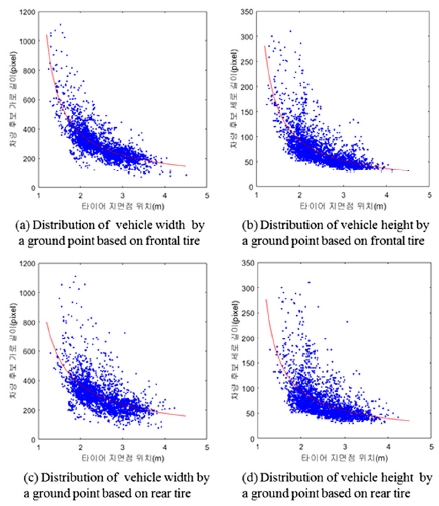

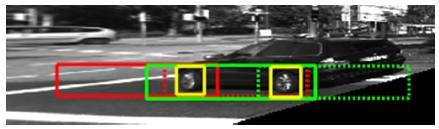

한 타이어 기반의 방법은 말 그대로 한 타이어의 정보만 가지고 그 타이어를 포함하는 차량 후보를 찾아내는 것이다. 검출된 타이어의 여러 정보들 가운데 타이어의 지면점이 실제 차량 후보를 결정하는 가로, 세로 길이와 연관성이 매우 크다는 것을 학습데이터의 분포를 통해 확인하였다. Fig. 8은 전륜과 후륜일 때 각각의 경우 타이어 지면점에 대한 실제 차량 후보의 가로와 세로 길이의 분포, 그리고 분포를 하나의 함수로 표현한 것을 보여준다. Fig. 8(a)~(d)에서 보여주는 데이터 분포는 학습데이터의 모든 GT 타이어의 전/후륜 정보와 조감도 상 지면점 위치, 그리고 해당 GT 타이어를 포함하는 GT 차량 영역의 가로와 세로 길이 값들로부터 얻어진다. 검출된 한 개의 타이어는 전륜인지 후륜인지 알 수 없기 때문에 분석을 통해 얻어진 함수들을 이용하여 전륜일 경우와 후륜일 경우로 나누어 후보를 생성하였다. Fig. 9는 네 개의 함수들을 이용하여 검출된 타이어 한 개당 두 개의 차량 후보가 생성된 결과를 보여준다. 타이어 한 개에서 두 개의 차량 후보를 생성하기 때문에 한 타이어 기반의 방법은 시스템의 정확도를 저하시키는 요인이 될 수 있다. 하지만 반대로 차량의 검출률을 높이는데 매우 효과적인 방법이라 할 수 있다.

Result of single tire based vehicle candidate generation (solid line: based on rear tire, dot line: based on front tire)

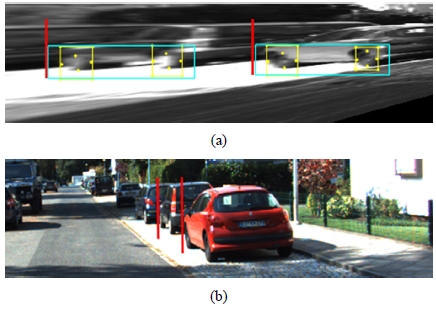

마지막 단계로 위험지역은 검출된 차량의 위치를 이용하여 차량의 앞 쪽에 검출 결과를 표시한다. Fig. 10(a)는 측면 정규 영상에서의 위험지역 검출 결과를 보여주고, Fig. 10(b)는 정면 영상에서의 위험지역 검출 결과를 보여준다.

5. 실험결과

제안된 방법은 KITTI Vision Benchmark Suite의 Raw data9)를 사용하여 평가하였다. Raw data는 전방 칼라 스테레오 카메라와 전방 흑백 스테레오 카메라, 3D 레이저 스캐닝 라이더, 고정밀 측위 시스템을 탑재한 차량이 다양한 환경을 주행하면서 수집한 데이터와 Calibration 정보를 제공한다. Raw data는 Campus, City, Residential, Road로 구성되며 총 71개의 시퀀스가 있다. 길가에 주정차된 차량이 있는 영상을 포함하는 시퀀스들은 City와 Residential 그룹에서만 볼 수 있으며, 학습 데이터 14개, 평가 데이터 10개로 총 24개의 시퀀스를 선택하여 실험에 사용하였다.

타이어 검출 및 차량 검출에 대해서는 식 (2)와 같이 Recall과 Precision으로 성능을 평가하였다.

| (2) |

TP는 검출된 True의 개수, FN은 미검출된 True의 개수, FP는 True로 오검출된 False의 개수이다. 검출된 결과를 True로 결정할 때는 GT와 검출된 결과 사이에 IOU (Intersection Over Union)를 구하여 임계값과 비교한다. 위험지역 검출 결과는 TPR(True Positive Rate)과 FPR (False Positive Rate)로 성능을 평가하였다. 여기서 True Positive는 GT로부터 일정 범위 내에 위험지역으로 검출된 결과가 존재할 경우로 결정된다.

Table 1은 일반적인 차량 검출 과정의 단계 별 성능 결과를 보여준다. 타이어와 차량 모두 후보 생성 단계에서는 Recall이 높게 나타나고, 후보 검증 단계에서는 Recall이 낮아지면서 Precision이 증가하는 것을 확인할 수 있다. 즉, 후보 검증 과정을 통해 확실한 후보들만 남게 되어 정확도는 높아지고, 일부 정검출된 후보들도 잃게 된다는 것이다. 마지막 단계인 차량 검증 단계의 결과를 보면 Recall이 90.08 %이고, Precision은 93.21 %이다. 이러한 결과는 차량 검출 결과로서는 비교적 우수한 성능이라 할 수 있다. 하지만, 이 결과를 토대로 얻은 위험지역 검출 성능은 Table 2에서와 같이 TPR이 81.43 %, FPR은 0.02 %로 보행자 보호가 목적인 경우에는 적합하지 않다.

Table 3은 제안된 위험지역 검출 과정 중 타이어 후보 생성 및 차량 후보 생성 결과를 보여준다. 이 과정에서는 검증 단계가 없기 때문에 Precision은 낮지만 Recall은 매우 높게 유지되는 것을 확인할 수 있다. 차량 후보 생성 결과에서 Recall이 99.02 %라는 것은 위험지역을 거의 대부분 검출할 수 있다는 것을 의미하며, 이 결과를 기반으로 얻어진 위험지역 검출결과는 Table 4에 정리되어있다.

Table 4에서 True positive를 결정하기 위한 범위는 GT를 중심으로 ±0.15 m, ±0.30 m, ±0.45 m로 설정하였으며, 0.45 m이내인 경우 TPR은 96.33 %, FPR은 1.48 %로 가장 우수한 성능을 보여준다. 기존의 스테레오 비전 기반의 방법은 그 범위를 0.15 m 이내로 설정하고 TPR 95.8 %, FPR 2.8 %의 성능을 보여주었다. 하지만, Fig. 2에서와 같이 위험지역은 길가에 주정차된 차와 차 사이 혹은 차의 앞부분으로 대부분 실제 영역의 폭이 약 0.5 m~1 m 범위를 갖는다. 따라서 GT를 기준으로 앞뒤로 0.45 m 범위는 1 m 이내에 속하므로 크게 문제가 되지 않는 수치이다. 결론적으로 실험결과 제안방법이 스테레오 비전 기반의 방법과 매우 비슷한 성능을 보여줌으로써 단일 영상 기반으로 위험지역을 찾는데 매우 효과적임이 입증되었다.

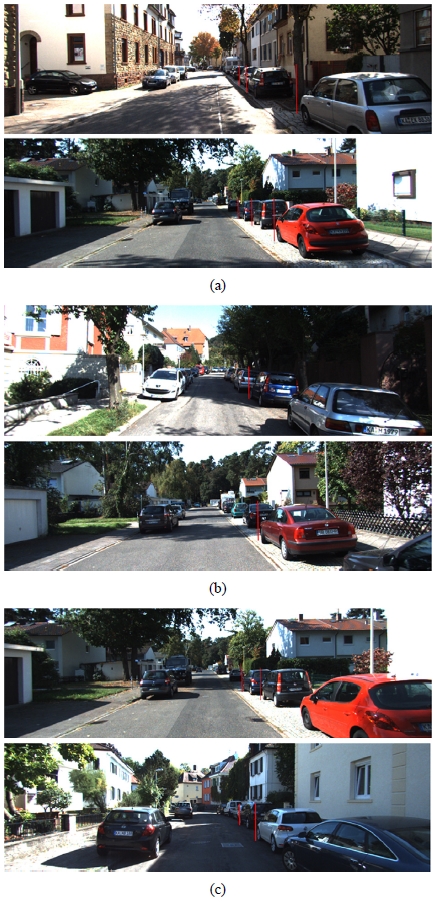

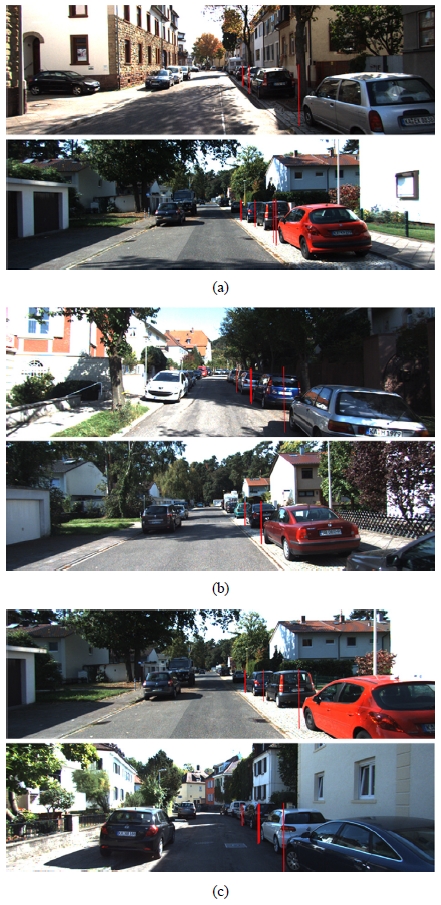

Fig. 11과 12는 각각 일반적인 차량검출방법에 의한 위험지역 검출 결과영상들과 제안된 방법에 의한 위험지역 검출 결과영상들을 보여준다. Fig. 11(a)와 12(a)는 두 방법 모두에서 위험지역이 잘 검출된 예들을 보여준다. Fig. 11(b)는 차량검출방법의 검증단계 때문에 미검출된 위험지역이 있는 영상들이며, Fig. 12(b)는 이러한 미검출 지역이 제안방법에서는 검출되고 있는 것을 보여준다. Fig. 11(c)는 두 타이어 기반의 차량 후보 생성에 의해 근거리에 위치한 한 타이어만 보이는 주정차 차량이 미검출된 사례를 보여준다. 반면에 Fig. 12(c)에서는 한 타이어 기반의 방식을 추가함으로써 근거리 주정차 차량도 모두 검출되는 것을 확인할 수 있다.

마지막으로 일반적인 차량 검출 방법과 제안된 방법의 처리시간을 측정하였다. Intel i7-6700 CPU 3.4 GHz, 16GB RAM을 사용하였고, Matlab으로 구현하였을 때 일반적인 차량 검출 방법은 0.93초이고, 제안된 방법은 0.76초로 측정되었다. 제안방법에서 검증단계를 생략함으로써 약 1.2배 처리속도가 향상될 수 있음이 확인되었다. 또한 C로 구현하였을 때, 제안방법의 처리속도는 약 126 ms로 초당 약 8장을 처리할 수 있었다.

6. 결 론

본 논문은 차량의 전방 카메라에서 획득된 한 장의 영상으로 위험 지역을 검출하는 방법을 제안했다. 차량의 측면 외형 변화가 최소화된 측면 정규 영상을 생성한 후 부품 기반 차량 검출 방법을 통해 차량을 검출한 후 차량의 앞 영역을 위험지역으로 검출한다. 기존의 일반적인 부품 기반 차량 검출 방법은 정확도는 높지만 Recall이 낮고 여러 단계의 복잡한 과정을 거쳐야 했다. 이런 단점을 보완하기 위해 보행자 보호 관점에서 Recall을 높이고 단계를 간소화하기 위해, 타이어와 차량 검증 단계를 생략하고 한 타이어로 차량 후보를 생성하는 단계를 추가하였다. 실험을 통해 수행시간이 단축되고 위험 지역에 대한 Recall이 향상됨을 확인하였다. 향후, 제안방법을 보행자 검출 시스템에 적용할 때 전체 시스템에 미치는 영향을 분석하고, 최종 성능을 최대화할 수 있는 파라미터 설정 방법을 연구할 계획이다. 또한, 제안방법의 실시간성을 향상시키기 위하여 속도에 따라 ROI를 설정하는 방법을 개발하고, 차량 속도 센서를 활용해 중복 탐색을 최소화하는 연구도 함께 진행할 예정이다.

Acknowledgments

이 논문은 2018년도 정부(미래창조과학부)의 재원으로 정보통신기술진흥센터의 지원을 받아 수행된 연구임 (No. 2016-0-00152, Deep Learning 기반의 보행자 안전 지원 스마트카 비전 기술의 개발).

References

-

H. -K. Lee, S. -G. Shin, and D. -S. Kwon, “Design of Emergency Braking Algorithm for Pedestrian Protection based on Multi-Sensor Fusion”, Int. J. Automotive Technology, 18(6), p1067-1076, (2017).

[https://doi.org/10.1007/s12239-017-0104-7]

-

A. Broggi, P. Cerri, S. Ghidoni, P. Grislenri, and H. G. Jung, “A New Approach to Urban Pedestrian Detection for Automatic Braking”, IEEE Transactions on Intellegent Transportation Systems, 10(4), p594-605, (2009).

[https://doi.org/10.1109/tits.2009.2032770]

-

J. Han, O. Heo, M. Park, S. Kee, and M. Sunwoo, “Vehicle Distance Estimation Using a Mono-Camera for FCW/AEB Systems”, Int. J. Automotive Technology, 17(3), p483-491, (2016).

[https://doi.org/10.1007/s12239-016-0050-9]

- J. K. Suhr, H. M. Kang, and H. G. Jung, “Selection of Regions of Interest for Pedestrian Detection using Stereo Vision”, KSAE Spring Conference Proceedings, p827-830, (2012).

- J. K. Suhr, H. M. Kang, and H. G. Jung, “Dense Stereo Based Critical Area Detection for an Active Pedestrian Protection System”, Electronics Letters, 48(19), p1199-1201, (2012).

- Euro NCAP, Test Protocol-AEB VRU Systems, Version 1.0.1, June), (2015.

- M. S. Ra, H. J. Lee, J. K. Suhr, H. G. Jung, and Wh. Y. Kim, “Rearview Camera-based Blind Spot Detection System”, KSAE Fall Conference Proceedings, p350-351, (2016).

-

M. S. Ra, H. G. Jung, J. K. Suhr, and W. -Y. Kim, “Part-based Vehicle Detection in Side-rectilinear Images for Blind-spot Detection”, Expert Systems with Applications, 101, p116-128, (2018).

[https://doi.org/10.1016/j.eswa.2018.02.005]

-

A. Geiger, P. Lenz, C. Stiller, and R. Urtasun, “Vision Meets Robotics: The KITTI Dataset”, The International Journal of Robotics Research, 32(11), p1231-1237, (2013).

[https://doi.org/10.1177/0278364913491297]

-

T. Gandhi, and M. M. Trivedi, “Pedestrian Protection Systems: Issues, Survey, and Challenges”, IEEE Transactions on Intelligent Transportation systems, 8(3), p413-430, (2007).

[https://doi.org/10.1109/tits.2007.903444]

-

P. Viola, and M. Jones, “Robust Real-Time Face Detection”, International Journal of Computer Vision, 57(2), p137-154, (2004).

[https://doi.org/10.1023/b:visi.0000013087.49260.fb]

- N. Dalal, and B. Triggs, “Histogram of Oriented Gradients for Human Detection”, IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 1, p886-893, (2005).

-

M. Enzweiler, and D. M. Gavrila, “Monocular Pedestrian Detection: Survey and Experiments”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 31(12), p2179-2195, (2009).

[https://doi.org/10.1109/tpami.2008.260]