저가형 센서융합기반 정밀측위를 위한 코너검출 기반 도로표지판 검출

* This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

To overcome the limitations of satellite navigation and inertial navigation, low-cost, precise localization systems that utilize road facilities as landmarks are being developed. Road signs are regarded as important landmarks because they are installed on all roads, and they can be seen even during congestion, unlike road surface markings. In this paper, we have proposed a method to detect road signs with various aspect ratios by identifying corners and combining such elements. By verifying each step to maximize detection performance and by tracking the bottom corners, the corners at close range can be used. The proposed method is applied to the images acquired on the highway, and high detection performance and real-time operation can be confirmed.

Keywords:

Low-cost sensor fusion-based precise localization, Road sign detection, Part-based method, Corner detection, Corner tracking키워드:

저가형 센서융합 기반 정밀측위, 도로표지판 검출, 부분 기반 방법, 코너 검출, 코너 추적1. 서 론

자율주행자동차와 첨단운전자지원시스템(ADAS: Advanced Driver Assistant System)을 구현함에 있어 정밀측위는 가장 중요한 구성요소 중 하나이며,1) 기본적으로 위성항법(GNSS: Global Navigation Satellite System)을 사용한다.2) 하지만, 위성 전파가 측위 단말기에 도달하기 전에 여러 가지 원인에 의해 왜곡되어 측위 정밀도를 확보하기 어렵다. 여러 원인들 중에서 대기권의 영향에 의한 왜곡을 극복하기 위해 지역적 왜곡 정보를 공유하고 보상함으로써 그 영향을 최소화하는 협력 측위(Cooperative positioning)가 개발되었는데,3) DGNSS(Differential GNSS), SBAS(Satellite Based Augmentation Systems), GBAS(Ground Based Augmentation System), RTK(Real Time Kinematic) 등이 여기에 포함된다. 한편, 높은 건물에 의한 위성 전파의 반사나 지하 도로에서의 차단을 극복하기 위하여 위성항법과 관성항법(INS: Inertial Navigation System)을 융합하는 GNSS/INS가 도입되었다.4) 하지만, 고층 건물이나 지하 도로, 고가 도로의 규모가 더 커지고 그 수도 더 많아진 도심에서 차로 수준 정밀도를 확보할 수 있는 GNSS/INS 단말기는 매우 고가여서, 이를 양산에 적용하는 것은 현실적으로 불가능하다. 이런 이유로, 위성 전파에 의존하지 않고 위치정보를 제공할 수 있는 랜드마크를 활용하는 저가형 센서융합 기반 정밀측위시스템에 대한 관심이 높아지고 있다.5)

차량에 탑재된 환경 인식 센서로 랜드마크를 검출하고 3차원 정보를 추정하면 자차에 대한 상대 위치를 알 수 있고, 이를 정밀지도의 랜드마크와 정합하면 랜드마크의 전지구 위치(Global position)를 알 수 있다. 이 두 가지 정보를 조합하여 자차의 전지구위치를 알 수 있게 된다.5) 이때 사용되는 센서와 랜드마크의 종류에 따라 거리 정보 기반 방법, 영상 특징점 기반 방법, 도로 시설물 기반 방법으로 나눌 수 있다. 거리 정보 기반 방법은 주로 스캐닝 라이다로 획득한 거리 정보를 미리 등록해 둔 거리 정보와 비교하는 방식이다.6-8) 거리 정밀도가 높은 라이다를 사용하기 때문에 측위 정밀도가 높지만, 차량이나 보행자 같은 이동 물체가 많은 도심에선 사용이 제한된다. 영상 특징점 기반 방법은 카메라로 획득한 영상에서 검출한 특징점을 미리 등록해 둔 영상 특징점들과 비교하는 방식이다.9-11) 라이다에 비해서 풍부한 정보를 획득할 수 있어서 주변에 이동 물체가 많은 경우에도 활용할 수 있지만, 계절, 날씨, 간판, 현수막 등의 변화에 취약하다는 단점이 있다. 거리 정보 기반 방법과 영상 특징점 기반 방법은 공통적으로 많은 정보를 정밀지도에 저장해두고 정합해야 한다는 단점이 있다. 도로 시설물 기반 방법은 카메라로 획득한 영상에서 노면표시나 도로표지판 같은 도로 시설물을 검출하고 이를 미리 등록해 둔 도로 시설물 정보와 비교한다.12-14) 도로 시설물은 교통 당국에서 관리하기 때문에 비교적 변화가 작고, 정밀지도에 저장해야 할 정보량도 월등히 적다. 영상을 사용하는 경우 가격적인 측면 때문에 스테레오 카메라보다는 단안 카메라를 선호하며, 일반적으로 다기능 전방 카메라 모듈에 내장될 수 있는 방식을 선호한다.

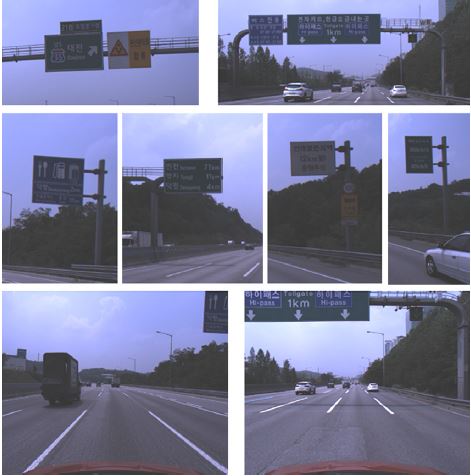

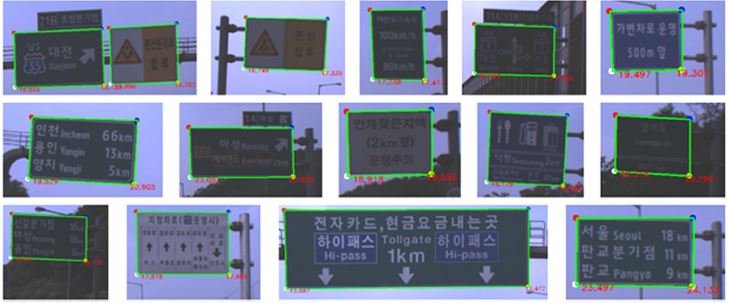

우리는 기존에 노면표시 검출을 활용하는 저가형 센서융합 기반 정밀측위시스템을 개발하였다.5) 차로표시를 검출하고 좌우 차로 사이 영역에서 노면 표시를 검출한 후,15) 카메라와 지표 사이 기하학적 관계를 활용하여 노면표시의 상대위치를 추정하였다. 하지만, 이 접근법은 정체 구간에서 노면표시가 장시간 가려지면 목표 측위 정밀도를 달성할 수 없었다. 이를 해결하기 위해 도로표지판(Road sign)을 추가적으로 사용하는 방법을 제안하였다.16) VJ(Viola Jones) 방법17)으로 후보를 생성하고 HOG-SVM(Histogram of Oriented Gradients-Support Vector Machine)18,19)으로 검증함으로써 도로표지판을 검출하였다. 도로표지판은 관련 법규에 따라 지표면에서 5 m 높이에 설치된다20)는 사실을 활용하여 도로표지판의 상대위치를 추정하였다. 개발된 도로표지판 검출 방법을 고속도로에 적용하려고 했을 때 몇가지 문제점이 발견되었다. 고속도로에는 시내도로에 비해 훨씬 다양한 형태의 도로표지판이 설치되어 있어(Fig. 1 참조), 전체를 한 번에 검출하는 방식의 도로표지판 검출 방법의 성능이 크게 저하되었다. 특히, 도로표지판의 종횡비가 다양하기 때문에 검출뿐 아니라 기준점 설정도 어려웠다. 본 논문은 이런 문제점을 해결할 수 있는 고속도로 정밀측위용 도로표지판 검출 방법을 제안한다.

교통표지판(Traffic sign) 검출은 오랫동안 연구되어 온 주제이지만, 주로 속도제한과 같은 교통안전표지의 내용을 인식하는데 집중되어 왔다.21) 도로표지판을 포함한 교통표지판 검출에는 색상을 이용하는 방법,22) 외양 기반 방법(Appearance-based),16) 부분기반 방법(Part-based)23,24) 등이 사용된다. 특히, 최근 딥러닝(Deep learning)을 활용하는 외양 기반 방법들이 높은 인식성능을 보이는 것으로 보고되고 있으나,25) 전방 카메라에 내장되기에는 계산 요구량이 너무 큰 것으로 알려져 있다.24) 본 논문은 코너를 검출하고 그 조합으로 표지판을 검출하는 부분 기반방법을 사용함으로써 다양한 종횡비의 도로표지판을 검출할 수 있는 방법을 제안한다. 특히, 측위 정밀도에 심각한 문제를 일으키는 오검출을 최소화하기 위해,5,15) 검출된 코너와 도로표지판을 검증하는 과정을 추가하였다. 또, 측위를 위해서는 도로표지판이 최대한 근접했을 때에 하단 코너를 검출할 수 있어야 하는데, 이를 위하여 코너를 추적하여 표지판 상단이 보이지 않는 상황(Fig. 1의 세 번째 행)에서도 도로표지판을 측위에 활용할 수 있는 방법을 제안한다. 코너를 검출하고 그 조합으로 도로표지판을 검출하는 선행 연구가 있었지만,23,24) 도로표지판 내용을 인식하는 용도로 개발되었기 때문에 오검출율을 최소화하고 최근접 지점에서의 검출이 중요한 측위용으론 활용이 제한적이었다. 제안 방법을 고속도로 영상 데이터베이스(DB: database)에 적용한 결과 높은 인식성능과 실시간성을 확보할 수 있었다.

2. 단안 기반 3차원 복원

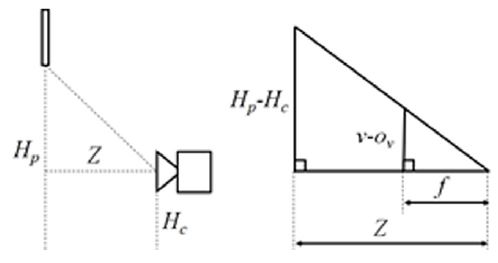

도로표지판의 하단 코너가 검출되면, 그 3차원 위치는 미리 계산해 놓은 카메라 내부 및 외부 파라미터와 도로표지판 설치 규정을 활용하여 계산된다.16) 즉, 카메라에서 도로표지판의 코너까지의 종방향 수직 거리 Z는 식 (1)과 (2)에 의해서 계산될 수 있다. 이때, 카메라가 지표면에 수평하고 광축이 차량진행 방향과 일치되도록 보정된 좌표를 사용한다고 가정한다.26)

| (1) |

| (2) |

위 식에서 f 와 ov는 카메라의 초점거리와 주점의 세로 좌표를 의미하고, Hp와 Hc는 도로표지판 코너와 카메라의 높이를 의미하며, v는 영상에서 검출된 도로표지판 코너의 세로 좌표를 의미한다. f, ov, Hc는 카메라 보정(Calibration)을 통해 미리 측정할 수 있고, Hp는 설치 규정에 의해 5 m로 설정된다. Fig. 2는 식 (1)과 (2)의 물리적 의미를 보여준다. 이 그림은 표지판, 카메라, 도로면을 측면에서 바라본 것을 보여준다.

다음으로 카메라에서 도로표지판의 코너까지의 횡방향 수직 거리 X는 식 (3)과 (4)에 의해서 계산될 수 있다.

| (3) |

| (4) |

위 식에서 ou는 주점의 가로축 좌표를 의미하고, u는 영상에서 검출된 도로표지판 코너의 가로 좌표를 의미한다. Fig. 3은 식 (3)과 (4)의 물리적 의미를 보여준다. 이 그림은 표지판, 카메라, 도로면을 하늘에서 바라본 것을 보여준다.

v좌표의 오류 Δv가 Z거리에 미치는 영향 ΔZ는 식 (5)와 같다. Δv가 일정할 때 ΔZ의 크기는 Z의 크기에 비례함을 알 수 있다. 따라서, 상대위치의 정밀도를 향상시키기 위해서 도로표지판이 최대한 근접했을 때 코너를 검출할 수 있어야 함을 알 수 있다.

| (5) |

3. 시스템 구성

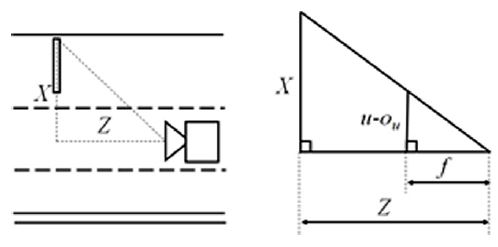

제안 방법은 코너 검출, 표지판 후보 생성, 코너검증, 표지판 검증, 표지판 통합, 코너 추적의 6단계로 구성된다. Fig. 4(a)는 제안 방법의 흐름도를 보여주고, (b)~(g)는 각 단계 별 결과의 예를 보여준다. 코너 검출 단계는 도로표지판의 4종류 코너(좌측 상단, 우측 상단, 좌측 하단, 우측 하단) 각각에 대한 코너 검출기로 코너를 검출한다. 표지판 후보 생성 단계는 검출된 4종류 코너 간의 기하학적 관계를 만족하는 경우를 표지판 후보로 생성한다. 이 과정에서 오검출된 코너들을 많이 제거할 수 있지만, Fig. 4(c)에서 보는 바와 같이 오검출된 표지판이 아직 많이 남아있다. 코너 검증 단계는 코너 주변 영상에 HOG-SVM 기반 검증을 적용함으로써 오검출된 코너와 이에 기반한 표지판 후보를 제거한다. 이때, 표지판 후보 생성 방법이 단순하여 고속으로 수행할 수 있기 때문에, 코너를 검증한 후 표지판 후보를 생성하는 경우보다 표지판 후보를 생성한 후 코너를 검증하는 방법이 더 효율적이다. 표지판 검증 단계는 표지판 후보 전체를 비교적 작은 영상으로 만들고, 여기에 HOG-SVM 기반 검증을 적용한다. 이렇게 저해상도 영상을 사용하는 이유는 도로 표지판의 윤곽은 공통적이지만 그 내용은 서로 상이하기 때문에, 윤곽 위주의 영상만을 검증에 활용하기 위해서다. 표지판 통합 단계는 서로 인접한 표지판 검출 결과들을 NMS(Non-Maximum Suppression)을 통해 통합한다. 이때, 표지판 하단에 다른 표지판이 존재하는 경우를 고려하여, 유용한 하단 코너 중 가장 낮은 코너를 선택한다. 마지막으로, 코너 추적 단계는 코너에 칼만 필터를 적용하여 추적한다. 이때, 표지판 상단 코너가 보이지 않는 경우에도 하단 코너는 계속적으로 추적함으로써, 표지판이 카메라와 아주 가까운 경우에도 하단 코너의 상대 위치를 추정할 수 있다. 표지판 후보 생성, 표지판 통합, 코너추적은 각각 4절, 5절, 6절에서 추가적으로 설명한다. 그리고, 7절에서 각 단계 별 파라미터 설정 과정과 성능평가 결과를 설명한다.

4. 표지판 후보 생성

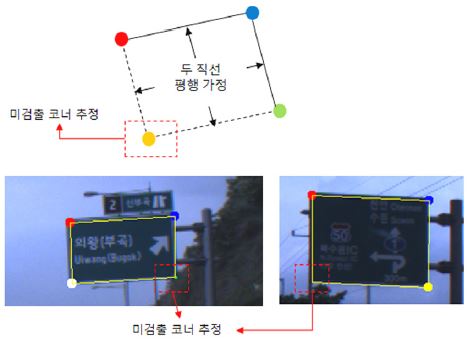

표지판 후보 생성 단계는 3개 혹은 4개 코너들을 조합하여 표지판 후보를 생성한다. 4개의 코너를 사용하는 방식은 검출된 4종류의 코너들 중 하나씩을 선택하여 이들로 만들어지는 사각형을 표지판 후보로 생성한다. 3개의 코너를 사용하는 방식은 검출된 3종류의 코너들 중 하나씩을 선택하여 이들로 만들어지는 평행사변형을 표지판 후보로 생성한다. 즉, Fig. 5에서 보는 바와 같이 3종류의 코너가 이루는 두 변과 평행하면서 양끝 코너를 지나는 두 직선의 교점을 미검출 코너로 가정한다. 이런 방식으로 4개의 코너 중 하나가 미검출됐을 때에도 표지판 후보를 생성할 수 있다.

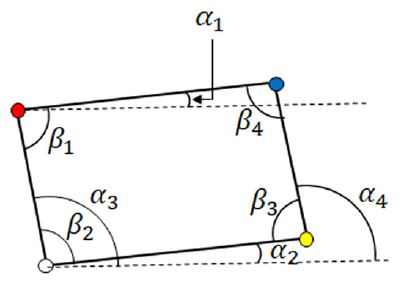

이때, 코너 검출 기반 선행 연구23,24)와 같이 코너들 사이 기하학적 관계를 활용하여 표지판 후보 중 형태가 이상한 것들은 제거하였다. 즉, Fig. 6과 같이 사각형의 8개 각도와 종횡비를 구하고, 그 값이 Table 1에서 기술한 학습 데이터의 범위 내에 있지 않은 후보들을 제거하였다. 추가적으로, 표지판 네코너에 대한 3차원 정보를 복원하고, 하단 두 코너 사이 거리나 표지판 높이가 1.0 m 미만인 후보들은 제거하였다. 이와 같은 과정은 매우 단순한 연산이지만, 상당히 많은 오검출을 제거할 수 있었다.

5. 표지판 통합

표지판 검증 단계를 통과한 표지판들이 서로 겹치는 경우, NMS를 통해 최적의 표지판만 남기고 나머지는 제거한다. 먼저, 검출된 두 표지판 간 IOU(Intersection over Union)가 임계치 이상인 표지판을 겹치는 표지판으로 판단하였다. 겹치는 표지판 중폭이나 표지판 검증 단계에서 사용했던 HOG-SVM 스코어가 유사하지 않은 경우, 오검출에 의한 겹침이라고 판단하여 HOG-SVM 스코어가 작은 표지판을 제거하였다. 만약, 두 표지판의 폭도 유사하고 HOG-SVM 스코어도 유사하다면, Fig. 7과 같이 표지판 하단에 작은 표지판이 붙어서 발생한 겹침이라고 판단하여 표지판 높이가 작은 표지판을 제거하였다. 이것은 표지판의 가장 하단 좌표를 정확하게 찾고 이 하단 좌표를 기반으로 표지판까지 상대거리를 정확하게 측정하기 위함이다.

6. 코너 추적

표지판 검출 후에는 칼만 필터 기반으로 표지판을 구성하는 코너들을 추적하였다. 표지판이 근접거리로 접근하면, 2개 이상의 코너들이 영상 내에 포함되지 않기 때문에 표지판이 검출되지 않는다. 하지만 정확한 상대 거리 추정을 위해서는 최대한 근접한 표지판 코너들을 검출해야 하기 때문에, 표지판이 검출되지 않고 일부 코너들만 검출되는 상황에서도 표지판 코너를 정확하게 추적할 수 있도록 하였다.

표지판 트랙(Track)은 표지판을 구성하는 4개의 코너 트랙으로 구성되며, 각 코너 트랙들은 일반적인 등속 운동 모델을 사용하는 칼만 필터로 추적된다. 각 코너 트랙의 예측치(Prediction)로 구성된 사각형과 새롭게 검출된 표지판의 IOU가 임계치 이상인 경우, 표지판 트랙과 검출된 표지판이 연관(Association)되었다고 판단한다. 이때, 검출된 표지판의 코너를 활용하여 코너 트랙을 교정(Correction)한다. 연관이 실패하여도, 연관이 실패한 회수가 일정회수 이내일 때는 예측치만으로 코너와 표지판 트랙을 갱신한다.

표지판이 근접거리로 들어오게 되면, 상단 코너 예측치가 영상 밖으로 나가기 시작한다. 이 상황에 선 표지판 수준의 연관은 성공할 수 없기 때문에, 코너 트랙과 코너 검출 결과를 직접적으로 연관시킨다. 즉, 코너 트랙의 예측치와 검출된 코너 사이 거리가 임계치 이하인 경우 가장 가까운 코너와 연관되었다고 판단하고, 연관된 코너를 활용하여 코너트랙을 교정한다.

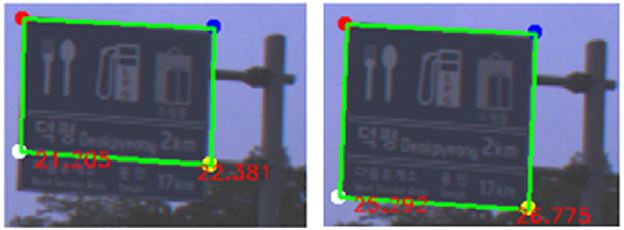

표지판 하단 코너 2개 중 1개만 관측 가능하여도 추적에 성공할 수 있음을 확인하였다. Fig. 8은 코너추적의 효과를 보여준다. 표지판 검출에만 의존할 경우 약 13 m 이상 거리에서만 표지판 코너를 검출할 수 있었지만, 코너 추적을 사용할 경우 약 8 m 거리의 표지판 코너들도 사용할 수 있었다. 코너의 3차원 복원 오차가 거리에 비례한다는 점을 고려하면, 제안 방법이 측위오차를 상당히 줄일 수 있음을 알 수 있다.

7. 실험결과

7.1 실험 DB

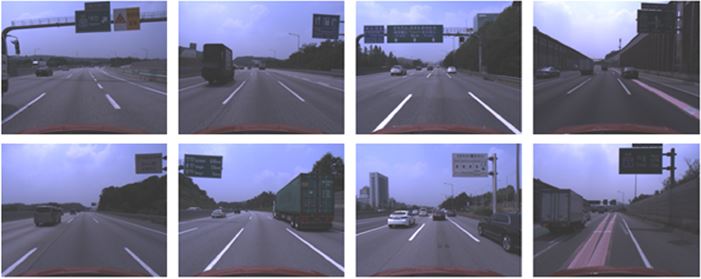

제안된 표지판 검출기를 학습시키고 평가하기 위하여 고속도로를 주행하면서 실험 DB를 Table 2와 같이 획득하였다. 영상의 해상도는 1280×1024이고, 획득 속도는 15-20장/초이다. 1번 DB는 코너 검출, 표지판 후보 생성, 코너 검증, 표지판 검증 단계의 학습을 위해서 사용하였다. 2번 DB는 코너 검출기 학습 시, 1번 DB를 보완하는 용도로 사용하였다. 3번 DB는 코너 검출, 표지판 후보 생성, 코너 검증, 표지판 검증 및 표지판 통합 단계의 성능을 평가하기 위해서 사용하였다. Fig. 9는 취득한 DB의 예를 보여주는데, 다양한 표지판과 함께 방음벽 및 나무와 같은 다양한 배경도 포함하고 있다.

표지판 하단 코너의 오차가 최대 5픽셀 발생한다고 가정하고, 표지판까지 상대거리 추정 오차가 50 cm 이내가 되는 최대 거리를 계산한 결과 20 m였다. 여기에 추적 등이 용이하도록 10 m 여분을 두어 30 m를 최대 탐색 거리로 설정하였다. 30 m 전방에 설치된 5 m 높이의 물체의 위치를 영상에 투영하여 Fig. 10과 같은 ROI(Region Of Interest)를 설정하였다.

7.2 단계별 파라미터 설정 및 성능평가

실험을 통하여 각 단계 별 파라미터를 설정하고 성능을 평가하였다. Table 3은 각 단계까지의 성능을 표로 정리한 것으로, 코너 검출 단계는 3번 DB의 코너에 대해서 평가하였고 나머지 단계는 3번 DB의 표지판에 대해서 평가하였다. 각 단계를 적용할수록 Recall은 유지하면서 Precision을 높일 수 있도록 튜닝하였다. 특히, 표지판 후보 생성과 표지판 검증 단계에서 Precision이 큰 폭으로 증가했음을 알 수 있다.

코너 검출기는 Open CV의 물체 검출기 라이브러리를 사용하였으며,27) 4종류의 코너 각각에 대해서 별도의 검출기를 학습하였다. 모든 종류의 코너를 하나의 검출기로 검출하는 방법도 고려하였으나, Precision이 너무 낮아 제외하였다. 이것은 4종류의 코너를 모두 Positive 샘플에 포함할 경우, 상하나 좌우 에지(Edge)가 강한 모든 패치(Patch)를 Positive로 오인식하는 경향이 생기기 때문인 것으로 보인다. 코너 GT(Ground Truth)는 수동으로 입력하고, 코너를 중심으로 표지판 높이의 12 % 크기의 패치를 획득하여 24×24 크기로 정규화하였다. 학습에는 1, 2번 DB의 18,439개의 코너가 사용되었고(패치 크기를 0.9, 1.1배로 변경한 패치도 포함), 평가에는 3번 DB의 3,328개의 코너가 사용되었다. 각 코너 종류별 검출기는 약 4,600개의 Positive 샘플과 8,000개의 Negative 샘플로 학습되었다.

코너 검출 단계가 Cascade 구조의 초기 단계인 점을 고려하여 Precision이 다소 낮더라도 Recall이 높도록 튜닝하였다. 패치 내 배경의 비율을 결정하기 위하여, 50 %, 25 %, 10 %, 0 % 다섯 가지 경우(Fig. 11 참조)에 대해서 평가한 결과, 25 %인 경우가 가장 성능이 우수하였다. 이것은 표지판의 수직, 수평 에지를 포함하면서도 배경을 너무 많이 포함하지 않아서 코너 비슷한 구조를 가질 수 있는 배경(예를 들면, 나뭇잎, 방음벽 등)의 영향을 최소화한 것이라고 볼 수 있다. 코너 검출기의 특징으로 Haar와 LBP(Local Binary Pattern)28)을 비교한 결과, LBP가 Recall과 Precision 모두에서 더 우수한 것으로 나타났다. 또한, LBP의 수행시간이 Haar에 비해서 30 % 이상 작은 것으로 나타났다. 따라서, LBP를 특징으로 선택하였다. 이 단계까지의 Recall은 95.13 %, Precision은 25.44 %로 측정되었다.

표지판 후보 생성 관련해서는 1번 DB를 사용하여 Table 1의 파라미터를 학습하고, 3번 DB로 평가하였다. 검출된 표지판과 GT 사이 IOU가 0.5이상인 경우에 제대로 검출된 것으로 판단하였다. 이 단계까지 Recall은 97.60 %, Rrecision은 51.62 %로 측정되었는데, 이것은 코너 검출 단계에 비해서 Precision이 25 % 이상 증가한 것이다. Recall도 조금 증가했는데, 이것은 3개 코너만으로도 표지판 후보를 생성했기 때문이다.

코너 검증을 위한 HOG 관련 파라미터는 다음과 같이 설정하였다: 패치 크기=24×24, 블록 사이즈=16×16, 블록 Stride=8×8, Cell size=8×8, 히스토그램 Bin의 수=9. 결과적으로, 패치 당 144차원의 특징벡터를 계산하였다. SVM 스코어 임계치는 -0.3으로 설정하였다. 학습용 데이터는 개발된 코너 검출기를 1번 DB에 적용하여 얻은 코너를 육안으로 분류하여 사용하였다. 각 코너 종류 별 검증기는 1,500~2,400여개의 Positive 샘플과 500~2,000개의 Negative 샘플로 학습되었다. 학습 샘플을 코너 종류 별 검출기로 획득하여 그 숫자에 큰 차이가 있었다. 이 단계까지 Recall은 97.36 %, Precision은 55.14 %로 측정되었다.

표지판 검증용 HOG-SVM을 학습하기 위하여 표지판 코너 검증 결과인 표지판 후보들을 일정 크기(120×72)의 직사각형으로 정규화하였다. 나머지 HOG 관련 파라미터는 코너 검증 단계와 같이 설정하였다. 학습용 데이터는 개발된 표지판 후보 생성기와 코너 검증기를 1번 DB에 적용하여 얻은 표지판을 육안으로 분류하여 사용하였는데, Positive 샘플의 수는 1,136개였고 Negative 샘플의 수는 1,710개였다. 표지판 통합 단계에서 표지판이 서로 겹쳤는지는 IOU가 0.3이상인지로 평가하였다. 표지판 검증 단계까지의 Recall은 96.03 %, Precision은 91.42 %로 측정되었고, 표지판 통합 단계까지의 Recall은 95.91 %, Precision은 98.64 %로 측정되었다.

Fig. 12는 제안 방법이 다양한 종횡비, 컬러, 안내문구를 가지는 표지판들을 검출할 수 있음을 보여준다. 방음벽이나 나무 등의 배경에 의해 표지판과 배경 간 대비가 떨어지는 상황에서도 표지판을 검출할 수 있었다.

7.3 전체 검출기와 성능 비교

제안 방법을 표지판 전체를 검출하는 방식과 비교하기 위하여, 전체를 검출하는 표지판 검출기를 학습하였다. 1, 2번 DB를 사용하여 학습하고, 3번 DB를 사용하여 평가하였다. 학습 파라미터는 전체표지판을 검출했던 선행연구16)를 따라 설정하였다. 표지판보다 10 % 큰 사각형을 학습하였고, 패치 크기는 48×24로 설정하였다. 결과적으로, Recall은 70.91 %, Precision은 47.66 %로 측정되었다. Fig. 13에서 보는 바와 같이, 종횡비가 다양한 표지판을 한가지 종횡비로 학습할 경우 성능이 제한적임을 알 수 있다.

7.4 코너 추적 관련 실험

코너 추적 단계에서 표지판 사이 연관은 표지판 트랙과 검출된 표지판의 IOU가 0.5이상인지로 평가하였다. 코너 트랙과 검출된 코너 사이 연관은 거리가 임계치 이하인지로 평가하였는데, 이 임계치는 실험적으로 30픽셀로 설정하였다. Fig. 14는 코너 추적기가 다양한 상황에서 표지판의 일부 코너만 보이는 경우에도 성공적으로 코너를 추적할 수 있음을 보여준다.

코너 추적기의 성능을 정량적으로 평가하기 위해서, 3번 DB에서 표지판이 출현하는 이벤트 별로 추적 성공 여부 및 추적을 통해 얼마나 근접한 코너를 검출했는지를 측정하였다. 추적이 성공했는지 여부는 하단 코너가 ROI 내에서 계속적으로 추적되는지 여부를 육안으로 확인하여 평가하였다. 표지판이 등장한 총 53회 이벤트 중에서 다른 표지판 및 차량에 의해 표지판이 가려진 2회를 제외한 51회에 대해서 평가하였다. 평가결과 50회에서 하단 코너를 성공적으로 추적하여, 추적 성공률은 약 98 %로 측정되었다. 어떤 영상에서 표지판이 검출되지 않아도 표지판이 검출되지 않는 회수가 임계치(=3) 이하일 경우 코너 트랙 별 예측치로 코너 정보를 갱신하기 때문에, 이벤트 별 추적 성능이 영상 별 표지판 검출 성능보다 우수하게 나타났다. Fig. 15는 추적이 실패한 경우를 보여주는데, 표지판 하단에 어두운 작은 표지판이 붙어 있는 상황으로 최하단 코너가 검출되지 못했기 때문에 실패로 분류되었다. Table 4는 코너 추적기 적용 여부에 따라 검출 또는 추적 가능한 최대 근접 표지판까지 거리를 비교하였다. 코너 추적기를 적용할 경우, 적용하지 않은 경우에 비해 평균적으로 약 5 m 더 근접한 코너를 검출하는 것을 확인할 수 있었다.

8. 결 론

본 논문은 저가형 센서융합기반 정밀측위시스템을 위해 네 코너를 조합하여 도로표지판을 검출하는 방법을 제안하였다. 코너와 표지판을 외양 기반 방법으로 검증함으로써 Recall 95.91 %, Precision 98.64 %를 달성하였다. 표지판 전체를 검출하는 접근법16)은 검출할 수 없었던 다양한 종횡비의 표지판도 검출할 수 있었고, 기존 코너 기반 방법23,24)론 최하단 코너를 검출할 수 없었던 여러 표지판이 붙은 경우에도 최하단 코너를 검출할 수 있었다. 특히, 원거리에선 표지판을 추적하여 오검출을 최소화하고, 근접거리에선 하단 코너만 추적하여 좀 더 근접한 위치에서의 하단 코너를 활용할 수 있었다.

제안 방법은 표지판의 높이가 설치 규정에 따를 것이라고 가정하고 코너의 3차원 정보를 복원하였다. 추후 MMS(Mobile Mapping System)을 활용해 획득한 영상과 거리 정보를 활용하여 제안 방법의 3차원 정보가 얼마나 정확한지 평가할 예정이다. 이를 근거로, 설치 규정을 활용할 수 있는지, 아니면, 표지판의 높이를 지도에 포함시켜야 하는지를 평가하여, 구축 예정인 디지털 지도의 내용을 제안할 예정이다. 추가적으로, 가상 영상을 활용하여 표지판의 설치 자세, 모양의 변형이 제안 방법에 어떤 영향을 미치는지도 평가하여, 고속도로 관리기관에 표지판 관리 방법을 제안할 예정이다.

Acknowledgments

본 연구는 국토교통부 ‘스마트 자율협력주행 도로시스템 개발’ 연구개발사업의 연구비지원(과제번호 17TLRP-B101406-03)에 의해 수행되었습니다.

References

-

J. Ziegler, P. Bender, M. Schreiber, H. Lategahn, T. Strauss, C. Stiller, T. Dang, U. Franke, N. Appenrodt, C. G. Kelle, E. Kaus, R. G. Herrtwich, C. Rabe, D. Pfeiffer, F. Lindner, F. Stein, F. Erbs, M. Enzweiler, C. Knoppel, J. Hipp, M. Haueis, M. Trepte, C. Brenk, A. Tamke, M. Ghanaat, M. Braun, A. Joos, H. Fritz, H. Mock, M. Hein, and E. Zeeb, “Making Bertha Drive-An Autonomous Journey on a Historic Route”, IEEE Intelligent Transportation Systems Magazine, 6(2), p8-20, (2014).

[https://doi.org/10.1109/MITS.2014.2306552]

-

I. Skog, and P. Handel, “In-Car Positioning and Navigation Technologies - A Survey,”, IEEE Transactions on Intelligent Transportation Systems, 10(1), p4-21, (2009).

[https://doi.org/10.1109/TITS.2008.2011712]

-

N. Alam, and A. G. Dempster, “Cooperative Positioning for Vehicular Networks: Facts and Future”, IEEE Transactions on Intelligent Transportation Systems, 14(4), p1708-1717, (2013).

[https://doi.org/10.1109/TITS.2013.2266339]

- D. S. Yun, and H. S. Yu, “Development of the Optimized Autonomous Navigation Algorithm for the Unmanned Vehicle using Extended Kalman Filter”, Transactions of KSAE, 16(3), p7-14, (2008).

-

J. K. Suhr, J. G. Jang, D. H. Min, and H. G. Jung, “Sensor Fusion-based Low-cost Vehicle Localization System for Complex Urban Environments”, IEEE Transactions on Intelligent Transportation Systems, 18(5), p1078-1086, (2017).

[https://doi.org/10.1109/TITS.2016.2595618]

-

A. Schlichting, and C. Brenner, “Localization Using Automotive Laser Scanners and Local Pattern Matching”, IEEE Intelligent Vehicles Symposium Proceedings, p414-419, (2014).

[https://doi.org/10.1109/IVS.2014.6856460]

-

K. Yoneda, H. Tehrani, T. Ogawa, N. Hukuyama, and S. Mita, “Lidar Scan Feature for Localization with Highly Precise 3-D Map”, IEEE Intelligent Vehicles Symposium Proceedings, p1345-1350, (2014).

[https://doi.org/10.1109/IVS.2014.6856596]

-

A. Y. Hata, and D. F. Wolf, “Feature Detection for Vehicle Localization in Urban Environments Using a Multilayer LIDAR”, IEEE Transactions on Intelligent Transportation Systems, 17(2), p420-429, (2016).

[https://doi.org/10.1109/TITS.2015.2477817]

-

H. Lategahn, and C. Stiller, “City GPS using Stereo Vision”, IEEE International Conference on Vehicular Electronics and Safety, p1-6, (2012).

[https://doi.org/10.1109/ICVES.2012.6294279]

-

J. Ziegler, H. Lategahn, M. Schreiber, C. G. Keller, C. Knoppel, J. Hipp, M. Haueis, and C. Stiller, “Video Based Localization for Bertha”, IEEE Intelligent Vehicles Symposium Proceedings, p1231-1238, (2014).

[https://doi.org/10.1109/IVS.2014.6856560]

-

M. Stübler, J. Wiest, and K. Dietmayer, “Feature- based Mapping and Self-localization for Road Vehicles Using a Single Grayscale Camera”, IEEE Intelligent Vehicles Symposium, p267-272, (2015).

[https://doi.org/10.1109/IVS.2015.7225697]

- M. Schreiber, C. Knöppel, and U. Franke, “Lane- Loc: Lane Marking based Localization Using Highly Accurate Maps,”, IEEE Intelligent Vehicles Symposium, p449-454, (2013).

-

S. Nedevschi, V. Popescu, R. Danescu, T. Marita, and F. Oniga, “Accurate Ego-Vehicle Global Localization at Intersections Through Alignment of Visual Data With Digital Map”, IEEE Transactions on Intelligent Transportation Systems, 14(2), p673-687, (2013).

[https://doi.org/10.1109/TITS.2012.2228191]

-

K. C. Jo, Y. W. Jo, J. K. Suhr, H. G. Jung, and M. H. Sunwoo, “Precise Localization of an Autonomous Car Based on Probabilistic Noise Models of Road Surface Marker Features Using Multiple Cameras”, IEEE Transactions on Intelligent Transportation Systems, 16(6), p3377-3392, (2015).

[https://doi.org/10.1109/TITS.2015.2450738]

-

D. S. Kim, and H. G. Jung, “Road Surface Marking Detection for Sensor Fusion-based Positioning System”, Transactions of KSAE, 22(7), p107-116, (2014).

[https://doi.org/10.7467/KSAE.2014.22.7.107]

- G. H. Jo, J. K. Suhr, and H. G. Jung, “Road Sign Detection based Driving Lane Recognition System”, KSAE Spring Conference Proceedings, p496-501, (2015).

-

P. Viola, and M. Jones, “Robust Real-Time Face Detection”, International Journal of Computer Vision, 57(2), p137-154, (2004).

[https://doi.org/10.1023/B:VISI.0000013087.49260.fb]

-

N. Dalal, and B. Triggs, “Histograms of Oriented Gradients for Human Detection”, IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 1, p886-893, (2005).

[https://doi.org/10.1109/CVPR.2005.177]

-

M. Enzweiler, and D. M. Gavrila, “Monocular Pedestrian Detection: Survey and Experiments”, IEEE Trans. on Pattern Analysis and Machine Intelligence, 31(12), p2179-2195, (2009).

[https://doi.org/10.1109/TPAMI.2008.260]

- Ministry of Land, Infrastructure and Transport, Specification and Installation Method of Road Sign etc., Attached Table 3 in Road Sign Specification, Law of Ministry of Land, Infrastructure and Transport No.294, (2016).

-

A. Mogelmose, M. M. Trivedi, and T. B. Moeslund, “Vision-Based Traffic Sign Detection and Analysis for Intelligent Driver Assistance Systems: Perspectives and Survey”, IEEE Transactions on Intelligent Transportation Systems, 13(4), p1484-1497, (2012).

[https://doi.org/10.1109/TITS.2012.2209421]

-

J. H. Lee, and H. K. Kim, “Lane Positioning in Highways Based on Road-sign Tracking by Kalman Filter”, Transactions of KSAE, 22(3), p50-59, (2014).

[https://doi.org/10.7467/KSAE.2014.22.3.050]

-

T. Wenzel, S. Brueggert, and J. Denzler, “Additional Traffic Sign Detection Using Learned Corner Representations”, IEEE Intelligent Vehicle Symposium, p316-321, (2016).

[https://doi.org/10.1109/IVS.2016.7535404]

-

T. Wenzel, T. -W. Chou, S. Brueggert, and J. Denzler, “From Corners to Rectangles - Directional Road Sign Detection Using Learned Corner Representations”, IEEE Intelligent Vehicles Symposium, p1039-1044, (2017).

[https://doi.org/10.1109/IVS.2017.7995851]

- S. W. Jung, U. H. Lee, J. W. Jung, and H. C. Shim, “Development of Traffic Sign Recognition Algorithm with Deep Convolution Neural Network”, KSAE Spring Conference Proceedings, p1100-1103, (2016).

- H. G. Jung, and J. K. Suhr, “Lane Detectionbased Camera Pose Estimation”, Transactions of KSAE, 23(5), p463-470, (2015).

- OpenCV, Object Detection (objdetect module), http://www.opencv.org (2017).

-

S. Liao, X. Zhu, Z. Lei, L. Zhang, and S. Z. Li, “Learning Multi-scale Block Local Binary Patterns for Face Recognition”, International Conference on Biometrics, p828-837, (2007).

[https://doi.org/10.1007/978-3-540-74549-5_87]