파노라믹 리어뷰를 위한 동적 정합선 결정

Copyright Ⓒ 2017 KSAE

Abstract

A mirrorless vehicle replaces a rear-view mirror and side-view mirrors with a camera monitoring system to show the video footage of a car’s surroundings. These systems mainly take the place of the rear-view mirror with displays that show the rear and the blind spots. Static seam-lines are mostly applied to the camera monitoring system for image synthesis, but its outcomes are vulnerable to unstructured camera arrays. To compensate these defects, we try to move seam-lines to a position where synthesis errors could be minimized. The proposed seam-line determination algorithm comprised of color computation, edge detection, and horizontal-line detection algorithms is used to change the seam-lines’ position. Experiments using three unbalanced camera arrays show that seam-lines appear to avoid cars whenever possible. It is verified that camera monitoring systems can provide a more realistic panoramic rear-view than before.

Keywords:

Mirrorless vehicles, Camera monitoring systems, Dynamic seam-lines, Panoramic rear-view키워드:

미러리스 자동차, 카메라 모니터링 시스템, 동적 정합선, 파노라믹 리어뷰1. 서 론

미국 도로교통 안전국(NHTSA)의 조사에 의하면 대부분의 교통사고는 음주운전, 운전자의 산만함, 그리고 과속운전처럼 운전자의 과실에 의하여 발생된다.1) 운전자 과실에 의한 사고를 미연에 방지하기 위하여 자동차 관련 업체들은 첨단 운전자 보조 시스템(ADAS)에 관련된 연구개발을 지속적으로 진행하고 있다.2,3) ADAS의 대표적인 예로는 차선 이탈 경보 시스템(LDWS), 사각지대 경보(BSW), 충돌 경보 시스템(CWS), 충돌 회피 시스템(CAS), 적응형 순항 제어(ACC), 주차 조향 보조 시스템(SPAS) 등이 있다. 영상 기반의 ADAS 기술은 대부분 차량의 전방, 후방, 측방에 설치된 카메라의 영상을 사용한다. 측방 촬영을 위한 카메라는 사이드 미러, 전방 촬영을 위한 카메라는 라디에이터 그릴이나 전면 유리, 그리고 후방 촬영을 위한 카메라는 뒷면 번호판이나 후면 유리에 장착된다. 미러리스 자동차는 사이드 미러와 리어 미러 대신에 카메라가 설치된 차량이다. ADAS 기술의 발전으로 차량에 장착되는 카메라의 숫자는 증가하지만 촬영된 영상을 보여주는 모니터 개수는 한정적이다. 따라서 하나의 모니터에 여러 개의 영상을 출력하기 위한 영상 합성 기술이 카메라 모니터링 시스템에 접목되었다. 자동차 제조회사인 NISSAN은 1990년대에 영상 합성 기술이 적용된 AVM을 최초로 양산하였다.4) NISSAN의 AVM을 시작으로 영상 합성 기술은 3차원 AVM과 미러리스 자동차를 위한 파노라믹 리어뷰로 발전하였다. 3차원 AVM은 차량 주변의 영상을 그릇모양으로 변형시켜서 운전자에게 기존의 AVM보다 더욱 미려한 영상을 제공하는 방법이다.5,6) 미러리스 자동차를 위한 파노라믹 리어뷰는 BMW 회사의 i8 차량에 장착되어 CES 2016에서 시연되었으며 2017년 현재 양산 차량에 장착되지는 않고 있다.7)

영상 합성 기술은 1980년대에 컴퓨터 비전 분야에서 처음으로 개발되기 시작하였다.8) 영상 합성의 오차는 대부분 원근 투영과 사영 변환에 의하여 발생한다. 사영변환은 카메라가 3차원 피사체를 2차원 영상에 저장하는 방법으로, 이 과정에서 깊이 정보가 사라진다. 사영변환은 3차원 변환에 근간을 두고 있어서 깊이 정보가 없는 2차원 영상에 적용될 때 오차가 발생한다. 컴퓨터 비전 분야에서는 영상의 색상 밀도 정보,9,10) 주파수 도메인 변환,11) 또는 특징점 매칭12-19) 등을 이용하여 이러한 오차를 최소화한다. 하지만 연산량이 많은 이러한 방식들은 실시간 처리가 필요한 ADAS에는 부적절하다. 그러므로 ADAS의 영상 합성 기술로는 오차가 그대로 포함되어 있는 기하학 LUT가 사용된다. 기하학 LUT란 사영변환과 같은 기하학 기반의 변환 방법으로 변환된 영상의 정보가 저장된 데이터를 의미한다. 기하학 LUT 기반의 카메라 모니터링 시스템은 각 영상의 좌표를 옮기는 역할만 수행하기 때문에 실시간 처리에 적합하다.

기하학 LUT를 사용하는 파노라믹 리어뷰의 오차는 정합선과 차량이 겹칠 때 가장 심각하다. 이러한 오차를 최소화하기 위해서 2015년에 Li 등은 차량과 같은 장애물을 회피하는 정합선 검출 방법을 제안하였다.20) 정합 영상 결과는 매우 미려하지만 하나의 정합선을 검출하는데 10초 이상의 시간이 걸리는 단점이 있다. 2017년 Pan 등의 연구에서는 스테레오 카메라를 이용하여 3차원 데이터를 구성하고, 그 정보를 이용하여 정합선 위치를 실시간으로 계산하였다.21) 본 논문에서는 차량 후방에 스테레오 카메라 대신 모노 카메라를 사용하여 정합선을 결정하는 방법을 제안한다. 3차원 데이터를 대신하여 두 영상의 색상 차이, 테두리 검출, 그리고 수평선 검출 알고리즘이 적용되었다. 세 가지 알고리즘은 정합 오차가 최소화 될 수 있는 정합선의 위치를 추정하기 위한 정보를 제공하게 된다.

우리는 검증 실험을 위하여 사이드 미러에 두 대의 카메라와 후면 유리에 한 대의 카메라를 설치하였다. 또한 임베디드 시스템을 구축하여 알고리즘을 포팅하였다.

2. 파노라믹 리어뷰

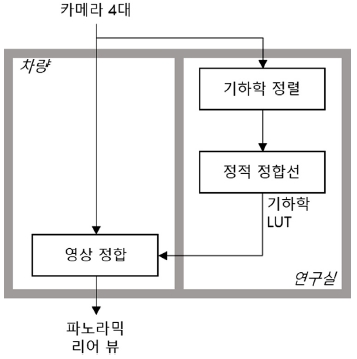

미러리스 자동차는 사이드 미러와 리어 미러를 제거한 차량을 의미한다. 사이드 미러 위치에는 카메라가 설치되어 있으며 리어 미러 위치에는 파노라믹 리어뷰 영상이 출력되는 모니터가 설치되어 있다. Fig. 1은 CES 2016에서 BMW가 공개한 파노라믹 리어뷰이다. BMW i8 차량에는 4대의 카메라가 설치되어 있으며, Fig. 2와 같은 방법으로 영상을 합성한다. 2대의 카메라는 후방 유리에 나란히 설치되어 차량 검출을 위해 사용된다. 나머지 2대는 사이드 미러 위치에 각각 설치되어있다. 정합선 위치는 2군데로 고정되어 있으며 차량과 가능한 겹치지 않는 정합선을 이용하여 영상을 합성한다.

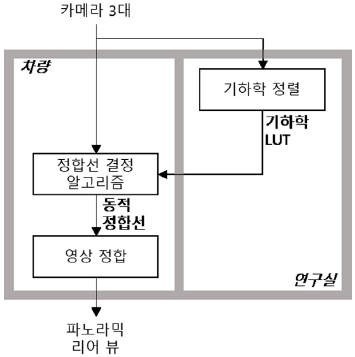

본 논문에서는 후방 유리에 설치된 스테레오 카메라 대신에 단일 카메라를 설치하고 동적 정합선을 적용한 파노라믹 리어뷰를 제안한다. 3대의 카메라에서 촬영된 영상을 합성하기 위해서는 먼저 기하학 정렬 실험이 연구실에서 선행된다. 기하학 정렬은 각기 다른 방향과 각도로 촬영된 영상을 동일한 방향과 각도에서 촬영한 것처럼 변환하여 정렬하는 방법이다. 이 때 변환된 정보는 기하학 LUT에 저장된다. 카메라 모니터링 시스템은 LUT에 저장된 좌표 변환 정보를 이용하여 영상의 좌표 변환을 수행한다. 좌표 변환만 수행하기 때문에 카메라 모니터링 시스템이 부담하는 연산량은 매우 적다. 하지만 LUT만 사용할 경우 정합선이 고정되어있음으로 정합 오차가 발생하게 된다. Fig. 3은 BMW의 파노라믹 리어뷰에서 정합선과 차량이 겹쳤을 경우에 발생하는 오차를 보여주는 사진이다. 우리는 이러한 문제를 해결하기 위해 차량과 정합선이 가능한 겹치지 않도록 하는 정합선 결정 알고리즘을 개발하였다.

Fig. 4는 정합선 결정 알고리즘이 적용된 파노라믹 리어뷰의 흐름도이다. 이 방식은 배경을 검출하고 그 위치를 기준으로 영상이 정합되도록 하는 정합선 결정 알고리즘이 추가되어 있다. 정합선 결정 알고리즘에 의해서 영상의 배경이 변화할 때마다 정합선의 위치도 변경된다. 정합선 위치가 변경되면 정합선이 차량을 회피하여 배경으로 이동하는 것과 같은 효과를 얻을 수 있다.

2.1 기하학 정렬

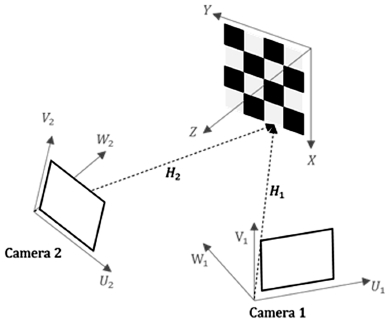

기하학 정렬은 파노라믹 리어뷰의 첫 번째 단계로 Fig. 5처럼 다른 방향과 각도로 촬영된 영상을 동일한 방향과 각도로 촬영한 것처럼 영상들을 변형하여 정렬하는 방법이다. 카메라의 센서와 체커 패턴이 그려있는 평면과의 기하학 관계를 3차원 행렬로 표현할 수 있으며 이를 호모그래피(Homography) 행렬이라 한다. 호모그래피 행렬 H는 식 (1)처럼 크기 변환 S, 회전 변환 R, 그리고 축 이동 T로 표현된다. 여기서 sx, sy, sz는 각 축의 크기 변환 계수, θx, θy, θz는 각 축의 회전 변환 계수, 그리고 tx, ty, tz는 축 이동 계수이다.

| (1) |

| (2) |

| (3) |

| (4) |

| (5) |

| (6) |

| (7) |

본 논문에서는 Zhang이 제안한 방법을 이용하여 호모그래피 행렬을 계산한다.22) 각 카메라의 호모그래피 행렬을 얻으면 동일한 방향과 각도로 촬영한 영상으로 변환할 수 있다. 예를 들어 첫 번째 카메라의 센서를 두 번째 카메라 센서의 방향과 각도로 변환하려면 식 (8)과 같이 수행하면 된다. 여기서 P1, P2는 각 카메라의 3차원 좌표 벡터이고, H1, H2는 각 카메라의 호모그래피 행렬이다. 첫 번째 카메라의 좌표를 체커 페턴이 그려있는 평면으로 변환한 후에 두 번째 카메라의 좌표로 변환하는 방식임으로 H1을 먼저 곱하고 나서 H2의 역행렬을 곱하게 된다.

| (8) |

각 카메라끼리의 변환은 3차원 관계로 되어있지만, 실제 영상은 2차원 데이터이다. 즉, 2차원 영상을 변환하려면 3차원 데이터가 필요함으로 z축 좌표가 모두 1이라고 가정하여 식 (8)을 사용한다. 또한 변환 후에 3차원 데이터를 다시 2차원으로 변환하기 위해서 z축 좌표가 1이 되도록 정규화를 수행하게 된다. 이를 원근투영이라 한다. 즉, 호모그래피 행렬을 이용한 변환은 모든 영상이 z=1인 임의의 평면 상에 있다고 가정했기 때문에 영상 내 z값이 계속 변화하는 차량 주변에서 가장 큰 오차가 발생하게 된다. 반대로 배경의 z값은 주행 중에도 크게 변화하지 않는다. 이러한 이유로 우리는 정합선의 위치가 배경위에 있도록 하는 정합선 결정 알고리즘을 개발하였다.

2.2 정합선 결정 알고리즘

기하학 정렬을 통해서 영상들은 동일한 방향과 각도로 촬영된 것처럼 정렬된다. 영상이 정렬되면 겹치는 영역이 발생하고, 그 영역 내에서 정합선 위치를 결정하여 영상을 정합한다. Fig. 6과 Fig. 7은 파노라믹 리어뷰에서 발생할 수 있는 오차를 보여주는 사진이다. Fig. 6은 입체주의 그림처럼 좌측에는 차량의 정면부, 우측에는 동일 차량의 측면부가 존재하는 사진이며, Fig. 7은 차량이 사라지는 것처럼 보이는 사진이다. 이러한 현상은 차량과 정합선 위치가 겹칠 경우에 나타난다.23) 본 논문에서 제안하는 정합선 결정 알고리즘은 정합선이 배경과 겹치도록 하며, 이는 정합선이 차량을 회피하는 효과를 제공한다.

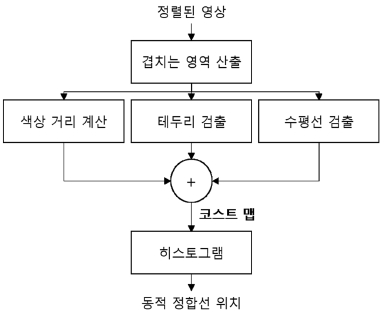

Fig. 8은 정합선 위치가 배경에 오도록 하는 정합선 결정 알고리즘의 흐름도이다. 정합선 결정 알고리즘에 정렬된 영상이 입력되면 먼저 영상이 겹치는 영역을 산출한다. 다음은 그 영역 내에서의 배경을 검출하기 위해 색상 거리 계산, 테두리 검출, 수평선 검출을 수행한다. 히스토그램을 통해 배경 영역 중에서 가장 오차가 적을 수 있는 정합선 위치를 계산한다.

겹치는 영역 내에서 한 쪽 영상은 차량의 정면, 다른 쪽 영상은 차량의 측면인 위치에 정합선이 있으면 Fig. 6과 같은 현상이 발생한다. 또한 한 쪽 영상에는 차량, 다른 쪽 영상에는 노면이 오면 Fig. 7과 같은 오차가 발생한다. 이 경우 두 영상의 색상 차이가 크므로 색상 차이가 적을수록 배경이라고 가정하였다. 또한 영상의 배경에서는 테두리가 없다고 가정하였다. 마지막으로 대부분의 차량은 직사각형으로 표현되기 때문에 수평선이 없는 영역에 정합선이 존재하도록 하였다. 각 픽셀마다 색상차이, 테두리, 수평선의 값을 구하고 더해서 코스트 맵(Cost Map)을 만든다. 코스트 맵의 숫자가 낮을수록 배경일 가능성이 높다. 그러므로 히스토그램을 통해서 코스트 맵 중에 수치가 가장 적은 영역을 산출하여 정합선의 위치로 정한다.

우리는 식 (9)를 통해서 각 픽셀마다의 색상 거리를 계산하였다. 여기서 는 이미지 i와 j의 (m,n) 좌표에서 색상 거리, 은 이미지 i와 j의 (m,n) 좌표에서 빨간색 값의 차이(), G와 B는 각각 녹색과 파란색 값, m=1,...,M은 행(row), n=1,...,N은 열(column)을 의미한다.

| (9) |

테두리 값은 Canny Edge Detector를 사용하여 얻을 수 있다.24) Canny Edge Detector를 사용하면 영상에서 테두리인 곳은 255, 아닌 곳은 0의 값을 구하게 된다. 이미지 i의 (m,n) 좌표에서 테두리 값이 일 때 코스트 맵을 위한 테두리 값 는 0.5가 된다. 수평선 또한 이미지 i와 j의 평균값 0.5로부터 얻을 수 있다. 는 식 (10)과 같은 커널과 콘볼루션(Convolution)을 통해 얻을 수 있다. 수평선 검출을 위한 커널 L의 크기는 2×(2k+1)이다.

| (10) |

테두리 검출과 수평선 검출은 그레이 스케일(Gray Scale) 영상을 사용한다. 각 픽셀의 그레이 스케일 값은 식 (11)을 통해서 얻을 수 있다.

| (11) |

각 픽셀마다 계산된 , 그리고 값을 식 (12)에 대입하여 코스트 맵 를 계산할 수 있다. 수평선은 테두리의 일부분이여서 계수를 각각 0.5로 설정한다. 그리고 , , 는 8비트 값이기 때문에 255를 나누어 정규화한다.

| (12) |

코스트 맵의 히스토그램은 식 (13)을 통해 얻을 수 있다. 여기서 은 코스트 맵 n번째 열의 히스토그램 데이터를 의미한다.

| (13) |

의 값이 작을수록 배경이기 때문에 이 가장 작을 때 n의 값이 동적 정합선이 이동해야 할 좌표가 된다.

2.3 영상 정합

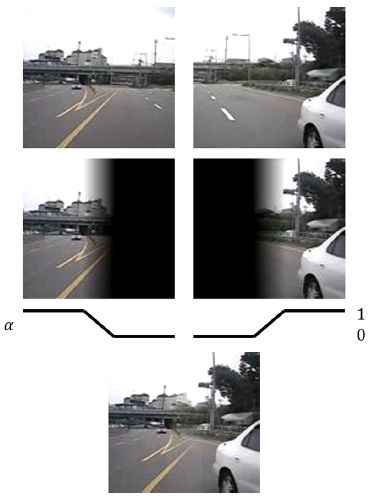

동적 정합선의 위치가 결정되면, 그 위치를 기준으로 영상을 정합한다. 하지만 색상 차이와 같은 여러가지 이유로 정합 영상이 매끄럽지 못할 수 있다. 우리는 정합선을 기준으로 좌우 영상이 매끄럽게 합성되도록 Fig. 9의 알파블렌딩(Alpha-Blending)을 적용했다. 알파블렌딩이란 식 (14)를 이용하여 영상을 정합하는 방법이며, 이때 알파값은 정합선을 기준으로 Fig. 9처럼 변화한다. 여기서 I1과 I2는 두 영상의 픽셀값이며, IB는 두 영상이 합성된 값이다.

| (14) |

알파블렌딩까지 적용된 정합 영상은 미러리스 자동차의 모니터에 출력된다. 정합선이 지속적으로 변경되기 때문에 정합선 결정 알고리즘과 알파블렌딩 알고리즘은 매 프레임마다 수행된다.

3. 실 험

본 논문에서 제안하는 방법을 검증하기 위해서 Fig. 10처럼 현대자동차 아슬란에 3대의 카메라를 설치했다. 중앙 카메라는 후면 유리의 중앙 윗부분에 장착했으며, 좌우측 카메라는 사이드 미러에 장착했다. 카메라의 촬영 방향은 차량의 후면부를 바라보고 있고, 좌우측 카메라는 약 10도정도 틀어서 차량의 외각 쪽을 바라보고 있다. 설치된 카메라의 화각은 약 90도로 동일하다. Fig. 11은 설치된 카메라의 사진이며 Fig. 12는 1280×720 해상도의 취득된 영상이다.

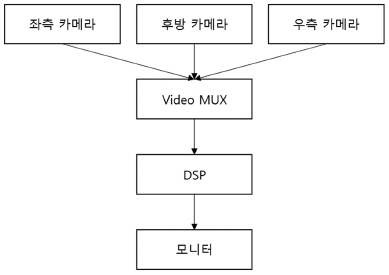

카메라 모니터링 시스템은 Fig. 13처럼 각 영상의 싱크(Sync)를 자동으로 맞춰주는 Video MUX와 알고리즘을 수행하는 DSP로 구성되어 있다. DSP는 FUJITSU 사의 533 MHz CPU를 사용했다. 실험 결과 1장의 영상을 합성하는데 약 92 ms를 소비하였다.

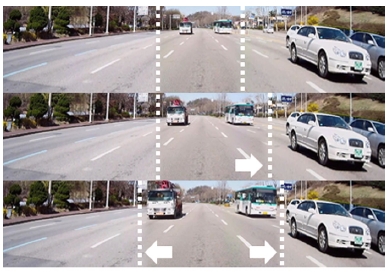

Fig. 14는 정합선 결정 알고리즘이 적용된 파노라믹 리어뷰이며 해상도는 2062×472 픽셀이다. 좌측 정합선은 검은차와 대형 트럭 사이에 있으며, 우측 정합선은 흰색 트럭 사이에 있다. 이는 동적 정합선이 차량과 차량 사이에 있는 배경에 위치한 것이다. 알파블렌딩으로 인하여 동적 정합선 주변으로 차량이 약간씩 희미해져 있는 것을 확인할 수 있다.

Fig. 15는 동적 정합선이 차량을 회피하여 움직이는 현상을 보여주는 사진이다. 좌측 정합선은 3번째 프레임에서 대형 트럭을 회피하기 위해 좌측으로 이동한다. 또한 우측 정합선은 버스를 피해서 우측으로 움직이는 것을 확인할 수 있다. 우리는 실험을 통해서 제안하는 방법이 정합선의 위치를 배경으로 옮겨주는 것을 확인했으며, 이는 정합선이 차량을 피하는 것처럼 보인다.

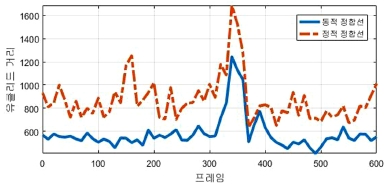

우리는 제안하는 알고리즘과 기존의 정합선이 고정되어 있는 파노라믹 리어 뷰를 비교하기 위해서 도로주행 영상을 취득하였다. 정합선 위치에 존재하는 두 영상의 픽셀들에 대한 유클리드 거리(Euclidean Distance)를 매 프레임마다 계산하였다. 동일한 두 영상의 유클리드 거리는 0이기 때문에 두 영상의 유클리드 거리 값이 작을수록 더욱 미려하게 정합되었다고 가정하였다. 유클리드 거리의 방정식은 식 (15)와 같다. 여기서 는 정합선의 위치인 n번째 열에서 이미지 i와 j의 유클리드 거리, 와 은 이미지 i와 j의 (m,n) 좌표에서의 그레이 스케일 값을 의미한다. 여기서 M은 정합선 길이인 472이다.

| (15) |

Fig. 16은 각 프레임마다 동적 정합선과 정적 정합선의 유클리드 거리를 측정한 결과이다. Table 1을 통해서 제안하는 정적 정합선이 적용된 파노라믹 리어뷰 알고리즘은 동일한 CPU에서 연산 시간이 더 필요하지만, 두 영상의 차이를 의미하는 유클리드 거리는 더 낮은 것을 확인할 수 있다.

4. 결 론

ADAS 기술은 운전자에게 편안하고 안락한 운전 환경을 제공할 뿐만 아니라 발생할 수 있는 각종 사고들을 미연에 방지해준다. 특히 사각지대의 정보를 제공해주는 BSW는 ADAS의 핵심 기술 중 하나이다. BSW를 위하여 후방과 측방에 카메라를 설치하고 카메라 모니터링 시스템을 통해 운전자에게 사각지대까지 촬영된 파노라믹 리어뷰를 제공한다. 실시간 처리가 필요한 차량용 전자 장비이기 때문에 후처리 방식인 기존의 영상 정합 방법을 적용하기에는 많은 문제점이 따른다. 우리는 실시간으로 차량을 회피하는 동적 정합선과 그 위치를 계산해주는 정합선 결정 알고리즘을 개발하여 이러한 문제를 개선하였다. 실험을 통해서 정합선은 대부분 배경에 위치하는 것을 확인했으며, 배경의 위치가 변경되면 그에 따라서 정합선 위치도 변경되었다. 다만 영상 내에서 배경이 없을 경우에는 기존의 영상 정합 오차가 동일하게 발생하였다.

추후 DMA를 적용하여 영상 처리 속도를 증가시킬 계획이며, 또한 정합선 주변부의 색상을 유사하게 변형시키는 색상 보정(Color Balance) 작업도 진행 할 계획이다. DMA와 색상 보정 알고리즘까지 적용된 파노라믹 리어뷰는 BSW와 같이 다양한 ADAS의 핵심 기술로 자리 잡을 수 있을 것이다.

Nomenclature

| ADAS : | advanced driver assistance systems |

| LDWS : | line departure warning systems |

| BSW : | blind spot warning |

| CWS : | collision warning systems |

| CAS : | collision avoidance systems |

| ACC : | adaptive cruise control |

| SPAS : | smart parking assist systems |

| AVM : | around view monitoring |

| LUT : | look-up table |

| DMA : | direct memory access |

References

- The Impact of Driver Inattention on Near-Crach Risk: An Analysis Using the 100-Car Naturalistic Driving Study Data, NHSTA Report, (2006).

- J. Y. Hwang, K. S. Huh, H. M. Na, H. G. Jung, H. J. Kang, and P. J. Yoon, “Development of a Model Based Predictive Controller for Lane Keeping Assistance System”, Transactions of KSAE, Vol.17(No.5), p54-61, (2009).

- H. S. Cha, and S. J. Park, “Driving Assistance Systems Using Wide Angle Lens Camera”, Transactions of KSAE, Vol.17(No.6), p39-46, (2009).

- Around View Monitor by Nissan, http://www.nissan-global.com/EN/TECHNOLOGY/OVERVIEW/avm.html (2017).

-

B. Zhang, V. Appia, I. Pekkucuksen, Y. Liu, A. U. Batur, P. Shastry, S. Liu, S. Sivasankaran, and K. Chitnis, “A Surround View Camera Solution for Embedded Systems”, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, p662-667, (2014).

[https://doi.org/10.1109/cvprw.2014.103]

-

M. Yu, and G. Ma, “360 Surround View System with Parking Guidance”, SAE International Journal of Commercial Vehicles, Vol.7(No.1), p19-24, (2014).

[https://doi.org/10.4271/2014-01-0157]

- Mirrorless Vehicles of BMW, https://www.press.bmwgroup.com/global/article/detail/T0247965EN/bmw-at-the-consumer-electronics-show-ces-2016-in-las-vegas?language=en (2017).

-

A. Rosenfeld, “Image Analysis and Computer Vision: 1988”, Computer Vision, Graphics, and Image Processing, Vol.46(No.2), p196-250, (1989).

[https://doi.org/10.1016/0734-189x(89)90169-2]

-

R. Gupta, and R. Hartley, “Linear Pushbroom Cameras”, IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.19(No.9), p963-975, (1997).

[https://doi.org/10.1109/34.615446]

-

A. Chalechale, G. Naghdy, and A. Mertins, “Sketch-Based Image Matching Using Angular Partitioning”, IEEE Transactions on Systems, Man, and Cybernetics-Part A: Systems and Humans, Vol.35(No.1), p28-41, (2005).

[https://doi.org/10.1109/tsmca.2004.838464]

- B. Srinivasa Reddy, and B. N. Chatterji, “An FFT-Based Technique for Translation, Rotation, and Scale-Invariant Image Registration”, IEEE Transactions on Image Processing, Vol.5(No.8), p1266-1271, (1996).

- C. Harris, and M. Stephens, “A Combined Corner and Edge Detector”, Alvey Vision Conference, Vol.15(No.50), p147-151, (1988).

- J. Sivic, and A. Zisserman, “Video Google: A Text Retrieval Approach to Object Matching in Videos”, Proceeding of the IEEE International Conference on Computer Vision, Vol.2, p1470-1478, (2003).

-

K. Mikolajczyk, and C. Schmid, “A Performance Evaluation of Local Descriptors”, IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.27(No.10), p1615-1630, (2005).

[https://doi.org/10.1109/tpami.2005.188]

- D. Nistér, O. Naroditsky, and J. Bergen, “Visual Odometry for Ground Vehicle Applications”, Journal of Field Robotics, Vol.23(No.1), p3-20, (2006).

-

Q. Zhu, B. Wu, and Z. Xu, “Seed Point Selection Method for Triangle Constrained Image Matching Propagation”, IEEE Geoscience and Remote Sensing Letters, Vol.3(No.2), p207-211, (2006).

[https://doi.org/10.1109/lgrs.2005.861735]

- Y. Zhang, G. Gao, and K. Jia, “A Fast Algorithm for Cylindrical Panoramic Image Based on Feature Points Matching”, Journal of Image and Graphics, Vol.14(No.6), p1188-1193, (2009).

- S. Cao, J. Jiang, G. Zhang, and Y. Yuan, “Multi-Scale Image Mosaic Using Features from Edge”, Journal of Computer Research and Development, Vol.48(No.9), p1788-1793, (2011).

-

M. Zhu, W. Wang, B. Liu, and J. Huang, “Correction: Efficient Video Panoramic Image Stitching Based on an Improved Selection of Harris Corners and a Multiple-Constraint Corner Matching”, PLoS One, Vol.9(No.1), p1-15, (2014).

[https://doi.org/10.1371/annotation/eada5385-44a7-4a4f-aa1b-2194affdf310]

-

L. Li, J. Yao, X. Lu, J. Tu, and J. Shan, “Optimal Seamline Detection for Multiple Image Mosaicking via Graph Cuts”, ISPRS Journal of Photogrammetry and Remote Sensing, Vol.113, p1-16, (2016).

[https://doi.org/10.1016/j.isprsjprs.2015.12.007]

-

J. Pan, V. Appia, J. Villarreal, L. Weaver, and D.-K. Kwon, “Rear-Stitched View Panorama: A Low-Power Embedded Implementation for Smart Rear-View Mirrors on Vehicles”, IEEE Conference on Computer Vision and Pattern Recognition Workshops, p1184-1193, (2017).

[https://doi.org/10.1109/cvprw.2017.157]

-

Z. Zhang, “A Flexible New Technique for Camera Calibration”, IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.22(No.11), p1330-1334, (2000).

[https://doi.org/10.1109/34.888718]

- J. H. Lee, Y. J. You, M. B. Kang, and D. W. Lee, “A Seam-Line Detection Method for Camera Monitoring Systems of Mirrorless Vehicles”, KSAE Spring Conference Proceedings, p634-642, (2017).

-

J. Canny, “A Computational Approach to Edge Detection”, IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.8(No.6), p679-698, (1986).

[https://doi.org/10.1109/tpami.1986.4767851]