다기능 전방 카메라 개발을 위한 영상 DB 구축 방법에 관한 연구

Copyright ⓒ 2017 KSAE

Abstract

This paper addresses the effective and quantitative image DB construction for the development of front looking camera systems. The automotive industry has expanded the capability of front camera solutions that will help ADAS(Advanced Driver Assistance System) applications targeting Euro NCAP function requirements. These safety functions include AEB(Autonomous Emergency Braking), TSR(Traffic Signal Recognition), LDW(Lane Departure Warning) and FCW(Forward Collision Warning). In order to guarantee real road safety performance, the driving image DB logged under various real road conditions should be used to train core object classifiers and verify the function performance of the camera system. However, the driving image DB would entail an invalid and time consuming task without proper guidelines. The standard working procedures and design factors required for each step to build an effective image DB for reliable automotive front looking camera systems are proposed.

Keywords:

Automotive front looking camera system, Driving image DB, ADAS, Design procedure, Image indexing키워드:

자동차용 전방 카메라 시스템, 주행 영상 데이터베이스, 첨단운전자보조시스템, 설계 절차, 영상 색인1. 서 론

최근 Euro NCAP1) 등과 같은 자동차 안전 등급 평가 기관에서 안전도 평가 항목과 요구 성능이 강화되면서 차선 이탈 경보, 전방 충돌 경보, 자동 긴급 제동 등과 같은 안전 주행 기능을 제공할 수 있는 전방 카메라의 수요가 급증하고 있다. 첨단 안전 시스템을 개발하고 있는 기업, 연구소, 대학 등에서는 다기능 전방 카메라용 영상 인식 알고리즘 개발에 투자를 집중하고 있으며, 상용화 수준의 영상 인식 알고리즘을 개발하기 위해서는 각 연구기관들이 대용량 영상 DB를 필수적으로 구축하여야 한다. 자체 영상 DB가 없는 경우, 영상 인식 알고리즘 개발자들은 인터넷에 공개되어 있는 영상 DB2-4)들을 기반으로 알고리즘 개발에 활용할 수도 있지만, 공개된 영상 DB에 포함된 영상들은 각 기업에서 상용화를 위해 개발된 자체 카메라 모듈과는 화각, 영상 화질, 해상도 그리고 프레임 속도 등이 모두 다르기 때문에 공개된 영상 DB만을 가지고는 알고리즘을 최적화 개발할 수 없다. 또한, 공개된 대다수의 영상 DB는 일부 한정된 주행 환경만 녹화되어 있기 때문에 날씨 변화, 조명 변화, 다양한 도로 형태 변화 등이 반영된 알고리즘을 검증할 수도 없다. 지금까지 이러한 문제점을 지적하고 문제점을 극복하기 위한 영상 DB 개발 방법론에 대한 연구는 거의 없었다.5) 또한, 자동차 환경에서 영상 DB의 화질 변화에 가장 밀접한 관계가 있는 이미지 센서의 요구 사항이 매우 엄격하기 때문에 최근까지 자동차용 카메라로 양산된 센서는 Aptina사(On Semiconductor사6)에 인수 합병됨)와 Omnivision사7)의 제품이 양분하고 있다. 특히, 전방 카메라용 이미지 센서는 Aptina사의 제품이 독보적으로 시장을 점유하고 있다. 실제 양산제품 개발 과정에서는 각 기업들은 자체 설계한 카메라 모듈 개발을 완료하고, 개발된 카메라 모듈로 구성된 영상 녹화 시스템이 장착된 실험 차량을 주행하면서 시간/계절/날씨/도로형태/차량거동 등의 변화가 포함된 영상을 녹화하여야 한다. 녹화된 동영상은 영상 프레임마다 영상 내에 포함된 각 요소들(차선, 차량, 보행자, 표지판 등)을 색인하여야 알고리즘 개발에 활용 가능한 최소한의 영상 DB가 될 수 있다. 상용화 알고리즘 개발에 활용 가능한 영상 DB를 구축하기 위해서는 고비용과 오랜 작업 시간이 소요되며, 막대한 자원을 투입하여 영상 DB를 구축하였다 하더라도 활용 단계에서 원하는 데이터의 관리 및 접근이 어렵거나, 실제 자동차 주행 상황을 얼마나 유효성 있게 검증할 수 있는지 판단할 수 없는 경우도 발생할 수 있다. 이러한 시행착오를 방지하기 위해서는 영상 DB 구축에 필요한 표준 작업 프로세스(Process)를 만들고, 각 프로세스에서 요구되는 개발 툴(Tool)들과 설계 인자에 대한 연구가 필요하다.

본 논문에서는 상용화 수준의 다기능 전방 카메라 영상 인식 알고리즘 개발에 필요한 대용량 영상 DB 구축 방법을 제안한다. 2장에서는 전방 카메라 개발에 필요한 시스템 개요와 이미징 모듈(Imaging module)개발 과정을 포함하는 영상 녹화 시스템의 구성에 대해서 설명하고, 3장에서는 주행 영상 DB 녹화를 위한 주행 계획 수립 방법과 영상 DB 개발 환경에 대해 설명하고, 4장에서는 영상 DB에서 영상 속성(Attribute)과 실측값(Ground truth) 입력 방법과 DB의 사용성 측면에서 보완 방안을 설명한다. 5장에서는 알고리즘 성능 평가 및 개선 방법에 대해 설명한다. 마지막으로 6장에서 결론을 제시한다.

2. 전방 카메라 시스템 개요

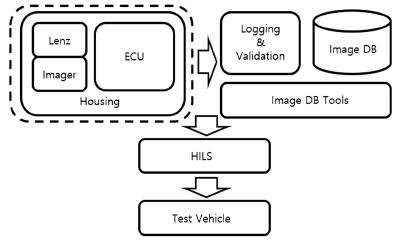

전방 카메라 제품을 개발하기 위해 구성해야 하는 전체 시스템의 구성은 Fig. 1과 같다. 실제로 개발되는 최종 카메라 제품은 좌측의 점선으로 표시된 영역에 한정되지만, 인식 알고리즘의 개발 및 성능 평가를 위해서는 실시간으로 영상 녹화와 성능 평가를 지원하는 평가 보드(Evaluation board)가 개발되어야 하고, 녹화된 영상을 DB로 제작, 관리할 수 있는 소프트웨어 툴(Tool)이 개발되어야 하고, 실제 DB를 저장할 수 있는 서버(Server)가 있어야 한다. 그리고 이러한 시스템을 장착하여 성능 평가를 할 수 있는 HILS(Hardware In the Loop Simulation) 시스템과 테스트 차량의 개발이 필요하다.

2.1 렌즈 설계

렌즈 설계에서 고려해야 할 주요 항목은 FoV (Field of View), 렌즈 왜곡, MTF(Modulation Transfer Function), 상대 조도, CRA(Chief Ray Angle), EFL (Equivalent Focal Length) 등이다. 렌즈를 포함한 이미징 모듈에서 설계의 관점은 사람의 시각으로 평가되는 화질이 아니라, 배경과 관심 영역을 분리하거나 물체의 특징점을 추출하기 위한 영상 처리 알고리즘에서 요구되는 최적화 인자가 되어야 한다는 것이다. 하지만, 다기능 카메라 시스템에서는 각 기능마다 요구되는 영상 화질의 특성이 상반되는 경우가 발생한다. 예를 들어 차선 인식 기능의 경우는 수평 화각은 좁고 초점 거리는 최대한 원거리까지 맞추어야 하나, 보행자 인식 기능의 경우는 수평 화각은 넓고 초점 거리는 근거리로 맞추어야 한다. 결국, 다기능 카메라 시스템에서는 특정 기능에 최적화된 렌즈 설계 인자로 최적화할 수 없으며, 각 기능별로 요구되는 대립 인자를 상호 보완하여 설계해야 한다. 일반적으로 다양한 실제 도로 주행 영상을 DB로 취득하고 색인된 영상 DB를 기반으로 인식 알고리즘을 개발하고 성능을 고도화한다. 만일, 대용량 영상 DB를 모두 구축한 이후 렌즈 특성의 부적합에 기인하여 신뢰성 있는 카메라 기능을 구현할 수 없다는 것이 판명된다면, 렌즈를 재설계하고 영상 DB를 다시 구축해야 하는 개발 일정과 자원의 낭비를 초래하게 된다. 따라서 모든 알고리즘이 요구하는 최소한의 렌즈 성능을 검증한 이후에 영상 DB 구축을 시작하여야 하며, 적정 수준의 알고리즘 검증 단계 영상 DB를 취득하여 향후 카메라 알고리즘의 개선만으로 각 알고리즘의 목표 성능 구현이 가능하다는 판단 지표를 근거로 대용량 영상 DB 구축 작업을 실행해야 한다.

2.2 이미지 센서 설계

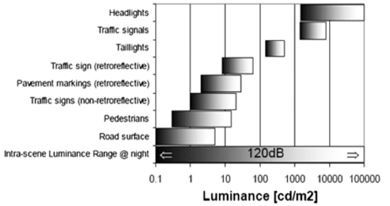

자동긴급제동과 같은 기능을 안전하게 구현하기 위해서는 가능한 빠른 영상 프레임 처리 속도가 요구된다. 각 영상 처리 알고리즘에 필요한 노출 모드(Exposure mode)가 상반된 조건을 요구하는 경우가 발생하므로 서로 다른 노출 모드를 자동 변경하는 기능이 지원되어야 하며, 최소 2개 이상의 독립적인 노출 모드별로 초당 30 프레임 처리속도(Frame per second : fps)를 제공하기 위해서는 전체 영상 프레임 처리속도는 60 fps 이상의 전송 속도가 필요하다. 또한, 주행 중 급격하게 변화하는 조명 변화와 다양한 대상 물체의 반사 특징에 강인한 화질의 영상을 취득하기 위해서는 최소 120 dB 이상의 명암비(Dynamic range)도 요구된다. Fig. 2는 전방 카메라가 감지해야 하는 대표적인 대상 물체별 휘도(Luminance) 특성 영역을 표시하였다.

2.1절에서 각 알고리즘의 성능 확보가 가능한 렌즈 설계가 완료된 이후에 대용량 영상 DB 구축을 착수해야 한다는 점을 지적한 바와 같이 이미지 센서의 레지스터 설정(Register setting)과 노출 모드에 대한 프레임 제어로직(Frame control logic) 설계로 각 알고리즘의 목표 성능 확보가 가능하다는 검증이 완료된 이후에 영상 DB 구축을 진행해야 한다.

2.3 영상 녹화 및 검증 인터페이스 장치

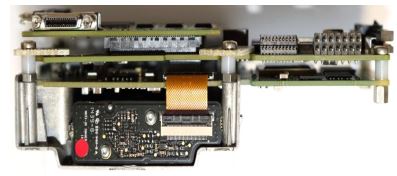

개발하려는 전방 카메라시스템을 이용하여 실차 환경에서 주행 영상을 실시간으로 취득하기 위해서는 차량 탑재가 가능한 영상 DB DAQ(Data Acquisition) 시스템의 개발이 필요하다. 통상적으로 영상 DB DAQ 시스템은 메인 콘트롤러 모듈과 HD급 해상도의 영상 데이터를 고속으로 전송하기 위한 프로세싱 보드, 차량 내부의 센서를 통해 거동정보 취득을 위한 CAN I/F 보드, 자차의 전역 위치 정보 수집을 위한 GPS 모듈, 그리고 취득된 영상정보 및 차량거동/위치 정보 저장을 위한 대용량 저장장치(HDD) 모듈 등으로 구성된다. 대다수의 연구기관들은 자동차부품연구원에 구축된 시스템8),9)과 같이 표준 상용 장비를 이용하여 DAQ시스템을 구성하고 있다. 그러나 목적하는 카메라 시스템의 영상 포맷, 컬러 좌표계, 해상도, 프레임 속도 등의 특성에 최적화된 DAQ 시스템을 자체적으로 설계하여, 개발자가 필요한 모든 기능을 구현하면서도 초소형, 경량화 가능한 확장보드 형태로 개발하는 것도 고려할 수 있다. Fig. 3은 국내 자동차 부품업체인 M사에서 독자 다기능 전방카메라 개발을 위해 별도로 개발한 영상DB DAQ 시스템의 사례이다.

3. 영상 DB 개발

영상 DB는 단순히 도로 주행영상을 녹화만 하는 것이 아니라 녹화된 영상 프레임마다 영상 내에 포함된 각 관심 물체들(차선, 차량, 보행자, 표지판 등)의 실측값(종류, 위치, 크기, 색상, 품질 등)을 색인하여 필요한 정보만 선택적으로 확인하고, 누적된 색인 정보에 대한 통계 지표가 직관적으로 표시되는 기능 등이 포함되어야 활용 가능한 최소한의 영상 DB가 될 수 있다. 한편, 신뢰성 있는 카메라 알고리즘 개발이 가능한 수준의 영상 DB를 구축하기 위해서는 막대한 비용과 인력 자원이 투입되어야 하기에 투입 자원을 최소화하고 단기간에 DB 구축이 가능하도록 주행 영상 녹화 계획을 수립하며, 대용량 영상 DB를 편리하게 저장하고 활용할 수 있는 효율적인 데이터 서버 환경 구축이 필요하다.

3.1 영상 녹화 계획

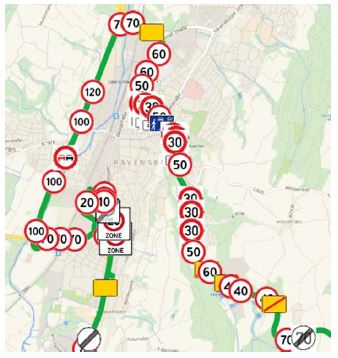

알고리즘의 개발 및 성능 평가를 위해 촬영 장면(Scene)에 대한 요구사항 분석을 수행한다. 요구 사항 분석에서는 다기능 카메라 알고리즘 개발에 공통적으로 반영되는 화질 변화 요소를 우선 고려한다. 조명 변화에 의한 카메라 입력 화질에 영향을 주는 계절, 시간, 날씨 변화를 포함하고, 장면의 복잡도에 영향을 주는 도로 환경(도심로, 자동차 전용도로, 일반국도, 지방도로 등)을 포함한다. 카메라의 영상 취득 속도에 영향을 주는 자차의 주행 속도 변화도 반영한다. 다음은 다기능 카메라의 각 기능별로 필요한 변화 요소를 고려한다. 차량 검출(Vehicle detection) 알고리즘의 경우는 다양한 차종, 차속과 위치변화가 녹화되어야 하며, 차선 검출(Lane detection) 알고리즘의 경우는 모든 차선의 종류가 포함되어야 한다. 상대 차량의 차종과 상대 속도는 사전 계획에 포함될 수 없는 변화 요소이므로 다양한 차량 종류가 촬영될 가능성이 높은 이동 경로를 선택하여 녹화를 한다. 도로 표지판 인식(Traffic sign recognition)알고리즘도 다양한 표지판의 종류가 필요한 개수만큼 녹화되어야 한다. 차선, 표지판의 종류는 사전에 설치 위치 정보를 입수하여 경로 계획을 수립함으로써, 최단의 경로 주행으로 최대한 많은 대상 장면을 녹화하기 위한 경로 계획을 수립한다. 독일 남부의 농촌도로에서 속도 제한 표지판의 위치 정보를 근거로 경로 계획을 세운 예제를 Fig. 4에 나타내었다.

3.2 영상 DB 개발 환경

도로 주행영상 녹화가 완료되면 녹화된 영상은 DB 서버 시스템으로 저장한다. 영상 DB 서버 시스템은 단순 저장의 기능뿐 아니라, 영상의 속성 (Attribute)을 분석하고, 분석된 결과를 개발자가 이해하기 쉬운 형태로 보여주는 기능까지 포함되어야 한다. 이 단계부터 영상 데이터는 비용과 개발 일정이 투입된 연구 자산이므로 단전, 침수, 지진 등과 같은 천재지변에도 훼손을 막을 수 있고, 시스템 오류, 사이버 해킹 등의 위험 요소에도 안전하게 보관될 수 있는 데이터센터 시설에 보관된다. 특히, 글로벌 시장을 목표로 개발되는 제품은 특정 국가의 환경에 국한되지 않고, 북미, 유럽, 아시아 등 전 세계에 흩어진 도로에서 취득된 영상 DB가 중앙 데이터 센터로 고속 네트워크를 통해 전송될 필요가 있다.

영상에 대한 속성은 녹화된 지역과 일시, 도로 조건, 날씨 조건, 주행 거리 등과 같은 영상에 대한 일반 속성과 녹화된 영상에서 각 장면마다 관심 내용에 해당되는 실측값(Ground Truth : GT)이 속성값으로 입력되어야 한다. GT 데이터는 그 자체만으로도 방대한 크기를 가지는 데이터이므로 빠른 검색이 가능해야 하고, 개별 인식 알고리즘의 구조 및 방법론과 밀접하게 관련되어 있으므로 GT 속성을 위한 데이터 구조 설계에 대한 연구가 필요하다. GT 속성에 대해서는 제4장에서 상세하게 서술하기로 한다. 도로 영상을 녹화한 원본 데이터와 영상 속성 데이터는 서로 동기화되어 관리된다.

지금까지 설명된 영상 DB는 알고리즘 성능을 육성하는 과정에서 새로이 추가되거나 삭제 또는 변경되면서 완성도가 높은 DB로 개발된다. DB 자체를 튜닝하면서 완성도롤 높이고, 특정 장면에 대한 알고리즘 성능 평가 등을 수행하기 위해서 영상 스트리밍(Streaming) 또는 단위 프레임별로 원본 영상과 속성 데이터를 빠르게 검색하는 기능이 필요하다.

또한, 보고서, 기술문서 등의 작성을 위해 영상 속성별로 통계 그래프와 표를 자동으로 생성하는 기능까지 구현할 수 있다. 도로 환경, 주행 거리, 날씨, 노면 상태 등의 속성별로 통계 결과를 자동으로 생성되도록 만들 수 있다.

4. 영상 DB 구성

다음은 제3장에서 설명된 영상 DB의 일반 속성 이외에 영상 프레임마다 관심 물체에 대한 GT 속성을 입력하는 방법에 대해 설명한다. GT 속성은 개발되는 알고리즘에 따라 추출되어야 하는 정보가 결정되므로 최적 해법을 제시할 수는 없기 때문에 일반적인 학습기반 영상인식 알고리즘에서 요구되는 공통 속성을 제시한다.

한편, 도로 주행영상으로 확보가 어려운 장면이지만, 알고리즘 개발이나 성능평가에 필요한 장면의 경우에 한정해서 모의 영상 DB를 생성해서 사용하는 방안에 대해서도 설명한다.

4.1 GT 입력방법

다기능 카메라 알고리즘은 학습 기반 알고리즘과 특징점 기반 알고리즘으로 구분되어진다. 학습 기반 알고리즘은 영상 DB의 GT 속성을 기준으로 지도학습(Supervised learning) 방법을 통해서 물체 분류기(Classifier)를 구현한다. 그리고 학습에 사용되지 않았던 나머지 영상들은 GT 속성을 기준으로 영상 DB 기반 성능 평가에 이용된다. 반면에, 특징점 기반 알고리즘은 학습을 할 필요가 없으므로 영상 DB는 성능평가 용도로만 사용된다.

차선검출은 일반적으로 특징점 기반 알고리즘으로 구현된다. 이때, 차선의 GT 속성은 노면 표시와 신호에 대한 비엔나 협약10)에 명시된 차선의 형태에 의한 분류(실선, 복선, 점선, 실선과점선, 지그재그선), 색상에 의한 분류(백색, 황색, 청색 등)를 GT 속성으로 입력한다. 또한, 자차를 기준으로 왼쪽과 오른쪽 차선을 구분해야하고, 차선의 노후화나 환경적 요인에 의한 품질을 구분할 필요도 있으며, 가드레일(Guard rail), 연석, 교차선, 사선, 돌출형 차선(Botts' dots) 등과 같이 준차선 역할을 하는 속성을 입력해서 성능평가에 사용한다.

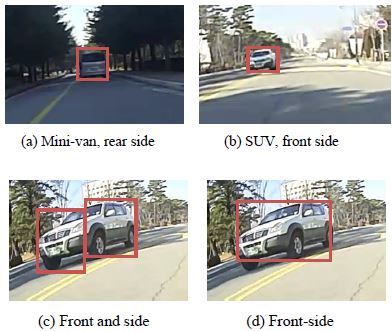

차량검출은 기본적으로 선행차량의 후방 영역을 속성으로 입력한다. 하지만, 카메라 기능의 필요에 의해서 반대편 차선에 있는 대항차량의 앞면 영역도 속성으로 입력할 수 있다. 실제 카메라에서 차량 영상을 녹화하는 과정에서는 관심 차량의 후방과 전방 영역만 보이는 것이 아니라, 측방 영역도 동시에 보이는 경우도 발생된다. 이때, 측방 영역을 무시하고 전/후방 영역만 GT로 입력할 것인지, 측방 영역을 별도로 GT로 입력할 것인지, 아니면 측후방 또는 측전방 영역을 하나의 영역으로 처리할 것인지도 알고리즘 개발 방향에 맞게 결정해야 한다. 차량 영역의 크기와 위치에 대한 GT 입력 예제를 Fig. 5에 보였다. 차량의 특정 영역을 GT 속성으로 입력하는 경우, 입력하고자 하는 차량 영역이 주변 차량 또는 다른 도로 요소에 의해 일부 가리워지는 경우가 존재한다. 가리워진 경우는 영상 DB에서 제외할 것인지, 가리워진 영역을 GT 속성으로 기록할 것인지도 설계 시에 결정되어야 한다. 또한, 차종(승용차, 승합차, 소형/대형트럭, 버스, 특수차 등)도 GT 속성에 포함될 수 있다. 특수한 상황으로 화물이 적재된 대형 트럭의 후방 영역은 차량 자체 모습보다 적재된 화물의 모습이 GT 영상에서 지배적인 차량 후방 영역으로 나타나게 된다.

교통표지판은 표지판의 위치검출과 검출된 표지판의 의미를 인식하는 문제로 나뉜다. 현재는 ADAS 기능에서 속도제한표시만을 인식하는 기능으로 양산되고 있으나, 앞으로 부분 자율주행, 완전 자율주행을 위해서는 인식할 표지판의 종류가 대폭 확대될 필요가 있다. 최근에 LED 표지판이 기존의 교통표지판과 병행되어 설치되고 있어서 LED 표지판 여부가 GT 속성으로 기록되어야 한다. 유럽의 독일에서는 마을의 진입과 진출을 표시하는 사각형 표지판이 50 km 속도제한의 의미를 내포하고 있기 때문에 GT로 기록하고 인식 대상에도 포함되어야 한다. 유럽지역에는 대형차의 후미부에 속도제한표시 스티커가 부착되어 있어서 도로변에 설치된 속도제한표지판과 구분되어 GT 속성으로 기록되어야 한다. 다음은 교통표지판의품질 특성을 기록한다. Fig. 6에는 GT 특성으로 기록되어야 하는 가로수나 건물 부착물에 의한 가리워짐, 오염, 비정상적인 비틀림 또는 회전각도 등의 사례를 보였다.

본 논문에서는 차선검출, 차량검출, 교통표지판인식 등 3개 기능에 대해서 GT 입력 방법을 검토하였다. 양산 수준의 실차 신뢰성을 확보하기 위한 DB의 크기는 최소 수백시간 이상, 수만 km 이상의 거리를 주행한 영상이 필요하다. 이렇게 방대한 영상 데이터를 대상으로 지금까지 언급된 GT 속성을 모두 수동으로 입력한다면 방대한 레이블링 인력과 시간이 요구된다. 단순 반복 작업이 지속되면 작업자의 집중도 저하가 발생하기 때문에, 이에 따른 레이블링 품질의 불균일도 관리되어야 한다. 레이블링 속도를 개선하고, 품질을 균일하게 유지하기 위해서는 GT 속성 레이블링 작업을 자동화할 필요가 있다. 자동화가 쉬운 단순한 영상은 레이블링 Tool을 개발하여 자동 입력하고, 자동 입력에 실패한 영상 데이터만을 대상으로 수동으로 교정하는 개발환경이 구축되어야 신뢰성이 보장된 DB를 신속하게 확보할 수 있다.

4.2 영상 DB 보완 방법

영상 DB는 실차 주행 영상을 기준으로 제작된다. 하지만, 실차주행 영상으로 확보하기 어려운 상황도 존재한다. 예를 들어, 실험하고자 하는 속성(날씨, 조명, 자차속, 등)만 바꾸어서 정확하게 똑같은 주행환경을 반복해서 촬영할 수 없고, 사고의 위험성이 높은 상황이나, 실제 사고 상황을 의도적으로 연출하여 촬영하는 것도 불가능하다. 다음은 실차 영상 획득의 효율성 문제를 고려해야 한다. 속도제한표지판의 경우 특정도로에서 출현 빈도의 차이가 매우 크다. 고속도로에서는 100 km, 110 km 속도제한표지판의 빈도가 높고, 일반도로에서는 60 km, 80 km 표지판의 빈도가 높다. 반면에 10 km, 20 km와 같은 표지판의 설치 빈도는 매우 낮다. 출현 빈도가 낮은 속도표지판을 실차영상으로 다수 확보하기 위해서는 불필요한 장거리 주행이 수반된다. 즉, 도로 교통법에 의해 존재가 가능한 모든 속도제한표지판을 동일한 빈도로 영상 DB를 구축하는 것은 거의 불가능하다. 이러한 실차 주행 영상 획득의 문제점을 개선하기 위해 영상처리 기술을 이용하는 보완책을 제시한다. 첫째는 합성영상(Synthetic image)을 생성하는 방법이다. 합성영상은 실차 영상을 기준으로 원하는 속성만을 영상처리 알고리즘으로 변경하여 DB로 만드는 데이터이다. 주변 환경 조명(Ambient light)을 조정하거나, 교통표지판의 뒤틀림, 오염의 정도 등을 인위적으로 생성할 수 있다. 실차 영상에서는 빈도가 부족한 차선, 차량 또는 표지판을 일부 변형하여 새로운 데이터로 생성하여 인위적으로 빈도를 증가시킬 수도 있다. 생성된 DB는 알고리즘 학습용과 성능평가 용도로 모두 고려될 수 있다.

두 번째는 가상영상(Simulated image) 데이터이다. 컴퓨터그래픽스 기술을 이용하여 실차 영상에서는 취득이 불가능하거나 가상 환경이 실제 환경보다 실험하기에 효율적인 경우 사용을 고려할 수 있다. 실제 영상이 아니므로 학습용 데이터로는 사용하지 않은 것이 좋다. 합성영상과 가상영상은 GT 속성을 모델 기반으로 생성하기 때문에 영상을 쉽게 생성할 수 있고, GT색인을 할 필요도 없어서 영상 DB를 쉽고 빠르게 확장할 수 있는 장점이 있다. 실제 도로에서는 속도제한표지판이 낮은 빈도로 출현하기 때문에 짧은 주행 구간에서 다수의 인식 성능 평가를 수행할 수 없다. 하지만, Fig. 7과 같이 가상영상에서 속도제한표지판을 짧은 구간에서 반복적으로 생성한다면 짧은 주행 구간에서도 다수의 성능 평가가 가능하다.

5. 알고리즘 성능평가 방법

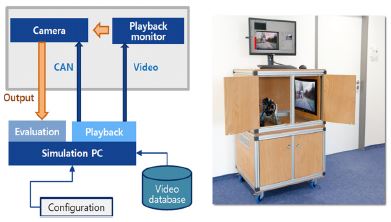

실제 주행 영상이 녹화된 영상 DB 기반의 알고리즘 성능평가는 SILS(Software In the Loop Simulation)와 HILS(Hardware In the Loop Simulation) 평가가 있다. SILS는 단위 알고리즘의 성능평가를 실시하고, HILS는 통합 카메라 시스템 차원의 평가가 진행된다. 영상 DB 기반의 평가가 완료된 이후에는 시스템 요구사항이 명시하는 PG(Proving Ground) 평가를 실시하고, 마지막으로 공로에서 실차 평가가 이루어진다. PG 평가는 대상 차량과의 정확한 거리, 차선 변경의 위치 등 물리적인 계측이 필요한 환경에서 카메라 기능의 동작 여부를 평가할 수 있고, 실차 평가는 임의로 발생되는 실제 주행 상황에서 카메라 성능을 평가한다. 본 논문에서는 완성차업체의 양산 개발 노하우가 포함된 PG 평가와 실차 평가는 제외하고, SILS와 HILS 평가에 대해서만 설명한다. SILS는 전방카메라 알고리즘의 설계 검증을 목적으로 ECU 시제품을 제작하기 전 단계에서 실제 ECU를 사용하지 않고 평가하는 방법이다. 소프트웨어를 PC 상에서 실행하고 카메라를 통한 영상 입력을 대신하여 영상 DB에 녹화된 실차 영상을 메모리를 통한 입력으로 사용하고, 차량 모델과의 인터페이스만 구현하여 소프트웨어 설계 결과를 검증한다. HILS는 실제 ECU를 사용하며, 실제 차량 대신 가상의 차량 모델이나 엔진 모델로 평가하는 수법이다. 실제 ECU를 사용하기 때문에 카메라를 통한 영상 입력이 가능한 환경이 필요하다. Fig. 8은 영상 DB에 저장된 실차 영상을 모니터에서 재생하고 카메라 ECU가 모니터 영상을 입력으로 사용하는 HILS의 블록도와 실제 사진을 보였다. 시뮬레이션 PC는 영상 DB를 모니터에 재생함과 동시에 카메라 ECU에서 출력되는 인식 결과를 입력받아서 성능평가도 가능하도록 구현되었다.

6. 결 론

본 논문은 신뢰성 있는 전방 카메라 영상 인식 알고리즘 개발에 필요한 대용량 영상 DB 구축 방법을 제안하였다. 영상 데이터 녹화를 착수하기 이전에 고려되어야 할 카메라 이미징 모듈의 설계 방법에 대해서 설명하였고, 주행 영상 녹화를 위한 주행 계획 수립과 영상 DB 저장 및 개발 환경에 대해 설명하였다. 다음에는 영상 DB에서 영상 속성과 GT 입력 방법과 DB의 사용성 측면에서 보완 방안도 제시하였다. 마지막에는 영상 DB 기반으로 알고리즘과 카메라 시스템 성능을 평가할 수 있는 SILS와 HILS 시스템 구현 방법에 대해서 설명하였다.

향후, 제안하는 영상 DB 개발 방법론에 의해 구축된 DB를 기반으로 전방카메라용 차선, 차량, 보행자, 교통표지판 등의 ADAS 알고리즘 성능 평가에 대한 연구가 진행될 예정이며, 자율주행자동차 개발에 대한 관심이 고조되면서 점차 필요성이 요구되고 있는 AVM(Around View Monitoring) 카메라에서 장애물 인식을 위한 영상 DB 개발 방법론을 포함하여, 카메라 설계사양, 장착위치, 측정도로 종류, 알고리즘 성능, 데이터 수집 국가, 운전자 패턴, 주행시간, 차량절대위치 등 모든 정보를 포함한 빅데이터 구축방안에 대해서도 연구될 예정이다.

Acknowledgments

이 논문은 2015년 충북대학교 학술연구지원사업과 미래창조과학부 IT・SW 융합산업 원천기술 개발 사업(No. R7117-16-0164, 차량통신 기반의 광역 주행환경인지 및 협조주행기술 개발)의 지원으로 수행되었으며, 이에 깊은 감사의 뜻을 표합니다.

References

- Euro NCAP 2020 Roadmap Revision 1, http://www.euroncap.com/en/for-engineers/technical-papers/ (2015).

- The KITTI Vision Benchmark Suite, http://www.cvlibs.net/datasets/kitti/ (2016).

- The German Traffic Sign Recognition Benchmark, http://benchmark.ini.rub.de/?section=gtsrb&subsection=dataset (2015).

- Daimler Pedestrian Benchmark Dataset, http://www.gavrila.net/Datasets/Daimler_Pedestrian_Benchmark_D/daimler_pedestrian_benchmark_d.html (2013).

- K. Kim, “A Method of Establish DB to Use Mono Camera based Lane Detection & Vehicle Detection”, IEIE Annual Conference Proceedings, p579-582, (2012).

- On Semiconductor, Automotive Application, http://www.onsemi.com/PowerSolutions/appDiagram.do?appId=131 (2016).

- Omnivision, Applications, Automotive Imaging, http://www.ovt.com/applications/application.php?id=7 (2016).

- H. J. Noh, J. W. Lee, D. J. Lim, and J. K. Lee, “The Research of Constructing the Real-world Image Data Base for Verifying the Function and Recognition Rate of ADAS Based on Image Sensor”, KSAE Annual Conference Proceedings, p1398-1402, (2012).

- H. J. Noh, J. W. Lee, D. J. Lim, and J. K. Lee, “The Research of Constructing and Operating the Real-world Image Data Base for Verifying the Recognition Rate of ADAS Based Image Sensor”, KSAE Annual Conference Proceedings, p1095, (2013).

- Convention on Road Signs and Signals, http://www.unece.org/fileadmin/DAM/trans/conventn/signalse.pdf (1995).