가상환경 내 자율주행 차량 데이터 취득을 위한 CARLA 기반 테스트 시나리오 제안

Copyright Ⓒ 2024 KSAE / 220-02

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

The advancement of autonomous vehicles relies on the integration of various techniques, including communication strategies. Since autonomous vehicles are directly connected to ensuring human safety, it is important to test their reliability. However, setting up testing environments in the real world can be excessively costly. To address these challenges, we are proposing extensive testing within virtual simulation environments. We will employ the 3GPP(3rd Generation Partnership Project) document’s scenario definitions as a reference to create a virtual environment by utilizing the CARLA simulation platform. In this study, we will be presenting various vehicle driving patterns and sensor data. The data will be obtained not only from the vehicle, but also from the RSU(Road Side Unit) attached at the junction.

Keywords:

Autonomous vehicle, CARLA, RSU, Test scenario, Virtual environment키워드:

자율주행 차량, 카를라, 노변 기지국, 평가 시나리오, 가상환경1. 서 론

자율주행 기술의 지속적인 발전은 우리의 교통 환경을 보다 안전하고 효율적으로 전환할 전망이다. 하지만 운전자의 개입 없이 지속적인 안전성을 위해서는 자율주행 기술에 대한 신뢰성이 보장되어야 한다. 이러한 신뢰성을 보장하고 차량에 장착된 센서의 인식범위 한계를 극복할 목적으로 차량과 다른 차량 혹은 기반 시설과의 통신을 수행하는 기술이 필요하다.1) 이를 위해 V2X(Vehicle to everything) 통신 기술 활용의 필요성이 제기되었으며 많은 연구가 3GPP(3rd generation partnership project)에서 제공한 통신표준을 사용하여 연구를 진행하고 있다.2-4) 3GPP는 모바일 광대역 통신표준 개발을 위한 기관으로써 여러 통신표준에 대해서 제공하고 있으며, V2X를 위한 통신 표준과 평가를 위한 시나리오도 제공하고 있다.5)

자율주행 기술은 신뢰성이 중요하므로 다양한 주행환경과 상황을 대표하면서 위험 요소를 포함하는 평가 시나리오의 선정이 중요하다. 이러한 시나리오를 실제 도로에서 수집하기 위해 사고 영상이나 교통정보 수집용 카메라를 통하여 데이터셋으로 제작한 연구가 진행되었다.6,7) 하지만, 실제 도로 상황은 다양한 변수에 의해 예측하기 어려운 상황이 수시로 발생하며 테스트를 위한 기반 시설을 구축하는 것은 상당한 비용과 위험 상황을 구현하는 데 현실적인 제약이 존재한다. 따라서 특정 기술을 검증하기 위해 반복적으로 실행할 수 있는 가상환경을 사용하는 것은 매우 중요하다.8)

이에 따라 현재 많은 차량 가상환경 시뮬레이션 프로그램이 개발되어 있다. 그중에서 CARLA(Car learning to act)는 자율주행 시스템의 개발, 훈련 및 검증을 지원하기 위해 개발된 가상환경 시뮬레이션으로, 오픈 소스로 되어 있어 접근성이 뛰어나고 사용자의 편의에 따라 유연하게 설정을 변경할 수 있다. 이를 통해 사용자가 원하는 시나리오를 쉽게 제작할 수 있다.9)

본 논문에서는 3GPP에서 제시한 시나리오 정의를 기반으로 5계층의 시나리오 표현 포맷을 정의하는 독일의 Pegasus 프로젝트의 포맷에 따라 시나리오를 정의하였다.10) 여러 가지 도로 주행 상황의 데이터를 수집하기 위해 다양한 운전 스타일을 가지는 주변 차량을 배치하였고, 교차로에 추가 센서를 부착하여 인지 범위 향상을 위한 데이터를 제공하였다. 마지막으로, 제작한 가상환경의 접근성을 위해 오픈소스 프로그램인 CARLA를 사용하였다.

2. 3GPP 시나리오

3GPP는 V2X 시나리오에서의 통신 성능 평가와 서비스 요구사항을 충족하기 위해 크게 군집 주행, 첨단 주행, 센서 확장, 원격 주행 4가지의 시나리오를 다음과 같이 정의하고 있다.5)

- 1) 군집 주행: 차량이 역동적으로 그룹을 형성할 수 있게 하여 같은 간격을 두고 주행하는 기술

- 2) 첨단 주행: 차량 및 RSU(Road Side Unit)로부터 수집된 센서 데이터를 주변 차량과 공유를 통해 최적화된 이동 경로를 생성하고, 각 차량의 주행 계획을 주변 차량에 전달하여 안정성과 교통 효율성을 향상하는 기술

- 3) 센서 확장: 차량 및 RSU로부터 수집된 센서 데이터를 주변 차량과 공유함으로써 차량이 보유한 센서가 측정할 수 있는 범위를 넘어서 인지할 수 있도록 하는 기술

- 4) 원격 주행: 스스로 운전할 수 없는 승객이나 위험한 환경에 있는 원격 차량을 위해 원격 운전자나 V2X 어플리케이션이 운행할 수 있도록 하는 기술

제시된 시나리오 정의는 도로에서 발생할 수 있는 상황보다는 각각의 기술에 필요한 통신 요구사항을 중심으로 기술되어 있다. 이 중 여러 대의 차량이 협력적으로 움직이는 군집 주행을 제외한 나머지 세 시나리오는 단독 주행 상황에서 발생할 수 있는 이벤트들을 위한 것이다. 그러므로 이 세 가지 시나리오는 실제 도로 상황에서 동시에 또는 연속적으로 적용될 수 있어 가상환경에서 이들을 구별하여 구현하는 것은 어려움이 있다. 이러한 점을 고려하여 본 논문에서 3가지(첨단 주행, 센서 확장, 원격 주행) 시나리오는 통합하여 단독 주행 시나리오로 작성하였다.

2.1 군집 주행

3GPP의 군집 주행 정의와 더불어 군집 내에 존재하는 차량은 선두 차량으로부터 주기적인 데이터를 수신한다. 선두 차량은 군집 내의 존재하는 차량의 상태를 실시간으로 인지하고 모니터링해야 하며 군집의 협력 주행을 위한 제어 메시지를 보내야 한다.11)

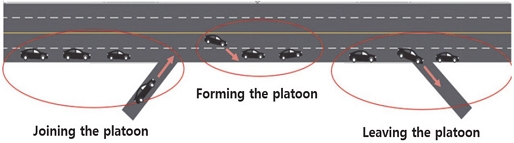

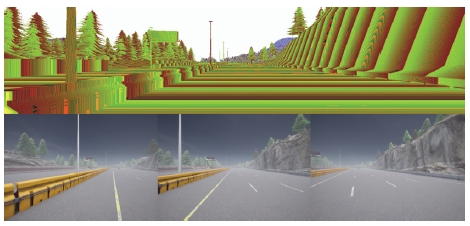

또한, 군집 내에 존재하는 차들은 선두 차량의 제어 명령만 받는 것이 아니라 상호 간 데이터를 공유할 수도 있다. 예를 들어, Fig. 1과 같이 고속도로 주행 상황에서 군집 주행을 적용할 수 있는 다양한 주행 패턴이 존재한다.

- 1) 합류 도로에서 새로운 차량이 군집에 합류하기 위해 선두 차량이 되는 패턴

- 2) 분기 도로에서 군집에서 이탈하는 패턴

- 3) 직진 주행 중 새로운 군집이 형성되는 패턴

1, 3번 패턴과 같이 합류 및 이탈 도로에서 군집이 형성된 후에 새로운 차량이 합류하거나 기존 차량이 군집에서 안전하게 이탈하기 위해서는 가장 가까운 차량에 경고를 보내면서 동시에 주행을 방해하지 않아야 한다. 이는 대부분 V2V 방식으로 군집 내의 각 차량은 위치, 속도, 가속도, 감속 등의 상태 정보를 공유하며 선두 차량을 결정해야 한다.12,13)

2.2 단독 주행 시나리오

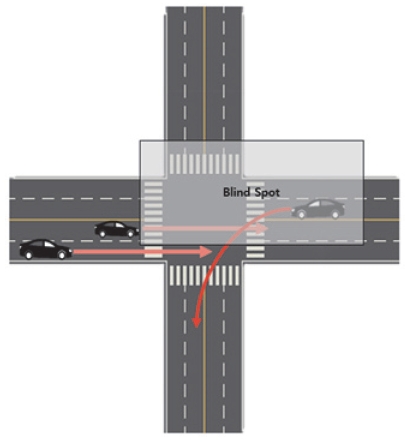

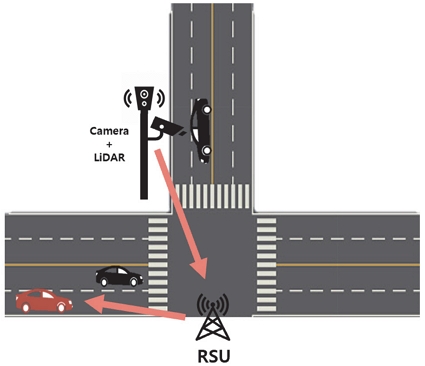

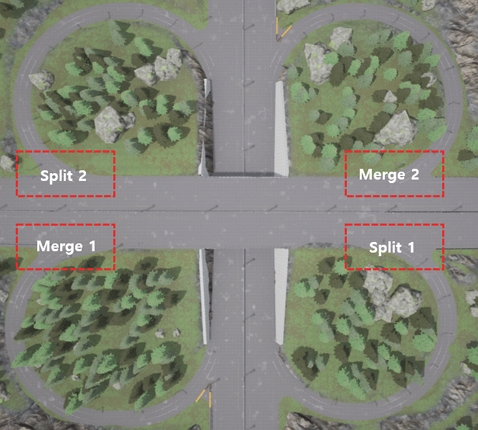

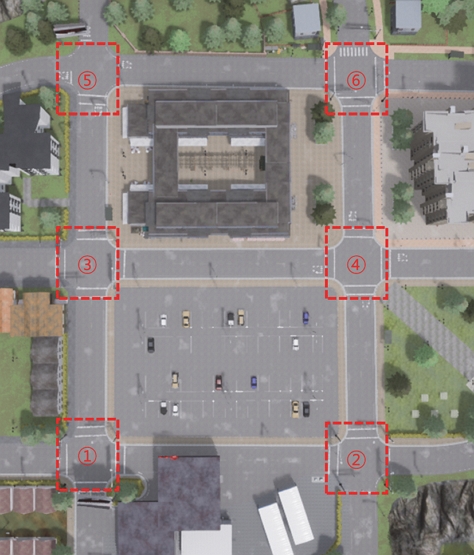

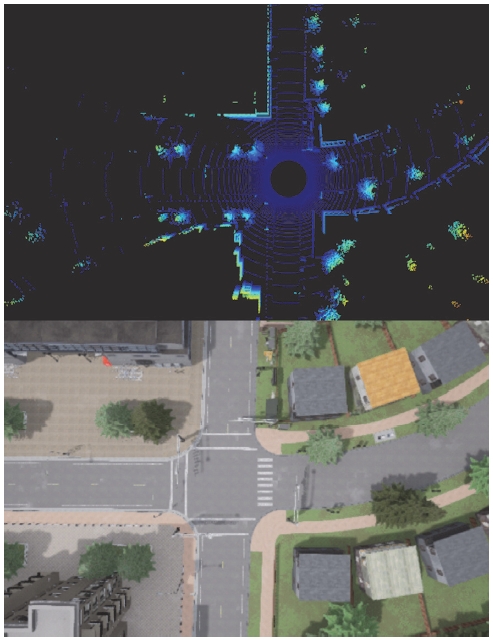

앞서 언급한 바와 같이 첨단 주행, 센서 확장, 원격 주행 세 가지 시나리오는 같은 교통 상황에서 다르게 적용될 수 있다. 십자 교차로에서 발생할 수 있는 상황을 예로 들면, 첨단 주행은 교차로에서 꼬리물기 현상과 도로 혼잡도를 감소시키기 위해 주변 차량 데이터를 RSU로 수집하고, 차량의 미래 상태를 예측하여 차량 흐름을 개선하는 방식으로 적용될 수 있다.14,15) 센서 확장의 경우, Fig. 2에서 사각지대에서 발생할 수 있는 접촉 사고를 피하려고 Fig. 3과 같이 교차로에 설치된 LiDAR와 Camera를 사용하여 AR 화면을 제공하여 운전자에게 위험을 알려주거나, 주변 차량의 객체 정보를 가지고 와 활용하는 연구를 예시로 들 수 있다.16,17) 마지막으로, 원격 주행에서는 차량과 원격 주행 주체와의 타임 지연 최소화가 중요하기 때문에, 교차로에서 차량이 밀집하는 경우 리소스를 분배하는 로드 밸런싱 기술이 필요하다.18)

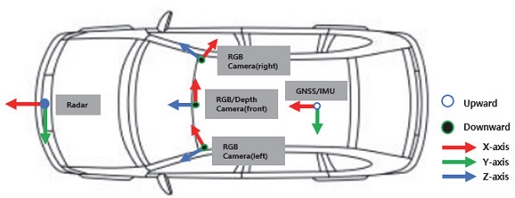

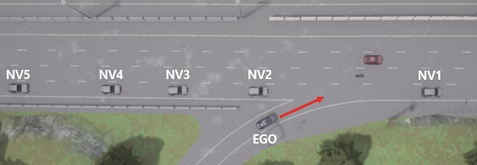

3. 3GPP 시나리오 기반 데이터 취득 환경 제작

제작된 시나리오 데이터 취득 환경은 다양한 도로 상황의 구현을 위해 직선도로뿐만 아니라 합류 및 분기 여러 개의 교차로를 제공하는 “Town 04” 맵을 선정하였다. 주행 중에 발생할 수 있는 다양한 상황에 대한 데이터를 얻기 위해서 Ego Vehicle을 제외한 일부 차량에 신호를 무시하거나 다른 차량과 안전거리를 유지하지 않고 충돌하는 행동이 발생할 확률을 30 %로 설정하고 제한 속도에 120 %까지 주행할 수 있게 설정하였다. Ego vehicle은 이러한 상황에서 데이터를 취득할 수 있도록 Fig. 4와 같이 센서들을 구성하였다. Fig. 5와 같이 넓은 시야각을 확보하기 위해 RGB 카메라 3대와 Depth 카메라 1대를 설치하였다. 추가로, 전방에 물체를 인식하기 위한 Radar 1대, 차량의 상태 정보를 얻기 위한 GNSS와 IMU를 각각 1대씩 장착하였다. Table 1은 차량의 중심을 기준으로 센서들의 상대적인 거리와 각도를 나타낸다.

3.1 군집 주행 시나리오

군집 주행 시나리오는 Fig. 6과 같이 합류 도로 2개와 분리도로 2개를 선정하여 사용자의 선택에 따라 4개 중 1개를 선택하여 실행될 수 있도록 하였다. 시나리오 계층은 Table 2와 같으며 계층 1은 주행 도로에 관한 속성이다. 계층 2는 신호등과 같은 기반 시설과 관련된 계층으로 군집 주행 시나리오에서는 고속도로 상황에서 합류 및 분리를 가정하여 고려하지 않았다. 계층 3은 계층 1과 계층 2에서 발생할 수 있는 변수나 일시적인 변화로 시나리오에서는 제외하였다. 계층 4에서는 시나리오에 영향을 미치는 객체들로 군집이 형성된 상태로 주행하는 차량을 5대로 설정하여 최소 3 m의 안전거리를 유지하도록 하였다. 마지막으로 계층 5에서는 사용자의 선택에 따라 날씨를 설정할 수 있도록 하였다.

3.2 단독 주행 시나리오

다양한 도로 상황을 구현하기 위하여 Fig. 8과 같이 도심 도로를 표현한 곳을 선정하였다. 시나리오 계층 중 계층 3과 계층 5는 군집 주행과 같고 그 이외에는 Table 3에 표시되어있다. 계층 1에서 모든 도로가 차선을 2개 사용하는 것은 같으나 길이는 위치에 따라 다르다. 계층 2에서는 신호등은 Fig. 8 기준 1, 3, 4, 6가 표시된 교차로에 존재하고 인지 향상을 위해 설치한 LiDAR는 모든 교차로에 설치하였다. 계층 4에서 도로 혼잡도를 표시할 수 있는 NV(Neighboring vehicle)의 수와 도로에서 위험도를 높일 수 있는 공격적인 주행 패턴의 차량의 수를 사용자가 수정할 수 있게 하였다.

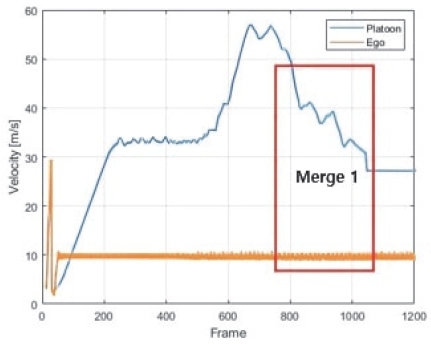

Fig. 10은 군집주행 시나리오 중 Merge 1에서 합류 상황이 발생했을 때 각각 군집과 Ego 차량의 속도를 나타낸다. 군집 내 차량은 최대 60 km/h로 속도로 주행하다가 Ego 차량이 Merge 1에 도달하는 순간부터 자동으로 감속함을 확인할 수 있다.

4. 결 론

본 논문에서는 3GPP에서 정의한 시나리오를 기반으로 5계층의 표현 포맷에 따라 시나리오 데이터 취득 환경을 CARLA에서 구현하였다. 3GPP에서 정의한 시나리오는 통신 기술에 따른 요구 조건을 평가지표로 분류하였기에 같은 상황에서 여러 시나리오가 적용될 수 있었다. 따라서 첨단 주행, 센서 확장, 원격 주행 3가지 시나리오들은 통합하여 같은 환경에서 사용자의 편의에 따라 기술을 적용할 수 있도록 하였다. 또한, 실제 도로 환경의 끊임없는 다양한 변수와 위험 상황을 재현하기 위하여 다양한 운전 패턴을 가지 차량을 만들어 제공하였다. 구현에 있어 모든 변수를 고려할 수는 없었기 때문에 모든 상황에는 대응할 수 없는 한계를 가진다. 또한, 수집된 센서 데이터들은 이상적인 값이 측정되기 때문에 실제 주행 상황에서 얻은 값과 같지 않다. 그러므로 제공한 가상환경 데이터를 사용하여 기술을 평가할 때 위와 같은 한계를 고려하여 평가할 필요가 있다.

Subscripts

| 3GPP : | 3rd generation partnership project |

| RSU : | roadside unit |

| UEs : | user equipments |

| CARLA : | car learning to act |

| V2X : | vehicle to everything |

| NV : | neighboring vehicle |

Acknowledgments

이 논문은 2022년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구임(No.2022-0-01053, 다중 통신기술 네트워크 로드밸런싱 기술개발).

References

-

S. Hakak, T. R. Gadekallu, P. K. R. Maddikunta, S. P. Ramu, Parimala M, C. D. Alwis and M. Liyanage, “Autonomous Vehicles in 5G and Beyond: A Survey,” Vehicular Communications, Vol.39, 2022.

[https://doi.org/10.1016/j.vehcom.2022.100551]

-

M. M. Saad, M. A. Tariq, J. Seo and D. Kim, “An Overview of 3GPP Release 17 & 18 Advancements in the Context of V2X Technology,” International Conference on Artificial Intelligence in Information and Communication(ICAIIC), pp.57-62, 2023.

[https://doi.org/10.1109/ICAIIC57133.2023.10067121]

-

M. J. Khan, M. A. Khan, S. Malik, P. Kulkarni, N. Alkaabi, O. Ullah, H. El-Sayed, A. Ahmed and S. Turaev, “Advancing C-V2X for Level 5 Autonomous Driving from the Perspective of 3GPP Standards,” Sensors, Vol.23, No.4, pp.2261, 2023.

[https://doi.org/10.3390/s23042261]

-

M. J. Khan, M. A. Khan, A. Beg, S. Malik and H. El-Sayed, “An Overview of the 3GPP Identified Use Cases for V2X Services,” Procedia Computer Science, Vol.198, pp.750-756, 2022.

[https://doi.org/10.1016/j.procs.2021.12.317]

- 3GPP, “Service Requirements for Enhanced V2X Scenarios,” Technical Specification 22.186, 3rd Generation Partnership Project(3GPP), 2019.

-

W. Bao, Q. Yu and Y. Kong, “Uncertainty-Based Traffic Accident Anticipation with Spatio-temporal Relational Learning,” Proceedings of the 28th ACM International Conference on Multimedia, pp.2682-2690, 2020.

[https://doi.org/10.1145/3394171.3413827]

-

A. P. Shah, J. B Lamare, T. Nguyen-Anh and A. Hauptmann, “CADP: A Novel Dataset for CCTV Traffic Camera Based Accident Analysis,” 15th IEEE International Conference on Advanced Video and Signal Based Surveillance(AVSS), pp.1-9, 2018.

[https://doi.org/10.1109/AVSS.2018.8639160]

-

J. Hou, Q. Chen, Y. Cheng, G. Chen, X. Xue, T. Zeng and J. Pu, “SUPS: A Simulated Underground Parking Scenario Dataset for Autonomous Driving,” IEEE 25th International Conference on Intelligent Transportation Systems(ITSC), pp.2265-2271, 2022.

[https://doi.org/10.1109/ITSC55140.2022.9922031]

- Computer Vision Center, CARLA, https://carla.org, , 2023.

-

S. Park, J. So, H. Ko, H. Jeong and I. Yun, “Development of Safety Evaluation Scenarios for Autonomous Vehicle Tests Using 5-Layer Format(Case of the Community Road),” The Journal of The Korea Institute of Intelligent Transport Systems, Vol.18, No.2, pp.114-128, 2019.

[https://doi.org/10.12815/kits.2019.18.2.114]

-

A. Vinel, L. Lan and N. Lyamin, “Vehicle-to-vehicle Communication in C-ACC/Platooning Scenarios,” IEEE Communications Magazine, Vol.53, No.8, pp.192-197, 2015.

[https://doi.org/10.1109/MCOM.2015.7180527]

-

A. Alalewi, I. Dayoub and S. Cherkaoui, “On 5G-V2X Use Cases and Enabling Technologies: A Comprehensive Survey,” IEEE Access, Vol.9, pp.107710-107737, 2021.

[https://doi.org/10.1109/ACCESS.2021.3100472]

-

D. Jia, K. Lu, J. Wang, X. Zhang and X. Shen, “A Survey on Platoon-Based Vehicular Cyber-Physical Systems,” IEEE Communications Surveys & Tutorials, Vol.18, No.1, pp.263-284, 2015.

[https://doi.org/10.1109/COMST.2015.2410831]

- S. Oh, S. Youn, S. Choi, H. Han, K. Kim, K. Choi, D. Kim, S. Yoon and S. Kang, “Intersection Traffic Blockage Prevention Using CARLA and Edge Computing,” KICS Summer Conference Proceedings, pp.1817-1818, 2022.

- S. Oh, S. Youn, S. Choi and S. Yoon, “Improved Emergency Vehicle Driving Scenarios Using Vehicle Sensors in the CARLA Simulator,” Autumn Annual Conference of IEIE, pp.363-365, 2022.

-

K. Maruta, M. Takizawa, R. Fukatsu, Y. Wang, Z. Li and K. Sakaguchi, “Blind-Spot Visualization via AR Glasses Using Millimeter-Wave V2X for Safe Driving,” IEEE 94th Vehicular Technology Conference(VTC2021-Fall), pp.1-5, 2021.

[https://doi.org/10.1109/VTC2021-Fall52928.2021.9625498]

-

Z. Xiao, J. Shu, H. Jiang, G. Min, J. Liang and A. Iyengar, “Toward Collaborative Occlusion-free Perception in Connected Autonomous Vehicles,” IEEE Transactions on Mobile Computing, pp.1-13, 2023.

[https://doi.org/10.1109/TMC.2023.3298643]

-

L. Liu, B. Chen, W. Ma, H. Chen, M. Gao, W. Shao, J. Wu, L. Peng and P. Ho, “Selective Resource Offloading in Cloud-edge Elastic Optical Networks,” Journal of Lightwave Technology, Vol.41, No.20, pp.6431-6445, 2023.

[https://doi.org/10.1109/JLT.2023.3288391]