자율주행용 임베디드 플랫폼 탑재를 위한 YOLOv4 기반 객체탐지 경량화 모델 개발

; Ju-Hyung Lim1)

; Ju-Hyung Lim1) ; Young-Wan Jang1)

; Young-Wan Jang1) ; JiHwan You2)

; JiHwan You2) ; SeonTaek Oh2)

; SeonTaek Oh2) ; Young-Keun Kim*, 1)

; Young-Keun Kim*, 1)

Copyright Ⓒ 2021 KSAE / 191-09

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

The latest CNN-based object detection models are quite accurate, but they require a high-performance GPU to run in real-time. For an embedded system with limited memory space, they are still are heavy in terms of memory size and speed. Since the object detection for autonomous system is run on an embedded processor, it is preferable to compress the detection network as light as possible while preserving detection accuracy. There are several popular lightweight detection models; however, their accuracy is too low for safe driving applications. Therefore, this paper proposes YOffleNet, a new object detection model that is compressed at a high ratio while minimizing the accuracy loss for real-time and safe driving application on an autonomous system. The backbone network architecture is based on YOLOv4, but we could significantly compress the network by replacing the high-calculation-load CSP DenseNet with the lighter modules of ShuffleNet. Experiments with KITTI dataset showed that the proposed YOffleNet is compressed by 4.7 times than the YOLOv4-s that could achieve as fast as 32 FPS on an embedded GPU system(NVIDIA Jetson AGX Xavier). When compared to the high compression ratio, the accuracy is reduced slightly to 85.8 % mAP, which is only 3.6 % lower than YOLOv4-s. As a result, the proposed network showed a high potential for deployment on the embedded system of the autonomous system for real-time and accurate object detection applications.

Keywords:

Compressed CNN, Compressed object detection, Autonomous driving, Embedded GPU, YOLOv4키워드:

경량화 CNN 모델, 경량화 객체탐지, 자율주행, 임베디드 GPU1. 서 론

자율주행자동차는 운전자의 편의를 증대할 수 있는 미래 교통수단으로 주목받고 있으며 미래 산업 시장에서 큰 파급 효과를 줄 것으로 예상된다.1,2) 자율주행 실현을 위한 핵심 기술은 크게 인지, 판단, 제어 세 부분으로 나뉜다. 이 중에서 최근 딥러닝을 활용한 객체탐지 기술의 발전으로 인해 주행 중 사물을 인식하는 인지 분야에서 큰 도약이 이뤄지고 있다.

영상 데이터를 통한 딥러닝 기반 객체탐지 알고리즘은 사람의 시각을 통한 검출보다 더 높은 인식률을 보이고 있다. 특별히, 영상 데이터의 경우 라이다 센서에 비해 저렴한 카메라 센서를 통해 데이터를 획득 가능하기 때문에 자율주행자동차의 인지 분야에서 딥러닝을 활용한 객체탐지 알고리즘의 중요도는 점점 증가하고 있다.

딥러닝 기반 객체탐지 알고리즘은 높은 연산 복잡도가 요구되기에 차량의 센서에서 얻은 데이터를 클라우드 서버에 전송하여 처리하는 방식에 의존하고 있다. 그러나 클라우드 컴퓨팅 방식은 해킹에 취약하고 통신망이 구축되지 않은 지역에서는 자율주행이 불가능하다는 한계점을 지닌다.3) 이러한 문제점을 개선하기 위해 임베디드 환경에서 자율주행에 필요한 연산을 처리하는 엣지(Edge) 컴퓨팅 기술이 요구되고 있다.4) 임베디드 플랫폼에서 딥러닝 기반의 객체탐지 알고리즘이 실시간으로 구동되기 위해서는 한정된 자원에서 동작할 수 있는 경량화된 모델 사이즈를 보유해야 한다. 대표적인 딥러닝 기반 객체탐지 모델인 YOLO, SSD의 경우에도 임베디드 플랫폼에 적용하기에는 모델의 크기가 크고 추론 속도가 느린 한계를 지니고 있다. 이러한 문제를 해결하기 위해서는 정확도 손실을 최소화하면서, 임베디드 시스템에서도 동작 가능한 정도로 모델의 크기를 줄일 수 있는 딥러닝 모델 경량화에 관한 연구가 필수적이다.25-31)

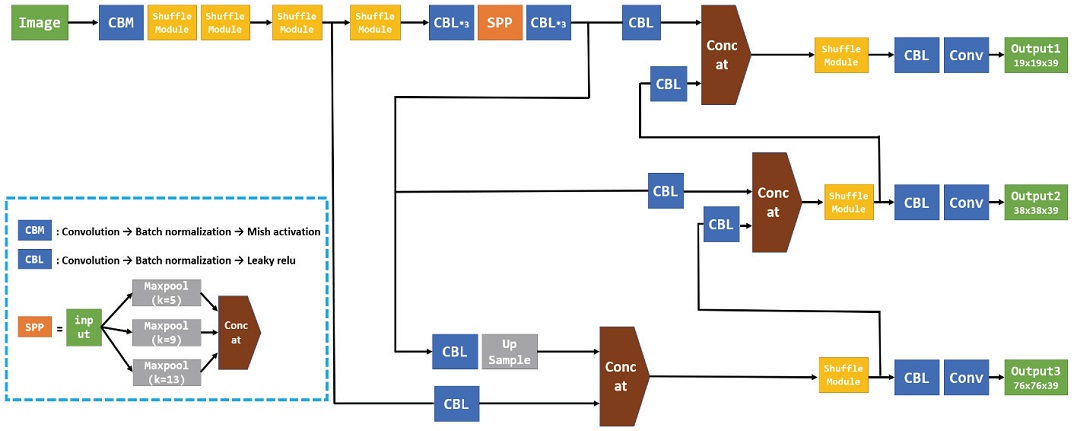

본 연구에서는 자율주행용 임베디드 플랫폼에 탑재 가능한 딥러닝 객체탐지 모델인 YOffleNet을 제안한다. YOffleNet은 대표적인 객체탐지 모델인 YOLOv4의 아키텍처를 기반으로 한다. Backbone Network에서는 CSP DenseNet으로 구성된 CSPDarkent53을 ShuffleNetv2 모듈로 변경하여 파라미터 수를 감소시켰으며, 정보흐름에 이점을 주는 ShuffleNetv2 모듈의 특성을 고려해 Neck 부분의 PANet 구조를 간소화하는 경량화를 진행했다. Head 부분에서는 YOLOv4의 단일단계 검출기 방식을 활용했다.

본 연구에서 제안하는 객체탐지 모델인 YOffleNet의 성능 측정을 위해 대표적인 자율주행 데이터셋인 KITTI 데이터셋을 통해 차량, 보행자, 사이클리스트 클래스에 대한 학습 및 평가를 진행했다. 또한, 임베디드 플랫폼에서의 탑재 적합성을 확인하기 위해 NVIDIA Jetson AGX Xavier 보드와 NVIDIA Jetson Nano 보드에 학습한 모델을 탑재하여 성능 검증을 진행했다. 실험 결과 제안하는 YOffleNet 모델은 85.8의 mAP와 1.9 M의 파라미터 수를 보유하였으며, YOLOv4-s 대비 3.7 낮은 mAP를 가졌으나 파라미터 수는 4.8배 적은 것을 확인했다. 또한, Nvidia AGX Xavier보드에서 32 FPS로 구동되는 것을 확인했기에 한정된 자원을 지닌 자율주행용 임베디드 플랫폼 환경에서의 실시간 구현이 가능함을 검증했다.

2. 관련 연구

2.1 CNN 기반 객체탐지 알고리즘

딥러닝 기반 객체탐지 알고리즘은 크게 단일단계 방식의 검출기(Single stage detector)과 이 단계 방식의 검출기(Two stage detector)로 나뉜다. 이 단계 방식의 검출기는 영역 제안(Region proposal) 네트워크를 통해 객체로 추정되는 물체의 위치를 선정한 후, 선정된 영역들에 대해서 객체의 클래스 분류를 수행한다. 대표적인 이 단계 방식의 검출기로는 Faster-RCNN,5) Mask R-CNN6) 등이 있으며, 이 단계 방식의 검출기는 많은 연산량으로 인해 실시간으로 사용되기에 어려움이 많다.

반면, 단일단계 방식의 검출기는 객체 분류와 위치 추정을 한 번에 수행하므로 연산량이 적고 빠른 추론이 가능한 장점이 있다. 대표적인 단일 단계 방식의 객체탐지 모델로는 SSD7)와 YOLO 계열(YOLOv1~v48-11))의 모델들이 있다. SSD의 경우 다양한 크기의 Convolution layer에 대해 Multi-scale feature map을 형성하여 객체탐지를 진행한다. DSSD12)는 SSD 모델에 Deconvolution layer를 추가하여, 속도 성능을 유지하면서 작은 객체에 대한 검출 성능을 향상시켰다. SSD를 기반으로 설계된 또다른 모델인 RefineDet13)은 ARM(Anchor Refinement Module)을 활용하여 객체탐지를 진행한다. ARM은 객체 탐지 과정 중, 입력의 불필요한 배경을 없애서 분류기의 공간 탐색의 경우를 줄이게 한다.

대표적인 단일단계 객체탐지 모델인 YOLO는 입력 이미지를 특정 개수의 Grid로 나누어 각각의 Grid cell마다의 객체의 Bounding box의 위치 및 해당 객체의 클래스를 추정한다. 이후 발전된 모델인 YOLOv3에서는 다양한 크기의 특징맵을 서로 다른 세 가지 다른 스케일로 추출하는 방법인 Feature pyramid network를 적용해 mAP를 증가시켰다. YOLOv411)는 Backbone-Neck-Head로 구성되어 있으며, 기존 YOLOv3 모델의 Head 부분을 유지한 채, Backbone layer에 CSPDarknet53을 도입하고 Neck 부분에서 SPP(Spatial Pyramid Pooling), PAN(Path Aggregation Network) 구조를 적용하였다. 이와 더불어 학습 과정에서의 새로운 기법들을 도입하여 추론속도를 높이는 BoF(Bag of Freebies)와 약간의 추론속도를 희생하지만 더욱 정확도를 높이는 기법인 BoS(Bag of Specials)를 사용하여 전체적인 성능을 향상시켰다.

위에서 언급한 SSD와 YOLO 계열의 단일단계 방식의 검출기는 이 단계 방식의 검출기에 비해 상대적으로 빠른 속도로 추론이 가능하다. 실제로 대표적 단일단계 방식 검출기인 YOLOv4-s는 고성능 GPU인 NVIDIA GTX 1080 Ti 환경에서는 62.6 FPS와 같은 빠른 속도로 동작 가능하지만, 제한된 자원을 지닌 자율주행용 임베디드 플랫폼에서 실시간으로 구동되기에는 여전히 어려움이 존재한다.

2.2 객체탐지 모델 경량화 연구

딥러닝 기반 객체탐지 모델을 저사양 환경에 탑재하기 위해 경량화된 객체탐지 모델 개발에 관한 연구들이 활발히 이뤄지고 있다. ResNet14)에서는 Short-cut 기법을 사용한 Residual block을 통해 잔 차를 줄여 나가는 방식으로 네트워크 깊이를 깊게 하여, 경량화를 이룸과 동시에 Gradient vanishing 문제를 해결했다. SqueezeNet15)에서는 Fire module을 사용하여 경량화를 진행했다. Fire module의 Squeeze layer에서 1x1 필터를 사용해 입력 채널의 수를 줄임으로 파라미터 수를 감소시켰고, Expand layer에서 3x3 필터와 1x1 필터를 동시에 사용하여 50배의 모델 사이즈 경량화를 이뤘다. Mobilenet16,17)은 모바일 기기에서 실시간 객체 검출 알고리즘 탑재를 위해 개발된 모델로 DSC(Depthwise Separable Convolution) 기법을 사용한다. DSC 기법은 CNN에 사용되는 2d Convolution을 각각의 채널에서 대해 Convolution을 진행하는 Depthwise convolution과 채널방향만을 고려하는 Convolution인 Pointwise convolution으로 분리하여 진행한다. 이를 통해, 파라미터 수와 연산량을 획기적으로 감소시켰다. ShuffleNet18,19)은 입력 채널을 여러 그룹으로 나누어 Convolution을 진행하는 Group convolution 연산 과 각 Group에 해당하는 채널들을 Shuffle하는 Channel shuffle 연산을 통해 모델 사이즈를 감소시킨다.

새로운 경량화 모델을 개발하는 것이 아니라, 기존 객체탐지 모델에 여러 경량화 기법들을 적용하는 연구들도 진행되고 있다. 대표적인 기법인 양자화(Quantization)는 기존 신경망의 가중치에 사용되는 비트 수를 감소시켜 연산량을 줄이는 방식이다. Jacob 등20)은 ResNet, Inception 모델에 대해 기존의 32비트 Float로 표현되는 가중치 정보를 8비트 Integer로 표현함으로써 양자화를 진행하였고 4배의 모델 사이즈 감소를 이루었다. Yuan Cheng 등21)은 YOLOv3 모델에 양자화와 텐서화 기법을 적용하여 3.9배의 모델 압축을 이뤄냈다.

하지만, 위에 언급된 논문에서 제안된 Q-YOLO와 T-RNN은 NVIDIA GTX 1060 Ti 기반 GPU에서 24~25 FPS의 값을 가지므로 자율주행자동차를 위한 임베디드 GPU 플랫폼에서 실시간 운용하기에는 한계가 있음을 알 수 있다. 고로, 본 연구에서는 임베디드 GPU 환경에서 실시간 구동이 가능한 경량화 객체탐지 모델인 YOffleNet을 제안하고자 한다.

3. 객체탐지 경량화 알고리즘 설계

3.1 Background

대표적인 단일단계 방식의 검출기인 YOLO는 이미지로부터 한 번에 객체의 Class와 Bounding box를 예측하는 방식으로 이 단계 방식의 검출기보다 빠른 추론이 가능하다는 장점을 지닌다. YOLOv2는 기존 YOLOv1 모델의 모든 Convolution layer에 Batch normalization을 적용함으로써 Regularization 효과를 얻어 정확도를 높였고, YOLOv3는 각 Class에 대해 독립적으로 로지스틱 회귀를 적용하였고 3개의 다른 크기의 Feature에 대해 각각 Prediction을 진행하는 FPN을 도입하여 정확도를 향상시켰다. YOLOv4는 Backbone layer에 CSP DenseNet을 적용한 CSPDarknet53을 도입하고 Neck 부분에 SPP와 PAN, FPN(Feature Pyramid Network) 구조를 도입하여 단일 GPU 환경에서도 높은 정확도와 빠른 객체탐지가 가능하도록 설계되었으며, 기존 YOLOv3에 비해 mAP와 FPS가 각각 10 %, 12 정도 향상된 성능을 보여준다. 따라서, 본 연구에서는 실시간 구동을 위해 가장 많이 사용되는 모델인 YOLOv4를 객체탐지를 위한 경량화 모델의 Baseline 모델로 선정하였다.

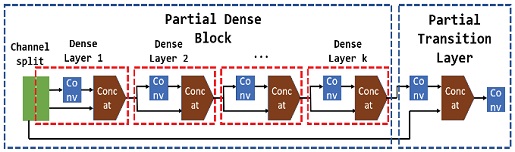

YOLOv4의 Backbone layer인 CSPDarknet53에서는 입력 데이터를 특정 횟수만큼 Convolution 한 후 복사하여 이전 Layer와 Concatenation하는 기법을 활용하는 CSP DenseNet22) 모듈을 활용한다. 이를 통해 이전 피처의 가중치를 재사용하고 중복되는 Gradient 값을 줄여 모델을 경량화한다.

Neck에서는 입력 특징맵에 대해 3가지 커널 사이즈로 Max pooling한 후 Concatenation을 진행하는 SPP23) 기법을 통해 여러 크기의 입력에 대한 정확도를 향상시켰다. 또한 Bottom-up path augmentation 기법을 통해 원활한 정보흐름을 가능하게 하는 PANet24) 구조를 적용시켜 정확도를 높였다. PANet은 Convolution layer로 이뤄진 피라미드 구조에 최하단 특징맵과의 Short-cut과 Convolution layer로 구성된 새로운 피라미드 구조를 만든다. YOLOv4에서는 PANet을 도입하여 정보의 흐름을 원활하게 하며 경량화를 통해 발생되는 정확성 손실의 문제를 보완한다.

Head의 경우 YOLOv3의 객체탐지 방식을 그대로 도입하였다. FPN(Feature Pyramid Network)에 의해 생성된 3개의 특징맵에 대한 Detection이 진행되며 Anchor box 사이즈의 경우 훈련 이미지를 K-means clustering으로 분석하여 결정된다. Head의 탐지과정은 각각의 Bounding box마다의 Box가 객체를 포함하고 있을 가능성을 예측하고 이때 GT(Ground Truth)와 IOU(Intersection Over Union)가 가장 높은 Bounding box를 1로 설정해 GT마다 1개의 Bounding box를 할당한다. Classification 부분에서는 Softmax 대신 로지스틱 회귀를 적용시켜 Multi label classification을 가능하게 한다.

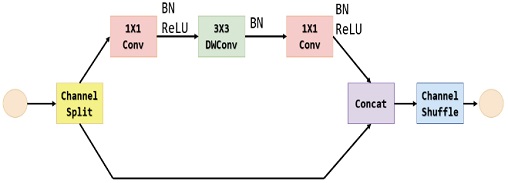

본 연구에서 사용되는 ShuffleNet v219) 모듈은 Channel split을 통해 파라미터 수와 연산량을 감소시키며, Channel shuffle 연산을 통해 정보의 흐름을 원활히 하는 효과를 얻는다. ShuffleNet v2는 파라미터 수를 줄이는 것뿐만 아니라, MAC(Memory Access Cost)를 줄여 딥러닝 모델의 추론 속도를 높이는 방법을 제시한다.

ShuffleNet v2 모듈의 경우 Channel split을 통해 입력 특징맵의 채널을 절반으로 줄인 뒤 Convolution 연산을 진행하여 연산량을 절반으로 감소시켰다. 나머지 절반의 입력 피처맵에 대해서는 Convolution 연산을 거친 특징맵과 Short-cut 구조를 통해 Concatenation함으로써 정보손실 방지에 유리한 구조를 가진다.

ShuffleNet v2에서 MAC를 최소화하기 위해 여러가지 전략들을 도입했다. 1x1 Convolution 시 입출력 특징맵의 채널 크기를 동등하게 가져가는 것이 유리함을 입증하여 동등한 입출력의 채널 크기를 가지는 1x1 Convolution을 도입한다. 또한, Group convolution 연산 과정에서 Group의 크기가 증가하면 MAC가 증가한다는 것을 증명한다. 마지막으로, Element-wise addition과 같은 Element-wise operation이 MAC를 크게 증가시켜 결과적으로 런타임을 크게 증가시킨다는 사실을 언급한다. 이러한 사실을 바탕으로 Channel split된 특징맵을 합치는 과정에서 Elementwise addition 대신 Concatenation 연산으로 대체하여 런타임을 감소시킨다.

3.2 YOLOv4 경량화 설계 전략

YOLOv4에서 사용된 Fig. 2의 CSP DenseNet는 Convolution과 Concatenation이 반복될수록 파라미터 수와 연산량이 증가한다. 또한, 초기 특징맵의 정보 손실을 방지하기 위해 PANet 구조는 Bottom-up path augmentation을 통해 정보의 흐름을 원활하게 하지만 피처맵의 채널의 수를 증가시켜 파라미터 수를 증가시키고 이는 연산량을 증가시킨다. 본 연구에서 제안하는 YOffleNet 모델은 위에서 언급한 YOLOv4 모델의 단점을 개선하고 경량화 효과를 이루기 위해 아래의 방법들을 제시한다.

1) Backbone layer인 CSP DenseNet(Fig. 1)은 네트워크가 깊어짐에 따라 연산량이 필연적으로 증가하는 구조이다. 본 연구에서는 경량화된 모델 설계를 위해 Backbone layer를 ShuffleNet(Fig. 2) 모듈로 구성했다.

2) YOLOv4 네트워크에서 사용하는 SPP + PANet 구조를 간소화하여 모델의 크기를 경량화 시킨다.

위의 두 기법을 통해 제안하는 YOffleNet 모델의 전체적인 구조는 Fig. 3과 같다.

4. 실험 및 검증

4.1 실험환경 구성

제안하는 YOffleNet 모델의 학습 및 성능평가를 위해 라벨링된 KITTI data 7480장의 이미지 데이터셋을 확보했다. 확보된 데이터는 Table 1과 같이 학습, 검증 및 시험용 데이터셋으로 분류하여 실험을 진행했다. 시험용 데이터는 학습에는 전혀 사용되지 않고 학습 후 모델 평가를 위해 구분해 두었다.

학습 과정에서 16의 Batch size로 200 epoch 동안 훈련을 진행했으며, 과적합(Overfitting)을 방지하기 위해 Batch normalization을 적용했다. NVIDIA GTX 1080 Ti GUI 환경에서 약 10시간 정도 학습을 진행했으며, 학습을 마친 후 GIOU Loss(Generalized Intersection over Union Loss) 값이 약 0.027에 수렴하여 충분히 학습이 이루어진 것을 확인했다.

4.2 성능평가

YOffleNet의 성능평가를 위한 비교모델로서 대표적인 단일단계 방식의 객체탐지 모델인 YOLOv4-s와 YOLOv4-m, YOLOv3, 대표적 경량화 객체탐지 모델인 YOLOv3-mobilenet, YOLOv3 tiny을 선정하여 성능비교를 진행했다. YOLOv4의 m 버전은 s 버전보다 모델의 크기가 크지만 정확도는 더 높고, s 버전은 m 버전보다 모델의 크기가 작지만 정확도는 더 낮다. YOLOv4는 YOffleNet(ours)의 기반이 되기 때문에 YOLOv4 s, m 모델과 정확도 및 속도 성능 비교를 진행했다.

또한, YOLOv4의 이전 모델인 YOLOv3와 YOLOv3의 경량화 버전인 YOLOv3-tiny도 평가모델로 선정하였다. YOLOv3-mobilnet은 YOLOv3 모델의 Backbone을 Mobilenetv332)로 대체한 모델이며, Mobilenet의 경우 경량화 모델에 널리 사용되기 때문에 비교모델로서 적합하다 판단했다.

학습 완료 후 학습된 모델의 성능 평가를 위해 시험용 데이터셋으로부터 객체 검출 성능 테스트를 수행하였다. 시험용 데이터셋은 학습에 사용된 이미지 외의 1658장의 이미지를 사용하였다. 성능 검증을 위해 모델의 가중치 크기, mAP, 파라미터 수, FPS를 검증 지표로 사용했다.

Table 2에서 Weight file size는 학습 후 도출되는 모델의 크기를 의미하며 YOffleNet의 Weight file size는 YOLO v4-m에 비해 약 38배 작고 YOLO v4-s에 비해 약 4.7배 작음을 확인할 수 있다. 이는 본 연구의 모델이 평가모델에 비해 간단한 구조를 가지고 있음을 의미하며 임베디드 플랫폼에서 실시간 구동에 이점을 갖는 것을 확인할 수 있다. mAP의 경우 가장 정확도가 높은 비교모델인 YOLO v4-m에 비해 4.1 % 정도의 차이를 보였다. 경량화 객체탐지 모델인 YOLOv3 tiny, YOLOv3-mobilenet과 비교했을 때도 모델 사이즈 측면에서 5.9배, 47.8배 경량화 된 것을 확인했다.

추론 속도 성능인 FPS의 경우 Table 3에서 확인할 수 있듯 CPU 환경에서는 YOLov3-mobilenet이 12.4 FPS로 비교모델 중 가장 빠르게 동작했지만, Jetson AGX Xavier 보드에서는 제안하는 YOffleNet 모델이 약 32 FPS로 가장 빠른 추론 속도를 가지는 것이 확인됐다. 이는 GPU 상에서 MAC를 감소시키기 위한 전략을 취한 ShuffleNet 모듈을 적용한 효과이며, YOffleNet의 base모델인 YOLO v4-s와 비교했을 때 약 8 FPS 빨라진 것을 확인할 수 있다.

5. 결 론

본 연구에서는 자율주행용 임베디드 플랫폼 환경에 탑재가능한 딥러닝 객체탐지 모델인 YOffleNet을 제안했고, KITTI 데이터셋을 통해 제안하는 모델의 성능 검증을 진행했다. YOffleNet은 대표적인 단일단계 방식 검출기인 YOLOv4를 기반으로 하며, 연산량 감소를 위해 PANet을 구조적으로 간소하고 Backbone layer에 사용되는 CSP DenseNet 모듈을 ShuffleNet 모듈로 대체하는 구조 경량화를 진행했다.

대표적인 자율주행용 데이터셋인 KITTI 데이터셋을 사용해 학습을 진행했으며, 본 논문에서 기반으로 삼은 모델인 YOLOv4와 비교했을 때 YOLOv4-s에 비해 mAP는 3.6 % 감소했지만, 4.8배 감소된 Weight file 크기를 가지는 것이 확인됐다. 임베디드 플랫폼 상에서의 실시간 구동을 확인하기 위해 YOffleNet 모델을 NVIDIA Jetson AGX Xavier 보드에 탑재한 결과 기존 YOLOv4에 비해 7 FPS 증가한 31 FPS로 동작함을 확인했다. 추후 연구에서는 YOffleNet 모델에 Quantization, Network pruning, Distillation 등의 경량화 기법을 추가하여 Jetson nano와 Raspberry pi 4B와 같은 보다 저 사양의 임베디드 플랫폼에서의 실시간 구동 가능성을 확인할 것이다.

References

- J. Y. Park, S. K. Wu and D. Y. Lee, Impact Analysis of Autonomous Vehicles and Policy Implications, The Korean Transport Institute, pp.1-200, 2018.

- J. H. Lee, H. S. Chang and Y. I. Park, “Influencing Factors on Social Acceptance of Autonomous Vehicles and Policy Implications,” Journal of Korean Technology Innovation Society, Vol.21, No.2, pp.715-737, 2018.

-

A. Ferdowsi, U. Challita, W. Saad and N. B. Mandayam, “Robust Deep Reinforcement Learning for Security and Safety in Autonomous Vehicle Systems,” 21st International Conference on Intelligent Transportation Systems(ITSC), pp.307-312, 2018.

[https://doi.org/10.1109/ITSC.2018.8569635]

-

S. Liu, L. Liu , J. Tang , B. Yu, Y. Wang and W. Shi, “Edge Computing for Autonomous Driving: Opportunities and Challenges,” Proceedings of the IEEE, Vol.107, No.8, pp.1697-1716, 2019.

[https://doi.org/10.1109/JPROC.2019.2915983]

-

S. Q. Ren, K. M. He, R. Girshick and J. Sun, “Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.39, No.6, pp.1137-1149, 2016.

[https://doi.org/10.1109/TPAMI.2016.2577031]

- K. He, G. Gkioxari, P. Dollár and R. Girshick, “Mask R-CNN,” Proceedings of the IEEE International Conference on Computer Vision, pp.2961-2969, 2017.

-

W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C. Y. Fu and A. C. Berg, “SSD: Single Shot Multibox Detector,” European Conference on Computer Vision, Springer, pp.21-37, 2016.

[https://doi.org/10.1007/978-3-319-46448-0_2]

-

J. Redmon, S. Divvala, R. Girshick and A. Farhadi, “You Only Look Once: Unified, Real-Time Object Detection,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.779-788, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

-

J. Redmon and A. Farhadi, “YOLO9000: Better, Faster, Stronger,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.7263-7271, 2017.

[https://doi.org/10.1109/CVPR.2017.690]

- J. Redmon and A. Farhadi, “Yolov3: An Incremental Improvement,” arXiv preprint arXiv:1804.02767, , 2018.

- A. Bochkovskiy, C. Y. Wang and H. Y. M. Liao, “YOLOv4: Optimal Speed and Accuracy of Object Detection,” arXiv preprint arXiv:2004.10934, , 2020.

- C. Y. Fu, W. Liu, A. Ranga, A. Tyagi and A. C. Berg, “DSSD: Deconvolutional Single Shot Detector,” arXiv preprint arXiv:1701.06659, , 2017.

-

S. Zhang, L. Wen, X. Bian, Z. Lei and S. Z. Li, “Single-Shot Refinement Neural Network for Object Detection,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.4203-4212, 2018.

[https://doi.org/10.1109/CVPR.2018.00442]

- K. M. He, X. Y. Zhang, S. Q. Ren and J. Sun, “Deep Residual Learning for Image Recognition,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.770-778, 2016.

- F. N. Iandola, S. Han, M. W. Moskewicz, K. Ashraf, W. J. Dally and K. Keutzer, “SqueezeNet: AlexNet-Level Accuracy with 50x Fewer Parameters and < 0.5 MB Model Size,” arXiv preprint arXiv:1602.07360, , 2016.

- A. G. Howard, M. L. Zhu, B. Chen, D. Kalenichenko, W. J. Wang, T. Weyand, M. Andreetto and H. Adam, “Mobilenets: Efficient Convolutional Neural Networks for Mobile Vision Applications,” arXiv preprint arXiv:1704.04861, , 2017.

-

M. Sandler, A. Howard, M. L. Zhu, A. Zhmoginov and L. C. Chen, “MobileNetV2: Inverted Residuals and Linear Bottlenecks,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.4510-4520, 2018.

[https://doi.org/10.1109/CVPR.2018.00474]

-

X. Y. Zhang, X. Y. Zhou, M. X. Lin and J. Sun, “ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.6848-6856, 2018.

[https://doi.org/10.1109/CVPR.2018.00716]

-

N. Ma, X. Zhang, H. T. Zheng and J. Sun, “ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design,” Proceedings of the European Conference on Computer Vision(ECCV), pp.122-138, 2018.

[https://doi.org/10.1007/978-3-030-01264-9_8]

-

B. Jacob, S. Kligys, B. Chen, M. Zhu, M. Tang, A. Howard, H. Adam and D. Kalenichenko, “Quantization and Training of Neural Networks for Efficient Integer-Arithmetic-Only Inference,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.2704-2713, 2018.

[https://doi.org/10.1109/CVPR.2018.00286]

- Y. Cheng, G. Li, H. B. Chen, S. X. D. Tan and H. Yu, “DEEPEYE: A Compact and Accurate Video Comprehension at Terminal Devices Compressed with Quantization and Tensorization,” arXiv preprint arXiv:1805.07935, , 2018.

-

C. Y. Wang, H. Y. M. Liao, Y. H. Wu, P. Y. Chen, J. W. Hsieh and I. H. Yeh, “CSPNet: A New Backbone that Can Enhance Learning Capability of CNN,” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, pp.390-391, 2020.

[https://doi.org/10.1109/CVPRW50498.2020.00203]

-

K. He, X. Zhang, S. Ren and J. Sun, “Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol.37, No.9, pp.1904-1916, 2015.

[https://doi.org/10.1109/TPAMI.2015.2389824]

-

S. Liu, L. Qi, H. F. Qin, J. P. Shi and J. Y. Jia, “Path Aggregation Network for Instance Segmentation,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.8759-8768, 2018.

[https://doi.org/10.1109/CVPR.2018.00913]

- H. C. Moon, H. Y. Lee and J. G. Kim, “Compression and Performance Evaluation of CNN Models on Embedded Board,” The Korean Institute of Broadcast and Media Engineers, Vol.25, No.2, pp.200-207, 2020.

-

Y. J. Kim, H. K. Hwang and J. T. Shin, “Optimization of Object Detection and Inference Time for Autonomous Driving,” Journal of KICS, Vol.45, No.4, pp.722-729, 2020.

[https://doi.org/10.7840/kics.2020.45.4.722]

- H. Y. Lee and S. H. Lee, “A Study on Memory Optimization for Applying Deep Learning to PC,” Journal of IKEEE, Vol.21, No.2, pp.136-141, 2017.

-

S. T. Oh, H. W. Kim, S. H. Cho, J. H. You, Y. S. Kwon, S. R. Won and Y. K. Kim, “Development of Model-Based Algorithm based on Deep Neural Network Lightweighting for Detection of Substation Child Anomaly in Drones,” Journal of ICROS, Vol.26, No.11, pp.884-890, 2020.

[https://doi.org/10.5302/J.ICROS.2020.20.0117]

- S. Oh, J. H. You and Y. K. Kim, “FRDet: Balanced and Lightweight Object Detector based on Fire-Residual Modules for Embedded Processor of Autonomous Driving,” arXiv preprint arXiv:2011.08061, , 2020.

- Y. Cheng, D. Wang, P. Zhou and T. Zhang, “A Survey of Model Compression and Acceleration for Deep Neural Networks,” arXiv preprint arXiv:1710.09282, , 2017.

- S. W. Lee, G. D. Lee, J. G. Ko, S. J. Lee and W. Y. Yoo, “Recent Trends of Object and Scene Recognition Technologies for Mobile/Embedded Devices,” Electronics and Telecommunications Trends, Vol.34, No.6, pp.133-144, 2019.

-

A. Howard, M. Sandler, G. Chu, L. C. Chen, B. Chen, M. Tan, W. Wang, Y. Zhu, R. Pang, V. Vasudevan, Q. V. Le and H. Adam, “Searching for MobileNetV3,” Proceedings of the IEEE/CVF International Conference on Computer Vision, pp.1314-1324, 2019.

[https://doi.org/10.1109/ICCV.2019.00140]