자율주행 자동차를 위한 정밀도로지도 활용성 검증

; Sangkwon Kim1)

; Sangkwon Kim1) ; Yeongsoo Kim1)

; Yeongsoo Kim1) ; Joonyong Park1)

; Joonyong Park1) ; Jimin Jeong1)

; Jimin Jeong1) ; Kichun Jo*, 1)

; Kichun Jo*, 1) ; Seongjin Lee2)

; Seongjin Lee2) ; Sungjin Cho2)

; Sungjin Cho2) ; Myoungho Sunwoo2) ; Jong Min Oh3), 4)

; Myoungho Sunwoo2) ; Jong Min Oh3), 4)

Copyright Ⓒ 2020 KSAE / 180-07

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper presents the viability of a high-definition(HD) map for fully autonomous cars. The HD map stores driving information that can be used by autonomous cars to address sensor-only limitations. To confirm the viability of the HD map for autonomous cars, this paper utilized four approaches. First, localization was used to match the point cloud data of the LiDAR sensor with those in the HD map. Second, an electronic horizon was extracted from the road geometry and traffic regulations in the HD map. Third, the acceptability of the HD map was verified after importing the HD map into the simulator. Lastly, autonomous driving simulation and experiments on trajectory tracking were performed to ensure the reliability of the HD map. These approaches demonstrated that the HD map was capable of handling perception limitations and allowed fully autonomous driving.

Keywords:

Autonomous driving, High Definition(HD) map, Localization, Electronic horizon, Simulator키워드:

자율주행, 정밀도로지도, 위치추정, 일렉트로닉 호라이즌, 시뮬레이터1. 서 론

자율주행은 운전자의 역할을 대신하여 차량을 목적지까지 안전하게 도달하도록 도와주는 기술이다. 이를 위해 자율주행에 필요한 기능은 주행환경 인식, 경로 계획, 차량 제어로 분류할 수 있다.1,2) 주행환경 인식 기능은 차선, 교통 신호, 교통 표지, 차량 및 장애물과 같이 주행에 필요한 정보를 인식한다. 인식된 정보는 자율주행 자동차가 어떻게 안전한 경로를 찾아 이동할지 계획하는 기능에 사용되며, 계획된 경로를 따라 차량 제어 알고리즘을 통해 가속 및 감속 페달과 조향 장치를 제어한다. 각 기능은 서로 유기적으로 연결되어 있으므로 하나의 기능이 문제가 되어도 전체 시스템에 영향을 미친다. 따라서 신뢰할 수 있는 인식 기술을 확보해야 강건하고 안전한 주행 경로를 계획하고 차량을 제어할 수 있다.

자율주행 기술은 SAE J3016 기준에 따르면 Level 1부터 적용되어 Level 5까지 분류된다.3) Level 2까지는 전방 충돌방지 보조, 크루즈 컨트롤, 고속도로 주행 보조와 같이 운전자의 주행을 돕는 수준이지만, Level 3부터는 직접 자율주행을 수행할 수 있는 기술을 요구한다. 게다가 Level이 올라갈수록 돌발 상황에서 사고가 나지 않도록 대처할 수 있는 자율주행 기술을 필요로 하므로 정확하고 정밀한 인식, 경로 계획, 차량 제어 기능이 필요하다.

주변 환경을 인식하기 위해 카메라, 레이더, 라이다(Light Detection and Ranging, LiDAR)와 같은 외부 환경 인식 센서 데이터를 처리하는 방법이 널리 사용된다. 또한, 차량의 자세 및 위치 정보를 추정하기 위해 내장 센서 및 GNSS(Global Navigation Satellite System)를 활용하기도 한다. 하지만 센서만을 기반으로 한 인식 시스템은 다양한 원인으로 인한 한계점들을 가지고 있다. 첫 번째로는 인식 영역의 한계가 있다. 예를 들어 카메라는 화각 외의 범위는 인식할 수 없다. LiDAR 역시 인식 거리 범위가 정해져 있으며 거리가 멀어질수록 해상도가 떨어진다. 두 번째로 주변 물체에 의해 인식 영역에 방해가 생긴다. 예를 들어, 차고가 높은 트럭이 차량 주변을 가리면 카메라나 LiDAR가 표지판, 주변 차량 등 가려진 영역을 인식할 수 없다. 또, 날씨 및 환경의 영향도 받는다. 카메라는 비가 오는 날에 물웅덩이의 반사, 빛 번짐 등의 요인으로 인해 정상적으로 인식하기 어렵고 외부 광원에 따라 이미지 밝기 범위가 달라지므로 어두운 밤에 인식률이 떨어진다. GNSS의 경우 고가 장비를 제외하면 미터 수준의 오차가 발생하며 구름이 많은 날 인식률이 떨어질 수 있고, 도심이나 터널 등 위성 정보를 수신하기 어려운 지역에서 위치 정보의 신뢰도가 떨어지는 문제가 있다. 이러한 센서에만 의존하는 자율주행 기술은 운전자를 보조해주는 시스템에는 적합하지만, Level 3 이상의 자율주행은 안정적인 성능을 요구하므로 보완이 필요하다. 이를 보완하기 위해 정밀도로지도로부터 다양한 정보를 추출하여 자율주행에 활용하는 방법이 연구되고 있다.4,5)

정밀도로지도란 정밀한 GNSS, LiDAR, 카메라 센서 등을 장착한 MMS(Mobile Mapping System) 장비를 통해 구축한 지도로, 도로 정보・지형 정보・주변 시설 정보 등을 담고 있어 단순 내비게이션 지도보다 정밀하고 풍부한 정보를 가지고 있다.6) 정밀도로지도는 전통적으로 지리, 군사, 항공 등의 다양한 분야에서 활용됐으며,7-9) 최근에는 4차 산업혁명과 더불어 자율주행, 스마트시티10) 등 다양한 분야에서 활용되고 있다. 그중 자율주행을 위한 정밀도로지도의 역할은 점차 그 중요성이 대두되고 있으며, 특히 Level 4 이상의 고수준 자율주행에서는 필수적인 요소로 여겨지고 있다.

자율주행을 위한 정밀도로지도는 차선・도로 시설・교통 표지・신호등・도로 곡률 및 경사 등과 같은 자율주행에 필요한 정보를 담고 있다. 이러한 정밀도로지도를 활용하여 자율주행 자동차 근방의 환경 정보를 가져와 자율주행을 위한 판단, 제어에 사용할 수 있다. 그뿐만 아니라 센서의 인식 범위를 벗어나는 장소의 환경 정보도 사용할 수 있어 센서만을 사용하는 인식 시스템의 한계를 보완하고 더 멀리 예측할 수 있는 인식 성능을 확보할 수 있다. 이러한 정밀도로지도의 수요로 HERE,11) TomTom12)과 같은 해외 정밀도로지도 관련 기업들이 주목받고 있으며, 국내에서도 현대 엠엔소프트,13) 네이버 랩스14)와 같은 기업뿐만 아니라 국토지리정보원15)과 같은 정부 기관에서도 정밀도로지도 생성에 관해 연구하고 있다.

이러한 정밀도로지도를 활용하여 객체 인지16)・정밀 측위17-20)・경로 계획21)과 같은 자율주행 기능 구현 관련 분야가 많이 연구되고 있으며, 이 외에도 다양한 관련 연구들이 있다. 크게 세 가지 방식으로 첫째, 정밀도로지도 구축・제작・배포・사용의 효율성 증대를 위한 지도 표준 최적화에 관한 연구.6,22) 둘째, Lanelet223)・OpenDRIVE24) 등 활용성을 극대화한 새로운지도 표현 형식에 관한 연구. 셋째, 정밀도로지도 신뢰성 향상을 위한 지도 유효성 검사25)에 관한 연구가 그 분류이다. 또한, 정밀도로지도는 자율주행 경진대회에서도 많이 활용되며 최근 다양한 경진대회에서 Level 4 이상의 자율주행 자동차 개발을 위해 정밀도로지도를 참가자들에게 제공하고 있다. 참가자들은 경로 계획 및 위치추정 등 자율주행 자동차 기능 구현에 정밀도로지도를 활용하여 대회를 참여하고 있으며21,26) 이는 Level 4 이상의 자율주행 자동차 개발에 있어 정밀도로지도 활용이 중요한 의미가 있다는 점을 시사한다. 이제 자율주행에 있어 정밀도로지도는 경로 탐색을 위한 지리정보의 기능을 넘어, 카메라・레이더・LiDAR 등 차량에 부착되어있는 센서만으로 감지할 수 없는 정보를 제공하는 또 하나의 센서로써 활용되고 있다.27,28)

본 논문은 국토지리정보원에서 제공한 정밀도로지도를 네 가지 접근 방법을 통하여 자율주행 기술에 적용함으로써 정밀도로지도의 자율주행 활용 가능성을 검증하고자 한다. 첫째, 정밀도로지도의 포인트 클라우드와 차량에 장착된 LiDAR 센서로부터 수집한 포인트 클라우드를 매칭하여 정밀한 위치를 추정하는 자율주행 위치추정 시스템에 대하여 검증한다. 둘째, 정밀도로지도의 도로형상 및 교통 규제 데이터가 자율주행을 위한 전역 경로 계획 및 일렉트로닉 호라이즌 추출에 적합한지 검증한다. 셋째, 정밀도로지도를 자율주행 시뮬레이터에 적용함으로써 정밀도로지도의 시뮬레이터 수용 가능성을 검증한다. 마지막으로, 자율주행 경로 추종 시뮬레이션 및 실제 차량 실험을 수행하여 정밀도로지도 도로형상 정보의 정확성과 신뢰성이 자율주행 자동차 제어에 적합한지 검증한다. 이 네 가지 검증은 정밀도로지도 안의 다양한 정보가 인식의 한계를 극복하고 완전 자율주행에 필수 요소임을 보여줄 수 있다. 위 검증을 통하여 경험한 점을 바탕으로 정밀도로지도의 활용성 향상을 위해 어떠한 개선점이 있을지 제시하였다.

2. 전체 검증 과정

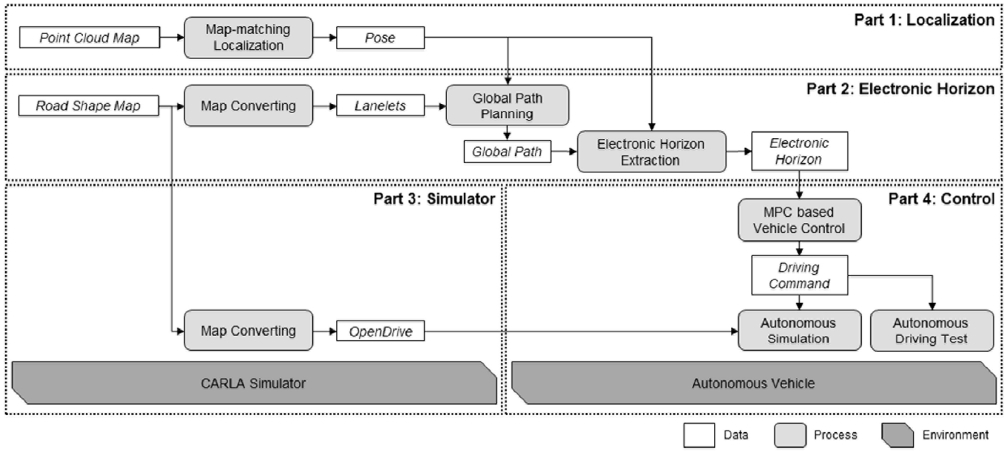

전체 검증 과정은 Part 1: 정밀도로지도-인식정보 매칭을 통한 정밀 위치추정, Part 2: 정밀도로지도 기반 전역 경로 계획 및 일렉트로닉 호라이즌 추출, Part 3: 정밀도로지도를 활용한 자율주행 시뮬레이터 환경 구성, Part 4: 차량 제어 알고리즘을 적용한 자율주행 실험 수행으로 크게 4가지 부분으로 구성되어 있다.

Fig. 1은 앞서 기술한 전체 검증 과정의 구조를 나타낸다. Part 1은 포인트 클라우드 정밀지도가 자율주행 위치추정에 활용 가능한지 검증하기 위해 사용된 알고리즘의 구조이다. 국토지리정보원에서 제공받은 정밀도로지도의 포인트 클라우드와 LiDAR 센서로 측정한 포인트 클라우드의 매칭을 통해 베이지안 확률 추정 기법을 기반으로 한 정밀 위치추정 알고리즘을 사용하였다.

Part 2는 정밀도로지도의 도로형상 및 교통 정보를 자율주행의 전역 경로 계획 및 일렉트로닉 호라이즌 추출에 적용 가능한지 검증하기 위해 설계된 알고리즘 구조도를 나타낸다. 우선 제공받은 도로형상 정밀도로지도를 Lanelet2 형식의 지도로 변환하고, Lanelet2 라이브러리에서 제공하는 기능을 활용하여 전역 경로 계획 및 자율주행 기능 구현을 위한 일렉트로닉 호라이즌을 추출하였다. 여기서 일렉트로닉 호라이즌은 전역 경로 및 현재 위치를 기반으로 정밀도로지도에서 추출한 도로형상 정보와 교통규약 정보가 포함된 주변 환경 정보의 집합을 말한다. 이후 시각화를 통해 정밀도로지도의 전역 경로 계획 및 일렉트로닉 호라이즌 추출 성능에 대하여 정성적으로 검증하였다.

Part 3에서는 제공받은 도로형상 정밀도로지도를 활용하여 자율주행 시뮬레이션 환경을 구성하였다. 도로형상 정밀도로지도를 다양한 시뮬레이터에서 요구하는 파일 형식인 OpenDRIVE 형식으로 변환하고, 오픈소스 자율주행 시뮬레이터인 CARLA 시뮬레이터에 적용하여 시뮬레이션 환경을 구성하였다.

Part 4는 Part 2에서 생성한 일렉트로닉 호라이즌 정보를 이용해 시뮬레이션 및 실제 차량으로 자율주행 실험을 수행하였다. 자율주행을 위한 제어로 모델기반 예측 제어(Model Predictive Control, MPC) 알고리즘을 사용하였다. 이 실험을 통하여 정밀도로지도를 활용한 위치추정과 도로형상 정보 및 교통 정보의 활용이 자율주행 자동차 제어에 적합한지 검증하였다.

3. 정밀도로지도-인식정보 매칭을 통한 정밀 위치추정

정밀도로지도 중 포인트 클라우드 정보의 자율주행에의 활용 적합성을 검증하기 위해 포인트 클라우드 매칭 기반 정밀 위치추정 알고리즘을 적용하였다. 이 방법은 베이지안 확률 추정 기법인 파티클 필터를 기반으로 하며, 정밀도로지도의 신뢰성을 검증하기 위해 정밀도로지도-인식정보 간 매칭을 통한 측정치를 추정 상태 보정에 사용한다. 본 논문에서 사용한 정밀 위치추정 알고리즘은 포인트 클라우드 데이터 전처리, 초기 위치 결정, 예측, 정밀도로지도-인식정보 매칭을 통한 가중치 갱신, 그리고 리샘플링 단계로 구성된다.

3.1 포인트 클라우드 데이터 전처리

포인트 클라우드 데이터를 수집하기 위해 차량에 장착된 LiDAR 센서는 센서 좌표계를 기준으로 정보를 제공한다. 이 데이터를 차량 좌표계 기준 정보로 변환하기 위해, 외부 캘리브레이션 파라미터를 알아내는 과정이 필요하다. 본 논문에 사용된 차량과 센서 간 외부 캘리브레이션 파라미터는 통제된 공간에서 데이터를 실시간으로 취득 실험을 통해 계산하였다. 외부 캘리브레이션 파라미터를 통해 차량 좌표계 기준 포인트 클라우드 데이터를 수집한다. 필요한 경우, 이 단계에서 지면에 해당하는 포인트를 높이에 기반을 두어 제거할 수 있다. 수집된 포인트 클라우드 데이터는 정밀도로지도의 포인트 클라우드와 매칭에 사용되며, 매칭을 통한 측정치를 통해 각 파티클의 가중치를 갱신할 수 있다.

3.2 초기위치 결정

파티클 필터와 같은 베이지안 확률 추정 기반 위치추정에서 초기 위치 결정은 위치추정 성능에 큰 영향을 줄 수 있다. 실내 공간에서의 위치추정과는 다르게, 넓은 실외 공간에서 실시간으로 위치를 추정하기 위해서는 파티클 수와 초기위치에 제약 사항이 있으므로 실시간 성능을 보장할 수 있는 파티클 수와 적절한 초기 예상 위치를 결정해주어야 한다. 본 논문에서의 초기위치는 단일 GNSS 이상의 퀄리티를 가지는 위치 정보를 기준으로 가우시안 확률 모델을 통해 결정하였다.

3.3 예측

예측 단계는 차량 내장 센서의 차량 속도와 요레이트와 같은 움직임 정보를 통해 파티클의 현재 시각에서의 자세를 예측하는 단계를 의미한다. 경과 시간은 이전 자세의 시각과 차량 내장 센서의 시각의 차이를 통해 구하고, 예측에 사용되는 상태 공간 방정식은 추측 항법(Dead Reckoning) 수식에 차량 내장 센서의 부정확도를 고려하여 가우시안 랜덤 잡음을 추가하여 예측한다. 아래의 수식 (1)은 상태공간 방정식을 나타낸다.

| (1) |

는 예측된 상태 벡터를 나타낸다. 상태 벡터를 구성하는 값은 차량의 위치(X,Y) 및 요(ψ)로 구성되며, 이전 상태 와 임의의 잡음이 포함된 속도() 및 요레이트() 입력에 따라 계산된다. 여기서 ∆T 는 이전 상태와의 시간 차이를 의미한다.

3.4 가중치 갱신

가중치 갱신 단계에서는 측정치로 사용할 수 있는 정보를 통해 파티클마다 가지고 있는 가중치를 갱신한다. 정밀도로지도-인식정보 포인트 클라우드 매칭 측정치를 사용하는 방법은 다음과 같다. 먼저, 인식 포인트 클라우드의 위치를 각 파티클의 자세를 기준으로 하는 좌표계로 변환한다. 그다음 각 파티클 마다 정밀도로지도-인식정보의 매칭 유사성을 계산한다. 아래의 식 (2)는 가중치를 계산하는 방법을 나타낸다.

| (2) |

파티클의 가중치는 로 표현되며, 가우시안 거리의 합으로 결정한다. dist는 포인트 클라우드의 각 포인트에 대한 정밀도로지도의 가장 가까운 거리를 의미한다. 그리고 std는 센서의 불확실성과 관련된 매개변수다. n은 포인트 클라우드에 대한 인덱스를 나타내며, Npcd개의 입력 포인트에 대한 거리를 합산하여 가중치를 계산한다. 이를 통해 유사성이 높은 파티클은 가우시안 거리가 작으므로 가중치가 높게, 반대로 유사성이 낮은 파티클은 가중치가 낮게 갱신된다.

3.5 리샘플링

리샘플링은 파티클 필터 알고리즘 과정 중 가중치 비중이 특정 파티클로 집중되어 의미 없는 파티클을 지속해서 계산하는 문제를 해결하기 위한 단계이다. 리샘플링 과정의 동작 결정은 유효 파티클 수 추정을 통해 판단할 수 있다. 아래의 식 (3)은 유효 파티클 수 추정에 사용된 수식이며, 유효 파티클 수가 일정 이하로 떨어지면 리샘플링 단계를 진행한다.

| (3) |

은 유효 파티클의 수, α는 리샘플링 시작에 대한 기준 파라미터로 이를 통해 파티클 수에 대한 비율 기준을 결정할 수 있다. 여기서 모든 파티클의 가중치가 같은 경우 유효 파티클 수는 실제 파티클 수와 같다.

리샘플링 여부가 결정되면 저-분산 리샘플링 기법을 통해 가중치에 따라 파티클이 재배치된다.29)

4. 정밀도로지도 기반 전역 경로 계획 및 일렉트로닉 호라이즌 추출

정밀도로지도를 지역 경로 계획에 활용하기 위해서는 정밀도로지도로부터 전역 경로를 생성하고, 생성한 전역 경로를 활용하여 일렉트로닉 호라이즌을 추출해야 한다. 일렉트로닉 호라이즌이란 전역 경로 및 현재 위치를 기반으로 정밀도로지도에서 추출한 도로형상 정보와 교통 정보가 포함된 주변 환경 정보의 집합을 말한다. 이를 지역 경로 계획 알고리즘에 활용하여 주행 가능한 최적의 경로를 생성할 수 있다.

전역 경로 및 일렉트로닉 호라이즌 생성을 위해 Lanelet2 라이브러리30)를 활용하였다. Lanelet2 라이브러리는 복잡한 교통 시나리오를 다루기 위해 C++ 로 설계된 공용 라이브러리이다. 본 논문에서는 국토지리정보원에서 제공하는 도로형상 정밀도로지도를 Lanelet2 지도로 변환하고, 이를 기반으로 전역 경로 및 일렉트로닉 호라이즌을 추출하여 지역 경로 계획에 활용하였다.

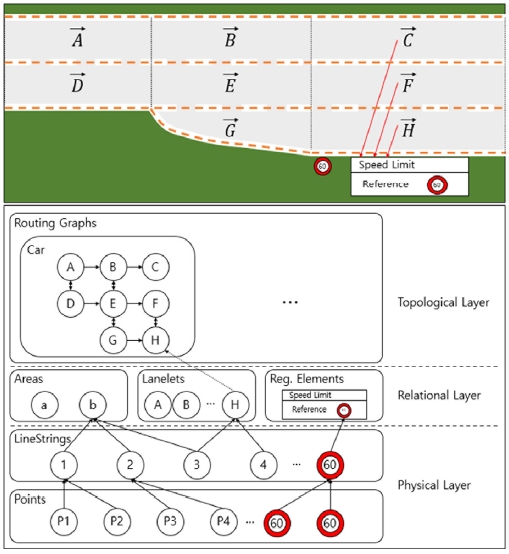

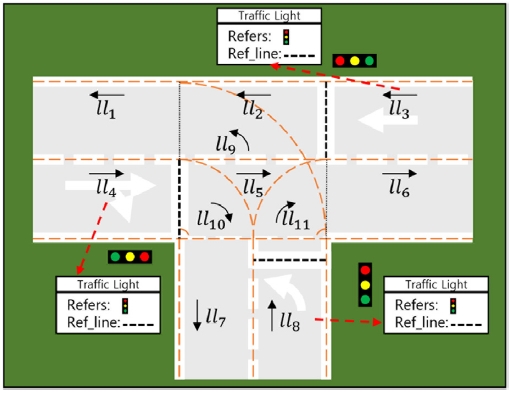

4.1 Lanelet2

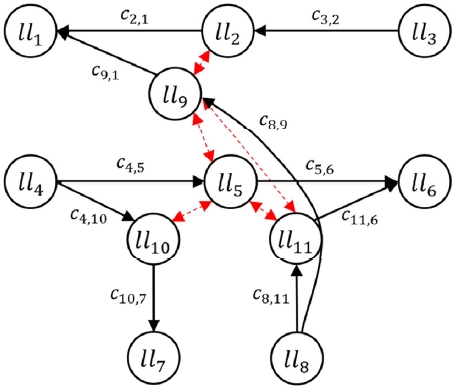

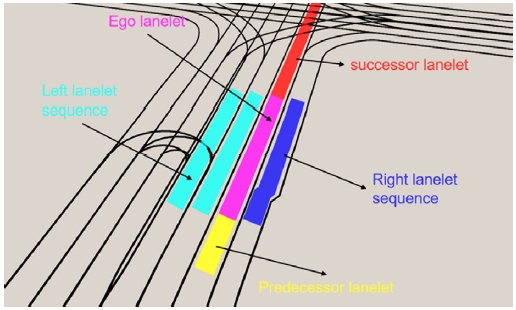

Lanelet2는 정밀도로지도를 표현하기 위해 Fig. 2와 같이 물리 계층, 관계 계층, 그리고 위상 계층을 포함하는 자료구조로 이루어져 있다. 또한, Lanelet2에는 앞서 제시된 자료구조의 속성 정보를 이용할 수 있는 함수들과 전역 경로 및 일렉트로닉 호라이즌을 추출할 수 있는 라이브러리가 제공된다. 본 논문에서는 Lanelet2의 자료구조와 제공되는 라이브러리를 활용하기 위해서 도로형상 형식의 정밀도로지도에 포함된 차선표시(규제선), 노면표시(노면방향/유도선/횡단보도면)와 같은 정보를 Lanelet2의 선, 교통규약 등의 요소로 변환하였다.

Lanelet2 지도는 세 가지 계층으로 구성된다. 각 계층에는 Lanelet2 요소 및 요소의 정보에 의해 생성되는 그래프가 포함된다. 먼저 물리 계층에는 실제 관측 가능한 교통표지, 신호등 등 물체를 표현할 수 있는 점과 선이 포함되어 있다. 관계 계층에는 물리적인 요소와 교통 정보를 포함하는 레인렛과 교통규약이 포함되어 있다. 마지막으로 위상 계층에는 관계 계층 요소 간의 관계를 나타내는 그래프가 있다.

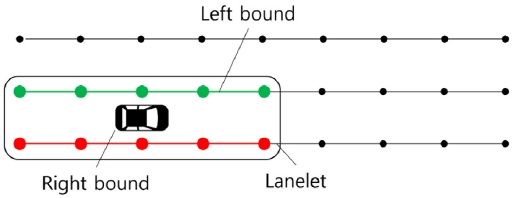

관계 계층에 속하는 레인렛 요소는 Lanelet2 지도의 한 영역을 표현하는 최소 단위로써 이 영역은 교통 정보가 변하지 않고, 인접한 영역과의 위상 관계가 변하지 않는다. 이 요소는 물리 계층의 선 요소를 사용하여 Fig. 3과 같이 영역의 왼쪽과 오른쪽 경계를 나타내고, 관계 계층의 교통규약을 참조함으로써 해당 영역의 교통 신호, 정지 신호, 제한 속도 등과 같은 교통 정보를 가지고 있다.

위상 계층에서 그래프 구조로 관계 계층 요소 간 관계를 표현하기 위해, 각각의 레인렛은 인접한 레인렛과의 관계 정보를 가지고 있다. 관계 정보란 앞, 뒤, 좌, 우 등 이웃한 레인렛의 위치 관계와 둘 이상의 레인렛이 하나의 레인렛으로 합쳐지는 합병 관계 또는 하나의 레인렛이 둘 이상의 레인렛으로 분할되는 분할 관계 그리고 둘 이상의 레인렛 영역이 겹쳐지는 갈등 관계를 말한다. Lanelet2 지도를 이루는 레인렛 집합은 이 관계정보와 해당 영역의 교통 정보를 이용하여 Lanelet2 지도를 그래프로 표현할 수 있다.

4.2 Lanelet2 그래프 기반 전역 경로 추출

전역 경로란 시작지점으로부터 목표지점까지 이동하는 최적 경로이다. 여기서 최적 경로는 이동에 필요한 비용을 최소화한 경로로, 이 비용은 이동 거리・소요 시간 등을 고려해 산출할 수 있다. 이러한 전역 경로를 추출하기 위해 그래프 구조를 활용한 탐색 알고리즘을 사용하는 방법이 많이 사용되고 있다.31-33) 앞서 변환한 Lanelet2 지도는 Lanelet2 라이브러리에서 제공하는 함수를 통해 그래프 형태로 변환할 수 있다. 이 함수는 그래프의 노드를 각각의 레인렛에 할당하고, 인접한 레인렛의 연결 관계 및 다른 레인렛으로의 이동에 필요한 비용을 엣지에 표현해준다.

Fig. 5는 Fig. 4의 지도를 그래프 형태로 표현한 것이다. 앞서 설명했듯 각 노드에는 레인렛이 할당되어 있고, 레인렛의 이동 방향에 맞게 방향이 있는 화살표로 연결 관계가 나타나 있다. 이 화살표를 엣지라고 한다. 또, 각 엣지에는 한 레인렛에서 다른 레인렛으로 가기 위한 비용이 표시되어 있다. 마지막으로 빨간색 양방향 화살표로 서로 겹치는 레인렛의 관계를 표시하고 있다.

이 그래프를 통해 시작지점 레인렛과 목표지점 레인렛 사이에 연결된 모든 레인렛으로 이루어진 경로들을 탐색 알고리즘을 통해 추출할 수 있다. 이렇게 추출된 레인렛으로 이루어진 경로 중 비용이 최소가 되는 경로를 최종 전역 경로로 선정한다. 탐색 알고리즘 중 Dijkstra 알고리즘을 사용하면 그래프 구조를 통해 비용이 최소가 되는 경로를 선정할 수 있다. Dijkstra 알고리즘이란, 각 노드 사이의 비용을 엣지에 표현한 그래프 구조에서, 시작 노드와 목표 노드 간의 비용을 최소화하는 경로를 찾는 알고리즘이다. Lanelet2 라이브러리에서 제공하는 전역 경로 추출 함수는 Dijkstra 알고리즘을 적용해 최적의 전역 경로를 추출하게 된다.

4.3 일렉트로닉 호라이즌 추출

앞서 추출한 Lanelet2 전역 경로는 시작지점과 목표지점 사이에 존재하는 많은 정보를 포함하고 있지만, 자율주행을 위해서는 현재 위치를 기준으로 한 주변 도로 환경에 대한 정보들이 필요하다. 본 논문에서는 현재 위치를 기준으로 한 지역적인 도로 정보를 얻기 위해 일렉트로닉 호라이즌을 추출하였다.

일렉트로닉 호라이즌은 전역 경로에서 현재 위치를 기반으로 추출한 차선의 방향, 경계, 교통규약 정보 등을 포함하는 주행 경로에 대한 지역적인 환경 정보를 의미한다. 일렉트로닉 호라이즌이 주변 환경 정보를 제공하기 때문에 이를 주변 환경을 인식하는 하나의 센서로 여기기도 한다.27,28) 전역 경로에서 일렉트로닉 호라이즌을 추출하기 위해 우선 레인렛의 관심 범위를 지정해야 한다. 관심 범위를 지정함으로써 원하는 범위 내의 환경 정보를 받아올 수 있다. 이후, 현재 위치를 기준으로 앞서 지정된 범위 내의 전역 경로 정보를 추출한다. 이와 같은 과정을 통해 추출된 일렉트로닉 호라이즌은 자율주행을 위해 사용된다.

5. 정밀도로지도를 활용한 자율주행시뮬레이터 환경 구성

정밀도로지도를 활용한 실차 실험에 앞서 자율주행 시뮬레이션을 수행하기 위해 정밀도로지도 기반 시뮬레이터 환경을 구성하였다. 시뮬레이터 환경은 시뮬레이션 및 실차 실험에 사용될 지역의 도로형상 정밀도로지도를 OpenDRIVE 형식으로 변환한 후, CARLA 시뮬레이터 환경에 적용하였다.

5.1 도로형상 정밀도로지도를 OpenDRIVE 형식으로 변환

국토지리정보원에서 제공한 초기 데이터 형식은 Shp 확장자로 구성된 도로형상 정밀도로지도(Shapefile)이며, 해당 지도를 시뮬레이터에서 활용하기 위해서는 지도형식의 변환이 필수적이다. 다수의 자율주행 시뮬레이터에서 채택하고 있는 지도형식은 OpenDRIVE 형식이다. 따라서, 본 논문에서는 자율주행 시뮬레이터 구성을 위해 도로형상 정밀도로지도를 OpenDRIVE 형식으로 변환하는 과정을 수행하였다. 우선 도로형상 정밀도로지도로부터 RoadRunner를 활용하여 도로형상을 스케치하였다. 이후 작성된 RoadRunner 상의 지도를 Xodr 확장자로 구성된 OpenDRIVE 형식으로 변환하였다. 변환된 정밀도로지도는 OpenDRIVE 형식을 채택하는 모든 시뮬레이터 환경에서 활용 가능하며, 본 논문에서는 CARLA 시뮬레이터 환경을 선정하여 활용하였다.

5.2 CARLA 시뮬레이터 환경 구성

자율주행 시험에 있어 충분한 실험 결과 획득 및 안정성을 고려할 때, 시뮬레이션의 활용은 필수적이며 본 논문 또한 실차 실험에 앞서 시뮬레이터를 구성하고 검증하였다. 자율주행을 위한 차량용 시뮬레이터는 CARLA, CarMaker, PreScan 등이 있으며, 그중 CARLA 시뮬레이터는 오픈소스 시뮬레이터로서 수많은 학계 및 산업파트너들의 참여를 통해 공유 및 개발되는 공통 개방형 플랫폼이라는 장점이 있다. 본 논문에서는 OpenDRIVE 형식의 정밀도로지도를 CARLA 시뮬레이터에 적용하여 자율주행 시험을 위한 환경을 구성하였다.

6. 차량 제어 알고리즘을 적용한 자율주행 실험 수행

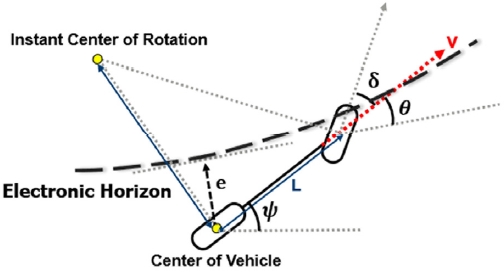

일렉트로닉 호라이즌으로부터 중앙 차선을 추출하여 지역 경로를 구성하고, 이를 추종하기 위해 모델 예측 기반 제어기(MPC)를 사용하였다. MPC의 입력으로 차량 상태를, 기준 입력으로 지역 경로의 형상 및 속도 성분을 사용하였다. MPC의 출력은 차량에 가하는 제어 입력으로써, 가・감속 값과 조향각도 값이다.

6.1 차량 모델 설정

차량의 기구학적 모델로부터 운동방정식을 도출하고, 이를 상태공간방정식으로 구성하였다. 차량의 뒤 차축을 중심으로 하는 기구학적 모델을 Fig. 6과 같이 나타낼 수 있다. 차량의 중심(x,y) 및 헤딩(ψ)과 차량의 속도(v), 횡방향 오차(e), 헤딩 오차(θ)로 차량의 상태를 정의하고, 조향각(δ)과 가속 입력(a)으로 차량의 제어 입력을 정의하였다. 이를 다음 식 (4)와 같은 운동방정식으로 정의할 수 있다.

| (4) |

6.2 제약조건 설정

MPC의 전체 예측 구간(T)을 샘플링 간격(제어 주기, dt)에 따라 N개의 구간으로 나누었다. 예측 구간 동안의 차량의 미래 상태를 식 (5)와 같이 재귀적인 형태로 표현할 수 있다.

| (5) |

재귀적 형태를 기반으로 현재 상태부터 예측 구간까지의 미래 상태를 표현하고, 이를 식 (6)과 같이 MPC의 비선형 균등 제약조건으로 사용할 수 있다.

| (6) |

비선형 불균등 제약조건으로는 안전을 고려한 차량의 속도제한 값을 사용하고, 입력의 경계조건으로는 차량 가・감속력과 조향 한계값을 사용하였다.

6.3 비용함수 설정

비용함수 f는 MPC의 예측 구간 동안의 추종 오차, 제어 입력, 입력의 변화량에 대한 가중 합을 사용하여 식 (7)처럼 이차함수 형태로 구성하였다.

| (7) |

식 (7)의 w1, w2, ⋯, w7 는 각 변수에 대한 가중치이고 vref는 지역 경로로부터 추출한 기준 속도를 의미한다. 각 시간의 제어 입력 변화량도 비용함수에 반영하여 시스템의 안정화에 기여하게 된다.

6.4 최적화

비용함수의 최적화 계산을 위한 Solver는 CVXGEN의 QP를 이용했다. 결과로써 얻은 최적 입력 벡터의 첫 번째 요소만을 차량 제어 입력으로 사용하고 전체 과정을 반복한다. 즉 매시간 초깃값을 시스템의 측정치로 갱신하여 유한 구간 최적 제어 문제를 해결한다.

7. 실험 결과

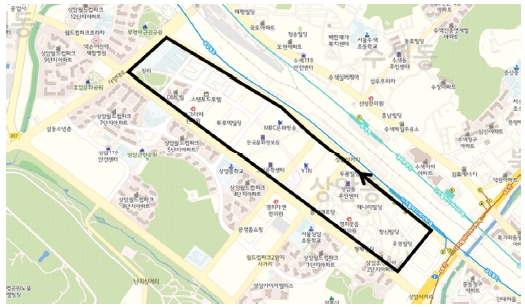

본 논문은 국토지리정보원에서 제공하는 신규 정밀도로지도의 자율주행 적용 가능성을 검증하기 위해 자율주행 실증 시험 구간에서 진행되었다. ‘상암 자율주행 테스트베드’는 자율주행을 시험할 수 있는 장소로 정밀도로지도 검증에 대한 신뢰성과 적합성을 확인할 수 있다.

GNSS의 도움 없이 정밀도로지도와 인식정보 매칭을 이용한 위치추정 알고리즘을 적용한 후, 이를 바탕으로 일렉트로닉 호라이즌을 추출하고 시뮬레이션 및 실제 차량 실험 수행을 통해 자율주행 활용 가능성에 대해 검증하였다. Fig. 7의 상암 자율주행 테스트베드 지역 중 검은색으로 표시한 구간이 평가에 사용된 주행 구간이다. 자율주행 임시운행허가를 위한 시험운행 확인방법 및 기준34)을 참고하여 차선 유지, 차로 변경 및 교차로 주행 등에 대한 시나리오를 선정하고 실험을 진행하였다.

검증에 사용된 차량은 Fig. 8의 한양대학교 자동차전자제어연구실(ACE Lab)의 자율주행 임시운행 허가를 받은 차량을 사용하였다. 차량에는 포인트 클라우드 형태의 정밀도로지도와 매칭하기 위한 LiDAR 센서로 Velodyne VLP-16이 사용되었고, 위치추정 결과를 비교하고 초기위치를 설정하기 위한 RTK-GNSS/INS 센서로 RT3002가 사용되었다.

7.1 Part 1: 정밀도로지도-인식정보 매칭을 통한 정밀 위치추정 실험 결과

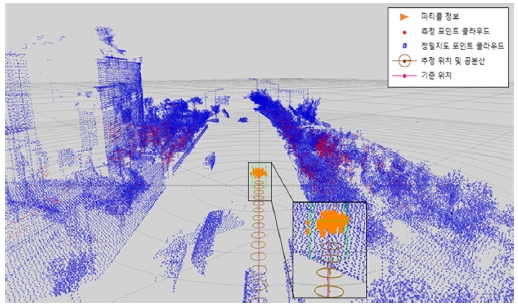

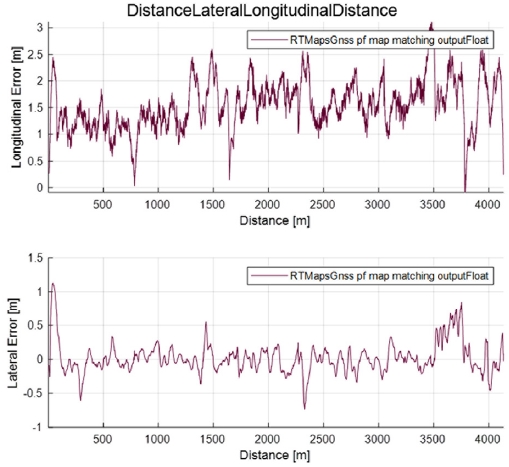

Fig. 9는 정밀도로지도-인식정보 매칭을 통한 정밀 위치추정 알고리즘의 결과를 보여준다. 중앙의 주황색 삼각형 군집은 파티클을 의미한다. 파티클의 가중치 분포를 통해 추정 위치 및 공분산을 결정할 추출할 수 있으며 그림에서는 갈색 원을 포함한 경로로 표현되었다. 정량적으로 위치추정 성능을 평가하기 위해 사용한 고정밀 GNSS 센서의 위치는 붉은 경로로 표현되었다. 그리고 정성적으로 매칭을 평가하기 위해 포인트 클라우드를 표시하였으며, 붉은 점은 센서로부터, 푸른 점은 정밀도로지도로부터 얻은 포인트 클라우드를 나타낸다. 실험에 적용한 초기위치는 RTK-GNSS/INS 위치를 기준으로 하고, 단일 GNSS의 퀄리티 성능을 고려하여 위치 정밀도는 5 m, 요 정밀도는 20 deg 내에서 결정하였다. 이러한 정밀 위치추정 알고리즘 적용에 대한 성능 평가 요소로는 각 종방향 및 횡방향 거리오차에 대한 평균제곱제곱근(RMSE)을 지표로 사용하였다. Fig. 10은 앞서 설명한 상암 자율주행 테스트베드에서 진행한 실험에 대한 추정 위치와 기준 위치 사이의 종・횡방향 오차를 나타낸다. 자율주행 테스트베드 실험 구간의 경우, 종방향 RMSE는 1.6648 m, 횡방향 RMSE는 0.1937 m의 결과를 얻을 수 있었다. 종방향 오차가 더 큰 이유는 테스트 주행로의 특성상 종방향 위치를 보정 하는 데 영향을 줄 수 있는 포인트 클라우드 정보가 상대적으로 적기 때문에 크게 나온 것으로 판단할 수 있다. 그리고 초기 양방향 오차가 큰 이유는 자율주행 시스템 시작 시 주변 정밀지도를 읽어오는 동안 예측만으로 위치를 추정하기 때문이다. 이후 간헐적으로 오차가 큰 부분에 대해서는 위치추정 결과를 비교하기 위해 사용한 RTK-GNSS/INS 센서의 오차로 인해 발생한 것으로, 검증에 사용된 상암 자율주행 테스트베드 특성상 건물이 많아 센서 데이터가 끊기거나 오차가 커지는 등 퀄리티가 좋지 않았다. 본 논문에서 적용한 정밀도로지도-인식정보 매칭을 통한 정밀 위치추정 결과를 바탕으로 7.4 Part 4: 차량 제어 알고리즘을 적용한 자율주행 실험에 적용해 본 결과 차량이 위치를 잘 추정하여 차선을 벗어나지 않고 테스트에 사용된 시나리오에 대해 정상적으로 주행함을 확인하였다. 정밀도로지도의 주기적인 정보 업데이트, 동적 객체 후처리와 같은 개선이 필요하지만, 정밀도로지도의 자율주행 자동차 위치추정에의 활용 가능성은 충분하다고 평가하였다.

7.2 Part 2: 정밀도로지도 기반 전역 경로 계획 및 일렉트로닉 호라이즌 추출 결과

Fig. 11은 상암지역 Lanelet2 정밀도로지도를 ROS RViz 상에서 시각화하였고, 현재 위치한 Ego lanelet과 인접한 Lanelet, 그리고 연속된 앞뒤 Lanelet을 시각화하였다. 여기서 일렉트로닉 호라이즌은 Predecessor, Ego, 그리고 Successor lanelet으로 이루어진 것을 말한다. Rviz 화면을 통해 일렉트로닉 호라이즌이 정성적으로 Lanelet2 정밀도로지도와 일치하는 것을 확인할 수 있다.

7.3 Part 3: 정밀도로지도를 활용한 자율주행 시뮬레이터 환경 구성 결과

OpenDRIVE 형식의 정밀도로지도를 적용한 CARLA 시뮬레이션 환경에 운전대 및 가속・브레이크 페달로 구성된 하드웨어를 연결하여 Fig. 12와 같이 가상 주행 환경을 구축하였다. CARLA 내부의 가상 차량을 운전하여 정밀도로지도의 시뮬레이션 환경에 대한 유효성을 정성적으로 검증하였다.

7.4 Part 4: 차량 제어 알고리즘을 적용한 자율주행 실험 결과

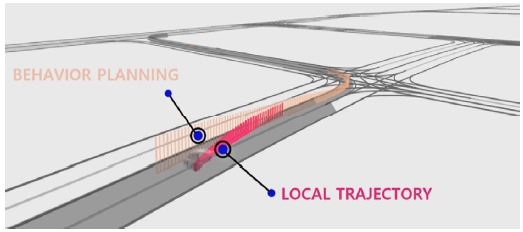

기준 입력과 차량 상태와의 차이를 최소화하는 원리인 MPC 알고리즘을 사용하여 자율주행 실험을 진행하였다. 정밀지도에서 추출한 일렉트로닉 호라이즌을 자율주행에 사용할 수 있는지에 대한 여부를 시뮬레이션 상에서 우선 실험하였고, Fig. 13의 ROS Rviz 화면상에서 정상적으로 움직이는 것을 확인하였다. 이후 Fig. 14와 같이 실제 차량 실험을 통하여 정성적으로 검증하였다. 주행 실험을 기록한 영상은 ‘자율주행을 위한 정밀도로지도 활용성 검증’ 공모전 제출 영상에서 확인할 수 있다(https://youtu.be/tznWp5NF4eA).35)

8. 결론 및 개선사항

본 논문은 자율주행 자동차의 주요 기능인 위치추정과 제어를 정밀도로지도를 활용하여 구현하였다. 구현된 포인트 클라우드 매칭 기반 정밀 위치추정과 일렉트로닉 호라이즌 기반 자율주행 자동차 제어 기능을 통한 정밀도로지도 검증을 위해 시뮬레이션 및 실차 환경에서 실험을 진행하였다. 실험 환경은 자율주행 실험의 신뢰성을 위해 자율주행 전용 실험 구역인 ‘서울시 상암 자율주행 테스트베드’ 지역에서 시행되었다.

실험 결과, 자율주행에 대한 정밀도로지도의 활용성은 매우 높으며, 앞으로도 활용성이 확대될 가능성이 크다고 판단하였다. 더 나아가 본 논문에서 활용한 정밀도로지도의 정적인 정보뿐만 아닌 신호등 점멸 순서와 같은 동적인 정보를 사용한 정밀도로지도의 검증 역시 진행할 예정이다.

추가로, 정밀도로지도의 활용성을 더욱 향상시키기 위해 아래와 같은 제안 점을 제시한다.

- 1) 포인트 클라우드 지도의 활용성 증대를 위해 도로 내 동적 포인트 클라우드를 제거하는 후처리를 수행하고, 도로 주변의 수정되는 정보를 고려하여 주기적인 재구축 및 배포를 통해 정보를 업데이트한다.

- 2) 자율주행 위치추정 시스템에 대한 활용성 증대를 위해, 위치추정에서 종방향 오차를 줄이는 랜드마크로 활용 가능한 특정 객체(표지판, 신호등 등)의 크기 및 형태 속성을 추가한다.

- 3) 자율주행 구현의 효율성을 위해, 도로 간의 관계를 저장한 지도 형식인 Lanelet2 형식의 정밀도로지도를 구축한다.

- 4) 자율주행 자동차 시뮬레이션 활성화를 위해, 지도 변환 과정을 생략할 수 있도록 OpenDRIVE 형식의 정밀도로지도를 배포한다.

Acknowledgments

이 성과는 공간정보산업진흥원 주관 ‘자율주행을 위한 정밀도로지도 활용성 검증’ 공모전의 결과로 국토지리정보원장상을 수상하였으며, 산업통상자원부 ‘산업전문인력역량강화사업’의 재원으로 한국산업기술진흥원(KIAT)의 지원을 받아 수행된 연구임(2020년 미래형 자동차 R&D 전문인력 양성사업, 과제번호: N0002428, 2020년 산업용 무인비행장치 전문인력 양성사업, 과제번호: N0002431). 또한, 이 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. 2019R1G1A1099806, No. 2020R1C1C1007739).

References

-

K. Jo, M. Lee, D. Kim, J. Kim, C. Jang, E. Kim, S. Kim, D. Lee, C. Kim, S. Kim, K. Huh and M. Sunwoo, “Overall Reviews of Autonomous Vehicle A1 - System Architecture and Algorithms,” The International Federation of Automatic Control (IFAC) International Autonomous Vehicles Symposium, Vol.46, No.10, pp.114-119, 2013.

[https://doi.org/10.3182/20130626-3-AU-2035.00052]

-

K. Jo, J. Kim, D. Kim, C. Jang and M. Sunwoo, “Development of Autonomous Car-Part II: A Case Study on the Implementation of an Autonomous Driving System Based on Distributed Architecture,” IEEE Transactions on Industrial Electronics, Vol. 62, No.8, pp.5119-5132, 2015.

[https://doi.org/10.1109/TIE.2015.2410258]

- SAE J3016, Taxonomy and Definitions for Terms Related to Driving Automation Systems for On-Road Motor Vehicles, SAE, 2014.

-

J. Zhao, B. Liang and Q. Chen, “The Key Technology toward the Self-driving Car,” International Journal of Intelligent Unmanned Systems, Vol.6, No.1, pp.2-20, 2018.

[https://doi.org/10.1108/IJIUS-08-2017-0008]

-

M. J. Choi, H. G. Jung and J. K. Suhr, “Reduction of Particle Filtering Degeneracy Exploiting Lane Number from Digital Map,” Transactions of KSAE, Vol.27, No.5, pp.369-378, 2019.

[https://doi.org/10.7467/KSAE.2019.27.5.369]

-

Y. Kang and A. Madgy, “HiDAM: A Unified Data Model for High-definition (HD) Map Data,” IEEE International Conference on Data Engineering Workshops (ICDEW), pp.26-32, 2020.

[https://doi.org/10.1109/ICDEW49219.2020.00-11]

-

H. Park, “Study on the Korean Accuracy Standards Setting of Digital Map for the Construction and Utilization of Precise Geospatial Information,” Journal of the Korean Society of Surveying, Geodesy, Photogrammetry and Cartography, Vol.31, No.6-1, pp.493-502, 2013.

[https://doi.org/10.7848/ksgpc.2013.31.6-1.493]

- D. Lee and J. Kwon, “A Study on the Possibility of Large Scale 3D Numerical Mapping Using Drone Images,” Proceedings of the Korean Society of Surveying, Geodesy, Photogrammetry, and Cartography Conference, pp.84-87, 2019.

- D. Hwang, I. Kang, D. Park and J. Kim, “Accuracy Assessment of Large-scale Digital Map Using Low-Cost UAV,” Proceedings of the Korean Society of Surveying, Geodesy, Photogrammetry, and Cartography Conference, pp.207-209, 2016.

-

H. G. Seif and X. Hu, “Autonomous Driving in the iCity-HD Maps as a Key Challenge of the Automotive Industry,” Engineering, Vol.2, No.2, pp.159-162, 2016.

[https://doi.org/10.1016/J.ENG.2016.02.010]

- Here, Real Time Maps & Map Data, https://www.here.com/platform/mapping/map-data, , 2020.

- TomTom, TomTom HD Map with RoadDNA, https://www.tomtom.com/products/hd-map/, , 2020.

- Hyundai MnSOFT, HD Mapping Solution for Autonomous Driving, http://www.hyundai-mnsoft.com/EN/technology/hdmappingsolution.mms, , 2020.

- Naver Labs, Naver Labs HD Map Dataset, https://hdmap.naverlabs.com/, , 2020.

- National Geographic Information Institute, Producing High Definition Road Map for Commercialization of Autonomous Vehicle, https://www.ngii.go.kr/eng/content.do?sq=124, , 2020.

- B. Yang, M. Liang and R. Urtasun, “HDNET: Exploiting HD Maps for 3D Object Detection,” Conference on Robot Learning (CoRL) Proceedings, pp.146-155, 2018.

-

H. Cai, Z. Hu, G. Huang, D. Zhu and X. Su “Integration of GPS, Monocular Vision, and High Definition (HD) Map for Accurate Vehicle Localization,” Sensors, Vol.18, No.10, Paper No.3270, 2018.

[https://doi.org/10.3390/s18103270]

-

B. Nagy and C. Benedek, “Real-time Point Cloud Alignment for Vehicle Localization in a High Resolution 3D Map,” The European Conference on Computer Vision (ECCV) Workshops, pp.226-239, 2018.

[https://doi.org/10.1007/978-3-030-11009-3_13]

- K. Jo, C. Kim, S. Cho, S. Myungho and B. Bradai, “Localization of Autonomous Cars Based on the Matching of High-definition(HD) Map and Multiple Sensors,” KSAE Fall Conference Proceedings, pp.742-743, 2018.

-

K. Choi, J. K. Suhr and H. G. Jung, “Landmark Suitability Evaluation of Road Facilities in Highway for Monocular Camera-based Precise Vehicle Localization System,” Transactions of KSAE, Vol.27, No.4, pp.273-290, 2019.

[https://doi.org/10.7467/KSAE.2019.27.4.273]

- G. Gwak, D. Kim, M. Park and S. Hwang, “Development of Path Planning Algorithm for Antonomous Driving based on High Definition Map,” KSAE Fall Conference Proceedings, p.875, 2019.

-

B. Kim, B, Kang, Y. Park and J. Kwon, “A Study on the Improvement Method of Precise Map for Cooperative Automated Driving based on ISO 14296,” Journal of the Korea Institute of Intelligent Transport Systems, Vol.16, No.1, pp.131-146, 2017.

[https://doi.org/10.12815/kits.2017.16.1.131]

-

F. Poggenhans, J. H. Pauls, J. Janosovits, S. Orf, M. Naumann, F. Kuhnt and M. Mayr, “Lanelet2: A High-definition Map Framework for the Future of Automated Driving,” International Conference on Intelligent Transportation Systems(ITSC), pp.1672-1679, 2018.

[https://doi.org/10.1109/ITSC.2018.8569929]

-

M. Althoff, S. Urban, and M. Koschi, “Automatic Conversion of Road Networks from OpenDRIVE to Lanelets,” Proceeding of 2018 IEEE International Conference on Service Operations and Logistics, and Informatics(SOLI), pp.157-162, 2018.

[https://doi.org/10.1109/SOLI.2018.8476801]

- A. Fabris, F. Drost, L. Parolini, Q. Rao, A. Rauch, S. Schneider, S. Wagner and A. Knoll, “Online Map Validation for Autonomous Driving,” Proceedings of ACM Computer Science in Cars Symposium (CSCS), 2019.

-

J. Lee, K. Ahn, T. Lee, K. Min, O. Kwon, S. Baek, M. Park, D. Cho, J. Hwang, J. Kang, S. Lee, D. Seo, J. Kim and Y. Kang, “Development of Control System for International Autonomous Driving Competition Using Robot Operating System,” Journal of Institute of Control Robotics and Systems, Vol.25, No.5, pp.363-373, 2019.

[https://doi.org/10.5302/J.ICROS.2019.19.0022]

-

D. Varnhagen “Electronic Horizon: A Map as a Sensor and Predictive Control,” SAE Technical Paper, 2017.

[https://doi.org/10.4271/2017-01-1945]

- C. Ress, A. Etermad, D. Kuck and M. Boerger “Electronic Horizon - Supporting ADAS Applications with Predictive Map Data,” Proceedings of ITS World Congress, 2006.

-

K. Jo, Y. Jo, J. K. Suhr, H. G. Jung and M. Sunwoo, “Precise Localization of an Autonomous Car Based on Probabilistic Noise Models of Road Surface Marker Features Using Multiple Cameras,” IEEE Transactions on Intelligent Transportation Systems, Vol.16, No.6, pp.3377-3392, 2015.

[https://doi.org/10.1109/TITS.2015.2450738]

- Lanelet2, C++ Library for Handling Map Data in the Context of Automated Driving, https://github.com/fzi-forschungszentrum-informatik/Lanelet2, , 2020.

-

J. Y. Hwang, J. S. Kim, S. S. Lim and K. H. Park, “A Fast Path Planning by Path Graph Optimization,” IEEE Transactions on Systems, Man, and Cybernetics - Part A: Systems and Humans, Vol.33, No.1, pp.121-129, 2003.

[https://doi.org/10.1109/TSMCA.2003.812599]

-

A. R. Soltani, H. Tawfik, J. Y. Goulermas and T. Fernando, “Path Planning in Construction Sites: Performance Evaluation of the Dijkstra, A*, and GA Search Algorithms,” Advanced Engineering Informatics, Vol.16, No.4, pp.291-303, 2002.

[https://doi.org/10.1016/S1474-0346(03)00018-1]

-

X. Jia, K. Li and H. Guan, “A Global Route Planning Method for Intelligent Vehicles,” Proceedings of the 2nd International Conference on Computer Science and Electronics Engineering, pp.1530-1533, 2013.

[https://doi.org/10.2991/iccsee.2013.384]

- Ministry of Land, Infrastructure and Transport, Regulations on the Safety Requirements and Testing of Autonomous Cars, http://www.law.go.kr/LSW/admRulLsInfoP.do?admRulSeq=2100000119909#AJAX, , 2020.

- AI Lab, HD Map Usability Verification for Autonomous Car, https://youtu.be/tznWp5NF4eA, , 2020.