공작기계 초기가공원점 자율인식

Copyright Ⓒ 2020 KSAE / 179-08

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

For the unmanned configuration of the machine tool processing technique, the initial machining origin must be autonomously recognized when the machining material is changed. In general, when changing to a different sized workpiece, the operator must measure the initial machining origin, which has been changed manually or semi-automatically, and the purpose is to recognize and monitor it autonomously. In this paper, we will explain the method and experimental results for the autonomous recognition of the initial machining origin due to material change.

Keywords:

Machining origin, Autonomous recognition, Machine-tool, Unmanned setup, Material change키워드:

가공원점, 자율인식, 공작기계, 셋업무인화, 시편변경1. 서 론

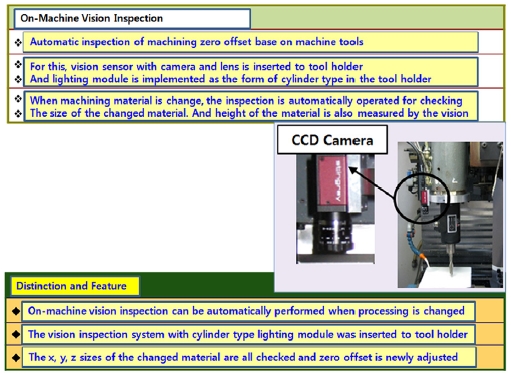

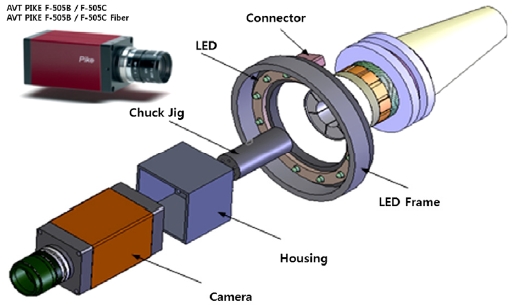

본 논문에서 언급하고자 하는 것은 공작기계에서 가공소재가 변경될 때 새로운 소재를 가공하기 위해 초기 가공원점을 자동으로 감지하여 이를 자율계측함으로써 가공소재가 바뀔때 마다 가공원점을 조그모드로 측정해야하는 시간을 제거하여 생산성을 증대시키는 자동원점 인식방안 및 컨셉구조에 관한 것이다. 여기서 중점을 둔 부분은 공작기계에 별도의 센싱장치 탈부착 및 설치가 필요없이 내장된 하나의 비젼센서를 이용하여 X/Y/Z 3축에 대한 초기 가공원점을 자동으로 계측함으로써 바로 다음 공정인 가공이 가능한 셋업 무인화를 위한 장치 구성 및 메커니즘이다. 이를 위한 장치구성을 살펴보면 다음과 같다. 인식장치는 자동툴체인져(ATC)에 사용되는 척의 개조와 렌즈 및 카메라로 구성되는 이미지 센서, 드릴척 외관에 지지되어 이미지 센서에 일정한 광량을 제공하는 조명부, 이러한 센서 및 조명부의 전원 및 신호선을 외부로 전달시키는 컨넥트부, 이미지 센서로부터 입력되는 이미지를 실시간으로 획득하여 필터 및 가공원점을 도출하는 이미지 컨트롤러부로 구성된다. 메커니즘 측면에서는 공작기계 셋업 자율화 및 무인화에 적합하도록 별도의 추가 센서 설치외에 가공기에 내장된 단일 센서 기반으로 3축 자율 정밀 계측이 가능하게 한 것이 특징이다.1,2)

2. 필요성 및 기존 문제점

초기원점은 공작기계를 이용한 가공과정에서 기계원점으로 복귀 후 각 축에 해당하는 소재의 가공 시작점으로써, 작업자는 새로운 가공물에 대해 항상 조그모드로 소재와 공구를 저속으로 접촉시켜 각 축의 기계원점에서 소재까지의 상대적인 거리를 측정하여 설정해야한다. 소재와 공구의 마찰을 작업자의 시각과 청각에 의존하여 설정함으로 인해 가공원점의 정밀한 측정에는 한계가 존재하여 가공후 제품의 형상오차를 유발하여 대표적인 원인이다. 생산성을 확보하는 측면과 제품의 가공형상 오차를 제거하는 측면에서 이러한 수동작업은 반드시 제거되어야 한다.3-8) 기존의 자동원점 보상에 대한 방법은 ATC에 입력된 공구의 치수 정보와 새로운 가공소재의 치수정보를 기입하여 자동으로 가공원점을 설정하는 방법이 대표적인 방법으로서 이 방식은 입력되는 소재의 치수 정보에 오차가 존재할 경우와 오차가 허용범위 안에 있을지라도 바이스에 소재를 물릴 경우 발생하는 각 축과의 정렬오차가 존재할 경우 가공원점은 필연적으로 오차를 가질 수밖에 없다.

구체적으로 살펴보면 일반적인 가공라인에서의 플로우는 가공물이 가공된 후 작업자가 새로운 소재를 장착한 후 가공원점을 수동으로 설정한다. 수동설정의 대표적인 방식은 스핀들을 회전시킨 후 절삭공구를 최대한 공작물에 가깝게 위치시킨 후 이송속도를 최소로하여 이송시켜가면서 공구와 소재의 접촉 시 발생하는 소음으로 각 축의 가공원점을 도출한다. 현재의 작업플로우에서 소재의 탈부착은 완전자동화가 가능하지만 가공원점의 자동화는 현재 어려운 실정이다. 이를 해결하기 위해서는 Fig. 1처럼 영상계측처리 장치가 기존의 가공 척 또는 가공 툴홀더와 결합되어야 한다. 즉 툴홀더와 결합된 무선 영상 처리 장치는 공구 자동 체인지 장치 즉 ATC에 삽입될 수 있다.

3. 장치 컨셉 및 메커니즘

본 연구의 영상처리 비젼계측 프로토타입 시스템은 공작기계에서 새로운 소재를 가공하기 위해 가공원점을 자동으로 감지하여 이를 보상함으로써 가공소재가 바뀔때 마다 가공원점을 조그모드로 측정해야하는 시간을 제거하여 생산성을 증대시키는 자동원점 인식시스템에 관한 것이다. 자동원점 인식장치는 자동툴체인져(ATC)에 사용되는 척의 개조와 렌즈 및 카메라로 구성되는 이미지 센서 등 임베디드 영상처리 비젼계측 장치 구성부는 Fig. 2와 같다.

비젼센서 모듈을 가공 툴홀더에 장착하여 On-Machine에서 투입가공물의 Setup 또는 장착 양부판정, 가공 후 가공부위 미가공 불량검사 및 치수측정 등을 함으로써 판단 및 측정기능을 실제 기계에 적용하여 무인화에 기여 한 것이 특징이다. 특히 자율재구성 생산시스템에서는 기계 및 주변기기의 재구성에 따른 가공공정 및 가공소재가 자주 변경이 될 수 있기에 이에 따른 비젼계측을 통한 가공원점 자동인식이 필요하다. 현재는 대부분 작업자에 의하여 가공소재가 변경 시 두께 및 넓이가 달라짐에 따라 가공원점을 조그모드에서 수작작업 제어로 세팅을 하게 된다. 이를 극복하는 방법이 Fig. 1처럼 본 논문에서 제안하는 임베디드 비젼계측을 통한 가공원점 자율인식 기능이다. 초기 가공원점 자율 인식시스템은 이미지를 처리하는 임베디드 장치에서 기존의 소재에 대한 정보를 저장할 수 있기 때문에 획득된 이미지에서 일정 부분만을 필터처리하여 원점도출이 가능하여 동일한 소재로 작업할 경우 매우 빠른 시간 안에 새로운 가공원점의 도출이 가능하다. 또한 임베디드 시스템에 무선통신 모듈인 블루투스를 부착할 경우 원격으로 이러한 정보를 CNC 컨트롤러와 작업자에게 송수신이 가능함으로 실시간으로 현재와 이전의 가공원점에 대한 이력을 DB화 할 수 있는 장점이 있다.

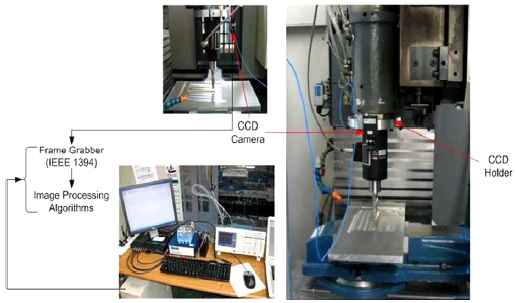

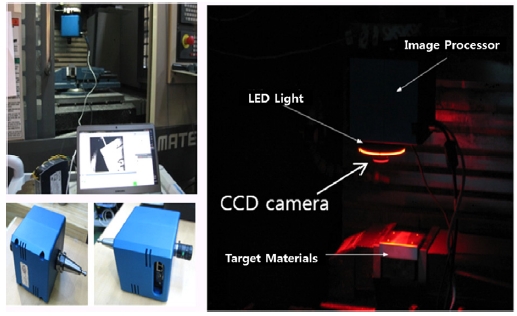

Fig. 3은 자동으로 가공원점을 검출하기 위해 구성된 실험장치를 나타내고 있다. 공작기계는 MCT 3호기 수직형 머시닝센터로 툴은 BT30척을 주로 사용한다. 카메라는 스핀들에 CCD홀더로 고정되어 있으며, 카메라의 측정 결과는 Frame Grabber로 전송되고 이를 프로그램에서 캡쳐/처리하여 가공원점을 도출한다. 영상이미지는 외부 진동과 노광에 따라 왜곡정도가 달라진다. 따라서 본 과제에서는 일정한 노광에서 실험하기 위해 동일 시간에 실험을 수행하였다.

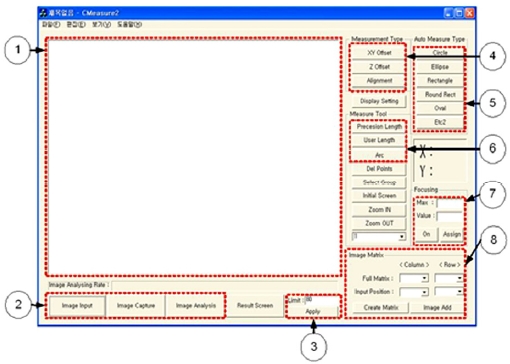

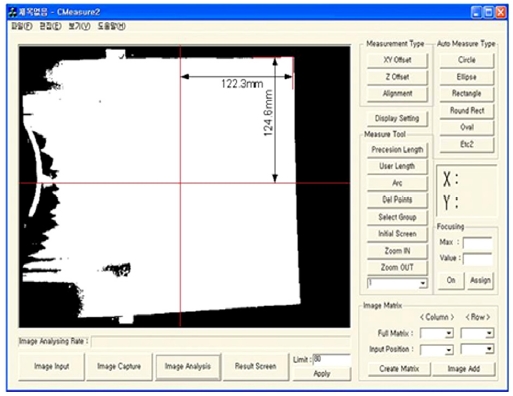

Fig. 4는 가공원점을 도출하기 위해 개발된 계측 프로그램을 나타내고 있다. 프로그램은 크게 8가지 기능으로 구성된다. ①은 카메라에 측정된 이미지 및 필터 처리와 같은 가공된 이미지의 결과를 나타내는 창이고, ②는 카메라에서 프로그램은 이미지를 가져오기 위해 카메라 설정 부분과 불러온 이미지를 처리하는 기능을 담당하고 있다. ③은 위에서 언급한 이미지의 이진화시 사용되는 임계치를 설정하는 부분이고, ④는 이미지에서 X,Y,Z축 Offset을 계산하기 위한 알고리즘을 호출하는 부분이다. ⑤는 가공소재가 정사각형이 아닌 경우에도 측정분석이 가능하도록 설정하는 것으로서 가공 소재의 형상을 미리 설정하는 부분이다. ⑥은 처리된 이미지에서 직선 또는 원주 길이를 측정하는 기능을 담담하고 있고 ⑦은 가공소재의 Z축 가공원점을 오토 포커싱으로 도출하기 위한 기능인데, 당해년도에서는 이 기능은 구현하지 않았다. ⑧은 가공소재가 카레라의 FOV를 벗어나는 경우를 고려해 여러장의 이미지를 처리할수 있도록 각 부분의 이미지를 Matrix화 하여 처리하는 부분이다.

Fig. 5는 카메라부터 읽어들인 이미지 결과를 보여준다. 가공원점을 찾아내기 위해 이미지 처리 즉 Binary화 시킨 결과를 나타 내었다. 매칭에 있어서 대응점을 찾는 일은 동일한 물체나 장면을 포함하는 다수의 영상에서 같은 위치에 있으면서 동일한 특징을 갖는 점들을 찾는 것으로, 컴퓨터 비전에서 대응점을 찾는 일은 필수적인 일의 하나로 카메라 보정, 물체인식 분야에 활용되고 있다. 한편 위치 추정을 위해 선분 특징점을 이용한 기존 연구도 있으며, 스케일 정보를 갖지 않는 특징점을 다중크기 영상으로 학습시키는 방법을 활용하여 실시간으로 물체를 인식 및 추적하는 연구도 있다. 하지만 스케일이나 조명환경, 그리고 시점이 변화된 영상에서 대응점을 찾는 것은 쉬운 일이 아니다. 다양한 환경에서 지역적인 특징을 이용하여 대응점을 찾기 위해서는 크게 특징점 추출과 표현자생성의 두 가지 과정이 필요하다.

첫 번째 특징점 추출 과정은 영상에서 환경이 변하더라도 강인하게 찾아질 수 있는 특징의 위치를 찾는 것이다. 특징점은 대응되는 영상에서도 물리적으로 동일한곳에 위치하여야 하며, 다른 영상에서 해당 특징점이 찾아질 확률 또한 높아야 한다. 두 번째 과정은 이전 과정에서 찾은 특징점을 설명할 표현자를 만드는 과정이다. 표현자는 환경 변화에 불변하는 특징을 가져야 하며, 다른 특징점과 구분되어야 한다. 마지막으로 찾아진 특징점의 표현자를 비교하여 매칭점을 찾을 때 속도를 향상 기키기 위해 최소한의 데이터를 이용하여 표현자를 만들어야 한다. 특징점을 찾고, 표현자를 생성하는 방법은 여러 가지가 있는데 이중에서 가장 대표적인 방법으로 스케일 불변 특징변환과 고속의 강인한 특징 추출 알고리즘이 있다. 두 알고리즘은 흑백 영상으로부터 스케일, 회전변환에 불변하는 특징점을 찿고, 표현자를 구성하는 공통점이 있다. 여기서는 필요에 따라 사용자가 선택하여 적용하도록 프로그래밍 하였다. 여기서는 Fig. 5처럼 2차원적으로 가로 세로 초기가공 원점을 자동 계측하는 기능을 확인하였다. 확인 방법은 모멘트 기법과 최소자승법에 근거한 에지추출 메커니즘을 통하여 가로 세로 시편의 위치를 파악한다. 다음 챕터에서는 선명도 제어를 통한 오토포커싱 기반의 3차원 비젼계측 실험에 대하여 언급하고자 한다.

4. 3차원 가공원점 계측 비젼 실험

Fig. 6은 3차원 초기 가공원점 자율인식 계측실험을 위한 영상처리장치 및 성능평가 실험 환경을 나타내고 있다.

별도의 센서 및 계측 장치 설치 없이 가공셋업 무인화 및 자동화를 위해서는 가공툴에 임베디드된 비젼센서 하나만으로 변경된 가공 소재의 가로, 세로 및 두께까지 측정하는 3차원 측정 방안이 필요하다. 본 논문에서는 이를 위한 두께 측정을 선명도 제어를 통한 오토포커싱 기능 구현을 통하여 두께인 초기 가공원점 높이 Z축 보정제어가 자동으로 이루어지도록 하였으며 이 상태에서 가로 세로 X/Y 계측을 하게 된다. 선명도 제어를 통한 오토포커싱 기능이 잘 되지 않는다면 희미한 영상 상태에서 당연히 가로 세로 측정이 원하는 정밀 측정되지 않기에 선명도 제어 통한 두께 측정이 가능하도록 Z축 CNC 보정제어 후 가로 세로 정밀 측정이 가능한 깨끗한 영상을 획득하는 것이 본 연구 메커니즘에 구현되었다. 물론 정밀도를 더 높이기 위해서는 별도의 두께 높이 측정용 레이저나 갭 센서 등을 설치하면 더 좋으나 그렇게 되면 셋업 정밀도는 높일 수 있으나 가공척이나 툴에 내장된 센서 외에 별도로 설치된 측정장치 및 주변 장치들로 인하여 바로 가공에 들어갈 수 없기에 무인화 및 자동화를 위해서 내장된 비젼 센서가 상하로 움직이게 제어하는 오토포커싱 기능을 구현하였다. 즉 가공소재와 공구간의 거리를 판단하는 이미치 처리 방법으로 방법은 다음과 같다. 영상에서 획득한 이미지에서 에지라인 검출 로직을 적용한 후 검출된 에지라인의 강도를 초기값으로 설정한 후 Z축을 특정거리 하향 이송시키는 지령을 CNC에 전달한다. 이송이 완료됨과 동시에 영상을 다시 획득하여 에지라인의 강도를 재 계산하고 이를 초기 설정된 값과 비교하여 크다고 판단되면 이 값을 다시 초기값으로 하여 위의 수행을 반복한다. 즉 에지라인 강도값이 지령 후 갱신되는 강도값보다 작은 경우를 만족할 때 까지 반복 수행한다. 에지라인 강도가 초기값보다 작은 경우는 Z축을 특정거리 상향시켜 동일한 과정을 반복한다. 특히 초기값의 강도가 이송후 반대 방향으로 변화되는 경우 이송거리를 더욱 미세화하여 반복 수행한다. 세부 로직에 대한 설명은 아래에서 자세히 기술한다. 셋째 이미지 장치에서 송신된 지령에 대해 CNC를 구동시키기는 방법은 NC커널과 관계된 함수를 호출함으로서 실제 요구된 지령을 수행한다. 넷째 일반적으로 실가공이 이루어지는 작업모드에서는 축의 이동에 대한 지령이 불가능하기 때문에(NC커널 설계 개념) 조그모드에서 이를 해결하였다. 조그모드에서 지령 명령을 수행하기 위해서는 기존 PLC로직을 변경하여 특정 버튼을 눌려지는 것을 트리거 신호로 설정하고 특정 버튼에 대한 ON/OFF는 소프트웨어에서 지령하는 것으로 하였다.

5. 실험 고찰

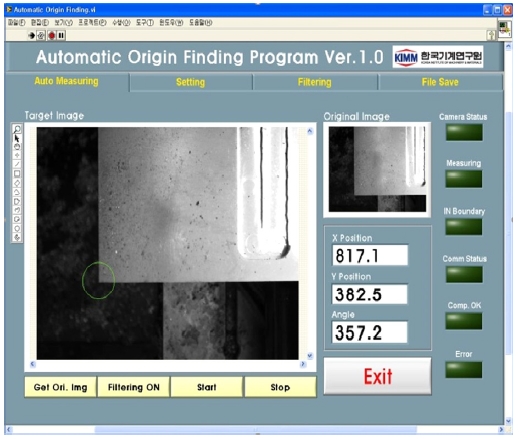

가공원점 도출의 정밀도를 측정하기 위해 X축 1회당 2 mm 씩 이동시키며 10 mm까지 5회, Y축 1회당 2 mm씩 이동시키며 10 mm까지 5회, XY축을 동시(대각선방향)에 1회당 2 mm씩 10 mm까지 5회, 총 15회 테스트 하였다. 축이동 완료시 CNC컨트롤러 포지션모니터링과 Vision계측 프로그램으로 획득한 위치값의 차이로 셋업정확도를 산출하였고 총 15회의 셋업정확도를 평균한 결과이며, 보통 현장에서 100 um(0.1 mm)이하이면 밀링 등 가공공정에서 기존 수동이나 반자동 방식대비 오차면에서 높은 실용성이 있는데 이보다 좋은 정밀도인 셋업계측 정확도 0.047 mm를 평균적으로 달성하였다. 이는 오토포커싱에 의한 소재 두께인 높이를 선명도 제어를 통하여 인식한 후 가공소재의 가로 세로 정확도를 측정하는 실험으로 가공척에 내장된 하나의 비젼센서로 3축에 대한 정밀 자율인식이 가능하여 바로 다음 공정인 가공이 가능한 공작기계 셋업 무인화를 이우었다는 점에 의의가 크다. 구체적인 방법은 다음과 같다. 가공물 장착하면 비젼 계측을 통하여 레퍼런스 이미지와 패턴매칭 알고리즘 적용 후 포지션값 모니터링 및 계측이 이루어지며 CNC컨트롤러 포지션 모니터링과 오차를 비교한다. 최종적으로 총 15회의 셋업 정확도를 축 별로 테스트 한 결과를 평균한 결과 셋업계측 정확도 0.05 mm 이내를 달성하였다. Fig. 7에 실험 GUI 프로그램 화면을 나타내었으며 Table 1은 X/Y축을 동시에 2 mm씩 이동시켜 계측한 X/Y축의 반복 재연에 따른 오차 정밀도 결과를 나타낸 것으로 기존 수동 및 반자동에 의한 오차 0.1 mm보다 적은 만족할 만한 오차범위를 가진다.

6. 결 론

본 논문에서는 가공 소재변경에 따라 수동 세팅으로 인한 시간 지연 감소 위한 일환으로 효과적인 접근방안을 분석하고 이에 따른 컨셉구조 분석 및 기반실험 등 기본 연구를 수행하였다. 아울러 소프트웨어적인 측정 기능구현 및 빌트인 센서 적용 연구 등 보다 구체적인 실증 연구를 통하여 계측정확도 등 결과를 제시하였으며 이는 공작기계에 셋업 무인화에 적합한 수준으로 무인화 및 자율화에 필수적으로 요구된다.

기존에는 일반적인 가공라인에서의 플로우는 가공물이 가공된 후 작업자가 새로운 소재를 장착한 후 가공원점을 수동으로 설정한다. 수동설정의 대표적인 방식은 스핀들을 회전시킨후 절삭공구를 최대한 공작물에 가깝게 위치시킨 후 이송속도를 최소로하여 이송시켜가면서 공구와 소재의 접촉시 발생하는 소음으로 각 축의 가공원점을 도출한다. 현재의 작업플로우에서 소재의 탈/부착은 완전자동화가 가능하지만 가공원점의 자동화는 현재 어렵기 때문에 가공라인의 완전자동화는 어려운 실정이었다. 따라서 번 연구에서 개발한 임베디드 영상처리 장치는 기존의 툴홀더와 결합된 처리 장치로 공구 자동 체인지 장치인 ATC에 삽입이 가능하여 매우 실용적이다.

따라서 기존의 자동원점 보상에 대한 방법인 ATC에 입력된 공구의 치수 정보와 새로운 가공소재의 치수정보를 기입하여 자동으로 가공원점을 설정하는 대표적인 방법이 가지는 입력되는 소재의 치수 정보에 오차가 존재하는 경우와 오차가 허용범위 안에 있을지라도 바이스에 소재를 물릴 경우 발생하는 각 축과의 정렬오차가 존재하는 경우를 차단함으로써 변경 소재시 초기 가공원점에서 발생하던 필연적 오차를 제거하는 효과를 만들었다.

또한, 본 연구에서 제안하는 자동원점 인식시스템은 이미지를 처리하는 장치에서 기존의 소재에 대한 정보를 저장할 수 있기 때문에 획득된 이미지에서 일정 부분만을 필터처리하여 원점도출이 가능하기에 동일한 소재로 작업할 경우 매우 빠른 시간안에 새로운 가공원점의 도출이 가능하다. 또한 시스템에 무선통신 모듈인 블루투스를 부착할 경우 원격으로 이러한 정보를 CNC 컨트롤러와 작업자에게 송수신이 가능함으로 실시간으로 현재와 이전의 가공원점에 대한 이력을 DB화 가능하게 할 수 있는 장점이 있어서 공작기계 셋업 자율화 및 무인화에 기여가 매우 클 것으로 기대된다.

Acknowledgments

여기에 이 논문은 과학기술정보통신부 국가과학기술연구회 사업(No. NK224A-KIMM, No. CRC-19-02-ETRI)의 지원으로 수행되었음.

References

-

H. S. Park and V. M. Tuladhar, “Robust Inspection Technique for Detection of Flatness Defects of Oil Pans,” Int. J. Automotive Technology, Vol.17, No.1, pp.119-126, 2016.

[https://doi.org/10.1007/s12239-016-0011-3]

-

X. Zhao, R. Hao, Z. Zhou, A. Ashour and N. Dey, “Novel Bench-based Inspection Approach for Automobile Anti-lock Braking System,” Int. J. Automotive Technology, Vol.19, No.5, pp.825-836, 2018.

[https://doi.org/10.1007/s12239-018-0079-z]

-

L. Schouveiler, A. Brydon, T. Leweke and M. C. Thompson, “Interactions of the Wakes of Two Spheres Placed Side by Side,” European Journal of Mechanics - B/Fluids, Vol.23, No.1, pp.137-145, 2003.

[https://doi.org/10.1016/j.euromechflu.2003.05.004]

-

D. H. Kim, and J. Y. Song, “Ubiquitous-Based Mobile Control and Monitoring of CNC Machines for Development of u-Machine,” Journal of Mechanical Science and Technology, Vol.20, No.4, pp.455-466, 2006.

[https://doi.org/10.1007/BF02916476]

-

D. H. Kim and J. Y. Song, “Knowledge -Evolutionary Intelligent Machine-Tool - Part 1: Design of Dialogue Agent based on Standard Platform,” Journal of Mechanical Science and Technology, Vol.20, No.11, pp.1863-1872, 2006.

[https://doi.org/10.1007/BF03027579]

-

P. K. Wright, “Principles of Open-architecture Manufacturing,” Journal of Manufacturing Systems, Vol.14, No.3, pp.187-202, 1995.

[https://doi.org/10.1016/0278-6125(95)98886-B]

-

I. Yellowley and P. R. Pottier, “The Integration of Process and Geometry within an Open Architecture Machine Tool Controller,” International Journal of Machine Tools & Manufacture, Vol.34, No.2, pp.277-293, 1998.

[https://doi.org/10.1016/0890-6955(94)90106-6]

-

E. Budak and Y. Altintas, “Analytical Prediction of Chatter Stability in Milling - Part1 : General Formulation,” Journal of Dynamic System, Measurement and Control, Vol.120, No.1, pp.22-30, 1998.

[https://doi.org/10.1115/1.2801317]