감시 카메라 영상의 비조화비를 이용한 차량 사고 분석

Copyright Ⓒ 2019 KSAE / 167-03

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

Vehicle speed estimation is the most important task in car accident reconstruction and intelligent transportation system design. Recent studies have been conducted in order to evaluate the speed of a vehicle by using the images of various surveillance cameras. However, the limitation is that it is necessary to know whether the calibration coefficient of the camera or only the average speed analysis of a specific interval is possible. In this study, we propose a novel technique for estimating vehicle speed by using a vehicle or structure already recognized as geometric information from the uncalibrated surveillance camera. The digital image processing technique tracks the specific coordinates information in all video frames and calculates the velocity change according to the video frame rate by using a cross ratio, which is the perspective invariant. The results of this method are verified through simulation and actual car evaluation. As a result, it is confirmed that it is possible to accurately analyze the change in the moving speed of a vehicle in different conditions.

Keywords:

Vehicle speed, Moving distance, Cross-ratio, Digital image processing, Surveillance camera키워드:

차량 속도, 이동 거리, 비조화비, 디지털 영상처리, 감시 카메라1. 서 론

차대차, 차대사람 충돌과 같은 교통사고를 재구성하는 데 있어 충돌 전의 차량 속도는 매우 중요한 요소가 되며, 특히 충돌 전 정확한 차량 속도는 사고해석 결과의 신뢰성을 높일 수 있다.1,2) 과거 CCTV나 블랙박스와 같은 영상이 없을 시 차량의 속도를 추정하기 위해서는 사고 당시 충돌로 형성된 노면의 타이어 흔적이나 차량 파편의 비산 흔적 등을 물리학 운동방정식에 적용하여 계산하는 방법을 사용하였다.3) 따라서 흔적을 구분하고 흔적발생 원인을 분석하려면 숙련된 지식을 필요로 하며, 시험을 통해 구한 마찰계수와 같은 특정 계수값을 방정식에 적용함으로써 오차범위가 커지는 단점이 있다. 이에 따라 최근에는 영상분석을 통해 사고 전 상황의 특정 구간을 이동한 차량의 평균속도를 분석하는 방법이 사용되고 있다.4) 이뿐 아니라 지능형 교통 시스템(ITS, Intelligent Transportation System)에서도 다양한 영상데이터를 이용하여 주행 차량에 유용한 정보를 제공하는 기술에 관심이 증가하고 있다.5,6) 교통시스템에서 일반적으로 차량 속도를 측정하기 위해서는 노면에 설치된 센서를 이용하여 구간속도를 측정하고 있으나, 설치와 관리 비용이 높을 뿐 아니라 차량의 순간속도가 아닌 구간의 평균속도를 제공하는 문제가 있다. 따라서 최근에는 도로에 설치된 감시 카메라의 영상정보를 이용하여 차량 속도와 이동량 등을 분석하는 연구가 수행되고 있다. 이는 CCTV와 블랙박스와 같은 감시 카메라의 하드웨어 및 소프트웨어 사양이 높아지고, 가격이 낮아지면서 영상데이터의 양과 질이 향상될 뿐 아니라 다양한 컴퓨터 비전 및 영상처리 알고리즘이 개발 및 적용되고 있기 때문이다. 일반적으로 감시 카메라의 영상데이터에서 차량 속도를 산출하기 위해 카메라의 보정인자를 구하고 영상 내 차량을 검출하여 각 영상 프레임 분석을 통해 속도를 산출하고 있다. 해당 방법은 교통사고 감정과 같이 제시된 감정 영상을 녹화한 카메라들의 보정인자를 구할 수 없는 경우에는 적용에 어려움이 있다. 따라서 영상 내 차량이나 건물 등과 같이 이미 공간정보를 알고 있는 요소를 이용해 카메라를 보정하고 속도를 산출하는 연구가 수행되고 있다.7-13) 그 중 영상 데이터로부터 사영기하학의 비조화비(Cross Ratio)라는 사영불변량을 이용하여 차량속도를 계산하는 연구가 법과학분야에서 발표되었다.14,15)

본 연구에서는 비조화비와 컴퓨터 비전 알고리즘을 통해 영상에서 차량의 특정 부분을 검출하고 추적하여 차량 속도를 산출하였다. 또한, 영상 내 모든 프레임의 비조화비를 이용하여 차량 속도 오차를 최소화하고 다양한 조건에서 차량 속도를 계산하였다. 이를 검증하기 위해 PC-Crash 10.1을 이용한 시뮬레이션 결과와 비교하였으며, Vbox를 이용한 실차평가 결과와도 비교하였다. 마지막으로 감정 의뢰된 영상을 분석하여 기존방법 결과와 비교하고 실제 사례에 적용하였다.

2. 차량 속도계산

2.1 영상처리를 이용한 차륜 추적

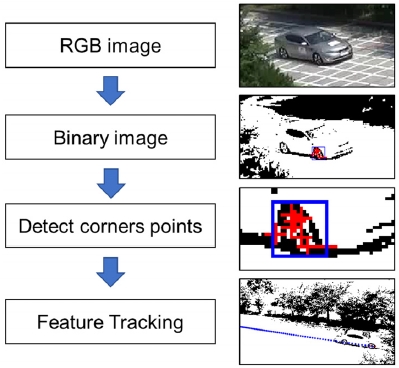

영상에 차륜의 중심 좌표를 추출하기 위해 Fig. 1과 같은 순서도로 디지털 영상처리(Digital Image Processing)를 수행하였다. 첫 단계로 Otsu 방법으로 구한 임계값을 이용하여 영상의 첫 번째 프레임의 RGB이미지를 Binary이미지로 변환하고, 형상의 윤곽선을 추출하였다. Otsu의 방법은 흑백 픽셀의 클래스 내 분산을 최소화하는 것으로 효과적인 임계값을 선택할 수 있다. 다음으로 최소 고유값 알고리즘(Minimum eigenvalue algorithm)을 이용하여 모서리 영역에 해당하는 좌표를 추출하였다. 마지막으로 KLT 알고리즘(Kanade-Lucas-Tomasi)을 적용한 형상추적(Feature tracking)을 이용하여 각 프레임에서 모서리 영역의 좌표들을 추적하였다. 각 프레임의 화면에서 추적된 좌표들의 신뢰 점수(Confidence score)와 평균을 이용하여 차륜의 중심 좌표를 도출하였다.

2.2 비조화비 (Cross-Ratio)

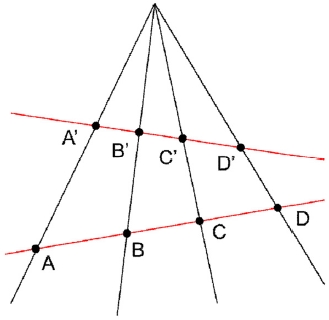

사영변환(Perspective Transformation)은 한 평면에서 다른 평면으로 직선의 직선성을 유지하는 선형 변환이다. 이를 다루는 사영기하학에서는 Fig. 2와 같이 서로 다른 두 직선은 한 점에서 만나게 된다.

Fig. 2와 같이 사영기하학에서 같은 직선 위에 있는 네 점의 비조화비는 식 (1)과 같이 표현하고 사영불변량으로써 식 (2)와 같은 성질을 가지고 있다.

| (1) |

| (2) |

이를 이용하면 점(ABCD)가 있는 직선이 실제 3차원 공간이라고 할 때, 점(A′B′C′D′)가 있는 직선은 카메라 영상에 투영된 2차원 평면으로 치환되며, 양 차원 간의 비조화비라는 사영불변량을 가질 수 있다.

2.3 비조화비를 이용한 이동 거리 계산

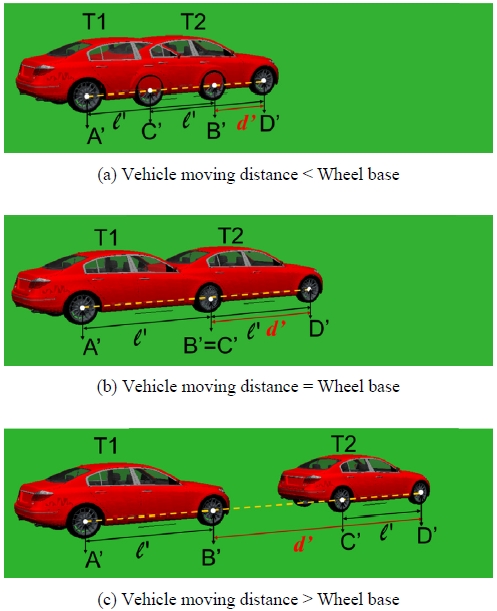

영상의 재생이란 정지된 각각의 화면이 프레임 레이트에 따라 보이는 것으로 프레임 레이트는 1초 동안 보여주는 화면의 수를 의미하며, 단위는 FPS(Frame Per Second)를 사용한다. 차량이 이동하는 영상에서 T1과 T2시간의 정지화면을 취득하여 합성하면 Fig. 3과 같이 차량의 이동거리가 축거보다 작을 경우, 축거와 같을 경우 그리고 축거보다 큰 경우로 나눌 수 있다.

여기서 l′는 영상 화면에 투영된 차량의 축거를 나타내고 d′는 영상 화면에서 시간 T1에서 T2까지 차량의 이동 거리를 의미한다. 이동 거리를 구하기 위해 영상의 모든 정지화면에서 전후 차륜의 중심 좌표를 추출하고 사영불변량인 비조화비를 계산한다. 다음으로 실제 3차원 공간에 대응하는 직선AB와 직선CD는 차량의 제원에 해당하는 축거로써 항상 같은 값을 가지며, 따라서 차량이 실제 움직인 거리인 d는 다음과 같이 구할 수 있다.

| (3) |

2.4 비조화비를 이용한 차량 속도계산

위에서 구한 이동 거리로부터 차량 속도는 식 (4)와 같이 구할 수 있다.

| (4) |

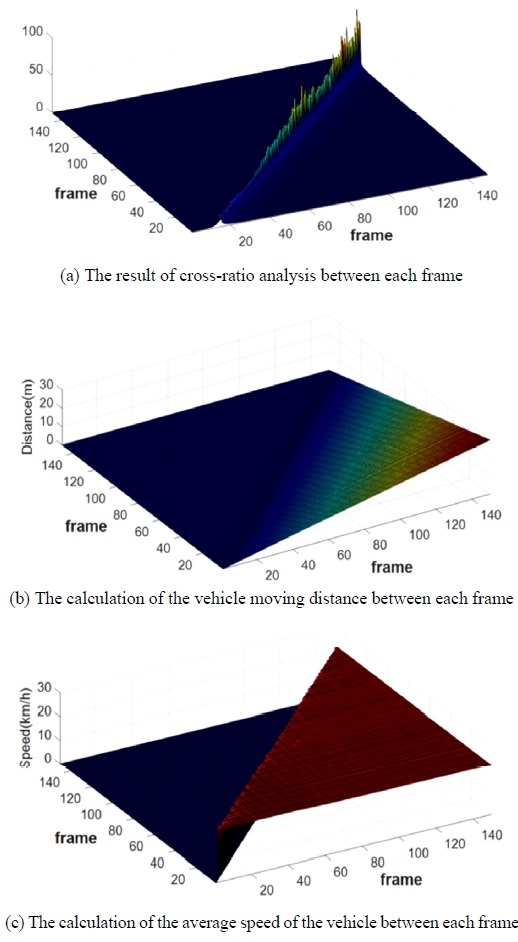

vi,j는 i번째 프레임과 j번째 프레임 사이에 이동한 차량의 평균속도를 나타내고, di,j는 i번째 프레임에서 j번째 프레임까지 차량이 이동한 거리이다. 다음으로 FPS는 프레임 레이트를 나타내며 |i-j|는 두 프레임 사이의 프레임 개수를 의미한다. 즉, Fig. 4와 같이 분석하고자 하는 영상을 구성하는 프레임 간의 비조화비를 이용하여 총 프레임 개수 제곱의 반에 해당하는 계산 결과를 얻을 수 있다.

Fig. 4(a)의 비조화비 결과를 살펴보면 특정 영역에서는 10 이상의 큰 값을 가지는 것을 볼 수 있는데, 이는 비조화비의 분모에 해당하는 직선BC의 길이가 매우 짧을 경우, 즉 차량의 이동 거리가 축거와 비슷한 상황에 해당한다. Fig. 4(b)는 각 프레임 간의 차량의 이동 거리를 계산한 결과이고, Fig. 4(c)는 각 프레임 간의 차량의 평균속도를 계산한 결과이며 그래프의 기울기를 통해 영상 내 차량이 등속 주행을 했는지 또는 가・감속 주행을 했는지 분석할 수 있다.

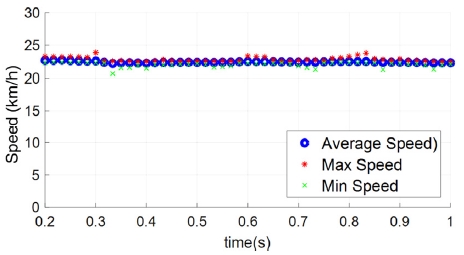

본 연구에서는 영상 내 한 시점의 속도를 계산하기 위해 영상의 모든 프레임에 Fig. 5와 같이 최대, 최소, 평균 등을 분석하는 통계적 방법을 적용함으로써 결과값의 신뢰성을 높일 수 있다. 그뿐만 아니라 영상의 프레임 레이트에 해당하는 시간 간격으로 차량 속도를 계산함으로써 차량의 속도변화를 분석할 수 있는 장점이 있다.

3. 비조화비 속도분석의 검증

3.1 시뮬레이션

본 연구에서는 운동량보존법칙 및 에너지보존법칙을 기반으로 사고에 대한 역학적 해석 및 3차원의 사고 재구성이 가능한 PC-Crash를 사용하였다.16) 소프트웨어로 차량 주행 상황을 모사하고 카메라 기능을 이용하여 30FPS 영상을 녹화하였다. 해석에는 국내에서 판매량이 비교적 높은 쏘나타 차량(현대자동차, 2008년식)과 그랜저 차량(현대자동차, 2006년식)을 이용하였고, 해당 차량의 축거는 각각 2.73 m와 2.78 m이다.

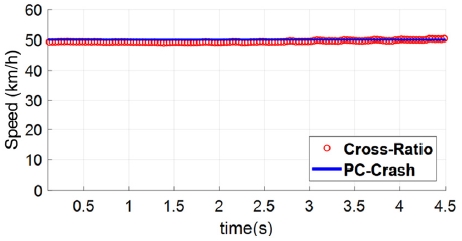

PC-Crash 상에 Fig. 6과 같이 직선 도로를 시속 50 km/h의 등속도로 움직이는 쏘나타 차량을 모사하였다. 디지털 영상분석으로 총 140개의 프레임 즉, 약 4.67초 동안의 영상에서 쏘나타 차량의 전후 차륜 중심 좌표를 구하였다. 구해진 차륜 중심의 좌표와 비조화비를 이용하여 계산된 속도와 PC-Crash상의 속도를 비교한 결과, Fig. 7과 같이 매우 유사한 것을 확인할 수 있다.

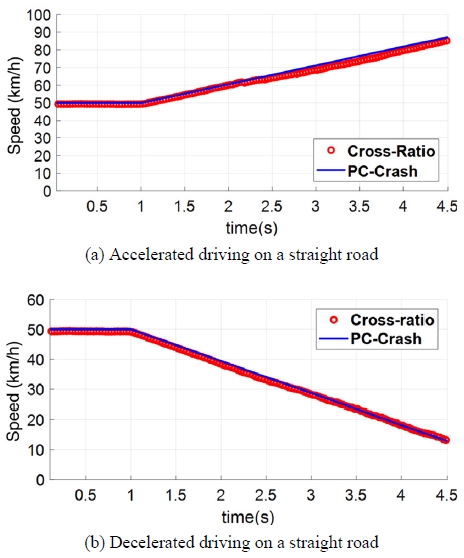

Fig. 6과 동일한 직선 도로를 시속 50 km/h로 주행하던 쏘나타 차량이 일정한 가속도로 가속 그리고 감속하는 상황을 모사하고 영상을 녹화하였다. 녹화된 영상을 비조화비를 이용하여 분석한 결과와 PC-Crash상의 해석된 결과가 Fig. 8(a)와 같이 속도의 상승 시점과 상승하는 기울기가 유사하며, Fig. 8(b)와 같이 속도가 하강하는 시점과 하강 기울기가 유사한 것을 확인할 수 있다.

PC-Crash상에 Fig. 9와 같은 곡선 도로를 주행하는 그랜저 차량을 모사하여 영상을 녹화하였다.

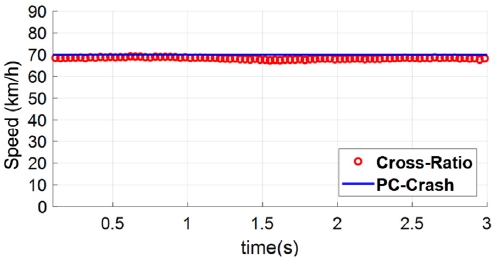

시속 70 km/h의 속도로 등속 주행하는 그랜저 차량의 경우 Fig. 10과 같이 PC-Crash 10.1로 해석된 차량의 속도와 비조화비를 이용하여 계산된 차량의 속도가 유사한 크기를 가짐을 알 수 있다.

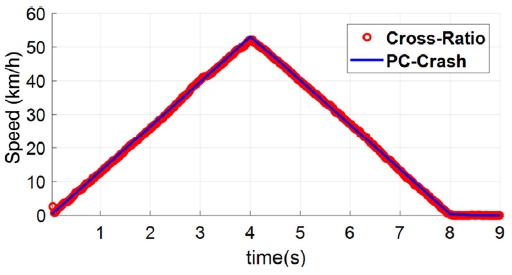

Fig. 9와 동일한 도로 상황에서 정지된 그랜저 차량이 가속하다가 감속하여 다시 정지되는 상황을 모사하였다. 그 결과 Fig. 11과 같이 가속하는 기울기와 감속하는 시점, 그리고 감속하는 기울기가 일치함을 확인할 수 있다.

지금까지 살펴본 PC-Crash를 이용한 다양한 조건에서의 차량의 속도와 Cross-ratio를 이용한 속도분석을 비교하면 Table 1과 같이 최대 오차가 3.68 %로 매우 정확한 결과가 나오는 것을 확인하였다.

3.2 실차평가

캠코더에 녹화된 차량의 주행 영상을 분석하기 위해 차량에는 Vbox를 장착하여 차량의 이동속도를 측정하였다. Vbox는 영국의 RACELOGIC社에서 개발한 장비로써 100 Hz의 주기의 GPS정보를 이용하여 차량의 진행경로, 속도 등을 실시간으로 취득할 수 있다.

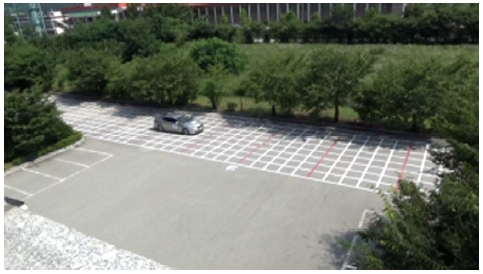

시험 차량은 옵티마 하이브리드(기아자동차, 2014년식)이며, Fig. 12와 같은 격자무늬가 그려진 도로에서 직선으로 주행하였다.

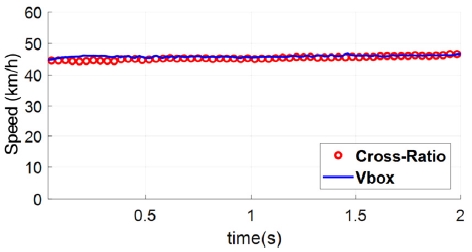

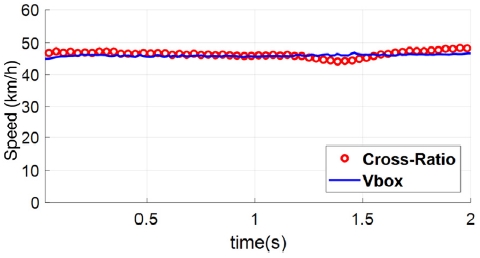

Fig. 12의 도로를 옵티마 차량이 등속으로 주행한 영상을 이용하여 분석한 결과 Fig. 13과 같이 Vbox로 취득한 실제 차량의 속도와 유사한 것을 확인할 수 있다.

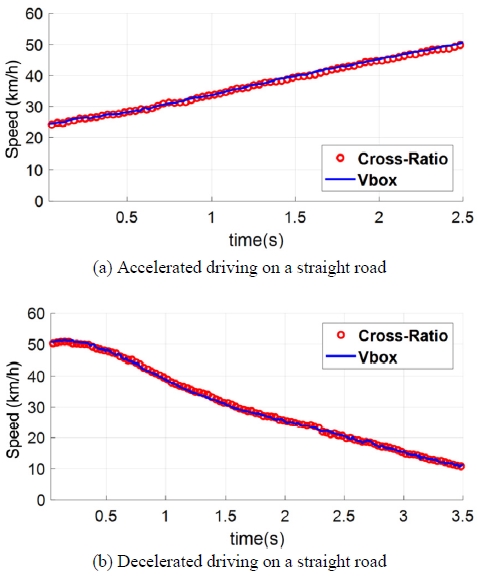

같은 도로를 옵티마 차량이 가속 그리고 감속 주행한 영상을 이용하여 분석한 결과 Fig. 14와 같이 차량의 속도와 가속과 감속 시 기울기가 Vbox 측정결과와 유사한 것을 확인할 수 있다.

카메라 렌즈가 가지고 있는 왜곡에 대한 영향을 분석하기 위해 등속 주행 실차평가 시 녹화된 영상을 Fig. 15와 같이 렌즈 왜곡을 인가한 영상으로 편집하여 동일한 방법으로 속도분석을 실시하였다.

과도한 왜곡으로 차량의 이동 경로와 차량의 형태가 바뀌었음에도 Fig. 16과 같이 실제 차량의 속도와 유사한 결과를 계산할 수 있음을 확인할 수 있다.

실차평가 결과, Table 2와 같이 Vbox가 장착된 차량의 실차평가 결과와 Cross-ratio를 이용한 속도분석 결과는 최대 3.44 % 오차가 있으며, 특히 과도한 렌즈 왜곡을 부여한 상태에서도 최대 4.95 % 오차가 있었다.

3.3 감정적용 사례

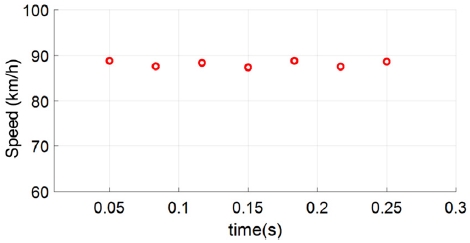

본 연구에서 제안한 영상 내 모든 프레임 간의 비조화비를 이용한 속도계산을 실제 감정사례에 적용해보고 기존의 영상분석 결과와 비교해보았다. 기존의 영상분석은 차량의 차륜 등의 기준점을 선정하여 해당 기준점이 도로 내 횡단보도나 점선 등과 같은 특정 지점을 지날 때 구간의 평균속도를 계산하는 방법이다. Fig. 17의 CCTV 화면은 Q3 차량(아우디)의 전륜이 A 지점에서 B 지점까지 약 0.73초 동안 이동한 것을 나타낸다. A 지점에서 B 지점까지의 거리는 약 18.53 m로 실측되었고, 따라서 해당 구간을 지나간 Q3 차량의 평균속도는 약 91.38 km/h로 계산된다. 다음으로 Fig. 17의 분석한 구간 영상을 비조화비를 이용하여 Q3 차량 속도를 분석하였다. 그 결과, Fig. 18과 같이 최대 약 88.81 km/h, 최소 약 87.39 km/h의 속도를 가지며 앞서 분석한 평균속도 91.38 km/h와 유사한 속도임을 확인하였다.

4. 결 론

본 연구에서는 디지털 이미지 처리와 비조화비라는 사영불변량을 이용하여 보정되지 않은 감시 카메라 영상의 차량 속도 분석을 수행하였다. PC-Crash를 이용한 시뮬레이션과 Vbox를 이용한 실차 평가를 통해 실제 차량의 속도와 비조화비로 산출된 속도를 비교하여 신뢰성을 검증하고, 실제 감정사례에 적용하여 기존의 방법과 비교하였다.

- 1) PC-Crash를 이용한 시뮬레이션 결과와 기존의 방법을 비교한 결과 직선도로의 경우 최대 3.68 %의 오차를 확인하였고, 곡선도로의 경우 최대 3.67 %의 오차를 확인하였다.

- 2) Vbox를 이용한 실차평가 결과, 직선도로에서 최대 3.67 %의 오차가 있음을 확인하였다. 특히 과도한 렌즈 왜곡을 부여한 영상을 분석하였을 시에도 최대 4.95 %의 오차를 확인하였다.

- 3) 실제 감정사례 결과와 비교하였을 때 기존 분석방법의 경우 평균속도가 약 91.38 km/h로 계산되었고, 본 연구에서 제안한 방법을 사용하였을 때 최대 88.81 km/h, 최소 87.39 km/h로 도출되어 유사한 결과를 가짐을 확인하였다.

지금까지 해석 및 실차평가를 통해 본 연구에서 제안한 속도분석 방법의 신뢰성을 확인하였고, 무엇보다 기존의 제한적인 평균속도 분석을 벗어나 영상이 가지고 있는 프레임 레이트에 따라 순간속도를 분석할 수 있음을 보였다. 이를 통해 속도가 변하는 시점을 확인함으로써 사고 재구성 결과의 신뢰성을 높일 수 있을 것으로 기대된다. 나아가 영상 내 기준점을 선정할 수 없는 경우나 영상의 왜곡이 심한 경우와 같이 분석할 수 없었던 조건에서도 기존 방식을 통해 신뢰성 높은 속도분석결과를 얻을 수 있음을 보였다.

향후 차량의 차륜 중심이 다른 구조물에 겹쳐진 경우나 화질이 조악한 조건을 극복할 수 있는 디지털 분석기법 개발이 요구된다.

Acknowledgments

이 논문은 행정안전부 주관 국립과학수사연구원 중장기과학수사감정기법연구개발(R&D)사업의 지원을 받아 수행한 연구임(NFS2019TAA01).

References

-

J. Choi, W. Oh, J. Kim, and J. Park, “Experimental Study and Finite Element Analysis about Vehicle Laminated Glass Subject to Headform Impact”, Transactions of KSAE, 25(3), p374-379, (2017).

[https://doi.org/10.7467/ksae.2017.25.3.374]

-

W. Oh, J. Kim, J. Choi, Y. Ha, H. Park, and J. Park, “A Study on the Coefficient of Restitution for Low-speed Rear-end Vehicle Impacts”, Transactions of KSAE, 25(5), p600-606, (2017).

[https://doi.org/10.7467/ksae.2017.25.5.600]

- S. Yi, and J. Ha, “The Vehicle Accident Reconstruction using Skid and Yaw Marks”, Journal of the Korean Society of Precision Engineering, 20(12), p55-63, (2003).

-

J. Kim, W. Oh, J. Choi, and J. Park, “Reliability Verification of Vehicle Speed Estimate Method in Forensic Videos”, Forensic Science International, 287, p195-206, (2018).

[https://doi.org/10.1016/j.forsciint.2018.04.002]

-

J. Lan, J. Li, G. Hu, B. Ran, and L. Wang, “Vehicle Speed Measurement Based on Gray Constraint Optical Flow Algorithm”, Optik, 125(1), p289-295, (2014).

[https://doi.org/10.1016/j.ijleo.2013.06.036]

- J. Kim, D. Shin, J. Kim, C. Kwon, and H. Byun, “Optical Flow Based Vehicle Counting and Speed Estimation in CCTV Videos”, Journal of Broadcast Engineering, 22(4), p448-461, (2017).

- B. Lee, J. Zhou, M. Ye, and Y. Guo, “A Novel Approach to Camera Calibration Method for Smart Phones Under Road Environment”, The International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, XLI-B5, p49-54, (2016).

-

F. W. Cathey, and D. J. Dailey, “A Novel Technique to Dynamically Measure Vehicle Speed Using Uncalibrated Roadway Cameras”, IEEE Proceedings, Intelligent Vehicles Symposium, p777-782, (2005).

[https://doi.org/10.1109/ivs.2005.1505199]

-

D. J. Dailey, F. W. Cathey, and S. Pumrin, “An Algorithm to Estimate Mean Traffic Speed Using Uncalibrated Cameras”, IEEE Transactions on Intelligent Transportation Systems, 1(2), p98-107, (200).

[https://doi.org/10.1109/6979.880967]

- R. Bhardwaj, G. K. Tummala, G. Ramalingam, R. Ramjee, and P. Sinha, “AutoCalib: Automatic Traffic Camera Calibration at Scale”, ACM Transactions on Sensor Networks (TOSN), 14(19), (2018).

- M. Dubska, A. Herout, and J. Sochor, “Automatic Camera Calibration for Traffic Understanding”, Proceedings British Machine Vision Conference, 4(6), (2014).

-

G. S. Fung, N. H. Yung, and G. K. Pang, “Camera Calibration from Road Lane Markings”, Optical Engineering, 42(10), (2003).

[https://doi.org/10.1117/1.1606458]

-

M. Dubska, A. Herout, R. Juranek, and J. Sochor, “Fully Automatic Roadside Camera Calibration for Traffic Surveillance”, IEEE Transactions on Intelligent Transportation Systems, 16(3), p1162-1171, (2015).

[https://doi.org/10.1109/tits.2014.2352854]

-

T. W. Wong, C. H. Tao, Y. K. Cheng, K. H. Wong, and C. N. Tam, “Application of Cross-ratio in Traffic Accident Reconstruction”, Forensic Science International, 235, p19-23, (2014).

[https://doi.org/10.1016/j.forsciint.2013.11.012]

-

I. Han, “Car Speed Estimation Based on Cross-ratio Using Video Data of Car-mounted Camera (Black box)”, Forensic Science International, 269, p89-96, (2016).

[https://doi.org/10.1016/j.forsciint.2016.11.014]

- I. Han, “Reconstruction Analysis of Vehicle Pedestrian Collision Accidents: Calculations and Uncertainties of Vehicle Speed”, Transactions of KSAE, 19(5), p82-91, (2011).