자율주행을 위한 u-, v-시차 히스토그램과 위험지도 기반의 장애물 검출

Copyright Ⓒ 2019 KSAE / 160-09

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium provided the original work is properly cited.

Abstract

This paper proposes an algorithm to detect the individual obstacles on the road using u-v-stereo disparity histograms and a risk map for autonomous driving. The algorithm consists of three main parts. The first part involves separating the disparities corresponding to the road surface from the disparities relating to objects on a road image using v-lines generated from v-disparity histograms. Then a u-line corresponding to the boundary between the road surface and objects is detected using the v-line and u-disparity histogram. The third part involves detecting an individual obstacle by constructing a two-dimensional risk map. This approach is faster and simpler than road surface fitting approaches using disparities. In addition, this approach makes path generation for autonomous driving efficient because it provides geometric information regarding individual obstacles. Experimental results show that the proposed algorithm detects obstacles with 98% precision in a variety of environments.

Keywords:

Road obstacle detection, u-, v-stereo disparity histogram, Risk map, Stereo vision, Autonomous driving키워드:

도로장애물 검출, u-, v-스테레오 시차 히스토그램, 위험 지도, 스테레오 비전, 자율주행1. 서 론

본 연구는 ADAS(Advanced Driver Assistant Systems)나 자율주행자동차 구현에 필수적인 도로상의 장애물 검출에 관한 것이다. 자율주행은 차로를 유지하면서 장애물과 충돌 없이 주행할 수 있는 경로 탐색을 요한다. 이를 위해 본 논문에서 제안된 시스템은 차량실내의 전방 글라스(Glass) 중앙에 전방을 주시할 수 있도록 장착된 스테레오 카메라로 촬영한 한 쌍의 영상으로부터 얻은 시차(Disparity)1)를 활용하여 도로의 노면을 분리하고 차량 주행에 간섭이 될 수 있는 장애물을 검출한다.

본 논문은 저자의 기존 논문1,2)의 연장선상에서 수행된 연구결과이다. 이전 연구에서는 촬영된 도로영상에서 노면은 가장 넓은 영역을 차지하며 횡방향으로 편평하다는 가정 하에 저밀도(Sparse) 시차맵3)을 사용하여 v-시차 히스토그램을 구축하고, 이 히스토그램으로부터 노면의 종방향 윤곽을 나타내는 v-라인을 예측하였다.1) 이 방법은 전제된 가정이 성립된 도로에서는 효율적이지만, 노면은 도로중앙에서 볼록하다 양 측면으로 가면서 낮아지기도 하고, 차량의 롤(Roll) 운동에 의해서 노면이 영상에서 어느 한 쪽으로 기우는 효과가 나타나기도 한다. 따라서 기존 논문2)에서 제안된 방법으로 노면과 장애물을 분리할 때 노면의 일부가 장애물 영역에 포함되거나 그 반대의 경우가 발생했다. 본 논문에서는 이 문제 해결을 위해 영상을 수평으로 몇 개의 영역으로 분할한 후 분할된 각 영역에 대해 v-라인을 추정한다. 이 때 밀도가 낮은 시차맵을 사용할 경우 분할된 영역에 따라 추출된 시차의 빈도가 낮아 v-라인예측이 실패할 수 있기 때문에 밀도가 높은(Dense) 시차맵4,5)을 사용한다.

도로 씬(Scene)에서 노면과 장애물을 분리하는 연구들이 중요하게 다루는 문제 중에 연석 검출6,7)이 있다. 연석은 높이가 25 cm이하로 낮고, 대부분 표면에 텍스처가 없기 때문에 영상처리를 통해 장애물로 분리하기가 쉽지 않다.7) 본 연구에서도 연석이 포함된 보도의 일부가 노면영역으로 분리되기도 하지만, 연석검출을 별도로 다루지 않는다. 따라서 스테레오 영상처리에 의한 연석검출은 기존논문7)을 참고하기 바란다. 2.5차원의 높이 맵(Elevation map)을 이용하여 장애물을 검출하는 연구8)에서는 도로 간판, 신호등과 같이 공중에 매달린 물체, 터널입구의 천정 등이 장애물로 인식되는 문제가 있다. 본 논문에서는 이 문제를 저자의 기존 연구1,2)를 이용하여 해결한다.

도로상의 물체를 검출할 때 정적 물체와 동적 물체를 구별하는 연구들9,16)이 있다. 이 연구들은 일련의 스테레오 영상들의 시・공간적인 특징 정합에 의해 시각 거리계(Visual odometry)를 구현하여 자차량의 운동을 예측하고 검출된 물체의 추적을 다룬다. 다임러(Daimler)에서 제안한 스틱셀(Stixel) 세계라는 방법16)은 시차를 이용하여 노면과 물체들이 접한 경계선과 물체들의 상단부를 연결하는 선을 찾아 폭이 5픽셀인 수직 사각형 막대기인 스틱셀들로 이 두 경계 사이를 채워 물체영역을 표현한다. 그리고 연속되는 영상 사이에서 스틱셀들의 운동을 계산하고 유사한 운동특성을 갖는 서로 인접한 스틱셀들을 묶어 개별 물체를 추출한다. 이 방법은 스틱셀을 구성하기까지 여러 과정을 거치며, 추출된 물체의 하한과 상한 경계에 오류가 발생하고, 물체의 하한이 노면과의 경계선이 아닌 경우도 발생한다. 그러나 본 논문에서는 동시에 촬영된 한 쌍의 영상에서 동물체 구별 없이 차량 주행에 방해가 될 수 있는 물체를 검출한다.

기존 논문2)에서는 u-시차 히스토그램을 구축하고, 이 히스토그램에서 노면과 자차량 주행에 방해가 될 수 있는 장애물들 경계인 u-라인을 검출하였지만, 본 연구에서는 u-라인에 더해 자율주행을 위한 경로를 설정할 수 있도록 장애물들을 개별적으로 검출하는 방법을 제안한다. u-라인에 대응되는 시차들을 3차원 데이터로 변환하여 2차원의 위험지도(Risk map)에 맵핑하고 이 지도상에 표현된 점들을 개별 장애물 단위로 묶은 후 컨벡스 헐(Convex hull)10)로 나타내는 방법이 그것이다.

본 논문의 구성은 다음과 같다. 2장에서는 v-라인, 3장에서는 u-라인, 4장은 장애물 검출 방법을 설명한다. 그리고 5장에서는 실험 결과를 제시하고, 6장은 결론을 맺는다.

2. v-라인 예측

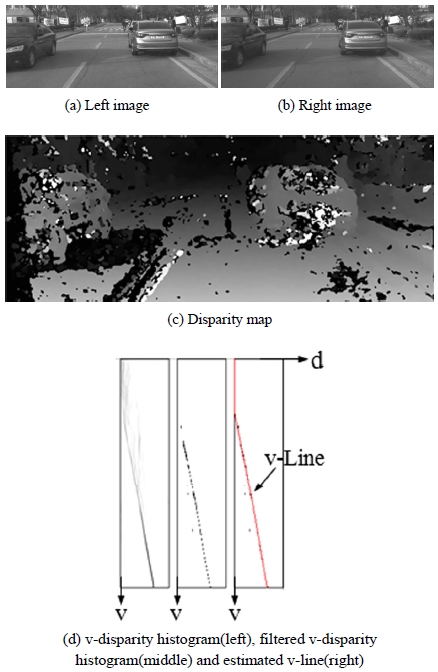

한 쌍의 스테레오 영상(Fig. 1(a), (b) 참조; 여기에서 영상의 수평축을 u, 수직축을 v라 놓음)에 대해 시차맵 D(u,v)3-5) (Fig. 1(c) 참조)를 얻은 후 다음과 같이 v-시차 히스토그램을 구축한다.1)

| (1) |

여기에서 δ는 크로넥커 델타 함수, Col은 영상의 한 행의 픽셀의 수, d는 시차, D(k,v)는 픽셀 (k,v)의 시차를 나타낸다. Fig. 1(d)의 가장 좌측 그림이 식 (1)에 의해 구축한 v-시차 히스토그램이다.

“노면이 도로영상에서 넓은 영역을 차지한다.”는 가정과 “도로상의 장애물은 대개 수직의 물체로서 이 물체에 속한 픽셀들의 시차는 유사하다.”는 가정을 토대로 v-시차 히스토그램에 필터링(Filtering)을 적용하여 필터링된 v-시차 히스토그램(Fig. 1(d) 중앙 참조)을 얻는다.1,10) 이 히스토그램에 다익스트라 알고리즘1)을 적용하여 영상의 각 행별로 노면에 대응하는 시차를 찾아 이은 선이 v-라인(Fig. 1(d) 우측의 빨간색 선 참조)이다.

수평으로 분할된 영상에 대해 v-시차 히스토그램을 구축할 경우 식 (1)의 k의 범위를 분할된 영역의 시작 열과 마지막 열의 좌표로 하면 된다. 나머지 과정은 동일하다.

3. u-라인 예측

영상의 각 행마다 노면에 대응되는 시차를 연결한 v-라인과 자차량의 높이를 고려하면 영상에서 자차량의 주행에 간섭이 될 수 있는 장애물들이 존재하는 영역을 알 수 있다. 기존 논문2)에서는 이 영역에 있는 시차들을 Do(u,v)라 놓고, 이들을 대상으로 각 열마다 시차의 빈도를 셈한 u-시차 히스토그램을 다음과 같이 구축한다.2)

| (2) |

여기에서 δ는 크로넥커 델타 함수, d는 시차, Row는 영상의 행의 수, Do(u,v)는 차량이 주행할 것으로 여겨지는 공간에 속한 영상픽셀들의 시차다. 이 히스토그램의 수평축을 따라 각 열마다 카메라로부터 가장 가까이 있을 것으로 예상되는 장애물에 대응되는 시차를 검출하고, 이들을 이은 선을 u-라인이라 칭했다.

는 대개 장애물에 대응되는 곳의 값이 크다. 만약 키 큰 장애물이 키 작은 장애물의 전방에 있을 때, 키 큰 장애물이 카메라로부터 더 멀리 있어도 이 장애물에 대응하는 시차의 빈도가 더 커서 u-라인이 키 큰 장애물에 해당되는 시차를 통과하는 문제가 발생한다. 또 노면의 일부가 장애물로 검출되는 오류도 발생한다. 기존 연구2)에서는 이 문제를 점수 맵 개념을 도입하여 해결했다.

본 연구에서는 저밀도 시차맵 대신에 고밀도 시차맵을 이용하다보니 시차오류로 인해 장애물 검출 오류가 상대적으로 많아졌다. 이 문제를 소벨 연산자11)를 이용하여 좌측 영상에서 에지를 추출하여 해결한다. 먼저 에지의 크기(Norm) ∇f(u,v)를 구한 후 이 크기가 일정값 이하면 제외하고 남은 픽셀들을 대상으로 다음과 같이 누적을 한다.

| (3) |

여기에서 d는 시차이고, Do(u,v)와 Row는 식 (2)와 같다. 보통 노면은 텍스처가 거의 없기 때문에 차선표식의 경계 외에는 특별히 에지크기가 큰 곳이 없는 반면에 여타의 물체들은 최소한 경계부에서라도 에지의 크기가 크다. 이에 따라 E(u,d)를 식 (2)의 에 곱하면 장애물 시차에 대응된 곳이 부각되므로, 이 결과를 가지고 u-라인을 검출하여 장애물 검출 성능을 높인다.

에지 검출시 장애물들의 경계가 잘 드러나지 않을 경우, 히스토그램 평활화11)를 적용하여 영상의 대비를 높인 후 에지를 추출하면 양호한 에지를 검출할 수 있다.

4. 장애물 검출

자율주행 경로계획12)은 노면과 장애물들이 접하는 선보다는 장애물 각각의 3차원 좌표가 더 요긴하다. 따라서 본 연구에서는 u-라인 정보와 카메라 파라미터를 이용하여 장애물에 대응되는 시차를 3차원 좌표로 변환하고, 이 좌표를 잘 표현할 수 있는 위험지도(Risk map)를 구축한 후, 이 지도상에서 장애물을 검출한다. 위험지도는 카메라의 광축에 대응되는 Z축과 광축에 수직인 카메라 좌우방향에 대응되는 X축으로 표현된 2차원 평면이다. 따라서 3차원 공간상의 각 위치에서 노면의 높이에 해당되는 Y축 좌표의 값은 0으로 간주한다.

위험지도에 표기할 장애물의 3차원 위치 R(u)는 다음 과정으로 결정한다. 영상의 각 열 u에서 u-라인에 대응된 시차를 U(u)라 할 때 U(u)는 장애물 시차로 볼 수 있지만, 같은 열에서 동일 장애물의 위치가 다 U(u)를 갖는다고 볼 수는 없다. 따라서 우리는 U(u)에 유효 오차 1을 반영한 후, 이 범위에 속한 시차를 장애물 시차로 간주하고, 영상의 각 열 u마다 장애물에 대한 평균 시차 를 구한 후, 를 이용하여 R(u)를 계산한다.

| (4) |

| (5) |

여기에서

로 영상의 열마다 장애물일 것으로 기대되는 픽셀들을 표기한 것이며, Row와 Do(u,v)는 식 (2)에서 정의했다. 또한 인데, 여기에서 f는 초점거리이고 b는 두 카메라 사이의 거리로서, f와 b는 카메라 캘리브레이션13)을 통해 구하며, cu는 영상의 수평축에 대한 카메라의 중심좌표인데, 보통 영상의 수평 픽셀수의 절반으로 설정한다.14)

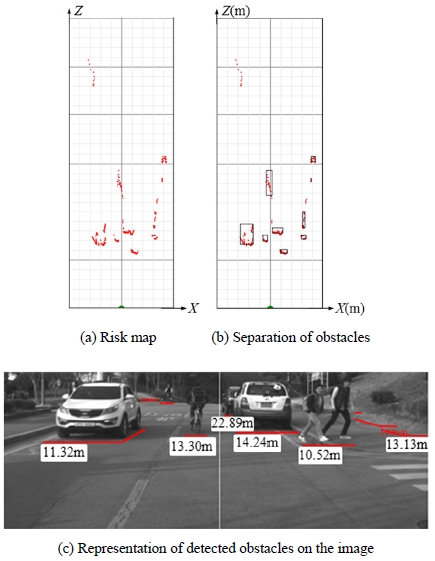

본 연구에서는 위험지도에 표시된 점들간의 위치가 서로 일정 거리 내에 있는 것들끼리 묶어 장애물로 검출한다. 이 때 단일 장애물로 묶인 점들의 수가 세 개 이하면 잡음으로 판정했다. Fig. 2는 위험지도를 보인 것으로 지도상의 빨간 점들이 식 (5)에 의해 계산된 장애물의 위치이며, 하단 중심은 자차량 최전방 중심에 해당된다. Fig. 2(b)에 표시된 사각형들은 제안된 방법으로 검출한 장애물들을 나타낸 것이고, Fig. 2(c)는 검출된 장애물들을 원 영상에다 카메라로부터 이들까지 계측된 거리(m) 정보와 함께 표시한 것이다.

Fig. 2(b)에 표시한 것처럼 검출된 장애물을 단순히 사각형으로 표현할 경우 단일 장애물로 묶인 점들이 어떻게 분포되었는지 알 수 없어서 자율주행 차량의 경로계획을 정확히 할 수 없다. 따라서 본 연구에서는 단일 장애물로 묶인 점들에 컨벡스 헐(Convex hull) 알고리즘10)을 적용하여 장애물을 볼록 다각형 형태로 표현한다.

5. 실험결과

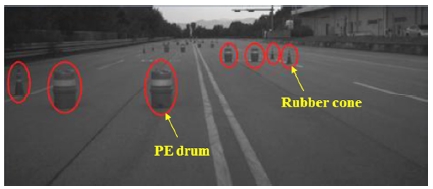

제안된 시스템의 평가는 공공 도로, 학교 교정, 자동차 연구소 주행시험장 등에서 이루어졌다. 주행시험장에서의 평가는 고무콘(Rubber cone)이나 PE드럼과 같은 물체를 설치해 놓고 자율주행 차량이 이들을 회피 주행하는 형태로 진행됐다. 이 때 다양한 상황에서의 평가를 위해 아침부터 해질녘까지 실험을 하였고, 햇빛이 강한 날이나 흐린 날에도 실험을 했다.

시스템 검증은 인텔 i7-4790k CPU와 Nvidia GTX 780 GPU로 했고, 카메라는 Point Grey사 Grass Hopper Express (GX-FW-28S5C)이며, 800(H) × 300(V) 해상도의 흑백영상을 이용했다.

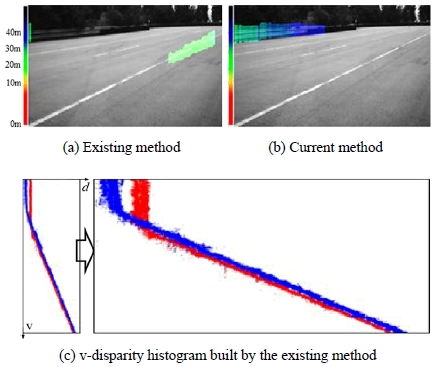

5.1 노면시차 예측

영상의 행별 노면시차 예측을 위해 v-라인을 추정한다. 기존 연구1,2)에서는 단일 v-라인을 추정했지만, 본 연구에서는 영상을 수평축 방향으로 분할하고, 분할된 영역별로 v-라인을 추정하여 횡방향의 노면시차 차이에 대응했다. Fig. 3에 보인 실험결과는 평탄한 주행시험장에서 급하게 우회전중인 차량으로 촬영한 영상에 대해 단일 v-라인 추정과 영역별 v-라인 추정을 적용하여 얻은 장애물 검출결과를 보인 것이다. Fig. 3(a)에 보인 것처럼 기존방법은 노면일부를 장애물로 검출했지만, 현 방법은 Fig. 3(b)에 보인 것처럼 노면을 장애물로 인식하지 않았다. Fig. 3(c)는 이 실험에서 구축한 단일 v-라인을 보인 것인데, 이 그림의 우측은 히스토그램을 d축 방향으로 확대한 것으로 노면 좌측과 우측에 시차차가 있음을 드러나게 했다. 빨간색 점들은 차량중앙에서 보았을 때 좌측영역의 시차를 나타낸 것이고, 파란색 점들은 우측영역의 시차를 나타낸 것이다. 동일한 거리에 있는 평탄한 노면이 차량 회전에 의하여 시차가 달라졌음을 알 수 있다.

Table 1은 횡방향 기울기가 있는 노면과 차량이 회전할 때 촬영한 영상 600장에 대해 기존방법과 현 방법에서 노면의 일부를 장애물로 검출한 결과를 보인 것이다. 이 결과에 의하면 제안된 방법은 기존방법에 비해 오검출을 15 % 이상 낮출 수 있다.

5.2 장애물 검출

장애물 검출 평가는 도로공사 현장에서 사용되는 고무콘이나 PE드럼을 Fig. 4에 보인 것처럼 주행시험장에 설치해 놓고 이들 사이로 차량을 주행하면서 진행했다. 연속된 영상에서는 장애물 배치형태와 수량이 비슷하므로 촬영한 영상 2만장을 100프레임 간격으로 200장을 선정하여 평가를 수행했다. 이 때 가드레일, 건물 외벽, 그리고 카메라로부터 60 m가 넘는 거리에 있는 물체는 검출 대상에서 제외하였다. 선별된 200장의 영상에 포함된 물체의 수는 고무콘 297개, PE드럼 943개였다. 장애물검출 결과는 Table 2의 분류결과표(Confusion matrix)15)에 제시한 바와 같다.

Table 2에서 TN(True negative)을 표기하지 않은 이유는 실제 Negative는 노면이므로 노면을 몇 개라고 단정하기 곤란했기 때문이다. 이 실험결과 장애물 검출 정밀도(Precision)는 98.05 %이고, 재현율(Recall)은 89.27 %다.

제안된 시스템에 의해 검출된 장애물들의 거리계측 정확도는 실험차량에 설치된 레이저 스캐너로 측정한 거리와 비교를 통해 얻었다. 레이저 스캐너로 얻은 측정치들은 평균을 취하여 기준으로 삼고, 제안된 시스템으로 얻은 거리값들 각각과 비교를 했다. 계측실험은 5 m간격으로 표적을 설치한 뒤 20회 실시하였다. 이 결과는 Table 3에 보인 바와 같은데, 여기서는 20 m간격의 결과만 제시했다. 카메라로부터 장애물까지 거리가 증가할수록 편차와 오차가 커짐을 알 수 있다.

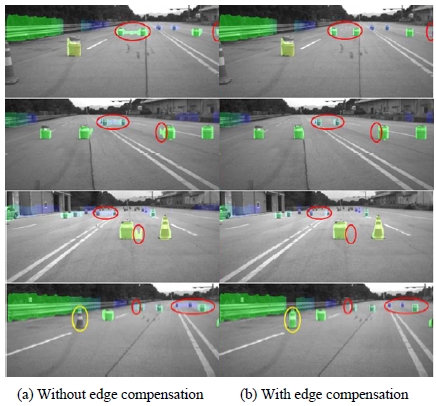

물체는 원거리에 있을 때 영상의 원근투영효과 때문에 작게 보인다. 이 때 식 (2)의 도 당연히 작게 된다. 이것이 키 작은 장애물 검출 실패원인이기도 하다. 이러한 상황에서 장애물 검출 재현율(Recall)을 높이려고 하면 장애물 검출 정밀도가 떨어질 수 있다. 이 두 가지를 동시에 향상시키기 위해 3장에서 설명한 것처럼 에지정보를 u-시차 히스토그램 구축에 반영했다. Fig. 5는 식 (2)의 에 식 (3)의 E(u,d)를 반영했을 때와 하지 않았을 때의 결과를 보인 것이다. 그림의 좌측이 E(u,d)를 보정하지 않은 것이며, 우측이 E(u,d)를 보정한 것이다. 그림에서 빨간색 타원으로 표시된 곳을 보면 장애물 검출시 에지보정 효과를 알 수 있다. 에지정보가 보정되지 않았을 때는 노면의 일부가 장애물로 검출되기도 하고, 실제 장애물 검출에 실패한 경우도 발생했는데, 보정이 됨으로써 이런 오류가 줄었다.

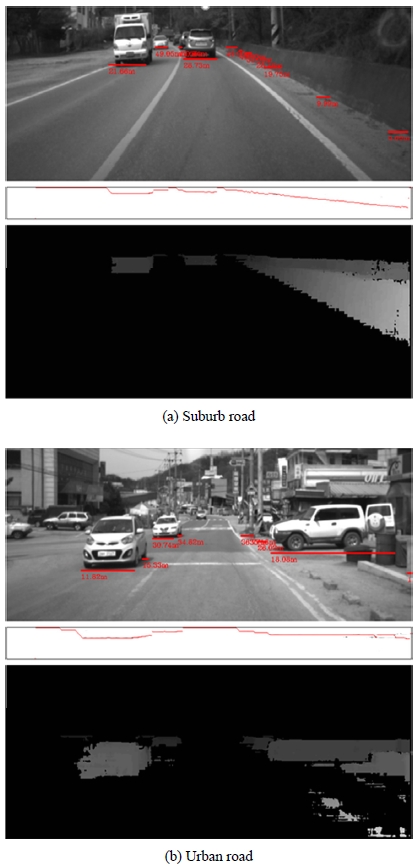

Fig. 6은 공공 도로에서 수행한 장애물 검출 실험결과를 보인 것이다. Fig. 6(a)는 교외도로에서 수행된 결과고, Fig. 6(b)는 도심도로에서 수행된 결과다. 각 그림에서 첫 행은 장애물 검출결과를 원영상위에 표기한 것으로 수평으로 그어진 빨간색 선이 검출된 장애물이며 숫자는 카메라로부터 그 장애물까지의 검출거리다. 둘째 행은 u-라인 예측결과로서 빨간색 선이 예측된 u-라인이다. 셋째 행은 장애물 시차를 나타낸 것으로 검은색이 아닌 부분들이 장애물시차를 의미한다.

5.3 처리시간

본 연구에서는 처리시간이 오래 걸리는 시차맵 구축을 GPU와 오픈소스 라이브러리인 openCL을 이용한 병렬 처리를 통해 수행했다. 단일 코어 CPU에서 평균 3.7초 걸리던 SGM 알고리즘4)을 GPU를 이용하여 40 ms로 단축했다. Table 4는 본 연구에서 제안한 시스템의 항목별 평균 처리시간을 나타낸 것이다. 총 처리시간은 70 ms로 초당 약 14 프레임의 영상을 처리한다.

5.4 실험결과 고찰

본 연구에서 제안된 시스템은 매 프레임 독립적으로 장애물을 검출한다. 이는 시스템의 단순성 측면에서는 유리하지만, 장애물 검출성능 측면에서는 불리하다. 동일한 장애물이 연속된 영상 사이에서 검출되기도 하고 되지 않기도 한다. 이러한 문제를 극복하려면 영상간의 정보를 활용하는 추적(Tracking) 기능을 도입할 필요가 있다. 더욱이 움직이는 장애물의 경우 위치 검출만이 아닌 움직임여부까지 검출할 수 있을 때 자율주행차량의 주행경로 계획을 정확히 할 수 있다.

6. 결 론

본 논문에서는 스테레오비전을 이용한 자차량 전방의 장애물 검출 시스템에 대해 제안했다. 노면의 횡방향 기울기문제를 다루었고, 장애물 검출 재현율과 정밀도를 동시에 향상시킬 목적으로 영상에서 에지를 추출하여 u-시차 히스토그램 구축에 반영했다. 또한 기존 연구는 영상의 열별로 카메라로부터 가까운 장애물에 대응되는 시차를 구하여 자유공간(Free space)을 검출하는 데에 그쳤지만, 본 연구에서는 정확한 경로계획을 위해 위험지도상에서 장애물들을 개별적으로 검출하였다.

실험 결과에서 보였듯이 제안된 시스템은 다양한 환경에서 크고 작은 물체들을 강건하게 검출하였지만, 앞으로의 연구에서는 장애물검출 과정에 추적(Tracking) 개념을 도입하고, 검출된 장애물의 움직임(Motion) 정보까지 검출할 필요가 있음이 확인되었다.

Acknowledgments

이 논문은 2016년도 교육부 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업임 (NRF-2016R1D1A1B02014422).

References

-

K. Y. Lee, J. M. Park, and J. W. Lee, “Estimation of Longitudinal Profile of Road Surface from Stereo Disparity using Dijkstra Algorithm”, International Journal of Control, Automation, and Systems, 12(4), p895-903, (2014).

[https://doi.org/10.1007/s12555-013-0478-x]

-

K. Y. Lee, G. Y. Song, J. M. Park, and J. W. Lee, “Stereo Vision Enabling Fast Estimation of Free Space on Traffic Roads for Autonomous Navigation”, Int. J. Automotive Technology, 16(1), p107-115, (2015).

[https://doi.org/10.1007/s12239-015-0012-7]

-

K. Y. Lee, and J. W. Lee, “Extraction of Corresponding Points of Stereo Images Based on Dynamic Programming”, Journal of Institute of Control, Robotics and Systems, 17(5), p397-404, (2011).

[https://doi.org/10.5302/j.icros.2011.17.5.397]

- H. Hirschmüller, “Stereo Processing by Semiglobal Matching and Mutual Information”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 30(2), p328-341, (2008).

-

J. M. Park, G. Y. Song, and J. W. Lee, “Shape-indifferent Stereo Disparity based on Disparity Gradient Estimation”, Image and Vision Computing, 57, p102-113, (2017).

[https://doi.org/10.1016/j.imavis.2016.11.001]

-

W. Zhang, “LIDAR Based Road and Road Edge Detection”, IEEE Intelligent Vehicle Symposium, (2012).

[https://doi.org/10.1109/ivs.2010.5548134]

-

P. G. Cho, J. M. Park, and J. W. Lee, “Curb Localization by Stereo Disparities and Elevation Map Built in a u-Disparity Grid”, Journal of Institute of Control, Robotics and Systems, 24(2), p196-204, (2018).

[https://doi.org/10.5302/j.icros.2018.17.0182]

-

F. Oniga, and S. Nedevschi, “Processing Dense Stereo Data Using Elevation Maps: Road Surface, Traffic Isle, and Obstacle Detection”, IEEE Transactions on Vehicular Technology, 59(3), p1172-1182, (2010).

[https://doi.org/10.1109/tvt.2009.2039718]

-

A. Broggi, S. Cattani, M. Patander, M. Sabbatelli, and P. Zani, “A Full-3D Voxel-based Dynamic Obstacle Detection for Urban Scenario using Stereo Vision”, International Conference on Intelligent Transportation Systems, (2013).

[https://doi.org/10.1109/itsc.2013.6728213]

- C. H. Lim, Obstacle Detection Based on u-Stereo Disparity Histogram Corrected by Edge Data, M. S. Thesis, Chonnam National University, Gwangju, (2016).

- R. C. Gonzalez, and R. E. Woods, Digital Image Processing, Addison-Wesley Publishing Co., Boston, (1993).

-

G. Y. Song, and J. W. Lee, “Path Planning for Autonomous Navigation of a Driverless Ground Vehicle Based on Waypoints”, Journal of Institute of Control, Robotics and Systems, 20(2), p211-217, (2014).

[https://doi.org/10.5302/j.icros.2014.13.1961]

-

Z. Zhang, “A Flexible New Technique for Camera Calibration”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 22(11), p1330-1334, (2000).

[https://doi.org/10.1109/34.888718]

-

R. Y. Tsai, “A Versatile Camera Calibration Technique for High-Accuracy 3D Machine Vision Metrology Using Off-the Shelf TV Cameras and Lenses”, IEEE Journal on Robotics and Automation, RA-3(4), p323-344, (1987).

[https://doi.org/10.1109/jra.1987.1087109]

-

S. H. Park, and J. W. Lee, “Real Time Traffic Signal Recognition Using HSI and YCbCr Color Models and Adaboost Algorithm”, Transactions of KSAE, 24(2), p214-224, (2016).

[https://doi.org/10.7467/ksae.2016.24.2.214]

-

D. Pfeiffer, and U. Franke, “Efficient Representation of Traffic Scenes by Means of Dynamic Stixels”, IEEE Intelligent Vehicle Symposium, (2010).

[https://doi.org/10.1109/ivs.2010.5548114]